Not

Åtkomst till denna sida kräver auktorisation. Du kan prova att logga in eller byta katalog.

Åtkomst till denna sida kräver auktorisation. Du kan prova att byta katalog.

De här handledningarna presenterar ett komplett helhetsflöde i Fabric-data science-upplevelsen. De täcker varje steg, från

- Datainsamling

- Datarensning

- Dataförberedelse

till

- Maskininlärningsmodellträning

- Insiktsgenerering

och täcker sedan förbrukningen av dessa insikter med visualiseringsverktyg – till exempel Power BI.

Personer som är nybörjare på Microsoft Fabric bör besöka Vad är Microsoft Fabric?.

Introduktion

En livscykel för ett data science-projekt innehåller vanligtvis följande steg:

- Förstå affärsreglerna

- Hämta data

- Utforska, rensa, förbereda och visualisera data

- Träna modellen och spåra experimentet

- Poängsätta modellen och generera insikter

Stegen fortsätter ofta iterativt. Målen och framgångskriterierna för varje fas beror på samarbete, datadelning och dokumentation. Data science-upplevelsen för Fabric omfattar flera inbyggda funktioner som möjliggör sömlöst samarbete, datainsamling, delning och användning.

De här självstudierna placerar dig i rollen som dataexpert som måste utforska, rensa och transformera en datauppsättning som innehåller omsättningsstatus för 10 000 bankkunder. Sedan skapar du en maskininlärningsmodell för att förutsäga vilka bankkunder som sannolikt kommer att lämna.

Du utför följande aktiviteter i självstudierna:

- Använda fabric notebook-filer för datavetenskapsscenarier

- Använda Apache Spark för att mata in data i en Fabric Lakehouse

- Läsa in befintliga data från lakehouse delta-tabellerna

- Använda Apache Spark- och Python-baserade verktyg för att rensa och transformera data

- Skapa experiment och körningar för att träna olika maskininlärningsmodeller

- Använd MLflow och Fabric-användargränssnittet för att registrera och spåra tränade modeller

- Kör bedömning i stor skala och spara förutsägelser och slutsatsdragningsresultat till lakehouse

- Använda DirectLake för att visualisera förutsägelser i Power BI

Arkitektur

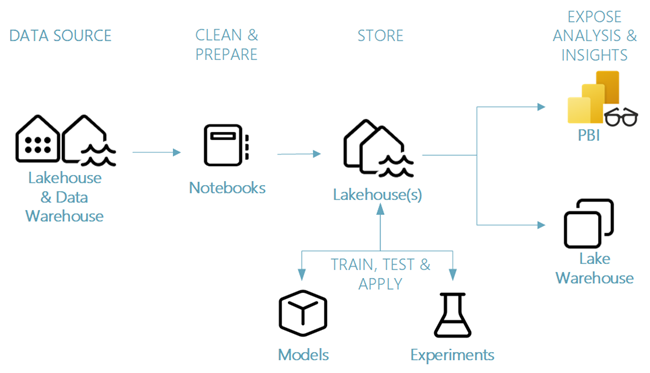

Den här självstudieserien visar ett förenklat datavetenskapsscenario från slutpunkt till slutpunkt som omfattar:

- Datainmatning från en extern datakälla.

- Datautforskning och rensning.

- Maskininlärningsmodellträning och registrering.

- Batchbedömning och förutsägelsebesparing.

- Visualisering av förutsägelseresultat i Power BI.

Olika komponenter i scenariot för datavetenskap

Datakällor – För att mata in data med Fabric kan du enkelt och snabbt ansluta till Azure Data Services, andra molnplattformar och lokala dataresurser. Med Fabric Notebooks kan du mata in data från dessa resurser:

- Inbyggda Sjöhus

- Informationslager

- Semantiska modeller

- Olika Apache Spark-datakällor

- Olika datakällor som stöder Python

Den här handledningsserien fokuserar på datainmatning och inläsning från en lakehouse-arkitektur.

Utforska, rensa och förbereda – Data science-upplevelsen i Fabric stöder datarensning, transformering, utforskning och funktionalisering. Den använder inbyggda Spark-upplevelser och Python-baserade verktyg , till exempel Data Wrangler och SemPy Library. Den här handledningen visar hur man utforskar data med seaborn-biblioteket i Python samt hur man utför datarensning och databearbetning med Apache Spark.

Modeller och experiment – Med Fabric kan du träna, utvärdera och poängsätta maskininlärningsmodeller med inbyggda experiment. För att registrera och distribuera dina modeller och spåra experiment erbjuder MLflow sömlös integrering med Fabric som ett sätt att modellera objekt. För att skapa och dela affärsinsikter erbjuder Fabric andra funktioner för modellförutsägelse i stor skala (PREDICT) för att skapa och dela affärsinsikter.

Lagring – Fabric standardiserar på Delta Lake, vilket innebär att alla Fabric-motorer kan interagera med samma datauppsättning som lagras i ett lakehouse. Med det lagringslagret kan du lagra både strukturerade och ostrukturerade data som stöder både filbaserad lagring och tabellformat. Du kan enkelt komma åt datauppsättningarna och lagrade filer via alla objekt i Fabric-upplevelsen, till exempel notebooks och pipelines.

Exponera analys och insikter – Power BI, ett branschledande business intelligence-verktyg, kan använda lakehouse-data för rapport- och visualiseringsgenerering. I notebook-resurser, python- eller Spark-inbyggda visualiseringsbibliotek

matplotlibseabornplotly- och så vidare.

kan visualisera data som sparats i ett sjöhus. SemPy-biblioteket stöder också datavisualisering. Det här biblioteket stöder inbyggda omfattande, uppgiftsspecifika visualiseringar för

- Den semantiska datamodellen

- Beroenden och deras överträdelser

- Användningsfall för klassificering och regression