Microsoft Fabric'te Apache Spark için faturalama ve kullanım raporlaması

Şunlar için geçerlidir: Microsoft Fabric'te Veri Madenciliği ve Veri Bilimi

Bu makalede, Microsoft Fabric'teki Synapse Veri Madenciliği ve Science iş yüklerini destekleyen ApacheSpark için işlem kullanımı ve raporlama açıklanmaktadır. İşlem kullanımı tablo önizlemesi, deltaya yükleme, arabirimden not defteri çalıştırmaları, zamanlanmış çalıştırmalar, işlem hatlarındaki not defteri adımları tarafından tetiklenen çalıştırmalar ve Apache Spark iş tanımı çalıştırmaları gibi lakehouse işlemlerini içerir.

Microsoft Fabric'teki diğer deneyimler gibi Veri Madenciliği de bu işi çalıştırmak için çalışma alanıyla ilişkili kapasiteyi kullanır ve genel kapasite ücretleriniz Microsoft Maliyet Yönetimi aboneliğinizin altındaki Azure portalında görünür. Doku faturalaması hakkında daha fazla bilgi edinmek için bkz . Doku kapasitesinde Azure faturanızı anlama.

Doku kapasitesi

Kullanıcı olarak Azure aboneliği kullanarak belirterek Azure'dan Doku kapasitesi satın alabilirsiniz. Kapasitenin boyutu, kullanılabilir işlem gücü miktarını belirler. Apache Spark for Fabric için satın alınan her CU, 2 Apache Spark sanal çekirdeğine çevrilir. Örneğin, bir Doku kapasitesi F128 satın alırsanız, bu 256 SparkVCore'a çevrilir. Doku kapasitesi, bu kapasiteye eklenen tüm çalışma alanları arasında paylaşılır ve izin verilen toplam Apache Spark işlemi, kapasiteyle ilişkili tüm çalışma alanlarından gönderilen tüm işlerde paylaşılır. Spark'ta farklı SKU'lar, çekirdek ayırma ve azaltma hakkında bilgi edinmek için bkz . Microsoft Fabric için Apache Spark'ta eşzamanlılık sınırları ve kuyruğa alma.

Spark işlem yapılandırması ve satın alınan kapasite

Doku için Apache Spark işlem, işlem yapılandırması söz konusu olduğunda iki seçenek sunar.

Başlangıç havuzları: Bu varsayılan havuzlar, Saniyeler içinde Microsoft Fabric platformunda Spark'ı kullanmanın hızlı ve kolay bir yoludur. Spark'ın düğümleri sizin için ayarlamasını beklemek yerine Spark oturumlarını hemen kullanabilirsiniz. Bu da verilerle daha fazlasını yapmanıza ve daha hızlı içgörüler elde etmenize yardımcı olur. Faturalama ve kapasite tüketimi söz konusu olduğunda, not defterinizi veya Spark iş tanımınızı veya lakehouse işleminizi yürütmeye başladığınızda ücretlendirilirsiniz. Kümeler havuzda boşta olduğu süre boyunca sizden ücret alınmaz.

Örneğin, bir başlangıç havuzuna not defteri işi gönderirseniz, yalnızca not defteri oturumunun etkin olduğu süre boyunca faturalandırılırsınız. Faturalanan süre boşta kalma süresini veya Spark bağlamı ile oturumu kişiselleştirmek için geçen süreyi içermez. Satın alınan Doku Kapasitesi SKU'su temelinde Başlangıç havuzlarını yapılandırma hakkında daha fazla bilgi edinmek için Başlangıç Havuzlarını Doku Kapasitesine Göre Yapılandırma başlıklı makaleye bakın

Spark havuzları: Bunlar, veri çözümleme görevleriniz için ihtiyacınız olan kaynakların boyutuna göre özelleştirebileceğiniz özel havuzlardır. Spark havuzunuza bir ad verebilir ve düğümlerin (işi yapacak makineler) kaç ve ne kadar büyük olduğunu seçebilirsiniz. Spark'a, sahip olduğunuz çalışma miktarına bağlı olarak düğüm sayısını nasıl ayarlayabileceğini de söyleyebilirsiniz. Spark havuzu oluşturmak ücretsizdir; yalnızca havuzda bir Spark işi çalıştırdığınızda ödeme yapın ve ardından Spark düğümleri sizin için ayarlar.

- Özel Spark havuzunuzda sahip olabileceğiniz düğümlerin boyutu ve sayısı Microsoft Fabric kapasitenize bağlıdır. Toplam Spark sanal çekirdek sayısı 128'i aşmadığı sürece, özel Spark havuzunuz için farklı boyutlarda düğümler oluşturmak için bu Spark sanal çekirdeklerini kullanabilirsiniz.

- Spark havuzları başlangıç havuzları gibi faturalandırılır; bir not defterini veya Spark iş tanımını çalıştırmak için oluşturulmuş etkin bir Spark oturumunun olmadığı sürece, oluşturduğunuz özel Spark havuzları için ödeme yapmazsınız. Yalnızca işinizin çalıştığı süre boyunca faturalandırılırsınız. İş tamamlandıktan sonra küme oluşturma ve serbest bırakma gibi aşamalar için faturalandırmazsınız.

Örneğin, bir not defteri işini özel bir Spark havuzuna gönderirseniz yalnızca oturumun etkin olduğu süre boyunca ücretlendirilirsiniz. Spark oturumu durdurulduktan veya süresi dolduktan sonra bu not defteri oturumu için faturalama durdurulur. Buluttan küme örneklerini almak için geçen süre veya Spark bağlamını başlatmak için geçen süre için sizden ücret alınmaz. Satın alınan Doku Kapasitesi SKU'su temelinde Spark havuzlarını yapılandırma hakkında daha fazla bilgi edinmek için Doku Kapasitesine Göre Havuzları Yapılandırma makalesini ziyaret edin

Not

Oluşturduğunuz Başlangıç Havuzları ve Spark Havuzları için varsayılan oturum süre sonu süresi 20 dakika olarak ayarlanır. Oturumunuzun süresi dolduktan sonra Spark havuzunuzu 2 dakika boyunca kullanmazsanız Spark havuzunuz serbest bırakılır. Oturum süresi dolmadan önce not defteri yürütmenizi tamamladıktan sonra oturumu ve faturalamayı durdurmak için, not defterleri Giriş menüsünde oturumu durdur düğmesine tıklayabilir veya izleme hub'ı sayfasına gidip oturumu orada durdurabilirsiniz.

Spark işlem kullanımı raporlaması

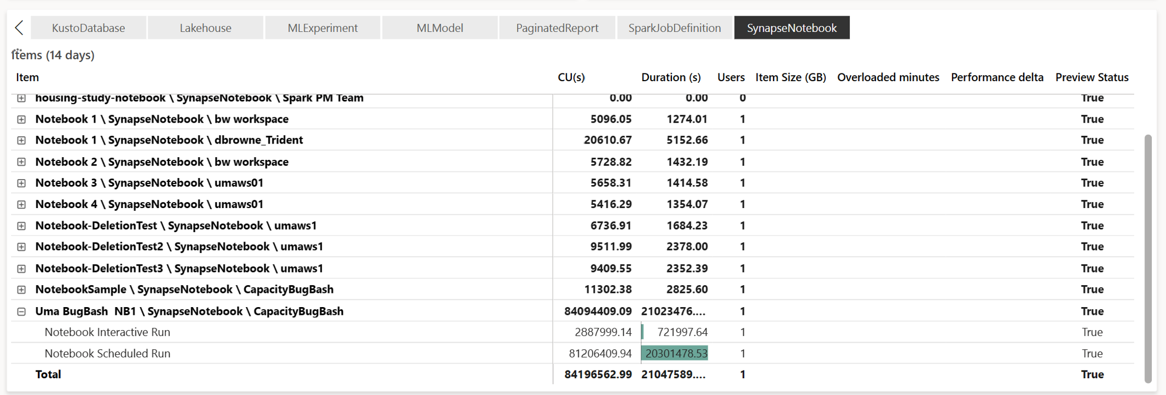

Microsoft Fabric Capacity Metrics uygulaması, tüm Doku iş yükleri için kapasite kullanımına tek bir yerden görünürlük sağlar. Satın alınan kapasiteye kıyasla iş yüklerinin performansını ve kullanımlarını izlemek için kapasite yöneticileri tarafından kullanılır.

Uygulamayı yükledikten sonra Öğe türünü seçin: açılan listesinden Not Defteri,Lakehouse,Spark İş Tanımı öğe türünü seçin. Çoklu ölçüm şerit grafik grafiği artık seçilen tüm öğelerdeki kullanımı anlamak için istenen zaman çerçevesine ayarlanabilir.

Spark ile ilgili tüm işlemler arka plan işlemleri olarak sınıflandırılır. Spark'tan kapasite tüketimi bir not defteri, Spark iş tanımı veya göl evi altında görüntülenir ve işlem adı ve öğesiyle toplanır. Örneğin: Bir not defteri işi çalıştırırsanız, not defterinin çalıştırıldığını, not defterinin kullandığı CU'ları (1 CU olarak Toplam Spark Sanal Çekirdek/2 değeri 2 Spark Sanal Çekirdeği verir), işin raporda aldığı süreyi görebilirsiniz.

Spark kapasite kullanım raporlaması hakkında daha fazla bilgi edinmek için bkz. Apache Spark kapasite tüketimini izleme

Spark kapasite kullanım raporlaması hakkında daha fazla bilgi edinmek için bkz. Apache Spark kapasite tüketimini izleme

Faturalama örneği

Aşağıdaki senaryoyu değerlendirin:

Doku Çalışma Alanı W1'i barındıran bir Kapasite C1 vardır ve bu Çalışma Alanı Lakehouse LH1 ve Not Defteri NB1'i içerir.

- Not defterinin (NB1) veya lakehouse(LH1) gerçekleştirdiği tüm Spark işlemleri C1 kapasitesine göre bildirilir.

Bu örneği, Doku Çalışma Alanı W2'yi barındıran ve bu Çalışma Alanının bir Spark iş tanımı (SJD1) ve Lakehouse (LH2) içerdiğini varsayalım.

- Çalışma Alanı'ndan (W2) Spark İş Tanımı (SDJ2) lakehouse'dan (LH1) verileri okursa, kullanım, öğeyi barındıran Çalışma Alanı (W2) ile ilişkili Kapasite C2'ye göre bildirilir.

- Not Defteri (NB1) Lakehouse'dan (LH2) bir okuma işlemi gerçekleştirirse, kapasite tüketimi, not defteri öğesini barındıran çalışma alanı W1'i destekleyen Kapasite C1'e göre bildirilir.

İlgili içerik

Geri Bildirim

Çok yakında: 2024 boyunca, içerik için geri bildirim mekanizması olarak GitHub Sorunları’nı kullanımdan kaldıracak ve yeni bir geri bildirim sistemiyle değiştireceğiz. Daha fazla bilgi için bkz. https://aka.ms/ContentUserFeedback.

Gönderin ve geri bildirimi görüntüleyin