你当前正在访问 Microsoft Azure Global Edition 技术文档网站。 如果需要访问由世纪互联运营的 Microsoft Azure 中国技术文档网站,请访问 https://docs.azure.cn。

Azure AI Studio 中的流 LLM 工具

重要

本文介绍的某些功能可能仅在预览版中提供。 此预览版未提供服务级别协议,不建议将其用于生产工作负载。 某些功能可能不受支持或者受限。 有关详细信息,请参阅 Microsoft Azure 预览版补充使用条款。

若要使用大型语言模型 (LLM) 进行自然语言处理,请使用提示流 LLM 工具。

注意

有关将文本转换为密集矢量表示形式以执行各种自然语言处理任务的嵌入,请参阅 Embedding 工具。

先决条件

按照提示工具文档中的说明准备提示。 LLM 工具和 Prompt 工具都支持 Jinja 模板。 有关更多信息和最佳做法,请参阅提示工程技术。

使用 LLM 工具进行生成

在 Azure AI Studio 中创建或打开流。 有关详细信息,请参阅创建流。

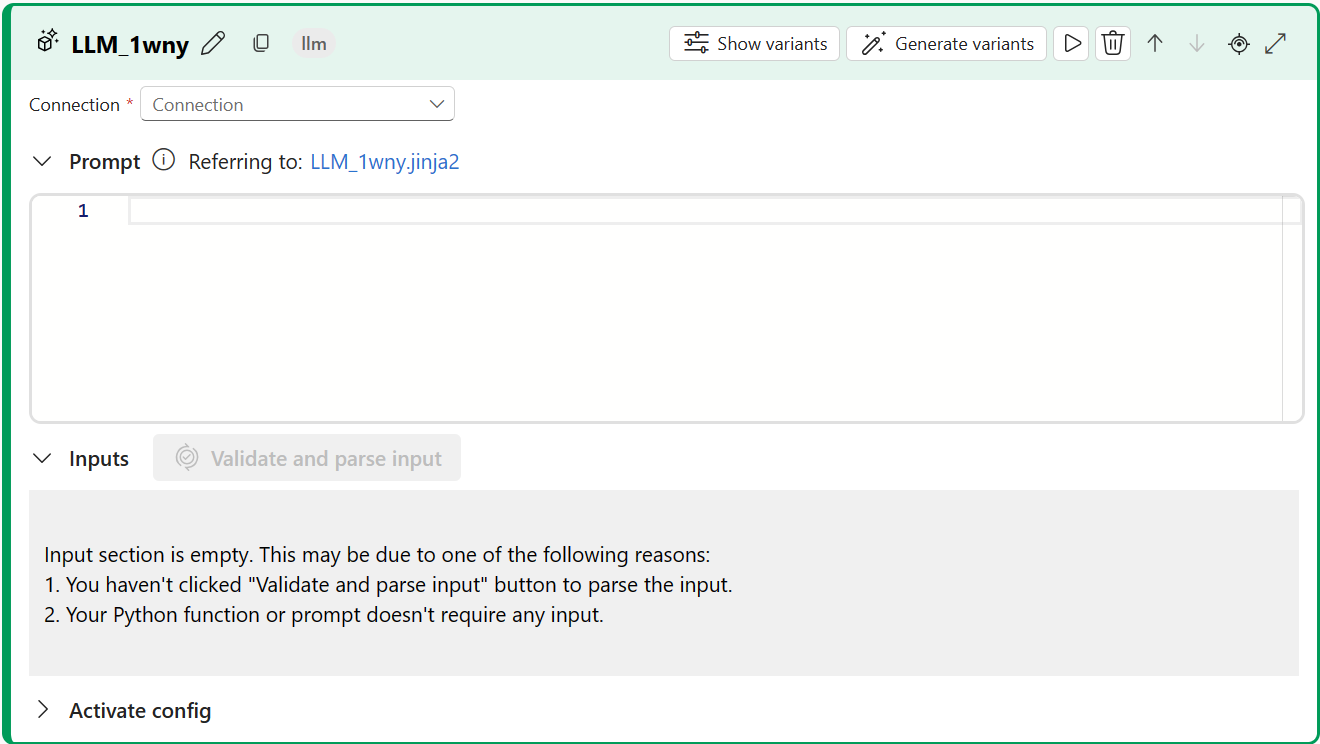

选择“+ LLM”,将 LLM 工具添加到流中。

选择与所预配的资源之一的连接。 例如,选择“Default_AzureOpenAI”。

从“Api”下拉列表中选择“聊天”或“补全”。

输入文本补全输入表中描述的 LLM 工具输入参数的值。 如果选择了“聊天”API,请参阅聊天输入表。 如果选择了“补全”API,请参阅文本补全输入表。 若要了解如何准备提示输入,请参阅先决条件。

根据需要向流添加更多工具。 或者,选择“运行”以运行流。

输出表中介绍了输出。

输入

以下输入参数可用。

文本补全输入

| 名称 | Type | 描述 | 必需 |

|---|---|---|---|

| prompt | string | 语言模型的文本提示。 | 是 |

| model, deployment_name | string | 要使用的语言模型。 | 是 |

| max_tokens | 整型 | 在完成中生成的最大令牌数。 默认值为 16。 | 否 |

| 温度 | FLOAT | 生成的文本的随机性。 默认值为 1。 | 否 |

| stop | list | 生成的文本的停止序列。 默认值为 null。 | 否 |

| suffix | string | 追加到补全内容末尾的文本。 | 否 |

| top_p | FLOAT | 使用所生成令牌中的最高选项的概率。 默认值为 1。 | 否 |

| logprobs | 整型 | 要生成的对数概率数。 默认值为 null。 | 否 |

| echo | boolean | 指示是否回显响应中的提示的值。 默认为 false。 | 否 |

| presence_penalty | FLOAT | 控制模型在重复短语方面的行为的值。 默认为 0。 | 否 |

| frequency_penalty | FLOAT | 控制模型在生成罕见短语方面的行为的值。 默认为 0。 | 否 |

| best_of | 整型 | 要生成的最佳补全数。 默认值为 1。 | 否 |

| logit_bias | dictionary | 语言模型的分对数偏差。 默认值为空字典。 | 否 |

聊天输入

| 名称 | Type | 描述 | 必需 |

|---|---|---|---|

| prompt | string | 语言模型应答复的文本提示。 | 是 |

| model, deployment_name | string | 要使用的语言模型。 | 是 |

| max_tokens | 整型 | 在响应中生成的最大令牌数。 默认为 inf。 | 否 |

| 温度 | FLOAT | 生成的文本的随机性。 默认值为 1。 | 否 |

| stop | list | 生成的文本的停止序列。 默认值为 null。 | 否 |

| top_p | FLOAT | 使用所生成令牌中的最高选项的概率。 默认值为 1。 | 否 |

| presence_penalty | FLOAT | 控制模型在重复短语方面的行为的值。 默认为 0。 | 否 |

| frequency_penalty | FLOAT | 控制模型在生成罕见短语方面的行为的值。 默认为 0。 | 否 |

| logit_bias | dictionary | 语言模型的分对数偏差。 默认值为空字典。 | 否 |

Outputs

输出根据你为输入选择的 API 的不同而有所不同。

| API | 返回类型 | 说明 |

|---|---|---|

| Completion | string | 一个预测补全的文本。 |

| 聊天 | string | 对话的一个响应的文本。 |

后续步骤

反馈

即将发布:在整个 2024 年,我们将逐步淘汰作为内容反馈机制的“GitHub 问题”,并将其取代为新的反馈系统。 有关详细信息,请参阅:https://aka.ms/ContentUserFeedback。

提交和查看相关反馈