数据库体系结构设计

本文概述了 Azure 体系结构中心中描述的 Azure 数据库解决方案。

Apache®、Apache Cassandra® 和 Hadoop 徽标是 Apache Software Foundation 在美国和/或其他国家/地区的商标或注册商标。 使用这些标记并不暗示获得 Apache Software Foundation 的认可。

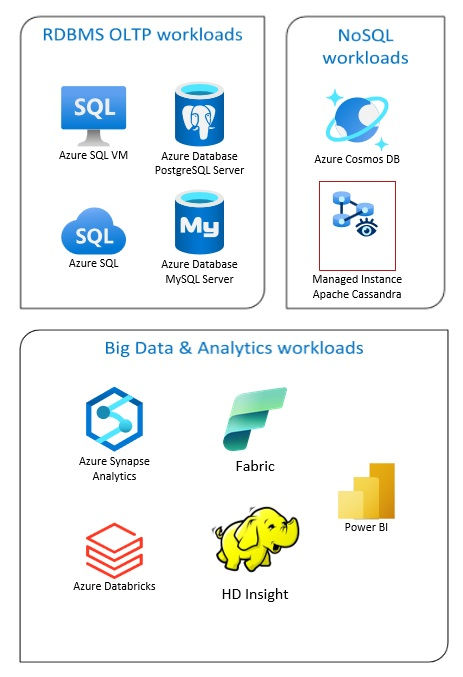

Azure 数据库解决方案包括传统关系数据库管理系统(RDBMS 和 OLTP)、大数据和分析工作负载(包括 OLAP)以及 NoSQL 工作负载。

RDBMS 工作负载包括联机事务处理 (OLTP) 和联机分析处理 (OLAP)。 组织中多个源的数据可以合并到数据仓库中。 可以使用提取、转换、加载 (ETL) 或提取、加载、转换 (ELT) 流程来移动和转换源数据。 有关 RDBMS 数据库的详细信息,请参阅探索 Azure 中的关系数据库。

大数据体系结构旨在处理大型或复杂数据的引入、处理和分析。 大数据解决方案通常涉及大量关系和非关系数据,传统的 RDBMS 系统不太适合存储这些数据。 这些通常涉及 Data Lake、Delta Lake 和 Lakehouses 等解决方案。 请参阅分析体系结构设计中的详细信息。

NoSQL 数据库可以被交替称为非关系、NoSQL DBs 或 non-SQL,以强调它们可以处理大量快速变化的非结构化数据。 它们不会像 (SQL) 数据库那样以表格、行和列的形式存储数据。 有关 No SQL DBs 数据库的详细信息,请参阅 NoSQL 数据和什么是 NoSQL 数据库?。

本文提供用于了解 Azure 数据库的资源。 其中概述了实现满足需求的体系结构的路径,以及在设计解决方案时要牢记的最佳做法。

有许多体系结构可供你从中借鉴,以满足数据库需求。 我们还提供可构建的解决方案理念,其中包括指向所需所有组件的链接。

了解 Azure 上的数据库

开始考虑解决方案的可能体系结构时,选择正确的数据存储至关重要。 如果你不熟悉 Azure,则最好从 Microsoft Learn 入手。 此免费在线平台提供了用于实践学习的视频和教程。 Microsoft Learn 提供基于工作角色(例如开发人员或数据分析师)的学习路径。

可以从 Azure 中不同数据库及其用途的常规说明开始了解。 还可以浏览 Azure 数据模块,并选择 Azure 中的数据存储方法。 这些文章可帮助你了解 Azure 数据解决方案中的选择,并了解为什么在特定方案中推荐某些解决方案。

下面是一些 Learn 模块,你可能会发现这些模块很有用:

- 设计如何迁移到 Azure

- 部署 Azure SQL 数据库

- 探索 Azure 数据库和分析服务

- 保护 Azure SQL 数据库

- Azure Cosmos DB

- Azure Database for PostgreSQL

- Azure Database for MySQL

- Azure VM 上的 SQL Server

实现生产的路径

要查找有助于处理关系数据的选项,请考虑以下资源:

- 要了解用于从多个来源收集数据的资源以及如何在数据管道中应用数据转换,请参阅Azure 中的 Analytics。

- 要了解组织大型业务数据库并支持复杂分析的 OLAP,请参阅联机分析处理。

- 要了解 OLTP 系统在发生业务交互时记录业务交互,请参阅联机事务处理。

非关系数据库不使用包含行和列的表格架构。 有关详细信息,请参阅非关系数据和 NoSQL。

要了解以本机原始格式保存大量数据的数据湖,请参阅数据湖。

大数据体系结构可处理对传统数据库系统而言太大或太复杂的数据的引入、处理和分析。 有关详细信息,请参阅大数据体系结构和分析。

混合云是一种结合了公有云和本地数据中心的 IT 环境。 有关详细信息,请考虑 Azure Arc 与 Azure 数据库结合使用。

Azure Cosmos DB 是一个完全托管的 NoSQL 数据库服务,用于新式应用开发。 有关详细信息,请参阅 Azure Cosmos DB 资源模型。

要了解如何将数据传入和传出 Azure 的选项,请参阅将数据传入和传出 Azure。

最佳实践

在设计解决方案时查看这些最佳做法。

| 最佳实践 | 说明 |

|---|---|

| 使用 Azure Cosmos DB 的事务性发件箱模式 | 了解如何使用事务性发件箱模式来实现可靠的消息传递和有保证的事件传递。 |

| 使用 Azure Cosmos DB 在全球范围内分发数据 | 要实现低延迟和高可用性,需要在靠近用户的数据中心部署某些应用程序。 |

| Azure Cosmos DB 中的安全性 | 安全最佳做法有助于预防、检测和响应数据库泄露。 |

| 使用 Azure Cosmos DB 中的时间点还原功能进行连续备份 | 了解 Azure Cosmos DB 时间点还原功能。 |

| 使用 Azure Cosmos DB 实现高可用性 | Azure Cosmos DB 提供了多种功能和配置选项来实现高可用性。 |

| Azure SQL 数据库和 SQL 托管实例的高可用性 | 数据库不应是体系结构中的单一故障点。 |

技术选择

有许多用于 Azure 数据库的技术选项。 以下文章有助于你选择最适合需求的技术。

- 选择数据存储

- 在 Azure 中选择分析型数据存储

- 在 Azure 中选择数据分析技术

- 在 Azure 中选择批处理技术

- 在 Azure 中选择大数据存储技术

- 选择 Azure 中的数据管道业务流程技术

- 在 Azure 中选择搜索数据存储

- 在 Azure 中选择流处理技术

随时了解数据库的最新信息

请参阅 Azure 更新以随时了解 Azure 数据库技术的最新信息。

相关资源

- 用于 Azure 中数据管理和分析的 Adatum Corporation 方案

- Azure 中用于数据管理和分析的 Lamna 医疗保健方案

- 优化 SQL Server 实例的管理

- Relecloud Azure 数据管理和分析方案

类似的数据库产品

如果你熟悉 Amazon Web Services (AWS) 或 Google Cloud,请参阅以下比较内容: