數據擷取牽涉到將數據載入叢集中的數據表。 Azure 資料總管可確保數據有效性、視需要轉換格式,以及執行架構比對、組織、編製索引、編碼和壓縮等操作。 資料被輸入後,即可供查詢。

Azure 資料瀏覽器使用串流或佇列引入,提供單次引入或架設連續引入流程。 若要判斷適合您,請參閱單次數據擷取和連續數據擷取。

注意

- 數據會根據設定 的保留原則保存在記憶體中。

- 如果記錄中的單一字串值或整個記錄超過允許的資料限制 64MB,則擷取會失敗。

一次性數據匯入

單次擷取有助於傳輸歷程記錄數據、填入遺漏的數據,以及原型設計和數據分析的初始階段。 這種方法有助於快速的數據整合,而不需要持續管線承諾。

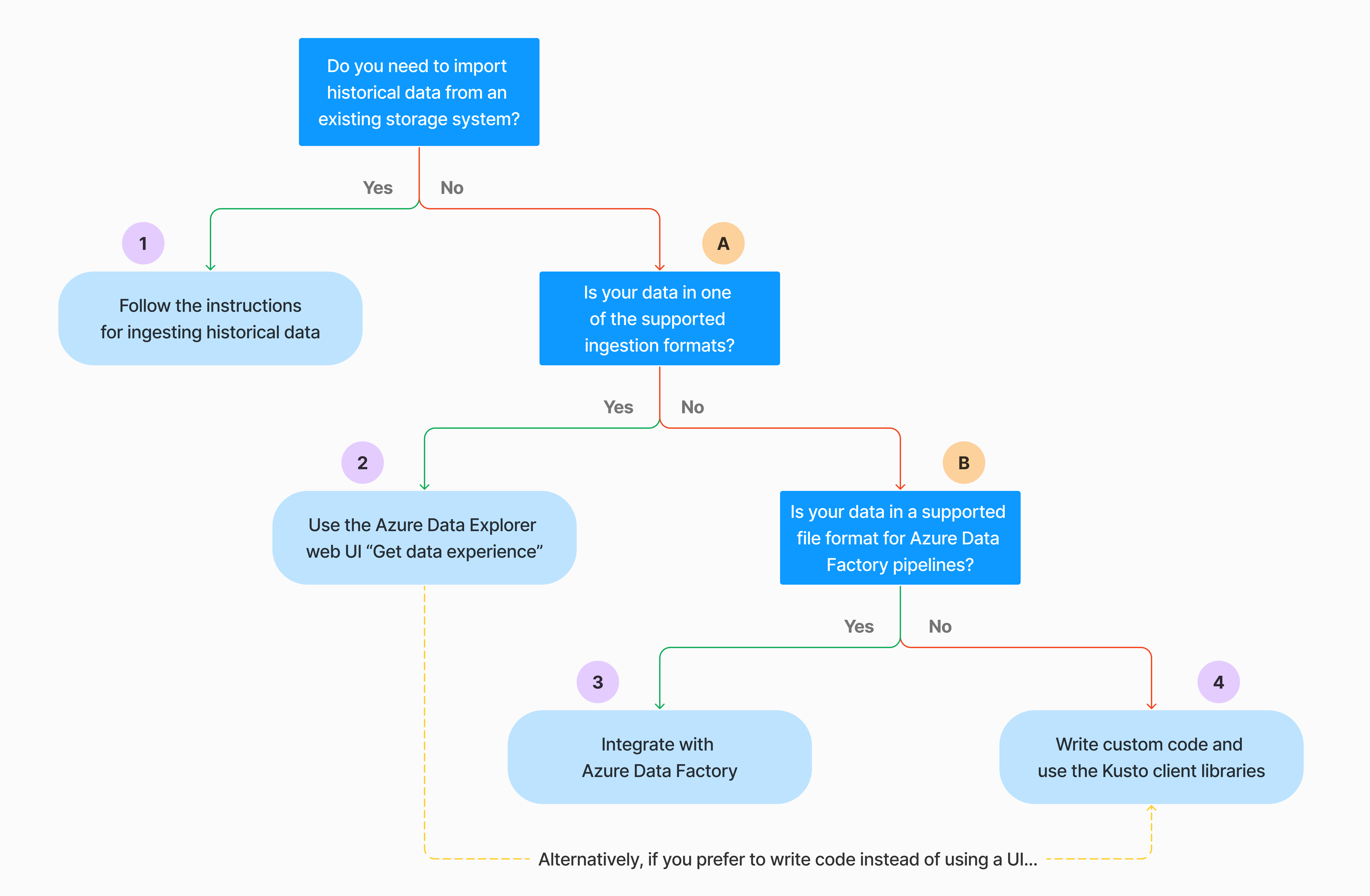

有多種方式可執行單次數據擷取。 使用下列判定樹來判斷最適合使用案例的選項:

如需詳細資訊,請參閱相關文件:

| 標注 | 相關文件 |

|---|---|

|

如需擷取,請參閱 Azure 數據總管支持的數據格式。 |

|

請參閱 Azure Data Factory 管線支援的檔案格式。 |

|

若要從現有的記憶體系統匯入數據,請參閱 如何將歷程記錄數據內嵌至 Azure 數據總管。 |

|

在 Azure 數據總管 Web UI 中,您可以從本機檔案、Amazon S3 或 Azure 儲存體 取得數據。 |

|

若要與 Azure Data Factory 整合,請參閱 使用 Azure Data Factory 將數據複製到 Azure 數據總管。 |

|

Kusto 用戶端連結庫 適用於 C#、Python、Java、JavaScript、TypeScript 和 Go。 您可以撰寫程式代碼來操作您的數據,然後使用 Kusto 擷取連結庫將數據內嵌至 Azure 數據總管數據表。 在擷取之前,數據必須使用其中一種支援的格式。 |

持續擷取資料

持續擷取在需要從即時數據中獲得見解的情況下效果佳。 例如,持續擷取適用於監控系統、記錄與事件資料,以及即時分析。

連續數據擷取牽涉到使用串流或佇列擷取來設定擷取管線:

串流擷取:此方法可確保每個資料表的小型數據集具備近乎實時的延遲。 數據會從串流來源以微批次匯入,最初放置於數據行存放區中,然後再傳輸至數據列存放區範圍。 如需詳細資訊,請參閱 設定串流擷取。

佇列擷取:這個方法已針對高擷取輸送量進行優化。 數據會根據擷取屬性進行批處理,然後合併並優化小型批次,以便快速查詢結果。 根據預設,佇列值上限為 5 分鐘、1000 個專案,或總大小為 1 GB。 佇列擷取命令的數據大小限制為 6 GB。 此方法會使用重試機制來減輕暫時性失敗,並遵循「至少一次」傳訊語意,以確保程式中不會遺失任何訊息。 如需佇列擷取的詳細資訊,請參閱 擷取批處理原則。

注意

在大部分情況下,我們建議使用佇列擷取,因為它是效能更高的選項。

注意

佇列擷取可確保可靠的數據緩衝長達 7 天。 不過,如果叢集在此保留期間內沒有足夠的容量來完成資料導入,在超過 7 天的限制後會刪除資料。 若要避免數據遺失和擷取延遲,請確定您的叢集有足夠的資源來處理 7 天內的佇列數據。

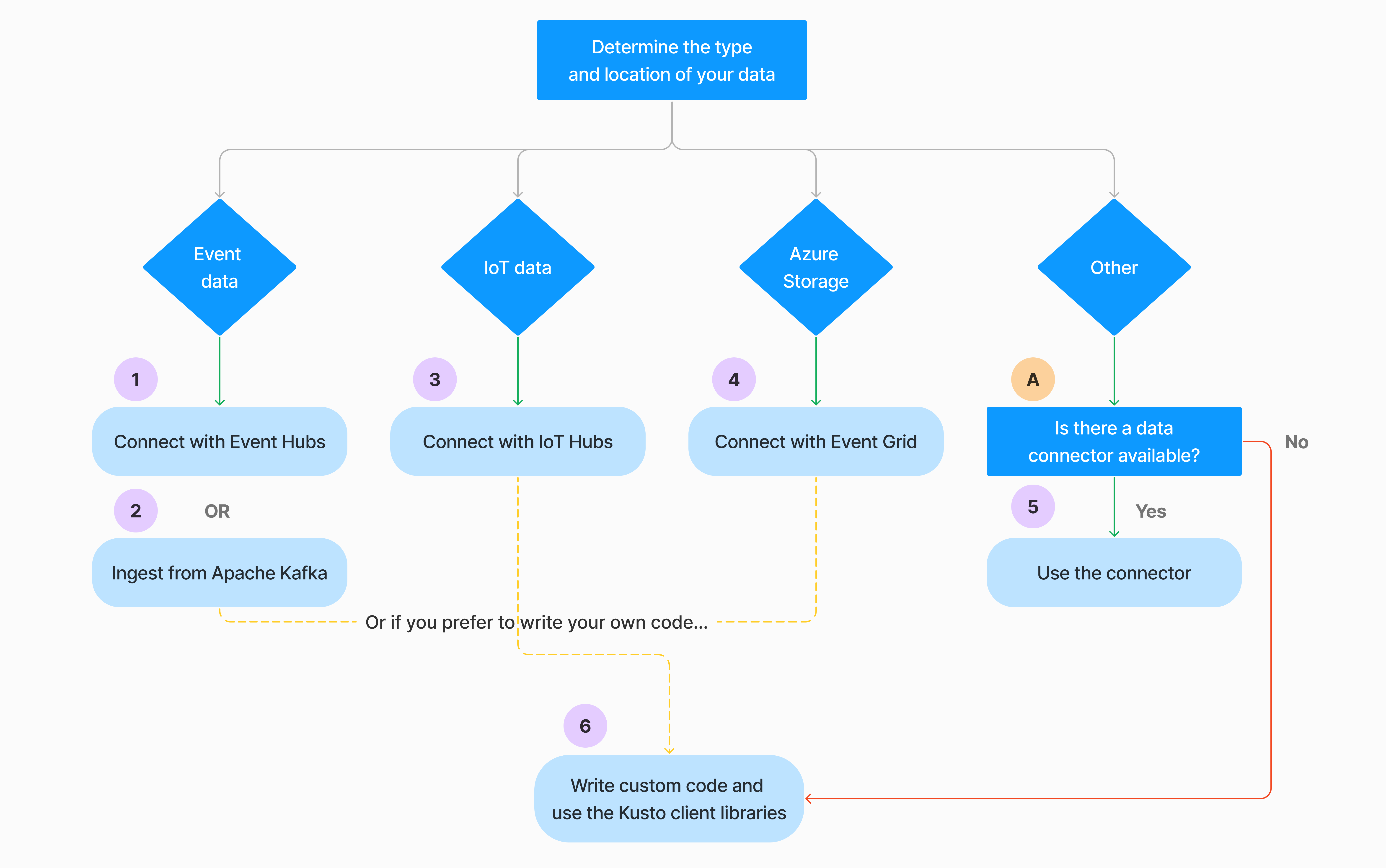

有多種方式可以設定連續數據擷取。 使用下列判定樹來判斷最適合使用案例的選項:

如需詳細資訊,請參閱相關文件:

| 標注 | 相關文件 |

|---|---|

|

如需連接器清單,請參閱 連接器概觀。 |

|

建立事件中樞數據連線。 與事件中樞整合提供節流、重試、監視和警示等服務。 |

|

從 Apache Kafka 擷取數據,這是一個分散式串流平臺,用於建置即時串流數據管線。 |

|

建立 IoT 中樞 數據連線。 與 IoT 中樞整合提供節流、重試、監視和警示等服務。 |

|

建立事件方格數據連線。 與事件方格整合提供節流、重試、監視和警示等服務。 |

|

請參閱相關連接器的指引,例如Apache Spark、Apache Kafka、Azure Cosmos DB、Fluent Bit、Logstash、Open Telemetry、Power Automate、Splunk 等等。 如需詳細資訊,請參閱 連接器概觀。 |

|

Kusto 用戶端連結庫 適用於 C#、Python、Java、JavaScript、TypeScript 和 Go。 您可以撰寫程式代碼來操作您的數據,然後使用 Kusto 擷取連結庫將數據內嵌至 Azure 數據總管數據表。 在擷取之前,數據必須使用其中一種支援的格式。 |

注意

並非所有擷取方法都支援串流擷取。 如需支援詳情,請查看文件以取得特定匯入方法。

使用管理命令直接擷取

Azure 資料總管提供下列擷取管理命令,其會直接將數據內嵌至您的叢集,而不是使用數據管理服務。 它們應僅用於探索和原型設計,而非用於生產環境或大量情境中。

- 內嵌擷取: .ingest 內嵌命令 包含要擷取的數據,成為命令文字本身的一部分。 此方法適用於即興測試目的。

- 從查詢擷取: .set、.append、.set-or-append 或 .set-or-replace 命令 間接指定要內嵌的數據做為查詢或命令的結果。

- 從記憶體擷取:.ingest into 命令會取得從外部記憶體擷取的數據,例如 Azure Blob 儲存體,由叢集存取,並由命令指向。

注意

發生失敗時,再次執行擷取,並使用指數輪詢方法重試最多 48 小時,以在嘗試之間等候時間。

比較擷取方法

下表比較主要攝取方法:

| 匯入名稱 | 資料類型 | 檔案大小上限 | 串流、已排入佇列、直接 | 最常見的案例 | 考量 |

|---|---|---|---|---|---|

| Apache Spark 連接器 | Spark 環境支援的每個格式 | 不限定 | 佇列 | 現有的資料管線,先在Spark上預處理資料後再進行擷取,快速建立從Spark環境支援的各種來源而來的安全 (Spark) 串流管線。 | 請考慮 Spark 叢集的成本。 針對批次寫入,請與事件方格的 Azure 數據總管數據連線進行比較。 針對Spark串流,請與事件中樞的數據連線進行比較。 |

| Azure Data Factory (ADF) | 支援的數據格式 | 無限制。 繼承ADF限制。 | 排隊或每次 ADF 觸發 | 支援不支援的格式,例如 Excel 和 XML,而且可以從 90 多個來源將大型檔案從內部部署複製到雲端 | 此方法在擷取數據之前需要較長的時間。 ADF 會將所有數據上傳至記憶體,然後開始擷取。 |

| 事件方格 | 支援的數據格式 | 6 GB 未壓縮 | 佇列 | 從 Azure 儲存持續擷取資料,以及 Azure 儲存中的外部資料 | 擷取可由 Blob 重新命名或 Blob 建立動作觸發 |

| 事件中樞 | 支援的數據格式 | N/A | 已排入佇列,正在串流 | 訊息、事件 | |

| 取得數據體驗 | *SV、JSON | 1 GB 未壓縮 | 已排入佇列或直接導入 | 一次性建立數據表架構、使用事件方格連續擷取的定義、使用容器大量擷取 (最多 5,000 個 Blob;使用歷程記錄擷取時沒有限制) | |

| IoT 中樞 | 支援的數據格式 | N/A | 已排入佇列,正在串流 | IoT 訊息、IoT 事件、IoT 屬性 | |

| Kafka 連接器 | Avro、ApacheAvro、JSON、CSV、Parquet 和 ORC | 無限制。 繼承 Java 限制。 | 已排入佇列,正在串流 | 現有管線,來源的高消耗量。 | 偏好設定可以根據當前使用的多個供應商或消費者服務,或者根據所需的服務管理水準來決定。 |

| Kusto 用戶端連結庫 | 支援的數據格式 | 1 GB 未壓縮 | 已排入佇列、串流、直接 | 根據組織需求撰寫您自己的程序代碼 | 程式化導入被優化以降低擷取成本(COG),其方法是在導入過程中及之後將儲存交易減至最低。 |

| LightIngest | 支援的數據格式 | 1 GB 未壓縮 | 已排入佇列或直接導入 | 數據遷移、經過調整的擷取時間戳、大量擷取的歷史數據 | 區分大小寫和空白敏感 |

| 邏輯應用程式 | 支援的數據格式 | 1 GB 未壓縮 | 佇列 | 用來自動化管線 | |

| LogStash | JSON | 無限制。 繼承 Java 限制。 | 佇列 | 既有管線,使用 Logstash 的成熟開放原始碼特性來高效處理來自輸入端的大量資料。 | 偏好設定可以根據當前使用的多個供應商或消費者服務,或者根據所需的服務管理水準來決定。 |

| Power Automate(自動化服務) | 支援的數據格式 | 1 GB 未壓縮 | 佇列 | 資料匯入命令作為流程的一部分。 用來自動化管線。 |

如需其他連接器的資訊,請參閱 連接器概觀。

權限

下列清單描述各種擷取案例所需的 許可權 :

- 若要建立新的數據表,您至少必須具有資料庫用戶許可權。

- 若要將數據內嵌至現有的數據表,而不需變更其架構,您必須至少有數據表擷取器許可權。

- 若要變更現有數據表的架構,您必須至少有數據表管理員或資料庫管理員許可權。

下表描述每個擷取方法所需的許可權:

| 攝取方法 | 權限 |

|---|---|

| 一次性導入 | 至少數據表擷取器 |

| 連續串流擷取 | 至少數據表擷取器 |

| 連續佇列匯入 | 至少數據表擷取器 |

| 直接線上匯入 | 至少數據表擷取器和資料庫查看器 |

| 從查詢直接擷取 | 至少數據表擷取器和資料庫查看器 |

| 從記憶體直接擷取 | 至少數據表擷取器 |

如需詳細資訊,請參閱 Kusto 角色型存取控制。

吞入過程

下列步驟概述一般資料取用流程:

設定保留原則 (可選):如果資料庫保留原則不適合您的需求,請在資料表層級覆寫。 如需詳細資訊,請參閱保留原則。

建立數據表:如果您使用取得數據體驗,您可以在擷取流程中建立數據表。 否則,請在 Azure 數據總管 Web UI 中或使用 .create table 命令 在擷取之前建立數據表。

建立架構對應:架構對應有助於將源數據欄位系結至目的地數據表數據行。 支援不同類型的對應,包括 CSV、JSON 和 AVRO 等數據列導向格式,以及 Parquet 等數據行導向格式。 在大部分的方法中,映射也可以在 資料表上預先建立。

設定更新原則(可選的):特定數據格式,例如 Parquet、JSON 和 Avro,允許在資料匯入時直接進行轉換。 如需在匯入期間進行更複雜的處理,請使用 更新策略。 此原則會自動對原始數據表內嵌的數據執行擷取和轉換,然後將修改過的數據內嵌到一或多個目的地數據表中。

內嵌數據:使用您慣用的擷取工具、連接器或方法來帶入數據。