在本快速入門中,您會使用 Azure Resource Manager 範本 (ARM 範本),在 Azure HDInsight 中建立 Apache Hadoop 叢集。 Hadoop 是原始的開放原始碼架構,用於分散式處理和分析叢集上的巨量資料集。 Hadoop 生態系統包含相關的軟體和公用程式,其中包括 Apache Hive、Apache HBase、Spark、Kafka 等等。

Azure Resource Manager 範本是一個 JavaScript 物件標記法 (JSON) 檔案,會定義專案的基礎結構和設定。 範本使用宣告式語法。 您可以描述預期的部署,而不需要撰寫程式設計命令順序來建立部署。

HDInsight 目前隨附 7 個不同的叢集類型。 每種叢集類型都支援一組不同的元件。 所有叢集類型都支援 Hive。 如需 HDInsight 中支援的元件清單,請參閱 HDInsight 在 Hadoop 叢集版本中提供的新功能

如果您的環境符合必要條件,而且您很熟悉 ARM 範本,請選取 [部署至 Azure] 按鈕。 範本會在 Azure 入口網站中開啟。

必要條件

如果您沒有 Azure 訂用帳戶,請在開始前建立免費帳戶。

檢閱範本

本快速入門中使用的範本是來自 Azure 快速入門範本。

{

"$schema": "https://schema.management.azure.com/schemas/2019-04-01/deploymentTemplate.json#",

"contentVersion": "1.0.0.0",

"metadata": {

"_generator": {

"name": "bicep",

"version": "0.26.54.24096",

"templateHash": "1839820966662864707"

}

},

"parameters": {

"clusterName": {

"type": "string",

"metadata": {

"description": "The name of the HDInsight cluster to create."

}

},

"clusterType": {

"type": "string",

"allowedValues": [

"hadoop",

"intractivehive",

"hbase",

"storm",

"spark"

],

"metadata": {

"description": "The type of the HDInsight cluster to create."

}

},

"clusterLoginUserName": {

"type": "string",

"metadata": {

"description": "These credentials can be used to submit jobs to the cluster and to log into cluster dashboards."

}

},

"clusterLoginPassword": {

"type": "securestring",

"minLength": 10,

"metadata": {

"description": "The password must be at least 10 characters in length and must contain at least one digit, one upper case letter, one lower case letter, and one non-alphanumeric character except (single-quote, double-quote, backslash, right-bracket, full-stop). Also, the password must not contain 3 consecutive characters from the cluster username or SSH username."

}

},

"sshUserName": {

"type": "string",

"metadata": {

"description": "These credentials can be used to remotely access the cluster. The username cannot be admin."

}

},

"sshPassword": {

"type": "securestring",

"minLength": 6,

"maxLength": 72,

"metadata": {

"description": "SSH password must be 6-72 characters long and must contain at least one digit, one upper case letter, and one lower case letter. It must not contain any 3 consecutive characters from the cluster login name"

}

},

"location": {

"type": "string",

"defaultValue": "[resourceGroup().location]",

"metadata": {

"description": "Location for all resources."

}

},

"HeadNodeVirtualMachineSize": {

"type": "string",

"defaultValue": "Standard_E4_v3",

"allowedValues": [

"Standard_A4_v2",

"Standard_A8_v2",

"Standard_E2_v3",

"Standard_E4_v3",

"Standard_E8_v3",

"Standard_E16_v3",

"Standard_E20_v3",

"Standard_E32_v3",

"Standard_E48_v3"

],

"metadata": {

"description": "This is the headnode Azure Virtual Machine size, and will affect the cost. If you don't know, just leave the default value."

}

},

"WorkerNodeVirtualMachineSize": {

"type": "string",

"defaultValue": "Standard_E4_v3",

"allowedValues": [

"Standard_A4_v2",

"Standard_A8_v2",

"Standard_E2_v3",

"Standard_E4_v3",

"Standard_E8_v3",

"Standard_E16_v3",

"Standard_E20_v3",

"Standard_E32_v3",

"Standard_E48_v3"

],

"metadata": {

"description": "This is the workdernode Azure Virtual Machine size, and will affect the cost. If you don't know, just leave the default value."

}

}

},

"variables": {

"defaultStorageAccount": {

"name": "[uniqueString(resourceGroup().id)]",

"type": "Standard_LRS"

}

},

"resources": [

{

"type": "Microsoft.Storage/storageAccounts",

"apiVersion": "2021-08-01",

"name": "[variables('defaultStorageAccount').name]",

"location": "[parameters('location')]",

"sku": {

"name": "[variables('defaultStorageAccount').type]"

},

"kind": "StorageV2",

"properties": {}

},

{

"type": "Microsoft.HDInsight/clusters",

"apiVersion": "2021-06-01",

"name": "[parameters('clusterName')]",

"location": "[parameters('location')]",

"properties": {

"clusterVersion": "4.0",

"osType": "Linux",

"clusterDefinition": {

"kind": "[parameters('clusterType')]",

"configurations": {

"gateway": {

"restAuthCredential.isEnabled": true,

"restAuthCredential.username": "[parameters('clusterLoginUserName')]",

"restAuthCredential.password": "[parameters('clusterLoginPassword')]"

}

}

},

"storageProfile": {

"storageaccounts": [

{

"name": "[replace(replace(concat(reference(resourceId('Microsoft.Storage/storageAccounts', variables('defaultStorageAccount').name), '2021-08-01').primaryEndpoints.blob), 'https:', ''), '/', '')]",

"isDefault": true,

"container": "[parameters('clusterName')]",

"key": "[listKeys(resourceId('Microsoft.Storage/storageAccounts', variables('defaultStorageAccount').name), '2021-08-01').keys[0].value]"

}

]

},

"computeProfile": {

"roles": [

{

"name": "headnode",

"targetInstanceCount": 2,

"hardwareProfile": {

"vmSize": "[parameters('HeadNodeVirtualMachineSize')]"

},

"osProfile": {

"linuxOperatingSystemProfile": {

"username": "[parameters('sshUserName')]",

"password": "[parameters('sshPassword')]"

}

}

},

{

"name": "workernode",

"targetInstanceCount": 2,

"hardwareProfile": {

"vmSize": "[parameters('WorkerNodeVirtualMachineSize')]"

},

"osProfile": {

"linuxOperatingSystemProfile": {

"username": "[parameters('sshUserName')]",

"password": "[parameters('sshPassword')]"

}

}

}

]

}

},

"dependsOn": [

"[resourceId('Microsoft.Storage/storageAccounts', variables('defaultStorageAccount').name)]"

]

}

],

"outputs": {

"storage": {

"type": "object",

"value": "[reference(resourceId('Microsoft.Storage/storageAccounts', variables('defaultStorageAccount').name), '2021-08-01')]"

},

"cluster": {

"type": "object",

"value": "[reference(resourceId('Microsoft.HDInsight/clusters', parameters('clusterName')), '2021-06-01')]"

}

}

}

範本中定義了兩個 Azure 資源:

- Microsoft.Storage/storageAccounts:建立 Azure 儲存體帳戶。

- Microsoft HDInsight/cluster:建立 HDInsight 叢集。

部署範本

選取下方的 [部署至 Azure] 按鈕來登入 Azure,並開啟 ARM 範本。

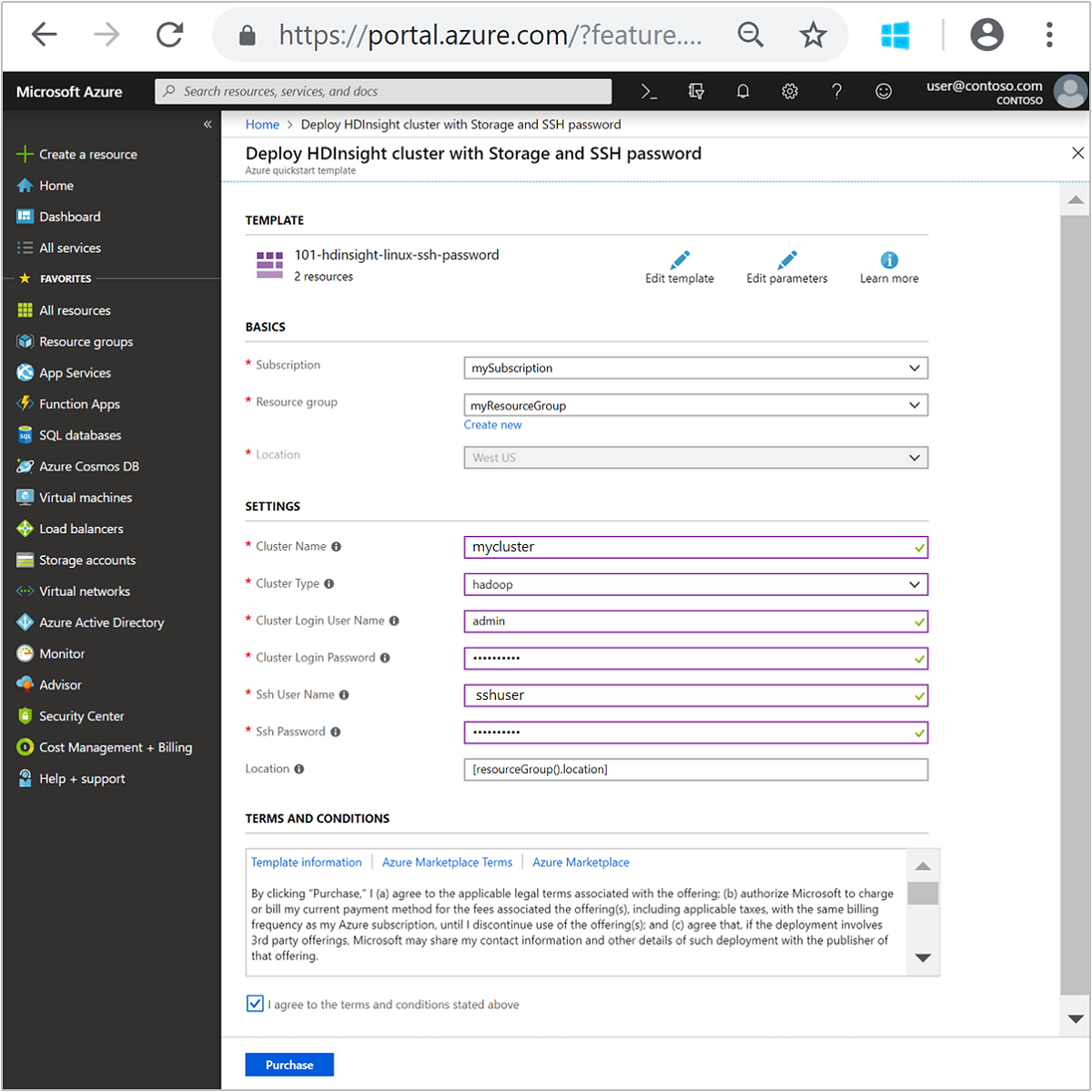

輸入或選取下列值:

屬性 描述 訂用帳戶 從下拉式清單中,選取用於此叢集的 Azure 訂用帳戶。 資源群組 從下拉式清單中選取現有資源群組,或選取 [新建]。 Location 此值會以資源群組所用的位置來自動填入。 叢集名稱 輸入全域唯一名稱。 針對此範本,請只使用小寫字母和數字。 叢集類型 選取 [Hadoop]。 叢集登入使用者名稱 提供使用者名稱,預設值為 admin。叢集登入密碼 提供密碼。 密碼長度至少必須為 10 個字元,且至少必須包含一個數字、一個大寫字母、一個小寫字母及一個非英數字元 (字元 ' ` "除外)。SSH 使用者名稱 提供使用者名稱,預設值為 sshuser。SSH 密碼 請提供密碼。 某些屬性已硬式編碼在範本中。 您可以從範本設定這些值。 如需這些屬性的詳細說明,請參閱在 HDInsight 中建立 Apache Hadoop 叢集。

注意

您提供的值必須是唯一且應該遵循命名方針。 範本不會執行驗證檢查。 如果您提供的值已在使用中或未遵循方針,則會在提交範本之後收到錯誤。

檢閱條款及條件。 然後選取 [我同意上方所述的條款及條件],然後選取 [購買]。 您會收到一則通知,內容指出您的部署正在進行中。 大約需要 20 分鐘的時間來建立叢集。

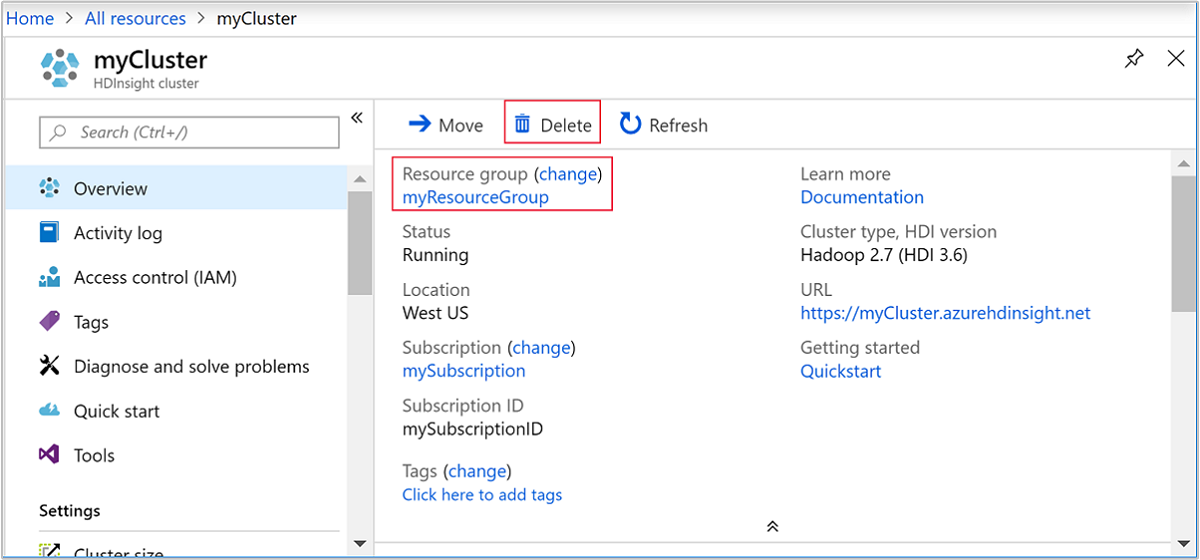

檢閱已部署的資源

叢集建立好之後,您會收到部署成功通知,內有 [移至資源] 連結。 [資源群組] 頁面會列出新的 HDInsight 叢集以及與叢集相關聯的預設儲存體。 每個叢集都具備 Azure Blob 儲存體帳戶或 Azure Data Lake Storage Gen2 相依性。 也稱為預設儲存體帳戶。 HDInsight 叢集及其預設儲存體帳戶必須共置於相同的 Azure 區域中。 刪除叢集並不會刪除儲存體帳戶。

注意

如需其他叢集建立方法及了解本快速入門中所使用的屬性,請參閱建立 HDInsight 叢集。

清除資源

完成此快速入門之後,您可以刪除叢集。 利用 HDInsight,您的資料會儲存在 Azure 儲存體中,以便您在未使用叢集時安全地刪除該叢集。 您也需支付 HDInsight 叢集的費用 (即使未使用該叢集)。 由於叢集費用是儲存體費用的許多倍,所以刪除未使用的叢集符合經濟效益。

注意

如果您要「立即」繼續下一個教學課程,以了解如何使用 HDInsight 上的 Hadoop 來執行 ETL 作業,則建議讓叢集保持執行狀態。 這是因為在教學課程中,您必須重新建立 Hadoop 叢集。 不過,如果您不會立即開始下一個教學課程,則現在就必須刪除該叢集。

在 Azure 入口網站中瀏覽至您的叢集,然後選取 [刪除]。

您也可以選取資源群組名稱來開啟資源群組頁面,然後選取 [刪除資源群組]。 刪除資源群組時,會同時刪除 HDInsight 叢集及預設儲存體帳戶。

下一步

在本快速入門中,您已了解如何使用 ARM 範本在 HDInsight 中建立 Apache Hadoop 叢集。 在下一篇文章中,您將了解如何使用 HDInsight 上的 Hadoop 來執行擷取、轉換及載入 (ETL) 作業。