這些教學課程會在 Fabric 數據科學體驗中呈現完整的端對端案例。 它們涵蓋每個步驟,從

- 資料提取

- 資料清理

- 資料準備

至

- 機器學習模型定型

- 洞察力生成

然後使用如 Power BI 等視覺化工具呈現這些深入見解的使用。

Microsoft Fabric 新手應該造訪 什麼是 Microsoft Fabric?。

簡介

資料科學專案生命週期通常包含下列步驟:

- 瞭解商務規則

- 取得數據

- 探索、清理、準備及可視化數據

- 定型模型並追蹤實驗

- 為模型評分併產生深入解析

這些步驟通常會反覆進行。 每個階段的目標和成功準則取決於合作、數據共享和文件。 Fabric 數據科學體驗牽涉到多個原生建置的功能,可順暢地共同作業、數據擷取、共用和取用。

這些教學課程可讓您擔任數據科學家的角色,而數據科學家必須探索、清理及轉換包含 10,000 個銀行客戶流失狀態的數據集。 然後,您建置機器學習模型來預測哪些銀行客戶可能會離開。

您會在教學課程中執行下列活動:

- 使用 Fabric 筆記本應用於資料科學場景

- 使用 Apache Spark 將數據內嵌至 Fabric Lakehouse

- 載入 Lakehouse Delta 表中的現有資料

- 使用 Apache Spark 和以 Python 為基礎的工具來清理和轉換數據

- 建立實驗並執行來定型不同的機器學習模型

- 使用 MLflow 和網狀架構 UI 來註冊和追蹤已定型的模型

- 大規模執行評分,並將預測和推斷結果儲存至 Lakehouse

- 使用 DirectLake 將 Power BI 中的預測可視化

架構

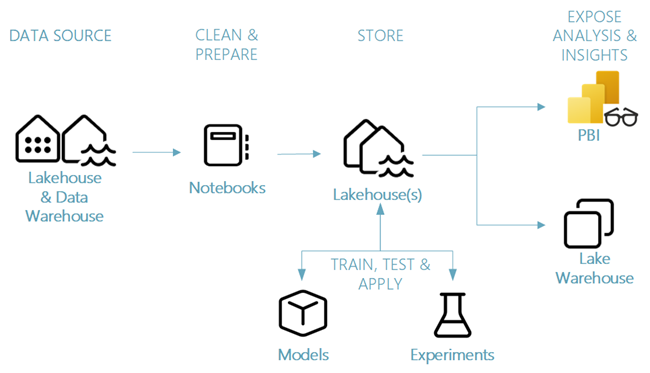

本教學課程系列示範簡化的端對端數據科學案例,涉及:

資料科學案例的不同元件

數據源 - 若要使用 Fabric 內嵌數據,您可以輕鬆且快速地連線到 Azure Data Services、其他雲端平臺和內部部署數據資源。 使用網狀架構筆記本,您可以從這些資源內嵌資料:

- 內建的湖倉

- 數據倉儲

- 語意模型

- 各種 Apache Spark 數據源

- 支援 Python 的各種數據源

本教學課程系列著重於從數據湖倉架構中提取和載入數據。

探索、清理和準備 - Fabric 數據科學體驗支持數據清理、轉換、探索和特徵化。 它使用內建的 Spark 體驗和以 Python 為基礎的工具,例如 Data Wrangler 和 SemPy Library。 本教學課程示範使用 seaborn Python 連結庫進行數據探索,以及使用 Apache Spark 進行數據清理和準備。

模型和實驗 - 使用 Fabric,您可以使用內建實驗來定型、評估和評分機器學習模型。 為了註冊和部署您的模型及追蹤實驗,MLflow 與 Fabric 提供無縫整合,作為管理模型項目的平台。 為了建置和分享商業見解,Fabric 提供其他功能來大規模預測模型 (PREDICT)。

儲存 - Fabric 在 Delta Lake 上標準化,這表示所有 Fabric 引擎都可以與儲存在資料湖倉中的相同資料集互動。 透過該儲存層,您可以儲存支援以檔案為基礎的記憶體和表格式的結構化和非結構化數據。 您可以透過所有網狀架構體驗項目輕鬆存取數據集和預存檔案,例如筆記本和管線。

公開分析和見解 - Power BI 是領先業界的商業智慧工具,可以取用 Lakehouse 數據來產生報表和視覺效果。 在筆記本資源中,使用 Python 或 Spark 的原生視覺化庫

matplotlibseabornplotly- 等等。

可以將儲存於資料湖倉中的數據進行視覺化。 SemPy 連結庫也支持數據視覺效果。 此程式庫支援內置的豐富、針對特定任務的視覺化效果。

- 語意數據模型

- 相依性及其違規

- 分類和回歸使用案例