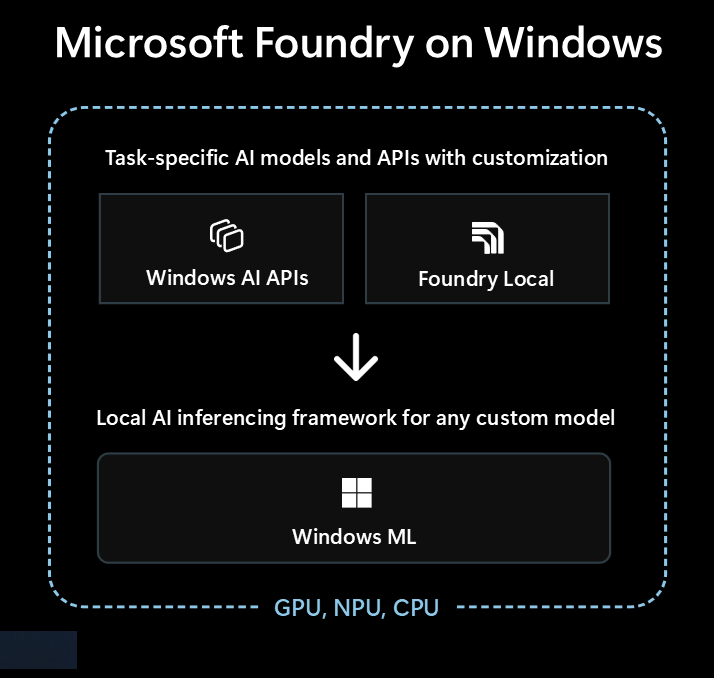

Microsoft Foundry on Windows 是開發者希望將本地 AI 功能整合進 Windows 應用程式的首選解決方案。

Microsoft Foundry on Windows 為開發者提供......

- 即用型人工智慧模型及 API 透過 Windows AI APIs 及 Foundry Local

- AI推論框架,能透過Windows ML在本地執行任何模型。

無論你是 AI 新手,還是經驗豐富的機器學習(ML)專家, Microsoft Foundry on Windows 都有適合你的選擇。

即用型 AI 模型與 API

你的應用程式可以在不到一小時內輕鬆使用以下本地 AI 模型和 API。 模型檔案的分發與執行時由 Microsoft 負責,模型則在多個應用程式間共享。 使用這些模型和 API 只需幾行程式碼,完全不需要機器學習專業知識。

| 模型類型或 API | 這是什麼 | 選項與支援裝置 |

|---|---|---|

| 大型語言模型 (LLM) | 生成式文字模型 | Phi Silica 透過 AI APIs(支援微調),或 20 多個 OSS LLM 模型透過 Foundry Local 請參考 本地大型語言模型 以了解更多資訊。 |

| 影像描述 | 取得一張圖片的自然語言文字描述 | 圖片說明來源 AI APIs (副駕駛+玩家角色) |

| 影像前景擷取器 | 分割影像前景 | 圖片前景擷取器 AI APIs(Copilot+ 個人電腦) |

| 影像生成 | 從文字產生圖片 | 影像生成 透過 AI APIs (Copilot+ 個人電腦) |

| 影像物件消除 | 從影像中抹除物件 | 影像物件消除 透過 AI APIs (Copilot+個人電腦) |

| 影像物件擷取器 | 在影像中分割特定物件 | 影像物件擷取器由 AI APIs(Copilot+個人電腦)提供 |

| 影像超高解析度 | 提升影像解析度 | 圖片超解析度技術 AI APIs(Copilot+電腦) |

| 語意搜尋 | 語意搜尋文字與圖片 | 應用程式內容搜尋 AI APIs(協作夥伴+PC) |

| 語音辨識 | 將語音轉換為文字 | 透過 Foundry Local 進行 Whisper 或透過 Windows SDK 進行語音辨識 請參見 語音辨識 以了解更多。 |

| 文字辨識(OCR) | 從圖片辨識文字 | OCR 透過 AI APIs (Copilot+ 個人電腦) |

| 影像超解析度(VSR) | 提升影片解析度 | 影片超解析度 AI APIs (Copilot+ 電腦) |

與Windows ML一起使用其他模型

你可以使用 Hugging Face 或其他來源的各種模型,甚至自己訓練模型,並在 Windows 10+ 電腦Windows ML上本地執行(模型相容性和效能會依裝置硬體而異)。

請參閱 尋找或訓練模型的部分以了解詳情 Windows ML 。

該從哪個選項開始

請依照此決策樹,為您的申請與情境選擇最佳方案:

檢查內建的Windows AI APIs是否涵蓋你的情境,以及你是否以 Copilot+ 電腦作為目標。 這是最快且開發投入最小的途徑。

如果 Windows AI APIs 沒有你需要的功能,或者你需要支援 Windows 10 以上,可以考慮使用 Foundry Local 用於大型語言模型(LLM)或語音轉文字的情境。

如果你需要自訂模型、想利用 Hugging Face 或其他來源的現有模型,或有上述選項未涵蓋的特定模型需求,這 Windows ML 會讓你有彈性去尋找或訓練自己的模型。

你的應用程式也可以結合這三種技術。

可用於本地人工智慧的技術

以下技術可用於 Microsoft Foundry on Windows:

| 窗戶 AI APIs | Foundry Local | Windows ML | |

|---|---|---|---|

| 怎麼了 | 適用於多種任務類型的現成 AI 模型與 API,並針對 Copilot+ PC 進行優化 | 即用型大型語言模型與語音轉文字模型 | ONNX Runtime 用於執行你找到或訓練的模型的框架 |

| 支援裝置 | Copilot+ PC | 所有 Windows 10+ 的電腦及跨平台 (效能依據可用硬體而異,並非所有型號) |

所有 Windows 10+ 電腦,並透過開放原始碼實現跨平台功能 ONNX Runtime (效能依據可用硬體而異) |

| 可用模型類型與API |

LLM 影像描述 影像前景擷取器 影像生成 影像物件消除 影像物件擷取器 影像超高解析度 語意搜尋 文字辨識(OCR) 影片超解析度 |

大型語言模型(多個) 語音轉文字 瀏覽20+可用型號 |

尋找或訓練你自己的模型 |

| 模型分布 | 由 Microsoft 託管,執行時取得,並跨應用程式共享 | 由 Microsoft 託管,執行時取得,並跨應用程式共享 | 分發由你的應用程式處理(應用程式庫可以在 不同應用程式間共享模型) |

| 瞭解更多資訊 | 閱讀 AI APIs 文件 | 閱讀 Foundry Local 文件 | 閱讀 Windows ML 文件 |

Microsoft Foundry on Windows 同時也包含開發工具,如 AI Toolkit Visual Studio Code 和 AI開發畫廊 ,幫助你成功建構AI能力。

AI Toolkit for Visual Studio Code 是 VS Code 擴充功能,可讓您在本機下載並執行 AI 模型,包括存取硬體加速以提升效能並透過 DirectML 進行調整。 這個 AI Toolkit 也能幫助你:

- 使用 REST API 在直覺式遊樂場或應用程式中測試模型。

- 微調您的 AI 模型,無論是在本機還是雲端中(在虛擬機上),以建立新的技能、改善回應的可靠性、設定回應的音調和格式。

- 微調熱門的小語言模型(SLM),如 Phi-3 和 Mistral。

- 將您的 AI 功能部署至雲端,或使用在裝置上執行的應用程式。

- 使用 DirectML 利用硬體加速以提升 AI 功能的效能。 DirectML 是低階 API,可讓您的 Windows 裝置硬體使用裝置 GPU 或 NPU 來加速 ML 模型的效能。 將 DirectML 與 ONNX Runtime 配對通常是開發人員大規模將硬體加速 AI 帶到使用者的最直接方式。 深入瞭解: DirectML 概觀。

- 使用模型轉換功能來量化和驗證模型以在 NPU 上使用

利用本地 AI 的點子

Windows 應用程式可以利用本地 AI 提升功能與使用者體驗的幾種方式包括:

- 應用程式可以使用 生成式 AI LLM 模型 來理解複雜主題,進行摘要、重寫、報告或擴充。

- 應用程式可以使用 大型語言模型(LLM )模型,將自由形式內容轉換成應用程式能理解的結構化格式。

- 應用程式可以使用語 意搜尋模型 ,讓使用者能依詞義搜尋內容並快速找到相關內容。

- 應用程式可以使用自然語言處理模型來推理複雜的自然語言需求,並規劃和執行動作來完成用戶的詢問。

- 應用程式可以使用影像處理模型,智慧地修改影像、清除或新增物件、提高解析度或產生新內容。

- 應用程式可以使用預測性診斷模型來協助識別和預測問題,並協助引導使用者或為其執行。

使用雲端 AI 模型

如果使用本機 AI 功能不是適合您的路徑, 則使用雲端 AI 模型和資源 可以是解決方案。

使用負責任的 AI 做法

每當您在 Windows 應用程式中納入 AI 功能時 ,強烈建議遵循 在 Windows 上開發負責任的產生 AI 應用程式和功能 指引。