Co je Databricks Připojení?

Poznámka:

Tento článek se zabývá Připojení Databricks pro Databricks Runtime 13.0 a vyšší.

Informace o starší verzi databricks Připojení najdete v tématu Databricks Připojení pro Databricks Runtime 12.2 LTS a níže.

- Pokud chcete tento článek přeskočit a začít hned používat Databricks Připojení pro Python, přečtěte si téma Připojení Databricks pro Python.

- Pokud chcete tento článek přeskočit a začít používat Databricks Připojení pro R hned, přečtěte si téma Databricks Připojení pro R.

- Pokud chcete tento článek přeskočit a začít používat Databricks Připojení pro Scala hned, přečtěte si téma Databricks Připojení pro Scala.

Přehled

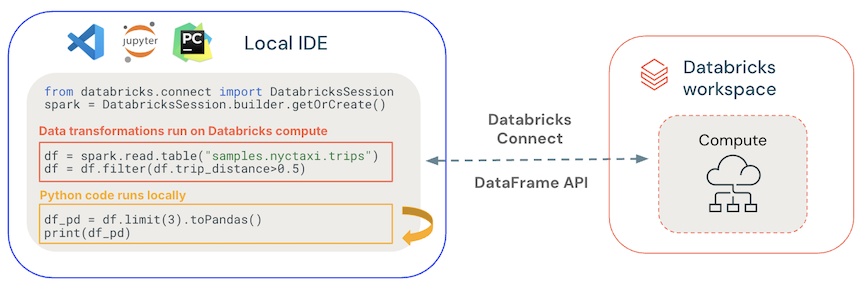

Databricks Připojení umožňuje připojit oblíbené integrované vývojové prostředí , jako jsou Visual Studio Code, PyCharm, RStudio Desktop, IntelliJ IDEA, servery poznámkových bloků a další vlastní aplikace k clusterům Azure Databricks. Tento článek vysvětluje, jak databricks Připojení funguje.

Databricks Připojení je klientská knihovna pro Databricks Runtime. Umožňuje psát kód pomocí rozhraní Spark API a spouštět je vzdáleně v clusteru Azure Databricks místo v místní relaci Sparku.

Když například spustíte příkaz spark.read.format(...).load(...).groupBy(...).agg(...).show() DataFrame pomocí databricks Připojení, logické znázornění příkazu se odešle na server Spark spuštěný v Azure Databricks za účelem spuštění ve vzdáleném clusteru.

S Připojení Databricks můžete:

Spusťte kód Sparku ve velkém měřítku z libovolné aplikace Python, R nebo Scala. Všude, kde můžete

import pysparkpoužít Python,library(sparklyr)pro R neboimport org.apache.sparkScala, teď můžete spouštět kód Sparku přímo z vaší aplikace, aniž byste museli instalovat jakékoli moduly plug-in IDE nebo používat skripty pro odeslání Sparku.Poznámka:

Databricks Připojení pro Databricks Runtime 13.0 a vyšší podporují spouštění aplikací Pythonu. R a Scala se podporují jenom v Databricks Připojení pro Databricks Runtime 13.3 LTS a vyšší.

Krokujte a ladicí kód v integrovaném vývojovém prostředí (IDE) i při práci se vzdáleným clusterem.

Iterujte rychle při vývoji knihoven. Po změně závislostí knihovny Python nebo Scala v Databricks Připojení nemusíte restartovat cluster, protože každá relace klienta je v clusteru izolovaná.

Vypněte nečinné clustery bez ztráty práce. Vzhledem k tomu, že je klientská aplikace oddělená od clusteru, nemá to vliv na restartování nebo upgrady clusteru, což by normálně způsobilo ztrátu všech proměnných, sad RDD a objektů datového rámce definovaných v poznámkovém bloku.

Pro Databricks Runtime 13.3 LTS a novější je teď databricks Připojení založená na opensourcových Připojení Sparku. Spark Připojení zavádí oddělenou architekturu klientského serveru pro Apache Spark, která umožňuje vzdálené připojení ke clusterům Spark pomocí rozhraní DATAFrame API a nevyřešených logických plánů jako protokolu. Díky této architektuře "V2" založené na Sparku Připojení se databricks Připojení stává tenkým klientem, který je jednoduchý a snadno použitelný. Spark Připojení se dá vložit všude, kde se můžete připojit k Azure Databricks: v prostředíCH IDEs, poznámkových blocích a aplikacích, což umožňuje jednotlivým uživatelům a partnerům vytvářet nová (interaktivní) uživatelská prostředí na základě platformy Databricks. Další informace o Připojení Sparku najdete v tématu Představení Připojení Sparku.

Databricks Připojení určuje, kde se váš kód spouští a ladí, jak je znázorněno na následujícím obrázku.

Pro spuštění kódu: Veškerý kód běží místně, zatímco veškerý kód zahrnující operace datového rámce běží v clusteru ve vzdáleném pracovním prostoru Azure Databricks a odpovědi na spuštění se posílají zpět místnímu volajícímu.

Ladění kódu: Veškerý kód je místně laděný, zatímco veškerý kód Sparku se bude dál spouštět v clusteru ve vzdáleném pracovním prostoru Azure Databricks. Základní kód modulu Spark nelze ladit přímo z klienta.

Další kroky

- Pokud chcete začít vyvíjet řešení Připojení Databricks pomocí Pythonu, začněte kurzem Databricks Připojení pro Python.

- Pokud chcete začít vyvíjet řešení Připojení Databricks pomocí jazyka R, začněte kurzem Připojení Databricks pro R.

- Pokud chcete začít s vývojem řešení Databricks Připojení pomocí scaly, začněte kurzem Připojení Databricks for Scala.