Poznámka:

Přístup k této stránce vyžaduje autorizaci. Můžete se zkusit přihlásit nebo změnit adresáře.

Přístup k této stránce vyžaduje autorizaci. Můžete zkusit změnit adresáře.

Tento článek popisuje, jak používat funkce specifické pro ochranu aplikací AI a dat, se kterými pracují.

- Chraňte svá citlivá data ve výzvách pro uživatele a v datech generovaných umělou inteligencí.

- Ochrana před vznikajícími hrozbami, jako jsou injekce příkazů

Toto je třetí článek v řadě. Pokud jste ještě nedokončili úkoly v části Příprava na zabezpečení AI a zjišťování aplikací a dat umělé inteligence, začněte těmito články a připravte prostředí s funkcemi, které jsou předepsané v tomto článku.

Tento článek použijte společně s tímto prostředkem:

- Architektura přechodu na cloud (CAF) pro AI – proces zabezpečení AI

Microsoft poskytuje širokou škálu funkcí pro ochranu aplikací a dat umělé inteligence. Tento článek je popisuje ve dvou kategoriích – ochrana dat a ochrana před hrozbami.

Následující dvě tabulky popisují obrázek a také si projdou kroky implementace těchto funkcí.

Tabulka 1 – možnosti ochrany dat

| Krok | Úkol | Scope |

|---|---|---|

| 1 | Použití ovládacích prvků sdílení SharePointu pro rychlé vyloučení citlivých webů a dat z rozsahu aplikací AI | Weby a soubory v prostředí Microsoftu 365 |

| 2 | Pomocí správy zabezpečení dat (DSPM) můžete zjistit, kde probíhá nadměrné sdílení, a najít mezery v pokrytí vaší politiky týkající se popisků citlivosti a zásad ochrany před únikem informací. | Copiloty, agenti a další aplikace AI, které používají rozsáhlé jazykové moduly třetích stran (LLM), včetně podporovaných webů AI. Aplikace AI v jiných cloudových poskytovatelích prostřednictvím sady Purview SDK. |

| 3 | Pokračujte v provádění zásad ochrany před únikem informací a popisků citlivosti. | Weby, soubory a zařízení v prostředí Microsoftu 365 Aplikace SaaS, když jsou integrované s Defenderem for Cloud Apps. Aplikace AI v Azure a další poskytovatelé cloudu prostřednictvím sady Purview SDK. |

| 4 | V rámci správy insiderských rizik (IRM) použijte šablonu Riziková AI k identifikaci rizikového chování v aplikacích AI. | Weby generativní umělé inteligence. Microsoft 365 Copilot, Microsoft Copilot, Copilot Studio, služby Azure AI Aplikace AI v jiných cloudových poskytovatelích prostřednictvím sady Purview SDK. |

| 5 | Konfigurace adaptivní ochrany pro správu insiderských rizik za účelem zvýšení ochrany dat na základě rizika uživatelů | Weby, soubory a zařízení v prostředí Microsoftu 365 |

Tabulka 2 – možnosti ochrany před hrozbami

| Krok | Úkol | Scope |

|---|---|---|

| 1 | Pomocí Programu Defender for Cloud Apps vás upozorníte, když se používají nové aplikace AI, k výpočtu skóre rizika pro aplikace AI a k povolení nebo blokování těchto aplikací ve vašem prostředí. Defender for Cloud Apps poskytuje dodatečnou ochranu pro Microsoft 365 Copilot. | Aplikace AI pro SaaS |

| 2 | Defender for Cloud Objevte nasazené úlohy AI ve vašem prostředí a získejte bezpečnostní přehledy s Microsoft Defender pro Cloud |

Aplikace AI na bázi Azure AI vytvořené na míru |

Ochrana dat AI

Tyto funkce vám pomůžou efektivně zjistit a zmírnit hlavní rizika spojená s nadměrném sdílením dat, používáním citlivých dat a rizikovým chováním uživatelů. Tyto funkce jsou vymezeny na ochranu aplikací a dat umělé inteligence ve vašem prostředí.

Krok 1 – Použití ovládacích prvků sdílení SharePointu

Ovládací prvky nadměrného sdílení SharePointu zahrnují ovládací prvky integrované do SharePointu, jako jsou oprávnění s vymezeným oborem, a možnosti doplňků v Rozšířené správě SharePointu pro podporu zásad správného řízení obsahu pro cestu nasazení Microsoft Copilotu. Ovládací prvky sdílení SharePointu vám pomůžou:

- Dočasně omezte vyhledávání Copilot na seznam webů, které zadáte (omezené vyhledávání SharePointu).

- Rychle identifikujte weby, které mohou obsahovat příliš sdílená data nebo citlivý obsah (výkazy správy přístupu k datům).

- Označte weby příznakem, aby je uživatelé nemohli najít prostřednictvím Copilot nebo celofiremního vyhledávání (omezené vyhledávání obsahu v rozšířené správě SharePointu).

- vytvářet neaktivní zásady webu pro automatickou správu a omezení neaktivních webů (Rozšířená správa SharePointu).

- Omezte přístup k webům SharePointu a OneDrivu na uživatele v konkrétní skupině (zásady řízení přístupu v Rozšířené správě SharePointu).

Pokud chcete začít s ovládáním sdílení, použijte následující zdroje.

| Úkol | Doporučené zdroje informací |

|---|---|

| Projděte si obrázek a popis ovládacích prvků pro nadměrné sdílení, které můžete používat s Microsoftem 365 Copilot. | Architektura ochrany dat a auditování Microsoft 365 Copilot |

| Podrobný plán ke stažení, který zabrání nadměrnému sdílení | Plán Microsoft 365 Copilot pro nadměrné sdílení |

| Další informace o rozšířené správě SharePointu | Microsoft SharePoint Premium – Přehled rozšířené správy SharePointu |

Krok 2 – Ochrana dat prostřednictvím DSPM pro AI

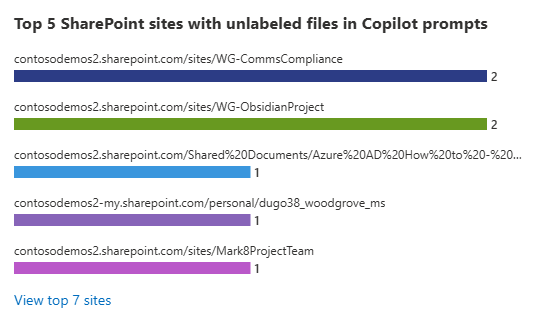

Pomocí DSPM může AI zjistit, kde probíhá nadměrné sdílení, a identifikovat mezery v pokrytí vašich zásad pro popisky citlivosti a zásady ochrany před únikem informací.

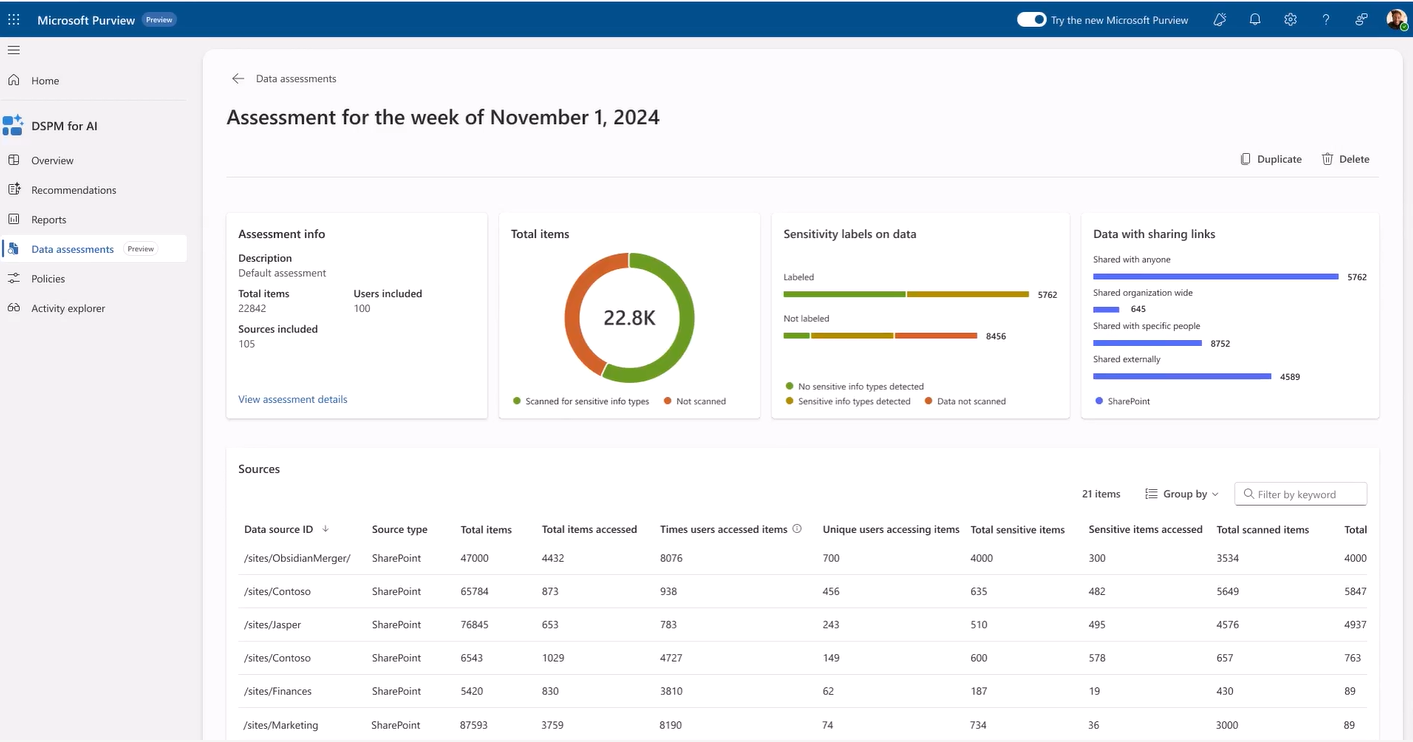

Skvělým místem pro začátek je zpráva Posouzení pro týden.

Můžete přejít k podrobnostem jednotlivých sestav, abyste se dozvěděli více o tom, kde máte mezery v ovládacích prvcích, popiscích a zásadách DLP, abyste mohli tyto problémy rychle napravit.

Pro každou sestavu poskytuje DSPM pro umělou inteligenci doporučení ke zlepšení zabezpečení dat. Pomocí odkazu Zobrazit všechna doporučení nebo Doporučení z navigačního podokna zobrazíte všechna dostupná doporučení pro vašeho tenanta a jejich stav.

Pomocí následujících zdrojů informací můžete chránit aplikace a data AI pomocí DSPM pro AI.

| Úkol | Doporučené zdroje informací |

|---|---|

| Další informace o DSPM pro AI | Jak používat DSPM pro AI |

| Získejte informace o požadavcích a o tom, jak fungují zásady na jedno kliknutí a výchozí zásady. | Důležité informace o DSPM pro AI |

| V případě aplikací AI v jiných poskytovatelích cloudu se dozvíte, jak otestovat integraci s DSPM pro AI pomocí sady Purview SDK. | Testování aplikace AI integrované se sadou Purview SDK |

Krok 3 – Pokračování v identifikaci mezer v popiscích citlivosti a zásadách ochrany před únikem informací

V části Příprava na zabezpečení AI jste použili nástroje pro správu stavu zabezpečení dat Microsoft Purview, DSPM a DSPM pro AI k určení priority ochrany citlivých dat. Pokračujte v procházení těchto nástrojů, abyste identifikovali mezery v pokrytí zásad a zjistili, kam potřebujete dál investovat do uplatňování popisků citlivosti a zásad ochrany před únikem informací. Rozšiřte také popisky citlivosti a zásady ochrany před únikem informací do aplikací SaaS pomocí programu Defender for Cloud Apps.

K pokroku s Microsoft Purview použijte následující zdroje informací.

| Úkol | Doporučené zdroje informací |

|---|---|

| Informace o doporučených strategiích nasazení pro ochranu informací | Nasazení řešení ochrany informací pomocí Microsoft Purview |

| Rozšíření popisků citlivosti a zásad ochrany před únikem informací do aplikací SaaS pomocí Defenderu pro Cloud Apps | Ochrana informací pro aplikace SaaS v deply |

| Definování popisků citlivosti a zásad, které budou chránit data vaší organizace |

Začínáme s popisky citlivosti Vytváření a konfigurace popisků citlivosti a jejich zásad Omezení přístupu k obsahu pomocí popisků citlivosti a šifrování |

| Označování a ochrana dat pro aplikace a služby Microsoftu 365 |

Správa citlivostních štítků v aplikacích Office Zapnutí popisků citlivosti pro soubory v SharePoint a OneDrive |

| Upravte zásady ochrany před únikem informací | Vytvoření a nasazení zásad ochrany před únikem informací |

| V případě aplikací AI vyvinutých v Azure nebo jiných poskytovatelů cloudu se dozvíte, jak používat popisky citlivosti a zásady ochrany před únikem informací pomocí sady Purview SDK. |

Co je Purview SDK Použití rozhraní MICROSOFT Graph Purview API Testování aplikace AI integrované se sadou Purview SDK |

Krok 4 – Použití šablony Riziková AI ve správě vnitřních rizik (IRM)

Microsoft Purview Insider Risk Management (IRM) obsahuje předdefinované šablony zásad, které můžete použít pro vaše prostředí, včetně rizikového využití AI. Šablony IRM jsou předdefinované podmínky zásad, které definují typy indikátorů rizik a model vyhodnocování rizik používaný zásadou.

Zásady používání rizikové umělé inteligence můžou pomoct rozpoznat a povolit vyhodnocování rizik pro výzvy a odpovědi v rámci nástrojů AI ve vaší organizaci. IRM vám pomůže prozkoumat a provést akce týkající se rizikových aktivit souvisejících s AI.

Pomocí následujících zdrojů informací můžete začít se správou insiderských rizik a použít šablonu zásad používání rizikové umělé inteligence.

| Úkol | Doporučené zdroje informací |

|---|---|

| Začněte se správou rizik interních pracovníků a prozkoumejte hlavní scénáře, které vaší organizaci přinášejí výhody. | Informace o správě insiderských rizik |

| Aplikovat šablonu Riziková AI | Další informace o šablonách zásad pro správu insiderských rizik | Microsoft Learn |

| Další informace o klíčových scénářích pro AI a zobrazení ukázkových sestav | Insider Risk Management umožňuje zviditelnit rizikové využití umělé inteligence a šetření zabezpečení |

| Pro aplikace AI vyvinuté pomocí sady Purview SDK otestujte integraci řešení Insider Risk Management. | Testování aplikace AI integrované se sadou Purview SDK |

Krok 5 – Konfigurace adaptivní ochrany pro správu insiderských rizik

Adaptivní ochrana v Microsoft Purview Insider Risk Management dynamicky přiřazuje uživatelům úroveň rizika a pak aplikuje zásady, které vytvoříte u uživatelů se středním nebo zvýšeným rizikem. Zásady můžou implementovat zvýšené akce ochrany před únikem informací, zachovat odstraněný obsah nebo vynutit vyšší požadavky podmíněného přístupu.

K zahájení práce s adaptivní ochranou využijte následující zdroje informací.

| Úkol | Doporučené zdroje informací |

|---|---|

| Začněte se správou rizik interních pracovníků a prozkoumejte hlavní scénáře, které vaší organizaci přinášejí výhody. | Informace o správě insiderských rizik |

| Další informace o klíčových scénářích pro AI a zobrazení ukázkových sestav | Insider Risk Management umožňuje zviditelnit rizikové využití umělé inteligence a šetření zabezpečení |

| Aplikovat šablonu Riziková AI | Další informace o šablonách zásad pro správu insiderských rizik |

| Vyšetřování a reakce na aktivity insiderských rizik |

Zkoumání aktivit řízení insiderských rizik Podnikněte akce týkající se případů řízení insiderských rizik |

Využít ochranu před hrozbami na maximum pro AI

Defender for Cloud Apps a Defender for Cloud zahrnují funkce, které vám umožní informovat o používání nové aplikace AI a použití vhodných ovládacích prvků.

Krok 1 – Použití defenderu for Cloud Apps ke třídění a ochraně používání aplikací AI

Předchozí článek v této sérii, Seznámení s aplikacemi AI a daty, se zaměřil na použití Defenderu pro Cloud Apps ke zjišťování aplikací AI ve vašem prostředí. Tento článek doporučuje organizacím, aby používaly Defender for Cloud Apps ke sledování nových využívání AI aplikací tím, že posoudí rizika, která představují pro vaše prostředí, schválí nebo blokují tyto aplikace a použijí ovládací prvky relací na aplikace.

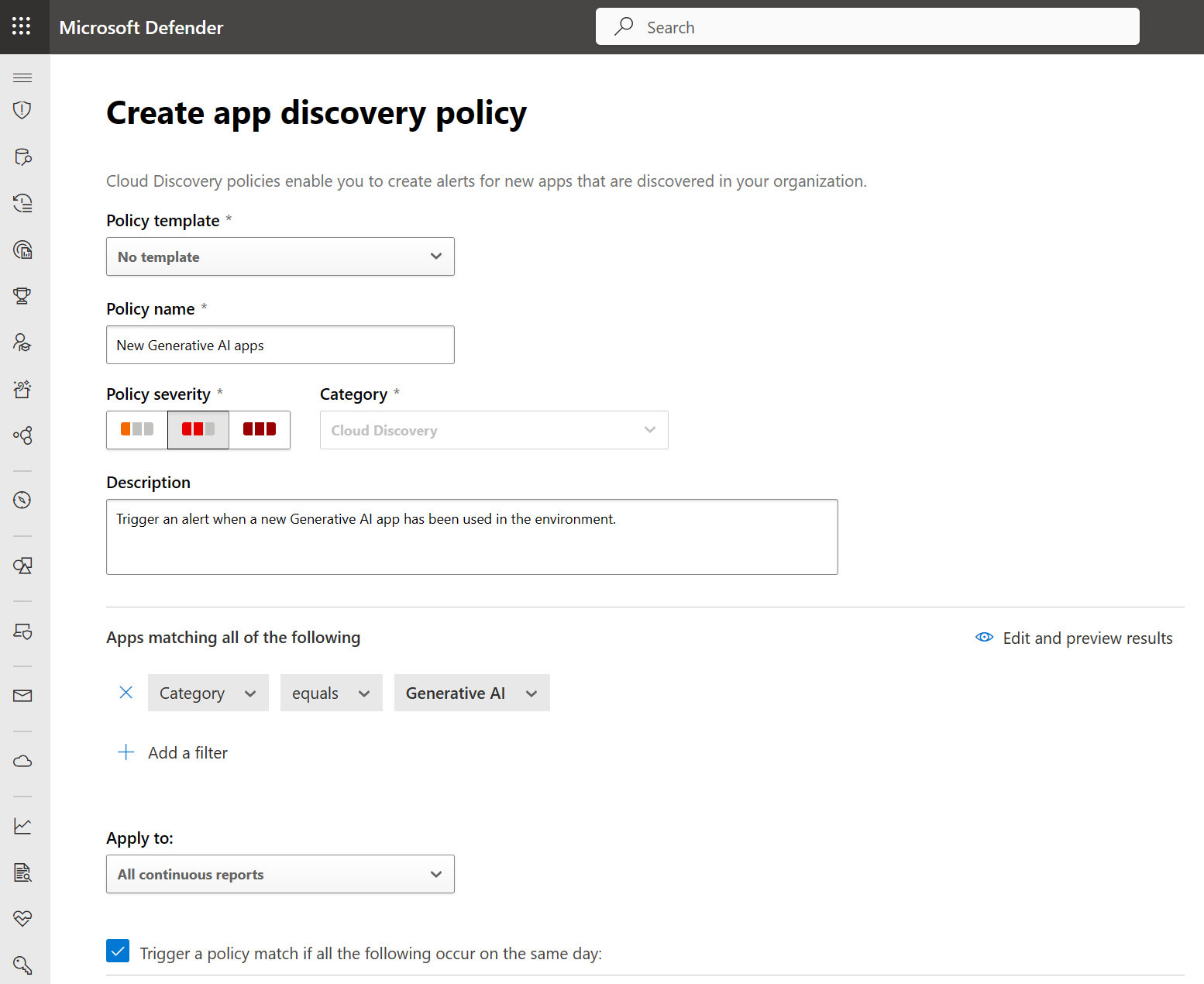

Nejprve vytvořte zásadu, která automaticky aktivuje upozornění při použití nové aplikace Generative AI ve vaší organizaci.

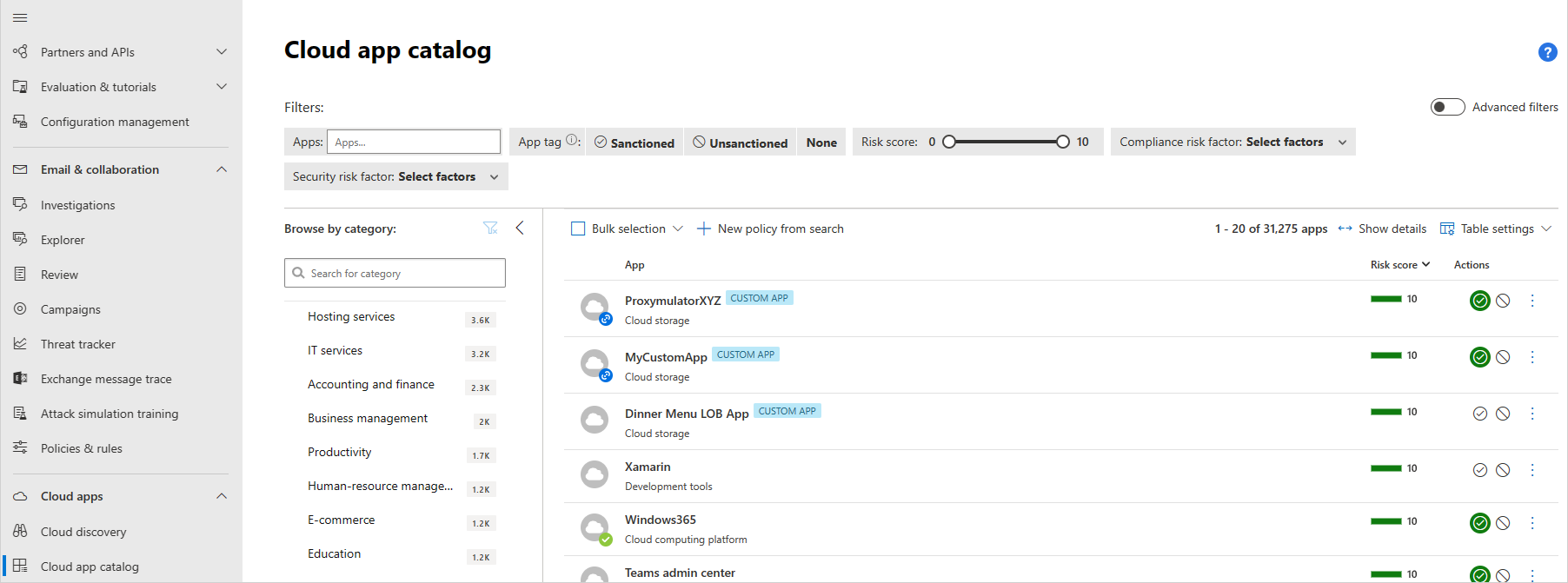

Dále vyhodnoťte skóre rizika pro nově zjištěné aplikace. Můžete také přizpůsobit skóre rizika. Například vysoce regulované organizace můžou chtít změnit váhu konkrétních atributů rizikového skóre. Můžete také přepsat hodnocení rizika.

Rozhodněte se, jestli chcete každou aplikaci schvalovat nebo blokovat. Organizace se můžou rozhodnout blokovat používání aplikací z různých důvodů. Některé jsou znepokojeny tím, že citlivá data se nebudou s aplikacemi sdílet s aplikacemi a budou se později zpřístupnit cílové skupině mimo organizaci. To může způsobit, že organizace zablokuje používání všech nespravovaných aplikací AI. I když ostatní organizace potřebují zajistit, aby všechny používané aplikace splňovaly různé standardy, jako je SOC2 nebo HIPAA.

Nakonec pro aplikace, které schvalujete, rozhodněte se, zda chcete použít politiky relací pro větší kontrolu a viditelnost. Zásady relací umožňují aplikovat parametry na způsob, jakým vaše organizace používá cloudové aplikace. Můžete například nakonfigurovat zásady relace, které umožňují přístup k aplikaci AI jenom spravovaným zařízením. Jednodušším příkladem může být konfigurace zásady pro monitorování provozu z nespravovaných zařízení, abyste mohli před použitím přísnějších zásad analyzovat riziko tohoto provozu.

Na tomto obrázku:

- Přístup uživatelů a zařízení ve vaší organizaci ke schválených cloudovým aplikacím se směruje přes Defender for Cloud Apps, kde se zásady relací dají použít na konkrétní aplikace.

- Cloudové aplikace, které jste neschvalovali nebo explicitně neschválili, nejsou ovlivněné.

Defender for Cloud Apps navíc poskytuje vyhrazené detekce pro Microsoft 365 Copilot. Bezpečnostní týmy můžou detekovat podezřelé interakce uživatele s Copilotem a reagovat na hrozbu a zmírnit je. Když například uživatel přistupuje k citlivým datům prostřednictvím Copilotu z rizikové IP adresy, Defender for Cloud Apps aktivuje výstrahu, která tuto podezřelou aktivitu označí důležitými podrobnostmi, včetně techniky útoku MITRE, IP adresy a dalších polí, která můžou bezpečnostní týmy použít k dalšímu prozkoumání tohoto upozornění.

Jako další kroky použijte následující zdroje informací.

| Úkol | Doporučené zdroje informací |

|---|---|

| Projděte si kroky 5 až 8 v tomto toku nasazení Defenderu pro Cloud Apps. | Zjišťování a správa cloudových aplikací |

| Projděte si toto videokurz o správě aplikací. | Zjistěte, které aplikace generující AI se ve vašem prostředí používají pomocí Defenderu pro Cloud Apps – YouTube |

| Vytvoření zásad zjišťování aplikací | Vytvoření zásad cloud discovery |

| Posouzení skóre rizika pro nově zjištěné aplikace | Katalog cloudových aplikací a skóre rizika |

| Schválení nebo blokování nových aplikací | Zjištěné aplikace |

| Použití zásad relací u aplikací AI pro lepší kontrolu a viditelnost | Vytvořte zásady relace |

| Zjistěte, jak používat ochranu před hrozbami pro Microsoft 365 Copilot. | Nové detekce hrozeb pro Microsoft Copilot pro Microsoft 365 |

Krok 2 – Použití ochrany AI v defenderu pro cloud

Předchozí článek v této sérii, Seznámení s aplikacemi a daty AI, se zaměřil na zjišťování úloh a modelů generující AI běžících ve vašem prostředí. Tento článek se zaměřuje na ochranu aplikací GenAI v průběhu životního cyklu aplikace při vytváření a používání vlastních aplikací AI.

Organizace se rozhodly vyvíjet nové aplikace GenAI a vkládat AI do stávajících aplikací, aby se zvýšila efektivita a produktivita firmy. Útočníci stále častěji chtějí využít aplikace ke změně navrženého účelu modelu AI novými útoky, jako jsou injektáže výzvy, útoky na peněženky, krádež modelu a otrava dat, a současně zvyšují citlivost na známá rizika, jako jsou porušení zabezpečení dat a odmítnutí služby. Bezpečnostní týmy musí být připravené a zajistit, aby měly správné bezpečnostní mechanismy pro své aplikace AI a detekce, které řeší nové prostředí hrozeb.

Microsoft Defender for Cloud pomáhá organizacím zabezpečit hybridní a multicloudová prostředí od kódu do cloudu. Defender pro cloud zahrnuje možnosti zabezpečení a ochrany před hrozbami, které organizacím umožňují chránit své podnikové aplikace GenAI v průběhu celého životního cyklu aplikace:

- Nepřetržitě zjišťovat komponenty aplikací GenAI a artefakty AI z kódu do cloudu.

- Prozkoumejte a opravte rizika pro aplikace GenAI pomocí integrovaných doporučení pro posílení stavu zabezpečení.

- Identifikace a náprava toxických kombinací v aplikacích GenAI pomocí analýzy cesty útoku

- Detekce u aplikací GenAI využívajících ochranné štíty Azure AI Content Safety, signály Microsoftu pro analýzu hrozeb a monitorování kontextových aktivit.

- Proaktivní vyhledávání a zkoumání útoků v aplikacích GenAI s integrovanou integrací s Microsoft Defenderem

Začněte s možnostmi správy zabezpečení AI v programu Defender Cloud Security Posture Management (CSPM). Defender CSPM automaticky a nepřetržitě zjišťuje nasazené úlohy AI bez agentů a poskytuje podrobný přehled o přítomnosti a konfiguracích modelů AI, sadách SDK a technologií používaných napříč službami AI, jako jsou Azure OpenAI Service, Azure Machine Learning a Amazon Bedrock.

CSPM nepřetržitě vystavuje kontextové problémy se zabezpečením a navrhuje doporučení zabezpečení založená na rizicích přizpůsobená k určení priorit kritických mezer napříč úlohami AI. Relevantní doporučení zabezpečení se také zobrazují v samotném prostředku Azure OpenAI na webu Azure Portal a poskytují vývojářům nebo vlastníkům úloh přímý přístup k doporučením a pomáhají rychleji napravit.

Schopnost analýzy cesty útoků dokáže identifikovat sofistikovaná rizika pro zátěže AI, včetně scénářů zabezpečení dat, kdy je zemnění nebo vyladění dat vystaveno internetu prostřednictvím laterálního pohybu a je náchylné k otrávení dat.

Dále zajistěte bezpečnost během běhu s ochranou před hrozbami pro úlohy AI. Defender for Cloud zahrnuje ochranu před hrozbami pro úlohy AI. Ochrana před hrozbami pro AI využívá nativní integraci služby Azure OpenAI Service, ochrany obsahu Azure AI Content Safety a inteligentní analýzy hrozeb Od Microsoftu k poskytování kontextových a akčních výstrah zabezpečení. Ochrana před hrozbami pro úlohy AI umožňuje týmům zabezpečení monitorovat své aplikace s technologií Azure OpenAI za běhu za účelem škodlivé aktivity spojené s přímými útoky injektáží, citlivými úniky dat a otravou daty a také zneužitím peněženky nebo útoky na odepření služeb.

Pro další kroky použijte následující zdroje informací.

| Úkol | Doporučené zdroje informací |

|---|---|

| Projděte si hlavní scénáře popsané v tomto blogu. | Zabezpečení aplikací generující AI pomocí Microsoft Defenderu pro cloud |

| Použití CSPM k získání přehledu o rizicích umělé inteligence ve vašem prostředí |

Ochrana prostředků pomocí nástroje Defender CSPM Zkontrolovat nástěnku zabezpečení dat a AI (Preview) |

| Povolit ochranu před hrozbami pro pracovní zátěže AI (náhled) | Povolení ochrany před hrozbami pro úlohy AI (Preview) Upozornění pro úlohy AI (Preview) |

Další krok pro zabezpečení AI

Po ochraně aplikací a dat AI ve vaší organizaci je dalším krokem řízení aplikací AI tak, aby splňovaly zákonné požadavky na dodržování předpisů:

- Posuďte a posilněte svůj přístup ke shodě s předpisy.

- Zavést opatření pro řízení využívání AI aplikací a dat.

Podívejte se na další článek v této sérii: Jak můžu řídit dodržování předpisů pomocí umělé inteligence?