Poznámka:

Přístup k této stránce vyžaduje autorizaci. Můžete se zkusit přihlásit nebo změnit adresáře.

Přístup k této stránce vyžaduje autorizaci. Můžete zkusit změnit adresáře.

Nařízení a standardy pro umělou inteligenci se objevují napříč regiony a průmysly, poskytují robustní rámec pro organizace k hodnocení, implementaci a testování jejich opatření za účelem vývoje a používání důvěryhodné umělé inteligence. Tento článek pomáhá týmům pro řízení rizik a zajištění souladu se připravit na úsilí o dodržování předpisů. Popisuje, jak na to:

- Posuďte a posilněte svůj přístup ke shodě s předpisy.

- Zavést opatření pro řízení využívání AI aplikací a dat.

Toto je čtvrtý článek ze série. Pokud jste dosud nesplnili úkoly v Přípravě na bezpečnost AI, Objevování AI aplikací a dat a Ochrana AI aplikací a dat, začněte s těmito články, abyste připravili své prostředí s dovednostmi doporučenými v tomto článku.

Tento článek se používá společně s těmito zdroji informací:

- Obchodní scénář architektury přechodu na nulovou důvěryhodnost – Splnění zákonných požadavků a požadavků na dodržování předpisů s nulovou důvěryhodností

- Cloud Adoption Framework (CAF) pro AI—Proces řízení AI

Jaké jsou nové úvahy pro řízení AI aplikací a dat?

Stejně jako umělá inteligence představuje nové plochy útoku, které mění rizikové prostředí, tak také zavádí nové metody zpracování a používání dat, které ovlivňují soulad s předpisy. Tyto nové charakteristiky AI ovlivňují jak stávající předpisy, jako jsou předpisy o ochraně soukromí, tak i nové předpisy cílené specificky na využití AI.

Následující ilustrace zdůrazňuje vznikající regulace AI, včetně zákona o umělé inteligenci a datech (AIDA) v Severní Americe, zákona o umělé inteligenci EU, akčního plánu AI v Austrálii a globálních standardů produkovaných ISO.

Obecně platí, že řízení AI pro zajištění souladu s předpisy zahrnuje:

- Zaznamenávání a uchovávání interakcí s AI.

- Detekce potenciálního nevyhovujícího použití.

- Použití nástrojů, jako je eDiscovery pro interakce s AI, když je to potřeba.

To pomáhá organizacím splnit jejich požadavky na dodržování předpisů a efektivně reagovat na potenciální právní spory.

Pro organizace, které vyvíjejí AI, musí týmy pro řízení rizik a dodržování předpisů umožnit vývojovým týmům dokumentovat podrobnosti jejich projektů, jako je název modelu, verze, účel AI systémů a jejich hodnotící metriky pro řešení rizik spojených s kvalitou, bezpečností a zabezpečením. Toto úsilí může pomoci týmům pro řízení rizik a dodržování předpisů mít standardizovaný formát informací k přípravě na audity a reakci na požadavky regulátorů.

Dalším osvědčeným postupem je používání hodnocení dopadu na soukromí, což je opatření, které mnoho společností již zavedlo pro dodržování předpisů, jako je GDPR, aby zajistily, že AI aplikace mají veškerá hodnocení a kontroly k ochraně soukromí. Microsoft poskytuje nástroje, jako je Priva Privacy Assessments, které lze snadno integrovat do vašeho vývojového cyklu AI, aby se zajistilo, že vývojáři budou mít ochranu soukromí na prvním místě.

Nakonec, aby mohly organizace vyvíjet odpovědné aplikace AI a dodržovat nové regulační požadavky, musí vytvořit opatření pro detekci a blokování škodlivého obsahu, jako je násilí, nenávist, sexuální a sebepoškozující obsah. Navíc chcete, aby vaše aplikace AI vytvářely spolehlivý obsah. Ochranné prvky by měly pomoci detekovat a opravit nesprávné informace, aby se snížilo riziko chybných rozhodnutí založených na neopodstatněném výstupu. Měli by také identifikovat obsah, který porušuje autorská práva. Tato ochranná opatření mohou organizacím pomoci při vytváření odpovědných a důvěryhodných aplikací AI.

Schopnosti pro správu aplikací a dat AI

Společnost Microsoft zahrnuje funkce, které pomáhají organizacím spojovat jednotlivé prvky mezi regulatorními standardy a technologickými řešeními.

Následující kroky popisují obrázek a také si projděte kroky implementace těchto funkcí.

| Krok | Úkol | Rozsah |

|---|---|---|

| 1 | Vytvářejte a spravujte hodnocení v Microsoft Purview Compliance Manager | Celopodnikový |

| 2 | Použití Defenderu pro Cloud Apps ke správě aplikací AI na základě rizika dodržování předpisů | Aplikace AI pro SaaS |

| 3 | Použijte správu zabezpečení cloudu (Cloud Security Posture Management, CSPM) pro pracovní zátěž AI ke zjištění a řízení vlastních aplikací na základě rizika souladu. | Aplikace AI na bázi Azure AI vytvořené na míru |

| 4 | Nakonfigurujte Purview Communication Compliance tak, abyste minimalizovali komunikační rizika tím, že vám pomůže detekovat, zaznamenat a reagovat na potenciálně nevhodné zprávy ve vaší organizaci. | Aplikace a služby Microsoftu 365 Aplikace umělé inteligence propojené konektory Microsoft Entra nebo Microsoft Purview Data Map Služby Azure AI |

| 5 | Nakonfigurujte správu životního cyklu dat pomocí Purview tak, aby si uchovávala obsah, který potřebujete, a mazala obsah, který nepotřebujete. | Zásady uchovávání informací pro aplikace AI zahrnují uživatelské výzvy a odpovědi pro Microsoft 365 Copilot a Copilot Studio, a také uživatelské výzvy a odpovědi pro další kopiloty Microsoftu a generativní aplikace AI, pokud mají zásady shromažďování s nastavením pro zachycení obsahu. Tyto zprávy je pak možné zachovat a odstranit z důvodů dodržování předpisů. K integraci aplikací AI vyvinutých na jiných poskytovatelích cloudu použijte sadu Purview SDK. |

| 6 | Použijte eDiscovery spolu s protokoly auditu pro Microsoft 365 Copilot pro vyšetřování podle potřeby. | Protokoly auditu se automaticky generují, když uživatel pracuje s Copilotem nebo aplikací AI. K integraci aplikací AI vyvinutých na jiných poskytovatelích cloudu použijte sadu Purview SDK. |

| 7 | Pomocí Priva posouzení ochrany osobních údajů zahájíte posouzení dopadu na ochranu osobních údajů pro AI aplikace, které vytváříte | Jakákoli aplikace, jakákoli lokace |

| 8 | Použijte zprávy o umělé inteligenci v AI Foundry k dokumentaci podrobností o projektech umělé inteligence pro aplikace, které vyvíjíte. | AI aplikace v Azure |

| 9 | Implementujte Azure AI Content Safety k blokování škodlivého obsahu a k detekci a opravě nepodložených odpovědí. | AI aplikace v Azure |

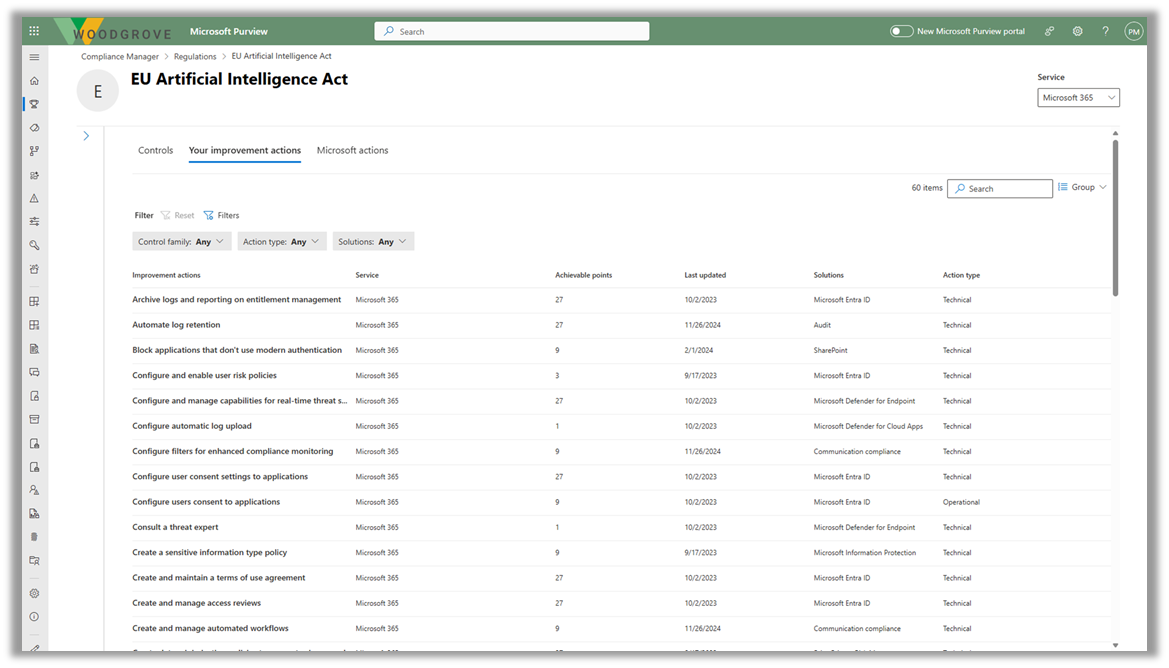

Krok 1 – Sestavení a správa posouzení v Microsoft Purview Compliance Manageru

Microsoft Purview Compliance Manager je řešení, které vám pomáhá automaticky posuzovat a spravovat shodu ve vašem prostředí multi-cloud. Compliance Manager vám může pomoci po celou dobu vaší cesty za dodržováním pravidel, od zmapování vašich rizik ochrany dat až po řízení složitostí implementace opatření, udržování aktuálnosti s předpisy a certifikacemi a podávání zpráv auditorům.

V současné době Compliance Manager zahrnuje šablony pro dodržování předpisů pro následující předpisy týkající se umělé inteligence:

- Zákon EU o umělé inteligenci

- ISO/IEC 23894:2023

- ISO/IEC 42001:2023

- NIST AI Risk Management Framework (RMF) 1.0

Použijte následující zdroje, abyste mohli začít s Compliance Managerem.

| Úkol | Doporučené zdroje informací |

|---|---|

| Zjistěte více a začněte |

Microsoft Purview Compliance Manager Začínáme s Microsoft Purview Compliance Managerem Vytvářejte a spravujte hodnocení v Microsoft Purview Compliance Manager |

| Sledujte, zda Compliance Manager obsahuje šablonu pro předpis. | Seznam nařízení |

| Vytvořte vlastní hodnocení | Vytváření vlastních hodnocení (náhled) v Microsoft Purview Compliance Manager |

Krok 2 – Použití Defenderu pro Cloud Apps

Použijte Defender for Cloud Apps ke správě aplikací AI na základě rizika souladu. ** Předchozí články v této sérii popisují, jak používat Defender pro Cloud Apps k objevování, správě a ochraně využívání AI aplikací. Regulace dodržování předpisů zavádí další kritéria pro třídění a hodnocení rizika těchto aplikací.

Po vytvoření jednoho nebo více posouzení pro konkrétní předpisy ve Správci dodržování předpisů Purview spolupracujte s týmem Defenderu for Cloud Apps a integrujte své povinnosti dodržování předpisů do kritérií pro posouzení rizika aplikací AI, schválení nebo blokování těchto aplikací a použití zásad relací pro řízení přístupu k těmto aplikacím (například jenom u vyhovujícího zařízení).

Viz předchozí články v této sérii, abyste se seznámili s a používali Defender for Cloud Apps.

| Úkol | Doporučené zdroje informací |

|---|---|

| Objevujte, schvalujte a blokujte aplikace s umělou inteligencí pomocí Microsoft Defender pro cloudové aplikace. | Viz krok 3 v tématu Zjišťování aplikací a dat AI |

| Použijte Defender for Cloud Apps k třídění a ochraně používání aplikací AI | Viz Jak co nejlépe využít ochranu proti hrozbám pro AI v aplikacích a datech Protect AI |

Krok 3—Použijte řízení stavu zabezpečení cloudů (CSPM) pro pracovní úlohy AI

Využijte plán Defender Cloud Security Posture Management (CSPM) v programu Microsoft Defender for Cloud ke zjišťování a řízení vlastnoručně vytvořených aplikací na základě rizika souladu. Stejně jako Defender for Cloud Apps, zavádí regulační shoda další kritéria pro třídění a posouzení rizika vašich vlastních aplikací s CSPM pro AI.

Spolupracujte se svým týmem Defender for Cloud na začlenění vašich povinností v oblasti compliance do kritérií pro posouzení rizika a řízení vašich vlastních aplikací.

Podívejte se na předchozí články v této sérii, abyste se seznámili s aplikací Defender pro Cloud a naučili se ji používat.

| Úkol | Doporučené zdroje informací |

|---|---|

| Objevte nasazené úlohy AI ve vašem prostředí a získejte bezpečnostní přehledy s Microsoft Defender pro Cloud | Viz krok 4 v tématu Zjišťování aplikací a dat AI] |

| Použít ochrany AI v Defenderu pro Cloud | See krok 2 v části Maximální využití ochrany před hrozbami pro AI v části Ochrana aplikací a dat AI |

Krok 4 – Konfigurace dodržování předpisů komunikace Purview

Nakonfigurujte dodržování předpisů komunikace Purview, abyste minimalizovali komunikační rizika tím, že vám pomůže zjišťovat, zaznamenávat a reagovat na potenciálně nevhodné zprávy ve vaší organizaci. V případě generující umělé inteligence můžete pomocí zásad dodržování předpisů komunikace analyzovat interakce (výzvy a odpovědi) zadané do generativních aplikací AI, které pomáhají detekovat nevhodné nebo rizikové interakce nebo sdílení důvěrných informací. Pokrytí je podporováno pro Microsoft 365 Copilot, Copilots sestavené pomocí Microsoft Copilot Studia, aplikací AI propojených pomocí konektorů Microsoft Entra nebo Microsoft Purview Data Map a další.

Použijte následující zdroje pro začátek.

| Úkol | Doporučené zdroje informací |

|---|---|

| Zjistěte více a začněte. |

Zjistěte více o dodržování pravidel komunikace Plán pro zajištění souladu komunikace Začněte s dodržováním pravidel komunikace |

| Konfigurace zásad |

Nakonfigurujte zásady souladu s komunikací pro detekci interakcí generativní AI Vytváření a správa zásad dodržování předpisů pro komunikaci |

Krok 5 – Konfigurace správy životního cyklu dat Purview

Microsoft Purview Data Lifecycle Management vám poskytuje nástroje a možnosti k uchování obsahu, který potřebujete zachovat, a k odstranění obsahu, který nepotřebujete. Proaktivní mazání obsahu, který již nemusíte uchovávat, pomáhá snížit riziko nadměrného zpřístupnění dat v nástrojích AI. Mezi klíčové funkce patří:

- Zásady uchovávání a štítky uchovávání

- Archivace poštovní schránky a neaktivní poštovní schránky—Uživatelské poštovní schránky obsahují skrytou složku s výzvami a odpověďmi Copilota

Použijte následující zdroje pro začátek.

| Úkol | Doporučené zdroje informací |

|---|---|

| Zjistěte více a začněte |

Další informace o správě životního cyklu dat Microsoft Purview Začněte se správou životního cyklu dat |

| Informace o uchovávání informací pro aplikace Copilot a AI | Zjistěte, jak funguje uchovávání s aplikacemi AI. |

| Pro aplikace AI vyvinuté v jiných poskytovatelích cloudu se integrujte se sadou Purview SDK. | Další informace o sadě Microsoft Purview SDK |

Krok 6 – Použití eDiscovery společně s protokoly auditu pro Microsoft 365 Copilot

Použijte Microsoft Purview eDiscovery k vyhledávání klíčových slov v dotazech a odpovědích Copilot, které mohou být nevhodné. Tyto informace můžete zahrnout také do případu eDiscovery, abyste mohli tato data zkontrolovat, exportovat nebo zadržet pro probíhající právní šetření.

Pomocí protokolů auditu Microsoft Purview můžete identifikovat, jak, kdy a kde došlo k interakcím s Copilotem, a které položky byly zpřístupněny, včetně případných citlivostních štítků na těchto položkách.

| Úkol | Doporučené zdroje informací |

|---|---|

| Naučte se, kde jsou ukládána data o využití Copilot a jak je můžete auditovat. | Architektura ochrany dat a auditování Microsoft 365 Copilot |

| Začněte s eDiscovery | Zjistěte více o řešeních eDiscovery |

| Seznamte se s protokoly auditu Purview | Zjistěte více o řešeních auditu v Microsoft Purview |

| Informace o protokolech auditu pro aplikace AI | Informace o tom, které aktivity správce a uživatelů se protokolují pro aplikace AI |

| Pro aplikace AI vyvinuté v jiných poskytovatelích cloudu se integrujte se sadou Purview SDK. | Další informace o sadě Microsoft Purview SDK |

Krok 7 – Použijte posouzení ochrany osobních údajů Priva

Použijte Priva Privacy Assessments (preview) k zahájení hodnocení dopadu na soukromí pro AI aplikace, které vytváříte. To pomáhá zajistit, aby aplikace AI byly vytvářeny způsobem, který respektuje soukromí. Posouzení ochrany osobních údajů automatizuje zjišťování, dokumentaci a vyhodnocení používání osobních údajů v rámci celého vašeho datového prostředí.

Použijte následující zdroje, abyste začali s hodnocením ochrany soukromí Priva a zahájili posouzení dopadu na soukromí.

| Úkol | Doporučené zdroje informací |

|---|---|

| Zjistěte více a začněte |

Seznamte se s hodnocením ochrany soukromí Začněte s hodnocením ochrany soukromí |

| Vytvořte hodnocení | Vytvářejte a spravujte hodnocení ochrany soukromí |

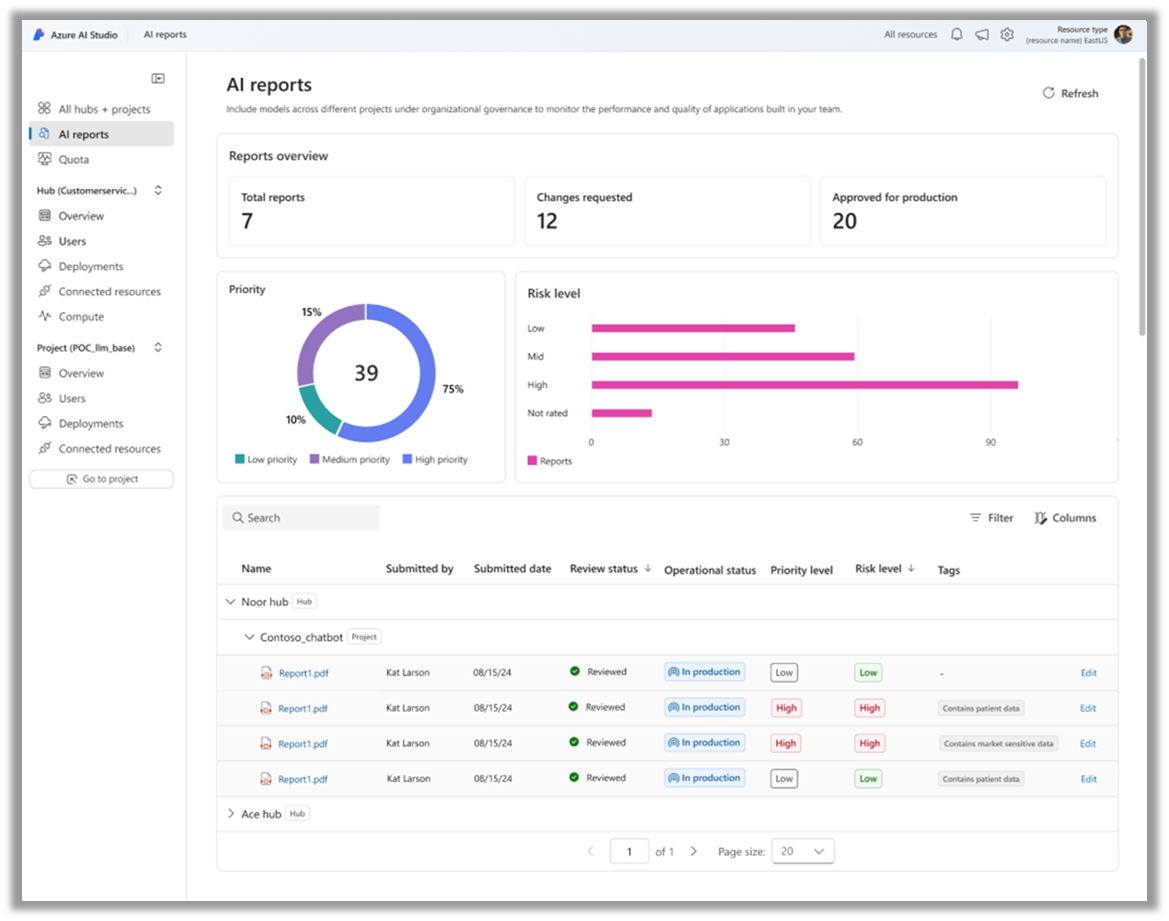

Krok 8 – Použití sestav AI v AI Foundry

AI zprávy v Azure AI Foundry mohou pomoci vývojářům dokumentovat podrobnosti jejich projektů. Vývojáři můžou vytvořit sestavu, která zobrazuje všechny podrobnosti o projektu AI, jako jsou karty modelů, verze modelů, konfigurace filtru bezpečnosti obsahu a metriky vyhodnocení. Tuto sestavu je možné exportovat ve formátech PDF nebo SPDX, což pomáhá vývojových týmům předvést připravenost na produkční prostředí v rámci pracovních postupů zásad správného řízení, rizik a dodržování předpisů (GRC) a usnadnit průběžné audity aplikací v produkčním prostředí.

Použijte následující zdroje pro začátek.

| Úkol | Doporučené zdroje informací |

|---|---|

| Přečtěte si o zprávách o umělé inteligenci na blogu AI Foundry. | Zprávy o AI: Zlepšete řízení AI a GenAIOps s konzistentní dokumentací |

| Naučte se a začněte s AI Foundry | Co je Azure AI Foundry? |

Krok 9 – Implementace zabezpečení obsahu Azure AI

Azure AI Content Safety je služba AI, která detekuje škodlivý uživatelem generovaný a generovaný obsah umělé inteligence v aplikacích a službách. Azure AI Content Safety obsahuje rozhraní API pro text a obrázky, která umožňují detekovat škodlivý materiál. Interaktivní Content Safety Studio umožňuje zobrazit, prozkoumat a vyzkoušet vzorový kód pro detekci škodlivého obsahu v různých režimech.

Použijte následující zdroje pro začátek.

| Úkol | Doporučené zdroje informací |

|---|---|

| Zjistěte více a začněte | Co je Zabezpečení obsahu Azure AI? – Služby Azure AI | Microsoft Learn Použijte zabezpečení obsahu v portálu Azure AI Foundry |

Další krok pro zabezpečení AI

Pokračujte v pokroku v zabezpečení od začátku do konce s využitím zdrojů Zero Trust.