Bemærk

Adgang til denne side kræver godkendelse. Du kan prøve at logge på eller ændre mapper.

Adgang til denne side kræver godkendelse. Du kan prøve at ændre mapper.

[Denne artikel er til dokumentationen til den foreløbige udgivelse. Der kan forekomme ændringer.]

Et testsæt består af en gruppe på op til 100 testtilfælde. Når du kører en agentvurdering, vælger du et testsæt, og Copilot Studio kører alle testcases i det sæt mod din agent.

Du kan manuelt oprette testcases inden for et testsæt, importere dem ved hjælp af et regneark eller bruge AI til at generere beskeder baseret på din agents design og ressourcer. Du kan derefter vælge, hvordan du vil måle kvaliteten af din agents svar for hver testcase i et testsæt.

For mere information om, hvordan agentvurdering fungerer, se Om agentvurdering.

For at lære, hvordan man redigerer et eksisterende testsæt, se Ændr detaljerne i et testsæt.

Vigtigt!

Testresultater er tilgængelige i Copilot Studio i 89 dage. For at gemme dine testresultater i længere tid, eksporter resultaterne til en CSV-fil.

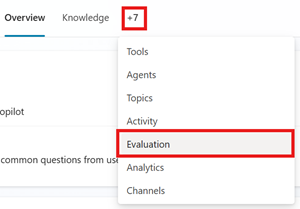

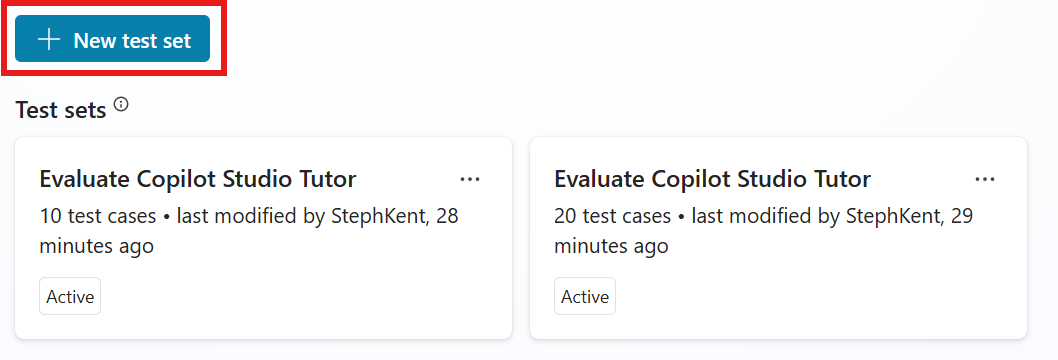

Opret et nyt testsæt

- Gå til din agents vurderingsside .

Vælg Ny evaluering.

På siden Ny evaluering vælger du den metode, du vil bruge til at oprette dit testsæt. Et testsæt kan have op til 100 testcases.

- Sæt et hurtigt spørgsmål for at få Copilot Studio til automatisk at oprette testcases baseret på din agents beskrivelse, instruktioner og kapaciteter. Denne mulighed genererer 10 spørgsmål til at køre små, hurtige evalueringer eller til at begynde at opbygge et større testsæt.

- Et komplet spørgsmålssæt for at lade Copilot Studio generere testcases ved hjælp af din agents videnskilder eller emner og vælge antallet af spørgsmål, der skal genereres.

-

Brug din testchat-samtale til automatisk at udfylde testsættet med de spørgsmål, du har givet i din testchat. Denne metode bruger spørgsmål fra den seneste testchat. Du kan også starte en evaluering fra testchatten ved at bruge evaluer-knappen

.

.

- Importer testcases fra en fil ved at trække din fil ind i det udpegede område, vælge Gennemse for at uploade en fil eller vælge en af de andre uploadmuligheder.

- Eller skriv selv nogle spørgsmål for manuelt at lave et testsæt. Følg trinene for at redigere et testsæt for at tilføje og redigere testcases.

- Brug produktionsdata baseret på temaer fra din agents analyser.

Rediger detaljerne i testtilfældene. Alle testcases, der bruger metoder, undtagen generel kvalitet, kræver forventede svar. For mere information om redigering, se Ændr et testsæt.

Angiv et navn til testsættet under Navn.

Ændr eller tilføj de testmetoder , du ønsker at bruge:

- Tilføj en ny metode:

- Vælg Tilføj testmetode.

- Vælg alle de metoder, du vil teste med, og vælg derefter OK. Du kan tilføje flere metoder.

- For nogle metoder skal du sætte en bestået score, og derefter vælge OK. Beståelsesscoren bestemmer, hvilken score der resulterer i bestået eller dumpet.

- Nogle metoder kræver, at man tilføjer forventede svar eller nøgleord for hvert af dine testtilfælde. For mere information, se Vælg evalueringsmetoder.

- Vælg en eksisterende testmetode til redigering eller sletning.

Testmetode Målinger Scoring Konfigurationer Generel kvalitet Hvor godt er testcases svar baseret på specifikke kvaliteter Scoret ud af 100% None Sammenlign betydning Hvor godt betydningen af testtilfældets svar matcher det forventede svar Scoret ud af 100% Bestået score, forventet svar Kapacitetsanvendelse Om testsagen brugte de forventede ressourcer Bestået/ikke bestået Forventede kapaciteter Nøgleordsmatch Om testsagen brugte alle eller nogle af de forventede nøgleord eller fraser Bestået/ikke bestået Forventede nøgleord eller fraser Tekstlighed Hvor godt teksten i testtilfældets svar matcher det forventede svar Scoret ud af 100% Bestået score, forventet svar Præcist match Om testtilfældets svar præcist matcher det forventede svar Bestået/ikke bestået Forventet svar - Tilføj en ny metode:

Vælg brugerprofil, og vælg eller tilføj derefter den konto, du vil bruge til dette testsæt, eller fortsæt uden autentificering. Evalueringen bruger denne konto til at forbinde til videnskilder og værktøjer under testning. For information om at tilføje og administrere brugerprofiler, se Administrer brugerprofiler og forbindelser.

Notat

Automatiseret test bruger autentificeringen af den valgte testkonto. Hvis din agent har videnskilder eller forbindelser, der kræver specifik autentificering, vælg den relevante konto til din testning. Når Copilot Studio genererer testcases, bruger den autentificeringsoplysningerne fra en tilknyttet konto til at få adgang til din agents videnskilder og værktøjer. De genererede testcases eller resultater kan indeholde følsomme oplysninger, som den tilknyttede konto har adgang til, og disse oplysninger er synlige for alle skabere, der kan få adgang til testsættet.

Vælg Save for at opdatere testsættet uden at køre testcases eller Evaluate for at køre testsættet med det samme.

Begrænsning for generering af testtilfælde

Generering af testcases fejler, hvis et eller flere spørgsmål overtræder din agents indholdsmoderationsindstillinger. Mulige årsager inkluderer:

- Agentens instruktioner eller emner fører modellen til at generere indhold, som systemet markerer.

- Den tilknyttede videnskilde indeholder følsomt eller begrænset indhold.

- Agentens indholdsmoderationsindstillinger er alt for strenge.

For at løse problemet kan du prøve forskellige handlinger, såsom at justere videnskilder, opdatere instruktioner eller ændre moderationsindstillinger.

Et testsæt kan indeholde op til 100 testtilfælde.

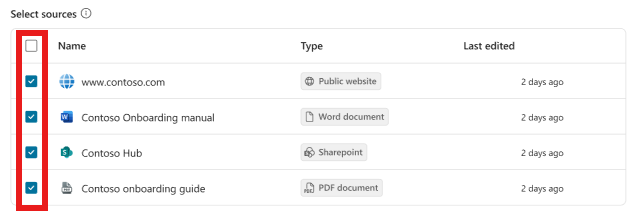

Generer et testsæt ud fra viden eller emner

Du kan teste din agent ved at generere spørgsmål ved hjælp af de oplysninger og samtalekilder, din agent allerede har. Denne testmetode er god til at teste, hvordan din agent bruger den viden og de emner, den allerede har, men den er ikke god til at teste for informationshuller.

Du kan generere testcases ved at bruge disse videnskilder:

Tekst

Microsoft Word

Microsoft Excel

Du kan bruge filer på op til 293 KB til at generere testspørgsmål.

For at generere et testsæt:

I Ny evaluering skal du vælge Hele spørgsmålssættet.

Vælg enten Viden eller Emner.

- Viden fungerer bedst for agenter, der bruger generativ orkestrering. Denne metode skaber spørgsmål ved at bruge et udvalg af din agents videnskilder.

- Topics fungerer bedst for agenter, der bruger klassisk orkestrering. Denne metode skaber spørgsmål ved at bruge din agents emner.

For Knowledge skal du vælge de videnskilder, du vil inkludere i spørgsmålsgenereringen.

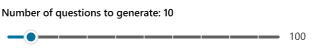

- For Viden og emner skal du vælge og trække skyderen for at vælge, hvor mange spørgsmål der skal genereres.

Vælg Generer.

Angiv et navn til testsættet under Navn.

-

- Ændr eller tilføj de testmetoder , du ønsker at bruge:

- Tilføj en ny metode:

- Vælg Tilføj testmetode.

- Vælg alle de metoder, du vil teste med, og vælg derefter OK. Du kan tilføje flere metoder.

- For nogle metoder skal du sætte en bestået score, og derefter vælge OK. Beståelsesscoren bestemmer, hvilken score der resulterer i bestået eller dumpet.

- Nogle metoder kræver, at man tilføjer forventede svar eller nøgleord for hvert af dine testtilfælde. For mere information, se Vælg evalueringsmetoder

- Vælg en eksisterende testmetode til redigering eller sletning.

Rediger detaljerne i testtilfældene. Alle testcases, der bruger metoder, undtagen generel kvalitet, kræver forventede svar. For mere information om redigering, se Ændr et testsæt.

Vælg Save for at opdatere testsættet uden at køre testcases eller Evaluate for at køre testsættet med det samme.

Opret en testsætfil til import

I stedet for at bygge dine testcases direkte i Copilot Studio kan du oprette en regnearksfil med alle dine testcases og importere dem for at oprette dit testsæt. Du kan skrive hvert testspørgsmål, bestemme den testmetode, du vil bruge, og angive de forventede svar for hvert spørgsmål. Når du er færdig med at oprette filen, skal du gemme den som en .csv- eller .txt-fil og importere den i Copilot Studio.

Vigtigt!

- Filen kan indeholde op til 100 spørgsmål.

- Hvert spørgsmål kan være op til 1.000 tegn, herunder mellemrum.

- Filen skal være i CSV-format (kommaseparerede værdier) eller tekstformat.

Sådan oprettes importfilen:

Åbn et regnearksprogram (f.eks. Microsoft Excel).

Tilføj følgende overskrifter i denne rækkefølge i den første række:

- Spørgsmål

- Forventet svar

- Testmetode

Angiv dine testspørgsmål i kolonnen Spørgsmål. Hvert spørgsmål kan være på 1.000 tegn eller mindre, inklusive mellemrum.

Indtast en af følgende testmetoder for hvert spørgsmål i kolonnen Testmetode :

- Generel kvalitet

- Sammenlign betydning

- Lighed

- Nøjagtigt match

- Nøgleordsmatch

Angiv de forventede svar for hvert spørgsmål i kolonnen Forventet svar. Forventede svar er valgfrie for import af et testsæt. Du skal dog have forventede svar for at køre match, lighed og sammenligne betydningstestcases.

Gem filen som en .csv- eller .txt-fil.

Importer filen ved at følge trinene i Opret et nyt testsæt.

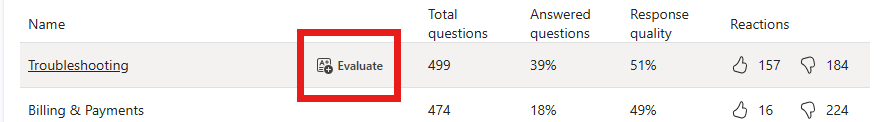

Lav et testsæt baseret på et tema

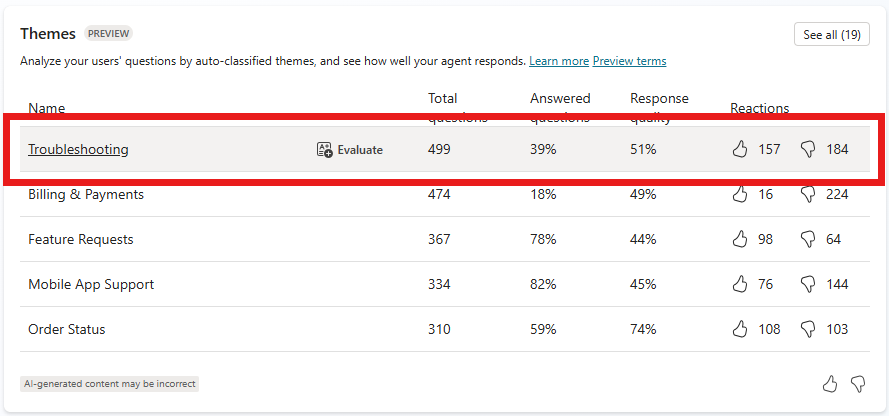

Lav et testsæt med spørgsmål fra samtaler med rigtige brugere. Denne metode bruger temaer (forhåndsvisning), som findes i din agents analyser.

Temaer er grupperinger af spørgsmål, der er taget fra gruppen af brugerspørgsmål, der udløser generative svar. Når du opretter et testsæt med et tema, genererer du testcases ud fra spørgsmål stillet af brugere relateret til det tema.

Brug disse testsæt til at udføre evalueringer med fokus på ét område eller emne inden for din agents omfang. For eksempel, hvis du har en kundeservicemedarbejder, kan du spore svarkvaliteten på fakturerings- og betalingsspørgsmål separat fra andre anvendelsestilfælde som fejlfinding.

Notat

Før du opretter testsæt ud fra temaer, har du brug for adgang til temaer i analytics. Gennemgå adgangskravene til temaer (forhåndsvisning).

På din agents Analytics-side skal du gå til listen over temaer .

Hold musen over et tema, og vælg derefter Evaluer.

Du kan også vælge Se alle for at se flere temaer og derefter vælge Evaluer.

Vælg Opret og åbn.

Rediger detaljerne om testsættene og sagerne. Alle testcases, der bruger metoder, undtagen generel kvalitet, kræver forventede svar. For mere information om redigering, se Ændr et testsæt.

Vælg Save for at opdatere testsættet uden at køre testcases eller Evaluate for at køre testsættet med det samme.