Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Es gibt zwei wichtige Möglichkeiten, um in Unity Maßnahmen für Ihren Anblick zu ergreifen: Handgesten und Motion-Controller in HoloLens und Immersive HMD. Sie greifen über die gleichen APIs in Unity auf die Daten für beide Quellen räumlicher Eingaben zu.

Unity bietet zwei primäre Möglichkeiten für den Zugriff auf räumliche Eingabedaten für Windows Mixed Reality. Die allgemeinen Input.GetButton/Input.GetAxis-APIs funktionieren über mehrere Unity XR SDKs hinweg, während die interactionManager/GestureRecognizer-API speziell für Windows Mixed Reality den vollständigen Satz räumlicher Eingabedaten verfügbar macht.

Unity XR-Eingabe-APIs

Für neue Projekte wird empfohlen, die neuen XR-Eingabe-APIs von Anfang an zu verwenden.

Weitere Informationen zu den XR-APIs finden Sie hier.

Unity-Schaltflächen-/Achsenzuordnungstabelle

Der Eingabe-Manager von Unity für Windows Mixed Reality-Motion-Controller unterstützt die unten aufgeführten Schaltflächen- und Achsen-IDs über die Input.GetButton/GetAxis-APIs. Die Spalte "Windows MR-specific" bezieht sich auf Eigenschaften, die außerhalb des InteractionSourceState-Typs verfügbar sind. Jede dieser APIs wird in den folgenden Abschnitten ausführlich beschrieben.

Die Schaltflächen-/Achsen-ID-Zuordnungen für Windows Mixed Reality in der Regel mit den Oculus-Schaltflächen-/Achsen-IDs übereinstimmen.

Die Schaltflächen-/Achsen-ID-Zuordnungen für Windows Mixed Reality unterscheiden sich auf zwei Arten von den Zuordnungen von OpenVR:

- Bei der Zuordnung werden Touchpad-IDs verwendet, die sich von Einem-Fingerstick unterscheiden, um Controller mit Fingersticks und Touchpads zu unterstützen.

- Die Zuordnung vermeidet das Überladen der A- und X-Schaltflächen-IDs für die Menüschaltflächen, damit sie für die physischen ABXY-Schaltflächen verfügbar bleiben.

| Input |

Allgemeine Unity-APIs (Input.GetButton/GetAxis) |

Windows MR-spezifische Eingabe-API (XR. WSA. Eingabe) |

|

|---|---|---|---|

| Linken | Rechte Hand | ||

| Select trigger pressed (Trigger gedrückt auswählen) | Achse 9 = 1,0 | Achse 10 = 1,0 | SelectPressed |

| Auswählen des analogen Triggerwerts | Achse 9 | Achse 10 | selectPressedAmount |

| Select trigger partially pressed (Trigger teilweise gedrückt auswählen) | Schaltfläche 14 (Gamepadkompat) | Schaltfläche 15 (Gamepadkompat) | selectPressedAmount > 0.0 |

| Gedrückte Menüschaltfläche | Schaltfläche 6* | Schaltfläche 7* | menuPressed |

| Gedrückter Ziehpunkt | Achse 11 = 1,0 (keine analogen Werte) Schaltfläche 4 (Gamepadkompat) | Achse 12 = 1,0 (keine analogen Werte) Schaltfläche 5 (Gamepad compat) | Begriffen |

| Thumbstick X (links: -1.0, rechts: 1.0) | Achse 1 | Achse 4 | thumbstickPosition.x |

| Thumbstick Y (oben: -1,0, unten: 1,0) | Achse 2 | Achse 5 | thumbstickPosition.y |

| Gedrückter Fingerabdruckstick | Schaltfläche 8 | Schaltfläche 9 | thumbstickPressed |

| Touchpad X (links: -1.0, rechts: 1.0) | Achse 17* | Achse 19* | touchpadPosition.x |

| Touchpad Y (oben: -1,0, unten: 1,0) | Achse 18* | Achse 20* | touchpadPosition.y |

| Touchpad berührt | Schaltfläche 18* | Schaltfläche 19* | touchpadTouched |

| Touchpad gedrückt | Schaltfläche 16* | Schaltfläche 17* | touchpadPressed |

| 6DoF-Griffpose oder Zeigerhaltung |

Nur Griffposition : XR. InputTracking.GetLocalPosition XR. InputTracking.GetLocalRotation | Übergeben Sie Grip oder Zeiger als Argument: sourceState.sourcePose.TryGetPosition sourceState.sourcePose.TryGetRotation |

|

| Nachverfolgungsstatus | Positionsgenauigkeit und Quellverlustrisiko nur über MR-spezifische API verfügbar |

sourceState.sourcePose.positionAccuracy sourceState.properties.sourceLossRisk |

|

Hinweis

Diese Schaltflächen-/Achsen-IDs unterscheiden sich von den IDs, die Unity für OpenVR verwendet, aufgrund von Kollisionen in den Zuordnungen, die von Gamepads, Oculus Touch und OpenVR verwendet werden.

OpenXR

Um die Grundlagen zu Mixed Reality-Interaktionen in Unity zu erfahren, besuchen Sie das Unity-Handbuch für Die XR-Eingabe von Unity. Diese Unity-Dokumentation behandelt die Zuordnungen von controllerspezifischen Eingaben zu generalisierbaren InputFeatureUsages, wie verfügbare XR-Eingaben identifiziert und kategorisiert werden können, wie Daten aus diesen Eingaben gelesen werden und vieles mehr.

Das Mixed Reality OpenXR-Plug-In stellt zusätzliche Eingabeinteraktionsprofile bereit, die den Standardmäßigen InputFeatureUsageszugeordnet sind, wie unten beschrieben:

| InputFeatureUsage | HP Reverb G2 Controller (OpenXR) | HoloLens Hand (OpenXR) |

|---|---|---|

| primary2DAxis | Joystick | |

| primary2DAxisClick | Joystick - Klicken | |

| Trigger | Auslöser | |

| Griff | Griff | Luft tippen oder drücken |

| primaryButton | [X/A] – Drücken | Tippen auf die Luft |

| secondaryButton | [Y/B] - Drücken | |

| gripButton | Griff – Drücken | |

| triggerButton | Trigger – Drücken | |

| menuButton | Menü |

Grip pose vs. pointing pose

Windows Mixed Reality unterstützt Motion-Controller in verschiedenen Formfaktoren. Das Design jedes Controllers unterscheidet sich in seiner Beziehung zwischen der Handposition des Benutzers und der natürlichen Vorwärtsrichtung, die Apps zum Zeigen beim Rendern des Controllers verwenden sollten.

Um diese Controller besser darzustellen, gibt es zwei Arten von Posen, die Sie für jede Interaktionsquelle untersuchen können: die Griffhaltung und die Zeigerhaltung. Sowohl die Koordinaten der Ziehposition als auch der Zeigerposition werden von allen Unity-APIs in globalen Unity-Weltkoordinaten ausgedrückt.

Griffhaltung

Die Griffposition stellt die Position der Handfläche des Benutzers dar, die entweder von einer HoloLens erkannt wird oder einen Bewegungscontroller hält.

Bei immersiven Headsets wird die Griffposition am besten verwendet, um die Hand des Benutzers oder ein Objekt in der Hand des Benutzers zu rendern. Die Ziehposition wird auch bei der Visualisierung eines Bewegungscontrollers verwendet. Das renderbare Modell , das von Windows für einen Bewegungscontroller bereitgestellt wird, verwendet die Ziehposition als Ursprung und Drehmittelpunkt.

Die Greifhaltung ist wie folgt definiert:

- Die Griffposition: Der Handflächenschwerpunkt beim natürlichen Halten des Controllers, nach links oder rechts eingestellt, um die Position innerhalb des Griffs zu zentrieren. Auf dem Windows Mixed Reality Motion Controller wird diese Position in der Regel an der Taste "Greif" ausgerichtet.

- Die rechte Achse der Griffausrichtung: Wenn Sie Ihre Hand vollständig öffnen, um eine flache 5-Finger-Pose zu bilden, ist der Strahl, der für Ihre Handfläche normal ist (vorwärts von der linken Handfläche, rückwärts von der rechten Handfläche)

- Die Vorwärtsachse der Griffausrichtung: Wenn Sie Ihre Hand teilweise schließen (als ob Sie den Controller halten), wird der Strahl, der "vorwärts" durch die Röhre zeigt, die von Ihren Fingern ohne Daumen gebildet wird.

- Die Nach-oben-Achse der Griffausrichtung: Die Nach-oben-Achse, die von den Definitionen Rechts und Vorwärts impliziert wird.

Sie können über die anbieterübergreifende Eingabe-API (XR) von Unity auf die Griffposition zugreifen. InputTracking. GetLocalPosition/Rotation) oder über die Windows MR-spezifische API (sourceState.sourcePose.TryGetPosition/Rotation, Anfordern von Posendaten für den Grip-Knoten ).

Zeigerposition

Die Zeigerposition stellt die Spitze des Controllers dar, der nach vorne zeigt.

Die vom System bereitgestellte Zeigerposition wird am besten zum Raycast verwendet, wenn Sie das Controllermodell selbst rendern. Wenn Sie ein anderes virtuelles Objekt anstelle des Controllers rendern, z. B. eine virtuelle Waffe, sollten Sie mit einem Strahl zeigen, der für dieses virtuelle Objekt am natürlichsten ist, z. B. ein Strahl, der sich entlang des Laufs des app-definierten Waffenmodells bewegt. Da Benutzer das virtuelle Objekt und nicht den physischen Controller sehen können, ist das Verweisen auf das virtuelle Objekt für Benutzer, die Ihre App verwenden, natürlicher.

Derzeit ist die Zeigerposition in Unity nur über die Windows MR-spezifische API sourceState.sourcePose.TryGetPosition/Rotation verfügbar, die InteractionSourceNode.Pointer als Argument übergibt.

OpenXR

Sie haben Zugriff auf zwei Sätze von Posen über OpenXR-Eingabeinteraktionen:

- Die Griffhaltungen zum Rendern von Objekten in der Hand

- Das Ziel ist, in die Welt zu zeigen.

Weitere Informationen zu diesem Design und den Unterschieden zwischen den beiden Posen finden Sie in der OpenXR-Spezifikation – Eingabeunterpfade.

Posen, die von InputFeatureUsages DevicePosition, DeviceRotation, DeviceVelocity und DeviceAngularVelocity bereitgestellt werden, stellen alle die OpenXR-Griffposition dar. InputFeatureUsages im Zusammenhang mit Griffhaltungen werden in Den CommonUsages von Unity definiert.

Die von InputFeatureUsages bereitgestellten Posen PointerPosition, PointerRotation, PointerVelocity und PointerAngularVelocity stellen alle die OpenXR-Zielposition dar. Diese InputFeatureUsages sind in keinen enthaltenen C#-Dateien definiert, daher müssen Sie Ihre eigenen InputFeatureUsages wie folgt definieren:

public static readonly InputFeatureUsage<Vector3> PointerPosition = new InputFeatureUsage<Vector3>("PointerPosition");

Haptik

Informationen zur Verwendung von Haptik im XR-Eingabesystem von Unity finden Sie im Unity-Handbuch für Unity XR Input – Haptics.

Controllernachverfolgungsstatus

Wie die Headsets erfordert auch der Windows Mixed Reality Motion Controller keine Einrichtung externer Tracking-Sensoren. Stattdessen verfolgen Sensoren die Controller im Headset selbst nach.

Wenn der Benutzer die Controller aus dem Sichtfeld des Headsets verschiebt, leitet Windows in den meisten Fällen weiterhin Controllerpositionen ab. Wenn der Controller die visuelle Nachverfolgung lange genug verliert, fallen die Positionen des Controllers auf ungefähre Genauigkeitspositionen ab.

An diesem Punkt sperrt das System den Controller für den Benutzer und verfolgt die Position des Benutzers, während er sich bewegt, während die tatsächliche Ausrichtung des Controllers weiterhin mithilfe der internen Ausrichtungssensoren verfügbar ist. Viele Apps, die Controller verwenden, um auf Benutzeroberflächenelemente zu zeigen und diese zu aktivieren, können normal und mit ungefährer Genauigkeit funktionieren, ohne dass der Benutzer es davon bemerkt.

Explizite Überlegungen zum Nachverfolgungsstatus

Apps, die Positionen basierend auf dem Nachverfolgungsstatus unterschiedlich behandeln möchten, können weiter gehen und Eigenschaften für den Zustand des Controllers überprüfen, z. B. SourceLossRisk und PositionAccuracy:

| Nachverfolgungsstatus | SourceLossRisk | PositionAccuracy | TryGetPosition |

|---|---|---|---|

| Hohe Genauigkeit | < 1.0 | Hoch | true |

| Hohe Genauigkeit (bei Verlustgefahr) | == 1,0 | Hoch | true |

| Ungefähre Genauigkeit | == 1,0 | Ungefähre | true |

| Keine Position | == 1,0 | Ungefähre | false |

Diese Bewegungscontroller-Nachverfolgungszustände sind wie folgt definiert:

- Hohe Genauigkeit: Während sich der Motion-Controller innerhalb des Sichtfelds des Headsets befindet, bietet er in der Regel positionen mit hoher Genauigkeit, basierend auf der visuellen Nachverfolgung. Ein sich bewegender Controller, der das Sichtfeld vorübergehend verlässt oder vorübergehend von den Headset-Sensoren verdeckt wird (z. B. durch die andere Hand des Benutzers), gibt weiterhin für kurze Zeit hochgenaue Posen zurück, basierend auf der Trägheitsnachverfolgung des Controllers selbst.

- Hohe Genauigkeit (mit Verlustgefahr): Wenn der Benutzer den Motion Controller über den Rand des Sichtfelds des Headsets verschiebt, kann das Headset die Position des Controllers nicht visuell nachverfolgen. Die App weiß, wann der Controller diese FOV-Grenze erreicht, indem sie sieht, dass SourceLossRisk 1.0 erreicht. An diesem Punkt kann die App Controllergesten anhalten, die einen stetigen Stream von qualitativ hochwertigen Posen erfordern.

- Ungefähre Genauigkeit: Wenn der Controller die visuelle Nachverfolgung lange genug verliert, fallen die Positionen des Controllers auf ungefähre Genauigkeitspositionen ab. An diesem Punkt sperrt das System den Controller für den Benutzer und verfolgt die Position des Benutzers, während er sich bewegt, während die tatsächliche Ausrichtung des Controllers weiterhin mithilfe der internen Ausrichtungssensoren verfügbar ist. Viele Apps, die Controller verwenden, um auf UI-Elemente zu zeigen und diese zu aktivieren, können normal und in ungefährer Genauigkeit funktionieren, ohne dass der Benutzer es aufmerkt. Apps mit höheren Eingabeanforderungen können diesen Rückgang von "Hohe Genauigkeit" auf "Ungefähre Genauigkeit" erkennen, indem sie die PositionAccuracy-Eigenschaft untersuchen, z. B. um dem Benutzer während dieser Zeit eine großzügigere Hitbox für Ziele außerhalb des Bildschirms zu bieten.

- Keine Position: Während der Controller für eine lange Zeit mit ungefährer Genauigkeit arbeiten kann, weiß das System manchmal, dass selbst eine körpergebundene Position im Moment nicht sinnvoll ist. Beispielsweise kann ein aktivierter Controller noch nie visuell beobachtet worden sein, oder ein Benutzer legt einen Controller ab, der dann von einer anderen Person aufgenommen wird. Zu diesen Zeiten stellt das System keine Position für die App bereit, und TryGetPosition gibt false zurück.

Allgemeine Unity-APIs (Input.GetButton/GetAxis)

Namespace:UnityEngine, UnityEngine.XR

Typen: Eingabe, XR. InputTracking

Unity verwendet derzeit seine allgemeinen Input.GetButton/Input.GetAxis-APIs, um Eingaben für das Oculus SDK, das OpenVR SDK und Windows Mixed Reality verfügbar zu machen, einschließlich Händen und Bewegungscontrollern. Wenn Ihre App diese APIs für die Eingabe verwendet, kann sie problemlos Motion-Controller für mehrere XR-SDKs unterstützen, einschließlich Windows Mixed Reality.

Abrufen des gedrückten Zustands einer logischen Schaltfläche

Um die allgemeinen Unity-Eingabe-APIs zu verwenden, beginnen Sie in der Regel damit, Schaltflächen und Achsen mit logischen Namen im Unity-Eingabe-Manager zu verkabeln und so eine Schaltfläche oder Achsen-IDs an jeden Namen zu binden. Anschließend können Sie Code schreiben, der auf den Namen der logischen Schaltfläche/Achse verweist.

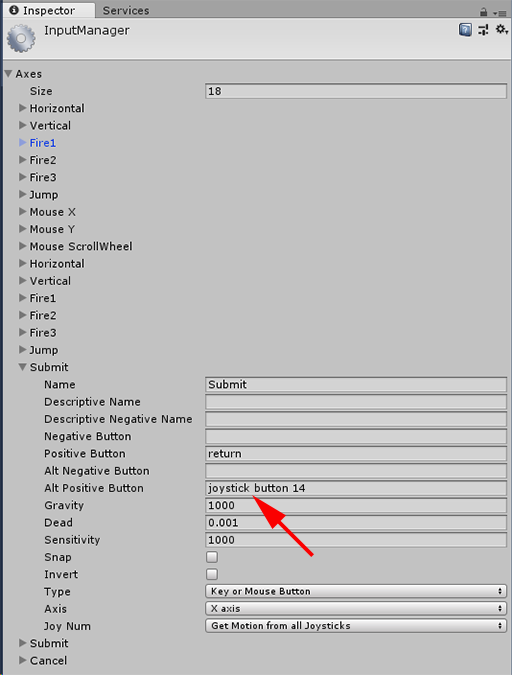

Wenn Sie beispielsweise die Triggerschaltfläche des linken Bewegungscontrollers der Aktion Senden zuordnen möchten, wechseln Sie in Unity zu Projekteinstellungen > bearbeiten>, und erweitern Sie die Eigenschaften des Abschnitts Absenden unter Achsen. Ändern Sie die Eigenschaft Positive Taste oder Alt Positive Taste wie folgt, um die Joysticktaste 14 zu lesen:

Unity InputManager

Ihr Skript kann dann mithilfe von Input.GetButton nach der Aktion Senden suchen:

if (Input.GetButton("Submit"))

{

// ...

}

Sie können weitere logische Schaltflächen hinzufügen, indem Sie die Size-Eigenschaft unter Achsen ändern.

Direktes Abrufen des gedrückten Zustands einer physischen Schaltfläche

Sie können mithilfe von Input.GetKey auch manuell über ihren vollqualifizierten Namen auf Schaltflächen zugreifen:

if (Input.GetKey("joystick button 8"))

{

// ...

}

Abrufen der Pose eines Hand- oder Bewegungscontrollers

Sie können mithilfe von XR auf die Position und Drehung des Controllers zugreifen . InputTracking:

Vector3 leftPosition = InputTracking.GetLocalPosition(XRNode.LeftHand);

Quaternion leftRotation = InputTracking.GetLocalRotation(XRNode.LeftHand);

Hinweis

Der obige Code stellt die Griffposition des Controllers dar (in der der Benutzer den Controller hält), was nützlich ist, um ein Schwert oder eine Waffe in der Hand des Benutzers oder ein Modell des Controllers selbst zu rendern.

Die Beziehung zwischen dieser Ziehposition und der Zeigerposition (an der die Spitze des Controllers zeigt) kann sich zwischen Controllern unterscheiden. Derzeit ist der Zugriff auf die Zeigerposition des Controllers nur über die MR-spezifische Eingabe-API möglich, die in den folgenden Abschnitten beschrieben wird.

Windows-spezifische APIs (XR. WSA. Eingabe)

Achtung

Wenn Ihr Projekt eine der XR-Dateien verwendet. WSA-APIs: Diese werden in zukünftigen Unity-Versionen zugunsten des XR SDK eingestellt. Für neue Projekte wird empfohlen, das XR SDK von Anfang an zu verwenden. Weitere Informationen zum XR-Eingabesystem und zu den APIs finden Sie hier.

Namespace:UnityEngine.XR.WSA.Input

Typen: InteractionManager, InteractionSourceState, InteractionSource, InteractionSourceProperties, InteractionSourceKind, InteractionSourceLocation

Um ausführlichere Informationen zu Windows Mixed Reality Handeingabe (für HoloLens) und Motion-Controllern zu erhalten, können Sie die Windows-spezifischen APIs für räumliche Eingaben unter dem UnityEngine.XR.WSA.Input-Namespace verwenden. Damit können Sie auf zusätzliche Informationen zugreifen, z. B. positionsgenau oder die Art der Quelle, sodass Sie Hände und Controller voneinander trennen können.

Abrufen des Zustands von Händen und Motion-Controllern

Sie können den Status dieses Frames für jede Interaktionsquelle (Hand- oder Bewegungscontroller) mithilfe der GetCurrentReading-Methode abfragen.

var interactionSourceStates = InteractionManager.GetCurrentReading();

foreach (var interactionSourceState in interactionSourceStates) {

// ...

}

Jeder InteractionSourceState , den Sie erhalten, stellt eine Interaktionsquelle zum aktuellen Zeitpunkt dar. InteractionSourceState macht Informationen verfügbar, z. B.:

Welche Arten von Druckvorgängen auftreten (Auswahl/Menü/Greifen/Touchpad/Thumbstick)

if (interactionSourceState.selectPressed) { // ... }Andere spezifische Daten für Bewegungscontroller, z. B. die XY-Koordinaten des Touchpads und/oder des Fingerabdrucksticks und der Touchzustand

if (interactionSourceState.touchpadTouched && interactionSourceState.touchpadPosition.x > 0.5) { // ... }InteractionSourceKind, um zu wissen, ob es sich bei der Quelle um einen Hand- oder Bewegungscontroller handelt

if (interactionSourceState.source.kind == InteractionSourceKind.Hand) { // ... }

Abfragen von vorwärts prognostizierten Renderingposen

Beim Abfragen von Interaktionsquellendaten von Händen und Controllern sind die Posen, die Sie erhalten, vorwärts vorhergesagte Posen für den Zeitpunkt, zu dem die Photonen dieses Frames die Augen des Benutzers erreichen. Vorausgesagte Posen werden am besten zum Rendern des Controllers oder eines gehaltenen Objekts für jeden Frame verwendet. Wenn Sie eine bestimmte Pressemitteilung mit dem Controller als Ziel verwenden, ist dies am genauesten, wenn Sie die folgenden APIs für verlaufsbezogene Ereignisse verwenden.

var sourcePose = interactionSourceState.sourcePose; Vector3 sourceGripPosition; Quaternion sourceGripRotation; if ((sourcePose.TryGetPosition(out sourceGripPosition, InteractionSourceNode.Grip)) && (sourcePose.TryGetRotation(out sourceGripRotation, InteractionSourceNode.Grip))) { // ... }Sie können auch die vorausgesagte Kopfposition für diesen aktuellen Frame abrufen. Wie bei der Quellposition ist es nützlich, einen Cursor zu rendern , obwohl die Ausrichtung auf eine bestimmte Presse oder Eine bestimmte Veröffentlichung am genauesten ist, wenn Sie die folgenden APIs für verlaufsbezogene Ereignisse verwenden.

var headPose = interactionSourceState.headPose; var headRay = new Ray(headPose.position, headPose.forward); RaycastHit raycastHit; if (Physics.Raycast(headPose.position, headPose.forward, out raycastHit, 10)) { var cursorPos = raycastHit.point; // ... }

Behandeln von Interaktionsquellenereignissen

Um Eingabeereignisse so zu behandeln, wie sie mit ihren genauen Verlaufsdaten auftreten, können Sie Interaktionsquellenereignisse behandeln, anstatt abfragen zu müssen.

So behandeln Sie Ereignisse der Interaktionsquelle:

Registrieren Sie sich für ein InteractionManager-Eingabeereignis . Für jeden Typ von Interaktionsereignis, an dem Sie interessiert sind, müssen Sie es abonnieren.

InteractionManager.InteractionSourcePressed += InteractionManager_InteractionSourcePressed;Behandeln Sie das -Ereignis. Nachdem Sie ein Interaktionsereignis abonniert haben, erhalten Sie ggf. den Rückruf. Im SourcePressed-Beispiel erfolgt dies, nachdem die Quelle erkannt wurde und bevor sie freigegeben oder verloren geht.

void InteractionManager_InteractionSourceDetected(InteractionSourceDetectedEventArgs args) var interactionSourceState = args.state; // args.state has information about: // targeting head ray at the time when the event was triggered // whether the source is pressed or not // properties like position, velocity, source loss risk // source id (which hand id for example) and source kind like hand, voice, controller or other }

So beenden Sie die Behandlung eines Ereignisses

Sie müssen die Behandlung eines Ereignisses beenden, wenn Sie nicht mehr an dem Ereignis interessiert sind oder das Objekt zerstören, das das Ereignis abonniert hat. Um die Behandlung des Ereignisses zu beenden, kündigen Sie das Ereignis ab.

InteractionManager.InteractionSourcePressed -= InteractionManager_InteractionSourcePressed;

Liste der Interaktionsquellenereignisse

Die verfügbaren Ereignisse der Interaktionsquelle sind:

- InteractionSourceDetected (Quelle wird aktiv)

- InteractionSourceLost (wird inaktiv)

- InteractionSourcePressed (Tippen, Drücken der Schaltfläche oder "Auswählen" ausgesprochen)

- InteractionSourceReleased (Ende eines Tippens, losgelassene Schaltfläche oder Ende der Äußerung "Auswählen")

- InteractionSourceUpdated (verschiebt oder ändert einen Zustand auf andere Weise)

Ereignisse für historische Targeting-Posen, die am genauesten zu einer Pressemitteilung oder Veröffentlichung passen

Die weiter oben beschriebenen Abruf-APIs geben Ihrer App vorausgesagte Posen. Während diese vorhergesagten Posen am besten zum Rendern des Controllers oder eines virtuellen Handheldobjekts geeignet sind, sind zukünftige Posen nicht optimal für die Ausrichtung, aus zwei wichtigen Gründen:

- Wenn der Benutzer eine Taste an einem Controller drückt, kann es etwa 20 ms drahtlose Latenz über Bluetooth geben, bevor das System den Druck empfängt.

- Wenn Sie dann eine vorausgesagte Pose verwenden, werden weitere 10-20 ms Vorwärtsvorhersage angewendet, um die Zeit festzulegen, zu der die Photonen des aktuellen Frames die Augen des Benutzers erreichen.

Dies bedeutet, dass Sie beim Abfragen eine Quellposition oder Kopfhaltung erhalten, die 30-40 ms vorn liegt, von der der Kopf und die Hände des Benutzers tatsächlich zurück waren, als die Presse oder Freigabe erfolgte. Bei HoloLens-Handeingaben kommt es zwar zu keiner Drahtlosen Übertragungsverzögerung, aber es gibt eine ähnliche Verarbeitungsverzögerung, um den Druck zu erkennen.

Um eine präzise Zielvorgabe basierend auf der ursprünglichen Absicht des Benutzers für eine Hand- oder Controllerpresse zu verwenden, sollten Sie die historische Quellposition oder Kopfposition aus diesem InteractionSourcePressed - oder InteractionSourceReleased-Eingabeereignis verwenden.

Sie können eine Pressemitteilung oder ein Release mit historischen Posendaten vom Kopf des Benutzers oder dessen Controller als Ziel verwenden:

Die Kopfhaltung zu dem Zeitpunkt, zu dem eine Geste oder ein Drücken des Controllers aufgetreten ist, die für die Ausrichtung verwendet werden kann, um zu bestimmen, was der Benutzer betrachtet hat:

void InteractionManager_InteractionSourcePressed(InteractionSourcePressedEventArgs args) { var interactionSourceState = args.state; var headPose = interactionSourceState.headPose; RaycastHit raycastHit; if (Physics.Raycast(headPose.position, headPose.forward, out raycastHit, 10)) { var targetObject = raycastHit.collider.gameObject; // ... } }Die Quellposition zu dem Zeitpunkt, zu dem ein Bewegungscontroller gedrückt wurde, der für die Ausrichtung verwendet werden kann, um zu bestimmen, worauf der Benutzer mit dem Controller zeigt. Es ist der Zustand des Controllers, der die Presse erlebt hat. Wenn Sie den Controller selbst rendern, können Sie die Zeigerhaltung anstelle der Griffposition anfordern, um den Zielstrahl von dem zu schießen, was der Benutzer als natürliche Spitze des gerenderten Controllers betrachtet:

void InteractionManager_InteractionSourcePressed(InteractionSourcePressedEventArgs args) { var interactionSourceState = args.state; var sourcePose = interactionSourceState.sourcePose; Vector3 sourceGripPosition; Quaternion sourceGripRotation; if ((sourcePose.TryGetPosition(out sourceGripPosition, InteractionSourceNode.Pointer)) && (sourcePose.TryGetRotation(out sourceGripRotation, InteractionSourceNode.Pointer))) { RaycastHit raycastHit; if (Physics.Raycast(sourceGripPosition, sourceGripRotation * Vector3.forward, out raycastHit, 10)) { var targetObject = raycastHit.collider.gameObject; // ... } } }

Beispiel für Ereignishandler

using UnityEngine.XR.WSA.Input;

void Start()

{

InteractionManager.InteractionSourceDetected += InteractionManager_InteractionSourceDetected;

InteractionManager.InteractionSourceLost += InteractionManager_InteractionSourceLost;

InteractionManager.InteractionSourcePressed += InteractionManager_InteractionSourcePressed;

InteractionManager.InteractionSourceReleased += InteractionManager_InteractionSourceReleased;

InteractionManager.InteractionSourceUpdated += InteractionManager_InteractionSourceUpdated;

}

void OnDestroy()

{

InteractionManager.InteractionSourceDetected -= InteractionManager_InteractionSourceDetected;

InteractionManager.InteractionSourceLost -= InteractionManager_InteractionSourceLost;

InteractionManager.InteractionSourcePressed -= InteractionManager_InteractionSourcePressed;

InteractionManager.InteractionSourceReleased -= InteractionManager_InteractionSourceReleased;

InteractionManager.InteractionSourceUpdated -= InteractionManager_InteractionSourceUpdated;

}

void InteractionManager_InteractionSourceDetected(InteractionSourceDetectedEventArgs args)

{

// Source was detected

// args.state has the current state of the source including id, position, kind, etc.

}

void InteractionManager_InteractionSourceLost(InteractionSourceLostEventArgs state)

{

// Source was lost. This will be after a SourceDetected event and no other events for this

// source id will occur until it is Detected again

// args.state has the current state of the source including id, position, kind, etc.

}

void InteractionManager_InteractionSourcePressed(InteractionSourcePressedEventArgs state)

{

// Source was pressed. This will be after the source was detected and before it is

// released or lost

// args.state has the current state of the source including id, position, kind, etc.

}

void InteractionManager_InteractionSourceReleased(InteractionSourceReleasedEventArgs state)

{

// Source was released. The source would have been detected and pressed before this point.

// This event will not fire if the source is lost

// args.state has the current state of the source including id, position, kind, etc.

}

void InteractionManager_InteractionSourceUpdated(InteractionSourceUpdatedEventArgs state)

{

// Source was updated. The source would have been detected before this point

// args.state has the current state of the source including id, position, kind, etc.

}

Motion Controller im MRTK

Sie können über den Eingabe-Manager auf den Gesten- und Bewegungscontroller zugreifen.

Folgen Sie den Tutorials

Schritt-für-Schritt-Tutorials mit ausführlicheren Anpassungsbeispielen finden Sie in der Mixed Reality Academy:

MR Input 213 - Motion Controller

Nächster Entwicklungsprüfpunkt

Wenn Sie die von uns beschriebene Unity-Entwicklungsreise verfolgen, befinden Sie sich mitten in der Erkundung der MRTK-Kernbausteine. Von hier aus können Sie mit dem nächsten Baustein fortfahren:

Oder wechseln Sie zu Mixed Reality Plattformfunktionen und APIs:

Sie können jederzeit zu den Unity-Entwicklungsprüfpunkten zurückkehren.