Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Ces didacticiels présentent un scénario complet de bout en bout dans l’expérience de science des données Fabric. Ils couvrent chaque étape, de

- Ingestion des données

- Nettoyage de données

- Préparation des données

à

- Apprentissage du modèle Machine Learning

- La génération d’insights

puis couvrent la consommation de ces insights avec des outils de visualisation, par exemple Power BI.

Les personnes nouvelles de Microsoft Fabric doivent visiter Qu’est-ce que Microsoft Fabric ?.

Présentation

Un cycle de vie de projet de science des données inclut généralement les étapes suivantes :

- Comprendre les règles d’entreprise

- Acquérir les données

- Explorer, nettoyer, préparer et visualiser les données

- Entraîner le modèle et suivre l’expérience

- Évaluer le modèle et générer des aperçus

Les étapes sont souvent itératives. Les objectifs et les critères de réussite de chaque étape dépendent de la collaboration, du partage de données et de la documentation. L’expérience de science des données Fabric implique plusieurs fonctionnalités intégrées natives qui permettent une collaboration transparente, l’acquisition de données, le partage et la consommation.

Ces didacticiels vous placent dans le rôle d’un scientifique des données qui doit explorer, nettoyer et transformer un jeu de données qui contient l’état d’activité de 10 000 clients bancaires. Vous créez ensuite un modèle Machine Learning pour prédire quels clients bancaires quitteront probablement.

Vous effectuez les activités suivantes dans les didacticiels :

- Utiliser les notebooks Fabric pour les scénarios de science des données

- Utiliser Apache Spark pour ingérer des données dans un lac Fabric

- Charger les données existantes à partir de tables delta lakehouse

- Utiliser les outils Basés sur Apache Spark et Python pour nettoyer et transformer des données

- Créer des expériences et des exécutions pour entraîner différents modèles Machine Learning

- Utiliser MLflow et l’interface utilisateur Fabric pour inscrire et suivre les modèles entraînés

- Exécuter la notation à grande échelle et enregistrer les prédictions et les résultats d’inférence dans un lakehouse

- Utiliser DirectLake pour visualiser les prédictions dans Power BI

Architecture

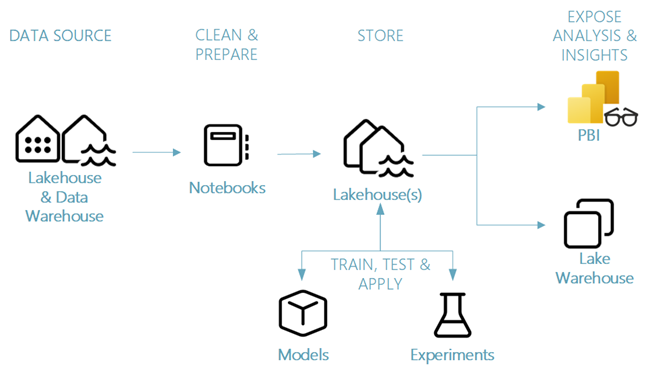

Cette série de tutoriels présente un scénario simplifié de science des données de bout en bout impliquant :

- Ingestion de données à partir d’une source de données externe.

- Exploration et nettoyage des données.

- Apprentissage et inscription du modèle Machine Learning.

- Scoring par lots et enregistrement de prédiction.

- Visualisation des résultats de prédiction dans Power BI.

Différents composants du scénario de science des données

Sources de données : pour ingérer des données avec Fabric, vous pouvez facilement et rapidement vous connecter à Azure Data Services, à d’autres plateformes cloud et aux ressources de données locales. Avec les notebooks Fabric, vous pouvez ingérer des données à partir de ces ressources :

- Lakehouses intégrés

- Entrepôts de données

- Modèles sémantiques

- Différentes sources de données Apache Spark

- Différentes sources de données qui prennent en charge Python

Cette série de tutoriels porte sur l’ingestion et le chargement de données à partir d’un lakehouse.

Explorer, nettoyer et préparer - L’expérience de science des données Fabric prend en charge le nettoyage, la transformation, l’exploration et la caractérisation des données. Il utilise des expériences Spark intégrées et des outils Basés sur Python, par exemple, Data Wrangler et SemPy Library. Ce tutoriel présente l’exploration des données avec la bibliothèque Python, ainsi que le seaborn nettoyage et la préparation des données avec Apache Spark.

Modèles et expériences : avec Fabric, vous pouvez entraîner, évaluer et noter des modèles Machine Learning avec des expériences intégrées. Pour inscrire et déployer vos modèles et suivre les expériences, MLflow offre une intégration transparente avec Fabric comme moyen de modéliser des éléments. Pour créer et partager des insights métier, Fabric offre d’autres fonctionnalités pour la prédiction de modèle à grande échelle (PREDICT), afin de créer et de partager des insights métier.

Stockage - Fabric standardise sur Delta Lake, ce qui signifie que tous les moteurs Fabric peuvent interagir avec le même jeu de données stocké dans un lakehouse. Avec cette couche de stockage, vous pouvez stocker des données structurées et non structurées qui prennent en charge le stockage basé sur les fichiers et le format tabulaire. Vous pouvez facilement accéder aux jeux de données et aux fichiers stockés via tous les éléments d’expérience Fabric, par exemple, les notebooks et les pipelines.

Exposer des analyses et des insights - Power BI, un outil décisionnel de pointe, peut consommer des données lakehouse pour la génération de rapports et de visualisations. Dans les ressources de notebook, les bibliothèques natives de visualisation Python ou Spark

matplotlibseabornplotly- etc.

peuvent visualiser les données persistantes dans un lakehouse. La bibliothèque SemPy prend également en charge la visualisation des données. Cette bibliothèque prend en charge des visualisations riches et spécifiques à des tâches pour

- Modèle de données sémantiques

- Dépendances et leurs violations

- Cas d’usage de classification et de régression