Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Le regard et la validation sont un modèle d’entrée fondamental étroitement lié à la façon dont nous interagissons avec nos ordinateurs à l’aide de la souris : pointer & clic. Dans cette page, nous présentons deux types d’entrée du regard (tête et regard) et différents types d’actions de validation. Le regard et la validation sont considérés comme un modèle d’entrée lointain avec manipulation indirecte. Il est préférable d’interagir avec du contenu holographique qui est hors de portée.

Les casques de réalité mixte peuvent utiliser la position et l’orientation de la tête de l’utilisateur pour déterminer leur vecteur de direction de la tête. Considérez le regard comme un laser pointant directement vers l’avant directement entre les yeux de l’utilisateur. C’est une approximation assez grossière de la zone vers laquelle se porte le regard de l’utilisateur. Votre application peut croiser ce rayon avec des objets virtuels ou réels, et dessiner un curseur à cet emplacement pour indiquer à l’utilisateur ce qu’il cible.

En plus du regard de la tête, certains casques de réalité mixte, comme HoloLens 2, incluent des systèmes de suivi oculaire qui produisent un vecteur de regard. Ces dispositifs fournissent une mesure précise de la zone vers laquelle se porte le regard de l’utilisateur. Dans les deux cas, le regard représente un signal important pour l’intention de l’utilisateur. Plus le système peut interpréter et prédire les actions prévues de l’utilisateur, plus la satisfaction et les performances de l’utilisateur s’améliorent.

Voici quelques exemples de la façon dont vous, en tant que développeur de réalité mixte, pouvez tirer parti de la tête ou du regard :

- Votre application peut croiser le regard avec les hologrammes de votre scène pour déterminer où se trouve l’attention de l’utilisateur (plus précisément avec le regard).

- Votre application peut canaliser les mouvements et les pressions du contrôleur en fonction du regard de l’utilisateur, ce qui permet à l’utilisateur de sélectionner, d’activer, de saisir, de faire défiler ou d’interagir avec ses hologrammes en toute transparence.

- Votre application peut permettre à l’utilisateur de placer des hologrammes sur des surfaces réelles en croisant son rayon de regard avec le maillage de mappage spatial.

- Votre application peut savoir quand l’utilisateur ne regarde pas dans la direction d’un objet important, ce qui peut amener votre application à donner des signaux visuels et audio pour se tourner vers cet objet.

Prise en charge des appareils

| Modèle d’entrée | HoloLens (1ère génération) | HoloLens 2 | Casques immersifs |

| Suivre de la tête et valider | ✔️ Recommandé | ✔️ Recommandé (troisième choix ; voir les autres options) | ➕ Autre option |

| Suivre du regard et valider | ❌ Non disponible | ✔️ Recommandé (troisième choix ; voir les autres options) | ❌ Non disponible |

Démonstration des concepts d’élaboration du suivi de la tête et du suivi oculaire

Si vous souhaitez voir les concepts d’élaboration du suivi de la tête et du suivi oculaire en action, consultez notre démonstration vidéo Conception d’hologrammes - Suivi de la tête et suivi oculaire ci-dessous. Une fois que vous avez terminé, poursuivez pour obtenir une présentation plus détaillée relative à des rubriques spécifiques.

Cette vidéo a été extraite de l’application HoloLens 2 « Designing Holograms ». Téléchargez et profitez de l’expérience complète ici.

Pointage du regard

Le regard ou la tête ?

Il existe plusieurs considérations à prendre en compte lorsque l’on se demande si vous devez utiliser le modèle d’entrée « œil-regard et validation » ou « regard de la tête et validation ». Si vous développez pour un casque immersif ou pour HoloLens (1ère génération), le choix est simple : regarder la tête et valider. Si vous développez pour HoloLens 2, le choix devient un peu plus difficile. Il est important de comprendre les avantages et les défis qui accompagnent chacun d’entre eux. Nous avons compilé certains avantages et inconvénients généraux dans le tableau ci-dessous pour comparer le ciblage de la tête et du regard. C’est loin d’être terminé et nous vous suggérons d’en savoir plus sur le ciblage du regard dans la réalité mixte ici :

- Suivi oculaire sur HoloLens 2 : introduction générale de notre nouvelle fonctionnalité de suivi oculaire sur HoloLens 2 y compris des conseils pour les développeurs.

- Interaction du regard et du regard : considérations et recommandations relatives à la conception lors de la planification de l’utilisation du suivi oculaire comme entrée.

| Ciblage des yeux | Ciblage avec la tête |

| Rapide! | Plus lent |

| Faible effort (peu de mouvements du corps nécessaires) | Peut être fatiguant - Inconfort possible (par exemple, une fatigue du cou) |

| Ne nécessite pas de curseur, mais des commentaires subtils sont recommandés | Nécessite l’affichage d’un curseur |

| Aucun mouvement des yeux lisses , par exemple, pas bon pour dessiner | Plus contrôlé et explicite |

| Difficile pour les petites cibles (par exemple, les boutons minuscules ou les liens web) | Fiable! Super secours ! |

| ... | ... |

Que vous utilisiez le regard ou le regard pour votre modèle d’entrée de regard et de validation, chacun est fourni avec différents ensembles de contraintes de conception. Ceux-ci sont abordés séparément dans les articles de validation et de validation , ainsi que dans les articles sur la tête et la validation .

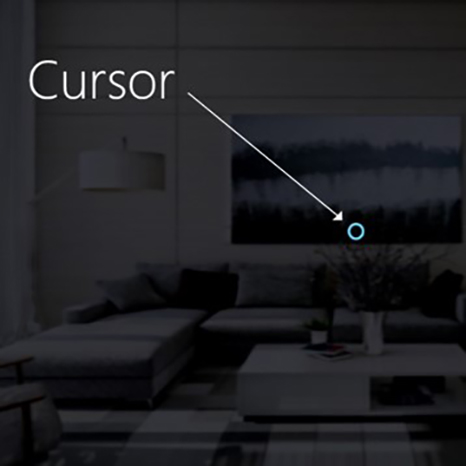

Curseur

Pour le regard de la tête, la plupart des applications doivent utiliser un curseur ou une autre indication auditive/visuelle pour donner à l’utilisateur la confiance dans ce qu’il est sur le point d’interagir.

Vous placez généralement ce curseur dans le monde où le rayon du regard de la tête croise d’abord un objet, qui peut être un hologramme ou une surface réelle.

Pour le regard, nous vous recommandons généralement de ne pas afficher de curseur, car cela peut rapidement devenir distrayant et ennuyeux pour l’utilisateur.

Au lieu de cela, mettez en surbrillance subtilement les cibles visuelles ou utilisez un curseur oculaire faible pour fournir une confiance quant à ce avec quoi l’utilisateur est sur le point d’interagir. Pour plus d’informations, veuillez case activée notre guide de conception pour obtenir des informations sur HoloLens 2 basées sur les yeux.

Image : exemple de curseur visuel pour afficher le regard

Commit

Après avoir parlé des différentes façons de regarder une cible, parlons un peu plus de la partie commit dans le regard et la validation. Après avoir ciblé un objet ou un élément d’interface utilisateur, l’utilisateur peut interagir ou cliquer dessus à l’aide d’une entrée secondaire. C’est ce que l’on appelle l’étape de validation du modèle d’entrée.

Les méthodes de validation suivantes sont prises en charge :

- Mouvement de la main du robinet aérien (c’est-à-dire, levez votre main devant vous et rassemblez votre index et votre pouce)

- Dites « sélectionner » ou l’une des commandes vocales ciblées

- Appuyez sur un bouton unique sur un clicker HoloLens

- Appuyez sur le bouton « A » d’un boîtier de commande Xbox

- Appuyez sur le bouton « A » d’une manette adaptative Xbox

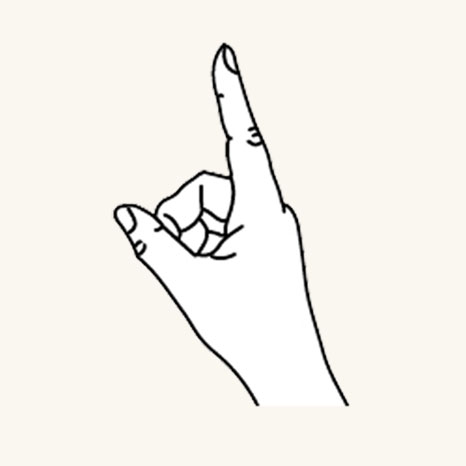

Mouvement d’appui du regard et de l’air

Le clic aérien est une action d’appui avec la main levée. Pour utiliser un robinet à air, levez votre index à la position prête, puis pincez avec votre pouce et levez votre index vers le haut pour relâcher. Sur HoloLens (1ère génération), le tap aérien est l’entrée secondaire la plus courante.

Doigt en position prête

Appuyez sur le doigt vers le bas pour appuyer ou cliquer sur

Le robinet à air est également disponible sur HoloLens 2. Il a été assoupli de la version d’origine. Presque tous les types de pincements sont maintenant pris en charge tant que la main est debout et tient immobile. Cela permet aux utilisateurs d’apprendre et d’utiliser le mouvement beaucoup plus facilement. Ce nouveau robinet d’air remplace l’ancienne via la même API, de sorte que les applications existantes auront automatiquement le nouveau comportement après recompilation pour HoloLens 2.

Commande vocale « Sélectionner » du regard et du regard

La commande vocale est l’une des principales méthodes d’interaction dans la réalité mixte. Il fournit un puissant mécanisme mains libres pour contrôler le système. Il existe différents types de modèles d’interaction vocale :

- Commande générique « Select » qui utilise une action de clic ou une validation comme entrée secondaire.

- Les commandes d’objet (par exemple, « Fermer » ou « Agrandir ») effectuent et valident une action en tant qu’entrée secondaire.

- Les commandes globales (par exemple, « Démarrer ») ne nécessitent pas de cible.

- Les interfaces utilisateur de conversation ou les entités telles que Cortana ont une fonctionnalité de langage naturel IA.

- Commandes vocales personnalisées

Pour en savoir plus sur les détails et la liste complète des commandes vocales disponibles et sur leur utilisation, case activée nos conseils en matière de commandes vocales.

Regard et HoloLens Clicker

HoloLens Clicker est le premier appareil périphérique conçu spécifiquement pour HoloLens. Il est inclus avec HoloLens (1ère génération) Development Edition. HoloLens Clicker permet à un utilisateur de cliquer avec un mouvement de main minimal et de valider en tant qu’entrée secondaire. HoloLens Clicker se connecte à HoloLens (1ère génération) ou HoloLens 2 à l’aide de Bluetooth Low Energy (BTLE).

Informations supplémentaires et instructions pour appairer l’appareil

Image : HoloLens Clicker

Regard et Manette sans fil Xbox

Le Manette sans fil Xbox effectue une action de clic en tant qu’entrée secondaire à l’aide du bouton « A ». L’appareil est mappé à un ensemble d’actions par défaut qui permettent de naviguer et de contrôler le système. Si vous souhaitez personnaliser la manette, utilisez l’application Accessoires Xbox pour configurer votre Manette sans fil Xbox.

Comment associer une manette Xbox à votre PC

Image : Manette sans fil Xbox

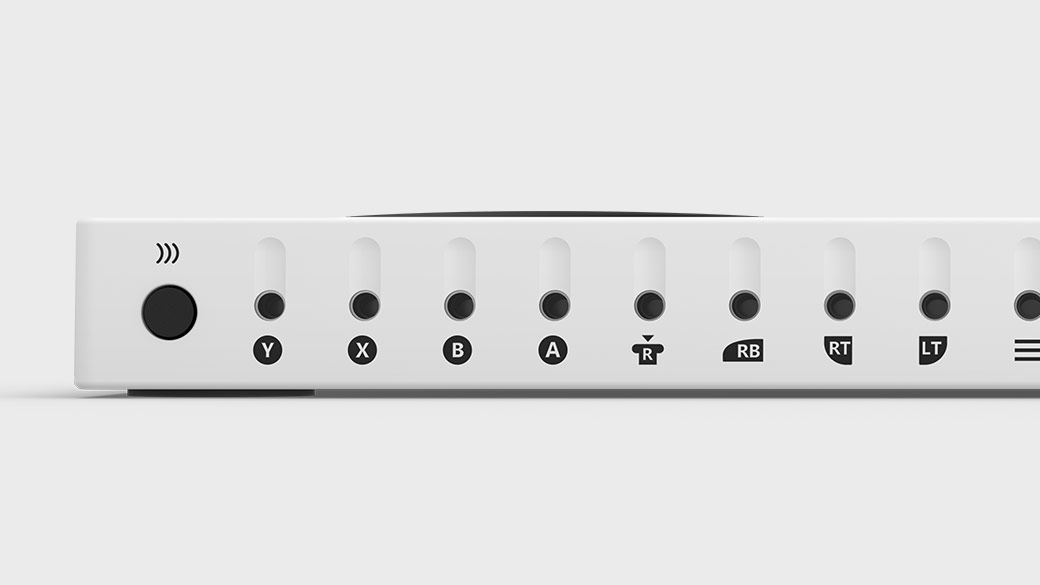

Regard et manette adaptative Xbox

Conçue principalement pour répondre aux besoins des joueurs à mobilité limitée, la manette adaptative Xbox est un hub unifié pour les appareils qui permet de rendre la réalité mixte plus accessible.

La manette adaptative Xbox effectue une action de clic en tant qu’entrée secondaire à l’aide du bouton « A ». L’appareil est mappé à un ensemble d’actions par défaut qui permettent de naviguer et de contrôler le système. Si vous souhaitez personnaliser la manette, utilisez l’application Accessoires Xbox pour configurer votre manette xbox adaptative.

Manette Xbox Adaptive Controller

Connectez des appareils externes tels que des commutateurs, des boutons, des supports et des joysticks pour créer une expérience de contrôleur personnalisée qui est la vôtre. Les entrées de bouton, de manette et de déclencheur sont contrôlées à l’aide d’appareils d’assistance connectés via des prises jack de 3,5 mm et des ports USB.

Ports de la manette Xbox Adaptive Controller

Instructions pour coupler l’appareil

Plus d’informations sur le site Xbox

Mouvements composites

Clic aérien

Le mouvement d’appui aérien (et les autres mouvements ci-dessous) réagit uniquement à un appui spécifique. Pour détecter d’autres pressions, telles que Menu ou Saisie, votre application doit utiliser directement les interactions de niveau inférieur décrites dans la section des deux mouvements de composants clés ci-dessus.

Appui de longue durée

L’appui prolongé consiste simplement à maintenir la position du doigt vers le bas pendant le clic aérien. La combinaison d’un appui et d’une suspension d’air permet diverses interactions plus complexes de « clic-glisser » lorsqu’elles sont combinées à des mouvements de bras, comme le retrait d’un objet au lieu de l’activer ou d’interactions secondaires de la souris, telles que l’affichage d’un menu contextuel. La prudence doit toutefois être utilisée lors de la conception de ce geste, car les utilisateurs peuvent être enclins à détendre leurs postures de la main pendant tout mouvement prolongé.

Manipulation

Les mouvements de manipulation peuvent être utilisés pour déplacer, redimensionner ou faire pivoter un hologramme lorsque vous souhaitez que l’hologramme réagisse 1 :1 aux mouvements de la main de l’utilisateur. La possibilité pour l’utilisateur de dessiner ou de peindre dans le monde illustre l’utilisation de ce type de mouvement. Le ciblage initial pour un mouvement de manipulation doit être effectué au moyen d’un pointage du regard ou d’un pointage. Une fois que la pression enfoncée commence, toute manipulation d’objet est gérée par les mouvements de la main, ce qui permet à l’utilisateur de regarder autour de lui pendant qu’il manipule.

Navigation

Les mouvements de navigation fonctionnent comme une manette de jeu virtuelle et peuvent être utilisés pour parcourir des widgets d’interface utilisateur, tels que des menus circulaires. Vous appuyez longuement pour démarrer le mouvement, puis déplacez votre main dans un cube 3D normalisé, centré sur l’appui initial. Vous pouvez déplacer votre main le long de l’axe X, Y ou Z d’une valeur de -1 à 1, 0 étant le point de départ. La navigation peut servir à générer des mouvements de zoom ou de défilement continus basés sur la vitesse, à l’image du défilement d’une interface utilisateur 2D que vous pouvez obtenir en cliquant sur le bouton central de la souris, puis en déplaçant le pointeur de la souris vers le haut ou le bas.

La navigation avec des rails fait référence à la capacité de reconnaître les mouvements dans certains axes jusqu’à ce qu’un certain seuil soit atteint sur cet axe. Cela n’est utile que lorsque le développeur active le déplacement dans plusieurs axes dans une application, par exemple si une application est configurée pour reconnaître les mouvements de navigation sur l’axe X et Y, mais également l’axe X spécifié avec des rails. Dans ce cas, le système reconnaît les mouvements de la main sur l’axe X tant qu’ils restent dans un rail imaginaire (repère) sur l’axe X, si le mouvement de la main se produit également sur l’axe Y.

Dans les applications 2D, l’utilisateur peut se servir de mouvements de navigation verticaux pour faire défiler l’écran, effectuer un zoom ou faire glisser un élément à l’intérieur de l’application. Des interactions tactiles virtuelles sont ainsi injectées dans l’application pour simuler des mouvements tactiles du même type. Les utilisateurs peuvent sélectionner l’une de ces actions en basculant entre les outils de la barre située au-dessus de l’application, soit en sélectionnant le bouton, soit en disant «< Outil défilement/glisser/zoom> ».

Plus d’informations sur les mouvements composites

Modules de reconnaissance des mouvements

L’un des avantages de l’utilisation de la reconnaissance de mouvements est que vous pouvez configurer un outil de reconnaissance de mouvements uniquement pour les mouvements que l’hologramme actuellement ciblé peut accepter. La plateforme ne fait que lever l’ambiguïté si nécessaire pour distinguer ces gestes pris en charge particuliers. De cette façon, un hologramme qui prend simplement en charge l’appui aérien peut accepter n’importe quelle durée entre l’appui et la mise en production, tandis qu’un hologramme qui prend en charge à la fois l’appui et la mise en attente peut promouvoir l’appui en une conservation après le seuil de temps de conservation.

Reconnaissance des mouvements de la main

HoloLens reconnaît les mouvements de la main en effectuant le suivi de la position de la main, ou des mains, que l’appareil peut voir. HoloLens voit les mains quand elles sont dans l’état « prêt » (dos de la main face à vous, index dressé) ou « enfoncé » (dos de la main face à vous, index abaissé). Lorsque les mains sont dans d’autres poses, HoloLens les ignore. Pour chaque main détectée par HoloLens, vous pouvez accéder à sa position sans orientation et son état enfoncé. Quand la main s’approche du bord du cadre de mouvement, vous disposez également d’un vecteur de direction, que vous pouvez présenter à l’utilisateur afin qu’il sache comment déplacer sa main de manière à ce que HoloLens puisse la voir.

Cadre de mouvement

Pour les mouvements sur HoloLens, la main doit se trouver dans un cadre de mouvement, dans une plage que les caméras de détection de mouvement peuvent voir de manière appropriée, du nez à la taille et entre les épaules. Les utilisateurs doivent être formés sur ce domaine de reconnaissance à la fois pour la réussite de l’action et pour leur propre confort. De nombreux utilisateurs supposent d’abord que le cadre de mouvement doit se trouver dans leur vue via HoloLens, et se tenir les bras mal à l’aise pour interagir. Lorsque vous utilisez holoLens Clicker, il n’est pas nécessaire que les mains se trouvent dans le cadre de mouvement.

Pour les mouvements continus en particulier, il existe un risque que les utilisateurs déplacent leurs mains en dehors du cadre de mouvement en milieu de mouvement lors du déplacement d’un objet holographique, par exemple, et perdent le résultat prévu.

Voici trois choses que vous devez envisager :

Formation de l’utilisateur sur l’existence du cadre de mouvement et les limites approximatives. Cela est enseigné lors de la configuration d’HoloLens.

Informer les utilisateurs lorsque leurs mouvements approchent ou dépassent les limites du cadre de mouvement au sein d’une application dans la mesure où un mouvement perdu conduit à des résultats indésirables. La recherche a montré les principales qualités d’un tel système de notification. L’interpréteur de commandes HoloLens fournit un bon exemple de ce type de notification : visuel, sur le curseur central, indiquant la direction dans laquelle le passage de limites a lieu.

Réduire au minimum les conséquences d’un franchissement des limites du cadre de mouvement. En général, cela signifie que le résultat d’un mouvement doit être arrêté à la limite et non inversé. Par exemple, si un utilisateur déplace un objet holographique dans une pièce, le mouvement doit s’arrêter lorsque le cadre de mouvement est violé et non retourné au point de départ. L’utilisateur peut rencontrer une certaine frustration, mais il peut comprendre plus rapidement les limites et ne pas avoir à redémarrer toutes les actions prévues à chaque fois.