Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

BERLAKU UNTUK: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Cobalah Data Factory di Microsoft Fabric, solusi analitik all-in-one untuk perusahaan. Microsoft Fabric mencakup semuanya mulai dari pergerakan data hingga ilmu data, analitik real time, kecerdasan bisnis, dan pelaporan. Pelajari cara memulai uji coba baru secara gratis!

Dalam dunia big data, data mentah dan tidak terorganisir sering kali disimpan dalam sistem penyimpanan relasional, non-relasional, dan lainnya. Namun, dengan sendirinya, data mentah tidak memiliki konteks atau makna yang tepat untuk memberikan wawasan yang bermakna kepada analis, ilmuwan data, atau pembuat keputusan bisnis.

Big data memerlukan layanan yang dapat mengatur dan mengoperasionalkan proses untuk memperbaiki penyimpanan data mentah yang sangat besar ini menjadi wawasan bisnis yang dapat ditindaklanjuti. Azure Data Factory is a managed cloud service that's built for these complex hybrid extract-transform-load (ETL), extract-load-transform (ELT), and data integration projects.

Fitur-Fitur dari Azure Data Factory

Kompresi Data: Selama aktivitas Salin Data, dimungkinkan untuk mengompresi data dan menulis data terkompresi ke sumber data target. Fitur ini membantu mengoptimalkan penggunaan bandwidth dalam penyalinan data.

Dukungan Konektivitas Ekstensif untuk Sumber Data yang Berbeda: Azure Data Factory menyediakan dukungan konektivitas yang luas untuk menyambungkan ke sumber data yang berbeda. Ini berguna ketika Anda ingin menarik atau menulis data dari sumber data yang berbeda.

Pemicu Peristiwa Kustom: Azure Data Factory memungkinkan Anda mengotomatiskan pemrosesan data menggunakan pemicu peristiwa kustom. Fitur ini memungkinkan Anda untuk secara otomatis menjalankan tindakan tertentu ketika peristiwa tertentu terjadi.

Pratinjau dan Validasi Data: Selama aktivitas Salin Data, alat disediakan untuk mempratinjau dan memvalidasi data. Fitur ini membantu Anda memastikan bahwa data disalin dengan benar dan ditulis ke sumber data target dengan benar.

Aliran Data yang Dapat Disesuaikan: Azure Data Factory memungkinkan Anda membuat aliran data yang dapat disesuaikan. Fitur ini memungkinkan Anda menambahkan tindakan atau langkah kustom untuk pemrosesan data.

Keamanan Terintegrasi: Azure Data Factory menawarkan fitur keamanan terintegrasi seperti integrasi Id Entra dan kontrol akses berbasis peran untuk mengontrol akses ke aliran data. Fitur ini meningkatkan keamanan dalam pemrosesan data dan melindungi data Anda.

Skenario penggunaan

Misalnya, bayangkan perusahaan game yang mengumpulkan petabyte log game yang diproduksi oleh game di cloud. Perusahaan tersebut ingin menganalisis log ini untuk mendapatkan wawasan tentang preferensi pelanggan, demografi, dan perilaku penggunaan. Perusahaan tersebut juga ingin mengidentifikasi peluang up-sell dan cross-sell, mengembangkan fitur baru yang menarik, mendorong pertumbuhan bisnis, dan memberikan pengalaman yang lebih baik kepada pelanggan.

Untuk menganalisis log ini, perusahaan perlu menggunakan data referensi seperti informasi pelanggan, informasi game, dan informasi kampanye pemasaran yang ada di penyimpanan data lokal. Perusahaan ingin menggunakan data ini dari penyimpanan data lokal, menggabungkannya dengan data log tambahan yang ada di penyimpanan data cloud.

Untuk mengekstrak wawasan, diharapkan dapat memproses data yang digabungkan dengan menggunakan kluster Spark di cloud (Azure HDInsight), dan menerbitkan data yang diubah menjadi gudang data cloud seperti Azure Synapse Analytics untuk dengan mudah membuat laporan di atasnya. Mereka ingin mengotomatisasi alur kerja ini, dan memantau dan mengelolanya di jadwal harian. Mereka juga ingin mengeksekusinya ketika file mendarat di kontainer penyimpanan blob.

Azure Data Factory adalah platform yang memecahkan skenario data tersebut. Ini adalah layanan ETL dan integrasi data berbasis cloud yang memungkinkan Anda membuat alur kerja berbasis data untuk mengkoordinasikan pergerakan data dan mengubah data dalam skala besar. Dengan Azure Data Factory, Anda dapat membuat dan menjadwalkan alur kerja berbasis data (disebut alur) yang dapat menyerap data dari penyimpanan data yang berbeda. Anda dapat membangun proses ETL kompleks yang mengubah data secara visual dengan alur data atau dengan menggunakan layanan komputasi seperti Azure HDInsight Hadoop, Azure Databricks, dan Azure SQL Database.

Selain itu, Anda dapat memublikasikan data yang telah ditransformasikan ke penyimpanan data seperti Azure Synapse Analytics agar dapat dikonsumsi oleh aplikasi intelijen bisnis (BI). Pada akhirnya, melalui Azure Data Factory, data mentah dapat diatur ke dalam penyimpanan data dan data lake yang bermakna untuk keputusan bisnis yang lebih baik.

Bagaimana cara kerjanya?

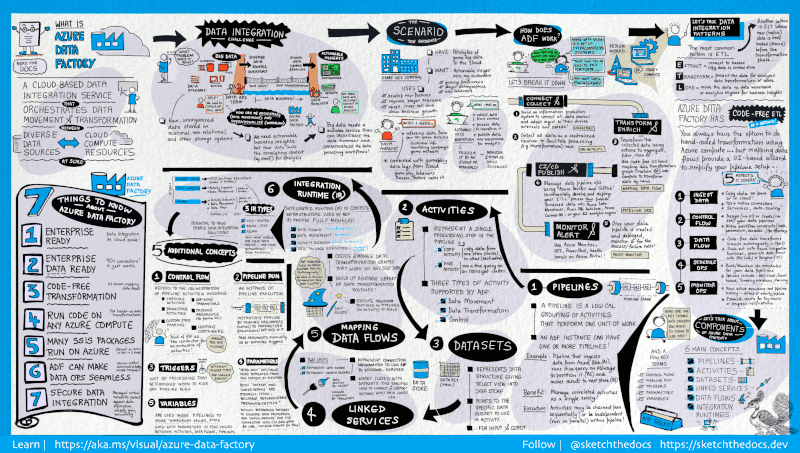

Azure Data Factory (ADF) berisi serangkaian sistem yang saling terhubung, yang menyediakan platform end-to-end lengkap untuk para teknisi data.

Panduan visual ini memberikan gambaran umum terperinci tentang arsitektur lengkap Data Factory:

Untuk melihat detail selengkapnya, pilih gambar sebelumnya untuk memperbesar, atau telusuri ke gambar resolusi tinggi.

Connect and collect

Perusahaan memiliki berbagai jenis data yang terletak di sumber yang berbeda di lokal, di cloud, terstruktur, tidak terstruktur, dan semi-terstruktur, semuanya tiba pada interval dan kecepatan yang berbeda.

Langkah pertama dalam membangun sistem produksi informasi adalah terhubung ke semua sumber data dan pemrosesan yang diperlukan, seperti layanan perangkat lunak sebagai layanan (SaaS), database, berbagi file, dan layanan web FTP. Kemudian pindahkan data sesuai kebutuhan ke lokasi terpusat untuk pemrosesan berikutnya.

Tanpa Data Factory, perusahaan harus membangun komponen pemindahan data kustom atau menulis layanan kustom untuk mengintegrasikan sumber data dan pemrosesan ini. Mahal dan sulit untuk mengintegrasikan dan memelihara sistem tersebut. Sistem ini juga sering tidak memiliki pemantauan, pemberitahuan, dan kontrol tingkat perusahaan yang dapat ditawarkan oleh layanan yang dikelola penuh.

Dengan Data Factory, Anda dapat menggunakan Aktivitas Salin dalam alur data untuk memindahkan data dari penyimpanan data sumber baik lokal maupun cloud ke penyimpanan data terpusat di cloud untuk analisis lanjutan. Misalnya, Anda dapat mengumpulkan data di Azure Data Lake Store dan mengubah data nanti dengan menggunakan layanan komputasi Azure Data Lake Analytics. Anda juga dapat mengumpulkan data dalam penyimpanan Azure Blob dan mengubahnya nanti dengan menggunakan kluster Azure HDInsight Hadoop.

Mengubah dan memperkaya

Setelah data ada di penyimpanan data terpusat di cloud, proses atau transformasi data yang dikumpulkan dengan menggunakan alur data pemetaan ADF. Alur data memungkinkan teknisi data untuk membangun dan memelihara grafik transformasi data yang dijalankan pada Spark tanpa perlu memahami kluster Spark atau pemrograman Spark.

Jika Anda lebih suka melakukan transformasi kode dengan tangan, ADF mendukung aktivitas eksternal untuk mengeksekusi transformasi Anda pada layanan komputasi seperti HDInsight Hadoop, Spark, Data Lake Analytics, dan Azure Machine Learning.

CI/CD and publish

Data Factory menawarkan dukungan penuh untuk CI/CD alur data Anda menggunakan Azure DevOps dan GitHub. Ini memungkinkan Anda untuk secara bertahap mengembangkan dan memberikan proses ETL Anda sebelum menerbitkan produk jadi. Setelah data mentah disempurnakan ke dalam bentuk siap pakai bisnis, muat data ke Azure Data Warehouse, Azure SQL Database, Azure Cosmos DB, atau mesin analitik apa pun yang dapat diarahkan pengguna bisnis Anda dari alat kecerdasan bisnis mereka.

Monitor

Setelah Anda berhasil membangun dan menerapkan alur integrasi data Anda, memberikan nilai bisnis dari data yang disempurnakan, pantau aktivitas dan alur terjadwal untuk tingkat keberhasilan dan kegagalan. Azure Data Factory memiliki dukungan bawaan untuk pemantauan alur melalui Azure Monitor, API, PowerShell, log Azure Monitor, dan panel kesehatan di portal Microsoft Azure.

Konsep tingkat atas

Langganan Azure dapat memiliki satu atau beberapa instans Azure Data Factory (atau pabrik data). Azure Data Factory terdiri dari komponen utama berikut:

- Pipelines

- Aktivitas

- Datasets

- Layanan Tertaut

- Data Flows

- Integration Runtimes

Komponen-komponen ini bekerja sama untuk menyediakan platform tempat Anda dapat menyusun alur kerja berbasis data dengan langkah-langkah untuk memindahkan dan mengubah data.

Pipeline

Pabrik data dapat memiliki satu atau beberapa alur. A pipeline is a logical grouping of activities that performs a unit of work. Together, the activities in a pipeline perform a task. Misalnya, alur dapat berisi sekelompok aktivitas yang menyerap data dari Azure blob, lalu menjalankan kueri Apache Hive pada kluster HDInsight untuk mempartisi data.

Keuntungannya adalah bahwa alur memungkinkan Anda untuk mengelola aktivitas sebagai satu kesatuan alih-alih masing-masing secara individual. Kegiatan dalam pipa dapat dirangkai bersama untuk beroperasi secara berurutan, atau mereka dapat beroperasi secara independen secara paralel.

Mapping data flows

Buat dan kelola grafik logika transformasi data yang bisa Anda gunakan untuk mentransformasi data berukuran apa pun. Anda dapat membangun perpustakaan yang dapat digunakan kembali dari rutinitas transformasi data dan menjalankan proses tersebut dengan cara yang terdistribusi dari pipeline ADF Anda. Azure Data Factory akan mengeksekusi logika Anda pada kluster Spark yang berputar ke atas dan bawah saat Anda membutuhkannya. Anda tidak perlu mengelola atau memelihara kluster.

Aktivitas

Aktivitas mewakili langkah pemrosesan dalam alur kerja. Misalnya, Anda dapat menggunakan aktivitas salin untuk menyalin data dari satu penyimpanan data ke penyimpanan data lain. Demikian pula, Anda mungkin menggunakan aktivitas Hive, yang menjalankan kueri Hive pada kluster Azure HDInsight, untuk mengubah atau menganalisis data Anda. Azure Data Factory memiliki tiga pengelompokan aktivitas: aktivitas pemindahan data, aktivitas transformasi data, dan aktivitas kontrol.

Datasets

Himpunan data mewakili struktur data dalam penyimpanan data, yang hanya menunjuk ke atau mereferensikan data yang ingin Anda gunakan dalam aktivitas Anda sebagai input atau output.

Layanan Tertaut

Layanan tertaut mirip seperti string koneksi, yang menentukan informasi koneksi yang diperlukan agar Data Factory tersambung ke sumber daya eksternal. Anggap seperti ini: layanan tertaut menentukan koneksi ke sumber data dan himpunan data mewakili struktur data. Misalnya, layanan yang ditautkan dengan Azure Storage menentukan string koneksi yang akan disambungkan ke akun Azure Storage. Himpunan data Azure blob menentukan kontainer blob dan folder yang berisi data.

Layanan tertaut digunakan karena dua alasan di Data Factory:

Untuk mewakili penyimpanan data yang mencakup, tetapi tidak terbatas pada, database SQL Server, database Oracle, berbagi file, atau akun penyimpanan Azure blob. Untuk daftar penyimpanan data yang didukung, lihat artikel aktivitas salin.

Untuk mewakili sumber daya komputasi yang dapat menghosting eksekusi aktivitas. Misalnya, aktivitas HDInsightHive yang berjalan pada kluster HDInsight Hadoop. Untuk daftar aktivitas transformasi dan lingkungan komputasi yang didukung, lihat artikel data transformasi.

Integration Runtime

Di Data Factory, aktivitas menentukan tindakan yang akan dilakukan. Layanan tertaut menentukan penyimpanan data target atau layanan komputasi. Waktu proses integrasi berfungsi sebagai jembatan antara aktivitas dan layanan yang ditautkan. Ini dirujuk oleh layanan atau aktivitas tertaut, dan menyediakan lingkungan komputasi tempat aktivitas dijalankan atau dikirim. Dengan begitu, aktivitas dapat dilakukan di wilayah yang paling dekat dengan penyimpanan data target atau layanan komputasi melalui cara paling berperforma sekaligus memenuhi kebutuhan keamanan dan kepatuhan.

Pemicu

Pemicu mewakili unit pemrosesan yang menentukan kapan eksekusi pipeline harus dimulai. Ada berbagai jenis pemicu untuk berbagai jenis peristiwa.

Pipeline runs

A pipeline run is an instance of the pipeline execution. Pipeline runs are typically instantiated by passing the arguments to the parameters that are defined in pipelines. Argumen dapat dilewatkan secara manual atau dalam definisi pemicu.

Parameters

Parameters are key-value pairs of read-only configuration. Parameter-parameter didefinisikan dalam alur kerja. Argumen untuk parameter yang ditentukan diteruskan selama eksekusi dari konteks proses yang dibuat oleh pemicu atau alur yang dijalankan secara manual. Aktivitas dalam alur mengonsumsi nilai parameter.

Himpunan data adalah parameter yang bertipe kuat dan entitas yang dapat digunakan kembali serta dapat direferensikan. Aktivitas dapat mereferensikan himpunan data dan dapat menggunakan properti yang ditentukan dalam definisi himpunan data.

A linked service is also a strongly typed parameter that contains the connection information to either a data store or a compute environment. Ini juga merupakan entitas yang dapat digunakan kembali/dapat direferensikan.

Alur kontrol

Control flow is an orchestration of pipeline activities that includes chaining activities in a sequence, branching, defining parameters at the pipeline level, and passing arguments while invoking the pipeline on-demand or from a trigger. It also includes custom-state passing and looping containers, that is, For-each iterators.

Variables

Variabel dapat digunakan di dalam pipa data untuk menyimpan nilai sementara dan juga dapat digunakan bersama dengan parameter untuk memungkinkan meneruskan nilai antara pipa data, aliran data, dan aktivitas lainnya.

Konten terkait

Berikut adalah dokumen langkah penting berikutnya untuk dijelajahi: