Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

BERLAKU UNTUK: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Petunjuk / Saran

Cobalah Data Factory di Microsoft Fabric, solusi analitik all-in-one untuk perusahaan. Microsoft Fabric mencakup semuanya mulai dari pergerakan data hingga ilmu data, analitik real time, kecerdasan bisnis, dan pelaporan. Pelajari cara memulai uji coba baru secara gratis!

Dalam tutorial ini, Anda menggunakan portal Microsoft Azure untuk membuat pabrik data. Anda kemudian akan menggunakan alat Salin Data untuk membuat alur yang secara bertahap menyalin file baru dan yang diubah saja, dari penyimpanan Azure Blob ke penyimpanan Azure Blob. Ini menggunakan LastModifiedDate untuk menentukan file mana yang akan disalin.

Setelah Anda menyelesaikan langkah-langkah di sini, Azure Data Factory akan memindai semua file di penyimpanan sumber, menerapkan filter file dengan LastModifiedDate, dan menyalin ke penyimpanan tujuan hanya file yang baru atau telah diperbarui sejak terakhir kali. Perhatikan bahwa jika Data Factory memindai sejumlah besar file, Anda masih harus mengharapkan durasi yang panjang. Pemindaian file memakan waktu, bahkan ketika jumlah data yang disalin berkurang.

Catatan

Jika Anda baru menggunakan Azure Data Factory, lihat Pengantar Azure Data Factory.

Dalam tutorial ini, Anda akan menyelesaikan tugas-tugas ini:

- Membuat pabrik data.

- Menggunakan alat Salin Data untuk membuat alur.

- Pantau eksekusi alur dan aktivitas.

Prasyarat

- Langganan Azure: Jika Anda tidak memiliki langganan Azure, buat akun gratis sebelum memulai.

- Akun Azure Storage: Gunakan penyimpanan Blob untuk penyimpanan data sumber dan sink. Jika Anda belum memiliki akun Azure Storage, ikuti instruksi di Buat akun penyimpanan.

Membuat dua kontainer di penyimpanan Blob

Siapkan penyimpanan Blob Anda untuk tutorial dengan menyelesaikan langkah-langkah ini:

Buat kontainer bernama sumber. Anda bisa menggunakan berbagai alat untuk melakukan tugas ini, seperti Azure Storage Explorer.

Buat kontainer bernama tujuan.

Membuat pabrik data

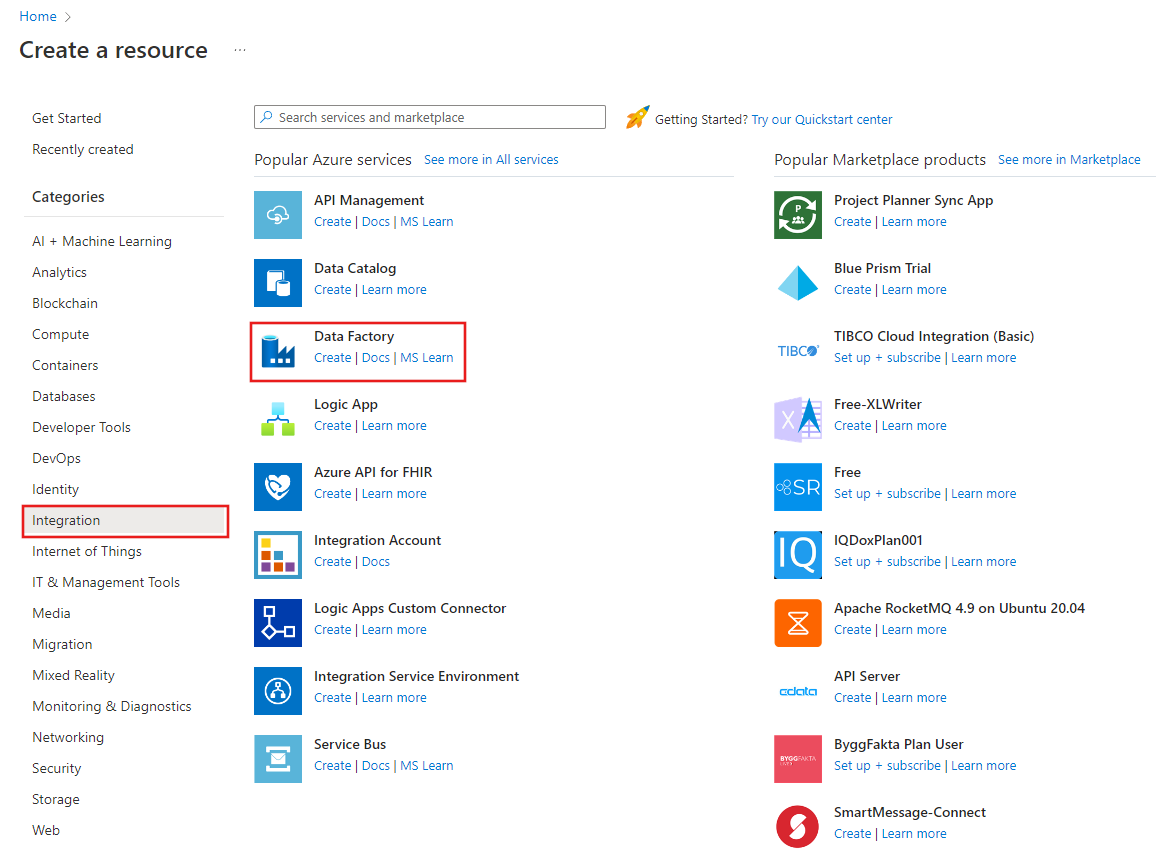

Di menu atas, pilih Buat sumber daya>Analitik>Pabrik Data :

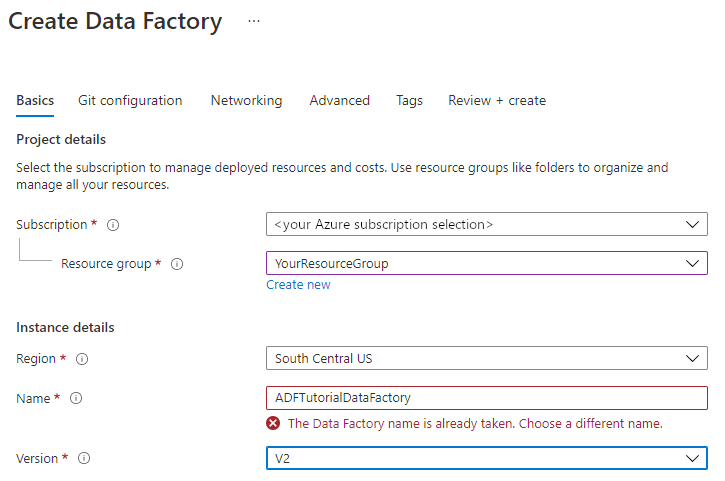

Di halaman Pabrik data baru, di bawah Nama, masukkan ADFTutorialDataFactory.

Nama pabrik data Anda harus unik secara global. Anda mungkin menerima pesan kesalahan ini:

Jika Anda menerima pesan kesalahan tentang nilai nama, masukkan nama yang berbeda untuk pabrik data. Misalnya, gunakan nama yournameADFTutorialDataFactory. Untuk aturan penamaan artefak Data Factory, lihat aturan penamaan Data Factory.

Di bawah Langganan, pilih langganan Azure tempat Anda akan membuat pabrik data baru.

Di bawah Grup Sumber Daya, lakukan salah satu langkah berikut ini:

Pilih Gunakan yang ada, kemudian pilih grup sumber daya yang ada dalam daftar.

Pilih Buat baru lalu masukkan nama untuk grup sumber daya.

Untuk mempelajari grup sumber daya, lihat Menggunakan grup sumber daya untuk mengelola sumber daya Azure Anda.

Di bawah Versi, pilih V2.

Di bawah Lokasi, pilih lokasi untuk pabrik data. Hanya lokasi yang didukung yang muncul dalam daftar. Penyimpanan data (misalnya, Azure Storage dan Azure SQL Database) dan komputasi (misalnya, Azure HDInsight) yang digunakan oleh pabrik data Anda dapat berada di lokasi dan wilayah lain.

Pilih Buat.

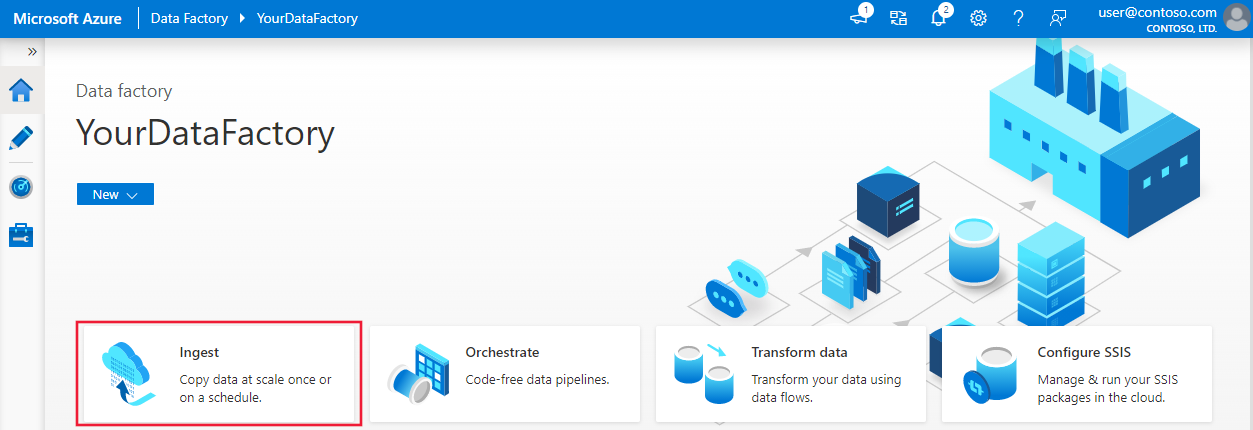

Setelah pabrik data dibuat, beranda pabrik data muncul.

Untuk membuka antarmuka pengguna (UI) Azure Data Factory pada tab terpisah, pilih Buka pada petak peta Membuka Azure Data Factory Studio:

Menggunakan alat Salin Data untuk membuat alur

Di beranda Azure Data Factory, pilih petak peta Serap untuk membuka alat Salin Data:

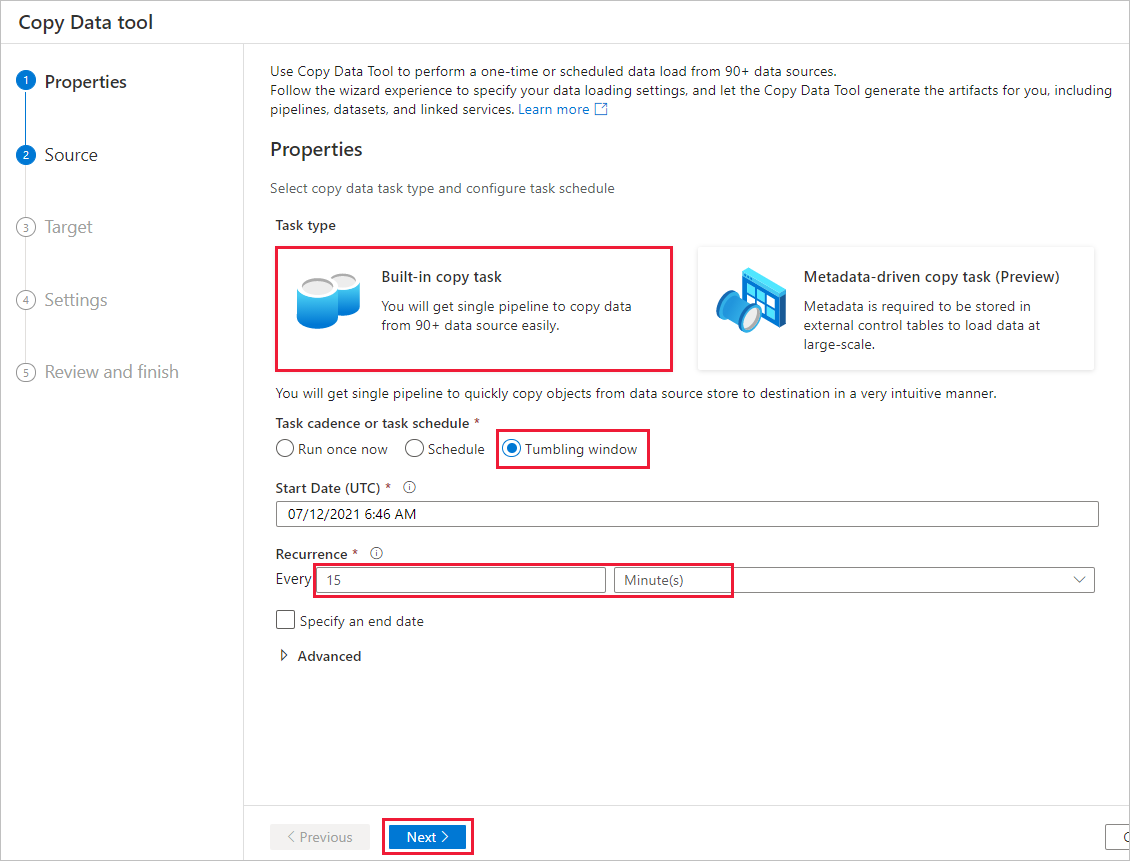

Pada halaman Properti, ikuti langkah-langkah berikut ini:

Di Jenis tugas, pilih Tugas salin bawaan.

Di Ritme tugas atau jadwal tugas, pilih Jendela tumbling.

Di bawahPengulangan, masukkan 15 Menit.

Pilih Selanjutnya.

Pada halaman Penyimpanan data sumber, selesaikan langkah-langkah berikut ini:

Pilih + Sambungan baru untuk menambahkan sambungan.

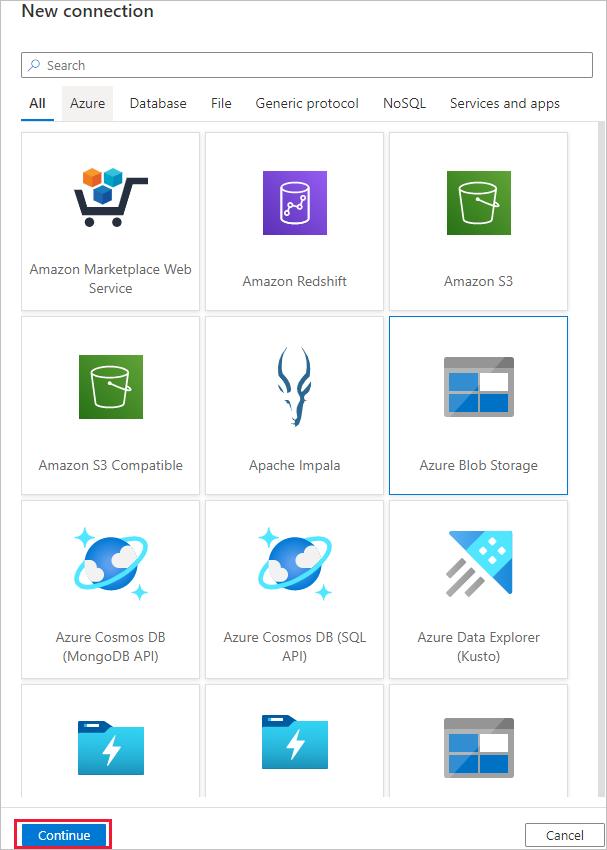

Pilih Azure Blob Storage dari galeri, lalu pilih Lanjutkan:

Pada halaman Koneksi baru (Azure Blob Storage), pilih langganan Azure Anda dari daftar langganan Azure dan akun penyimpanan Anda dari daftar Nama akun penyimpanan. Uji koneksi lalu pilih Buat.

Pilih koneksi yang baru dibuat di blok Koneksi.

Di bagian File atau folder, pilih Telusur, lalu pilih folder sumber, kemudian pilih OK.

Di Perilaku pemuatan file, pilih Pemuatan bertambah bertahap: LastModifiedDate, dan pilih Salinan biner.

Pilih Selanjutnya.

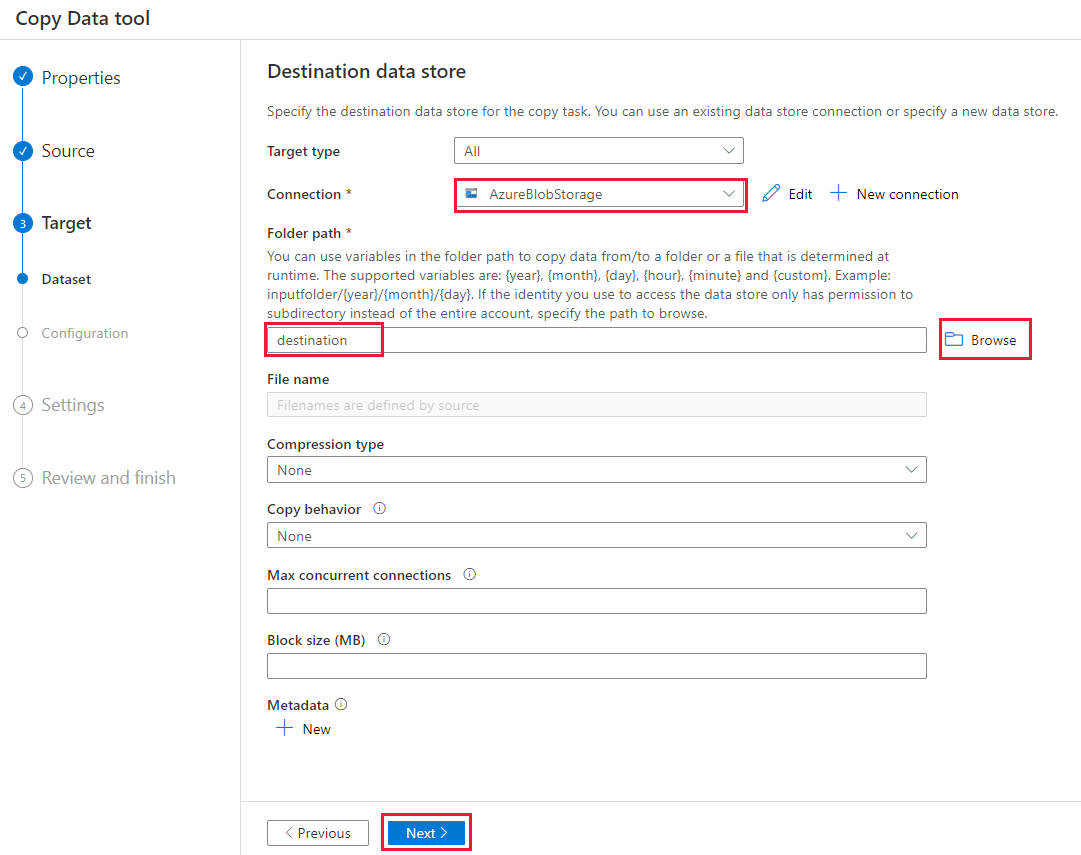

Pada halaman Penyimpanan data tujuan, selesaikan langkah-langkah berikut:

Pilih sambungan AzureBlobStorage yang Anda buat. Ini adalah akun penyimpanan yang sama dengan penyimpanan data sumber.

Di bagian Jalur folder, telusuri dan pilih folder tujuan, lalu pilih OK.

Pilih Selanjutnya.

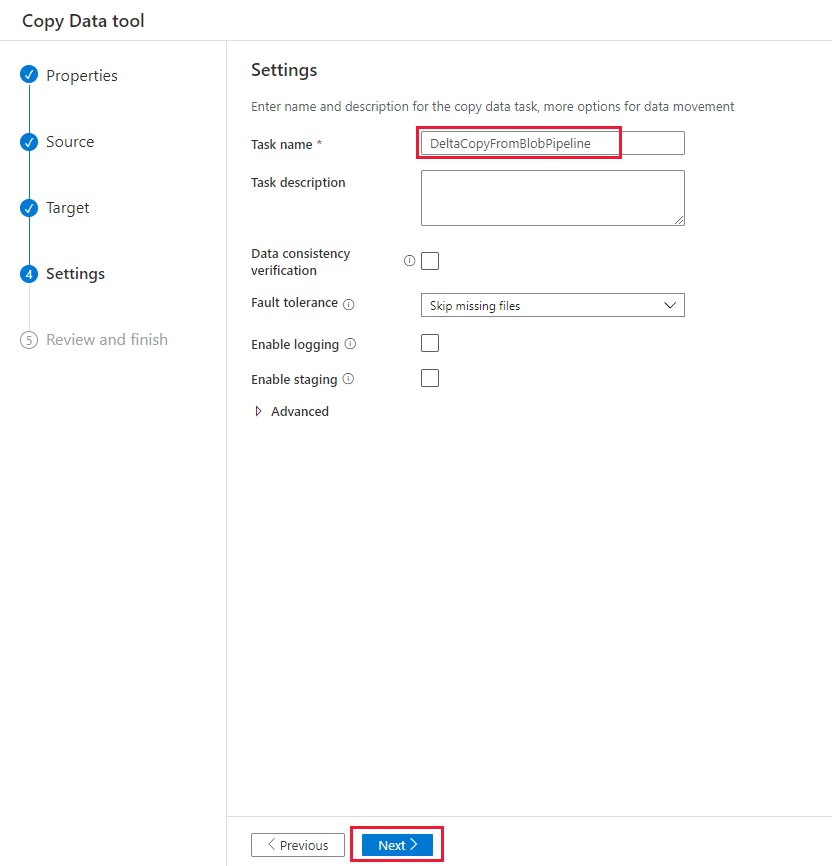

Pada halaman Pengaturan, di Nama tugas, masukkan DeltaCopyFromBlobPipeline, lalu pilih Berikutnya. Data Factory membuat alur dengan nama tugas yang ditentukan.

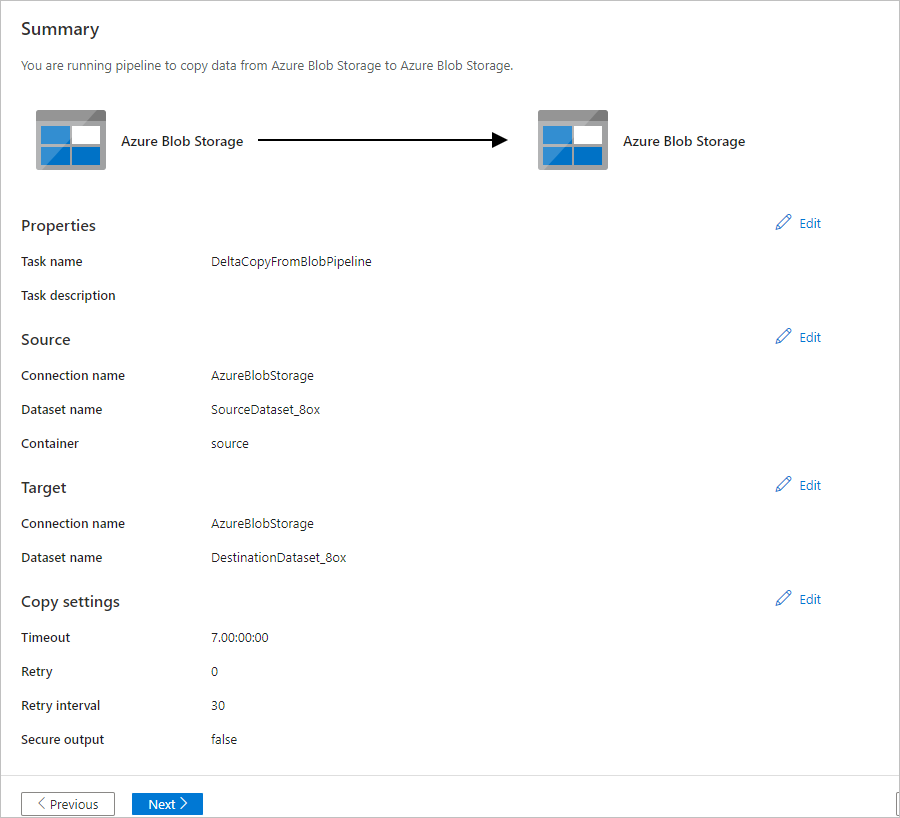

Pada halaman Ringkasan, tinjau pengaturan, lalu pilih Berikutnya.

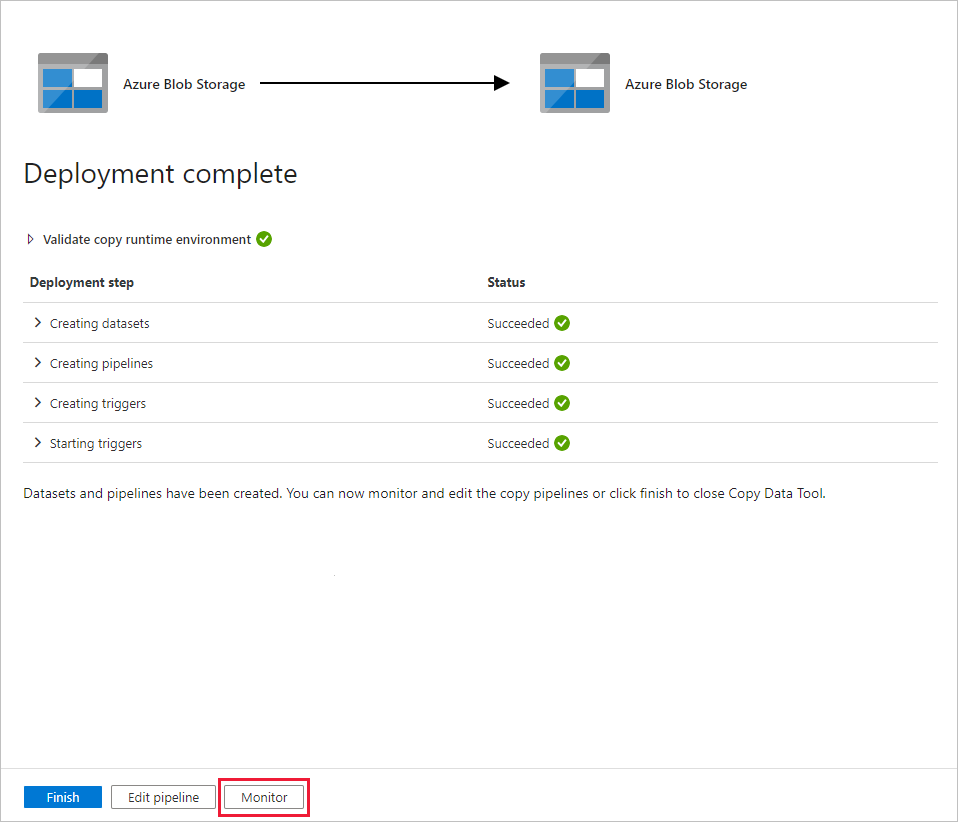

Pada Halaman penyebaran, pilih Monitor untuk memantau alur (tugas).

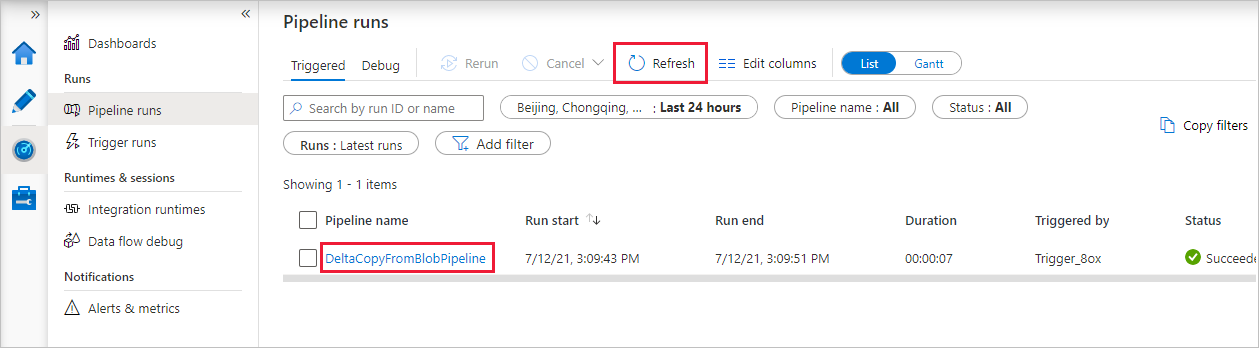

Perhatikan bahwa tab Pemantauan di sebelah kiri dipilih secara otomatis. Aplikasi beralih ke tab Pemantau. Anda melihat status alur. Pilih Refresh untuk menyegarkan daftar. Pilih tautan di bawah Nama alur untuk melihat detail eksekusi aktivitas atau menjalankan kembali alur.

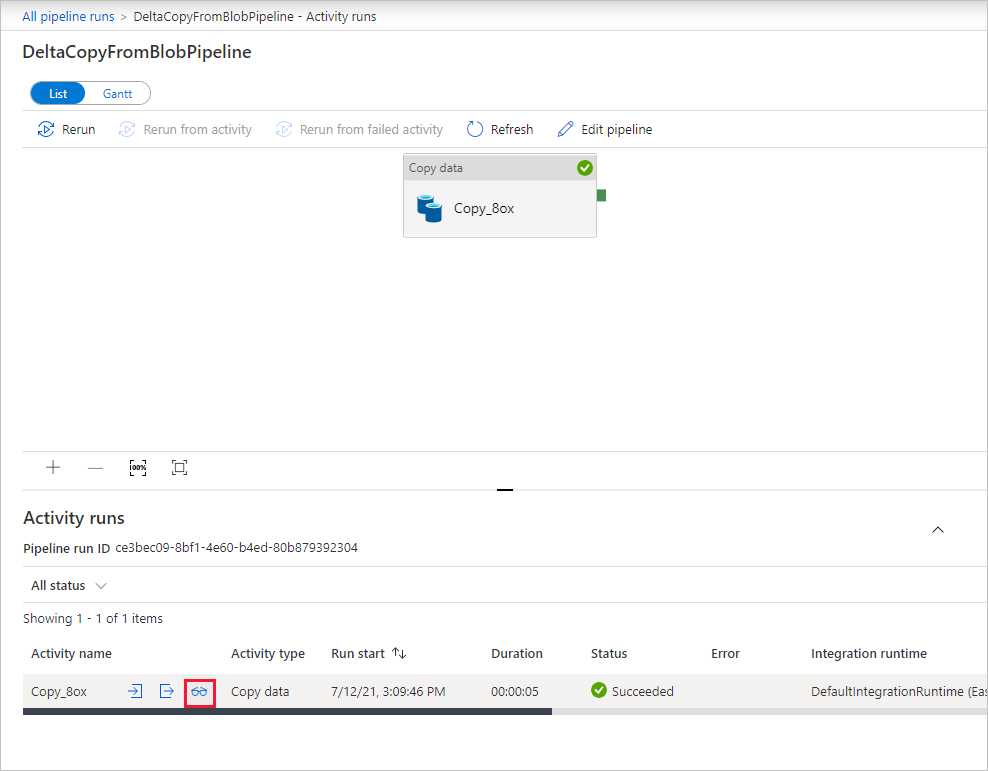

Hanya ada satu aktivitas (aktivitas salin) dalam alur, jadi Anda hanya akan melihat satu entri. Untuk detail tentang operasi penyalinan, pada halaman Aktivitas berjalan, pilih tautan Detail (ikon kacamata) di kolom Nama aktivitas. Untuk detail properti, lihat Ringkasan aktivitas salin.

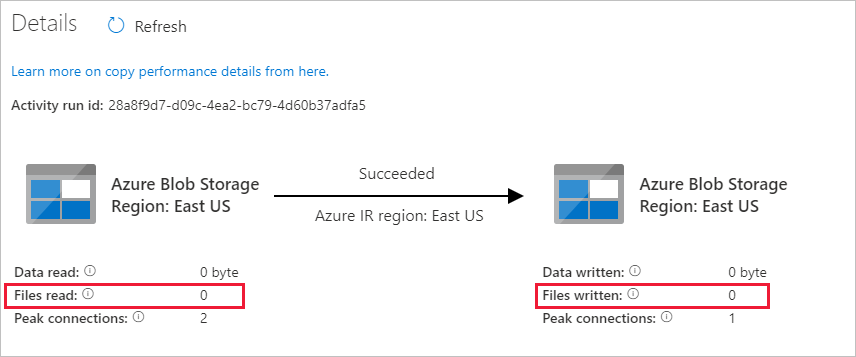

Karena tidak ada file dalam kontainer sumber di akun penyimpanan Blob Anda, Anda tidak akan melihat file apa pun yang disalin ke kontainer tujuan di akun:

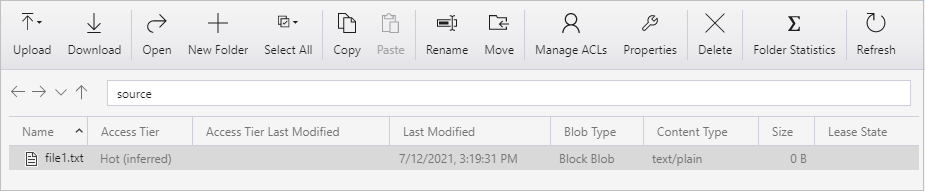

Buat file teks kosong dan beri nama file1.txt. Unggah file teks ini ke kontainer sumber di akun penyimpanan Anda. Anda bisa menggunakan berbagai alat untuk melakukan tugas ini, seperti Azure Storage Explorer.

Untuk kembali ke tampilan Alur berjalan, pilih tautan Semua tautan berjalan di menu breadcrumb pada halaman Aktivitas berjalan, dan tunggu hingga alur yang sama otomatis terpicu lagi.

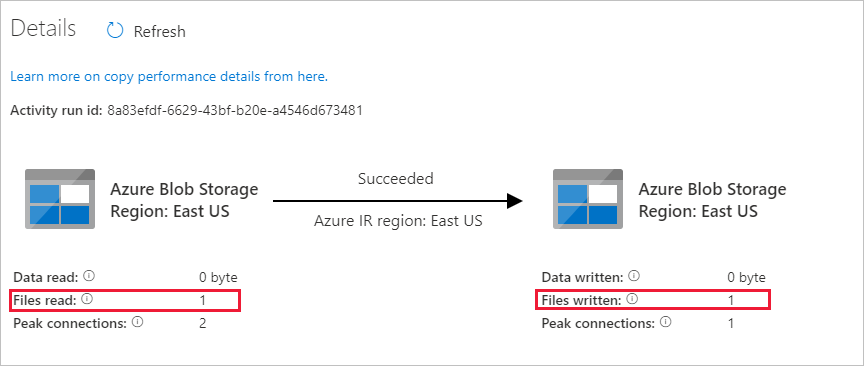

Ketika eksekusi alur kedua selesai, ikuti langkah yang sama yang disebutkan sebelumnya untuk meninjau detail eksekusi aktivitas.

Anda akan melihat bahwa satu file (file1.txt) telah disalin dari kontainer sumber ke kontainer tujuan akun penyimpanan Blob Anda:

Buat file teks kosong lainnya dan beri nama file2.txt. Unggah file teks ini ke kontainer sumber di akun penyimpanan Blob Anda.

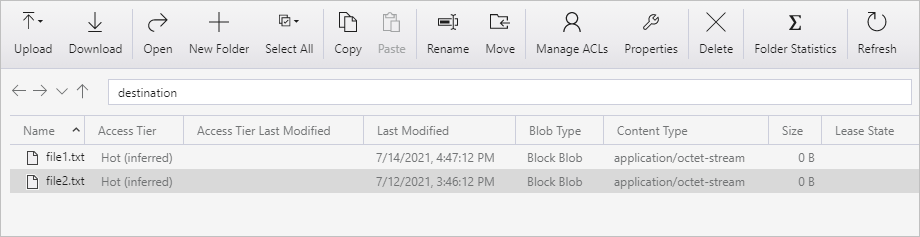

Ulangi langkah 11 dan 12 untuk file teks kedua. Anda akan melihat bahwa hanya file baru (file2.txt) yang disalin dari kontainer sumber ke kontainer tujuan akun penyimpanan Anda selama eksekusi alur.

Anda juga dapat memverifikasi bahwa hanya satu file yang telah disalin dengan menggunakan Azure Storage Explorer untuk memindai file:

Konten terkait

Buka tutorial berikut untuk mempelajari cara mengubah data dengan menggunakan kluster Apache Spark di Azure: