Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Tutorial ini memandu Anda menyiapkan ekstensi Databricks untuk Visual Studio Code, lalu menjalankan Python pada kluster Azure Databricks dan sebagai pekerjaan Azure Databricks di ruang kerja jarak jauh Anda. Lihat Apa itu ekstensi Databricks untuk Visual Studio Code?.

Persyaratan

Tutorial ini mengharuskan:

- Anda telah menginstal ekstensi Databricks untuk Visual Studio Code. Lihat Menginstal ekstensi Databricks untuk Visual Studio Code.

- Anda memiliki kluster Azure Databricks jarak jauh untuk digunakan. Catat nama kluster. Untuk melihat kluster yang tersedia, di bilah sisi ruang kerja Azure Databricks Anda, klik Komputasi. Lihat Komputasi.

Langkah 1: Buat proyek Databricks baru

Dalam langkah ini, Anda membuat proyek Databricks baru dan mengonfigurasi koneksi dengan ruang kerja Azure Databricks jarak jauh Anda.

- Luncurkan Visual Studio Code, lalu klik Buka File > Folder dan buka beberapa folder kosong di komputer pengembangan lokal Anda.

- Di bilah samping, klik ikon logo Databricks . Ini membuka ekstensi Databricks.

- Dalam tampilan Konfigurasi, klik Buat konfigurasi.

-

Palet Perintah untuk mengonfigurasi ruang kerja Databricks Anda terbuka. Untuk Host Databricks, masukkan atau pilih URL per ruang kerja Anda, misalnya

https://adb-1234567890123456.7.azuredatabricks.net. - Pilih profil autentikasi untuk proyek. Lihat Mengatur otorisasi untuk ekstensi Databricks di Visual Studio Code.

Langkah 2: Tambahkan informasi kluster ke ekstensi Databricks dan mulai kluster

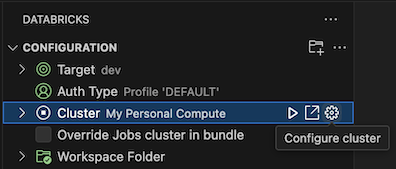

Dengan tampilan Konfigurasi sudah terbuka, klik Pilih kluster atau klik ikon gigi (Konfigurasikan kluster).

Di Palet Perintah, pilih nama kluster yang Anda buat sebelumnya.

Klik ikon putar (Mulai Kluster) jika belum dimulai.

Langkah 3: Membuat dan menjalankan kode Python

Buat file kode Python lokal: pada bilah samping, klik ikon folder (Explorer).

Pada menu utama, klik File > File Baru dan pilih file Python. Beri nama file demo.py dan simpan ke akar proyek.

Tambahkan kode berikut ke file lalu simpan. Kode ini membuat dan menampilkan konten PySpark DataFrame dasar:

from pyspark.sql import SparkSession from pyspark.sql.types import * spark = SparkSession.builder.getOrCreate() schema = StructType([ StructField('CustomerID', IntegerType(), False), StructField('FirstName', StringType(), False), StructField('LastName', StringType(), False) ]) data = [ [ 1000, 'Mathijs', 'Oosterhout-Rijntjes' ], [ 1001, 'Joost', 'van Brunswijk' ], [ 1002, 'Stan', 'Bokenkamp' ] ] customers = spark.createDataFrame(data, schema) customers.show()# +----------+---------+-------------------+ # |CustomerID|FirstName| LastName| # +----------+---------+-------------------+ # | 1000| Mathijs|Oosterhout-Rijntjes| # | 1001| Joost| van Brunswijk| # | 1002| Stan| Bokenkamp| # +----------+---------+-------------------+Klik ikon Jalankan di Databricks di samping daftar tab editor, lalu klik Unggah dan Jalankan File. Output muncul di tampilan Konsol Debug.

Atau, dalam tampilan Explorer, klik

demo.pykanan file, lalu klik Jalankan pada Databricks>Unggah dan Jalankan File.

Langkah 4: Jalankan kode sebagai pekerjaan

Untuk menjalankan demo.py sebagai pekerjaan, klik ikon Jalankan di Databricks di samping daftar tab editor, lalu klik Jalankan File sebagai Alur Kerja. Output muncul di tab editor terpisah di demo.py samping editor file.

![]()

Atau, klik demo.py kanan file di panel Explorer, lalu pilih Jalankan di Databricks>Run File sebagai Alur Kerja.

Langkah berikutnya

Sekarang setelah Anda berhasil menggunakan ekstensi Databricks untuk Visual Studio Code untuk mengunggah file Python lokal dan menjalankannya dari jarak jauh, Anda juga dapat:

- Jelajahi sumber daya dan variabel Bundel Aset Databricks menggunakan antarmuka pengguna ekstensi. Lihat Fitur ekstensi Bundel Aset Databricks.

- Jalankan atau debug kode Python dengan Databricks Connect. Lihat Kode debug menggunakan Databricks Connect untuk ekstensi Databricks untuk Visual Studio Code.

- Jalankan file atau buku catatan sebagai pekerjaan Azure Databricks. Lihat Menjalankan file di kluster atau file atau buku catatan sebagai pekerjaan di Azure Databricks menggunakan ekstensi Databricks untuk Visual Studio Code.

- Jalankan pengujian dengan

pytest. Lihat Menjalankan pengujian Python menggunakan ekstensi Databricks untuk Visual Studio Code.