Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Penting

Halaman ini mencakup instruksi untuk mengelola komponen Azure IoT Operations menggunakan manifes penyebaran Kubernetes, yang saat ini dalam pratinjau. Fitur ini disediakan dengan beberapa batasan, dan tidak boleh digunakan untuk beban kerja produksi.

Lihat Ketentuan Penggunaan Tambahan untuk Pratinjau Microsoft Azure untuk persyaratan hukum yang berlaku pada fitur Azure dalam versi beta, pratinjau, atau belum dirilis secara umum.

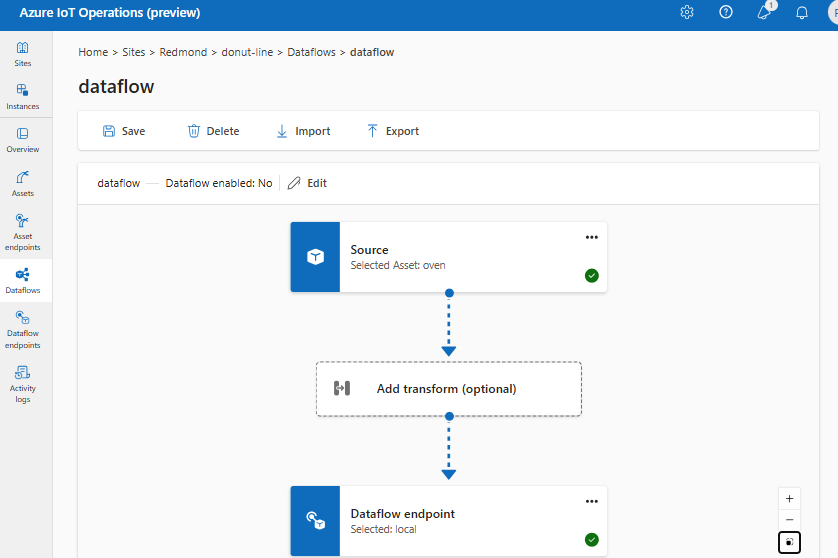

Aliran data adalah jalur yang diambil data dari sumber ke tujuan dengan transformasi opsional. Anda dapat mengonfigurasi aliran data dengan membuat sumber daya kustom aliran Data atau menggunakan antarmuka pengguna web pengalaman operasi. Aliran data terdiri dari tiga bagian: sumber, transformasi, dan tujuan.

Untuk menentukan sumber dan tujuan, Anda perlu mengonfigurasi titik akhir aliran data. Transformasi bersifat opsional dan dapat mencakup operasi seperti memperkaya data, memfilter data, dan memetakan data ke bidang lain.

Penting

Setiap aliran data harus memiliki titik akhir default broker MQTT lokal Azure IoT Operations sebagai entah sebagai sumber atau tujuan.

Anda dapat menggunakan pengalaman operasi di Operasi Azure IoT untuk membuat aliran data. Pengalaman operasi menyediakan antarmuka visual untuk mengonfigurasi aliran data. Anda juga dapat menggunakan Bicep untuk membuat aliran data menggunakan file Bicep, atau menggunakan Kubernetes untuk membuat aliran data menggunakan file YAML.

Lanjutkan membaca untuk mempelajari cara mengonfigurasi sumber, transformasi, dan tujuan.

Prasyarat

Anda dapat menyebarkan aliran data segera setelah Anda memiliki instans Operasi Azure IoT menggunakan profil aliran data default dan titik akhir default. Namun, Anda mungkin ingin mengonfigurasi profil aliran data dan titik akhir untuk menyesuaikan aliran data.

Profil aliran data

Jika Anda tidak memerlukan pengaturan penskalaan yang berbeda untuk aliran data Anda, gunakan profil aliran data default yang disediakan oleh Operasi Azure IoT. Anda harus menghindari mengaitkan terlalu banyak aliran data dengan satu profil aliran data. Jika Anda memiliki sejumlah besar aliran data, distribusikan di beberapa profil aliran data untuk mengurangi risiko melebihi batas ukuran konfigurasi profil aliran data.

Untuk mempelajari cara mengonfigurasi profil aliran data baru, lihat Mengonfigurasi profil aliran data.

Titik akhir aliran data

Titik akhir aliran data diperlukan untuk mengonfigurasi sumber dan tujuan untuk aliran data. Untuk memulai dengan cepat, Anda dapat menggunakan titik akhir aliran data default untuk broker MQTT lokal. Anda juga dapat membuat jenis titik akhir aliran data lainnya seperti Kafka, Event Hubs, atau Azure Data Lake Storage. Untuk mempelajari cara mengonfigurasi setiap jenis titik akhir aliran data, lihat Mengonfigurasi titik akhir aliran data.

Mulai sekarang

Setelah memiliki prasyarat, Anda dapat mulai membuat aliran data.

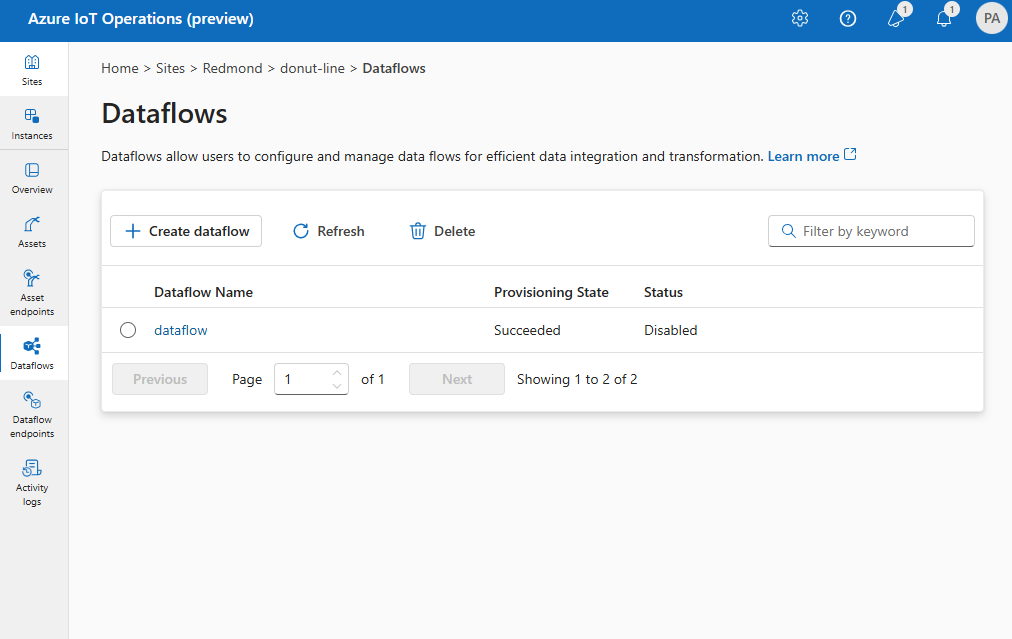

Untuk membuat aliran data dalam operasi pengalaman, pilih Aliran data>Buat aliran data.

Pilih nama tempat penampung new-data-flow untuk mengatur properti aliran data. Masukkan nama aliran data dan pilih profil aliran data yang akan digunakan. Profil aliran data default dipilih secara default. Untuk informasi selengkapnya tentang profil aliran data, lihat Mengonfigurasi profil aliran data.

Penting

Anda hanya dapat memilih profil aliran data saat membuat aliran data. Anda tidak dapat mengubah profil aliran data setelah aliran data dibuat. Jika Anda ingin mengubah profil aliran data dari aliran data yang ada, hapus aliran data asli dan buat yang baru dengan profil aliran data baru.

Konfigurasikan titik akhir sumber, transformasi, dan tujuan untuk aliran data dengan memilih item dalam diagram aliran data.

Tinjau bagian berikut untuk mempelajari cara mengonfigurasi jenis operasi aliran data.

Sumber

Untuk mengonfigurasi sumber untuk aliran data, tentukan referensi titik akhir dan daftar sumber data untuk titik akhir. Pilih salah satu opsi berikut sebagai sumber untuk aliran data.

Jika titik akhir default tidak digunakan sebagai sumber, titik akhir harus digunakan sebagai tujuan. Untuk mempelajari selengkapnya tentang menggunakan titik akhir broker MQTT lokal, lihat Aliran data harus menggunakan titik akhir broker MQTT lokal.

Opsi 1: Gunakan titik akhir broker pesan default sebagai sumber

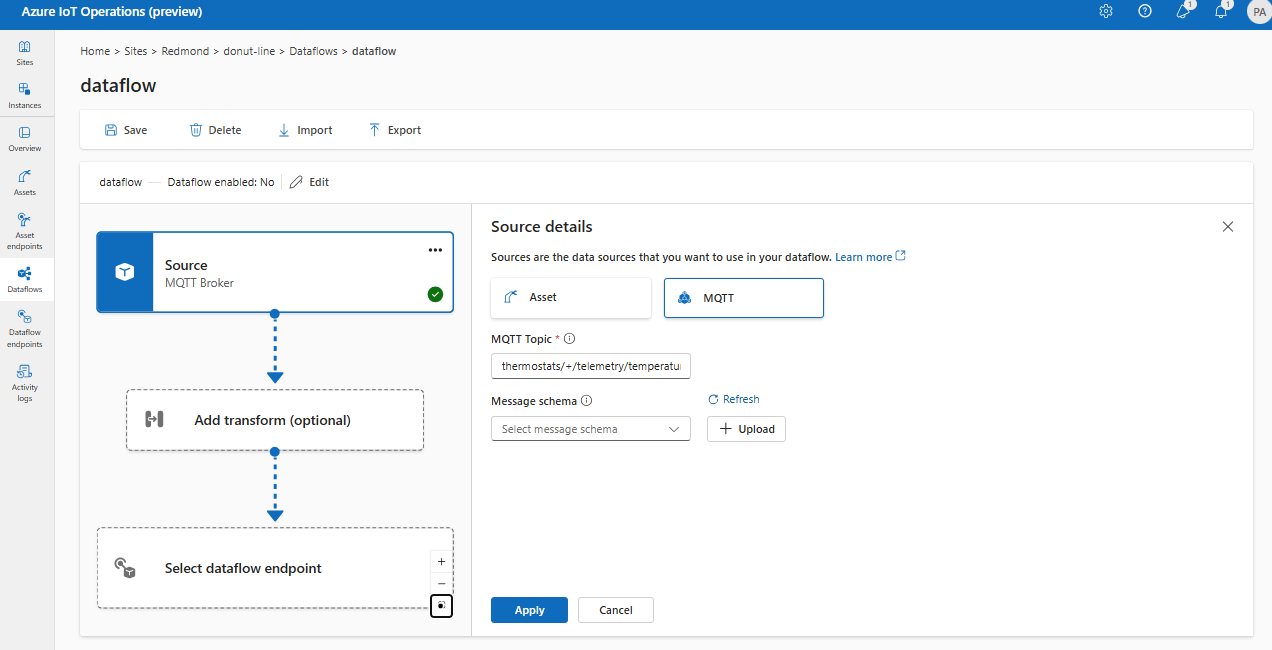

Di bawah Detail sumber, pilih Pengelola Pesan.

Masukkan pengaturan berikut untuk sumber broker pesan:

Pengaturan Deskripsi Titik akhir aliran data Pilih default untuk menggunakan titik akhir broker pesan MQTT default. Topik Filter topik untuk berlangganan pesan masuk. Gunakan Topik> Tambahkan baris untuk menambahkan beberapa topik. Untuk informasi selengkapnya tentang topik, lihat Mengonfigurasi topik MQTT atau Kafka. Skema pesan Skema yang digunakan untuk mendeserialisasi pesan masuk. Lihat Menentukan skema untuk mendeserialisasi data. Pilih Terapkan.

Karena dataSources memungkinkan Anda menentukan topik MQTT atau Kafka tanpa memodifikasi konfigurasi titik akhir, Anda dapat menggunakan kembali titik akhir untuk beberapa aliran data meskipun topiknya berbeda. Untuk mempelajari selengkapnya, lihat Mengonfigurasi sumber data.

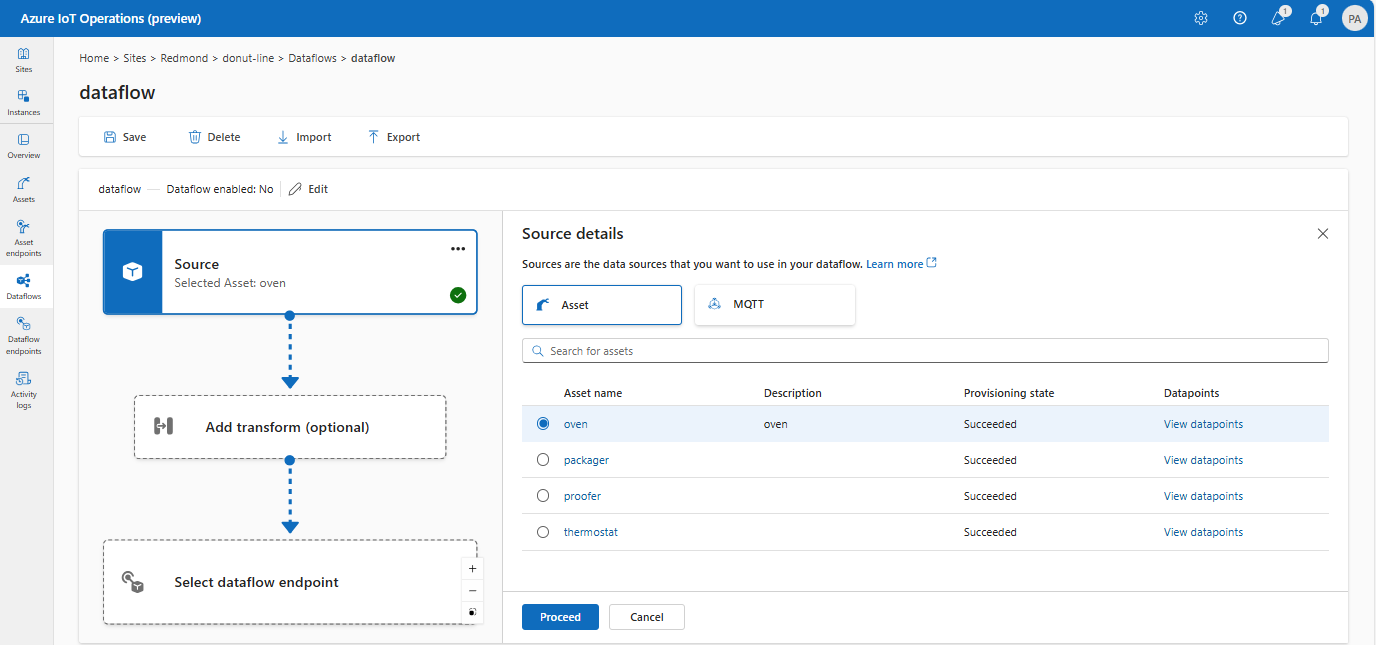

Opsi 2: Gunakan aset sebagai sumber

Anda dapat menggunakan aset sebagai sumber untuk aliran data. Menggunakan aset sebagai sumber hanya tersedia dalam pengalaman operasi.

Di bawah Detail sumber, pilih Aset.

Pilih aset yang ingin Anda gunakan sebagai titik akhir sumber.

Pilih Lanjutkan.

Daftar titik data untuk aset yang dipilih ditampilkan.

Pilih Terapkan untuk menggunakan aset sebagai titik akhir sumber.

Saat menggunakan aset sebagai sumber, definisi aset digunakan untuk menyimpulkan skema untuk aliran data. Definisi aset mencakup skema untuk titik data aset. Untuk mempelajari selengkapnya, lihat Mengelola konfigurasi aset dari jarak jauh.

Setelah dikonfigurasi, data dari aset mencapai aliran data melalui broker MQTT lokal. Jadi, saat menggunakan aset sebagai sumber, aliran data menggunakan titik akhir default broker MQTT lokal sebagai sumber dalam aktualitas.

Opsi 3: Gunakan titik akhir aliran data MQTT atau Kafka kustom sebagai sumber

Jika Anda membuat titik akhir aliran data MQTT atau Kafka kustom (misalnya, untuk digunakan dengan Event Grid atau Event Hubs), Anda dapat menggunakannya sebagai sumber untuk aliran data. Ingat bahwa titik akhir jenis penyimpanan, seperti Data Lake atau Fabric OneLake, tidak dapat digunakan sebagai sumber.

Di bawah Detail sumber, pilih Pengelola Pesan.

Masukkan pengaturan berikut untuk sumber broker pesan:

Pengaturan Deskripsi Titik akhir aliran data Gunakan tombol Pilih kembali untuk memilih titik akhir aliran data MQTT atau Kafka kustom. Untuk informasi selengkapnya, lihat Mengonfigurasi titik akhir aliran data MQTT atau Mengonfigurasi Azure Event Hubs dan titik akhir aliran data Kafka. Topik Filter topik untuk berlangganan pesan masuk. Gunakan Topik> Tambahkan baris untuk menambahkan beberapa topik. Untuk informasi selengkapnya tentang topik, lihat Mengonfigurasi topik MQTT atau Kafka. Skema pesan Skema yang digunakan untuk mendeserialisasi pesan masuk. Lihat Menentukan skema untuk mendeserialisasi data. Pilih Terapkan.

Mengonfigurasi sumber data (topik MQTT atau Kafka)

Anda dapat menentukan beberapa topik MQTT atau Kafka dalam sumber tanpa perlu memodifikasi konfigurasi titik akhir aliran data. Fleksibilitas ini berarti titik akhir yang sama dapat digunakan kembali di beberapa aliran data, bahkan jika topik bervariasi. Untuk informasi selengkapnya, lihat Menggunakan kembali titik akhir aliran data.

Topik MQTT

Saat sumbernya adalah titik akhir MQTT, termasuk Event Grid, Anda dapat menggunakan filter topik MQTT guna berlangganan pesan masuk. Filter topik dapat menyertakan karakter pengganti untuk berlangganan beberapa topik. Misalnya, thermostats/+/sensor/temperature/# berlangganan semua pesan sensor suhu dari termostat. Untuk mengonfigurasi filter topik MQTT:

Dalam aliran data pengalaman operasi Detail sumber, pilih Perantara Pesan, lalu gunakan kolom Topik untuk menentukan filter topik MQTT untuk berlangganan pesan yang masuk. Anda dapat menambahkan beberapa topik MQTT dengan memilih Tambahkan baris dan memasukkan topik baru.

Langganan bersama

Untuk menggunakan langganan bersama dengan sumber broker pesan, Anda dapat menentukan topik langganan bersama dalam bentuk $shared/<GROUP_NAME>/<TOPIC_FILTER>.

Dalam aliran data pengalaman operasi Detail sumber, pilih Broker pesan dan gunakan bidang Topik untuk menentukan grup langganan bersama dan topik.

Jika jumlah instans di profil aliran data lebih besar dari satu, langganan bersama secara otomatis diaktifkan untuk semua aliran data yang menggunakan sumber perantara pesan. Dalam hal ini, awalan $shared ditambahkan dan nama grup langganan bersama dibuat secara otomatis. Misalnya, jika Anda memiliki profil aliran data dengan jumlah instans sebanyak 3, dan aliran data Anda menggunakan titik akhir broker pesan sebagai sumber yang dikonfigurasi dengan topik topic1 dan topic2, mereka secara otomatis dikonversi ke langganan bersama sebagai $shared/<GENERATED_GROUP_NAME>/topic1 dan $shared/<GENERATED_GROUP_NAME>/topic2.

Anda dapat secara eksplisit membuat topik bernama $shared/mygroup/topic dalam konfigurasi Anda. Namun, menambahkan $shared topik secara eksplisit tidak disarankan karena awalan $shared ditambahkan secara otomatis saat diperlukan. Aliran data dapat melakukan pengoptimalan dengan nama grup jika belum ditetapkan. Misalnya, $share tidak diatur dan aliran data hanya harus beroperasi melalui nama topik.

Penting

Aliran data yang memerlukan langganan bersama ketika jumlah instans lebih dari satu sangat penting saat menggunakan Azure Event Grid MQTT broker sebagai sumber karena tidak mendukung langganan bersama. Untuk menghindari pesan yang hilang, atur jumlah instans profil aliran data menjadi satu saat menggunakan broker Azure Event Grid MQTT sebagai sumbernya. Ini berarti ketika aliran data berperan sebagai pelanggan dan menerima pesan dari cloud.

Topik Kafka

Ketika sumbernya adalah titik akhir Kafka (termasuk Azure Event Hubs), tentukan topik Kafka individu untuk berlangganan pesan masuk. Wildcard tidak didukung, jadi Anda harus menentukan setiap topik dengan cara statis.

Catatan

Saat menggunakan Event Hubs melalui titik akhir Kafka, setiap hub peristiwa individual pada namespace adalah topik Kafka. Misalnya, jika Anda memiliki namespace Layanan Pusat Aktivitas dengan dua hub peristiwa, thermostats dan humidifiers, Anda dapat menentukan setiap hub peristiwa sebagai topik Kafka.

Untuk mengonfigurasi topik Kafka:

Dalam pengalaman operasi aliran data detail sumber, pilih broker pesan, lalu gunakan bidang topik untuk menentukan filter topik Kafka untuk berlangganan pesan masuk.

Catatan

Hanya satu filter topik yang dapat ditentukan dalam pengalaman operasi. Untuk menggunakan beberapa filter topik, gunakan Bicep atau Kubernetes.

Tentukan skema sumber

Saat menggunakan MQTT atau Kafka sebagai sumbernya, Anda dapat menentukan skema untuk menampilkan daftar titik data dalam antarmuka pengguna web pengalaman operasi. Menggunakan skema untuk mendeserialisasi dan memvalidasi pesan masuk saat ini tidak didukung.

Jika sumber adalah aset, skema secara otomatis disimpulkan dari definisi aset.

Tips

Untuk menghasilkan skema dari file data sampel, gunakan Schema Gen Helper.

Untuk mengonfigurasi skema yang digunakan untuk mendeserialisasi pesan masuk dari sumber:

Dalam pengalaman operasi aliran data Detail sumber, pilih Broker pesan dan gunakan bidang Skema pesan untuk menentukan skema. Anda dapat menggunakan tombol Unggah untuk mengunggah file skema terlebih dahulu. Untuk mempelajari selengkapnya, lihat Memahami skema pesan.

Untuk mempelajari selengkapnya, lihat Memahami skema pesan.

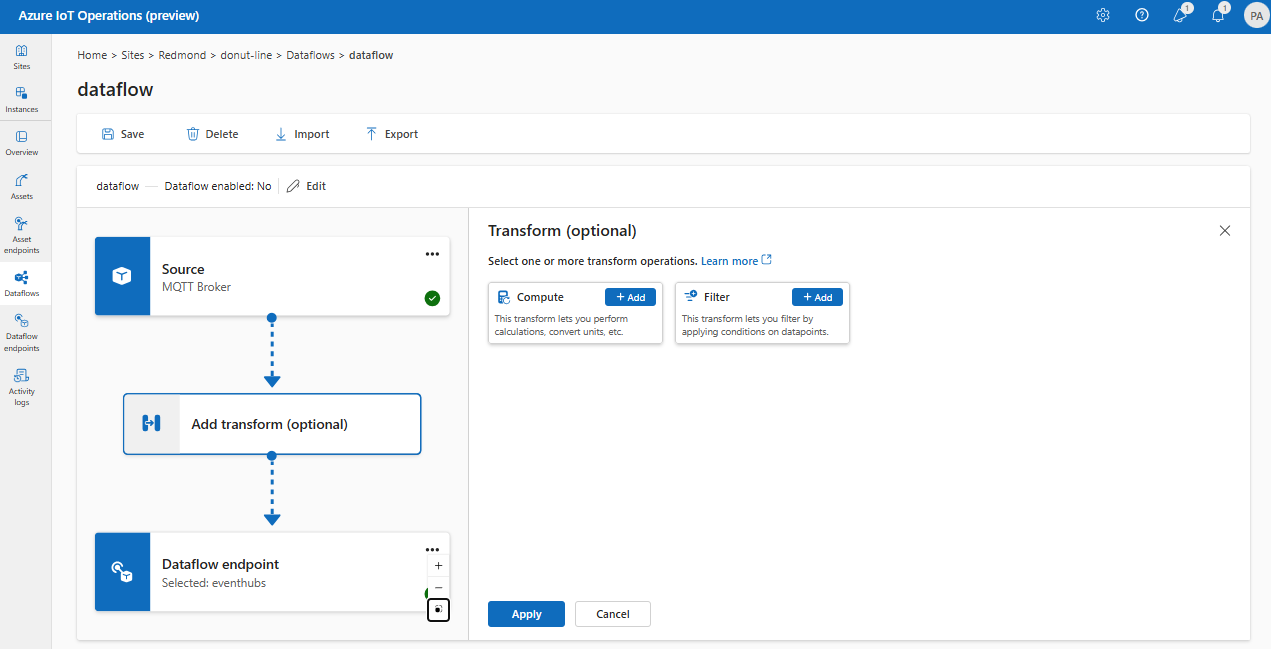

Transformasi

Operasi transformasi adalah tempat Anda dapat mengubah data dari sumber sebelum mengirimkannya ke tujuan. Transformasi bersifat opsional. Jika Anda tidak perlu membuat perubahan pada data, jangan sertakan operasi transformasi dalam konfigurasi aliran data. Beberapa transformasi dirantai bersama-sama secara bertahap terlepas dari urutan yang ditentukan dalam konfigurasi. Urutan tahapan selalu:

- Pengayaan: Tambahkan data tambahan ke data sumber yang diberi himpunan data dan kondisi yang cocok.

- Filter: Memfilter data berdasarkan kondisi.

- Peta, Komputasi, Ganti Nama, atau tambahkan properti Baru: Pindahkan data dari satu bidang ke bidang lain dengan konversi opsional.

Bagian ini adalah pengenalan transformasi aliran data. Untuk informasi selengkapnya, lihat Memetakan data dengan menggunakan aliran data, Mengonversi data dengan menggunakan konversi aliran data, dan Memperkaya data dengan menggunakan aliran data.

Dalam pengalaman operasi, pilih Aliran data>Tambahkan transformasi (opsional).

Pengayaan: Menambahkan data referensi

Untuk memperkaya data, pertama-tama tambahkan himpunan data referensi di penyimpanan keadaan Operasi Azure IoT. Himpunan data digunakan untuk menambahkan data tambahan ke data sumber berdasarkan kondisi. Kondisi ditentukan sebagai bidang dalam data sumber yang cocok dengan bidang dalam himpunan data.

Anda dapat memuat data sampel ke penyimpanan status dengan menggunakan CLI penyimpanan status. Nama kunci di penyimpanan status sesuai dengan himpunan data dalam konfigurasi aliran data.

Saat ini, tahap Pengayaan tidak didukung dalam pengalaman operasi.

Jika himpunan data mempunyai catatan pada bidang asset, mirip dengan:

{

"asset": "thermostat1",

"location": "room1",

"manufacturer": "Contoso"

}

Data dari sumber dengan bidang yang sesuai deviceId dan thermostat1 memiliki bidang location dan manufacturer yang tersedia dalam tahap filter dan pemetaan.

Untuk informasi selengkapnya tentang sintaks kondisi, lihat Memperkaya data dengan menggunakan aliran data dan Mengonversi data menggunakan aliran data.

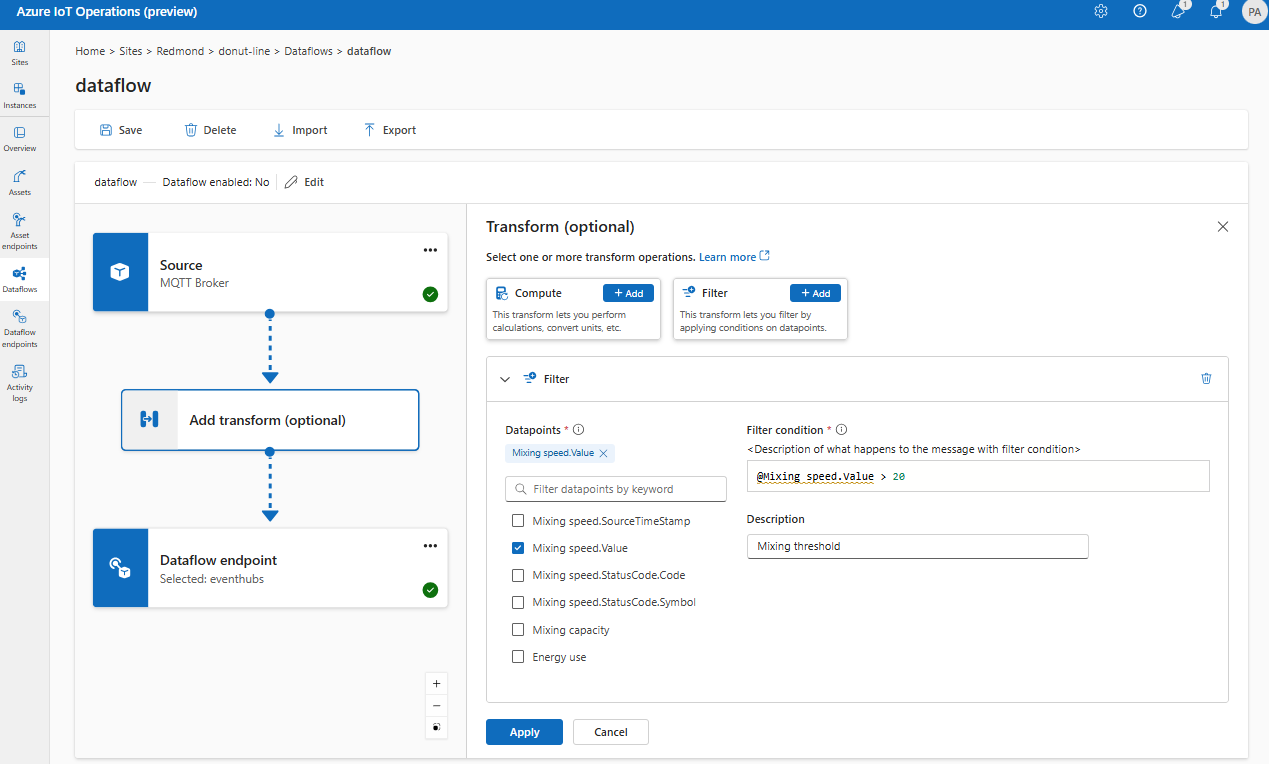

Filter: Memfilter data berdasarkan kondisi

Untuk memfilter data pada kondisi, Anda dapat menggunakan tahapan filter . Kondisi ditentukan sebagai bidang dalam data sumber yang cocok dengan nilai.

Di bawah Transformasi (opsional), pilih Filter>Tambahkan.

Masukkan pengaturan yang diperlukan.

Pengaturan Deskripsi Kondisi filter Kondisi untuk memfilter data berdasarkan bidang dalam data sumber. Deskripsi Berikan deskripsi untuk kondisi filter. Di bidang kondisi filter, masukkan

@atau pilih Ctrl + Spasi untuk memilih titik data dari menu dropdown.Anda dapat memasukkan properti metadata MQTT menggunakan format

@$metadata.user_properties.<property>atau@$metadata.topic. Anda juga dapat memasukkan header $metadata menggunakan format@$metadata.<header>. Sintaks$metadatahanya diperlukan untuk properti MQTT yang merupakan bagian dari header pesan. Untuk informasi selengkapnya, lihat referensi bidang.Kondisi dapat memanfaatkan kolom dalam data sumber. Misalnya, Anda dapat menggunakan kondisi filter seperti

@temperature > 20memfilter data kurang dari atau sama dengan 20 berdasarkan bidang suhu.Pilih Terapkan.

Peta: Memindahkan data dari satu bidang ke bidang lainnya

Untuk memetakan data ke bidang lain dengan konversi opsional, Anda dapat menggunakan operasi.map Konversi ditentukan sebagai rumus yang menggunakan bidang dalam data sumber.

Dalam pengalaman operasi, pemetaan saat ini didukung menggunakan Komputasi, Ganti Nama, dan properti baru transformasi.

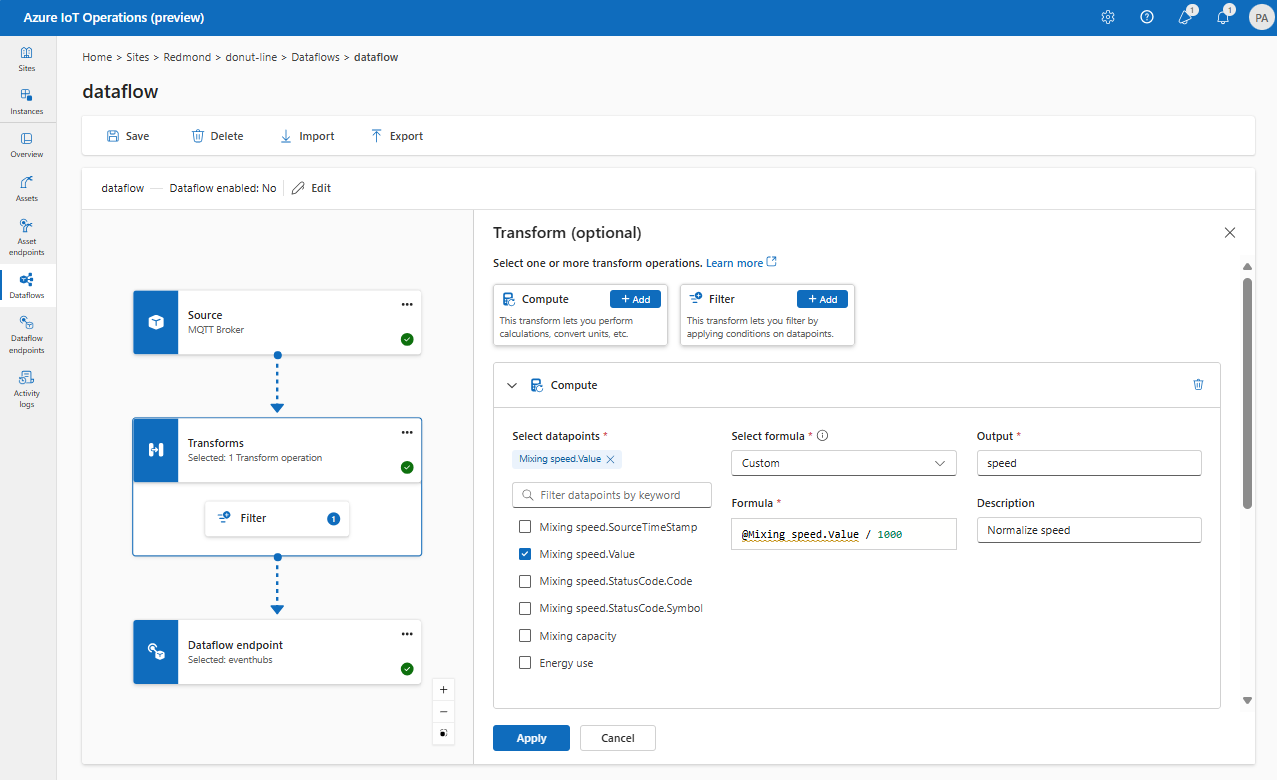

Komputasi

Anda bisa menggunakan transformasi Komputasi untuk menerapkan rumus ke data sumber. Operasi ini digunakan untuk menerapkan rumus ke data sumber dan menyimpan bidang hasil.

Di bawah Transformasi (opsional), pilih Tambahkan Komputasi>.

Masukkan pengaturan yang diperlukan.

Pengaturan Deskripsi Pilih rumus Pilih rumus yang sudah ada dari menu dropdown atau pilih Kustom untuk memasukkan rumus secara manual. Keluaran Tentukan nama tampilan output untuk hasilnya. Rumus Masukkan rumus yang akan diterapkan ke data sumber. Deskripsi Berikan deskripsi untuk transformasi. Nilai terakhir diketahui Secara opsional, gunakan nilai terakhir yang diketahui jika nilai saat ini tidak tersedia. Anda bisa memasukkan atau mengedit rumus di bidang Rumus . Rumus dapat menggunakan bidang dalam data sumber. Masukkan

@atau pilih Ctrl + Spasi untuk memilih titik data dari menu dropdown. Untuk rumus bawaan, pilih tempat penampung<dataflow>untuk melihat daftar titik data yang tersedia.Anda dapat memasukkan properti metadata MQTT menggunakan format

@$metadata.user_properties.<property>atau@$metadata.topic. Anda juga dapat memasukkan header $metadata menggunakan format@$metadata.<header>. Sintaks$metadatahanya diperlukan untuk properti MQTT yang merupakan bagian dari header pesan. Untuk informasi selengkapnya, lihat referensi bidang.Rumus dapat menggunakan bidang dalam data sumber. Misalnya, Anda dapat menggunakan

temperaturebidang dalam data sumber untuk mengonversi suhu ke Celcius dan menyimpannya ditemperatureCelsiusbidang output.Pilih Terapkan.

Ubah nama

Anda dapat mengganti nama titik data menggunakan transformasi Ganti Nama . Operasi ini digunakan untuk mengganti nama titik data dalam data sumber menjadi nama baru. Nama baru dapat digunakan dalam tahap berikutnya dari aliran data.

Di bawah Transformasi (opsional), pilih Ganti Nama>Tambahkan.

Masukkan pengaturan yang diperlukan.

Pengaturan Deskripsi Titik data Pilih titik data dari menu dropdown atau masukkan header $metadata. Nama titik data baru Masukkan nama baru untuk titik data. Deskripsi Berikan deskripsi untuk transformasi. Anda dapat memasukkan properti metadata MQTT menggunakan format

@$metadata.user_properties.<property>atau@$metadata.topic. Anda juga dapat memasukkan header $metadata menggunakan format@$metadata.<header>. Sintaks$metadatahanya diperlukan untuk properti MQTT yang merupakan bagian dari header pesan. Untuk informasi selengkapnya, lihat referensi bidang.Pilih Terapkan.

Properti baru

Anda dapat menambahkan properti baru ke data sumber menggunakan transformasi properti Baru. Operasi ini digunakan untuk menambahkan properti baru ke data sumber. Properti baru ini dapat digunakan pada tahap-tahap selanjutnya dari aliran data.

Di bawah Transformasi (opsional), pilih Tambahkan properti>baru.

Masukkan pengaturan yang diperlukan.

Pengaturan Deskripsi Kunci properti Masukkan kunci untuk properti baru. Nilai properti Masukkan nilai untuk properti baru. Deskripsi Berikan deskripsi untuk properti baru. Pilih Terapkan.

Untuk mempelajari selengkapnya, lihat Memetakan data dengan menggunakan aliran data dan Mengonversi data dengan menggunakan aliran data.

Hapus

Secara default, semua titik data disertakan dalam skema output. Anda dapat menghapus titik data apa pun dari tujuan menggunakan transformasi Hapus .

Di bawah Transformasi (opsional), pilih Hapus.

Pilih titik data yang akan dihapus dari skema output.

Pilih Terapkan.

Untuk mempelajari selengkapnya, lihat Memetakan data dengan menggunakan aliran data dan Mengonversi data dengan menggunakan aliran data.

Menserialisasikan data sesuai dengan skema

Jika Anda ingin membuat serialisasi data sebelum mengirimkannya ke tujuan, Anda perlu menentukan format skema dan serialisasi. Jika tidak, data diserialisasikan di JSON dengan jenis yang disimpulkan. Titik akhir penyimpanan seperti Microsoft Fabric atau Azure Data Lake memerlukan skema untuk memastikan konsistensi data. Format serialisasi yang didukung adalah Parquet dan Delta.

Tips

Untuk menghasilkan skema dari file data sampel, gunakan Schema Gen Helper.

Untuk pengalaman operasi, Anda menentukan format skema dan serialisasi dalam detail titik akhir aliran data. Titik akhir yang mendukung format serialisasi adalah Microsoft Fabric OneLake, Azure Data Lake Storage Gen 2, Azure Data Explorer, dan penyimpanan lokal. Misalnya, untuk membuat serialisasi data dalam format Delta, Anda perlu mengunggah skema ke registri skema dan mereferensikannya dalam konfigurasi titik akhir tujuan aliran data.

Untuk informasi selengkapnya tentang registri skema, lihat Memahami skema pesan.

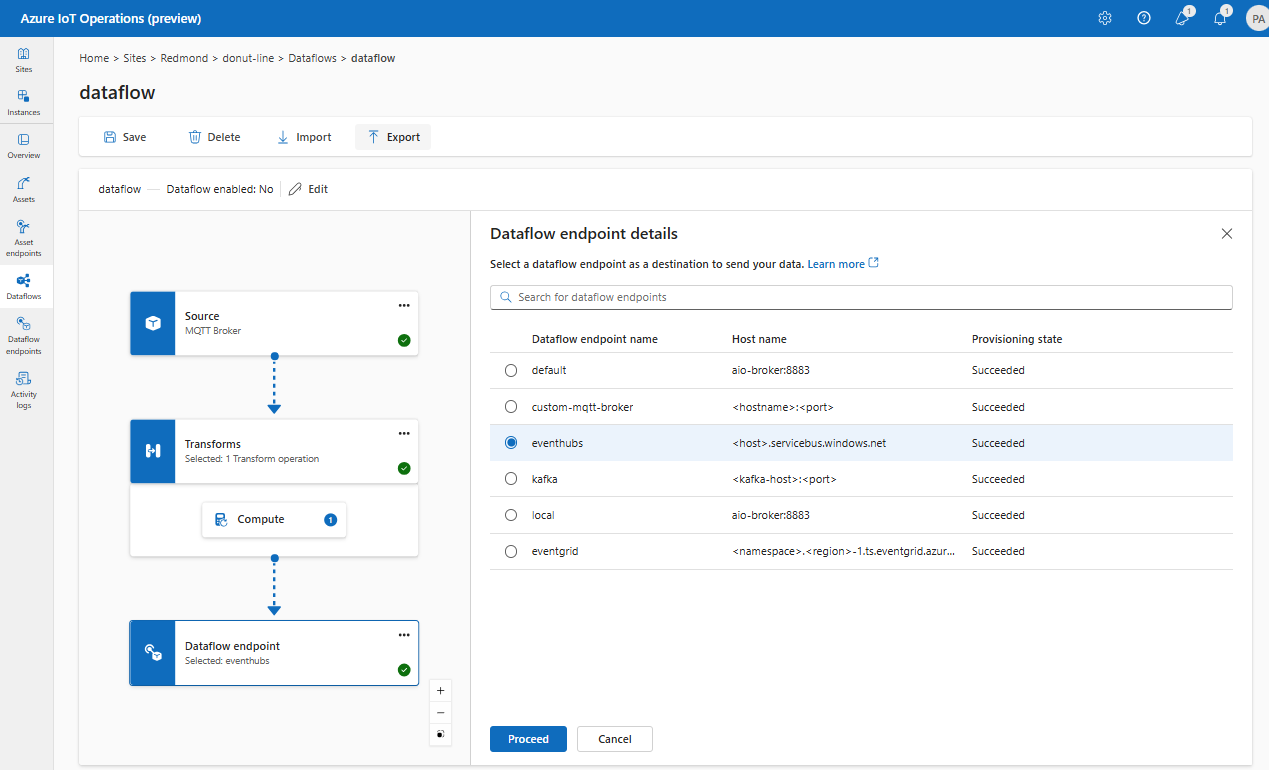

Tujuan

Untuk mengonfigurasi tujuan aliran data, tentukan referensi titik akhir dan tujuan data. Anda dapat menentukan daftar tujuan data untuk titik akhir.

Untuk mengirim data ke tujuan selain broker MQTT lokal, buat titik akhir aliran data. Untuk mempelajari caranya, lihat Mengonfigurasi titik akhir aliran data. Jika tujuan bukan broker MQTT lokal, tujuan harus digunakan sebagai sumber. Untuk mempelajari selengkapnya tentang menggunakan titik akhir broker MQTT lokal, lihat Aliran data harus menggunakan titik akhir broker MQTT lokal.

Penting

Titik akhir penyimpanan memerlukan skema untuk serialisasi. Untuk menggunakan aliran data dengan Microsoft Fabric OneLake, Azure Data Lake Storage, Azure Data Explorer, atau Penyimpanan Lokal, Anda harus menentukan referensi skema.

Pilih titik akhir aliran data untuk digunakan sebagai tujuan.

Titik akhir penyimpanan memerlukan skema untuk serialisasi. Jika Anda memilih titik akhir tujuan Microsoft Fabric OneLake, Azure Data Lake Storage, Azure Data Explorer, atau Penyimpanan Lokal, Anda harus menentukan referensi skema. Misalnya, untuk menserialisasikan data ke titik akhir Microsoft Fabric dalam format Delta, Anda perlu mengunggah skema ke registri skema dan mereferensikannya dalam konfigurasi titik akhir tujuan aliran data.

Pilih Lanjutkan untuk mengonfigurasi tujuan.

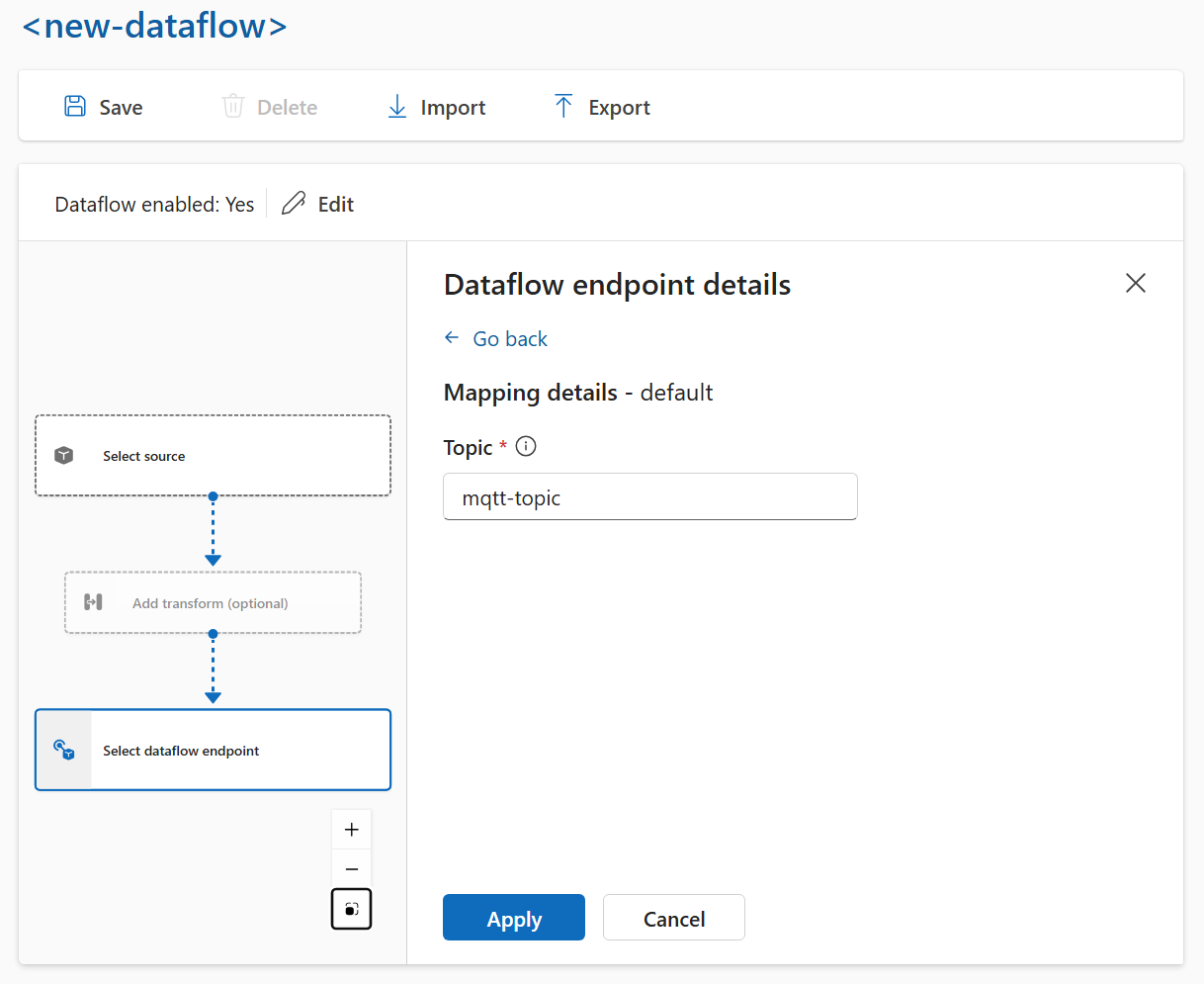

Masukkan pengaturan yang diperlukan untuk tujuan, termasuk topik atau tabel untuk mengirim data. Lihat Mengonfigurasi tujuan data (topik, kontainer, atau tabel) untuk informasi selengkapnya.

Mengonfigurasi tujuan data (topik, kontainer, atau tabel)

Mirip dengan sumber data, tujuan data adalah konsep yang digunakan untuk menjaga titik akhir aliran data dapat digunakan kembali di beberapa aliran data. Pada dasarnya, ini mewakili subdirektori dalam konfigurasi titik akhir aliran data. Misalnya, jika titik akhir aliran data adalah titik akhir penyimpanan, tujuan data adalah tabel di akun penyimpanan. Jika titik akhir aliran data adalah titik akhir Kafka, tujuan data adalah topik Kafka.

| Jenis titik akhir | Arti tujuan data | Deskripsi |

|---|---|---|

| MQTT (atau Event Grid) | Topik | Topik MQTT tempat data dikirim. Hanya topik statis yang didukung, tidak ada kartubebas. |

| Kafka (atau Event Hubs) | Topik | Topik Kafka tempat data dikirim. Hanya topik statis yang didukung, tidak ada kartubebas. Jika titik akhir adalah namespace Event Hubs, tujuan data adalah hub peristiwa individual dalam namespace tersebut. |

| Azure Data Lake Storage | Kontainer | Kontainer di akun penyimpanan. Bukan meja. |

| Microsoft Fabric OneLake | Tabel atau Folder | Sesuai dengan jenis jalur yang dikonfigurasi untuk endpoint. |

| Azure Data Explorer (layanan pencarian data) | Tabel | Tabel dalam database Azure Data Explorer. |

| Penyimpanan Lokal | Map | Nama folder atau direktori dalam pemasangan volume penyimpanan lokal yang persisten. Saat menggunakan Azure Container Storage yang diaktifkan oleh Azure Arc Cloud Ingest Edge Volumes, ini harus sesuai dengan parameter spec.path untuk subvolume yang Anda buat. |

Untuk mengonfigurasi tujuan data:

Saat menggunakan pengalaman operasi, bidang tujuan data secara otomatis ditafsirkan berdasarkan jenis titik akhir. Misalnya, jika titik akhir aliran data adalah titik akhir penyimpanan, halaman detail tujuan meminta Anda untuk memasukkan nama kontainer. Jika titik akhir aliran data adalah titik akhir MQTT, halaman detail tujuan meminta Anda untuk memasukkan topik, dan sebagainya.

Contoh

Contoh berikut adalah konfigurasi aliran data yang menggunakan titik akhir MQTT untuk sumber dan tujuan. Sumber memfilter data dari topik azure-iot-operations/data/thermostatMQTT . Transformasi mengonversi suhu menjadi Fahrenheit dan memfilter data di mana suhu dikalikan dengan kelembaban kurang dari 100000. Tujuan mengirimkan data ke topik factoryMQTT .

Untuk melihat lebih banyak contoh konfigurasi aliran data, lihat Azure REST API - Aliran data dan panduan mulai cepat Bicep.

Memverifikasi aliran data berfungsi

Ikuti Tutorial: Jembatan MQTT dua arah ke Azure Event Grid untuk memverifikasi aliran data berfungsi.

Mengekspor konfigurasi aliran data

Untuk mengekspor konfigurasi aliran data, Anda dapat menggunakan pengalaman operasi atau dengan mengekspor sumber daya kustom aliran data.

Pilih aliran data yang ingin Anda ekspor dan pilih Ekspor dari toolbar.

Konfigurasi aliran data yang tepat

Untuk memastikan aliran data berfungsi seperti yang diharapkan, verifikasi hal berikut:

- Titik akhir aliran data MQTT default harus digunakan sebagai sumber atau tujuan.

- Profil aliran data ada dan dirujuk dalam konfigurasi aliran data.

- Sumber adalah titik akhir MQTT, titik akhir Kafka, atau aset. Titik akhir jenis penyimpanan tidak dapat digunakan sebagai sumber.

- Saat menggunakan Event Grid sebagai sumbernya, jumlah instans profil dataflow diatur ke 1 karena broker MQTT Event Grid tidak mendukung langganan bersama.

- Saat menggunakan Azure Event Hubs sebagai sumber, setiap hub peristiwa di namespace adalah topik Kafka terpisah dan harus ditentukan sebagai sumber data.

- Transformasi, jika digunakan, dikonfigurasi dengan sintaks yang tepat, termasuk penyertaan karakter khusus yang tepat.

- Saat menggunakan titik akhir jenis penyimpanan sebagai tujuan, skema ditentukan.