Ketersediaan tinggi peningkatan skala SAP Hana dengan Azure NetApp Files di RHEL

Artikel ini menjelaskan cara mengonfigurasi Replikasi Sistem SAP Hana dalam penyebaran peningkatan skala, ketika sistem file HANA dipasang melalui NFS, dengan menggunakan Azure NetApp Files. Dalam contoh konfigurasi dan perintah penginstalan, nomor instans 03 dan ID Sistem HANA HN1 digunakan. Replikasi Sistem SAP Hana terdiri dari satu simpul utama dan setidaknya satu simpul sekunder.

Ketika langkah-langkah dalam dokumen ini ditandai dengan awalan berikut, artinya adalah sebagai berikut:

- [A]: Langkah ini berlaku untuk semua node

- [1]: Langkah ini hanya berlaku untuk node1

- [2]: Langkah ini hanya berlaku untuk node2

Prasyarat

Baca makalah dan Catatan SAP berikut terlebih dahulu:

- 1928533 Catatan SAP, yang memiliki:

- Daftar ukuran komputer virtual (VM) Azure yang didukung untuk penyebaran perangkat lunak SAP.

- Informasi kapasitas penting untuk ukuran komputer virtual Azure.

- Kombinasi perangkat lunak dan sistem operasi (OS) dan database SAP yang didukung.

- Versi kernel SAP yang diperlukan untuk Windows dan Linux di Microsoft Azure.

- Catatan SAP 2015553 mencantumkan prasyarat untuk penyebaran perangkat lunak SAP yang didukung SAP di Azure.

- Catatan SAP 405827 mencantumkan sistem file yang direkomendasikan untuk lingkungan HANA.

- Catatan SAP 2002167 telah merekomendasikan pengaturan OS untuk Red Hat Enterprise Linux.

- Catatan SAP 2009879 memiliki Pedoman SAP HANA untuk Red Hat Enterprise Linux.

- Catatan SAP 3108302 memiliki Panduan SAP Hana untuk Red Hat Enterprise Linux 9.x.

- Catatan SAP 2178632 memiliki informasi rinci tentang semua metrik pemantauan yang dilaporkan untuk SAP pada Azure.

- SAP Note 2191498 memiliki versi Agen Host SAP yang diperlukan untuk Linux di Azure.

- Catatan SAP 2243692 memiliki informasi tentang lisensi SAP di Linux pada Azure.

- Catatan SAP 1999351 memiliki lebih banyak informasi pemecahan masalah bagi ekstensi Azure Enhanced Monitoring untuk SAP.

- SAP Community Wiki memiliki semua Catatan SAP yang diperlukan untuk Linux.

- Microsoft Azure Virtual Machines perencanaan dan penerapan untuk SAP di Linux

- Azure Virtual Machines penyebaran untuk SAP pada Linux

- Penyebaran Azure Virtual Machines DBMS untuk SAP pada Linux

- Replikasi sistem SAP Hana di kluster Pacemaker

- Dokumentasi Umum Red Hat Enterprise Linux (RHEL):

- Dokumentasi RHEL khusus Azure:

- Kebijakan Dukungan untuk Kluster Ketersediaan Tinggi RHEL - Microsoft Azure Virtual Machines sebagai Anggota Kluster

- Memasang dan Mengonfigurasikan Red Hat Enterprise Linux 7.4 (dan yang lebih baru) Ketersediaan Tinggi Kluster pada Microsoft Azure

- Mengonfigurasi replikasi sistem peningkatan SAP Hana di kluster Pacemaker saat sistem file HANA berada di berbagi NFS

- Volume NFS v4.1 di Azure NetApp Files untuk SAP Hana

Gambaran Umum

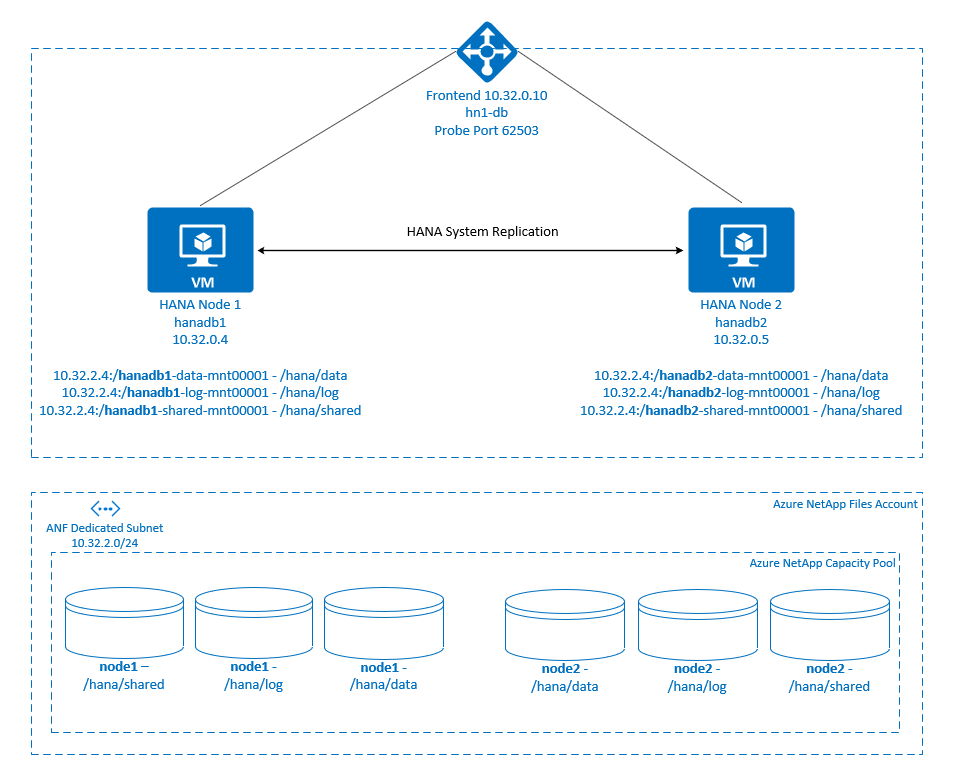

Secara tradisional dalam lingkungan peningkatan skala, semua sistem file untuk SAP Hana dipasang dari penyimpanan lokal. Menyiapkan ketersediaan tinggi (HA) Replikasi Sistem SAP Hana di Red Hat Enterprise Linux diterbitkan dalam Menyiapkan Replikasi Sistem SAP Hana di RHEL.

Untuk mencapai SAP Hana HA dari sistem peningkatan skala pada berbagi NFS Azure NetApp Files , kita memerlukan beberapa konfigurasi sumber daya lagi di kluster, agar sumber daya HANA pulih, ketika satu simpul kehilangan akses ke berbagi NFS di Azure NetApp Files. Klaster ini mengelola pemasangan NFS, memungkinkannya untuk memantau kesehatan sumber daya. Ketergantungan antara pemasangan sistem file dan sumber daya SAP HANA diberlakukan.

.

.

Sistem file SAP Hana dipasang pada berbagi NFS dengan menggunakan Azure NetApp Files pada setiap simpul. Sistem file /hana/data, /hana/log, dan /hana/shared unik untuk setiap simpul.

Dipasang pada node1 (hanadb1):

- 10.32.2.4:/hanadb1-data-mnt00001 on /hana/data

- 10.32.2.4:/hanadb1-log-mnt00001 on /hana/log

- 10.32.2.4:/hanadb1-shared-mnt00001 on /hana/shared

Dipasang pada node2 (hanadb2):

- 10.32.2.4:/hanadb2-data-mnt00001 on /hana/data

- 10.32.2.4:/hanadb2-log-mnt00001 on /hana/log

- 10.32.2.4:/hanadb2-shared-mnt00001 on /hana/shared

Catatan

Sistem file /hana/shared, /hana/data, dan /hana/log tidak dibagi antara dua simpul. Setiap node kluster memiliki sistem file terpisah sendiri.

Konfigurasi Replikasi Sistem SAP HANA menggunakan nama host virtual khusus dan alamat IP virtual. Pada Azure, penyeimbang muatan diperlukan untuk menggunakan alamat IP virtual. Konfigurasi yang ditampilkan di sini memiliki load balancer dengan:

- Alamat IP front-end: 10.32.0.10 untuk hn1-db

- Port probe: 62503

Menyiapkan infrastruktur Azure NetApp Files

Sebelum Anda melanjutkan penyiapan untuk infrastruktur Azure NetApp Files, biasakan diri Anda dengan dokumentasi Azure NetApp Files.

Azure NetApp Files tersedia di beberapa wilayah Azure. Periksa untuk melihat apakah wilayah Azure yang Anda pilih menawarkan Azure NetApp Files.

Untuk informasi tentang ketersediaan Azure NetApp Files menurut wilayah Azure, lihat Ketersediaan Azure NetApp Files menurut wilayah Azure.

Pertimbangan penting

Saat Anda membuat volume Azure NetApp Files untuk sistem peningkatan skala SAP Hana, ketahui pertimbangan penting yang didokumentasikan dalam volume NFS v4.1 di Azure NetApp Files untuk SAP Hana.

Ukuran database HANA pada Azure NetApp Files

Throughput volume Azure NetApp Files adalah fungsi dari ukuran volume dan tingkat layanan, seperti yang didokumentasikan dalam Tingkat layanan untuk Azure NetApp Files.

Saat Anda merancang infrastruktur untuk SAP Hana di Azure dengan Azure NetApp Files, ketahui rekomendasi dalam volume NFS v4.1 di Azure NetApp Files untuk SAP Hana.

Konfigurasi dalam artikel ini disajikan dengan volume Azure NetApp Files sederhana.

Penting

Untuk sistem produksi, di mana performa adalah kunci, kami sarankan Anda mengevaluasi dan mempertimbangkan untuk menggunakan grup volume aplikasi Azure NetApp Files untuk SAP Hana.

Sebarkan sumber daya Azure NetApp Files

Instruksi berikut mengasumsikan bahwa Anda sudah menyebarkan jaringan virtual Azure Anda. Sumber daya dan VM Azure NetApp Files, di mana sumber daya Azure NetApp Files akan dipasang, harus disebarkan di jaringan virtual Azure yang sama atau di jaringan virtual Azure yang diserekan.

Buat akun NetApp di wilayah Azure pilihan Anda dengan mengikuti instruksi di Buat akun NetApp.

Siapkan kumpulan kapasitas Azure NetApp Files dengan mengikuti instruksi pada Menyiapkan kumpulan kapasitas Azure NetApp Files.

Arsitektur HANA yang ditunjukkan dalam artikel ini menggunakan satu kumpulan kapasitas Azure NetApp Files di tingkat layanan Ultra . Untuk beban kerja HANA di Azure, sebaiknya gunakan Azure NetApp Files Ultra atau Premium untuk tingkat layanannya.

Delegasikan subnet ke Azure NetApp Files, seperti yang dijelaskan dalam instruksi di Mendelegasikan subnet ke Azure NetApp Files.

Sebarkan volume Azure NetApp Files dengan mengikuti instruksi pada Membuat volume NFS untuk Azure NetApp Files.

Saat Anda menyebarkan volume, pastikan untuk memilih versi NFSv4.1. Sebarkan volume di subnet Azure NetApp Files yang ditunjuk. Alamat IP volume Azure NetApp ditetapkan secara otomatis.

Perlu diingat bahwa sumber daya Azure NetApp Files dan VM Azure harus berada di jaringan virtual Azure yang sama atau di jaringan virtual Azure yang diserekan. Misalnya,

hanadb1-data-mnt00001danhanadb1-log-mnt00001merupakan nama volume dannfs://10.32.2.4/hanadb1-data-mnt00001dannfs://10.32.2.4/hanadb1-log-mnt00001merupakan jalur file untuk volume Azure NetApp Files.Pada hanadb1:

- Volume hanadb1-data-mnt00001 (nfs://10.32.2.4:/hanadb1-data-mnt00001)

- Volume hanadb1-log-mnt00001 (nfs://10.32.2.4:/hanadb1-log-mnt00001)

- Volume hanadb1-shared-mnt00001 (nfs://10.32.2.4:/hanadb1-shared-mnt00001)

Pada hanadb2:

- Volume hanadb2-data-mnt00001 (nfs://10.32.2.4:/hanadb2-data-mnt00001)

- Volume hanadb2-log-mnt00001 (nfs://10.32.2.4:/hanadb2-log-mnt00001)

- Volume hanadb2-shared-mnt00001 (nfs://10.32.2.4:/hanadb2-shared-mnt00001)

Catatan

Semua perintah untuk dipasang /hana/shared dalam artikel ini disajikan untuk volume NFSv4.1 /hana/shared .

Jika Anda menyebarkan /hana/shared volume sebagai volume NFSv3, jangan lupa untuk menyesuaikan perintah pemasangan untuk /hana/shared NFSv3.

Siapkan infrastruktur

Marketplace Azure berisi gambar yang memenuhi syarat untuk SAP Hana dengan add-on Ketersediaan Tinggi, yang dapat Anda gunakan untuk menyebarkan VM baru dengan menggunakan berbagai versi Red Hat.

Menyebarkan VM Linux secara manual melalui portal Azure

Dokumen ini mengasumsikan bahwa Anda telah menyebarkan grup sumber daya, jaringan virtual Azure, dan subnet.

Menyebarkan VM untuk SAP Hana. Pilih gambar RHEL yang sesuai yang didukung untuk sistem HANA. Anda dapat menyebarkan VM di salah satu opsi ketersediaan: set skala komputer virtual, zona ketersediaan, atau set ketersediaan.

Penting

Pastikan BAHWA OS yang Anda pilih bersertifikat SAP untuk SAP Hana pada jenis VM tertentu yang Anda rencanakan untuk digunakan dalam penyebaran Anda. Anda dapat mencari jenis VM bersertifikat SAP Hana dan rilis OS mereka di Platform IaaS Bersertifikat SAP Hana. Pastikan Anda melihat detail jenis VM untuk mendapatkan daftar lengkap rilis OS yang didukung SAP Hana untuk jenis VM tertentu.

Mengonfigurasi load balancer Azure

Selama konfigurasi VM, Anda memiliki opsi untuk membuat atau memilih keluar dari load balancer di bagian jaringan. Ikuti langkah-langkah di bawah ini, untuk menyiapkan load balancer standar untuk penyiapan ketersediaan tinggi database HANA.

Ikuti langkah-langkah dalam Membuat load balancer untuk menyiapkan load balancer standar untuk sistem SAP ketersediaan tinggi dengan menggunakan portal Azure. Selama penyiapan load balancer, pertimbangkan poin-poin berikut:

- Konfigurasi IP Frontend: Buat IP front-end. Pilih jaringan virtual dan nama subnet yang sama dengan komputer virtual database Anda.

- Kumpulan Backend: Buat kumpulan back-end dan tambahkan VM database.

- Aturan masuk: Buat aturan penyeimbangan beban. Ikuti langkah yang sama untuk kedua aturan penyeimbangan beban.

- Alamat IP frontend: Pilih IP front-end.

- Kumpulan backend: Pilih kumpulan back-end.

- Port ketersediaan tinggi: Pilih opsi ini.

- Protokol: Pilih TCP.

- Pemeriksaan Kesehatan: Buat pemeriksaan kesehatan dengan detail berikut:

- Protokol: Pilih TCP.

- Port: Misalnya, 625<instance-no.>.

- Interval: Masukkan 5.

- Ambang Probe: Masukkan 2.

- Batas waktu menganggur (menit): Masukkan 30.

- Aktifkan IP Mengambang: Pilih opsi ini.

Catatan

Properti numberOfProbeskonfigurasi pemeriksaan kesehatan , atau dikenal sebagai Ambang tidak sehat di portal, tidak dihormati. Untuk mengontrol jumlah pemeriksaan berturut-turut yang berhasil atau gagal, atur properti probeThreshold ke 2. Saat ini tidak dimungkinkan untuk mengatur properti ini dengan menggunakan portal Azure, jadi gunakan perintah Azure CLI atau PowerShell.

Untuk informasi selengkapnya tentang port yang diperlukan untuk SAP Hana, baca bab Koneksi ke Database Penyewa di panduan Database Penyewa SAP Hana atau Catatan SAP 2388694.

Catatan

Ketika VM tanpa alamat IP publik ditempatkan di kumpulan back-end instans internal (tanpa alamat IP publik) Azure Load Balancer Standar, tidak ada konektivitas internet keluar, kecuali lebih banyak konfigurasi dilakukan untuk memungkinkan perutean ke titik akhir publik. Untuk informasi selengkapnya tentang cara mencapai konektivitas keluar, lihat Konektivitas titik akhir publik untuk komputer virtual menggunakan Standard Azure Load Balancer dalam skenario ketersediaan tinggi SAP.

Penting

Jangan aktifkan tanda waktu TCP pada VM Azure yang ditempatkan di belakang Azure Load Balancer. Mengaktifkan tanda waktu TCP dapat menyebabkan pemeriksaan kesehatan gagal. Atur parameter net.ipv4.tcp_timestamps ke 0. Untuk informasi selengkapnya, lihat Pemeriksaan kesehatan Load Balancer dan 2382421 Catatan SAP.

Pasang volume Azure NetApp Files

[A] Buat titik pemasangan untuk volume database HANA.

sudo mkdir -p /hana/data sudo mkdir -p /hana/log sudo mkdir -p /hana/shared[A] Verifikasi pengaturan domain NFS. Pastikan bahwa domain dikonfigurasi sebagai domain Azure NetApp Files default, yaitu, defaultv4iddomain.com, dan pemetaan diatur ke tidak ada.

sudo cat /etc/idmapd.confContoh output:

[General] Domain = defaultv4iddomain.com [Mapping] Nobody-User = nobody Nobody-Group = nobodyPenting

Pastikan untuk mengatur domain NFS di

/etc/idmapd.confpada VM agar sesuai dengan konfigurasi domain default di Azure NetApp Files: defaultv4iddomain.com. Jika ada ketidakcocokan antara konfigurasi domain pada klien NFS (yaitu, VM) dan server NFS (yaitu, konfigurasi Azure NetApp Files), maka izin untuk file pada volume Azure NetApp Files yang dipasang pada VM ditampilkan sebagainobody.[1] Pasang volume khusus node pada node1 (hanadb1).

sudo mount -o rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 10.32.2.4:/hanadb1-shared-mnt00001 /hana/shared sudo mount -o rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 10.32.2.4:/hanadb1-log-mnt00001 /hana/log sudo mount -o rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 10.32.2.4:/hanadb1-data-mnt00001 /hana/data[2] Pasang volume khusus node pada node2 (hanadb2).

sudo mount -o rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 10.32.2.4:/hanadb2-shared-mnt00001 /hana/shared sudo mount -o rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 10.32.2.4:/hanadb2-log-mnt00001 /hana/log sudo mount -o rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys 10.32.2.4:/hanadb2-data-mnt00001 /hana/data[A] Verifikasi bahwa semua volume HANA dipasang dengan protokol NFS versi NFSv4.

sudo nfsstat -mVerifikasi bahwa bendera

versdiatur ke 4.1. Contoh dari hanadb1:/hana/log from 10.32.2.4:/hanadb1-log-mnt00001 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.32.0.4,local_lock=none,addr=10.32.2.4 /hana/data from 10.32.2.4:/hanadb1-data-mnt00001 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.32.0.4,local_lock=none,addr=10.32.2.4 /hana/shared from 10.32.2.4:/hanadb1-shared-mnt00001 Flags: rw,noatime,vers=4.1,rsize=262144,wsize=262144,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=10.32.0.4,local_lock=none,addr=10.32.2.4[A] Verifikasi nfs4_disable_idmapping. Ini harus diatur ke Y. Untuk membuat struktur direktori tempat nfs4_disable_idmapping berada, jalankan perintah mount. Anda tidak dapat membuat direktori secara manual karena

/sys/modulesakses dicadangkan untuk kernel dan driver.Periksa

nfs4_disable_idmapping.sudo cat /sys/module/nfs/parameters/nfs4_disable_idmappingJika Anda perlu mengatur

nfs4_disable_idmappingke:sudo echo "Y" > /sys/module/nfs/parameters/nfs4_disable_idmappingBuat konfigurasi permanen.

sudo echo "options nfs nfs4_disable_idmapping=Y" >> /etc/modprobe.d/nfs.confUntuk informasi selengkapnya tentang cara mengubah

nfs_disable_idmappingparameter, lihat Pangkalan Pengetahuan Red Hat.

Penginstalan SAP Hana

[A] Siapkan resolusi nama host untuk semua host.

Anda bisa menggunakan server DNS atau mengubah

/etc/hostsfile pada semua simpul. Contoh ini menunjukkan kepada Anda cara menggunakan/etc/hostsfile. Ganti alamat IP dan nama host dalam perintah berikut:sudo vi /etc/hostsSisipkan baris berikut dalam

/etc/hostsfile. Ubah alamat IP dan nama host agar sesuai dengan lingkungan Anda.10.32.0.4 hanadb1 10.32.0.5 hanadb2[A] Siapkan OS untuk menjalankan SAP Hana di Azure NetApp dengan NFS, seperti yang dijelaskan dalam SAP Note 3024346 - Pengaturan Kernel Linux untuk NetApp NFS. Buat file

/etc/sysctl.d/91-NetApp-HANA.confkonfigurasi untuk pengaturan konfigurasi NetApp.sudo vi /etc/sysctl.d/91-NetApp-HANA.confTambahkan entri berikut dalam file konfigurasi.

net.core.rmem_max = 16777216 net.core.wmem_max = 16777216 net.ipv4.tcp_rmem = 4096 131072 16777216 net.ipv4.tcp_wmem = 4096 16384 16777216 net.core.netdev_max_backlog = 300000 net.ipv4.tcp_slow_start_after_idle=0 net.ipv4.tcp_no_metrics_save = 1 net.ipv4.tcp_moderate_rcvbuf = 1 net.ipv4.tcp_window_scaling = 1 net.ipv4.tcp_sack = 1[A] Buat file

/etc/sysctl.d/ms-az.confkonfigurasi dengan pengaturan pengoptimalan yang lebih banyak.sudo vi /etc/sysctl.d/ms-az.confTambahkan entri berikut dalam file konfigurasi.

net.ipv6.conf.all.disable_ipv6 = 1 net.ipv4.tcp_max_syn_backlog = 16348 net.ipv4.conf.all.rp_filter = 0 sunrpc.tcp_slot_table_entries = 128 vm.swappiness=10Tip

Hindari pengaturan

net.ipv4.ip_local_port_rangedannet.ipv4.ip_local_reserved_portssecara eksplisit dalamsysctlfile konfigurasi untuk memungkinkan Agen Host SAP mengelola rentang port. Untuk informasi selengkapnya, lihat 2382421 Catatan SAP.[A] Sesuaikan pengaturan, seperti yang

sunrpcdirekomendasikan dalam SAP Note 3024346 - Pengaturan Kernel Linux untuk NetApp NFS.sudo vi /etc/modprobe.d/sunrpc.confHapus baris berikut:

options sunrpc tcp_max_slot_table_entries=128[A] Lakukan konfigurasi RHEL OS untuk HANA.

Konfigurasikan OS seperti yang dijelaskan dalam Catatan SAP berikut berdasarkan versi RHEL Anda:

- 2292690 - SAP HANA DB: Pengaturan OS yang disarankan untuk RHEL 7

- 2777782 - SAP Hana DB: Pengaturan OS yang disarankan untuk RHEL 8

- 2455582 - Linux: Jalankan aplikasi SAP yang dikompilasi dengan GCC 6.x

- 2593824 - Linux: Jalankan aplikasi SAP yang dikompilasi dengan GCC 7.x

- 2886607 - Linux: Jalankan aplikasi SAP yang dikompilasi dengan GCC 9.x

[A] Pasang SAP Hana.

Dimulai dengan HANA 2.0 Microsoft SharePoint Server 01, MDC adalah opsi default. Saat Anda menginstal sistem HANA, SYSTEMDB dan penyewa dengan SID yang sama dibuat bersama-sama. Dalam beberapa kasus, Anda tidak ingin penyewa default. Jika Anda tidak ingin membuat penyewa awal bersama dengan penginstalan, Anda dapat mengikuti Catatan SAP 2629711.

Jalankan program hdblcm dari DVD HANA. Masukkan nilai berikut pada permintaan:

- Pilih penginstalan: Masukkan 1 (untuk penginstalan).

- Pilih komponen lainnya untuk penginstalan: Masukkan 1.

- Masukkan Jalur Penginstalan [/hana/shared]: Pilih Enter untuk menerima default.

- Masukkan Nama Host Lokal [..]: Pilih Enter untuk menerima default. Apakah Anda ingin menambahkan host tambahan ke sistem? (y/n) [n]: n.

- Masukkan ID Sistem SAP Hana: Masukkan HN1.

- Masukkan Nomor Instans [00]: Masukkan 03.

- Pilih Mode Database / Masukkan Indeks [1]: Pilih Enter untuk menerima default.

- Pilih Penggunaan Sistem / Masukkan Indeks [4]: Masukkan 4 (untuk kustom).

- Masukkan Lokasi Volume Data [/hana/data]: Pilih Enter untuk menerima default.

- Masukkan Lokasi Volume Log [/hana/log]: Pilih Enter untuk menerima default.

- Batasi alokasi memori maksimum? [n]: Pilih Enter untuk menerima default.

- Masukkan Nama Host Sertifikat Untuk Host '...' [...]: Pilih Enter untuk menerima default.

- Masukkan Kata Sandi Pengguna Agen Host SAP (sapadm): Masukkan kata sandi pengguna agen host.

- Konfirmasi Kata Sandi Pengguna Agen Host SAP (sapadm): Masukkan kata sandi pengguna agen host lagi untuk mengonfirmasi.

- Masukkan Kata Sandi Administrator Sistem (hn1adm): Masukkan kata sandi administrator sistem.

- Konfirmasi Kata Sandi Administrator Sistem (hn1adm): Masukkan kata sandi administrator sistem lagi untuk mengonfirmasi.

- Masukkan Direktori Beranda Administrator Sistem [/usr/sap/HN1/home]: Pilih Enter untuk menerima default.

- Masukkan System Administrator Login Shell [/bin/sh]: Pilih Enter untuk menerima default.

- Masukkan ID Pengguna Administrator Sistem [1001]: Pilih Enter untuk menerima default.

- Masukkan ID Grup Pengguna (sapsys) [79]: Pilih Enter untuk menerima default.

- Masukkan Kata Sandi Pengguna Database (SISTEM): Masukkan kata sandi pengguna database.

- KonfirmasiKan Kata Sandi Pengguna Database (SISTEM): Masukkan kata sandi pengguna database lagi untuk mengonfirmasi.

- Hidupkan ulang sistem setelah boot ulang komputer? [n]: Pilih Enter untuk menerima default.

- Apakah Anda ingin melanjutkan? (y/n): Validasi ringkasan. Masukkan y untuk melanjutkan.

[A] Meningkatkan Agen Host SAP.

Unduh arsip Agen Host SAP terbaru dari SAP Software Center dan jalankan perintah berikut untuk meningkatkan agen. Ganti jalur ke arsip untuk menunjuk ke file yang Anda unduh:

sudo /usr/sap/hostctrl/exe/saphostexec -upgrade -archive <path to SAP Host Agent SAR>[A] Konfigurasikan firewall.

Buat aturan firewall untuk port probe Azure Load Balancer.

sudo firewall-cmd --zone=public --add-port=62503/tcp sudo firewall-cmd --zone=public --add-port=62503/tcp –permanent

Mengonfigurasi Replikasi Sistem SAP Hana

Ikuti langkah-langkah dalam Menyiapkan Replikasi Sistem SAP HANA untuk mengonfigurasi Replikasi Sistem SAP HANA.

Mengonfigurasi kluster

Bagian ini menjelaskan langkah-langkah yang diperlukan kluster untuk beroperasi dengan mulus saat SAP Hana diinstal pada berbagi NFS dengan menggunakan Azure NetApp Files.

Membuat kluster Pacemaker

Ikuti langkah-langkah dalam Menyiapkan Pacemaker di Red Hat Enterprise Linux di Azure untuk membuat kluster Pacemaker dasar untuk server HANA ini.

Penting

Dengan Kerangka Kerja Startup SAP berbasis sistemd, instans SAP Hana sekarang dapat dikelola oleh systemd. Versi Red Hat Enterprise Linux (RHEL) minimum yang diperlukan adalah RHEL 8 untuk SAP. Seperti yang diuraikan dalam catatan SAP 3189534, setiap instalasi baru revisi SAP Hana SPS07 70 atau lebih tinggi, atau pembaruan untuk sistem HANA ke HANA 2.0 SPS07 revisi 70 atau lebih tinggi, kerangka kerja Startup SAP akan secara otomatis didaftarkan dengan sistem.

Saat menggunakan solusi HA untuk mengelola replikasi sistem SAP Hana dalam kombinasi dengan instans SAP Hana yang diaktifkan sistem (lihat Catatan SAP 3189534), langkah-langkah tambahan diperlukan untuk memastikan bahwa kluster HA dapat mengelola instans SAP tanpa gangguan sistem. Jadi, untuk sistem SAP Hana yang terintegrasi dengan systemd, langkah tambahan yang diuraikan dalam Red Hat KBA 7029705 harus diikuti pada semua node kluster.

Terapkan SAPHanaSR kait replikasi sistem Python

Langkah ini adalah langkah penting untuk mengoptimalkan integrasi dengan kluster dan meningkatkan deteksi ketika failover kluster diperlukan. Kami sangat menyarankan Anda mengonfigurasi kait Python SAPHanaSR. Ikuti langkah-langkah dalam Menerapkan replikasi sistem Python yang menghubungkan SAPHanaSR.

Mengonfigurasi sumber daya sistem file

Dalam contoh ini, setiap node kluster memiliki sistem /hana/sharedfile NFS HANA sendiri , , /hana/datadan /hana/log.

[1] Letakkan kluster dalam mode pemeliharaan.

sudo pcs property set maintenance-mode=true[1] Buat sumber daya sistem file untuk pemasangan hanadb1 .

sudo pcs resource create hana_data1 ocf:heartbeat:Filesystem device=10.32.2.4:/hanadb1-data-mnt00001 directory=/hana/data fstype=nfs options=rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys op monitor interval=20s on-fail=fence timeout=120s OCF_CHECK_LEVEL=20 --group hanadb1_nfs sudo pcs resource create hana_log1 ocf:heartbeat:Filesystem device=10.32.2.4:/hanadb1-log-mnt00001 directory=/hana/log fstype=nfs options=rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys op monitor interval=20s on-fail=fence timeout=120s OCF_CHECK_LEVEL=20 --group hanadb1_nfs sudo pcs resource create hana_shared1 ocf:heartbeat:Filesystem device=10.32.2.4:/hanadb1-shared-mnt00001 directory=/hana/shared fstype=nfs options=rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys op monitor interval=20s on-fail=fence timeout=120s OCF_CHECK_LEVEL=20 --group hanadb1_nfs[2] Buat sumber daya sistem file untuk pemasangan hanadb2 .

sudo pcs resource create hana_data2 ocf:heartbeat:Filesystem device=10.32.2.4:/hanadb2-data-mnt00001 directory=/hana/data fstype=nfs options=rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys op monitor interval=20s on-fail=fence timeout=120s OCF_CHECK_LEVEL=20 --group hanadb2_nfs sudo pcs resource create hana_log2 ocf:heartbeat:Filesystem device=10.32.2.4:/hanadb2-log-mnt00001 directory=/hana/log fstype=nfs options=rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys op monitor interval=20s on-fail=fence timeout=120s OCF_CHECK_LEVEL=20 --group hanadb2_nfs sudo pcs resource create hana_shared2 ocf:heartbeat:Filesystem device=10.32.2.4:/hanadb2-shared-mnt00001 directory=/hana/shared fstype=nfs options=rw,nfsvers=4.1,hard,timeo=600,rsize=262144,wsize=262144,noatime,lock,_netdev,sec=sys op monitor interval=20s on-fail=fence timeout=120s OCF_CHECK_LEVEL=20 --group hanadb2_nfsAtribut

OCF_CHECK_LEVEL=20ditambahkan ke operasi monitor sehingga setiap monitor melakukan pengujian baca/tulis pada sistem file. Tanpa atribut ini, operasi monitor hanya memverifikasi bahwa sistem file sudah terpasang. Ini bisa menjadi masalah karena ketika konektivitas hilang, sistem file mungkin tetap dipasang meskipun tidak dapat diakses.Atribut

on-fail=fencejuga ditambahkan ke operasi monitor. Dengan opsi ini, jika operasi monitor gagal pada sebuah simpul, simpul tersebut segera dipagari. Tanpa opsi ini, perilaku default adalah menghentikan semua sumber daya yang bergantung pada sumber daya yang gagal, memulai ulang sumber daya yang gagal, lalu memulai semua sumber daya yang bergantung pada sumber daya yang gagal.Perilaku ini tidak hanya membutuhkan waktu lama ketika sumber daya SAPHana bergantung pada sumber daya yang gagal, tetapi juga dapat gagal sama sekali. Sumber daya SAPHana tidak dapat berhasil dihentikan jika server NFS yang memegang hana executable tidak dapat diakses.

Nilai batas waktu yang disarankan memungkinkan sumber daya kluster untuk menahan jeda khusus protokol, yang terkait dengan perpanjangan sewa NFSv4.1. Untuk informasi selengkapnya, lihat NFS di Praktik terbaik NetApp. Batas waktu dalam konfigurasi sebelumnya mungkin perlu disesuaikan dengan penyiapan SAP tertentu.

Untuk beban kerja yang memerlukan throughput yang lebih tinggi, pertimbangkan untuk menggunakan

nconnectopsi pemasangan, seperti yang dijelaskan dalam volume NFS v4.1 pada Azure NetApp Files untuk SAP Hana.nconnectPeriksa apakah didukung oleh Azure NetApp Files pada rilis Linux Anda.[1] Konfigurasikan batasan lokasi.

Konfigurasikan batasan lokasi untuk memastikan bahwa sumber daya yang mengelola pemasangan unik hanadb1 tidak pernah dapat berjalan pada hanadb2, dan sebaliknya.

sudo pcs constraint location hanadb1_nfs rule score=-INFINITY resource-discovery=never \#uname eq hanadb2 sudo pcs constraint location hanadb2_nfs rule score=-INFINITY resource-discovery=never \#uname eq hanadb1Opsi

resource-discovery=neverdiatur karena pemasangan unik untuk setiap node memiliki titik kait yang sama. Misalnya,hana_data1menggunakan titik pemasangan/hana/data, danhana_data2juga menggunakan titik pemasangan/hana/data. Berbagi titik pemasangan yang sama dapat menyebabkan positif palsu untuk operasi pemeriksaan, ketika status sumber daya diperiksa pada startup kluster, dan pada gilirannya dapat menyebabkan perilaku pemulihan yang tidak perlu. Untuk menghindari skenario ini, aturresource-discovery=never.[1] Konfigurasikan sumber daya atribut.

Konfigurasikan sumber daya atribut. Atribut ini diatur ke true jika semua pemasangan NFS simpul (

/hana/data,/hana/log, dan/hana/data) dipasang. Jika tidak, mereka diatur ke false.sudo pcs resource create hana_nfs1_active ocf:pacemaker:attribute active_value=true inactive_value=false name=hana_nfs1_active sudo pcs resource create hana_nfs2_active ocf:pacemaker:attribute active_value=true inactive_value=false name=hana_nfs2_active[1] Konfigurasikan batasan lokasi.

Konfigurasikan batasan lokasi untuk memastikan bahwa sumber daya atribut hanadb1 tidak pernah berjalan pada hanadb2, dan sebaliknya.

sudo pcs constraint location hana_nfs1_active avoids hanadb2 sudo pcs constraint location hana_nfs2_active avoids hanadb1[1] Buat batasan pemesanan.

Konfigurasikan batasan pemesanan sehingga sumber daya atribut node dimulai hanya setelah semua dudukan NFS node dipasang.

sudo pcs constraint order hanadb1_nfs then hana_nfs1_active sudo pcs constraint order hanadb2_nfs then hana_nfs2_activeTip

Jika konfigurasi Anda menyertakan sistem file, di luar grup

hanadb1_nfsatauhanadb2_nfs, sertakansequential=falseopsi sehingga tidak ada dependensi pengurutan di antara sistem file. Semua sistem file harus dimulai sebelumhana_nfs1_active, tetapi mereka tidak perlu memulai dalam urutan apa pun relatif satu sama lain. Untuk informasi selengkapnya, lihat Bagaimana cara mengonfigurasi Replikasi Sistem SAP Hana dalam Peningkatan Skala di kluster Pacemaker saat sistem file HANA berada di berbagi NFS

Mengonfigurasi sumber daya kluster SAP HANA

Ikuti langkah-langkah dalam Membuat sumber daya kluster SAP Hana untuk membuat sumber daya SAP Hana di kluster. Setelah sumber daya SAP Hana dibuat, Anda perlu membuat batasan aturan lokasi antara sumber daya SAP Hana dan sistem file (pemasangan NFS).

[1] Konfigurasikan batasan antara sumber daya SAP Hana dan pemasangan NFS.

Batasan aturan lokasi diatur sehingga sumber daya SAP Hana dapat berjalan pada simpul hanya jika semua pemasangan NFS simpul dipasang.

sudo pcs constraint location SAPHanaTopology_HN1_03-clone rule score=-INFINITY hana_nfs1_active ne true and hana_nfs2_active ne truePada RHEL 7.x:

sudo pcs constraint location SAPHana_HN1_03-master rule score=-INFINITY hana_nfs1_active ne true and hana_nfs2_active ne truePada RHEL 8.x/9.x:

sudo pcs constraint location SAPHana_HN1_03-clone rule score=-INFINITY hana_nfs1_active ne true and hana_nfs2_active ne true[1] Konfigurasikan batasan pemesanan sehingga sumber daya SAP pada node akan berhenti di depan pemberhentian untuk salah satu pemasangan NFS.

pcs constraint order stop SAPHanaTopology_HN1_03-clone then stop hanadb1_nfs pcs constraint order stop SAPHanaTopology_HN1_03-clone then stop hanadb2_nfsPada RHEL 7.x:

pcs constraint order stop SAPHana_HN1_03-master then stop hanadb1_nfs pcs constraint order stop SAPHana_HN1_03-master then stop hanadb2_nfsPada RHEL 8.x/9.x:

pcs constraint order stop SAPHana_HN1_03-clone then stop hanadb1_nfs pcs constraint order stop SAPHana_HN1_03-clone then stop hanadb2_nfsKeluarkan kluster dari mode pemeliharaan.

sudo pcs property set maintenance-mode=falsePeriksa status kluster dan semua sumber daya.

Catatan

Artikel ini berisi referensi ke istilah yang tidak lagi digunakan Microsoft. Saat istilah dihapus dari perangkat lunak, kami akan menghapusnya dari artikel ini.

sudo pcs statusContoh output:

Online: [ hanadb1 hanadb2 ] Full list of resources: rsc_hdb_azr_agt(stonith:fence_azure_arm): Started hanadb1 Resource Group: hanadb1_nfs hana_data1 (ocf::heartbeat:Filesystem):Started hanadb1 hana_log1 (ocf::heartbeat:Filesystem):Started hanadb1 hana_shared1 (ocf::heartbeat:Filesystem):Started hanadb1 Resource Group: hanadb2_nfs hana_data2 (ocf::heartbeat:Filesystem):Started hanadb2 hana_log2 (ocf::heartbeat:Filesystem):Started hanadb2 hana_shared2 (ocf::heartbeat:Filesystem):Started hanadb2 hana_nfs1_active (ocf::pacemaker:attribute): Started hanadb1 hana_nfs2_active (ocf::pacemaker:attribute): Started hanadb2 Clone Set: SAPHanaTopology_HN1_03-clone [SAPHanaTopology_HN1_03] Started: [ hanadb1 hanadb2 ] Master/Slave Set: SAPHana_HN1_03-master [SAPHana_HN1_03] Masters: [ hanadb1 ] Slaves: [ hanadb2 ] Resource Group: g_ip_HN1_03 nc_HN1_03 (ocf::heartbeat:azure-lb): Started hanadb1 vip_HN1_03 (ocf::heartbeat:IPaddr2): Started hanadb1

Mengonfigurasi replikasi sistem aktif/baca-aktif HANA di kluster Pacemaker

Dimulai dengan SAP Hana 2.0 SPS 01, SAP memungkinkan pengaturan aktif/berkemampuan baca untuk Replikasi Sistem SAP Hana, di mana sistem sekunder Replikasi Sistem SAP Hana dapat digunakan secara aktif untuk beban kerja baca intens. Untuk mendukung pengaturan seperti itu dalam kluster, alamat IP virtual kedua diperlukan, yang memungkinkan klien mengakses database SAP Hana sekunder yang diaktifkan baca.

Untuk memastikan situs replikasi sekunder masih dapat diakses setelah pengambilalihan terjadi, kluster perlu memindahkan alamat IP virtual dengan sumber daya sekunder SAPHana.

Konfigurasi tambahan, yang diperlukan untuk mengelola Replikasi Sistem aktif/baca-aktif HANA di kluster Red Hat HA dengan IP virtual kedua, dijelaskan dalam Mengonfigurasi Replikasi Sistem Aktif/Baca-Aktif HANA di kluster Pacemaker.

Sebelum melanjutkan lebih lanjut, pastikan Anda telah sepenuhnya mengonfigurasi Red Hat High Availability Cluster yang mengelola database SAP Hana seperti yang dijelaskan di bagian sebelumnya dari dokumentasi.

Menguji penyiapan kluster

Bagian ini menjelaskan bagaimana Anda dapat menguji penyiapan Anda.

Sebelum Anda memulai pengujian, pastikan bahwa Pacemaker tidak memiliki tindakan yang gagal (melalui status pcs), tidak ada batasan lokasi yang tidak terduga (misalnya, sisa tes migrasi), dan bahwa replikasi sistem HANA dalam keadaan sinkron, misalnya, dengan

systemReplicationStatus:sudo su - hn1adm -c "python /usr/sap/HN1/HDB03/exe/python_support/systemReplicationStatus.py"Verifikasi konfigurasi kluster untuk skenario kegagalan ketika node kehilangan akses ke berbagi NFS (

/hana/shared).Agen sumber daya SAP Hana bergantung pada binari yang disimpan di

/hana/shareduntuk melakukan operasi selama failover. Sistem file/hana/shareddipasang di atas NFS dalam skenario yang disajikan.Sulit untuk mensimulasikan kegagalan di mana salah satu server kehilangan akses ke berbagi NFS. Sebagai pengujian, Anda dapat me-remount sistem file sebagai baca-saja. Pendekatan ini memvalidasi bahwa kluster dapat gagal, jika akses ke

/hana/sharedhilang pada simpul aktif.Hasil yang diharapkan: Pada pembuatan

/hana/sharedsebagai sistem file baca-saja,OCF_CHECK_LEVELatribut sumber dayahana_shared1, yang melakukan operasi baca/tulis pada sistem file, gagal. Ini tidak dapat menulis apa pun pada sistem file dan melakukan failover sumber daya HANA. Hasil yang sama diharapkan ketika node HANA Anda kehilangan akses ke share NFS.Status sumber daya sebelum memulai pengujian:

sudo pcs statusContoh output:

Full list of resources: rsc_hdb_azr_agt (stonith:fence_azure_arm): Started hanadb1 Resource Group: hanadb1_nfs hana_data1 (ocf::heartbeat:Filesystem): Started hanadb1 hana_log1 (ocf::heartbeat:Filesystem): Started hanadb1 hana_shared1 (ocf::heartbeat:Filesystem): Started hanadb1 Resource Group: hanadb2_nfs hana_data2 (ocf::heartbeat:Filesystem): Started hanadb2 hana_log2 (ocf::heartbeat:Filesystem): Started hanadb2 hana_shared2 (ocf::heartbeat:Filesystem): Started hanadb2 hana_nfs1_active (ocf::pacemaker:attribute): Started hanadb1 hana_nfs2_active (ocf::pacemaker:attribute): Started hanadb2 Clone Set: SAPHanaTopology_HN1_03-clone [SAPHanaTopology_HN1_03] Started: [ hanadb1 hanadb2 ] Master/Slave Set: SAPHana_HN1_03-master [SAPHana_HN1_03] Masters: [ hanadb1 ] Slaves: [ hanadb2 ] Resource Group: g_ip_HN1_03 nc_HN1_03 (ocf::heartbeat:azure-lb): Started hanadb1 vip_HN1_03 (ocf::heartbeat:IPaddr2): Started hanadb1Anda dapat menempatkan

/hana/shareddalam mode baca-saja pada node kluster aktif dengan menggunakan perintah ini:sudo mount -o ro 10.32.2.4:/hanadb1-shared-mnt00001 /hana/sharedhanadbakan di-boot ulang atau dimatikan berdasarkan tindakan yang ditetapkan padastonith(pcs property show stonith-action). Setelah server (hanadb1) tidak berfungsi, sumber daya HANA berpindah kehanadb2. Anda dapat memeriksa status kluster darihanadb2.sudo pcs statusContoh output:

Full list of resources: rsc_hdb_azr_agt (stonith:fence_azure_arm): Started hanadb2 Resource Group: hanadb1_nfs hana_data1 (ocf::heartbeat:Filesystem): Stopped hana_log1 (ocf::heartbeat:Filesystem): Stopped hana_shared1 (ocf::heartbeat:Filesystem): Stopped Resource Group: hanadb2_nfs hana_data2 (ocf::heartbeat:Filesystem): Started hanadb2 hana_log2 (ocf::heartbeat:Filesystem): Started hanadb2 hana_shared2 (ocf::heartbeat:Filesystem): Started hanadb2 hana_nfs1_active (ocf::pacemaker:attribute): Stopped hana_nfs2_active (ocf::pacemaker:attribute): Started hanadb2 Clone Set: SAPHanaTopology_HN1_03-clone [SAPHanaTopology_HN1_03] Started: [ hanadb2 ] Stopped: [ hanadb1 ] Master/Slave Set: SAPHana_HN1_03-master [SAPHana_HN1_03] Masters: [ hanadb2 ] Stopped: [ hanadb1 ] Resource Group: g_ip_HN1_03 nc_HN1_03 (ocf::heartbeat:azure-lb): Started hanadb2 vip_HN1_03 (ocf::heartbeat:IPaddr2): Started hanadb2Kami menyarankan agar Anda menguji konfigurasi kluster SAP Hana secara menyeluruh dengan juga melakukan pengujian yang dijelaskan dalam Menyiapkan Replikasi Sistem SAP Hana pada RHEL.