Opsi untuk memasukkan data ke Fabric Lakehouse

Pengalaman mendapatkan data mencakup semua skenario pengguna untuk membawa data ke lakehouse, seperti:

- Koneksi ke SQL Server yang ada dan menyalin data ke tabel Delta di lakehouse.

- Mengunggah file dari komputer Anda.

- Menyalin dan menggabungkan beberapa tabel dari lakehouse lain ke dalam tabel Delta baru.

- Koneksi ke sumber streaming untuk mendaratkan data di lakehouse.

- Mereferensikan data tanpa menyalinnya dari lakehouse internal atau sumber eksternal lainnya.

Berbagai cara untuk memuat data ke lakehouse

Di Microsoft Fabric, ada beberapa cara untuk memasukkan data ke lakehouse:

- Unggahan file dari komputer lokal

- Menjalankan alat salin dalam alur

- Menyiapkan aliran data

- Pustaka Apache Spark dalam kode buku catatan

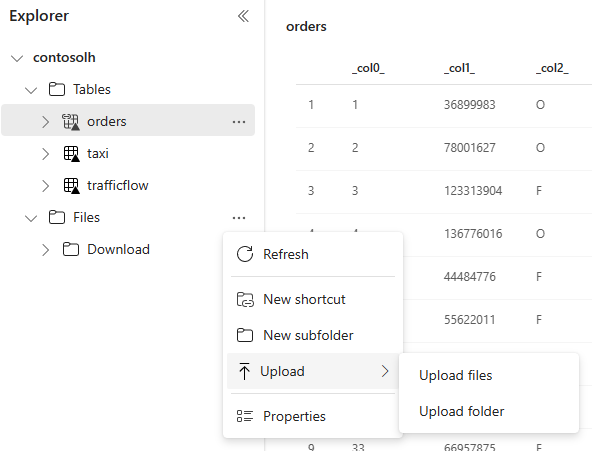

Unggahan file lokal

Anda juga dapat mengunggah data yang disimpan di komputer lokal Anda. Anda dapat melakukannya langsung di penjelajah Lakehouse.

Alat salin dalam alur

Alat Salin adalah solusi Integrasi Data yang sangat dapat diskalakan yang memungkinkan Anda terhubung ke sumber data yang berbeda dan memuat data baik dalam format asli atau mengonversinya ke tabel Delta. Alat salin adalah bagian dari aktivitas alur yang dapat Anda ubah dengan berbagai cara, seperti penjadwalan atau pemicu berdasarkan suatu peristiwa. Untuk informasi selengkapnya, lihat Cara menyalin data menggunakan aktivitas salin.

Aliran data

Untuk pengguna yang terbiasa dengan aliran data Power BI, alat yang sama tersedia untuk memuat data ke lakehouse Anda. Anda dapat dengan cepat mengaksesnya dari opsi "Dapatkan data" penjelajah Lakehouse, dan memuat data dari lebih dari 200 konektor. Untuk informasi selengkapnya, lihat Mulai Cepat: Membuat aliran data pertama Anda untuk mendapatkan dan mengubah data.

Kode buku catatan

Anda dapat menggunakan pustaka Spark yang tersedia untuk menyambungkan ke sumber data secara langsung, memuat data ke bingkai data, lalu menyimpannya di lakehouse. Metode ini adalah cara paling terbuka untuk memuat data di lakehouse yang dikelola sepenuhnya oleh kode pengguna.

Catatan

Tabel Delta eksternal yang dibuat dengan kode Spark tidak akan terlihat oleh titik akhir analitik SQL. Gunakan pintasan di ruang Tabel untuk membuat tabel Delta eksternal terlihat untuk titik akhir analitik SQL.

Pertimbangan saat memilih pendekatan untuk memuat data

| Gunakan huruf besar | Rekomendasi |

|---|---|

| Unggahan file kecil dari komputer lokal | Gunakan Unggahan file lokal |

| Data kecil atau konektor tertentu | Menggunakan Aliran Data |

| Sumber data besar | Menggunakan alat Salin dalam alur |

| Transformasi data kompleks | Menggunakan kode Notebook |