Microsoft Purview protegge la sicurezza dei dati e la conformità per le app di intelligenza artificiale generativa

Linee guida sulle licenze di Microsoft 365 per la sicurezza & conformità

Usare Microsoft Purview per attenuare e gestire i rischi associati all'utilizzo dell'IA e implementare i controlli di protezione e governance corrispondenti.

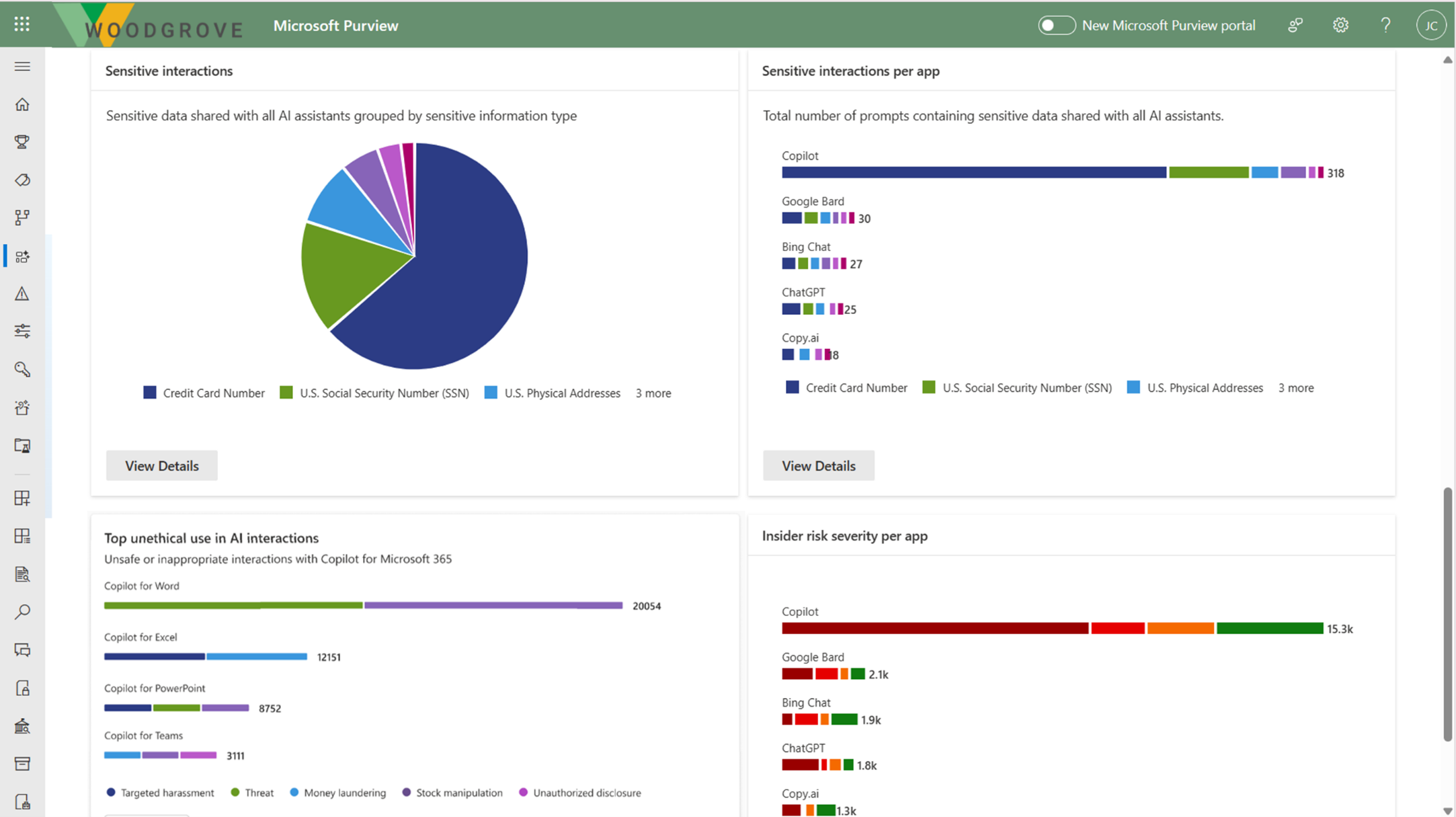

Microsoft Purview AI Hub è attualmente in anteprima e offre strumenti grafici e report facili da usare per ottenere rapidamente informazioni dettagliate sull'uso dell'intelligenza artificiale all'interno dell'organizzazione. I criteri con un clic consentono di proteggere i dati e di rispettare i requisiti normativi.

Usare l'hub di intelligenza artificiale insieme ad altre funzionalità di Microsoft Purview per rafforzare la sicurezza e la conformità dei dati per Microsoft Copilot per Microsoft 365:

- Etichette di riservatezza e contenuto crittografato da Microsoft Purview Information Protection

- Classificazione dei dati

- Customer Key

- Conformità delle comunicazioni

- Controllo

- Ricerca contenuto

- eDiscovery

- Conservazione ed eliminazione

- Customer Lockbox

Nota

Per verificare se i piani di licenza dell'organizzazione supportano queste funzionalità, vedere il collegamento alle linee guida sulle licenze nella parte superiore della pagina. Per informazioni sulle licenze per Microsoft Copilot per Microsoft 365 stesso, vedere la descrizione del servizio per Microsoft Copilot per Microsoft 365.

Usare le sezioni seguenti per altre informazioni sull'hub di intelligenza artificiale e sulle funzionalità di Microsoft Purview che forniscono controlli aggiuntivi per la sicurezza e la conformità dei dati per accelerare l'adozione di Microsoft Copilot da parte dell'organizzazione e di altre app generative per intelligenza artificiale. Se non si ha familiarità con Microsoft Purview, è anche possibile trovare una panoramica del prodotto utile: Informazioni su Microsoft Purview.

Per informazioni più generali sui requisiti di sicurezza e conformità per Copilot per Microsoft 365, vedere Dati, privacy e sicurezza per Microsoft Copilot per Microsoft 365.

Microsoft Purview AI Hub fornisce informazioni dettagliate, criteri e controlli per le app per intelligenza artificiale

Nota

Microsoft Purview AI Hub è attualmente in anteprima e soggetto a modifiche.

L'hub di intelligenza artificiale dal portale di Microsoft Purview o dal portale di conformità di Microsoft Purview offre un percorso di gestione centrale che consente di proteggere rapidamente i dati per le app per intelligenza artificiale e monitorare in modo proattivo l'uso dell'IA. Queste app includono Microsoft Copilot per Microsoft 365 e app per intelligenza artificiale di moduli di linguaggio di grandi dimensioni di terze parti.

L'hub di intelligenza artificiale offre un set di funzionalità che consentono di adottare in modo sicuro l'intelligenza artificiale senza dover scegliere tra produttività e protezione:

Informazioni dettagliate e analisi sulle attività di intelligenza artificiale nell'organizzazione

Criteri pronti per l'uso per proteggere i dati e prevenire la perdita di dati nelle richieste di intelligenza artificiale

Controlli di conformità per applicare criteri ottimali per la gestione e l'archiviazione dei dati

Per un elenco dei siti di intelligenza artificiale di terze parti supportati, ad esempio quelli usati per Bard e ChatGPT, vedere Siti di intelligenza artificiale supportati da Microsoft Purview per le protezioni di sicurezza e conformità dei dati.

Come usare l'hub di intelligenza artificiale

Per ottenere più rapidamente informazioni dettagliate sull'utilizzo dell'IA e proteggere i dati, l'hub di intelligenza artificiale fornisce alcuni criteri preconfigurati che è possibile attivare con un solo clic. Consentire almeno 24 ore affinché questi nuovi criteri possano raccogliere dati per visualizzare i risultati nell'hub di intelligenza artificiale o riflettere eventuali modifiche apportate alle impostazioni predefinite.

Per iniziare a usare l'hub di intelligenza artificiale, è possibile usare il portale di Microsoft Purview o il portale di conformità di Microsoft Purview. È necessario un account con autorizzazioni appropriate per la gestione della conformità, ad esempio un account membro del ruolo del gruppo Amministratore conformità Microsoft Entra .

A seconda del portale in uso, passare a una delle posizioni seguenti:

Accedere al portale> di Microsoft PurviewScheda hub di intelligenza artificiale (anteprima).

Se la scheda hub di intelligenza artificiale (anteprima) non viene visualizzata, selezionare Visualizza tutte le soluzioni e quindi selezionare Hub di intelligenza artificiale (anteprima) nella sezione Sicurezza dei dati .

Accedere al portale >di conformità di Microsoft PurviewHub di intelligenza artificiale (anteprima).

In Analisi esaminare la sezione Introduzione per altre informazioni sull'hub di intelligenza artificiale e sulle azioni immediate che è possibile eseguire. Selezionare ognuno di essi per visualizzare il riquadro a comparsa per altre informazioni, eseguire azioni e verificare lo stato corrente.

Azione Ulteriori informazioni Attivare Controllo Di Microsoft Purview Il controllo è attivato per impostazione predefinita per i nuovi tenant, quindi è possibile che si soddisfi già questo prerequisito. In tal caso, e agli utenti sono già state assegnate licenze per Copilot, si iniziano a visualizzare informazioni dettagliate sulle attività copilot dalla sezione Analisi dei dati di intelligenza artificiale più in basso nella pagina. Installare l'estensione del browser Microsoft Purview Prerequisito per i siti di intelligenza artificiale di terze parti. Eseguire l'onboarding dei dispositivi in Microsoft Purview Un prerequisito anche per i siti di intelligenza artificiale di terze parti. Estendere le informazioni dettagliate per l'individuazione dei dati Criteri con un clic per raccogliere informazioni sugli utenti che visitano siti di IA generativi di terze parti e inviano loro informazioni sensibili. L'opzione è la stessa del pulsante Estendi informazioni dettagliate nella sezione Analisi dei dati di intelligenza artificiale più avanti nella pagina. Per altre informazioni sui prerequisiti, vedere Prerequisiti per l'hub di intelligenza artificiale.

Per altre informazioni sui criteri preconfigurati che è possibile attivare, vedere Criteri con un clic dall'hub di intelligenza artificiale.

Esaminare quindi la sezione Raccomandazioni e decidere se implementare eventuali opzioni rilevanti per il tenant. Ad esempio:

- Selezionare Visualizza dettagli per Ottenere assistenza guidata alle normative di intelligenza artificiale che usano modelli normativi di mapping dei controlli di Compliance Manager.

- Selezionare Visualizza dettagli per Proteggere i dati sensibili a cui si fa riferimento nelle risposte copilot per identificare il contenuto a cui è stato fatto riferimento da Microsoft Copilot per Microsoft 365 e che non è protetto con un'etichetta di riservatezza.

Selezionare Criteri dall'hub di intelligenza artificiale in cui è possibile attivare rapidamente i criteri predefiniti per proteggere i dati sensibili inviati a siti di IA generativi di terze parti e proteggere i dati con etichette di riservatezza. Per altre informazioni su questi criteri, vedere Criteri con un clic dall'hub di intelligenza artificiale. È necessario attendere almeno un giorno per il popolamento dei report.

In Raccomandazioni e Rafforzare la sicurezza dei dati per l'intelligenza artificiale selezionare Introduzione per altre informazioni, eseguire azioni e verificare lo stato corrente.

Quando vengono creati i criteri, inclusi quelli di Analytics, è possibile monitorarne lo stato da questa pagina. Per modificarli, usare la soluzione di gestione corrispondente nel portale. Ad esempio, per Controllare il comportamento non etico nell'intelligenza artificiale, è possibile esaminare e correggere le corrispondenze dalla soluzione Conformità delle comunicazioni.

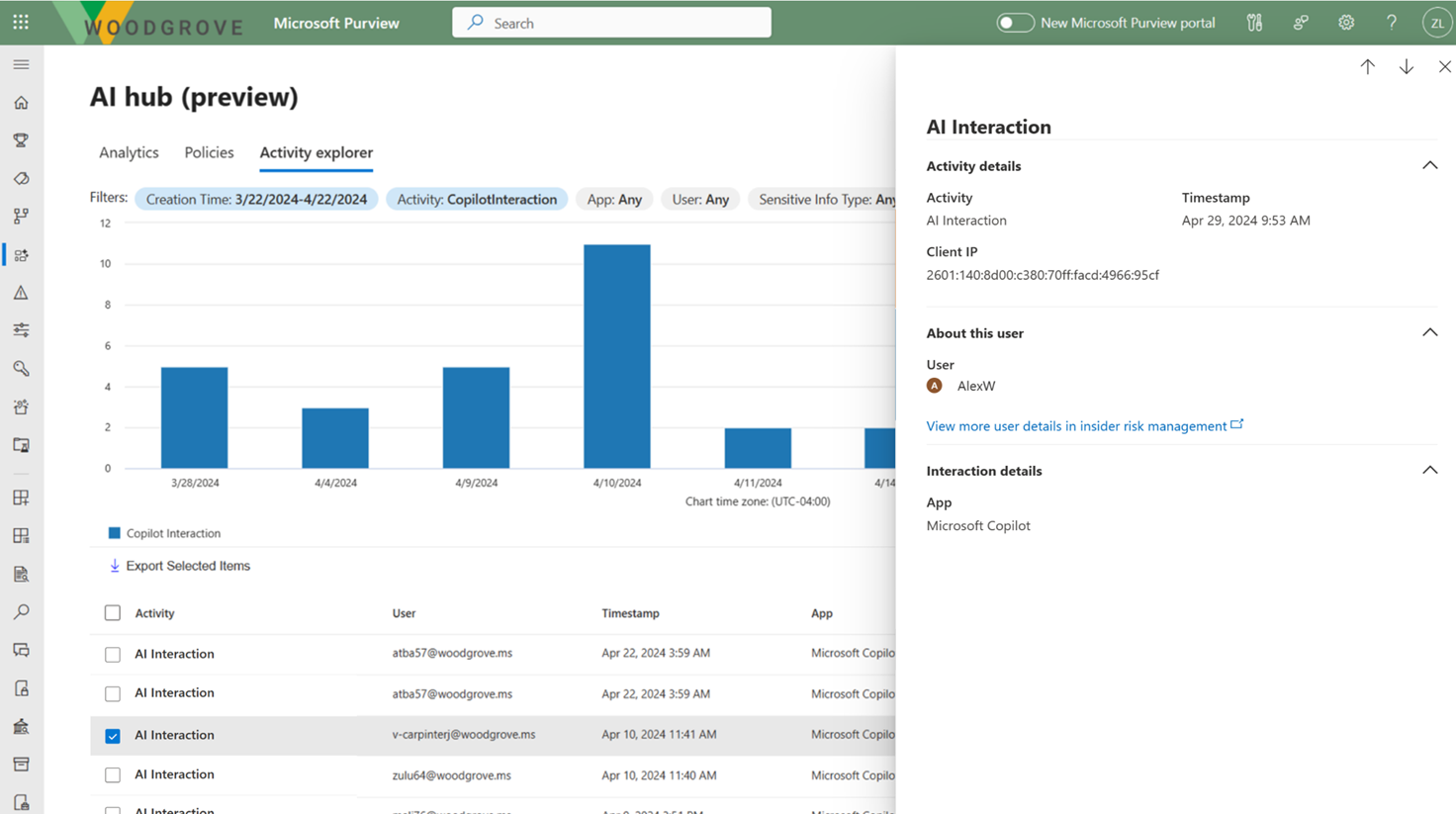

Selezionare Esplora attività dall'hub di intelligenza artificiale per visualizzare i dettagli dei dati raccolti dai criteri. Se si seleziona Visualizza dettagli da uno qualsiasi dei grafici della pagina Analisi o della pagina Criteri , si passa anche a Esplora attività.

Queste informazioni più dettagliate includono attività, carico di lavoro e app, utente, data e ora ed eventuali tipi di informazioni sensibili rilevati.

Esempi di attività includono l'interazione con l'intelligenza artificiale, la classificazione contrassegnata, la corrispondenza delle regole DLP e la visita all'intelligenza artificiale. Per altre informazioni sugli eventi, vedere Eventi di Esplora attività.

Esempi di app includono Microsoft Copilot e Altre app per intelligenza artificiale.

Per Microsoft Copilot per Microsoft 365, usare questi criteri e informazioni dettagliate in combinazione con altre protezioni e funzionalità di conformità di Microsoft Purview.

Microsoft Purview rafforza la protezione delle informazioni per Copilot

Copilot usa i controlli esistenti per assicurarsi che i dati archiviati nel tenant non vengano mai restituiti all'utente o usati da un modello LLM (Large Language Model) se l'utente non ha accesso a tali dati. Quando i dati hanno etichette di riservatezza dell'organizzazione applicate al contenuto, esiste un ulteriore livello di protezione:

Quando un file è aperto in Word, Excel, PowerPoint o in modo analogo un evento di posta elettronica o calendario è aperto In Outlook, la riservatezza dei dati viene visualizzata agli utenti dell'app con il nome dell'etichetta e i contrassegni di contenuto (ad esempio intestazione o testo del piè di pagina) configurati per l'etichetta.

Quando l'etichetta di riservatezza applica la crittografia, gli utenti devono avere il diritto di utilizzo EXTRACT, nonché VIEW, affinché Copilot restituisca i dati.

Questa protezione si estende ai dati archiviati all'esterno del tenant di Microsoft 365 quando è aperta in un'app di Office (dati in uso). Ad esempio, archiviazione locale, condivisioni di rete e archiviazione cloud.

Consiglio

Se non è già stato fatto, è consigliabile abilitare le etichette di riservatezza per SharePoint e OneDrive e acquisire familiarità con i tipi di file e le configurazioni delle etichette che questi servizi possono elaborare. Quando le etichette di riservatezza non sono abilitate per questi servizi, i file crittografati a cui Copilot per Microsoft 365 può accedere sono limitati ai dati in uso dalle app di Office in Windows.

Per istruzioni, vedere Abilitare le etichette di riservatezza per i file di Office in SharePoint e OneDrive.

Inoltre, quando si usa la chat a terra di Microsoft Copilot Graph (in precedenza Microsoft 365 Chat) che può accedere ai dati da un'ampia gamma di contenuti, la riservatezza dei dati etichettati restituiti da Copilot per Microsoft 365 viene resa visibile agli utenti con l'etichetta di riservatezza visualizzata per le citazioni e gli elementi elencati nella risposta. Usando il numero di priorità delle etichette di riservatezza definito nel portale di Microsoft Purview o nel portale di conformità di Microsoft Purview, la risposta più recente in Copilot visualizza l'etichetta di riservatezza con priorità più alta dai dati usati per la chat copilot.

Anche se gli amministratori della conformità definiscono la priorità di un'etichetta di riservatezza, un numero di priorità più alto indica in genere una maggiore riservatezza del contenuto, con autorizzazioni più restrittive. Di conseguenza, le risposte copilot vengono etichettate con l'etichetta di riservatezza più restrittiva.

Nota

Se gli elementi vengono crittografati da Microsoft Purview Information Protection ma non hanno un'etichetta di riservatezza, Anche Microsoft Copilot per Microsoft 365 non restituirà questi elementi agli utenti se la crittografia non include i diritti di utilizzo EXTRACT o VIEW per l'utente.

Se non si usano già etichette di riservatezza, vedere Introduzione alle etichette di riservatezza.

Anche se i criteri DLP non supportano ancora le interazioni per Microsoft Copilot per Microsoft 365, la classificazione dei dati per i tipi di informazioni sensibili e i classificatori sottoponibili a training sono supportati per identificare i dati sensibili nelle richieste degli utenti a Copilot e nelle risposte.

Protezione copilot con ereditarietà dell'etichetta di riservatezza

Quando si usa Copilot per creare nuovo contenuto in base a un elemento a cui è applicata un'etichetta di riservatezza, l'etichetta di riservatezza del file di origine viene ereditata automaticamente, con le impostazioni di protezione dell'etichetta.

Ad esempio, un utente seleziona Bozza con Copilot in Word e quindi Fa riferimento a un file. In alternativa, un utente seleziona Crea presentazione dal file in PowerPoint. Il contenuto di origine ha l'etichetta di riservatezza Confidential\Anyone (senza restrizioni) applicata e tale etichetta è configurata per applicare un piè di pagina che visualizza "Riservato". Il nuovo contenuto viene automaticamente etichettato Riservato\Chiunque (senza restrizioni) con lo stesso piè di pagina.

Per vedere un esempio di questa funzionalità in azione, guardare la demo seguente della sessione di Ignite 2023 Getting your enterprise ready for Microsoft 365 Copilot(Preparare l'azienda per Microsoft 365 Copilot). La demo mostra come l'etichetta di riservatezza predefinita General viene sostituita con un'etichetta Confidential quando un utente esegue la bozza con Copilot e fa riferimento a un file etichettato. La barra delle informazioni nella barra multifunzione informa l'utente che il contenuto creato da Copilot ha comportato l'applicazione automatica della nuova etichetta:

Se vengono usati più file per creare nuovo contenuto, l'etichetta di riservatezza con la priorità più alta viene usata per l'ereditarietà delle etichette.

Come per tutti gli scenari di etichettatura automatica, l'utente può sempre eseguire l'override e sostituire un'etichetta ereditata (o rimuovere, se non si usa l'etichettatura obbligatoria).

Protezione di Microsoft Purview senza etichette di riservatezza

Anche se non viene applicata un'etichetta di riservatezza al contenuto, i servizi e i prodotti potrebbero usare le funzionalità di crittografia del servizio Azure Rights Management. Di conseguenza, Copilot per Microsoft 365 può comunque verificare i diritti di utilizzo VIEW ed EXTRACT prima di restituire dati e collegamenti a un utente, ma non esiste un'ereditarietà automatica della protezione per i nuovi elementi.

Consiglio

Si otterrà la migliore esperienza utente quando si usano sempre etichette di riservatezza per proteggere i dati e la crittografia viene applicata da un'etichetta.

Esempi di prodotti e servizi che possono usare le funzionalità di crittografia del servizio Azure Rights Management senza etichette di riservatezza:

- Crittografia dei messaggi di Microsoft Purview

- Microsoft Information Rights Management (IRM)

- Connettore Microsoft Rights Management

- Microsoft Rights Management SDK

Per altri metodi di crittografia che non usano il servizio Azure Rights Management:

I messaggi di posta elettronica protetti da S/MIME non verranno restituiti da Copilot e Copilot non è disponibile in Outlook quando è aperto un messaggio di posta elettronica protetto S/MIME.

Non è possibile accedere ai documenti protetti da password da Copilot per Microsoft 365 a meno che non siano già aperti dall'utente nella stessa app (dati in uso). Le password non vengono ereditate da un elemento di destinazione.

Come per altri servizi di Microsoft 365, ad esempio eDiscovery e la ricerca, gli elementi crittografati con Microsoft Purview Customer Key o la propria chiave radice (BYOK) sono supportati e idonei per essere restituiti da Copilot per Microsoft 365.

Microsoft Purview supporta la gestione della conformità per Copilot

Usare le funzionalità di conformità di Microsoft Purview per supportare i requisiti di rischio e conformità per Copilot per Microsoft 365.

Le interazioni con Copilot possono essere monitorate per ogni utente nel tenant. Di conseguenza, è possibile usare la classificazione di Purview (tipi di informazioni sensibili e classificatori sottoponibili a training), la ricerca del contenuto, la conformità alle comunicazioni, il controllo, eDiscovery e le funzionalità di conservazione ed eliminazione automatiche usando i criteri di conservazione.

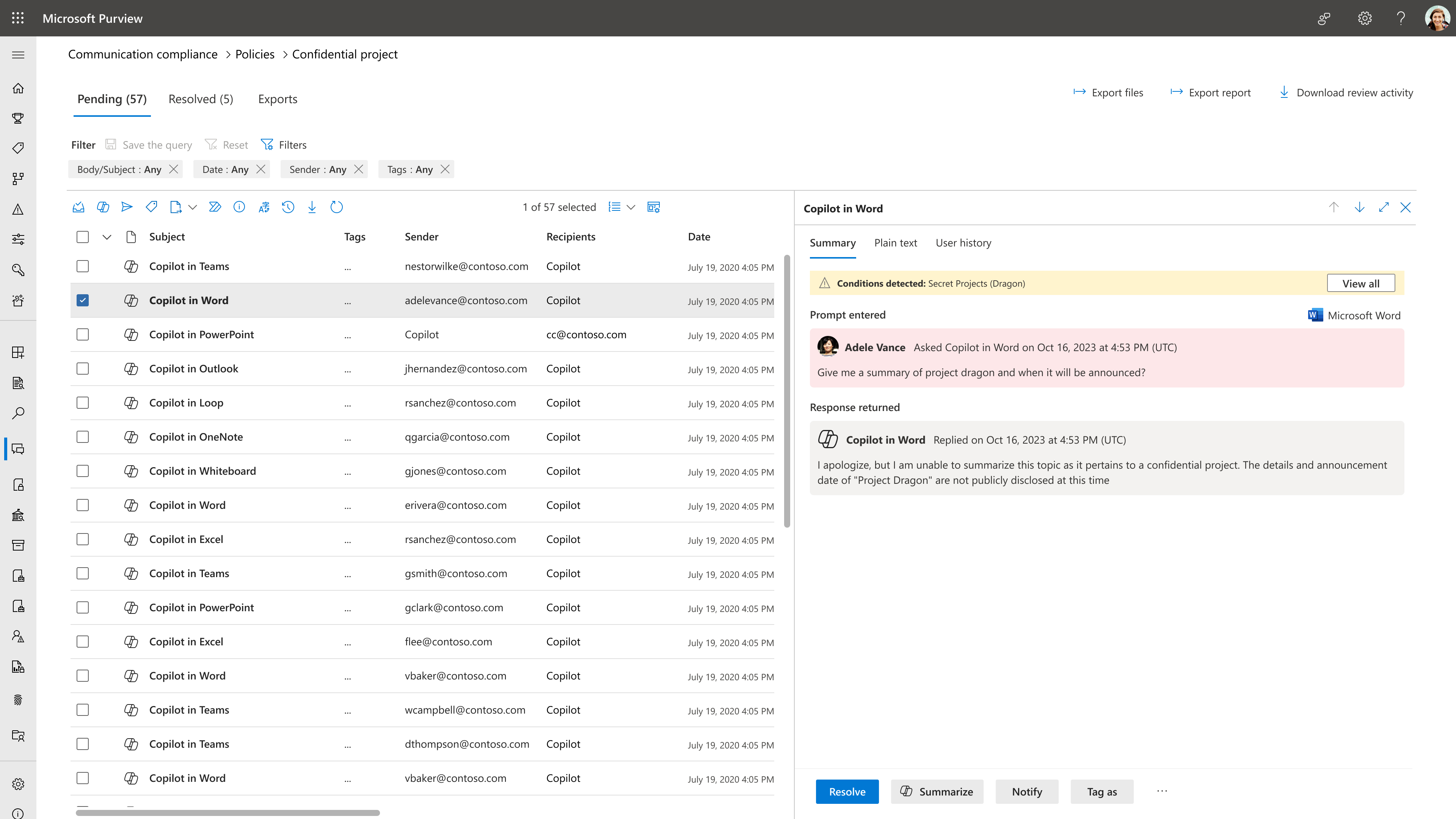

Per la conformità delle comunicazioni, è possibile analizzare le richieste degli utenti e le risposte copilot per rilevare interazioni inappropriate o rischiose o condividere informazioni riservate. Per altre informazioni, vedere Configurare criteri di conformità delle comunicazioni per rilevare le interazioni di Copilot per Microsoft 365.

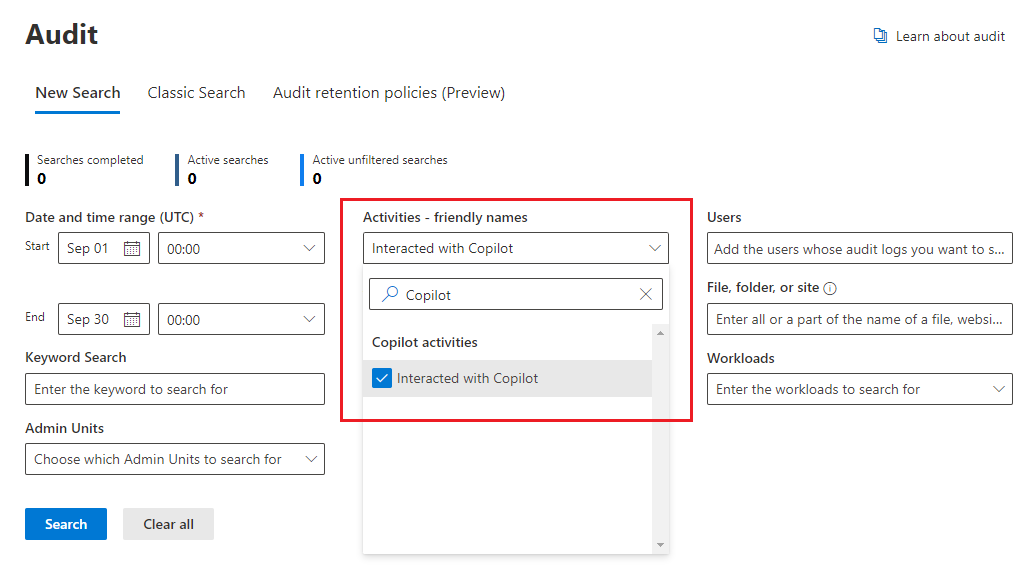

Per il controllo, i dettagli vengono acquisiti nel log di controllo unificato quando gli utenti interagiscono con Copilot. Gli eventi includono come e quando gli utenti interagiscono con Copilot, in cui si è svolta l'attività del servizio Microsoft 365, e riferimenti ai file archiviati in Microsoft 365 a cui è stato eseguito l'accesso durante l'interazione. Se questi file hanno un'etichetta di riservatezza applicata, anche questa viene acquisita. Nella soluzione Audit del portale di Microsoft Purview o del portale di conformità di Microsoft Purview selezionare Attività Copilot e Interagire con Copilot. È anche possibile selezionare Copilot come carico di lavoro. Ad esempio, dal portale di conformità:

Per la ricerca di contenuto, poiché le richieste dell'utente a Copilot e le risposte da Copilot vengono archiviate nella cassetta postale di un utente, possono essere ricercate e recuperate quando la cassetta postale dell'utente è selezionata come origine per una query di ricerca. Selezionare e recuperare questi dati dalla cassetta postale di origine selezionando dal generatore di query Aggiungitipo di>condizione>Uguale a una qualsiasi delle>opzioni Aggiungi/Rimuovi altre interazioni>copilot.

Analogamente per eDiscovery, si usa lo stesso processo di query per selezionare le cassette postali e recuperare le richieste degli utenti a Copilot e le risposte da Copilot. Dopo la creazione della raccolta e l'origine della fase di revisione in eDiscovery (Premium), questi dati sono disponibili per l'esecuzione di tutte le azioni di revisione esistenti. Queste raccolte e questi set di revisione possono quindi essere ulteriormente sospesi o esportati. Se è necessario eliminare questi dati, vedere Cercare ed eliminare i dati per Microsoft Copilot per Microsoft 365.

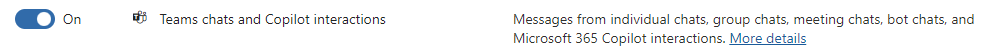

Per i criteri di conservazione che supportano la conservazione e l'eliminazione automatica, le richieste degli utenti a Copilot e le risposte di Copilot sono identificate dalle chat di Teams e dalle interazioni copilot. In precedenza denominate solo chat di Teams, gli utenti non devono usare la chat di Teams per applicare questi criteri. Tutti i criteri di conservazione esistenti configurati in precedenza per le chat di Teams ora includono automaticamente richieste e risposte degli utenti da e verso Microsoft Copilot per Microsoft 365:

Per informazioni dettagliate su questa conservazione, vedere Informazioni sulla conservazione per Microsoft Copilot per Microsoft 365.

Come per tutti i criteri e i blocchi di conservazione, se più criteri per la stessa posizione si applicano a un utente, i principi di conservazione resolvono eventuali conflitti. Ad esempio, i dati vengono conservati per la durata più lunga di tutti i criteri di conservazione applicati o dei blocchi di eDiscovery.

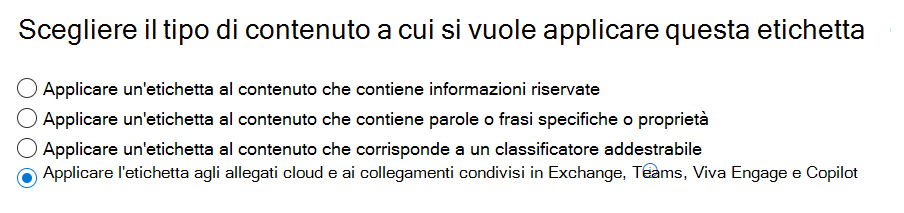

Per consentire alle etichette di conservazione di conservare automaticamente i file a cui si fa riferimento in Copilot, selezionare l'opzione per gli allegati cloud con un criterio di etichetta di conservazione automatica: Applicare l'etichetta agli allegati cloud e ai collegamenti condivisi in Exchange, Teams, Viva Engage e Copilot. Come per tutti gli allegati cloud conservati, la versione del file al momento in cui viene fatto riferimento viene mantenuta.

Per informazioni dettagliate sul funzionamento di questa conservazione, vedere Funzionamento della conservazione con gli allegati cloud.

Per istruzioni di configurazione:

Per configurare i criteri di conformità delle comunicazioni per le interazioni copilot, vedere Creare e gestire i criteri di conformità delle comunicazioni.

Per cercare le interazioni di Copilot nel log di controllo, vedere Cercare nel log di controllo.

Per usare la ricerca di contenuto per trovare le interazioni copilot, vedere Cercare contenuto.

Per usare eDiscovery per le interazioni copilot, vedere Soluzioni Microsoft Purview eDiscovery.

Per creare o modificare un criterio di conservazione per le interazioni copilot, vedere Creare e configurare i criteri di conservazione.

Per creare un criterio di applicazione automatica delle etichette di conservazione per i file a cui si fa riferimento in Copilot, vedere Applicare automaticamente un'etichetta di conservazione per conservare o eliminare il contenuto.

Altra documentazione per l'hub di intelligenza artificiale e Copilot

Annuncio del post di blog: Proteggere i dati per sfruttare in tutta sicurezza l'intelligenza artificiale generativa con Microsoft Purview

Per informazioni più dettagliate, vedere Considerazioni per Microsoft Purview AI Hub e le protezioni per la sicurezza e la conformità dei dati per Microsoft Copilot.

Microsoft Copilot per Microsoft 365:

Commenti e suggerimenti

Presto disponibile: Nel corso del 2024 verranno gradualmente disattivati i problemi di GitHub come meccanismo di feedback per il contenuto e ciò verrà sostituito con un nuovo sistema di feedback. Per altre informazioni, vedere https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per