Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

L'Ingegneria dei dati in Microsoft Fabric consente agli utenti di progettare, creare e gestire infrastrutture e sistemi che consentono alle organizzazioni di raccogliere, archiviare, elaborare e analizzare grandi volumi di dati.

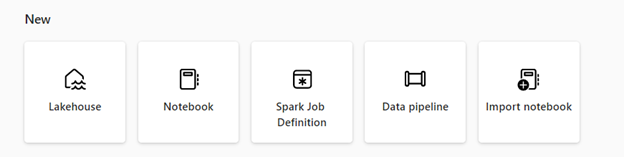

Microsoft Fabric offre varie funzionalità di ingegneria dei dati per garantire che i dati siano facilmente accessibili, ben organizzati e di alta qualità. Per accedere alla home page dell'ingegneria dei dati, selezionare Carichi di lavoro nel riquadro di navigazione e quindi selezionare il riquadro Data Engineering. Dalla home page dell'ingegneria dei dati è possibile:

Creare e gestire i dati utilizzando un data lakehouse

Progettare pipeline per copiare i dati nel tuo sistema di archiviazione integrato (lakehouse)

Usare le definizioni dei processi di Spark per inviare un processo batch/streaming al cluster Spark

Usare i notebook per scrivere un codice per l'inserimento, la preparazione e la trasformazione dei dati

Lakehouse

Le Lakehouse sono architetture di dati che consentono alle organizzazioni di archiviare e gestire dati strutturati e non strutturati in un'unica posizione, usando vari strumenti e framework per elaborare e analizzare tali dati. Questi strumenti e framework possono includere query e analisi basate su SQL, nonché l'apprendimento automatico e altre tecniche di analisi avanzata.

Definizione del job di Apache Spark

Le definizioni dei processi Spark sono un set di istruzioni che definiscono come eseguire un processo in un cluster Spark. Ciò include informazioni quali le origini dati di input e output, le trasformazioni e le impostazioni di configurazione per l'applicazione Spark. La definizione del processo di Spark consente di inviare processi batch/streaming al cluster Spark, applicare una logica di trasformazione diversa ai dati ospitati nella lakehouse, oltre a molti altri strumenti.

Taccuino

I notebook sono un ambiente di elaborazione interattivo che consente agli utenti di creare e condividere documenti contenenti codici live, equazioni, visualizzazioni e testo narrativo. Inoltre, consentono agli utenti di scrivere ed eseguire codici in vari linguaggi di programmazione, tra cui Python, R e Scala. È possibile usare i notebook per l'inserimento, la preparazione, l'analisi e altre attività correlate ai dati.

Pipeline

Le pipeline sono una serie di passaggi che possono raccogliere, elaborare e trasformare i dati dal formato non elaborato a un formato che è possibile usare per l'analisi e il processo decisionale. Sono un componente fondamentale dell'ingegneria dei dati, poiché offrono un modo per spostare i dati dall'origine alla destinazione in modo affidabile, scalabile ed efficiente.

È possibile usare l'Ingegneria dei dati gratuitamente in Microsoft Fabric quando si effettua l'iscrizione per la versione di prova di Fabric. È anche possibile acquistare una capacità di Microsoft Fabric o una capacità riservata di Fabric

Contenuto correlato

Introduzione all'ingegneria dei dati:

- Per altre informazioni sulle lakehouse, vedere Che cos'è una lakehouse in Microsoft Fabric?

- Per iniziare a usare una lakehouse, consultare Creare una lakehouse in Microsoft Fabric.

- Per altre informazioni sulle definizioni dei processi Apache Spark, vedere Che cos'è una definizione del processo di Apache Spark?

- Per iniziare a usare una definizione di processo di Apache Spark, vedere Come creare una definizione del processo di Apache Spark in Fabric.

- Per altre informazioni sui notebook, vedere Creare ed eseguire il notebook.

- Per iniziare a usare l'attività di copia della pipeline, vedere Come copiare i dati usando l'attività di copia.