Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Microsoft Fabric è una soluzione completa di analisi per le aziende che copre tutto il necessario, da spostamento dati ad analisi in tempo reale e business intelligence. Offre una suite completa di servizi, tra cui Data Lake, ingegneria dei dati e integrazione dati, tutto in un'unica posizione. Per altre informazioni, vedere Che cos'è Microsoft Fabric?

Questa esercitazione illustra uno scenario end-to-end dall'acquisizione dei dati all'utilizzo dei dati. Consente di creare una conoscenza di base di Fabric, incluse le diverse esperienze e il modo in cui si integrano, nonché le esperienze di professional e citizen developer fornite con l'uso di questa piattaforma. Questa esercitazione non è progettata per essere un'architettura di riferimento, un elenco completo di funzionalità o un consiglio di procedure consigliate specifiche.

Scenario end-to-end di Lakehouse

Tradizionalmente, le organizzazioni hanno creato data warehouse moderni per le loro esigenze di analisi di dati strutturatli e transazionali. E data lakehouse per esigenze di analisi dei dati di Big Data (semi/non strutturate). Questi due sistemi erano eseguiti in parallelo, creando silo, duplicazione dei dati e aumento del costo totale di proprietà.

Fabric con l'unificazione dell'archivio dati e della standardizzazione nel formato Delta Lake consente di eliminare i silo, rimuovere la duplicazione dei dati e ridurre drasticamente il costo totale di proprietà.

Grazie alla flessibilità offerta da Fabric, è possibile implementare architetture lakehouse o data warehouse oppure combinarle insieme per ottenere il meglio di entrambe con un'implementazione semplice. In questa esercitazione si esaminerà un esempio di organizzazione di vendita al dettaglio e si creerà il relativo lakehouse dall'inizio alla fine. Usa l'architettura medallion in cui il livello bronzo ha i dati non elaborati, il livello argento ha i dati convalidati e deduplicati e il livello oro ha dati estremamente raffinati. È possibile adottare lo stesso approccio per implementare un lakehouse per qualsiasi organizzazione di qualsiasi settore.

Questa esercitazione illustra in che modo uno sviluppatore della società fittizia Wide World Importers nel dominio della vendita al dettaglio completa i passaggi seguenti:

Accedere all'account Power BI e iscriversi per ottenere la versione di valutazione di Microsoft Fabric gratuita. Se non si ha una licenza di Power BI, registrarsi per ottenere una licenza gratuita di Fabric e quindi iniziare la prova gratuita di Fabric.

Creare e implementare un lakehouse end-to-end per l'organizzazione:

- Creare un'area di lavoro di Fabric.

- Creare un lakehouse.

- Inserire i dati, trasformare i dati e caricarli nel lakehouse. È anche possibile esplorare OneLake, una copia dei dati in modalità lakehouse e in modalità endpoint di Analisi SQL.

- Connettersi al lakehouse usando l'endpoint di Analisi SQL e Creare un report di Power BI usando DirectLake per analizzare i dati di vendita tra dimensioni diverse.

- Facoltativamente, è possibile orchestrare e pianificare il flusso di inserimento e trasformazione dei dati con una pipeline.

Pulire le risorse eliminando l'area di lavoro e altri elementi.

Architettura

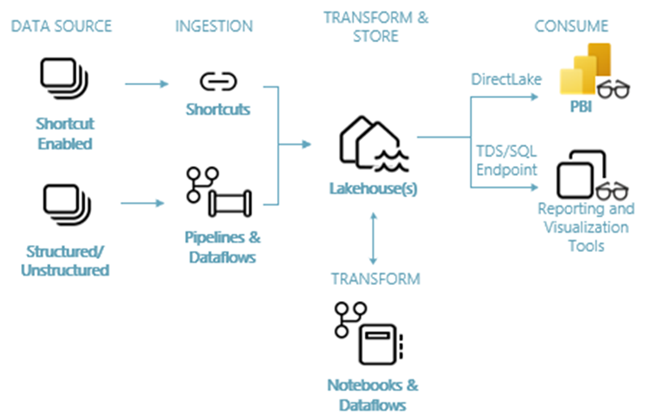

L'immagine seguente mostra l'architettura end-to-end del lakehouse. I componenti coinvolti sono descritti nell’elenco seguente.

Origini dati: Fabric semplifica la connessione a Servizi dati di Azure, oltre ad altre piattaforme basate sul cloud e origini dati locali, per semplificare l'inserimento dei dati.

Inserimento: è possibile creare rapidamente informazioni dettagliate per l'organizzazione usando più di 200 connettori nativi. Questi connettori sono integrati nella pipeline di Fabric e usano la trasformazione dei dati con trascinamento e rilascio intuitivo con il flusso di dati. Inoltre, con la funzionalità Collegamento in Fabric è possibile connettersi ai dati esistenti senza doverli copiare o spostare.

Trasformazione e archiviazione: Fabric si standardizza sul formato Delta Lake. Ciò implica che tutti i motori di Fabric possono accedere e manipolare lo stesso set di dati archiviato in OneLake senza duplicare i dati. Questo sistema di archiviazione offre la flessibilità che consnete di creare lakehouse usando un'architettura medallion o una mesh di dati, a seconda dei requisiti dell'organizzazione. È possibile scegliere tra un'esperienza con poco codice o senza codice per la trasformazione dei dati, usando pipeline/flussi di dati o notebook/Spark per un'esperienza Code First.

Utilizzo: Power BI può usare i dati del lakehouse per la creazione di report e la visualizzazione. Ogni lakehouse ha un endpoint TDS predefinito denominato Endpoint di Analisi SQL per semplificare la connettività e l'esecuzione di query sui dati nelle tabelle lakehouse da altri strumenti di creazione report. L'endpoint di Analisi SQL fornisce agli utenti la funzionalità di connessione SQL.

Set di dati di esempio

Questa esercitazione usa il database di esempio Wide World Importers (WWI) che verrà importato nel lakehouse nell'esercitazione successiva. Per lo scenario end-to-end del lakehouse sono stati generati dati sufficienti per esplorare le funzionalità di scalabilità e prestazioni della piattaforma Fabric.

Wide World Importers (WWI) è un importatore e distributore all'ingrosso di articoli di moda operante nell'area della Baia di San Francisco. Essendo WWI un rivenditore all'ingrosso, i suoi clienti sono prevalentemente aziende che rivendono ai singoli. WWI vende ai clienti della rivendita al dettaglio in tutti il Stati Uniti, tra cui negozi specializzati, supermercati, negozi di informatica, negozi di souvenir e alcuni privati. WWI vende anche ad altri rivenditori all'ingrosso tramite una rete di agenti che promuovono i prodotti per suo conto. Per altre informazioni sul profilo e sulle operazioni aziendali, vedere Database di esempio Wide World Importers per Microsoft SQL.

In generale, i dati vengono portati da sistemi transazionali o applicazioni line-of-business in un lakehouse. Tuttavia, per motivi di semplicità, in questa esercitazione viene usato il modello dimensionale fornito da WWI come origine dati iniziale. Viene usato come origine per inserire i dati in un lakehouse e trasformarli in diverse fasi (Bronzo, Argento e Oro) di un'architettura medallion.

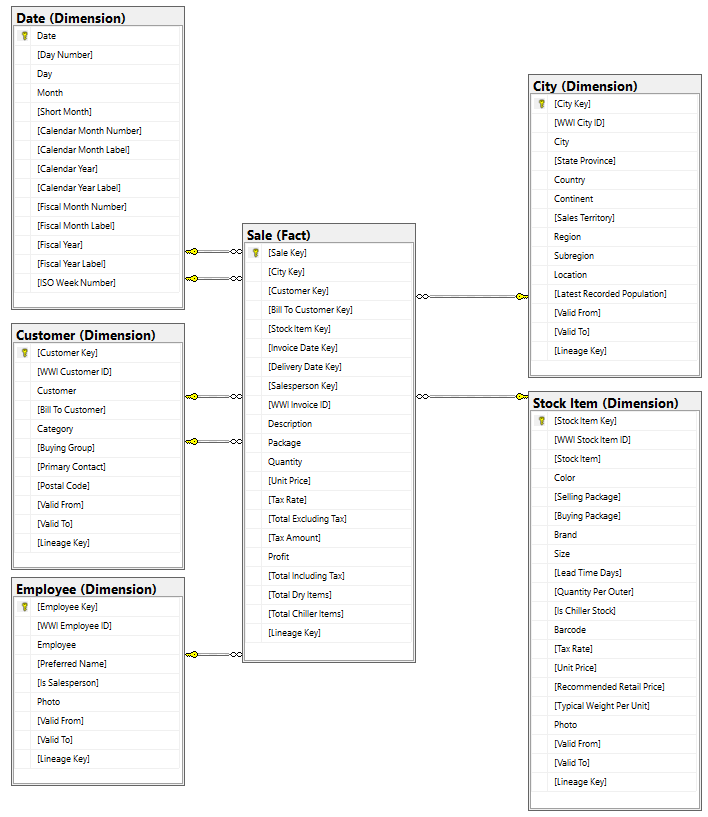

Modello di dati

Mentre il modello dimensionale WWI contiene numerose tabelle dei fatti, per questa esercitazione viene usata la tabella dei fatti Sale e le relative dimensioni correlate. Nell'esempio seguente è illustrato il modello dati di WWI:

Dati e flusso di trasformazione

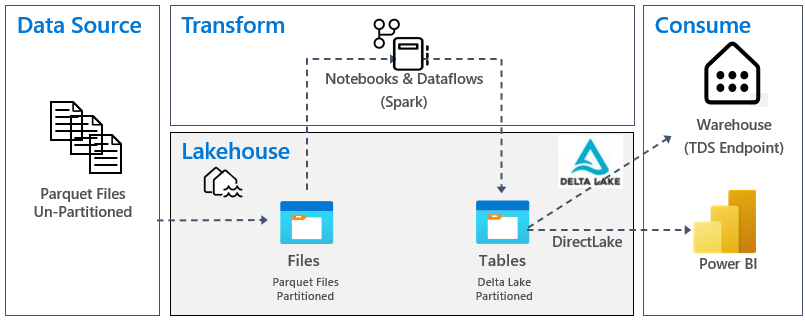

Come descritto in precedenza, vengono usati i dati di esempio di Wide World Importers (WWI) per creare questo lakehouse end-to-end. In questa implementazione, i dati di esempio vengono archiviati in un account di archiviazione dati di Azure in formato file Parquet per tutte le tabelle. Tuttavia, in scenari reali, genrealmente i dati provengono da varie origini e sono in formati diversi.

L'immagine seguente mostra l'origine, la destinazione e la trasformazione dei dati:

Origine dati: i dati di origine sono in formato di file Parquet e in una struttura non partizionata. Vengono archiviati in una cartella per ogni tabella. In questa esercitazione è stata configurata una pipeline per inserire dati OneTime o storici completi nel lakehouse.

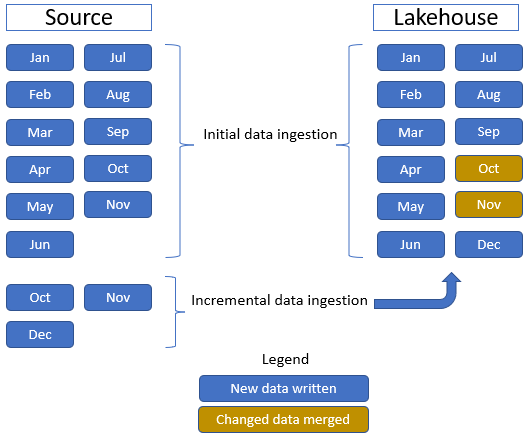

In questa esercitazione viene usata la tabella dei fatti Sale, che contiene una cartella padre con i dati storici per 11 mesi, con una sottocartella per ogni mese, e un'altra cartella contenente dati incrementali per tre mesi, una sottocartella per ogni mese. Durante l'inserimento iniziale dei dati, vengono inseriti 11 mesi di dati nella tabella lakehouse. Tuttavia, all’arrivo dei dati incrementali, include dati aggiornati per ottobre e novembre, i nuovi dati per dicembre, ottobre e novembre vengono uniti ai dati esistenti e i nuovi dati di dicembre vengono scritti nella tabella lakehouse, come illustrato nell'immagine seguente:

Lakehouse: in questa esercitazione si crea un lakehouse, si inseriscono i dati nella sezione File del lakehouse e quindi si creano tabelle Delta Lake nella sezione Tabelle del lakehouse.

Trasformazione: per la preparazione e la trasformazione dei dati vengono visualizzati due approcci diversi. Viene illustrato l'uso di Notebook/Spark per gli utenti che preferiscono un'esperienza ode First e si usano pipeline/flussi di dati per gli utenti che preferiscono un'esperienza con poco codice o senza codice.

Utilizzo: per illustrare l'utilizzo dei dati, si vede come usare la funzionalità DirectLake di Power BI per creare report, dashboard ed eseguire direttamente query sui dati dal lakehouse. Viene inoltre illustrato come rendere i dati disponibili a strumenti di creazione report di terzi usando l'endpoint di Analisi SQL/TDS. Questo endpoint consente di connettersi al warehouse ed eseguire query SQL per l'analisi.