Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Per l'arricchimento dei dati e le informazioni dettagliate aziendali, Microsoft Fabric offre esperienze di data science che consentono agli utenti di creare flussi di lavoro di data science end-to-end. Per iniziare, vedere l'esercitazione end-to-end sull'analisi scientifica dei dati.

È possibile completare un'ampia gamma di attività nell'intero processo di data science:

- Esplorazione dei dati

- preparazione dei dati

- pulizia dei dati

- sperimentazione

- modellazione

- assegnazione dei punteggi del modello

- fornire informazioni dettagliate predittive ai report di business intelligence

Gli utenti di Microsoft Fabric possono accedere a una home page di data science. Possono quindi individuare e accedere a varie risorse pertinenti, come illustrato nello screenshot seguente:

Screenshot della pagina iniziale di data science.

Screenshot della pagina iniziale di data science.

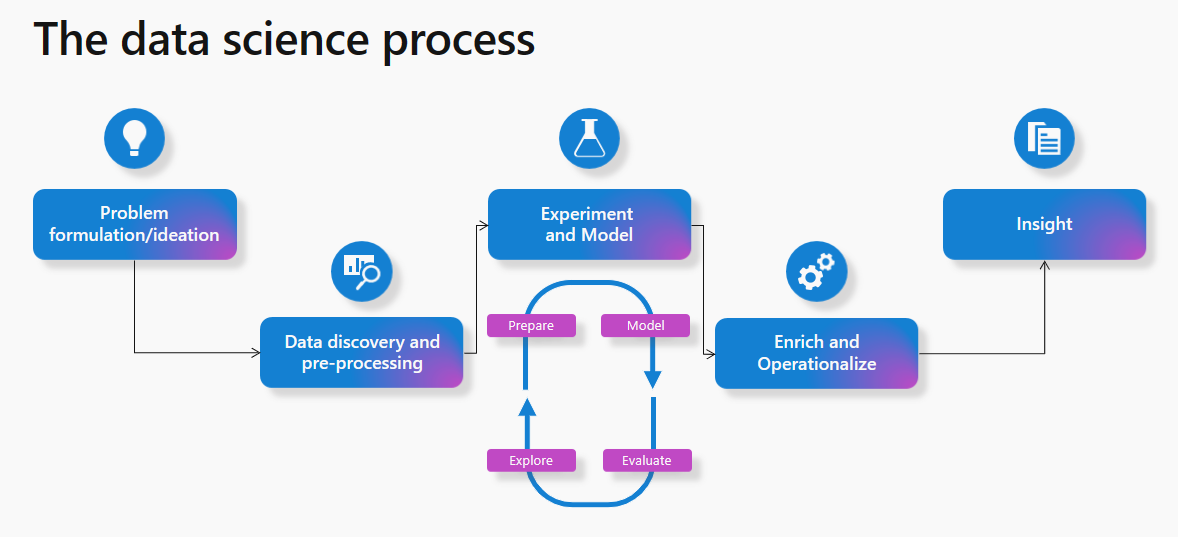

La maggior parte dei progetti di Machine Learning segue il processo di data science. A livello generale, il processo prevede questi passaggi:

- formulazione e ideazione del problema

- individuazione e pre-elaborazione dei dati

- sperimentazione e modellazione

- arricchire e rendere operativi

- creare informazioni dettagliate

Diagramma del processo di data science.

Diagramma del processo di data science.

Questo articolo descrive le funzionalità di data science di Microsoft Fabric dal punto di vista del processo di data science. Per ogni passaggio del processo di data science, il presente articolo riporta un riepilogo delle funzionalità di Microsoft Fabric che possono essere utili.

Formulazione dei problemi e ideazione

Gli utenti di data science in Microsoft Fabric lavorano sulla stessa piattaforma degli utenti aziendali e degli analisti. Di conseguenza, la condivisione dei dati e la collaborazione risultano più semplici. Gli analisti possono condividere facilmente report e set di dati di Power BI con gli esperti di data science. La facilità di collaborazione tra i ruoli in Microsoft Fabric semplifica la fase di formulazione dei problemi.

Individuazione e pre-elaborazione dei dati

Gli utenti di Microsoft Fabric possono interagire con i dati in OneLake usando la risorsa Lakehouse. Per esplorare e interagire con i dati, Lakehouse si collega facilmente a un notebook. Gli utenti possono leggere facilmente i dati da un Lakehouse direttamente in un dataframe Pandas. Per l'esplorazione, le letture fluide dei dati da OneLake diventano possibili.

Un potente set di strumenti è disponibile per l'inserimento dati e le pipeline di orchestrazione dei dati con pipeline di integrazione dei dati, una parte integrata in modo nativo di Microsoft Fabric. Le pipeline facili da compilare possono accedere e trasformare i dati in un formato utilizzabile da Machine Learning.

Esplorazione dei dati

Una parte importante del processo di Machine Learning implica la comprensione dei dati tramite l'esplorazione e la visualizzazione.

A seconda del percorso di archiviazione dei dati, Microsoft Fabric offre strumenti per esplorare e preparare i dati per l'analisi e l'apprendimento automatico. I notebook stessi diventano strumenti di esplorazione dei dati efficienti ed efficaci.

Apache Spark e Python per la preparazione dei dati

Microsoft Fabric può trasformare, preparare ed esplorare i dati su larga scala. Con Spark, gli utenti possono usare gli strumenti PySpark/Python, Scala e SparkR/SparklyR per pre-elaborare i dati su larga scala. Potenti librerie di visualizzazioni open source possono migliorare l'esperienza di esplorazione dei dati per una migliore comprensione dei dati.

Data Wrangler per una perfetta pulizia dei dati

Per usare Data Wrangler, l'esperienza notebook di Microsoft Fabric ha aggiunto una funzionalità dello strumento di codice che prepara i dati e genera codice Python. Questa esperienza semplifica l'accelerazione di attività noiose e banali, ad esempio la pulizia dei dati. Con esso, è anche possibile creare automazione e ripetibilità tramite codice generato. Altre informazioni su Data Wrangler sono disponibili nella sezione Data Wrangler di questo documento.

Sperimentazione e modellazione ML

Con strumenti come PySpark/Python e SparklyR/R, i notebook possono gestire il training dei modelli di Machine Learning. Gli algoritmi e le librerie di Machine Learning consentono di eseguire il training di modelli di Machine Learning. Gli strumenti di gestione delle librerie possono installare queste librerie e algoritmi. Gli utenti possono quindi usare le librerie di Machine Learning più diffuse per completare il training del modello di Machine Learning in Microsoft Fabric. Anche altre librerie note, come Scikit Learn, possono sviluppare dei modelli.

Gli esperimenti e le esecuzioni di MLflow possono tenere traccia del training del modello di Machine Learning. Per registrare esperimenti e modelli, Microsoft Fabric offre un'esperienza MLflow predefinita che supporta l'interazione. Altre informazioni sull'uso di MLflow per tenere traccia degli esperimenti e gestire i modelli in Microsoft Fabric.

SynapseML

Microsoft possiede e gestisce la libreria open source SynapseML (in precedenza nota come MMLSpark). Semplifica la creazione di pipeline di Machine Learning altamente scalabili. Si tratta di un ecosistema di strumenti che espande il framework Apache Spark in diverse nuove direzioni. SynapseML unifica diversi framework di Machine Learning esistenti e nuovi algoritmi Microsoft in un'unica API scalabile. La libreria SynapseML open source include un ricco ecosistema di strumenti di Machine Learning per lo sviluppo di modelli predittivi e usa modelli di intelligenza artificiale con training preliminare dai servizi di intelligenza artificiale di Azure. Per altre informazioni, visitare la risorsa SynapseML .

Arricchire e rendere operativi

I notebook possono gestire l'assegnazione dei punteggi batch del modello di Machine Learning con librerie open source per la stima. Possono anche gestire la funzione Spark Predict universale scalabile di Microsoft Fabric. Questa funzione supporta i modelli in pacchetto MLflow nel registro dei modelli di Microsoft Fabric.

Ottenere informazioni approfondite

In Microsoft Fabric è possibile scrivere facilmente valori stimati in OneLake. Da qui, i report di Power BI possono usarli senza problemi con la modalità Direct Lake di Power BI. I professionisti della data science possono quindi condividere facilmente i risultati del loro lavoro con gli stakeholder e semplifica l'operazionalizzazione.

È possibile usare le funzionalità di pianificazione dei notebook per programmare l'esecuzione di notebook che contengono valutazioni in batch. È anche possibile pianificare l'assegnazione dei punteggi batch come parte delle attività della pipeline o dei processi Spark. Con la modalità Direct Lake in Microsoft Fabric, Power BI ottiene automaticamente le stime più recenti senza bisogno di caricamenti o aggiornamenti dei dati.

Esplorazione dei dati con collegamento semantico

I data scientist e gli analisti aziendali dedicano molto tempo a cercare di comprendere, pulire e trasformare i dati prima di iniziare un'analisi significativa. Gli analisti aziendali mettono in genere a disposizione modelli semantici e codificano la conoscenza del dominio e la logica di business in misure di Power BI. D'altra parte, i data scientist possono lavorare con gli stessi dati, ma in genere usano un ambiente di codice o un linguaggio diverso. Con il collegamento semantico, i data scientist possono stabilire una connessione tra i modelli semantici di Power BI e l'esperienza di data science synapse nell'esperienza di Microsoft Fabric tramite la libreria SemPy Python. Per semplificare l'analisi dei dati, SemPy acquisisce e usa la semantica dei dati mentre gli utenti eseguono varie trasformazioni sui modelli semantici. Quando i data scientist usano il collegamento semantico, possono

- evitare la riapplicazione della logica di business e della conoscenza del dominio nel codice

- accedere e usare facilmente le misure di Power BI nel codice

- usare la semantica per potenziare le nuove esperienze, ad esempio funzioni semantiche

- esplorare e convalidare le dipendenze funzionali e le relazioni tra i dati

Quando le organizzazioni usano SemPy, possono aspettarsi

- una maggiore produttività e una collaborazione più immediata tra i team che operano sugli stessi set di dati

- unja maggiore collaborazione incrociata tra team di business intelligence e team IA

- riduzione dell'ambiguità e una curva di apprendimento più semplice durante l'onboarding in un nuovo modello o set di dati

Per altre informazioni sul collegamento semantico, vedere Che cos'è il collegamento semantico?.

Contenuti correlati

- Per iniziare a usare esempi di data science end-to-end, vedere Esercitazioni di data science

- Per altre informazioni sulla preparazione e la pulizia dei dati con Data Wrangler, vedere Data Wrangler

- Visitare l'esperimento di Machine Learning per altre informazioni sul rilevamento degli esperimenti

- Per altre informazioni sulla gestione dei modelli, vedere Modello di Machine Learning

- Per altre informazioni sull'assegnazione dei punteggi in batch con Predict, vedere Assegnare punteggi ai modelli di punteggio con PREDICT

- Fornire le previsioni del Lakehouse a Power BI con Direct Lake