Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

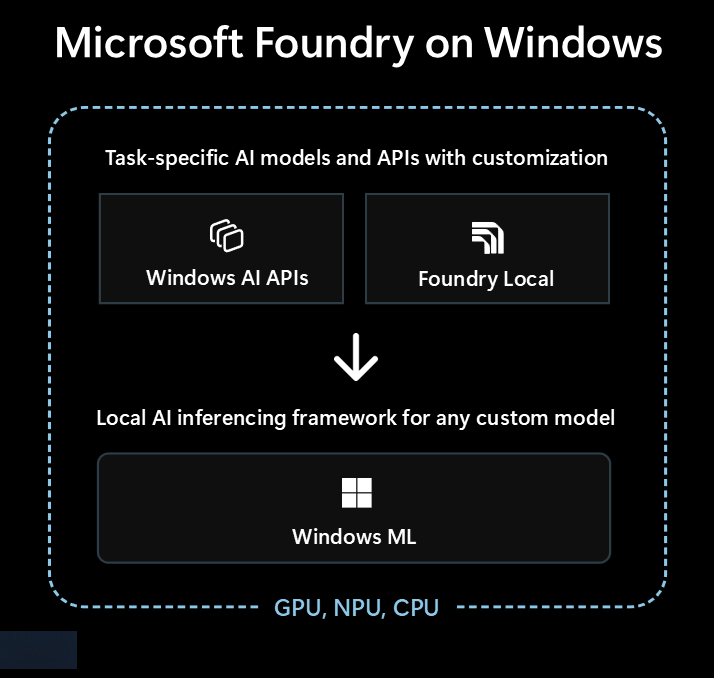

Microsoft Foundry on Windows è la soluzione ideale per gli sviluppatori che vogliono integrare le funzionalità di intelligenza artificiale locale nelle app di Windows.

Microsoft Foundry on Windows fornisce agli sviluppatori...

- Modelli e API di intelligenza artificiale pronti per l'uso tramite Windows AI APIs e Foundry Local

- Framework di inferenza di intelligenza artificiale per eseguire qualsiasi modello in locale tramite Windows ML

Indipendentemente dal fatto che tu sia nuovo all'intelligenza artificiale o un esperto di Machine Learning (ML), Microsoft Foundry on Windows offre qualcosa per te.

Modelli e API di intelligenza artificiale pronti per l'uso

L'app può usare facilmente i modelli e le API di intelligenza artificiale locali seguenti in meno di un'ora. La distribuzione e il runtime dei file di modello vengono gestiti da Microsoft e i modelli vengono condivisi tra le app. L'uso di questi modelli e API richiede solo poche righe di codice, zero competenze di MACHINE Learning necessarie.

| Tipo di modello o API | Cos'è | Opzioni e dispositivi supportati |

|---|---|---|

| Modelli di linguaggio di grandi dimensioni | Modelli di testo generativi | Phi Silica tramite AI APIs (supporta l'ottimizzazione fine) o 20 modelli OSS LLM tramite Foundry Local Per altre informazioni, vedere LOCAL LLMS (LLMS locale ). |

| Descrizione immagine | Ottenere una descrizione del testo in linguaggio naturale di un'immagine | Descrizione immagine tramite AI APIs (Copilot+ PC) |

| Estrattore di primo piano dell'immagine | Segmentare il primo piano di un'immagine | Estrattore del Primo Piano dell'Immagine tramite AI APIs (Copilot+ PC) |

| Generazione di immagini | Generare immagini dal testo | Generazione di immagini tramite AI APIs (Copilot+ PC) |

| Cancellazione dell'oggetto Image | Cancellare oggetti dalle immagini | Cancellazione dell'oggetto Image tramite AI APIs (Copilot+ PC) |

| Estrattore di oggetti Image | Segmentare oggetti specifici in un'immagine | Estrattore di oggetti image tramite AI APIs (Copilot+ PC) |

| Super risoluzione delle immagini | Aumentare la risoluzione delle immagini | Super risoluzione dell'immagine tramite AI APIs (Copilot+ PC) |

| Ricerca semantica | Ricerca semantica di testo e immagini | Ricerca contenuto app tramite AI APIs (Copilot+ PC) |

| Riconoscimento vocale | Convertire il parlato in testo | Sussurrare tramite Foundry Local o riconoscimento vocale tramite Windows SDK Per altre informazioni, vedere Riconoscimento vocale . |

| Riconoscimento del testo (OCR) | Riconoscere il testo dalle immagini | OCR tramite AI APIs (Copilot+ PC) |

| Super Risoluzione Video (VSR) | Aumentare la risoluzione dei video | Risoluzione super video tramite AI APIs (Copilot+ PC) |

Uso di altri modelli con Windows ML

È possibile usare un'ampia gamma di modelli di Hugging Face o altre origini o anche eseguire il training dei propri modelli ed eseguirli localmente in Pc Windows 10 e versioni successive usando Windows ML(la compatibilità del modello e le prestazioni variano in base all'hardware del dispositivo).

Per ulteriori informazioni, consulta Trovare o addestrare modelli da usare con Windows ML.

Quale opzione iniziare con

Seguire questo albero delle decisioni per selezionare l'approccio migliore per l'applicazione e lo scenario:

Controllare se il Windows integrato copre il tuo scenario e se hai come obiettivo i PC Copilot+. Questo è il percorso più veloce per il mercato con un minimo sforzo di sviluppo.

Se Windows AI APIs non ha ciò di cui hai bisogno, oppure se devi supportare Windows 10 e versioni successive, prendi in considerazione Foundry Local per scenari LLM o voice-to-text.

Se hai bisogno di modelli personalizzati, vuoi sfruttare i modelli esistenti di Hugging Face o altre origini o avere requisiti di modello specifici che non sono coperti dalle opzioni precedenti, Windows ML offre la flessibilità di trovare o eseguire il training di modelli personalizzati (e supporta Windows 10 e versioni successive).

La tua app può anche usare una combinazione di tutte e tre queste tecnologie.

Tecnologie disponibili per l'IA locale

In Microsoft Foundry on Windows, sono disponibili le tecnologie seguenti:

| Finestre AI APIs | Foundry Local | Windows ML | |

|---|---|---|---|

| Cos'è | Modelli e API di intelligenza artificiale pronti per l'uso in un'ampia gamma di tipi di attività, ottimizzati per i PC Copilot+ | Modelli LLM e voice-to-text pronti per l'uso | ONNX Runtime framework per l'esecuzione di modelli che trovi o che addestri |

| Dispositivi supportati | PC Copilot+ | PC Windows 10 e versioni successive e multipiattaforma Le prestazioni variano in base all'hardware disponibile, non a tutti i modelli disponibili. |

PC Windows 10 e versioni successive, e su piattaforme diverse utilizzando software open-source ONNX Runtime (Le prestazioni variano in base all'hardware disponibile) |

| Tipi di modello e API disponibili |

LLM Descrizione immagine Estrattore di primo piano dell'immagine Generazione di immagini Cancellazione dell'oggetto Image Estrattore di oggetti Image Super risoluzione delle immagini Ricerca semantica Riconoscimento del testo (OCR) Super Risoluzione Video |

Modelli Linguistici Avanzati (LLMs) da voce a testo Sfogliare 20+ modelli disponibili |

Trovare o addestrare i propri modelli |

| Distribuzione del modello | Ospitato da Microsoft, acquisito in fase di esecuzione e condiviso tra app | Ospitato da Microsoft, acquisito in fase di esecuzione e condiviso tra app | Distribuzione gestita dall'app (le librerie di app possono condividere modelli tra app) |

| Ulteriori informazioni | Leggere la AI APIs documentazione | Leggere la Foundry Local documentazione | Leggere la Windows ML documentazione |

Microsoft Foundry on Windows include anche strumenti per sviluppatori, ad AI Toolkit esempio per Visual Studio Code e AI Dev Gallery , che consentono di creare correttamente funzionalità di intelligenza artificiale.

AI Toolkit per Visual Studio Code è un'estensione di VS Code che consente di scaricare ed eseguire modelli di intelligenza artificiale in locale, incluso l'accesso all'accelerazione hardware per migliorare le prestazioni e la scalabilità tramite DirectML. Può AI Toolkit anche essere utile per:

- Test dei modelli in un playground intuitivo o nell'applicazione con un'API REST.

- Ottimizzare il modello di intelligenza artificiale, sia in locale che nel cloud (in una macchina virtuale) per creare nuove competenze, migliorare l'affidabilità delle risposte, impostare il tono e il formato della risposta.

- Ottimizzazione dei modelli di piccole lingue più diffusi, ad esempio Phi-3 e Mistral.

- Distribuire la funzionalità di intelligenza artificiale nel cloud o con un'applicazione in esecuzione in un dispositivo.

- Sfruttare l'accelerazione hardware per migliorare le prestazioni con le funzionalità di intelligenza artificiale usando DirectML. DirectML è un'API di basso livello che consente all'hardware del dispositivo Windows di accelerare le prestazioni dei modelli di Machine Learning usando la GPU del dispositivo o la NPU. L'associazione di DirectML ai ONNX Runtime è in genere il modo più semplice per gli sviluppatori di implementare l'intelligenza artificiale accelerata dall'hardware agli utenti su larga scala. Per ulteriori informazioni: Panoramica di DirectML.

- Quantizzare e convalidare un modello per l'uso in NPU usando le funzionalità di conversione del modello

Idee per sfruttare l'IA locale

Alcuni modi in cui le app di Windows possono sfruttare l'intelligenza artificiale locale per migliorare le funzionalità e l'esperienza utente includono:

- Le app possono usare modelli LLM di intelligenza artificiale generative per comprendere argomenti complessi da riepilogare, riscrivere, creare report o espandere.

- Le app possono usare i modelli LLM per trasformare il contenuto in formato libero in un formato strutturato che l'app può comprendere.

- Le app possono usare modelli di ricerca semantica che consentono agli utenti di cercare contenuto in modo significativo e di trovare rapidamente contenuto correlato.

- Le app possono usare modelli di elaborazione del linguaggio naturale per ragionare sui requisiti complessi del linguaggio naturale e pianificare ed eseguire azioni per eseguire la richiesta dell'utente.

- Le applicazioni possono usare modelli di manipolazione delle immagini per modificare le immagini in modo intelligente, cancellare o aggiungere i soggetti, migliorare la qualità o generare nuovi contenuti.

- Le app possono usare modelli di diagnostica predittiva per identificare e stimare i problemi e guidare l'utente o farlo per loro.

Uso dei modelli di intelligenza artificiale cloud

Se l'utilizzo delle funzionalità di intelligenza artificiale locale non è il percorso corretto per te, l'uso di modelli e risorse di intelligenza artificiale cloud può essere una soluzione.

Usare le procedure di IA responsabile

Ogni volta che si incorporano le funzionalità di intelligenza artificiale nell'app Di Windows, è consigliabile altamente seguire le linee guida per lo sviluppo di applicazioni e funzionalità di intelligenza artificiale responsabile in Windows.