Merk

Tilgang til denne siden krever autorisasjon. Du kan prøve å logge på eller endre kataloger.

Tilgang til denne siden krever autorisasjon. Du kan prøve å endre kataloger.

Denne veiledningen viser hvordan du importerer den registrerte LightGBMClassifier-modellen du bygde i del 3. Den veiledningen brukte Microsoft Fabric MLflow-modellregisteret for å trene modellen, og deretter utføre batchprediksjoner på et testdatasett lastet inn fra et lakehouse.

Microsoft Fabric lar deg operasjonalisere maskinlæringsmodeller med en skalerbar funksjon kalt PREDICT, som støtter batch-scoring i enhver beregningsmotor. Du kan generere batch-prediksjoner direkte fra en Microsoft Fabric-notebook eller fra en gitt modells produktside. For å lære mer, se PREDICT.

For å generere batch-prediksjoner på testdatasettet, bruker du versjon 1 av den trente LightGBM-modellen som demonstrerte best ytelse blant alle trente maskinlæringsmodeller. Du laster testdatasett inn i en Spark DataFrame og oppretter et MLFlowTransformer-objekt for å generere batch-prediksjoner. Du kan deretter påkalle PREDICT-funksjonen ved å bruke en av følgende tre måter:

- Transformer API fra SynapseML

- Spark SQL API

- Brukerdefinert PySpark-funksjon (UDF)

Forutsetninger

Få et Microsoft Fabric-abonnement. Eller registrer deg for en gratis Prøveversjon av Microsoft Fabric.

Logg på Microsoft Fabric.

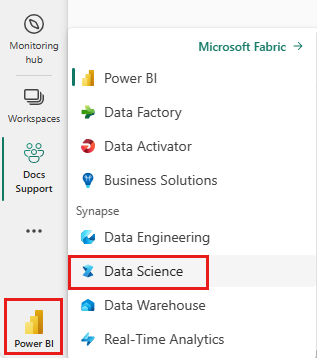

Bytt til Fabric ved å bruke erfaringsbryteren nederst til venstre på hjemmesiden din.

Dette er del 4 av en femdelt veiledningsserie. Hvis du vil fullføre denne opplæringen, må du først fullføre:

- del 1: Innta data i et Microsoft Fabric lakehouse ved hjelp av Apache Spark.

- del 2: Utforske og visualisere data ved hjelp av Microsoft Fabric-notatblokker for å lære mer om dataene.

- del 3: Lær opp og registrer maskinlæringsmodeller.

%pip install scikit-learn==1.6.1

Følg med i notatblokken

4-predict.ipynb er notatblokken som følger med denne opplæringen.

Hvis du vil åpne den medfølgende notatblokken for denne opplæringen, følger du instruksjonene i Klargjøre systemet for opplæringer om datavitenskap importere notatblokken til arbeidsområdet.

Hvis du heller vil kopiere og lime inn koden fra denne siden, kan du opprette en ny notatblokk.

Pass på å feste et lakehouse til notatblokken før du begynner å kjøre kode.

Viktig

Fest det samme lakehouse du brukte i de andre delene av denne serien.

Laste inn testdataene

I følgende kodesnippet, last inn testdataene du lagret i del 3:

df_test = spark.read.format("delta").load("Tables/df_test")

display(df_test)

FORUTSI med Transformer-API-en

For å bruke Transformer API fra SynapseML må du først opprette et MLFlowTransformer-objekt.

Instantiate MLFlowTransformer-objekt

MLFlowTransformer-objektet fungerer som en wrapper rundt MLFlow-modellen du registrerte i del 3. Den lar deg generere satsvise prognoser på en gitt DataFrame. For å instansiere MLFlowTransformer-objektet må du oppgi følgende parametere:

- Testkolonnene DataFrame som modellen trenger som input (i dette tilfellet trenger modellen alle)

- Et navn på den nye utdatakolonnen (i dette tilfellet prediksjoner)

- Det riktige modellnavnet og modellversjonen for å generere prediksjonene (i dette tilfellet

lgbm_smog versjon 1)

Følgende kodeutdrag håndterer disse stegene:

from synapse.ml.predict import MLFlowTransformer

model = MLFlowTransformer(

inputCols=list(df_test.columns),

outputCol='predictions',

modelName='lgbm_sm',

modelVersion=1

)

Nå som du har MLFlowTransformer-objektet, kan du bruke det til å generere batchprediksjoner, som vist i følgende kodeutdrag:

import pandas

predictions = model.transform(df_test)

display(predictions)

FORUTSI med Spark SQL-API-en

Følgende kodebit bruker Spark SQL API for å kalle PREDICT-funksjonen:

from pyspark.ml.feature import SQLTransformer

# Substitute "model_name", "model_version", and "features" below with values for your own model name, model version, and feature columns

model_name = 'lgbm_sm'

model_version = 1

features = df_test.columns

sqlt = SQLTransformer().setStatement(

f"SELECT PREDICT('{model_name}/{model_version}', {','.join(features)}) as predictions FROM __THIS__")

# Substitute "X_test" below with your own test dataset

display(sqlt.transform(df_test))

FORUTSI med en brukerdefinert funksjon (UDF)

Følgende kodesnippet bruker en PySpark UDF for å kalle PREDICT-funksjonen:

from pyspark.sql.functions import col, pandas_udf, udf, lit

# Substitute "model" and "features" below with values for your own model name and feature columns

my_udf = model.to_udf()

features = df_test.columns

display(df_test.withColumn("predictions", my_udf(*[col(f) for f in features])))

Du kan også generere PREDICT-kode fra elementsiden i en modell. For mer informasjon om PREDICT-funksjonen, se Maskinlæringsmodellvurdering med PREDICT-ressurs .

Skrive prognoseresultater for modell til lakehouse

Etter at du har generert batchprediksjoner, skriver modellprediksjonsresultatene tilbake til lakehouse som vist i følgende kodesnippet:

# Save predictions to lakehouse to be used for generating a Power BI report

table_name = "df_test_with_predictions_v1"

predictions.write.format('delta').mode("overwrite").save(f"Tables/{table_name}")

print(f"Spark DataFrame saved to delta table: {table_name}")

Neste trinn

Fortsett til: