Merk

Tilgang til denne siden krever autorisasjon. Du kan prøve å logge på eller endre kataloger.

Tilgang til denne siden krever autorisasjon. Du kan prøve å endre kataloger.

Disse opplæringene presenterer et fullstendig ende-til-ende-scenario i stoffdatavitenskapsopplevelsen. De dekker hvert trinn, fra

- Datainntak

- Datarengjøring

- Dataforberedelse

til

- Opplæring i maskinlæringsmodell

- Innsiktsgenerering

og deretter dekke forbruket av disse innsiktene med visualiseringsverktøy – for eksempel Power BI.

Personer som er nye i Microsoft Fabric, bør gå til Hva er Microsoft Fabric?.

Introduksjon

En livssyklus for datavitenskapsprosjekt omfatter vanligvis disse trinnene:

- Forstå forretningsreglene

- Hent dataene

- Utforske, rense, klargjøre og visualisere dataene

- Kalibrer modellen og spor eksperimentet

- Få modellen og generer innsikt

Trinnene fortsetter ofte iterativt. Målene og suksesskriteriene for hvert trinn avhenger av samarbeid, datadeling og dokumentasjon. Fabric Data Science-opplevelsen omfatter flere innebygde funksjoner som muliggjør sømløst samarbeid, datainnsamling, deling og forbruk.

Disse opplæringene plasserer deg i rollen som en dataforsker som må utforske, rense og transformere et datasett som inneholder frafallsstatusen til 10 000 bankkunder. Deretter bygger du en maskinlæringsmodell for å forutsi hvilke bankkunder som sannsynligvis vil forlate.

Du utfører følgende aktiviteter i opplæringene:

- Bruke Fabric-notatblokkene for datavitenskapsscenarioer

- Bruk Apache Spark til å innta data i et fabric lakehouse

- Laste inn eksisterende data fra deltatabellene i lakehouse

- Bruke Apache Spark- og Python-baserte verktøy til å rense og transformere data

- Opprett eksperimenter og kjøringer for å lære opp ulike maskinlæringsmodeller

- Bruk MLflow og Fabric UI til å registrere og spore opplærte modeller

- Kjør scoring i stor skala, og lagre prognoser og slutningsresultater til lakehouse

- Bruke DirectLake til å visualisere prognoser i Power BI

Arkitektur

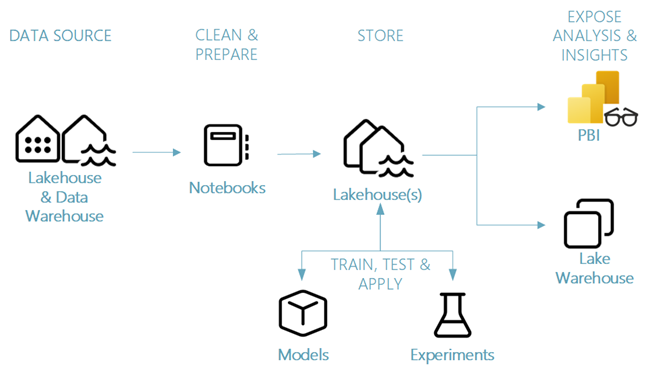

Denne opplæringsserien viser et forenklet scenario for ende-til-ende-datavitenskap som involverer:

- Datainntak fra en ekstern datakilde.

- Datautforskning og -rengjøring.

- Opplæring og registrering av maskinlæringsmodell.

- Satsvis poengsum og prognosesparing.

- Prognoseresultatvisualisering i Power BI.

Ulike komponenter i datavitenskapsscenarioet

Datakilder – Hvis du vil innta data med Fabric, kan du enkelt og raskt koble til Azure Data Services, andre skyplattformer og lokale dataressurser. Med Fabric Notebooks kan du innta data fra disse ressursene:

- Innebygde Lakehouses

- Datalagre

- Semantic models

- Ulike Apache Spark-datakilder

- Ulike datakilder som støtter Python

Denne opplæringsserien fokuserer på datainntak og innlasting fra et lakehouse.

Utforsk, rengjøre og klargjøre – Stoffdatavitenskapsopplevelsen støtter datarengjøring, transformasjon, utforskning og medstreking. Den bruker innebygde Spark-opplevelser og Python-baserte verktøy – for eksempel Data Wrangler og SemPy Library. Denne opplæringen viser datautforskning med Python-biblioteket, og datarengjøring seaborn og forberedelser med Apache Spark.

Modeller og eksperimenter – Med Fabric kan du lære opp, evaluere og få maskinlæringsmodeller med innebygde eksperimenter. Hvis du vil registrere og distribuere modellene og spore eksperimenter, tilbyr MLflow sømløs integrering med Fabric som en måte å modellere elementer på. For å bygge og dele forretningsinnsikter tilbyr Fabric andre funksjoner for modellprognose i stor skala (PREDICT), for å bygge og dele forretningsinnsikter.

Storage - Fabric standardiserer på Delta Lake, noe som betyr at alle Fabric-motorer kan samhandle med det samme datasettet som er lagret i et innsjøhus. Med dette lagringslaget kan du lagre både strukturerte og ustrukturerte data som støtter både filbasert lagring og tabellformat. Du kan enkelt få tilgang til datasettene og lagrede filer gjennom alle stoffopplevelseselementer – for eksempel notatblokker og datasamlebånd.

Eksponer analyse og innsikt – Power BI, et bransjeledende forretningsanalyseverktøy, kan bruke lakehouse-data for rapport- og visualiseringsgenerering. I notatblokkressurser, Python- eller Spark-opprinnelige visualiseringsbiblioteker

matplotlibseabornplotly- etc.

kan visualisere data som vedvarer i et lakehouse. SemPy-biblioteket støtter også datavisualisering. Dette biblioteket støtter innebygde rike, oppgavespesifikke visualiseringer for

- Den semantiske datamodellen

- Avhengigheter og brudd på dem

- Klassifiserings- og regresjonsbrukstilfeller