Notitie

Voor toegang tot deze pagina is autorisatie vereist. U kunt proberen u aan te melden of de directory te wijzigen.

Voor toegang tot deze pagina is autorisatie vereist. U kunt proberen de mappen te wijzigen.

In dit artikel stelt u geautomatiseerde machine learning-trainingstaken in met behulp van Geautomatiseerde ML van Azure Machine Learning in Azure Machine Learning-studio. Met deze methode kunt u de taak instellen zonder code te schrijven. Geautomatiseerde ML is een proces waarbij Azure Machine Learning het beste machine learning-algoritme voor uw specifieke gegevens selecteert. Met het proces kunt u snel machine learning-modellen genereren. Zie het overzicht van het geautomatiseerde ML-proces voor meer informatie.

Dit artikel bevat een algemeen overzicht van het werken met Geautomatiseerde ML in de studio. De volgende artikelen bevatten gedetailleerde instructies voor het werken met specifieke machine learning-modellen:

- Classificatie: Zelfstudie: Een classificatiemodel trainen met Geautomatiseerde ML in de studio

- Tijdreeksprognose: Zelfstudie: Vraag voorspellen met geautomatiseerde ML in de studio

- Natural Language Processing (NLP): Geautomatiseerde ML instellen om een NLP-model te trainen (Azure CLI of Python SDK)

- Computer Vision: AutoML instellen voor het trainen van Computer Vision-modellen (Azure CLI of Python SDK)

- Regressie: een regressiemodel trainen met Geautomatiseerde ML (Python SDK)

Vereisten

Een Azure-abonnement. U kunt een gratis of betaald account maken voor Azure Machine Learning.

Een Azure Machine Learning-werkruimte of rekenproces. Zie quickstart: Aan de slag met Azure Machine Learning om deze resources voor te bereiden.

Een gegevensasset die moet worden gebruikt voor de geautomatiseerde ML-trainingstaak. In dit artikel wordt beschreven hoe u een bestaande gegevensasset selecteert of een gegevensasset maakt op basis van een gegevensbron, zoals een lokaal bestand, een web-URL of een gegevensarchief. Zie Gegevensassets maken en beheren voor meer informatie.

Belangrijk

Er zijn twee vereisten voor de trainingsgegevens:

- De gegevens moeten in tabelvorm zijn.

- De waarde die moet worden voorspeld (de doelkolom ) moet aanwezig zijn in de gegevens.

Experiment maken

Maak en voer een experiment uit door de volgende stappen uit te voeren:

Meld u aan bij Azure Machine Learning-studio en selecteer uw abonnement en werkruimte.

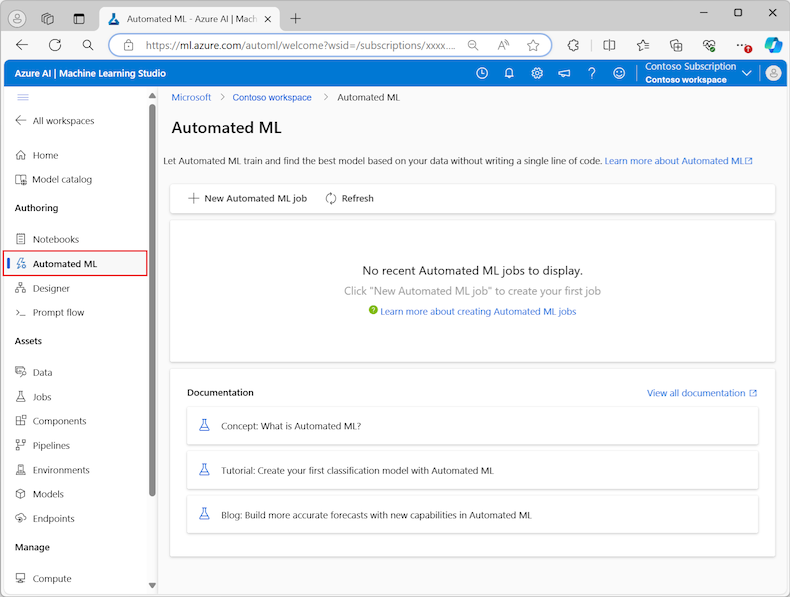

In de sectie Ontwerpen van het linkermenu, selecteer geautomatiseerde ML.

De eerste keer dat u met experimenten in de studio werkt, ziet u een lege lijst en koppelingen naar documentatie. Anders ziet u een lijst met uw recente geautomatiseerde ML-experimenten, inclusief items die zijn gemaakt met de Azure Machine Learning SDK.

Selecteer Nieuwe geautomatiseerde ML-taak om het geautomatiseerde ML-taakproces verzenden te starten.

Standaard selecteert het proces de optie Automatisch trainen op het tabblad Trainingsmethode en gaat verder met de configuratie-instellingen.

Voer op het tabblad Basisinstellingen waarden in voor de vereiste instellingen, inclusief de taaknaam en de naam van het experiment. U kunt desgewenst ook waarden opgeven voor de optionele instellingen.

Selecteer Volgende om door te gaan.

Gegevensasset identificeren

Op het tabblad Taaktype & gegevens geeft u de gegevensasset op voor het experiment en het machine learning-model dat moet worden gebruikt om de gegevens te trainen.

In dit artikel kunt u een bestaande gegevensasset gebruiken of een nieuwe gegevensasset maken op basis van een bestand op uw lokale computer. De pagina's van de gebruikersinterface van Studio worden gewijzigd op basis van uw selectie voor de gegevensbron en het type trainingsmodel.

Als u ervoor kiest om een bestaande gegevensasset te gebruiken, kunt u doorgaan naar de sectie Trainingsmodel configureren.

Voer de volgende stappen uit om een nieuwe gegevensasset te maken:

Als u een nieuwe gegevensasset wilt maken op basis van een bestand op uw lokale computer, selecteert u Maken.

Op de pagina Gegevenstype :

- Voer de naam van een gegevensasset in .

- Voor het type selecteert u Tabellair in de vervolgkeuzelijst.

- Selecteer Volgende.

Selecteer op de pagina Gegevensbron de optie Uit lokale bestanden.

Machine Learning Studio voegt extra opties toe aan het linkermenu waarmee u de gegevensbron kunt configureren.

Selecteer Volgendeom door te gaan naar de pagina Doelopslagtype, waar u de Azure Storage-locatie opgeeft om uw gegevensasset te uploaden.

U kunt de standaardopslagcontainer opgeven die automatisch met uw werkruimte wordt gemaakt of een opslagcontainer kiezen die u voor het experiment wilt gebruiken.

- Selecteer Azure Blob Storage voor het gegevensarchieftype.

- Selecteer workspaceblobstore in de lijst met gegevensarchieven.

- Selecteer Volgende.

Gebruik op de pagina Bestand en mapselectie de vervolgkeuzelijst Bestanden of mappen uploaden en selecteer de optie Bestanden uploaden of Map uploaden.

- Blader naar de locatie van de gegevens die u wilt uploaden en selecteer Openen.

- Nadat de bestanden zijn geüpload, selecteert u Volgende.

Machine Learning Studio valideert uw gegevens en uploadt deze.

Notitie

Als uw gegevens zich achter een virtueel netwerk bevinden, moet u de validatiefunctie Overslaan inschakelen om ervoor te zorgen dat de werkruimte toegang heeft tot uw gegevens. Zie Azure Machine Learning-studio gebruiken in een virtueel Azure-netwerk voor meer informatie.

Controleer op de pagina Instellingen de geüploade gegevens op nauwkeurigheid. De velden op de pagina worden vooraf ingevuld op basis van het bestandstype van uw gegevens:

Veld Beschrijving Bestandsindeling Definieert de indeling en het type gegevens dat is opgeslagen in een bestand. Scheidingsteken Identificeert een of meer tekens voor het opgeven van de grens tussen afzonderlijke, onafhankelijke regio's in tekst zonder opmaak of andere gegevensstromen. Codering Identificeert welke bit-naar-tekenschematabel er moet gebruikt worden om uw gegevensset te lezen. Kolomkoppen Geeft aan hoe de headers van de gegevensset, indien aanwezig, worden behandeld. Rijen overslaan Geeft aan hoeveel rijen er eventueel worden overgeslagen in de gegevensset. Selecteer Volgendeom door te gaan naar de pagina Schema. Deze pagina wordt ook vooraf ingevuld op basis van uw instellingenselecties . U kunt het gegevenstype voor elke kolom configureren, de kolomnamen controleren en kolommen beheren:

- Als u het gegevenstype voor een kolom wilt wijzigen, gebruikt u het vervolgkeuzemenu Type om een optie te selecteren.

- Als u een kolom wilt uitsluiten van de gegevensasset, schakelt u de optie Opnemen voor de kolom in.

Selecteer Volgendeom door te gaan naar de pagina Controleren. Bekijk de samenvatting van uw configuratie-instellingen voor de taak en selecteer vervolgens Maken.

Trainingsmodel configureren

Wanneer de gegevensasset gereed is, keert Machine Learning Studio terug naar het tabblad Taaktype & gegevens van het geautomatiseerde ML-taakproces verzenden . De nieuwe gegevensasset wordt weergegeven op de pagina.

Volg deze stappen om de taakconfiguratie te voltooien:

Vouw het vervolgkeuzemenu Taaktype selecteren uit en kies het trainingsmodel dat u voor het experiment wilt gebruiken. De opties zijn onder andere classificatie, regressie, tijdreeksprognose, natuurlijke taalverwerking (NLP) of computer vision. Zie de beschrijvingen van de ondersteunde taaktypen voor meer informatie over deze opties.

Nadat u het trainingsmodel hebt opgegeven, selecteert u uw gegevensset in de lijst.

Selecteer Volgendeom door te gaan naar het tabblad Taakinstellingen.

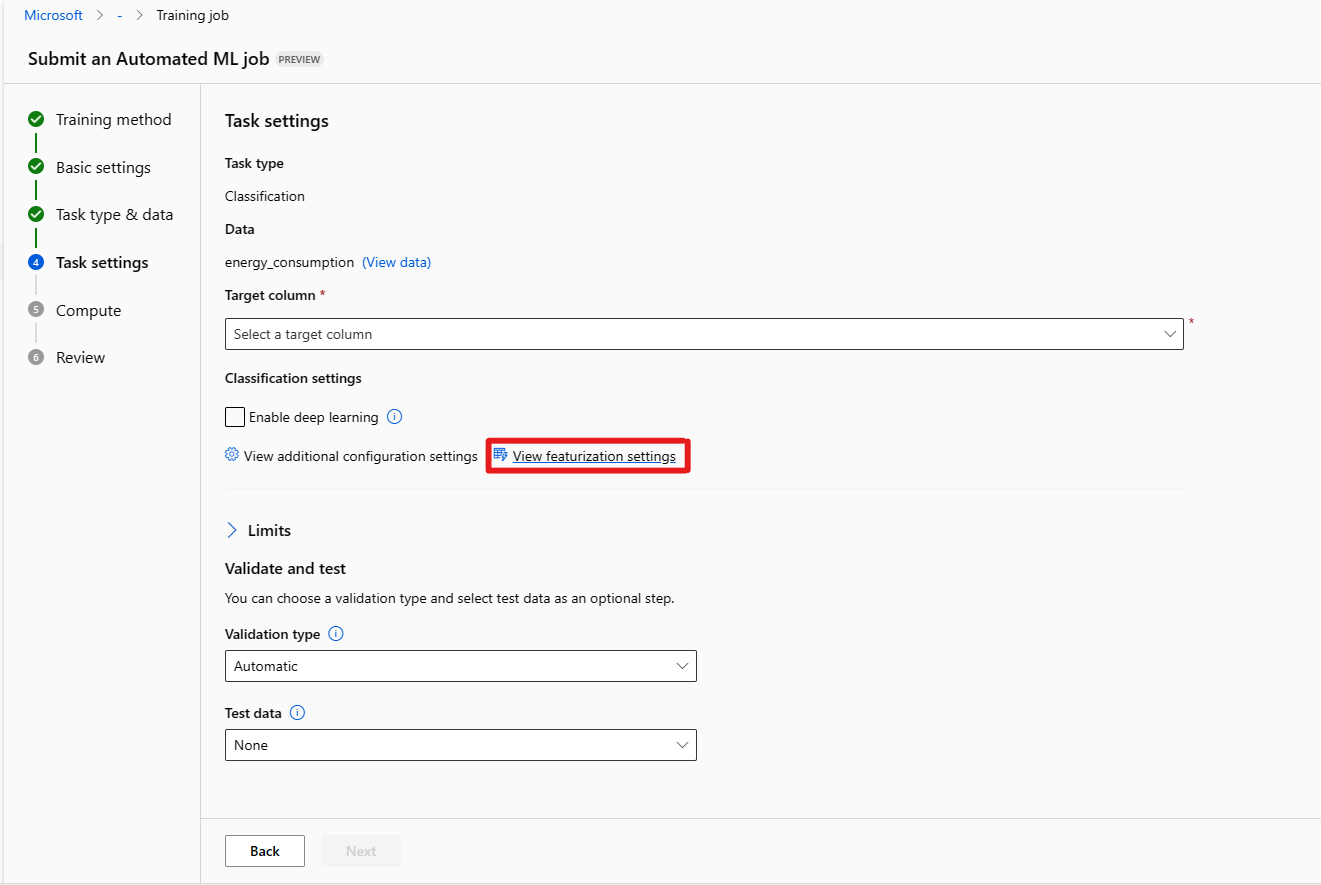

Selecteer in de vervolgkeuzelijst Doelkolom de kolom die u wilt gebruiken voor de modelvoorspellingen.

Configureer de volgende vereiste instellingen, afhankelijk van uw trainingsmodel:

Classificatie: Kies of u deep learning wilt inschakelen.

Tijdreeksprognose: Kies of u Deep Learning wilt inschakelen en bevestig uw voorkeuren voor de vereiste instellingen:

Gebruik de optie Tijdkolom om de tijdgegevens op te geven die in het model moeten worden gebruikt.

Kies of u een of meer autodetectieopties wilt inschakelen. Wanneer u de selectie van een autodetectieoptie opheffen, zoals de horizon van De automatische detectie, kunt u een specifieke waarde opgeven. De waarde van de voorspellende horizon geeft aan hoeveel tijdseenheden (minuten/uren/dagen/weken/maanden/jaren) het model voor de toekomst kan voorspellen. Hoe verder in de toekomst het model is vereist om te voorspellen, hoe minder nauwkeurig het model wordt.

Zie Geautomatiseerde ML gebruiken om een tijdreeksprognosemodel te trainen voor meer informatie over het configureren van deze instellingen.

Verwerking van natuurlijke taal: bevestig uw voorkeuren voor de vereiste instellingen:

Gebruik de optie Subtype selecteren om het subclassificatietype voor het NLP-model te configureren. U kunt kiezen uit classificatie met meerdere klassen, classificatie met meerdere labels en NER (Named Entity Recognition).

Geef in de sectie Opruimen-instellingen waarden op voor de Slack-factor en het sampling-algoritme.

Configureer in de sectie Zoekruimte de opties voor het modelalgoritmen .

Zie Geautomatiseerde ML instellen voor het trainen van een NLP-model (Azure CLI of Python SDK) voor meer informatie over het configureren van deze instellingen.

Computer Vision: Kies of u handmatig opruimen wilt inschakelen en bevestig uw voorkeuren voor de vereiste instellingen:

- Gebruik de optie Subtype selecteren om het subclassificatietype voor het Computer Vision-model te configureren. U kunt kiezen uit afbeeldingsclassificatie (meerdere klassen) of (multilabel), objectdetectie en veelhoek (exemplaarsegmentatie).

Zie AutoML instellen voor het trainen van Computer Vision-modellen (Azure CLI of Python SDK) voor meer informatie over het configureren van deze instellingen.

Optionele instellingen opgeven

Machine Learning Studio biedt optionele instellingen die u kunt configureren op basis van uw machine learning-modelselectie. In de volgende secties worden de extra instellingen beschreven.

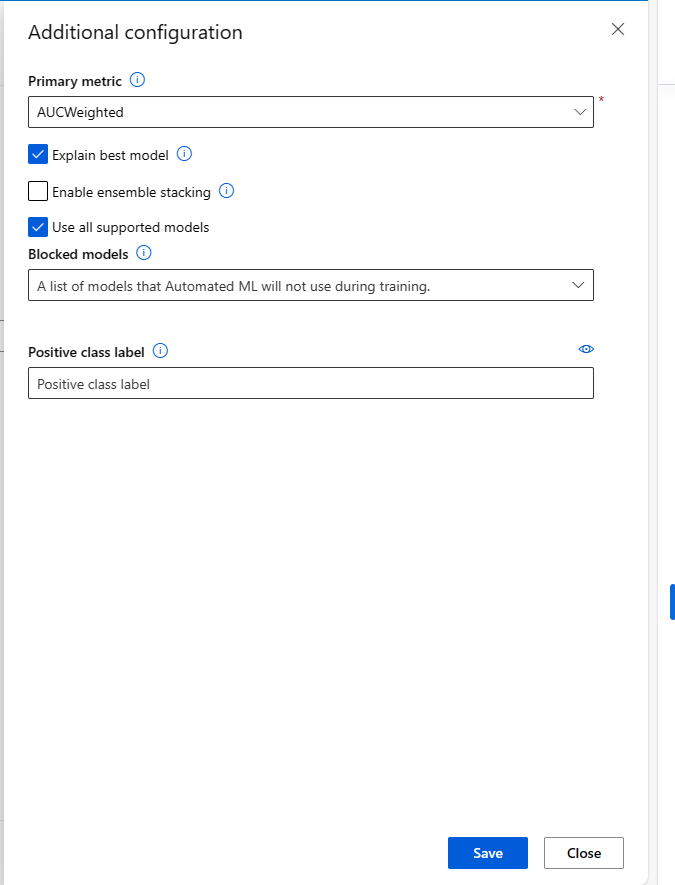

Aanvullende instellingen configureren

U kunt de optie Aanvullende configuratie-instellingen weergeven selecteren om acties te zien die moeten worden uitgevoerd op de gegevens ter voorbereiding op de training.

Op de pagina Aanvullende configuratie worden standaardwaarden weergegeven op basis van uw experimentselectie en -gegevens. U kunt de standaardwaarden gebruiken of de volgende instellingen configureren:

| Instelling | Beschrijving |

|---|---|

| Primaire metrische gegevens | Identificeer de belangrijkste metrische gegevens voor het scoren van uw model. Zie metrische modelgegevens voor meer informatie. |

| Ensemblestacking inschakelen | U kunt ensemble learning toestaan en machine learning-resultaten en voorspellende prestaties verbeteren door meerdere modellen te combineren in plaats van één model te gebruiken. Zie ensemblemodellen voor meer informatie. |

| Alle ondersteunde modellen gebruiken | Gebruik deze optie om geautomatiseerde ML te instrueren of alle ondersteunde modellen in het experiment moeten worden gebruikt. Zie de ondersteunde algoritmen voor elk taaktype voor meer informatie. - Selecteer deze optie om de instelling Geblokkeerde modellen te configureren. - Schakel deze optie uit om de instelling Toegestane modellen te configureren. |

| Geblokkeerde modellen | (Beschikbaar wanneer Alle ondersteunde modellen worden geselecteerd) Gebruik de vervolgkeuzelijst en selecteer de modellen die u wilt uitsluiten van de trainingstaak. |

| Toegestane modellen | (Beschikbaar wanneer Alle ondersteunde modellen worden niet geselecteerd) Gebruik de vervolgkeuzelijst en selecteer de modellen die u wilt gebruiken voor de trainingstaak. Belangrijk: alleen beschikbaar voor SDK-experimenten. |

| Het beste model uitleggen | Kies deze optie om automatisch uitleg weer te geven over het beste model dat is gemaakt door Geautomatiseerde ML. |

| Label van positieve klasse | Voer het label in voor Geautomatiseerde ML dat moet worden gebruikt voor het berekenen van binaire metrische gegevens. |

Instellingen voor featurization configureren

U kunt de optie Weergave-instellingen selecteren om acties te zien die moeten worden uitgevoerd op de gegevens ter voorbereiding op de training.

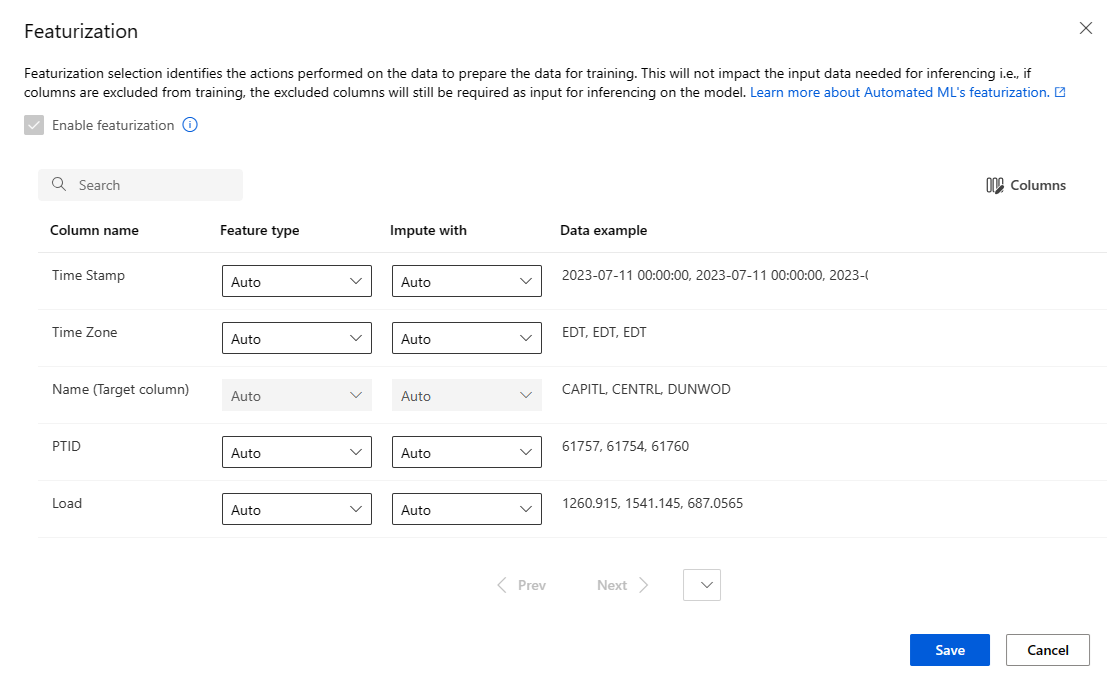

Op de pagina Featurization worden standaardmetrisatietechnieken voor uw gegevenskolommen weergegeven. U kunt automatische featurisatie in- of uitschakelen en de instellingen voor automatische featurisatie voor uw experiment aanpassen.

Selecteer de optie Featurization inschakelen om configuratie toe te staan.

Belangrijk

Wanneer uw gegevens niet-numerieke kolommen bevatten, is featurization altijd ingeschakeld.

Configureer elke beschikbare kolom naar wens. De volgende tabel bevat een overzicht van de aanpassingen die momenteel beschikbaar zijn via de studio.

Kolom Aanpassing Functietype Wijzig het waardetype voor de geselecteerde kolom. Impute with Selecteer met welke waarde ontbrekende waarden in uw gegevens moeten worden opgenomen.

De instellingen voor featurization hebben geen invloed op de invoergegevens die nodig zijn voor deductie. Als u kolommen uitsluit van training, zijn de uitgesloten kolommen nog steeds vereist als invoer voor deductie op het model.

Limieten voor de taak configureren

De sectie Limieten bevat configuratieopties voor deze instellingen:

| Instelling | Beschrijving | Waarde |

|---|---|---|

| Maximum aantal proefversies | Geef het maximum aantal experimenten op dat moet worden geprobeerd tijdens de geautomatiseerde ML-taak, waarbij elke proefversie een andere combinatie van algoritme en hyperparameters heeft. | Geheel getal tussen 1 en 1.000 |

| Maximaal aantal gelijktijdige proefversies | Geef het maximum aantal proeftaken op dat parallel kan worden uitgevoerd. | Geheel getal tussen 1 en 1.000 |

| Maximum aantal knooppunten | Geef het maximum aantal knooppunten op dat door deze taak kan worden gebruikt vanuit het geselecteerde rekendoel. | 1 of meer, afhankelijk van de rekenconfiguratie |

| Drempelwaarde voor metrische score | Voer de drempelwaarde voor de metrische iteratiewaarde in. Wanneer de iteratie de drempelwaarde bereikt, wordt de trainingstaak beëindigd. Houd er rekening mee dat zinvolle modellen een correlatie hebben die groter is dan nul. Anders is het resultaat hetzelfde als raden. | Gemiddelde metrische drempel tussen grenzen [0, 10] |

| Time-out van experiment (minuten) | Geef de maximale tijd op waarop het hele experiment kan worden uitgevoerd. Nadat het experiment de limiet heeft bereikt, annuleert het systeem de geautomatiseerde ML-taak, inclusief alle experimenten (onderliggende taken). | Aantal minuten |

| Time-out voor iteratie (minuten) | Geef de maximale tijd op waarop elke proeftaak kan worden uitgevoerd. Nadat de proeftaak deze limiet heeft bereikt, annuleert het systeem deze. | Aantal minuten |

| Vroegtijdige beëindiging inschakelen | Gebruik deze optie om de taak te beëindigen wanneer de score op korte termijn niet wordt verbeterd. | Selecteer de optie om een vroeg einde van de taak in te schakelen |

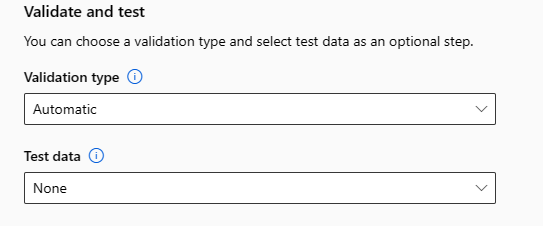

Valideren en testen

De sectie Valideren en testen biedt de volgende configuratieopties:

Geef het validatietype op dat moet worden gebruikt voor uw trainingstaak. Als u niet expliciet een

validation_dataofn_cross_validationsparameter opgeeft, past Automated ML standaardtechnieken toe, afhankelijk van het aantal rijen in de datasettraining_datamet één gegevensverzameling.Grootte van trainingsgegevens Validatietechniek Groter dan 20.000 rijen De gegevenssplitsing train/validatie wordt toegepast. De standaardinstelling is om 10% van de initiële trainingsgegevensset als validatieset te gebruiken. Op zijn beurt wordt die validatieset gebruikt voor het berekenen van metrische gegevens. Kleiner dan 20.000 rijen De benadering voor kruisvalidatie wordt toegepast. Het standaardaantal vouwen is afhankelijk van het aantal rijen.

- Gegevensset met minder dan 1000 rijen: 10 vouwen worden gebruikt

- Gegevensset met 1.000 tot 20.000 rijen: er worden drie vouwen gebruiktGeef de testgegevens (preview) op om het aanbevolen model te evalueren dat geautomatiseerde ML aan het einde van uw experiment genereert. Wanneer u een testgegevensset opgeeft, wordt aan het einde van uw experiment automatisch een testtaak geactiveerd. Deze testtaak is de enige taak voor het beste model dat wordt aanbevolen door Geautomatiseerde ML.

Belangrijk

Het leveren van een testgegevensset voor het evalueren van gegenereerde modellen is een preview-functie. Deze mogelijkheid is een experimentele preview-functie en kan op elk gewenst moment worden gewijzigd.

Testgegevens worden beschouwd als gescheiden van training en validatie en mogen de resultaten van de testtaak van het aanbevolen model niet afwijken. Zie Training, validatie en testgegevens voor meer informatie.

U kunt uw eigen testgegevensset opgeven of een percentage van uw trainingsgegevensset gebruiken. Testgegevens moeten de vorm hebben van een Azure Machine Learning-tabelgegevensset.

Het schema van de testgegevensset moet overeenkomen met de trainingsgegevensset. De doelkolom is optioneel, maar als er geen doelkolom wordt aangegeven, worden er geen metrische testgegevens berekend.

De testgegevensset mag niet hetzelfde zijn als de trainingsgegevensset of de validatiegegevensset.

Prognosetaken ondersteunen geen train-/testsplitsing .

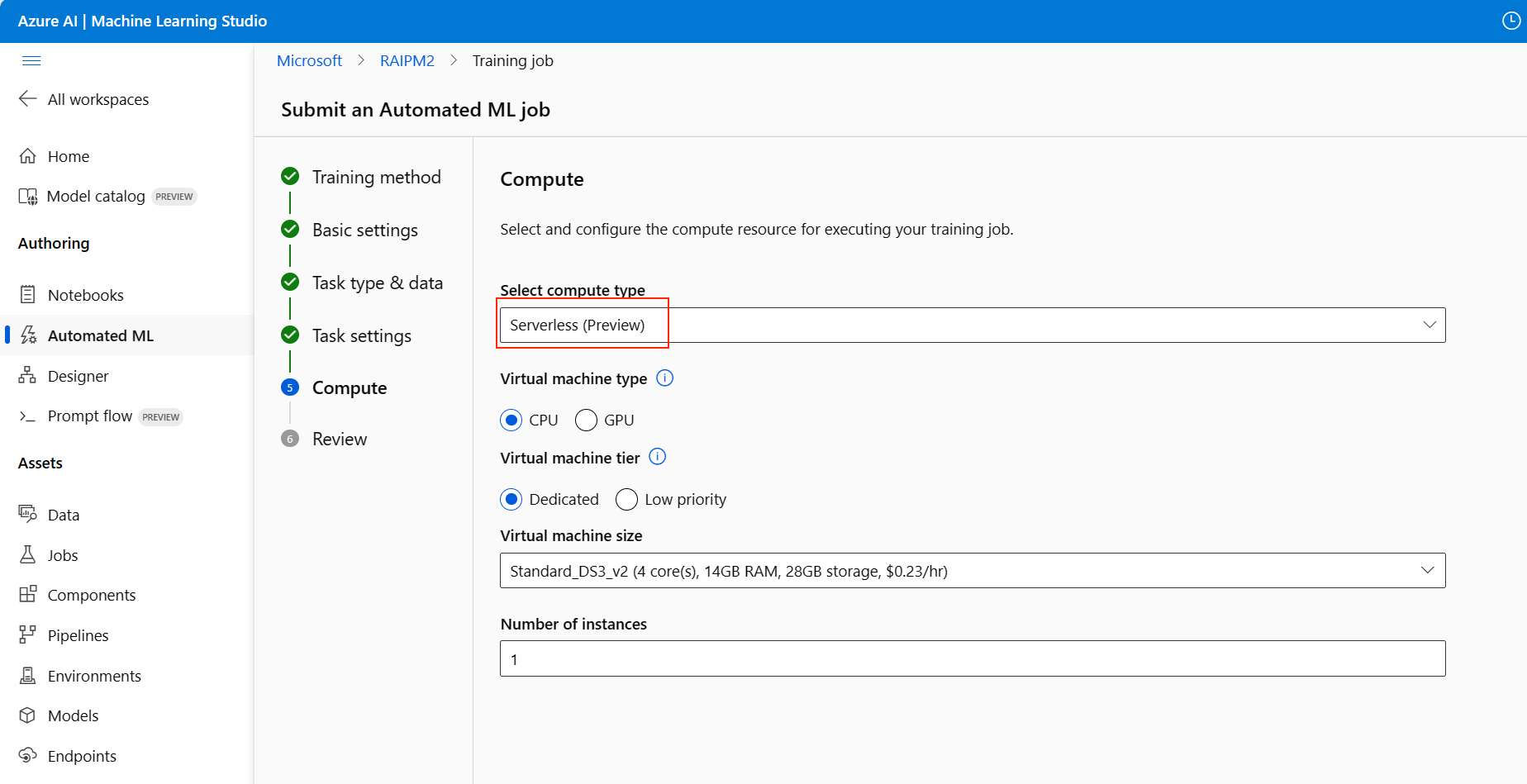

De rekenkracht configureren

Volg deze stappen en configureer de berekening:

Selecteer Volgende om door te gaan naar het tabblad Compute .

Gebruik de vervolgkeuzelijst Berekeningstype selecteren om een optie te kiezen voor gegevensprofilering en trainingstaken.

Nadat u het rekentype hebt geselecteerd, verandert de andere gebruikersinterface op de pagina op basis van uw selectie:

Serverloos: de configuratie-instellingen worden weergegeven op de huidige pagina. Ga door naar de volgende stap voor beschrijvingen van de instellingen die u wilt configureren.

Rekencluster of rekenproces: Kies een van de volgende opties:

- Gebruik de vervolgkeuzelijst Selecteer Geautomatiseerde ML-rekenkracht om een bestaande rekenkracht voor uw werkruimte te selecteren en klik op Volgende.

- Selecteer Nieuw om een nieuw rekenproces of cluster te maken. Met deze optie opent u de pagina Rekenproces maken. Ga door naar de volgende stap voor beschrijvingen van de instellingen die u wilt configureren.

Voor een serverloze berekening of een nieuwe berekening configureert u de vereiste (*) instellingen:

De configuratie-instellingen verschillen, afhankelijk van uw rekentype. De volgende tabel bevat een overzicht van de verschillende instellingen die u mogelijk moet configureren:

Veld Beschrijving Compute-naam Voer een unieke naam in waarmee uw rekencontext wordt geïdentificeerd. Plaats Geef de regio voor de computer op. Prioriteit van virtuele machine Virtuele machines met lage prioriteit zijn goedkoper, maar bieden geen garantie voor de rekenknooppunten. Type virtuele machine Selecteer CPU of GPU voor het type virtuele machine. Virtuele-machinelaag Selecteer de prioriteit voor uw experiment. Grootte van virtuele machine Selecteer de grootte van de virtuele machine voor uw berekening. Min/Max-knooppunten Als u gegevens wilt profilen, moet u een of meer knooppunten opgeven. Voer het maximum aantal knooppunten voor uw rekenproces in. De standaardwaarde is zes knooppunten voor een Azure Machine Learning Compute. Niet-actieve seconden voor omlaag schalen Geef de niet-actieve tijd op voordat het cluster automatisch omlaag wordt geschaald tot het minimumaantal knooppunten. Geavanceerde instellingen Met deze instellingen kunt u een gebruikersaccount en een bestaand virtueel netwerk voor uw experiment configureren. Nadat u de vereiste instellingen hebt geconfigureerd, selecteert u Volgende of Maken, indien van toepassing.

Het maken van een nieuwe berekening kan enkele minuten duren. Wanneer het maken is voltooid, selecteert u Volgende.

Experiment uitvoeren en resultaten weergeven

Selecteer Voltooien om uw experiment uit te voeren. Het voorbereiden van het experiment kan tot 10 minuten duren. Trainingstaken kunnen nog eens 2-3 minuten duren voordat elke pijplijn is voltooid. Als u hebt opgegeven om een RAI-dashboard te genereren voor het best aanbevolen model, kan het tot 40 minuten duren.

Notitie

De algoritmen die Geautomatiseerde ML gebruikt, hebben inherente willekeurigheid die lichte variatie kan veroorzaken in de uiteindelijke score voor metrische gegevens van een aanbevolen model, zoals nauwkeurigheid. Geautomatiseerde ML voert indien nodig ook bewerkingen uit op gegevens zoals splitsing van train-test, train-validation split of kruisvalidatie. Als u een experiment met dezelfde configuratie-instellingen en primaire metrische gegevens meerdere keren uitvoert, ziet u waarschijnlijk variatie in de uiteindelijke score voor metrische gegevens van elk experiment vanwege deze factoren.

Experimentgegevens bekijken

Het scherm Taakdetails wordt geopend op het tabblad Details . In dit scherm ziet u een samenvatting van de experimenttaak, inclusief een statusbalk bovenaan het taaknummer.

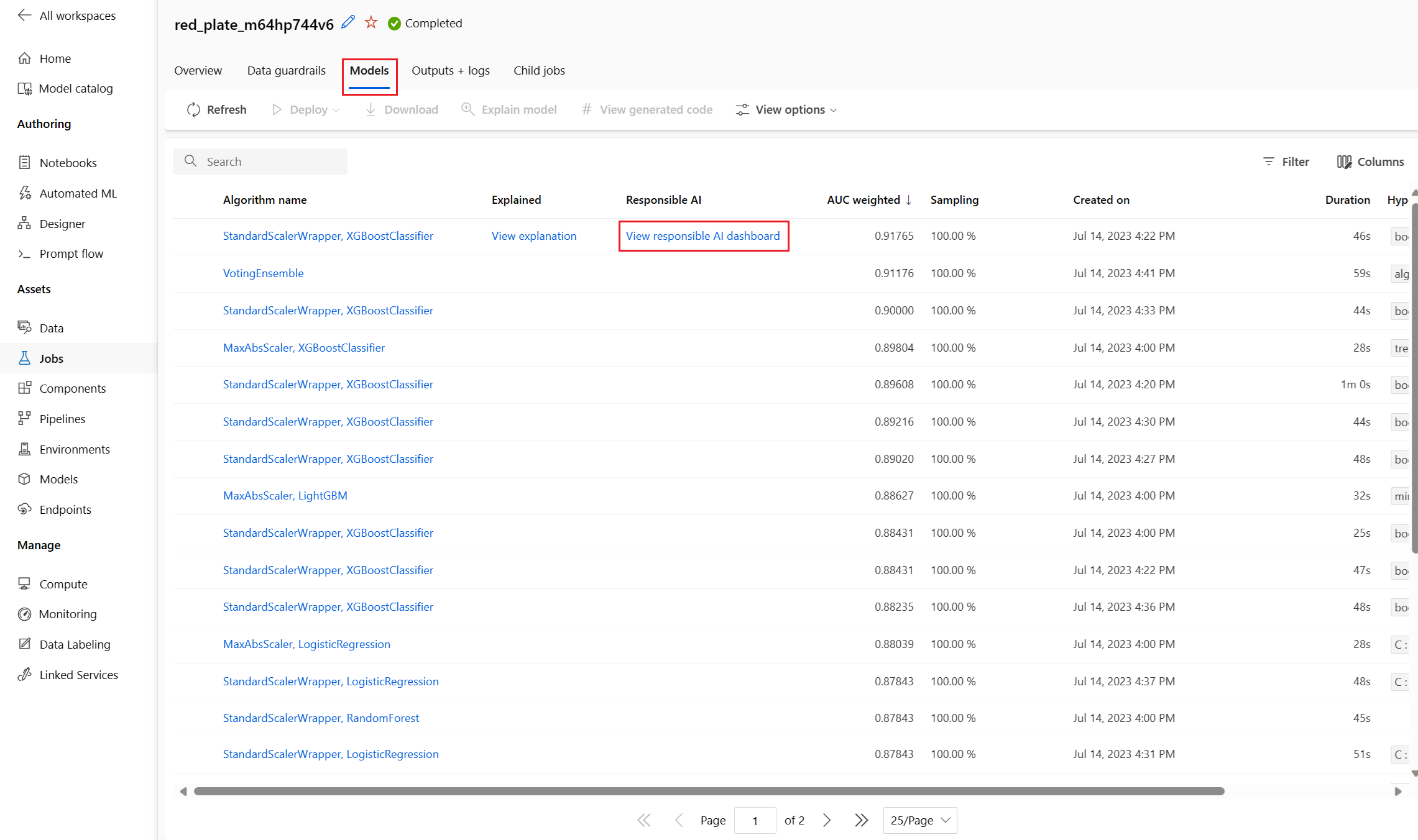

Het tabblad Modellen bevat een lijst met de gemaakte modellen, op volgorde van de metrische score. Standaardstaat het model dat het hoogst scoort op basis van het gekozen metrische gegeven bovenaan de lijst. Naarmate de trainingstaak meer modellen probeert, worden de oefeningsmodellen toegevoegd aan de lijst. Gebruik deze methode om een snelle vergelijking te maken van de metrische gegevens voor de geproduceerde modellen.

Details van trainingstaak weergeven

Meer informatie bekijken over een voltooid model voor details van de trainingstaak. U kunt grafieken met metrische prestatiegegevens voor specifieke modellen bekijken op het tabblad Metrische gegevens . Zie Resultaten van geautomatiseerde machine learning-experimenten evalueren voor meer informatie. Op deze pagina vindt u ook details over alle eigenschappen van het model, samen met de bijbehorende code, onderliggende taken en afbeeldingen.

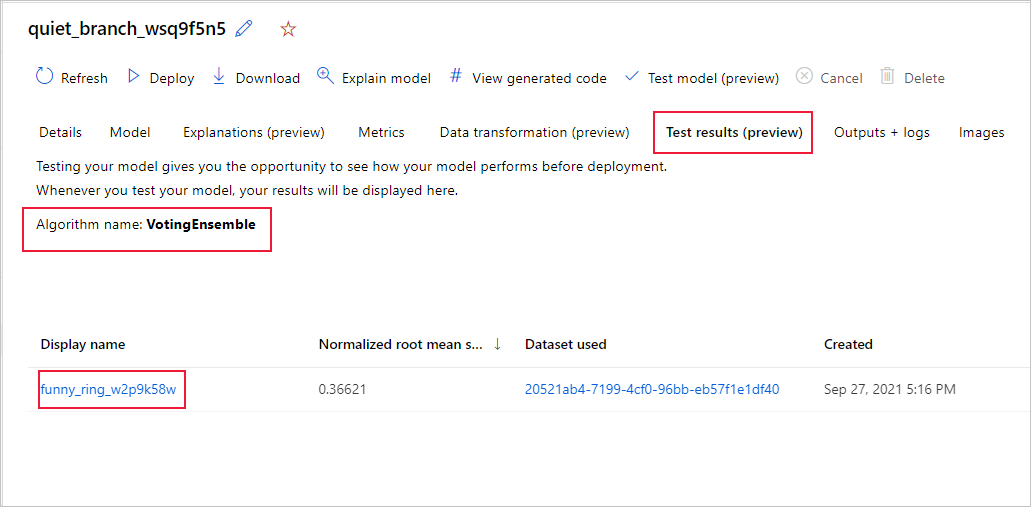

Resultaten van externe testtaken weergeven (preview)

Als u een testgegevensset hebt opgegeven of hebt gekozen voor een train/test split tijdens het instellen van het experiment op het formulier Valideren en testen , test Geautomatiseerde ML het aanbevolen model standaard. Als gevolg hiervan berekent Automated ML testmetrieken om de kwaliteit van het aanbevolen model en de bijbehorende voorspellingen te bepalen.

Belangrijk

Het testen van uw modellen met een testgegevensset om gegenereerde modellen te evalueren, is een preview-functie. Deze mogelijkheid is een experimentele preview-functie en kan op elk gewenst moment worden gewijzigd.

Deze functie is niet beschikbaar voor deze geautomatiseerde ML-scenario's:

Volg deze stappen om de metrische gegevens van de testtaak van het aanbevolen model weer te geven:

Blader in de studio naar de pagina Modellen en selecteer het beste model.

Selecteer het tabblad Testresultaten (preview).

Selecteer de gewenste taak en bekijk het tabblad Metrische gegevens :

Bekijk de testvoorspellingen die worden gebruikt om de metrische testgegevens te berekenen door de volgende stappen uit te voeren:

Selecteer onder aan de pagina de koppeling onder Uitvoergegevensset om de gegevensset te openen.

Selecteer op de pagina Gegevenssets het tabblad Verkennen om de voorspellingen van de testtaak weer te geven.

Het voorspellingsbestand kan ook worden bekeken en gedownload op het tabblad Uitvoer en logboeken . Vouw de map Voorspellingen uit om het predictions.csv-bestand te zoeken.

Met de modeltesttaak wordt het predictions.csv bestand gegenereerd dat is opgeslagen in het standaardgegevensarchief dat is gemaakt met de werkruimte. Dit gegevensarchief is zichtbaar voor alle gebruikers met hetzelfde abonnement. Testtaken worden niet aanbevolen voor scenario's als een van de gegevens die worden gebruikt voor of gemaakt door de testtaak privé moet blijven.

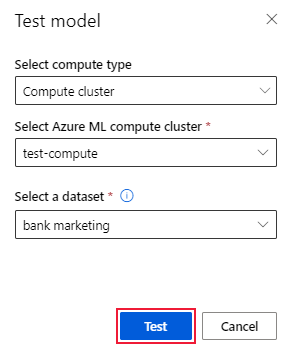

Bestaand geautomatiseerd ML-model testen (preview)

Nadat uw experiment is voltooid, kunt u de modellen testen die geautomatiseerde ML voor u genereert.

Belangrijk

Het testen van uw modellen met een testgegevensset om gegenereerde modellen te evalueren, is een preview-functie. Deze mogelijkheid is een experimentele preview-functie en kan op elk gewenst moment worden gewijzigd.

Deze functie is niet beschikbaar voor de volgende geautomatiseerde ML-scenario's:

Als u een ander geautomatiseerd ML-gegenereerd model wilt testen en niet het aanbevolen model, voert u de volgende stappen uit:

Selecteer een bestaande geautomatiseerde ML-experimenttaak.

Blader naar het tabblad Modellen van de taak en selecteer het voltooide model dat u wilt testen.

Selecteer op de pagina Details van het model de optie Testmodel (preview) om het deelvenster Testmodel te openen.

Selecteer in het deelvenster Testmodel het rekencluster en de testgegevensset die u wilt gebruiken voor uw testtaak.

Selecteer de optie Testen . Het schema van de testgegevensset moet overeenkomen met de trainingsgegevensset, maar de kolom Doel is optioneel.

Wanneer de modeltesttaak is gemaakt, wordt op de pagina Details een bericht weergegeven dat het is gelukt. Selecteer het tabblad Testresultaten om de voortgang van de taak te bekijken.

Als u de resultaten van de testtaak wilt bekijken, opent u de pagina Details en volgt u de stappen in de sectie Resultaten van de externe testtaak weergeven (preview).

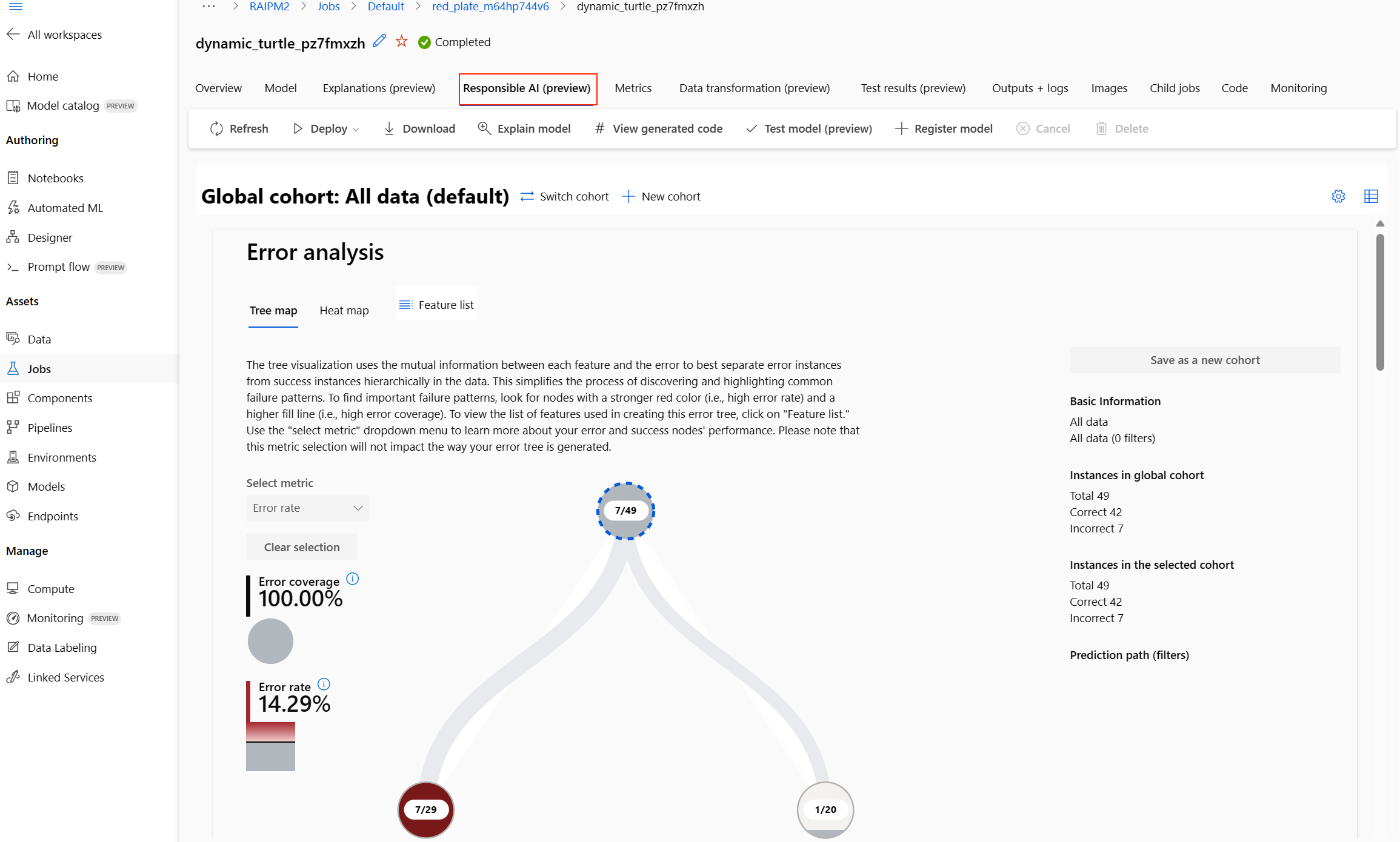

Verantwoordelijk AI-dashboard (preview)

Als u meer inzicht wilt krijgen in uw model, kunt u verschillende inzichten over het model bekijken met behulp van het dashboard Verantwoorde AI. Met deze gebruikersinterface kunt u uw beste geautomatiseerde ML-model evalueren en fouten opsporen. Het verantwoordelijke AI-dashboard evalueert modelfouten en fairness-problemen, diagnosticeert waarom de fouten optreden door uw train- en/of testgegevens te evalueren en modeluitleg te observeren. Samen kunnen deze inzichten u helpen bij het opbouwen van vertrouwen met uw model en het doorgeven van auditprocessen. Verantwoordelijke AI-dashboards kunnen niet worden gegenereerd voor een bestaand Geautomatiseerd ML-model. Het dashboard wordt alleen gemaakt voor het best aanbevolen model wanneer u een nieuwe geautomatiseerde ML-taak maakt. Gebruikers moeten modeluitleg blijven gebruiken (preview) totdat we ondersteuning bieden voor bestaande modellen.

Als u een verantwoordelijk AI-dashboard voor een bepaald model wilt genereren, voert u de volgende stappen uit:

Terwijl u een geautomatiseerde ML-taak verzendt, gaat u naar de sectie Taakinstellingen in het linkermenu en selecteert u Aanvullende configuratie-instellingen weergeven.

Selecteer op de pagina Aanvullende configuratie de optie Beste model uitleggen:

Ga naar het tabblad Compute en selecteer Serverloos voor uw berekening:

Nadat de bewerking is voltooid, bladert u naar de pagina Modellen van uw geautomatiseerde ML-taak, die een lijst met uw getrainde modellen bevat.

Het verantwoordelijke AI-dashboard wordt weergegeven voor het geselecteerde model:

In het dashboard ziet u vier onderdelen die zijn geactiveerd voor uw geautomatiseerde ML-beste model:

Onderdeel Wat wordt in het onderdeel weergegeven? Hoe kan ik de grafiek lezen? Foutanalyse Gebruik een foutanalyse wanneer u het volgende moet doen:

- Krijg een diepgaand inzicht in hoe modelfouten worden verdeeld over een gegevensset en over verschillende invoer- en functiedimensies.

- De metrische statistische prestatiegegevens opsplitsen om automatisch onjuiste cohorten te detecteren om uw gerichte risicobeperkingsstappen te informeren.Foutanalysegrafieken Overzicht en billijkheid van modellen Gebruik dit onderdeel voor het volgende:

- Krijg een diepgaand inzicht in de prestaties van uw model in verschillende cohorten met gegevens.

- Inzicht in de redelijkheidsproblemen van uw model door te kijken naar de metrische gegevens over verschillen. Deze metrische gegevens kunnen modelgedrag evalueren en vergelijken tussen subgroepen die zijn geïdentificeerd in termen van gevoelige (of niet-gevoelige) functies.Modeloverzicht en getrouwheidsgrafieken Modeluitleg Gebruik het onderdeel voor modeluitleg om begrijpelijke beschrijvingen van de voorspellingen van een machine learning-model te genereren door te kijken naar:

- Globale uitleg: Welke functies zijn bijvoorbeeld van invloed op het algehele gedrag van een leningtoewijzingsmodel?

- Lokale uitleg: Waarom is bijvoorbeeld de aanvraag voor een lening van een klant goedgekeurd of afgewezen?Model-uitleggrafieken Gegevensanalyse Gebruik gegevensanalyse wanneer u het volgende moet doen:

- Verken uw gegevenssetstatistieken door verschillende filters te selecteren om uw gegevens te segmenteren in verschillende dimensies (ook wel cohorten genoemd).

- Inzicht in de distributie van uw gegevensset in verschillende cohorten en functiegroepen.

- Bepaal of uw bevindingen met betrekking tot billijkheid, foutanalyse en causaliteit (afgeleid van andere dashboardonderdelen) het resultaat zijn van de distributie van uw gegevensset.

- Bepaal op welke gebieden meer gegevens moeten worden verzameld om fouten te beperken die afkomstig zijn van representatieproblemen, labelruis, functieruis, labelvooroordelen en vergelijkbare factoren.Data Explorer-grafieken U kunt cohorten (subgroepen van gegevenspunten die opgegeven kenmerken delen) maken om uw analyse van elk onderdeel op verschillende cohorten te richten. De naam van het cohort dat momenteel op het dashboard is toegepast, wordt altijd linksboven in het dashboard weergegeven. De standaardweergave in uw dashboard is uw hele gegevensset, met de titel Alle gegevens standaard. Zie Algemene besturingselementen voor uw dashboard voor meer informatie.

Taken bewerken en verzenden (preview)

Wanneer u een nieuw experiment wilt maken op basis van de instellingen van een bestaand experiment, biedt Automated ML de optie Bewerken en verzenden in de gebruikersinterface van studio.

Belangrijk

De mogelijkheid om een nieuw experiment te kopiëren, bewerken en verzenden op basis van een bestaand experiment is een preview-functie. Deze mogelijkheid is een experimentele preview-functie en kan op elk gewenst moment worden gewijzigd.

Met de optie Bewerken en verzenden opent u de wizard Een nieuwe geautomatiseerde ML-taak maken met de vooraf ingevulde gegevens- en reken- en experimentinstellingen. U kunt de opties op elk tabblad in de wizard configureren en indien nodig selecties bewerken voor uw nieuwe experiment. Deze functionaliteit is beperkt tot experimenten die zijn gestart vanuit de gebruikersinterface van studio en vereist dat het gegevensschema voor het nieuwe experiment overeenkomt met het schema van het oorspronkelijke experiment.

Uw model implementeren

Nadat u het beste model hebt, kunt u het implementeren als een webservice om nieuwe gegevens te voorspellen.

Notitie

Als u een model wilt implementeren dat is gegenereerd via het automl pakket met de Python SDK, moet u uw model registreren bij de werkruimte.

Nadat u het model hebt geregistreerd, kunt u het vinden in de studio door Modellen te selecteren in het menu links.

Geautomatiseerde ML helpt u bij het implementeren van het model zonder code te schrijven.

Start de implementatie met behulp van een van de volgende methoden:

Implementeer het beste model met de metrische criteria die u hebt gedefinieerd:

Nadat het experiment is voltooid, selecteert u Taak 1 en bladert u naar de bovenliggende taakpagina.

Selecteer het model dat wordt vermeld in de sectie Beste modelsamenvatting en selecteer vervolgens Implementeren.

Implementeer een specifieke model-iteratie vanuit dit experiment:

- Selecteer het gewenste model op het tabblad Modellen en selecteer vervolgens Implementeren.

Vul het deelvenster Model implementeren:

Veld Waarde Naam Voer een unieke naam in voor uw implementatie. Beschrijving Voer een beschrijving in om het implementatiedoel beter te identificeren. Rekentype Selecteer het type eindpunt dat u wilt implementeren: Azure Kubernetes Service (AKS) of Azure Container Instance (ACI). Compute-naam (Alleen van toepassing op AKS) Selecteer de naam van het AKS-cluster waarnaar u wilt implementeren. Verificatie inschakelen Selecteer deze optie om verificatie op basis van tokens of sleutels toe te staan. Aangepaste implementatieassets gebruiken Schakel aangepaste assets in als u uw eigen scorescript en omgevingsbestand wilt uploaden. Anders biedt Automated ML deze assets standaard voor u. Zie Een machine learning-model implementeren en beoordelen met behulp van een online-eindpunt voor meer informatie. Belangrijk

Bestandsnamen moeten tussen 1 en 32 tekens zijn. De naam moet beginnen en eindigen met alfanumerieke tekens en kan streepjes, onderstrepingstekens, punten en alfanumerieke tekens ertussen bevatten.

Het menu Geavanceerd biedt standaardimplementatiefuncties, zoals instellingen voor gegevensverzameling en resourcegebruik. U kunt de opties in dit menu gebruiken om deze standaardinstellingen te overschrijven. Zie Online-eindpunten bewaken voor meer informatie.

Selecteer Implementeren. Implementatie duurt ongeveer 20 minuten.

Nadat de implementatie is gestart, wordt het tabblad Samenvatting model geopend. U kunt de voortgang van de implementatie bewaken in de sectie Status implementeren .

U hebt nu een operationele webservice om voorspellingen te genereren. U kunt de voorspellingen testen door een query uit te voeren op de service vanuit de end-to-end AI-voorbeelden in Microsoft Fabric.