Projekt architektury baz danych

Ten artykuł zawiera omówienie rozwiązań bazy danych platformy Azure opisanych w Centrum architektury platformy Azure.

Apache®, Apache Cassandra® i logo Hadoop są zastrzeżonymi znakami towarowymi lub znakami towarowymi fundacji Apache Software Foundation w Stany Zjednoczone i/lub innych krajach. Użycie tych znaków nie jest dorozumiane przez fundację Apache Software Foundation.

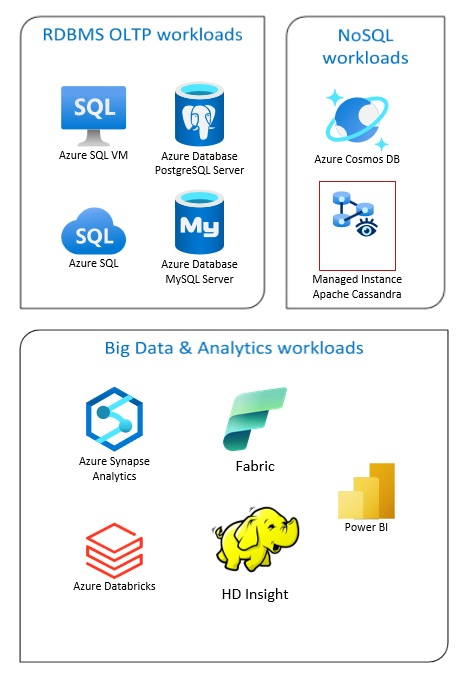

Rozwiązania usługi Azure Database obejmują tradycyjne systemy zarządzania relacyjnymi bazami danych (RDBMS i OLTP), obciążenia danych big data i analizy (w tym OLAP) i obciążenia NoSQL.

Obciążenia RDBMS obejmują przetwarzanie transakcji online (OLTP) i przetwarzanie analityczne online (OLAP). Dane z wielu źródeł w organizacji można skonsolidować w magazynie danych. Możesz użyć procesu wyodrębniania, przekształcania, ładowania (ETL) lub wyodrębniania, ładowania, przekształcania (ELT) w celu przenoszenia i przekształcania danych źródłowych. Aby uzyskać więcej informacji na temat baz danych RDBMS, zobacz Eksplorowanie relacyjnych baz danych na platformie Azure.

Architektura danych big data jest przeznaczona do obsługi pozyskiwania, przetwarzania i analizowania dużych lub złożonych danych. Rozwiązania do obsługi danych big data zwykle obejmują dużą ilość danych relacyjnych i nierelacyjnych, które tradycyjne systemy RDBMS nie są odpowiednie do przechowywania. Zazwyczaj obejmują one rozwiązania, takie jak Data Lake, Delta Lake i lakehouses. Zobacz więcej informacji w temacie Projektowanie architektury analizy.

Bazy danych NoSQL są zamiennie określane jako nierelacyjne, bazy danych NoSQL lub bazy danych innych niż SQL, aby podkreślić fakt, że mogą obsługiwać ogromne ilości szybko zmieniających się, nieustrukturyzowanych danych. Nie przechowują one danych w tabelach, wierszach i kolumnach, takich jak bazy danych SQL. Aby uzyskać więcej informacji na temat baz danych No SQL DBs, zobacz NoSQL Data and What are NoSQL Databases?( Co to są bazy danych NoSQL Database?).

Ten artykuł zawiera zasoby umożliwiające zapoznanie się z bazami danych platformy Azure. Przedstawia on ścieżki implementacji architektur, które spełniają Twoje potrzeby i najlepsze rozwiązania, aby pamiętać o projektach rozwiązań.

Istnieje wiele architektur, z których można korzystać, aby zaspokoić potrzeby bazy danych. Udostępniamy również pomysły na rozwiązania, które można wykorzystać, w tym linki do wszystkich potrzebnych składników.

Dowiedz się więcej o bazach danych na platformie Azure

Gdy zaczniesz myśleć o możliwych architekturach rozwiązania, ważne jest, aby wybrać prawidłowy magazyn danych. Jeśli dopiero zaczynasz pracę z bazami danych na platformie Azure, najlepszym miejscem do rozpoczęcia jest środowisko Microsoft Learn. Ta bezpłatna platforma online udostępnia filmy wideo i samouczki umożliwiające praktyczne uczenie się. Platforma Microsoft Learn oferuje ścieżki szkoleniowe oparte na twojej roli, takie jak deweloper lub analityk danych.

Możesz zacząć od ogólnego opisu różnych baz danych na platformie Azure i ich użycia. Możesz również przeglądać moduły danych platformy Azure i wybrać podejście do magazynu danych na platformie Azure. Te artykuły ułatwiają zrozumienie wyborów w rozwiązaniach danych platformy Azure i dowiedz się, dlaczego niektóre rozwiązania są zalecane w określonych scenariuszach.

Oto kilka modułów platformy Learn, które mogą okazać się przydatne:

- Projektowanie migracji na platformę Azure

- Wdrażanie usługi Azure SQL Database

- Eksplorowanie usług baz danych i analiz platformy Azure

- Zabezpieczanie bazy danych Azure SQL Database

- Azure Cosmos DB

- Azure Database for PostgreSQL

- Azure Database for MySQL

- Program SQL Server na maszynach wirtualnych platformy Azure

Ścieżka do środowiska produkcyjnego

Aby znaleźć opcje przydatne do radzenia sobie z danymi relacyjnymi, rozważ następujące zasoby:

- Aby dowiedzieć się więcej o zasobach na potrzeby zbierania danych z wielu źródeł oraz sposobu i stosowania przekształceń danych w potokach danych, zobacz Analiza na platformie Azure.

- Aby dowiedzieć się więcej o usłudze OLAP, która organizuje duże bazy danych biznesowych i obsługuje złożoną analizę, zobacz Przetwarzanie analityczne online.

- Aby dowiedzieć się więcej o systemach OLTP rejestrują interakcje biznesowe w miarę ich występowania, zobacz Przetwarzanie transakcji online.

Nierelacyjna baza danych nie używa tabelarycznego schematu wierszy i kolumn. Aby uzyskać więcej informacji, zobacz Dane nierelacyjne i NoSQL.

Aby dowiedzieć się więcej o magazynach data lake, które przechowują dużą ilość danych w natywnym, nieprzetworzonym formacie, zobacz Magazyny typu Data Lake.

Architektura danych big data może obsługiwać pozyskiwanie, przetwarzanie i analizę danych, które są zbyt duże lub zbyt złożone dla tradycyjnych systemów baz danych. Aby uzyskać więcej informacji, zobacz Architektury danych big data i Analiza.

Chmura hybrydowa to środowisko IT, które łączy chmurę publiczną i lokalne centra danych. Aby uzyskać więcej informacji, rozważ Azure Arc w połączeniu z bazami danych platformy Azure.

Usługa Azure Cosmos DB to w pełni zarządzana usługa bazy danych NoSQL umożliwiająca tworzenie nowoczesnych aplikacji. Aby uzyskać więcej informacji, zobacz Model zasobów usługi Azure Cosmos DB.

Aby dowiedzieć się więcej o opcjach przesyłania danych na platformę Azure i z platformy Azure, zobacz Transfer danych do i z platformy Azure.

Najlepsze rozwiązania

Zapoznaj się z tymi najlepszymi rozwiązaniami podczas projektowania rozwiązań.

| Najlepsze rozwiązania | opis |

|---|---|

| Wzorzec transakcyjnej skrzynki wychodzącej z usługą Azure Cosmos DB | Dowiedz się, jak używać wzorca transakcyjnej skrzynki odbiorczej na potrzeby niezawodnej obsługi komunikatów i gwarantowanego dostarczania zdarzeń. |

| Globalna dystrybucja danych przy użyciu usługi Azure Cosmos DB | Aby osiągnąć małe opóźnienia i wysoką dostępność, niektóre aplikacje muszą być wdrażane w centrach danych, które znajdują się blisko użytkowników. |

| Zabezpieczenia w usłudze Azure Cosmos DB | Najlepsze rozwiązania w zakresie zabezpieczeń pomagają zapobiegać naruszeniom bazy danych, wykrywać je i reagować na nie. |

| Ciągła kopia zapasowa z przywracaniem do punktu w czasie w usłudze Azure Cosmos DB | Dowiedz się więcej o funkcji przywracania do punktu w czasie w usłudze Azure Cosmos DB. |

| Uzyskiwanie wysokiej dostępności za pomocą usługi Azure Cosmos DB | Usługa Azure Cosmos DB udostępnia wiele funkcji i opcji konfiguracji w celu osiągnięcia wysokiej dostępności. |

| Wysoka dostępność usług Azure SQL Database i SQL Managed Instance | Baza danych nie powinna być pojedynczym punktem awarii w architekturze. |

Wybór technologi

Istnieje wiele opcji użycia technologii z usługą Azure Databases. Te artykuły ułatwiają wybór najlepszych technologii dla Twoich potrzeb.

- Wybieranie magazynu danych

- Wybieranie magazynu danych analitycznych na platformie Azure

- Wybieranie technologii analizy danych na platformie Azure

- Wybieranie technologii przetwarzania wsadowego na platformie Azure

- Wybieranie technologii magazynu danych big data na platformie Azure

- Wybieranie technologii aranżacji potoku danych na platformie Azure

- Wybieranie magazynu danych wyszukiwania na platformie Azure

- Wybieranie technologii przetwarzania strumieniowego na platformie Azure

Bądź na bieżąco z bazami danych

Zapoznaj się z tematem Aktualizacje platformy Azure, aby zachować aktualność dzięki technologii Azure Databases.

Powiązane zasoby

- Scenariusz firmy Adatum Corporation na potrzeby zarządzania danymi i analizy na platformie Azure

- Scenariusz firmy Lamna Healthcare na potrzeby zarządzania danymi i analizy na platformie Azure

- Optymalizowanie administrowania wystąpieniami programu SQL Server

- Scenariusz firmy Relecloud na potrzeby zarządzania danymi i analizy na platformie Azure

Podobne produkty bazy danych

Jeśli znasz usługi Amazon Web Services (AWS) lub Google Cloud, zapoznaj się z następującymi porównaniami: