Korzystanie z usługi Azure Data Lake Storage Gen1 na potrzeby wymagań dotyczących danych big data

Uwaga

Usługa Azure Data Lake Storage Gen1 została wycofana. Zobacz ogłoszenie o wycofaniu tutaj. Zasoby usługi Data Lake Storage Gen1 nie są już dostępne.

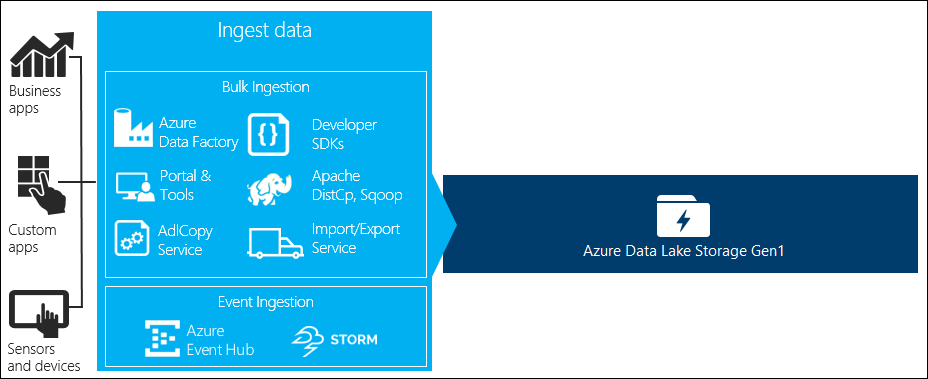

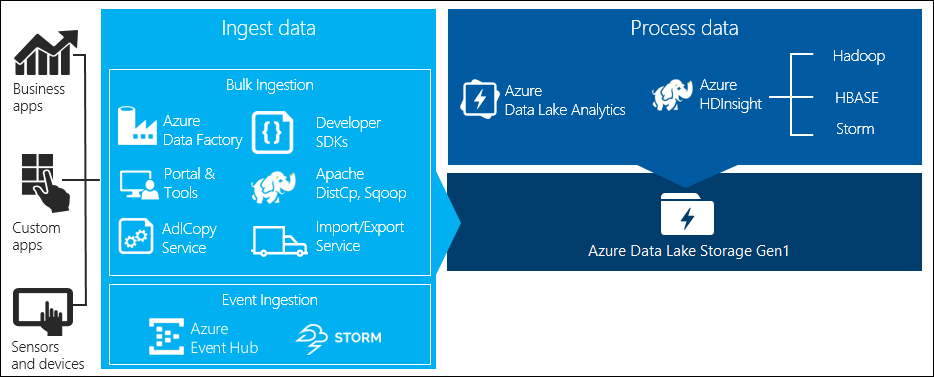

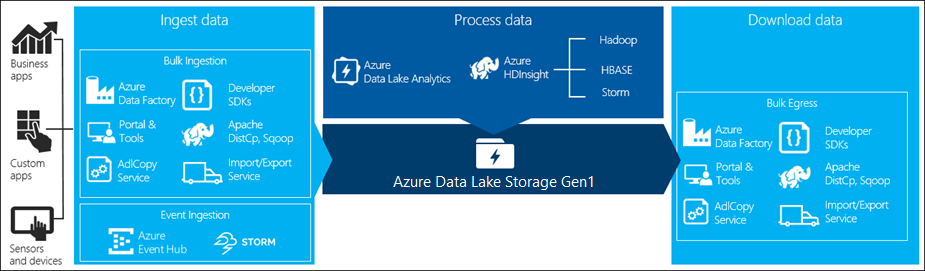

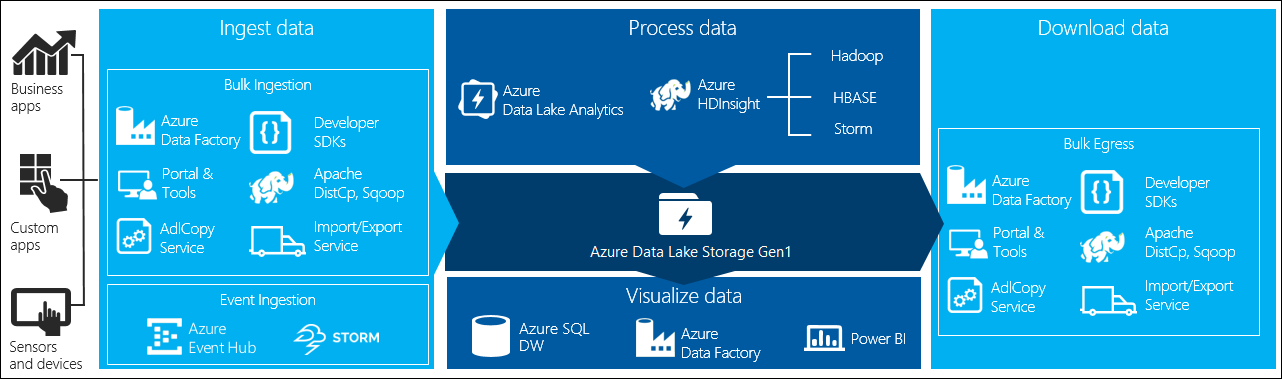

Istnieją cztery kluczowe etapy przetwarzania danych big data:

- Pozyskiwanie dużych ilości danych do magazynu danych w czasie rzeczywistym lub w partiach

- Przetwarzanie danych

- Pobieranie danych

- Wizualizowanie danych

W tym artykule przyjrzymy się tym etapom w odniesieniu do usługi Azure Data Lake Storage Gen1, aby zrozumieć opcje i narzędzia dostępne dla potrzeb związanych z danymi big data.

Pozyskiwanie danych do usługi Data Lake Storage Gen1

W tej sekcji przedstawiono różne źródła danych i różne sposoby pozyskiwania tych danych na konto usługi Data Lake Storage Gen1.

Dane ad hoc

Reprezentuje to mniejsze zestawy danych używane do tworzenia prototypów aplikacji danych big data. Istnieją różne sposoby pozyskiwania danych ad hoc w zależności od źródła danych.

| Źródło danych | Pozyskiwanie go przy użyciu |

|---|---|

| Komputer lokalny | |

| Azure Storage Blob |

Dane przesyłane strumieniowo

Reprezentuje to dane, które mogą być generowane przez różne źródła, takie jak aplikacje, urządzenia, czujniki itp. Te dane można pozyskiwać do usługi Data Lake Storage Gen1 za pomocą różnych narzędzi. Te narzędzia zwykle przechwytują i przetwarzają dane na podstawie zdarzenia w czasie rzeczywistym, a następnie zapisują zdarzenia w partiach w usłudze Data Lake Storage Gen1, aby można je było dalej przetwarzać.

Poniżej przedstawiono narzędzia, których można użyć:

- Azure Stream Analytics — zdarzenia pozyskane do usługi Event Hubs można zapisywać w usłudze Azure Data Lake Storage Gen1 przy użyciu danych wyjściowych usługi Azure Data Lake Storage Gen1.

- EventProcessorHost — zdarzenia można odbierać z usługi Event Hubs, a następnie zapisywać je w usłudze Data Lake Storage Gen1 przy użyciu zestawu SDK platformy .NET usługi Data Lake Storage Gen1.

Dane relacyjne

Możesz również źródle danych z relacyjnych baz danych. W danym okresie relacyjne bazy danych zbierają ogromne ilości danych, które mogą zapewnić kluczowe szczegółowe informacje w przypadku przetwarzania za pośrednictwem potoku danych big data. Aby przenieść takie dane do usługi Data Lake Storage Gen1, możesz użyć następujących narzędzi.

Dane dziennika serwera sieci Web (przekazywanie przy użyciu aplikacji niestandardowych)

Ten typ zestawu danych jest specjalnie wywoływany, ponieważ analiza danych dziennika serwera internetowego jest typowym przypadkiem użycia aplikacji danych big data i wymaga przekazania dużych ilości plików dziennika do usługi Data Lake Storage Gen1. Możesz użyć dowolnego z poniższych narzędzi, aby napisać własne skrypty lub aplikacje w celu przekazania takich danych.

- Interfejs wiersza polecenia platformy Azure

- Azure PowerShell

- Azure Data Lake Storage Gen1 .NET SDK

- Azure Data Factory

W przypadku przekazywania danych dziennika serwera internetowego, a także przekazywania innych rodzajów danych (np. danych tonacji społecznościowych), dobrym rozwiązaniem jest napisanie własnych niestandardowych skryptów/aplikacji, ponieważ zapewnia elastyczność dołączania składnika do przekazywania danych w ramach większej aplikacji danych big data. W niektórych przypadkach ten kod może mieć postać skryptu lub prostego narzędzia wiersza polecenia. W innych przypadkach kod może służyć do integrowania przetwarzania danych big data z aplikacją biznesową lub rozwiązaniem.

Dane skojarzone z klastrami usługi Azure HDInsight

Większość typów klastrów usługi HDInsight (Hadoop, HBase, Storm) obsługuje usługę Data Lake Storage Gen1 jako repozytorium magazynu danych. Klastry usługi HDInsight uzyskują dostęp do danych z obiektów blob usługi Azure Storage (WASB). Aby uzyskać lepszą wydajność, możesz skopiować dane z usługi WASB do konta usługi Data Lake Storage Gen1 skojarzonego z klastrem. Do skopiowania danych można użyć następujących narzędzi.

Dane przechowywane w klastrach lokalnych lub IaaS Hadoop

Duże ilości danych mogą być przechowywane w istniejących klastrach Hadoop lokalnie na maszynach przy użyciu systemu plików HDFS. Klastry Hadoop mogą znajdować się we wdrożeniu lokalnym lub w klastrze IaaS na platformie Azure. Mogą istnieć wymagania dotyczące kopiowania takich danych do usługi Azure Data Lake Storage Gen1 na potrzeby podejścia jednorazowego lub w sposób cykliczny. Istnieją różne opcje, których można użyć do osiągnięcia tego celu. Poniżej znajduje się lista alternatyw i powiązanych kompromisów.

| Metoda | Szczegóły | Zalety | Kwestie wymagające rozważenia |

|---|---|---|---|

| Kopiowanie danych bezpośrednio z klastrów Hadoop do usługi Azure Data Lake Storage Gen1 przy użyciu usługi Azure Data Factory (ADF) | Usługa ADF obsługuje system plików HDFS jako źródło danych | Usługa ADF zapewnia wbudowaną obsługę systemu plików HDFS i kompleksowego zarządzania i monitorowania | Wymaga wdrożenia bramy Zarządzanie danymi lokalnie lub w klastrze IaaS |

| Eksportowanie danych z usługi Hadoop jako plików. Następnie skopiuj pliki do usługi Azure Data Lake Storage Gen1 przy użyciu odpowiedniego mechanizmu. | Pliki można kopiować do usługi Azure Data Lake Storage Gen1 przy użyciu następujących narzędzi:

|

Szybkie rozpoczęcie pracy. Może wykonywać dostosowane przekazywanie | Wieloetapowy proces obejmujący wiele technologii. Zarządzanie i monitorowanie będzie wyzwaniem w miarę upływu czasu ze względu na dostosowany charakter narzędzi |

| Użyj narzędzia Distcp, aby skopiować dane z usługi Hadoop do usługi Azure Storage. Następnie skopiuj dane z usługi Azure Storage do usługi Data Lake Storage Gen1 przy użyciu odpowiedniego mechanizmu. | Dane z usługi Azure Storage można skopiować do usługi Data Lake Storage Gen1 przy użyciu: | Możesz użyć narzędzi typu open source. | Wieloetapowy proces obejmujący wiele technologii |

Naprawdę duże zestawy danych

W przypadku przekazywania zestawów danych w kilku terabajtach użycie opisanych powyżej metod może czasami być powolne i kosztowne. W takich przypadkach możesz użyć poniższych opcji.

Korzystanie z usługi Azure ExpressRoute. Usługa Azure ExpressRoute umożliwia tworzenie prywatnych połączeń między centrami danych platformy Azure i infrastrukturą lokalną. Zapewnia to niezawodną opcję transferu dużych ilości danych. Aby uzyskać więcej informacji, zobacz dokumentację usługi Azure ExpressRoute.

Przekazywanie danych w trybie offline. Jeśli korzystanie z usługi Azure ExpressRoute nie jest wykonalne z jakiegokolwiek powodu, możesz użyć usługi Azure Import/Export, aby dostarczyć dyski twarde z danymi do centrum danych platformy Azure. Dane są najpierw przekazywane do obiektów blob usługi Azure Storage. Następnie możesz użyć narzędzia Azure Data Factory lub AdlCopy, aby skopiować dane z obiektów blob usługi Azure Storage do usługi Data Lake Storage Gen1.

Uwaga

Podczas korzystania z usługi Import/Export rozmiary plików na dyskach dostarczonych do centrum danych platformy Azure nie powinny być większe niż 195 GB.

Przetwarzanie danych przechowywanych w usłudze Data Lake Storage Gen1

Gdy dane będą dostępne w usłudze Data Lake Storage Gen1, możesz uruchomić analizę tych danych przy użyciu obsługiwanych aplikacji danych big data. Obecnie można używać usług Azure HDInsight i Azure Data Lake Analytics do uruchamiania zadań analizy danych na danych przechowywanych w usłudze Data Lake Storage Gen1.

Możesz zapoznać się z poniższymi przykładami.

- Tworzenie klastra usługi HDInsight przy użyciu usługi Data Lake Storage Gen1 jako magazynu

- Używanie usługi Azure Data Lake Analytics z usługą Data Lake Storage Gen1

Pobieranie danych z usługi Data Lake Storage Gen1

Możesz również pobrać lub przenieść dane z usługi Azure Data Lake Storage Gen1 w scenariuszach, takich jak:

- Przenoszenie danych do innych repozytoriów w celu interfejsu z istniejącymi potokami przetwarzania danych. Możesz na przykład przenieść dane z usługi Data Lake Storage Gen1 do usługi Azure SQL Database lub programu SQL Server.

- Pobierz dane na komputer lokalny do przetwarzania w środowiskach IDE podczas tworzenia prototypów aplikacji.

W takich przypadkach można użyć dowolnej z następujących opcji:

Możesz również użyć następujących metod, aby napisać własny skrypt/aplikację w celu pobrania danych z usługi Data Lake Storage Gen1.

Wizualizowanie danych w usłudze Data Lake Storage Gen1

Możesz użyć kombinacji usług, aby utworzyć wizualne reprezentacje danych przechowywanych w usłudze Data Lake Storage Gen1.

- Możesz zacząć od użycia usługi Azure Data Factory do przenoszenia danych z usługi Data Lake Storage Gen1 do usługi Azure Synapse Analytics

- Następnie możesz zintegrować usługę Power BI z usługą Azure Synapse Analytics , aby utworzyć wizualną reprezentację danych.