Como implantar modelos de inserção do Cohere com o Estúdio de IA do Azure

Importante

Alguns dos recursos descritos nesse artigo podem estar disponíveis apenas na versão prévia. Essa versão prévia é fornecida sem um contrato de nível de serviço e não recomendamos isso para cargas de trabalho de produção. Alguns recursos podem não ter suporte ou podem ter restrição de recursos. Para obter mais informações, consulte Termos de Uso Complementares de Versões Prévias do Microsoft Azure.

Neste artigo, você aprenderá a usar o Estúdio de IA do Azure para implantar os modelos Cohere Embed, como APIs sem servidor com cobrança paga conforme o uso baseada em tokens.

O Cohere oferece dois modelos de inserção no Estúdio de IA do Azure. Estes modelos estão disponíveis como APIs sem servidor com cobrança paga conforme o uso baseada em tokens. Navegue pela família Cohere de modelos no Catálogo de modelos filtrando na coleção Cohere.

Modelos Cohere Embed

Nesta seção, você conhecerá os dois modelos de Cohere Embed que estão disponíveis no catálogo de modelos:

- Cohere Embed v3 – English

- Cohere Embed v3 – Multilingual

Navegue pela família Cohere de modelos no Catálogo de modelos filtrando na coleção Cohere.

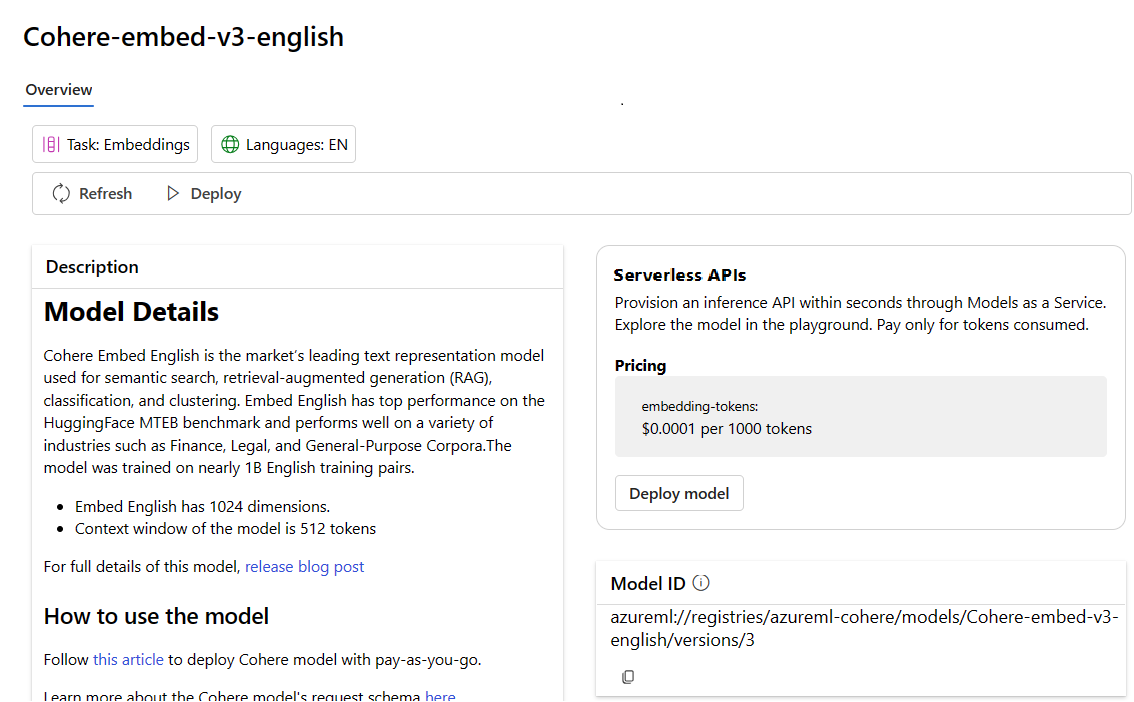

Cohere Embed v3 – English

O Cohere Embed English é o modelo de representação de texto líder de mercado usado para pesquisa semântica, RAG (geração aumentada de recuperação), classificação e clustering. O modelo Embed English tem desempenho superior no parâmetro de comparação HuggingFace MTEB e é ideal em casos de uso para diversos setores, como financeiro, jurídico e corpora de uso geral. O Embed English também tem os seguintes atributos:

- A Inserção em Inglês tem 1.024 dimensões.

- A janela de contexto do modelo é de 512 tokens

Inserção do Cohere v3 – Multilíngue

O Cohere Embed Multilingual é o modelo de representação de texto líder de mercado usado para pesquisa semântica, RAG (geração aumentada de recuperação), classificação e clustering. Ele dá suporte a mais de 100 idiomas e pode ser usado para pesquisas em um idioma (por exemplo, pesquisar com uma consulta em francês em documentos em francês) e em vários idiomas (por exemplo, pesquisar com uma consulta em inglês em documentos em chinês). O Embed Multilingual oferece um desempenho de ponta em parâmetros de comparação multilíngues como o Miracl. O Embed Multilingual também tem os seguintes atributos:

- A Inserção Multilíngue tem 1.024 dimensões.

- A janela de contexto do modelo é de 512 tokens

Implantar como uma API sem servidor

Alguns modelos do catálogo de modelos podem ser implantados como uma API sem servidor com a cobrança paga conforme o uso. Esse tipo de implantação fornece uma maneira de consumir modelos como uma API sem hospedá-los em sua assinatura, ao mesmo tempo que mantém a segurança empresarial e a conformidade que as organizações precisam. Essa opção de implantação não requer cota de sua assinatura.

Os modelos Cohere mencionados anteriormente podem ser implantados como um serviço com cobranças pagas conforme o uso e são oferecidos pela Cohere por meio do Microsoft Azure Marketplace. A Cohere pode alterar ou atualizar os termos de uso e preços desses modelos.

Pré-requisitos

Uma assinatura do Azure com uma forma de pagamento válida. As assinaturas gratuitas ou de avaliação do Azure não funcionarão. Caso você não tenha uma assinatura do Azure, crie uma conta paga do Azure para começar.

-

Importante

Quanto aos modelos da família Cohere, a oferta de implantação de modelo de API sem servidor só está disponível com hubs criados na região Leste dos EUA 2 ou Suécia Central.

Um projeto do Estúdio de IA no Estúdio de IA do Azure.

O controle de acesso baseado em função do Azure é usado para permitir acesso a operações no Estúdio de IA do Azure. Para executar as etapas neste artigo, sua conta de usuário deve receber a função de Desenvolvedor de IA do Azure no grupo de recursos. Para obter mais informações sobre permissões, confira Controle de acesso baseado em função no Estúdio de IA do Azure.

Criar uma nova implantação

Os passos a seguir demonstram a implantação do Cohere Embed v3 - English, mas você pode seguir os mesmos passos para implementar o Cohere Embed v3 - Multilingual substituindo o nome do modelo.

Para criar uma implantação:

Entre no Azure AI Studio.

Selecione Catálogo de modelos na barra lateral esquerda.

Pesquise por Cohere.

Selecione o Cohere-embed-v3-english para abrir a página Detalhes do Modelo.

Selecione Implantar para abrir uma janela de implantação de API sem servidor para o modelo.

Como alternativa, você pode iniciar a implantação começando pelo seu projeto no Estúdio de IA.

Na barra lateral esquerda do projeto, selecione Componentes>Implantações.

Selecione + Criar implantação.

Pesquise e selecione Cohere-embed-v3-english. para abrir a página Detalhes do Modelo.

Selecione Confirmar para abrir uma janela de implantação de API sem servidor para o modelo.

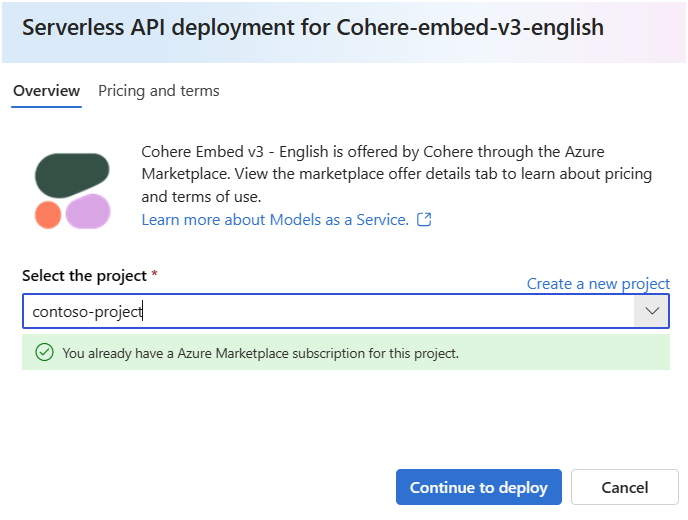

Selecione o projeto no qual você deseja implantar seu modelo. Para implantar o modelo, seu projeto deve estar nas regiões do Leste dos EUA 2 ou Suécia Central.

No assistente de implantação, selecione o link para Termos do Azure Marketplace para saber mais sobre os termos de uso.

Escolha a guia Preços e termos para saber mais sobre os preços do modelo selecionado.

Selecione o botão Assinar e Implantar. Se esta for a primeira vez implantando o modelo no projeto, você precisará inscrevê-lo na oferta específica. Esta etapa exige que sua conta tenha as permissões de função de Desenvolvedor de IA do Azure no Grupo de Recursos, conforme listado nos pré-requisitos. Cada projeto tem sua própria inscrição na oferta específica do Azure Marketplace do modelo, que permite controlar e monitorar os gastos. Atualmente, você pode ter apenas uma implantação para cada modelo em um projeto.

Depois de inscrever o projeto na oferta específica do Azure Marketplace, as implantações subsequentes da mesma oferta no mesmo projeto não exigirão a inscrição novamente. Se esse cenário se aplicar a você, haverá uma opção Continuar a implantar para seleção.

Dê um nome à implantação. Esse nome se torna parte da URL da API de implantação. Essa URL deve ser exclusiva em cada região do Azure.

Selecione Implantar. Quando a implantação estiver pronta, você será redirecionado para a página Implantações.

Selecione Abrir no playground para começar a interagir com o modelo.

Retorne à página Implantações, selecione a implantação e observe a URL de Destino do ponto de extremidade e a Chave Secreta. Para obter mais informações sobre como usar as APIs, consulte a seção Referência.

A qualquer momento, você pode encontrar os detalhes, a URL e as chaves de acesso do ponto de extremidade acessando a página Visão geral do projeto. Depois, na barra lateral esquerda do projeto, selecione Componentes>Implantações.

Para entender a cobrança dos modelos Cohere implantados como uma API sem servidor com pagamento conforme o uso baseado em tokens, confira Considerações sobre custos e cotas para modelos do Cohere implantados como um serviço.

Consumir os modelos de Inserção do Cohere como um serviço

Esses modelos podem ser consumidos usando a API de inserção.

Na página Visão geral do projeto, acesse a barra lateral esquerda e selecione Componentes>Implantações.

Encontre e selecione a implantação criada.

Copie a URL de Destino e o valor de Chave.

O Cohere expõe duas rotas para inferência com os modelos de Inserção v3 – Inglês e Inserção v3 – Multilíngue.

v1/embeddingsadere ao esquema da API de mensagens generativas de IA do Azure ev1/embeddá suporte ao esquema de API nativa da Cohere.Para obter mais informações sobre como usar as APIs, consulte a seção Referência.

Referência da API de Inserção para modelos de Inserção do Cohere implantados como um serviço

Cohere Embed v3 - English e Embed v3 - Multilingual aceitam tanto a API de Inferência de Modelo de IA do Azure na rota /embeddings quanto a API Cohere Embed v3 nativa em /embed.

API de Inferência de Modelo de IA do Azure

O esquema API de Inferência de Modelo de IA do Azure pode ser encontrado no artigo referência para incorporações e uma especificação da OpenAPI pode ser obtida no próprio ponto de extremidade.

Cohere Embed v3

A seguir contém detalhes sobre a API Cohere Embed v3.

Solicitar

POST /v1/embed HTTP/1.1

Host: <DEPLOYMENT_URI>

Authorization: Bearer <TOKEN>

Content-type: application/json

Esquema de solicitação de v1/embed

Inserção do Cohere v3, inglês e Inserção v3: multilíngue, aceitam os seguintes parâmetros para uma chamada de API v1/embed:

| Chave | Tipo | Padrão | Descrição |

|---|---|---|---|

texts |

array of strings |

Obrigatório | Uma matriz de cadeia de caracteres para o modelo de inserção. O número máximo de textos por chamada é 96. É recomendável reduzir o comprimento de cada texto para menos de 512 tokens, para obter a qualidade ideal. |

input_type |

enum string |

Obrigatório | Anexa tokens especiais para diferenciar os tipos entre si. Você não deve misturar tipos diferentes, exceto para pesquisa e recuperação. Nesse caso, incorpore o corpus com o tipo search_document e as consultas incorporadas com o tipo search_query. search_document – Em casos de uso de pesquisa, use search_document ao codificar documentos para as inserções armazenadas em um banco de dados vetorial. search_query – Use search_query ao consultar seu banco de dados vetorial para encontrar documentos relevantes. classification – Use classificação ao usar as inserções como entrada para um classificador de texto. clustering – Use clustering para agrupar as incorporações. |

truncate |

enum string |

NONE |

NONE – Retorna um erro quando a entrada excede o comprimento máximo do token de entrada. START – Descarta o início da entrada. END – Descarta o final da entrada. |

embedding_types |

array of strings |

float |

Especifica os tipos de inserções a serem recuperadas. Pode ser um ou mais dos tipos a seguir. float, int8, uint8, binary, ubinary |

Esquema de resposta de v1/embed

Inserção do Cohere v3, inglês e Inserção v3: multilíngue, incluem os seguintes campos na resposta:

| Chave | Type | Descrição |

|---|---|---|

response_type |

enum |

O tipo de resposta. Retorna embeddings_floats quando embedding_types não é especificado ou retorna embeddings_by_type quando embeddings_types é especificado. |

id |

integer |

Um identificador para a resposta. |

embeddings |

array ou array of objects |

Uma matriz de incorporações, em que cada incorporação é uma matriz de floats com 1.024 elementos. O comprimento da matriz de inserções é igual ao comprimento da matriz de textos originais. |

texts |

array of strings |

As entradas de texto para as quais as inserções foram retornadas. |

meta |

string |

Dados de uso da API, incluindo a versão atual e tokens faturáveis. |

Para obter mais informações, consulte https://docs.cohere.com/reference/embed.

Exemplos de v1/embed

Resposta embeddings_floats

Solicitação:

{

"input_type": "clustering",

"truncate": "START",

"texts":["hi", "hello"]

}

Resposta:

{

"id": "da7a104c-e504-4349-bcd4-4d69dfa02077",

"texts": [

"hi",

"hello"

],

"embeddings": [

[

...

],

[

...

]

],

"meta": {

"api_version": {

"version": "1"

},

"billed_units": {

"input_tokens": 2

}

},

"response_type": "embeddings_floats"

}

Resposta de Embeddings_by_types

Solicitação:

{

"input_type": "clustering",

"embedding_types": ["int8", "binary"],

"truncate": "START",

"texts":["hi", "hello"]

}

Resposta:

{

"id": "b604881a-a5e1-4283-8c0d-acbd715bf144",

"texts": [

"hi",

"hello"

],

"embeddings": {

"binary": [

[

...

],

[

...

]

],

"int8": [

[

...

],

[

...

]

]

},

"meta": {

"api_version": {

"version": "1"

},

"billed_units": {

"input_tokens": 2

}

},

"response_type": "embeddings_by_type"

}

Mais exemplos de inferência

| Pacote | Exemplo de notebook |

|---|---|

| CLI usando solicitações web CURL e Python | cohere-embed.ipynb |

| SDK do OpenAI (experimental) | openaisdk.ipynb |

| LangChain | langchain.ipynb |

| SDK da Cohere | cohere-sdk.ipynb |

| SDK do LiteLLM | litellm.ipynb |

Exemplos de Geração Aumentada de Recuperação (RAG) e uso de ferramentas

| Descrição | Pacote | Exemplo de notebook |

|---|---|---|

| Crie um índice de vetor local da Pesquisa de Similaridade de IA do Facebook (FAISS), usando as inserções do Cohere - Langchain | langchain, langchain_cohere |

cohere_faiss_langchain_embed.ipynb |

| Use o Comando Cohere R/R+ para responder às perguntas dos dados no índice de vetores FAISS local - Langchain | langchain, langchain_cohere |

command_faiss_langchain.ipynb |

| Use o Comando Cohere R/R+ para responder às perguntas dos dados no índice do vetor de pesquisa de IA - Langchain | langchain, langchain_cohere |

cohere-aisearch-langchain-rag.ipynb |

| Use o Comando Cohere R/R+ para responder às perguntas dos dados no índice vetorial de pesquisa de IA - SDK do Cohere | cohere, azure_search_documents |

cohere-aisearch-rag.ipynb |

| Comando R+ ferramenta/chamada de função, usando o LangChain | cohere, langchain, langchain_cohere |

command_tools-langchain.ipynb |

Custo e cotas

Considerações sobre custo e cota para modelos implantados como um serviço

Os modelos de coerência implantados como uma API sem servidor com cobrança paga conforme o uso são oferecidos pelo Cohere por meio do Azure Marketplace e integrados ao Estúdio de IA do Azure para uso. Você pode encontrar preços do Azure Marketplace ao implantar o modelo.

Sempre que um projeto se inscreve em determinada oferta do Azure Marketplace, um recurso é criado para acompanhar os custos associados ao consumo dele. O mesmo recurso é usado para acompanhar os custos associados à inferência. No entanto, vários medidores estão disponíveis para acompanhar cada cenário de modo independente.

Para obter mais informações sobre como acompanhar os custos, consulte Monitorar os custos dos modelos oferecidos por meio do Azure Marketplace.

A cota é gerenciada por implantação. Cada implantação tem um limite de taxa de 200.000 tokens por minuto e 1.000 solicitações de API por minuto. No entanto, atualmente, limitamos uma implantação por modelo e projeto. Entre em contato com o Suporte do Microsoft Azure se os limites de taxa atuais não forem suficientes para seus cenários.

Filtragem de conteúdo

Os modelos implantados como uma API sem servidor são protegidos pelaSegurança de Conteúdo de IA do Azure. Com a Segurança de Conteúdo de IA do Azure, o prompt e o preenchimento passam por um conjunto de modelos de classificação destinados a detectar e impedir a saída de conteúdo prejudicial. O sistema de filtragem de conteúdo detecta e executa ações em categorias específicas de conteúdo potencialmente prejudicial em prompts de entrada e conclusões de saída. Saiba mais sobre filtragem de conteúdo aqui.

Conteúdo relacionado

Comentários

Em breve: Ao longo de 2024, eliminaremos os problemas do GitHub como o mecanismo de comentários para conteúdo e o substituiremos por um novo sistema de comentários. Para obter mais informações, consulte https://aka.ms/ContentUserFeedback.

Enviar e exibir comentários de