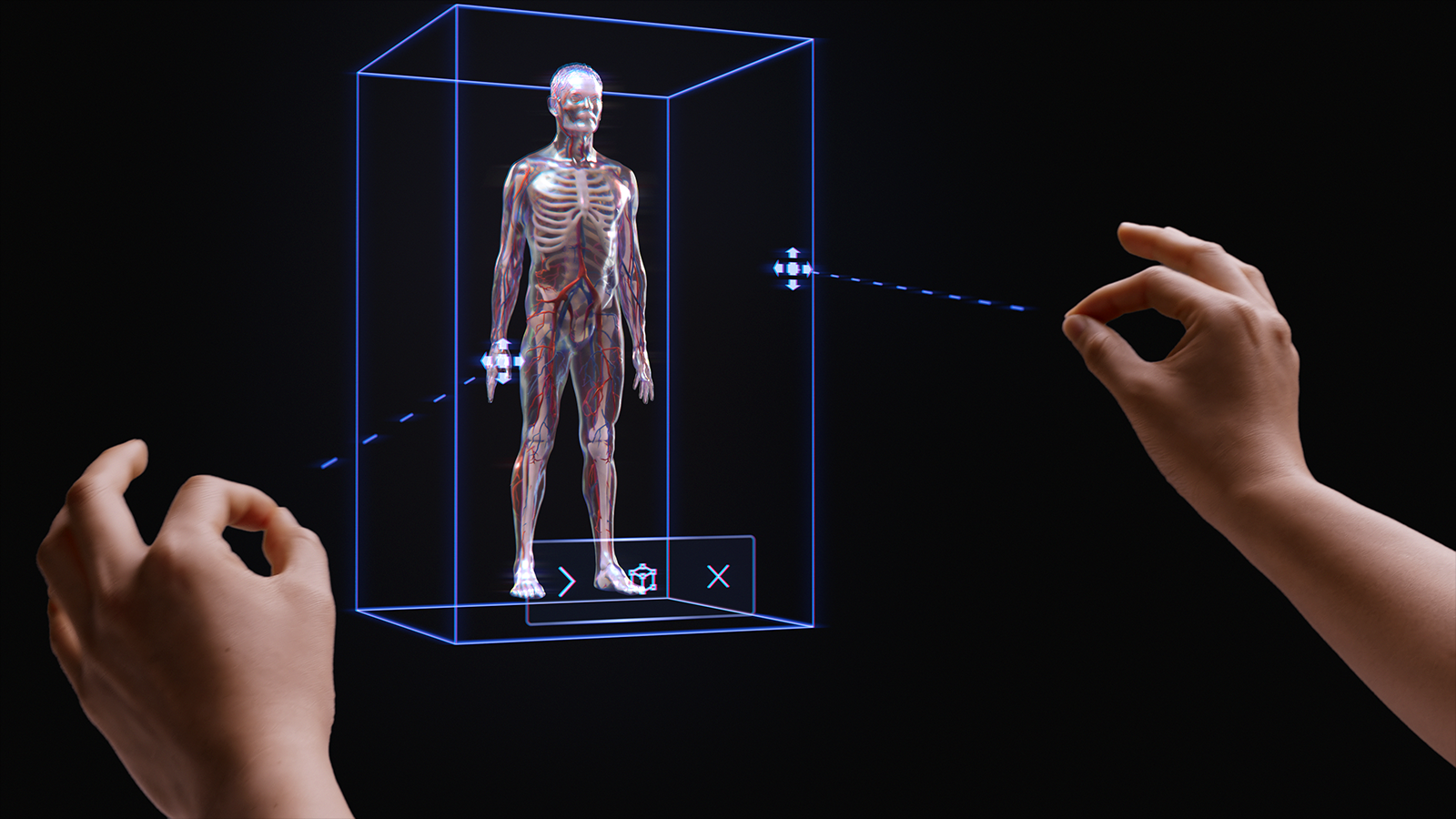

Apresentação de interações instintivas

A filosofia de interações simples e instintivas está presente em toda a plataforma de MR (realidade misturada). Temos três etapas para os desenvolvedores e designers de aplicativos fornecerem interações fáceis e intuitivas para os clientes deles.

Primeiro, confirmamos que os nossos sensores e as tecnologias de entrada se combinam em modelos de interação multimodal. Esses modelos de interação incluem o acompanhamento ocular e de mão, juntamente com a entrada de idioma natural. Com base em nossa pesquisa, projetar e desenvolver em uma estrutura multimodal (em vez de com base em entradas individuais) é o segredo para criar experiências instintivas.

Em segundo lugar, reconhecemos que muitos desenvolvedores destinam suas criações a vários dispositivos HoloLens, por exemplo, HoloLens 2 e HoloLens (1ª geração) ou então HoloLens e VR. Sendo assim, criamos nossos modelos de interação para que funcionem em vários dispositivos (mesmo que a tecnologia de entrada varie em cada dispositivo). Por exemplo, a interação à distância em um headset imersivo do Windows com um controlador 6DoF e o HoloLens 2 usam funcionalidades e padrões idênticos. Isso facilita o desenvolvimento de aplicativos entre dispositivos e proporciona uma sensação natural às interações do usuário.

Ainda que reconheçamos que há milhares de interações eficazes, envolventes e mágicas possíveis na MR, descobrimos que empregar intencionalmente um só modelo de interação em um aplicativo é a melhor maneira de garantir que os usuários sejam bem-sucedidos e tenham uma ótima experiência. Para isso, incluímos três coisas neste guia de interação:

- Diretrizes específicas sobre os três principais modelos de interação e os componentes e os padrões necessários para cada um.

- Diretrizes complementares sobre os outros benefícios fornecidos por nossa plataforma.

- Diretrizes gerais para ajudar a selecionar o modelo de interação apropriado para seu cenário de desenvolvimento.

Demonstração do rastreamento básico de mãos e interações instintivas

Confira abaixo nosso vídeo de demonstração do Projetando hologramas - rastreamento da cabeça e rastreamento dos olhos e prossiga para saber mais sobre os tópicos específicos:

Este vídeo foi obtido do aplicativo HoloLens 2 "Designing Holograms". Baixe-o e aproveite a experiência completa aqui.

Modelos de interação multimodal

Com base nas pesquisas e nos comentários dos clientes, descobrimos que três modelos de interação principais atendem à maioria das experiências de Realidade Misturada. Em muitos aspectos, o modelo de interação é o modelo mental do usuário para a maneira como concluir um fluxo de trabalho. Cada um desses modelos de interação é otimizado para um conjunto de necessidades do cliente e é conveniente, avançado e utilizável quando usado corretamente.

O gráfico abaixo é uma visão geral simplificada. Há links para informações detalhadas de uso de cada modelo de interação nas páginas abaixo com imagens e exemplos de código.

| Modelo | Cenários de exemplo | Ajustar | Hardware |

| Controladores de movimentos e mãos | Experiências 3D espaciais, por exemplo, design e layout espacial, manipulação de conteúdo ou simulação. | Excelente para novos usuários, juntamente com voz, acompanhamento ocular ou foco com a cabeça. Baixa curva de aprendizado. Experiência do usuário consistente com acompanhamento da mão e controladores 6DoF. | HoloLens 2 Headsets imersivos |

| Mãos livres | Experiências contextuais, nas quais as mãos de um usuário estão ocupadas, por exemplo, no aprendizado no trabalho e na manutenção. | Algum aprendizado é necessário. Caso as mãos não estejam disponíveis, o dispositivo emparelha bem com voz e linguagem natural. | HoloLens 2 HoloLens (1ª geração) Headsets imersivos |

| Focar e confirmar | Experiências de clique, por exemplo, apresentações 3D, demonstrações. | Requer treinamento em HMDs, mas não em dispositivos móveis. Melhor para controladores acessíveis. Melhor para HoloLens (1ª geração). | HoloLens 2 HoloLens (1ª geração) Headsets imersivos AR móvel |

Para evitar lacunas na experiência de interação do usuário, é melhor seguir as diretrizes para um só modelo, do início ao fim.

As seções a seguir seguem as etapas de seleção e implementação de um desses modelos de interação.

No final desta página, você entenderá nossas diretrizes sobre como:

- Escolhendo um modelo de interação para seu cliente

- Implementar o modelo de interação

- Transição entre os modelos de interação

- Próximas etapas de design

Escolha um modelo de interação para seu cliente

Na maioria dos casos, os desenvolvedores e criadores pensaram nos tipos de interações que seus clientes podem ter. Para incentivar uma abordagem do design voltada para o cliente, é recomendável seguir as orientações abaixo para selecionar o modelo de interação que é otimizado para o cliente.

Por que seguir esta orientação?

- Testamos nossos modelos de interação com critérios objetivos e subjetivos, incluindo esforço físico e cognitivo, intuitividade e capacidade de aprendizado.

- Como as interações são diferentes, as funcionalidades de áudio/visuais e o comportamento de objeto podem ser diferentes entre os modelos de interação.

- Combinar partes de vários modelos de interação cria o risco de funcionalidades conflitantes, tais como raios de mão simultâneos e um cursor de foco com a cabeça. Isso pode sobrecarregar e confundir os usuários.

Aqui estão alguns exemplos de como as capacidades e os comportamentos são otimizados para cada modelo de interação. Vemos com frequência que novos usuários têm perguntas semelhantes, como "como faço para saber se o sistema está funcionando” , “como saber o que posso fazer” e “como saber se entendi o que acabei de fazer?"

| Modelo | Como saber se está funcionando? | Como saber o que posso fazer? | Como saber o que eu acabei de fazer? |

| Controladores de movimentos e mãos | Vejo uma malha de mão, uma funcionalidade de ponta do dedo ou raios de mão/controlador. | Vejo alças ou uma caixa delimitadora é exibida quando a minha mão está próxima de um objeto. | Posso ouvir sons e ver animações ao capturar e soltar. |

| Focar com a cabeça e confirmar | Eu vejo um cursor no centro do meu campo de visão. | O cursor muda de estado quando está sobre determinados objetos. | Posso ver/ouvir confirmações visuais e audíveis quando executo uma ação. |

| Mãos livres (foco com a cabeça e permanência) | Eu vejo um cursor no centro do meu campo de visão. | Vejo um indicador de progresso quando paro em um objeto com o qual posso interagir. | Posso ver/ouvir confirmações visuais e audíveis quando executo uma ação. |

| Mãos livres (comandos de voz) | Vejo um indicador de escuta e legendas que mostram o que o sistema ouviu. | Obtenho prompts de voz e dicas. Quando digo: "O que posso falar?" Vejo feedback. | Vejo/ouço confirmações visuais e auditivas quando emito um comando ou obtenho uma experiência de usuário de desambiguação quando necessário. |

Veja as perguntas que descobrimos que ajudam as equipes e selecionar um modelo de interação:

P: Meus usuários desejam tocar nos hologramas e fazer manipulações holográficas de precisão?

R: Nesse caso, confira o Modelo de interação com as mãos e controladores de movimentos para direcionamento e manipulação de precisão.P: Meus usuários precisam manter as mãos livres para tarefas do mundo real?

R: Nesse caso, examine o Modelo de interação de mãos livres, que fornece uma ótima experiência de mãos livres por meio de interações de foco e voz.P: Meus usuários têm tempo para aprender as interações do meu aplicativo de MR ou precisam das interações com a curva de aprendizado mais baixa possível?

R: Para obter a curva de aprendizado mais baixa e as interações mais intuitivas, recomendamos o Modelo de mãos e de controladores de movimentos, desde que os usuários possam usar as mãos para interação.P: Meus usuários usam controladores de movimentos para apontar para objetos e manipulá-los?

R: O Modelo de mãos e de controladores de movimentos inclui todas as diretrizes para proporcionar uma ótima experiência com os controladores de movimentos.P: Meus usuários usam um controlador de acessibilidade ou um controlador de Bluetooth comum, como um clicker?

R: Recomendamos o Modelo de foco com a cabeça e de confirmação para todos os controladores não acompanhados. Ele foi projetado para permitir que um usuário passe por uma experiência completa com um mecanismo simples de "direcionar e confirmar".P: Meus usuários progridem por uma experiência somente "clicando" (por exemplo em um ambiente de apresentação de slides 3D), em vez de navegar por layouts densos de controles de interface de usuário?

R: Caso os usuários não precisem controlar muitos aspectos da interface do usuário, o foco com a cabeça e a confirmação oferecem uma opção que pode ser aprendida, na qual os usuários não precisam se preocupar com o direcionamento.P: Meus usuários usam os headsets imersivos do HoloLens (1ª geração) e do HoloLens 2/Windows Mixed Reality (VR)?

R: Como o foco com a cabeça e a confirmação é o modelo de interação do HoloLens (1ª geração), recomendamos que os criadores que dão suporte ao HoloLens (1ª geração) usem o foco com a cabeça e a confirmação para os recursos ou os modos que os usuários experimentarão em um headset do HoloLens (1ª geração). Confira a próxima seção sobre Transição de modelos de interação para obter detalhes sobre como ter uma ótima experiência em várias gerações do HoloLens.P: E quanto aos usuários que usam dispositivos móveis, que abrangem um espaço amplo ou a movimentação entre espaços, em relação aos usuários que tendem a trabalhar em um só espaço?

R: Qualquer um dos modelos de interação funcionará para esses usuários.

Observação

Mais diretrizes específicas ao design de aplicativo em breve.

Modelos de interação de transição

Também há casos de uso que podem exigir o uso de mais de um modelo de interação. Por exemplo, o fluxo de criação do seu aplicativo usa o modelo de interação de "mãos e controladores de movimentos" , mas o ideal é empregar um modo de mãos livres para técnicos de campo. Se a sua experiência exigir vários modelos de interação, os usuários poderão ter dificuldade em fazer a transição de um modelo para outro, especialmente quando estiverem se familiarizando com a Realidade Misturada.

Observação

Estamos trabalhando constantemente em mais diretrizes que estarão disponíveis para desenvolvedores e designers, informando-os sobre como, quando e por que usar vários modelos de interação de realidade misturada.