Nota

O acesso a esta página requer autorização. Pode tentar iniciar sessão ou alterar os diretórios.

O acesso a esta página requer autorização. Pode tentar alterar os diretórios.

Comece a usar imagens em seus bate-papos com o Azure OpenAI no Azure AI Foundry Models.

Importante

Taxas de uso adicionais podem ser aplicadas ao usar modelos de conclusão de bate-papo com funcionalidade de visão.

Use este artigo para começar a usar o Azure AI Foundry para implantar e testar um modelo de conclusão de bate-papo com compreensão de imagem.

Pré-requisitos

- Uma assinatura do Azure. Crie um gratuitamente.

- Depois de ter sua assinatura do Azure, crie um recurso do Azure OpenAI . Para obter mais informações sobre a criação de recursos, consulte o guia de implantação de recursos.

- Um projeto do Azure AI Foundry com seu recurso do Azure OpenAI adicionado como uma conexão.

Prepare os seus conteúdos multimédia

Você precisa de uma imagem para concluir este tutorial rápido. Você pode usar esta imagem de exemplo ou qualquer outra imagem disponível.

Ir para Azure AI Foundry

- Navegue até Azure AI Foundry e entre com as credenciais associadas ao seu recurso do Azure OpenAI. Durante ou após o processo de início de sessão, selecione o diretório apropriado, a assinatura do Azure e o recurso do Azure OpenAI.

- Selecione o projeto no qual você gostaria de trabalhar.

- No menu de navegação à esquerda, selecione Modelos + endpoints e, em seguida, selecione + Implementar modelo.

- Escolha uma implementação com capacidade de imagem selecionando o nome do modelo: gpt-4o ou gpt-4o-mini. Na janela exibida, selecione um nome e um tipo de implantação. Verifique se seu recurso do Azure OpenAI está conectado. Para obter mais informações sobre a implementação de modelos, veja o guia de implementação de recursos.

- Selecione Implantar.

- Em seguida, selecione o seu novo modelo e selecione Abrir no playground. Na área de teste do chat, a implantação criada deve ser selecionada na lista pendente Implantação.

Parque Infantil

Nesta sessão de chat, você instrui o assistente para ajudá-lo a entender as imagens que você inserir.

Para obter ajuda geral com a configuração do assistente, sessões de chat, configurações e painéis, consulte o Guia de início rápido do bate-papo.

Iniciar uma sessão de chat para analisar imagens

Nesta sessão de bate-papo, você está instruindo o assistente para ajudar a entender as imagens que você inserir.

Para começar, verifique se a implantação com suporte a imagem está selecionada no menu de seleção Implantação.

Na caixa de texto de contexto no painel Configuração , forneça este prompt para orientar o assistente:

"You're an AI assistant that helps people find information."Ou, você pode personalizar o prompt para sua imagem ou cenário.Observação

Recomendamos que você atualize a mensagem do sistema para ser específica para a tarefa, a fim de evitar respostas inúteis do modelo.

Selecione Aplicar alterações para salvar as alterações.

No painel de sessões de chat, selecione o botão de anexo e, em seguida, Carregar imagem. Escolha a sua imagem.

Adicione o seguinte prompt no campo de chat:

Describe this imagee, em seguida, selecione o ícone de envio para enviá-lo.O ícone de envio é substituído por um botão de parada. Se você selecioná-lo, o assistente para de processar sua solicitação. Para este início rápido, deixe o assistente terminar sua resposta.

O assistente responde com uma descrição da imagem.

Faça uma pergunta de acompanhamento relacionada com a análise da sua imagem. Você poderia entrar,

"What should I highlight about this image to my insurance company?".Você deve receber uma resposta relevante semelhante à mostrada aqui:

When reporting the incident to your insurance company, you should highlight the following key points from the image: 1. **Location of Damage**: Clearly state that the front end of the car, particularly the driver's side, is damaged. Mention the crumpled hood, broken front bumper, and the damaged left headlight. 2. **Point of Impact**: Indicate that the car has collided with a guardrail, which may suggest that no other vehicles were involved in the accident. 3. **Condition of the Car**: Note that the damage seems to be concentrated on the front end, and there is no visible damage to the windshield or rear of the car from this perspective. 4. **License Plate Visibility**: Mention that the license plate is intact and can be used for identification purposes. 5. **Environment**: Report that the accident occurred near a roadside with a guardrail, possibly in a rural or semi-rural area, which might help in establishing the accident location and context. 6. **Other Observations**: If there were any other circumstances or details not visible in the image that may have contributed to the accident, such as weather conditions, road conditions, or any other relevant information, be sure to include those as well. Remember to be factual and descriptive, avoiding speculation about the cause of the accident, as the insurance company will conduct its own investigation.

Ver e exportar código

A qualquer momento da sessão de chat, você pode ativar a opção Mostrar JSON bruto na parte superior da janela de bate-papo para ver a conversa formatada como JSON. Veja como é no início da sessão de bate-papo de início rápido:

[

{

"role": "system",

"content": [

"You are an AI assistant that helps people find information."

]

},

]

Limpeza de recursos

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Use este artigo para começar a usar as APIs REST do Azure OpenAI para implantar e usar o modelo GPT-4 Turbo with Vision.

Pré-requisitos

- Uma assinatura do Azure. Crie um gratuitamente.

- Python 3.8 ou versão posterior.

- As seguintes bibliotecas Python:

requests,json. - Um recurso do Azure OpenAI no Azure AI Foundry Models com um modelo GPT-4 Turbo com Visão implantado. Consulte a disponibilidade dos modelos GPT-4 e GPT-4 Turbo Preview para obter as regiões disponíveis. Para obter mais informações sobre a criação de recursos, consulte o guia de implantação de recursos.

Observação

Atualmente, não há suporte para desativar a filtragem de conteúdo para o modelo GPT-4 Turbo with Vision.

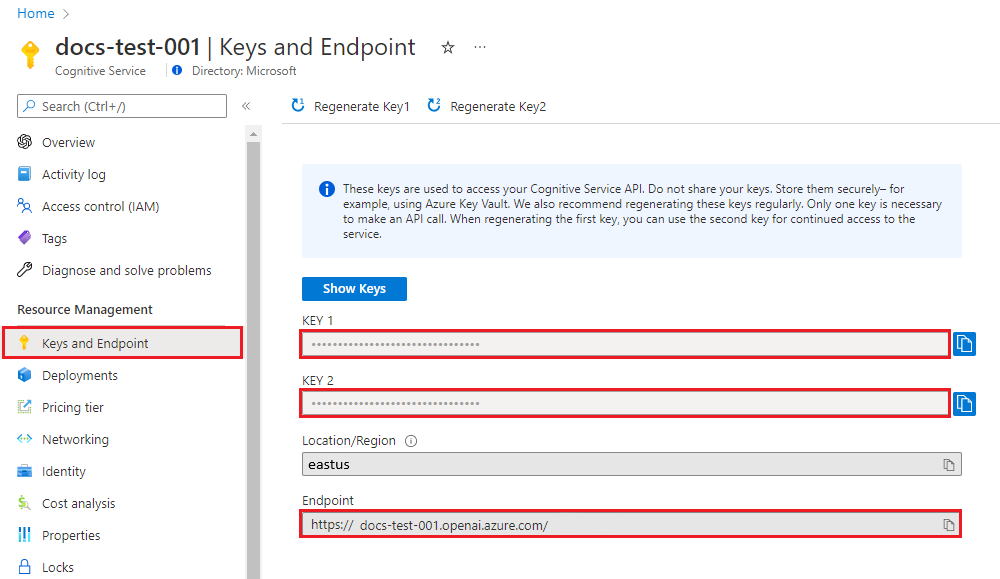

Recuperar a chave e o endpoint

Para chamar com êxito as APIs do Azure OpenAI, você precisa das seguintes informações sobre seu recurso do Azure OpenAI:

| Variável | Nome | Valor |

|---|---|---|

| Ponto final | api_base |

O valor do ponto de extremidade está localizado em Chaves e Ponto de Extremidade para seu recurso no portal do Azure. Você também pode encontrar o ponto final através da página de Implementações no portal Azure AI Foundry. Um exemplo de ponto de extremidade é: https://docs-test-001.openai.azure.com/. |

| Chave | api_key |

O valor da chave também está localizado em Chaves e Endpoint para o seu recurso no portal do Azure. O Azure gera duas chaves para o seu recurso. Você pode usar qualquer um dos valores. |

Vá para o seu recurso no portal do Azure. No painel de navegação, selecione Chaves e Ponto Final em Gerenciamento de Recursos. Copie o valor Endpoint e um valor de chave de acesso. Você pode usar o valor KEY 1 ou KEY 2 . Ter duas chaves permite que você gire e regenere chaves com segurança sem causar uma interrupção do serviço.

Criar uma aplicação Python nova

Crie um novo arquivo Python chamado quickstart.py. Abra o novo arquivo em seu editor ou IDE preferido.

Substitua o conteúdo do quickstart.py pelo código a seguir.

# Packages required: import requests import json api_base = '<your_azure_openai_endpoint>' deployment_name = '<your_deployment_name>' API_KEY = '<your_azure_openai_key>' base_url = f"{api_base}openai/deployments/{deployment_name}" headers = { "Content-Type": "application/json", "api-key": API_KEY } # Prepare endpoint, headers, and request body endpoint = f"{base_url}/chat/completions?api-version=2023-12-01-preview" data = { "messages": [ { "role": "system", "content": "You are a helpful assistant." }, { "role": "user", "content": [ { "type": "text", "text": "Describe this picture:" }, { "type": "image_url", "image_url": { "url": "<image URL>" } } ] } ], "max_tokens": 2000 } # Make the API call response = requests.post(endpoint, headers=headers, data=json.dumps(data)) print(f"Status Code: {response.status_code}") print(response.text)Faça as seguintes alterações:

- Insira o URL do ponto final e a chave nos campos apropriados.

- Insira o nome da implantação do GPT-4 Turbo with Vision no campo apropriado.

- Altere o

"image"valor do campo para o URL da sua imagem.Sugestão

Você também pode usar dados de imagem codificados em base 64 em vez de um URL. Para obter mais informações, consulte o guia de instruções do GPT-4 Turbo with Vision.

Execute o aplicativo com o

pythoncomando:python quickstart.py

Limpeza de recursos

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Use este artigo para começar a usar o SDK do Azure OpenAI Python para implantar e usar o modelo GPT-4 Turbo with Vision.

Código-fonte da biblioteca | Pacote (PyPi) |

Pré-requisitos

- Uma assinatura do Azure. Crie um gratuitamente.

- Python 3.8 ou versão posterior.

- As seguintes bibliotecas Python:

os - Um recurso do Azure OpenAI no Azure AI Foundry Models com um modelo GPT-4 Turbo com Visão implantado. Consulte a disponibilidade dos modelos GPT-4 e GPT-4 Turbo Preview para obter as regiões disponíveis. Para obter mais informações sobre a criação de recursos, consulte o guia de implantação de recursos.

Configurar

Instale a biblioteca de cliente OpenAI Python com:

pip install openai

Observação

Esta biblioteca é mantida pela OpenAI. Consulte o histórico de versões para acompanhar as atualizações mais recentes da biblioteca.

Recuperar a chave e o endpoint

Para efetuar uma chamada com êxito no Azure OpenAI, necessita de um endpoint e de uma chave.

| Nome da variável | Valor |

|---|---|

ENDPOINT |

O ponto de extremidade do serviço pode ser encontrado na seção Chaves & Ponto de Extremidade ao examinar seu recurso no portal do Azure. Como alternativa, pode encontrar o endpoint através da página Implantações no portal do Azure AI Foundry. Um exemplo de ponto de extremidade é: https://docs-test-001.openai.azure.com/. |

API-KEY |

Este valor pode ser encontrado na secção Chaves e Ponto Final ao examinar o recurso no portal do Azure. Pode utilizar KEY1 ou KEY2. |

Vá para o seu recurso no portal do Azure. A seção Chaves & Ponto Final pode ser encontrada na seção Gerenciamento de Recursos. Copie seu endpoint e sua chave de acesso, pois você precisará de ambos para autenticar suas chamadas de API. Pode utilizar KEY1 ou KEY2. Ter sempre duas chaves permite-lhe alternar e regenerar as suas chaves com segurança, sem causar uma interrupção do serviço.

Variáveis de ambiente

Crie e atribua variáveis de ambiente persistentes para sua chave e endpoint.

Importante

Recomendamos a autenticação do Microsoft Entra ID com identidades gerenciadas para recursos do Azure para evitar o armazenamento de credenciais com seus aplicativos executados na nuvem.

Use chaves de API com cuidado. Não inclua a chave da API diretamente no seu código e nunca a publique publicamente. Se estiver usando chaves de API, armazene-as com segurança no Cofre de Chaves do Azure, gire as chaves regularmente e restrinja o acesso ao Cofre de Chaves do Azure usando controle de acesso baseado em função e restrições de acesso à rede. Para obter mais informações sobre como usar chaves de API com segurança em seus aplicativos, consulte Chaves de API com o Cofre de Chaves do Azure.

Para obter mais informações sobre segurança de serviços de IA, consulte Autenticar solicitações para serviços de IA do Azure.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

Criar uma aplicação Python nova

Crie um novo arquivo Python chamado quickstart.py. Abra o novo arquivo em seu editor ou IDE preferido.

Substitua o conteúdo do quickstart.py pelo código a seguir.

from openai import AzureOpenAI api_base = os.getenv("AZURE_OPENAI_ENDPOINT") api_key= os.getenv("AZURE_OPENAI_API_KEY") deployment_name = '<your_deployment_name>' api_version = '2023-12-01-preview' # this might change in the future client = AzureOpenAI( api_key=api_key, api_version=api_version, base_url=f"{api_base}/openai/deployments/{deployment_name}" ) response = client.chat.completions.create( model=deployment_name, messages=[ { "role": "system", "content": "You are a helpful assistant." }, { "role": "user", "content": [ { "type": "text", "text": "Describe this picture:" }, { "type": "image_url", "image_url": { "url": "<image URL>" } } ] } ], max_tokens=2000 ) print(response)Faça as seguintes alterações:

- Digite o nome da sua implantação GPT-4 Turbo com Visão no campo apropriado.

- Altere o

"url"valor do campo para o URL da sua imagem.Sugestão

Você também pode usar dados de imagem codificados em base 64 em vez de um URL. Para obter mais informações, consulte o guia de instruções do GPT-4 Turbo with Vision.

Execute o aplicativo com o

pythoncomando:python quickstart.py

Importante

Use chaves de API com cuidado. Não inclua a chave da API diretamente no seu código e nunca a publique publicamente. Se você usar uma chave de API, armazene-a com segurança no Cofre de Chaves do Azure. Para obter mais informações sobre como usar chaves de API com segurança em seus aplicativos, consulte Chaves de API com o Cofre de Chaves do Azure.

Para obter mais informações sobre segurança de serviços de IA, consulte Autenticar solicitações para serviços de IA do Azure.

Limpeza de recursos

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Use este artigo para começar a usar o OpenAI JavaScript SDK para implantar e usar o modelo GPT-4 Turbo with Vision.

Este SDK é fornecido pelo OpenAI, incluindo tipos específicos para Azure providenciados pelo Azure.

Documentação de referência | Código-fonte da biblioteca | Pacote (npm) | Exemplos

Pré-requisitos

- Uma assinatura do Azure - Crie uma gratuitamente

- Versões LTS do Node.js

- CLI do Azure usada para autenticação sem senha em um ambiente de desenvolvimento local, crie o contexto necessário entrando com a CLI do Azure.

- Um recurso OpenAI do Azure criado em uma região com suporte (consulte Disponibilidade da região). Para obter mais informações, consulte Criar um recurso e implantar um modelo com o Azure OpenAI.

Observação

Esta biblioteca é mantida pela OpenAI. Consulte o histórico de versões para acompanhar as atualizações mais recentes da biblioteca.

Pré-requisitos do Microsoft Entra ID

Para a autenticação sem chave recomendada com o Microsoft Entra ID, você precisa:

- Instale a CLI do Azure usada para autenticação sem chave com o Microsoft Entra ID.

- Atribua a

Cognitive Services Userfunção à sua conta de utilizador. Você pode atribuir funções no portal do Azure em Controle de acesso (IAM)>Adicionar atribuição de função.

Configurar

Crie uma nova pasta

vision-quickstarte vá para a pasta de início rápido com o seguinte comando:mkdir vision-quickstart && cd vision-quickstartCrie o

package.jsoncom o seguinte comando:npm init -yInstale a biblioteca de cliente OpenAI para JavaScript com:

npm install openaiPara a autenticação sem senha recomendada :

npm install @azure/identity

Obter informações do recurso

Você precisa recuperar as seguintes informações para autenticar seu aplicativo com seu recurso do Azure OpenAI:

| Nome da variável | Valor |

|---|---|

AZURE_OPENAI_ENDPOINT |

Esse valor pode ser encontrado na seção Chaves e Ponto de Extremidade ao examinar seu recurso no portal do Azure. |

AZURE_OPENAI_DEPLOYMENT_NAME |

Este valor corresponderá ao nome personalizado que escolheu para a implementação quando implementou um modelo. Esse valor pode ser encontrado em Gerenciamento de Recursos>Implantações de Modelo no portal do Azure. |

OPENAI_API_VERSION |

Saiba mais sobre as versões da API. Você pode alterar a versão no código ou usar uma variável de ambiente. |

Saiba mais sobre autenticação sem chave e configuração de variáveis de ambiente.

Atenção

Para usar a autenticação sem chave recomendada com o SDK, verifique se a AZURE_OPENAI_API_KEY variável de ambiente não está definida.

Criar uma nova aplicação JavaScript para sugestões de imagem

Selecione uma imagem dos azure-samples/cognitive-services-sample-data-files. Use o URL da imagem no código abaixo ou defina a variável de IMAGE_URL ambiente como a URL da imagem.

Sugestão

Você também pode usar dados de imagem codificados em base 64 em vez de um URL. Para obter mais informações, consulte o guia de instruções do GPT-4 Turbo with Vision.

Crie o

index.jsarquivo com o seguinte código:const AzureOpenAI = require('openai').AzureOpenAI; const { DefaultAzureCredential, getBearerTokenProvider } = require('@azure/identity'); // You will need to set these environment variables or edit the following values const endpoint = process.env.AZURE_OPENAI_ENDPOINT || "Your endpoint"; const imageUrl = process.env.IMAGE_URL || "<image url>"; // Required Azure OpenAI deployment name and API version const apiVersion = process.env.OPENAI_API_VERSION || "2024-07-01-preview"; const deploymentName = process.env.AZURE_OPENAI_DEPLOYMENT_NAME || "gpt-4-with-turbo"; // keyless authentication const credential = new DefaultAzureCredential(); const scope = "https://cognitiveservices.azure.com/.default"; const azureADTokenProvider = getBearerTokenProvider(credential, scope); function getClient(): AzureOpenAI { return new AzureOpenAI({ endpoint, azureADTokenProvider, apiVersion, deployment: deploymentName, }); } function createMessages() { return { messages: [ { role: "system", content: "You are a helpful assistant." }, { role: "user", content: [ { type: "text", text: "Describe this picture:", }, { type: "image_url", image_url: { url: imageUrl, }, }, ], }, ], model: "", max_tokens: 2000, }; } async function printChoices(completion) { for (const choice of completion.choices) { console.log(choice.message); } } export async function main() { console.log("== Get GPT-4 Turbo with vision Sample =="); const client = getClient(); const messages = createMessages(); const completion = await client.chat.completions.create(messages); await printChoices(completion); } main().catch((err) => { console.error("Error occurred:", err); });Entre no Azure com o seguinte comando:

az loginExecute o arquivo JavaScript.

node index.js

Limpeza de recursos

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Use este artigo para começar a usar o OpenAI JavaScript SDK para implantar e usar o modelo GPT-4 Turbo with Vision.

Este SDK é fornecido pelo OpenAI, incluindo tipos específicos para Azure providenciados pelo Azure.

Documentação de referência | Código-fonte da biblioteca | Pacote (npm) | Exemplos

Pré-requisitos

- Uma assinatura do Azure - Crie uma gratuitamente

- Versões LTS do Node.js

- TypeScript

- CLI do Azure usada para autenticação sem senha em um ambiente de desenvolvimento local, crie o contexto necessário entrando com a CLI do Azure.

- Um recurso OpenAI do Azure criado em uma região com suporte (consulte Disponibilidade da região). Para obter mais informações, consulte Criar um recurso e implantar um modelo com o Azure OpenAI.

Observação

Esta biblioteca é mantida pela OpenAI. Consulte o histórico de versões para acompanhar as atualizações mais recentes da biblioteca.

Pré-requisitos do Microsoft Entra ID

Para a autenticação sem chave recomendada com o Microsoft Entra ID, você precisa:

- Instale a CLI do Azure usada para autenticação sem chave com o Microsoft Entra ID.

- Atribua a

Cognitive Services Userfunção à sua conta de utilizador. Você pode atribuir funções no portal do Azure em Controle de acesso (IAM)>Adicionar atribuição de função.

Configurar

Crie uma nova pasta

vision-quickstarte vá para a pasta de início rápido com o seguinte comando:mkdir vision-quickstart && cd vision-quickstartCrie o

package.jsoncom o seguinte comando:npm init -yAtualize o

package.jsonpara ECMAScript com o seguinte comando:npm pkg set type=moduleInstale a biblioteca de cliente OpenAI para JavaScript com:

npm install openaiPara a autenticação sem senha recomendada :

npm install @azure/identity

Obter informações do recurso

Você precisa recuperar as seguintes informações para autenticar seu aplicativo com seu recurso do Azure OpenAI:

| Nome da variável | Valor |

|---|---|

AZURE_OPENAI_ENDPOINT |

Esse valor pode ser encontrado na seção Chaves e Ponto de Extremidade ao examinar seu recurso no portal do Azure. |

AZURE_OPENAI_DEPLOYMENT_NAME |

Este valor corresponderá ao nome personalizado que escolheu para a implementação quando implementou um modelo. Esse valor pode ser encontrado em Gerenciamento de Recursos>Implantações de Modelo no portal do Azure. |

OPENAI_API_VERSION |

Saiba mais sobre as versões da API. Você pode alterar a versão no código ou usar uma variável de ambiente. |

Saiba mais sobre autenticação sem chave e configuração de variáveis de ambiente.

Atenção

Para usar a autenticação sem chave recomendada com o SDK, verifique se a AZURE_OPENAI_API_KEY variável de ambiente não está definida.

Criar uma nova aplicação JavaScript para sugestões de imagem

Selecione uma imagem dos azure-samples/cognitive-services-sample-data-files. Use o URL da imagem no código abaixo ou defina a variável de IMAGE_URL ambiente como a URL da imagem.

Sugestão

Você também pode usar dados de imagem codificados em base 64 em vez de um URL. Para obter mais informações, consulte o guia de instruções do GPT-4 Turbo with Vision.

Crie o

index.tsarquivo com o seguinte código:import { AzureOpenAI } from "openai"; import { DefaultAzureCredential, getBearerTokenProvider } from "@azure/identity"; import type { ChatCompletion, ChatCompletionCreateParamsNonStreaming, } from "openai/resources/index"; // You will need to set these environment variables or edit the following values const endpoint = process.env.AZURE_OPENAI_ENDPOINT || "Your endpoint"; const imageUrl = process.env["IMAGE_URL"] || "<image url>"; // Required Azure OpenAI deployment name and API version const apiVersion = process.env.OPENAI_API_VERSION || "2024-07-01-preview"; const deploymentName = process.env.AZURE_OPENAI_DEPLOYMENT_NAME || "gpt-4-with-turbo"; // keyless authentication const credential = new DefaultAzureCredential(); const scope = "https://cognitiveservices.azure.com/.default"; const azureADTokenProvider = getBearerTokenProvider(credential, scope); function getClient(): AzureOpenAI { return new AzureOpenAI({ endpoint, azureADTokenProvider, apiVersion, deployment: deploymentName, }); } function createMessages(): ChatCompletionCreateParamsNonStreaming { return { messages: [ { role: "system", content: "You are a helpful assistant." }, { role: "user", content: [ { type: "text", text: "Describe this picture:", }, { type: "image_url", image_url: { url: imageUrl, }, }, ], }, ], model: "", max_tokens: 2000, }; } async function printChoices(completion: ChatCompletion): Promise<void> { for (const choice of completion.choices) { console.log(choice.message); } } export async function main() { console.log("== Get GPT-4 Turbo with vision Sample =="); const client = getClient(); const messages = createMessages(); const completion = await client.chat.completions.create(messages); await printChoices(completion); } main().catch((err) => { console.error("Error occurred:", err); });Crie o

tsconfig.jsonarquivo para transpilar o código TypeScript e copie o código a seguir para ECMAScript.{ "compilerOptions": { "module": "NodeNext", "target": "ES2022", // Supports top-level await "moduleResolution": "NodeNext", "skipLibCheck": true, // Avoid type errors from node_modules "strict": true // Enable strict type-checking options }, "include": ["*.ts"] }Converter TypeScript em JavaScript.

tscEntre no Azure com o seguinte comando:

az loginExecute o código com o seguinte comando:

node index.js

Limpeza de recursos

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.

Use este artigo para começar a usar o Azure OpenAI .NET SDK para implantar e usar o modelo GPT-4 Turbo with Vision.

Pré-requisitos

- Uma assinatura do Azure. Você pode criar um gratuitamente.

- O SDK do .NET 8.0

- Um recurso do Azure OpenAI no Azure AI Foundry Models com um modelo GPT-4 Turbo com Visão implantado. Consulte a disponibilidade dos modelos GPT-4 e GPT-4 Turbo Preview para obter as regiões disponíveis. Para obter mais informações sobre a criação de recursos, consulte o guia de implantação de recursos.

Pré-requisitos do Microsoft Entra ID

Para a autenticação sem chave recomendada com o Microsoft Entra ID, você precisa:

- Instale a CLI do Azure usada para autenticação sem chave com o Microsoft Entra ID.

- Atribua a

Cognitive Services Userfunção à sua conta de utilizador. Você pode atribuir funções no portal do Azure em Controle de acesso (IAM)>Adicionar atribuição de função.

Configurar

Crie uma nova pasta

vision-quickstarte vá para a pasta de início rápido com o seguinte comando:mkdir vision-quickstart && cd vision-quickstartCrie um novo aplicativo de console com o seguinte comando:

dotnet new consoleInstale a biblioteca de cliente OpenAI .NET com o comando dotnet add package :

dotnet add package Azure.AI.OpenAIPara a autenticação sem chave recomendada com o Microsoft Entra ID, instale o pacote Azure.Identity com:

dotnet add package Azure.IdentityPara a autenticação sem chave recomendada com o Microsoft Entra ID, entre no Azure com o seguinte comando:

az login

Obter informações do recurso

Você precisa recuperar as seguintes informações para autenticar seu aplicativo com seu recurso do Azure OpenAI:

| Nome da variável | Valor |

|---|---|

AZURE_OPENAI_ENDPOINT |

Esse valor pode ser encontrado na seção Chaves e Ponto de Extremidade ao examinar seu recurso no portal do Azure. |

AZURE_OPENAI_DEPLOYMENT_NAME |

Este valor corresponderá ao nome personalizado que escolheu para a implementação quando implementou um modelo. Esse valor pode ser encontrado em Gerenciamento de Recursos>Implantações de Modelo no portal do Azure. |

OPENAI_API_VERSION |

Saiba mais sobre as versões da API. Você pode alterar a versão no código ou usar uma variável de ambiente. |

Saiba mais sobre autenticação sem chave e configuração de variáveis de ambiente.

Executar o arranque rápido

O código de exemplo neste início rápido usa o Microsoft Entra ID para a autenticação sem chave recomendada. Se preferir usar uma chave de API, você pode substituir o DefaultAzureCredential objeto por um AzureKeyCredential objeto.

AzureOpenAIClient openAIClient = new AzureOpenAIClient(new Uri(endpoint), new DefaultAzureCredential());

Para executar o início rápido, siga estes passos:

Substitua o conteúdo de

Program.cspelo código a seguir e atualize os valores dos marcadores de posição com os seus próprios.using Azure; using Azure.AI.OpenAI; using Azure.Identity; using OpenAI.Chat; // Required for Passwordless auth string deploymentName = "gpt-4"; string endpoint = Environment.GetEnvironmentVariable("AZURE_OPENAI_ENDPOINT") ?? "https://<your-resource-name>.openai.azure.com/"; string key = Environment.GetEnvironmentVariable("AZURE_OPENAI_API_KEY") ?? "<your-key>"; // Use the recommended keyless credential instead of the AzureKeyCredential credential. AzureOpenAIClient openAIClient = new AzureOpenAIClient(new Uri(endpoint), new DefaultAzureCredential()); //AzureOpenAIClient openAIClient = new AzureOpenAIClient(new Uri(endpoint), new AzureKeyCredential(key)); var chatClient = openAIClient.GetChatClient(deploymentName); var imageUrl = "YOUR_IMAGE_URL"; var chatMessages = new List<ChatMessage> { new SystemChatMessage("You are a helpful assistant."), new UserChatMessage($"Describe this picture: {imageUrl}") }; ChatCompletion chatCompletion = await chatClient.CompleteChatAsync(chatMessages); Console.WriteLine($"[ASSISTANT]:"); Console.WriteLine($"{chatCompletion.Content[0].Text}");Execute o aplicativo usando o

dotnet runcomando ou o botão Executar na parte superior do Visual Studio:dotnet run

Resultado

A saída do aplicativo será uma descrição da imagem que você forneceu na imageUri variável. O assistente irá analisar a imagem e fornecer uma descrição detalhada com base no seu conteúdo.

Limpeza de recursos

Se quiser limpar e remover um recurso do Azure OpenAI, você pode excluir o recurso ou grupo de recursos. A exclusão do grupo de recursos também exclui quaisquer outros recursos associados a ele.