Introdução a interações instintivas

A filosofia de interações simples e instintivas está entrelaçada em toda a plataforma de realidade mista (MR). Tomámos três passos para garantir que os designers de aplicações e os programadores possam proporcionar aos seus clientes interações fáceis e intuitivas.

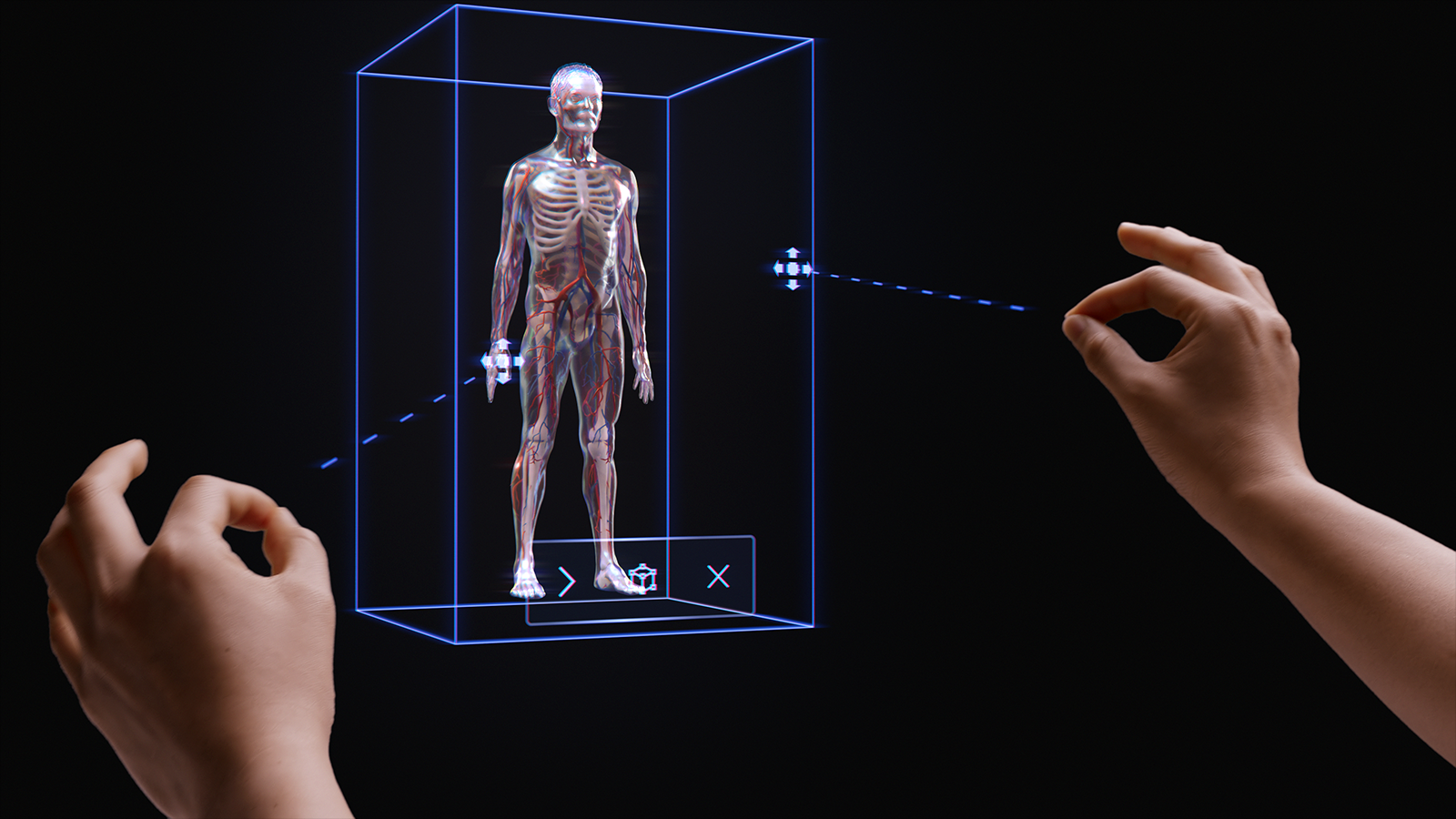

Primeiro, garantimos que os nossos sensores e tecnologias de entrada se combinam em modelos de interação multimodal. Estes modelos de interação incluem o controlo manual e ocular, juntamente com a entrada de linguagem natural. Com base na nossa investigação, conceber e desenvolver dentro de uma arquitetura multimodal (e não com base em entradas individuais) é a chave para criar experiências instintivas.

Em segundo lugar, reconhecemos que muitos programadores têm como destino vários dispositivos HoloLens, como HoloLens 2 e HoloLens (1.ª geração) ou HoloLens e VR. Por isso, concebemos os nossos modelos de interação para trabalhar em todos os dispositivos, mesmo que a tecnologia de entrada varie em cada dispositivo. Por exemplo, uma interação muito grande num headset Envolvente do Windows com um controlador 6DoF e HoloLens 2 ambos utilizam padrões e acessibilidades idênticos. Isto facilita o desenvolvimento de aplicações entre dispositivos e proporciona uma sensação natural às interações dos utilizadores.

Embora reconheçamos que existem milhares de interações eficazes, envolventes e mágicas possíveis no MR, descobrimos que utilizar intencionalmente um único modelo de interação numa aplicação é a melhor forma de garantir que os utilizadores têm sucesso e têm uma grande experiência. Para tal, incluímos três aspetos nesta documentação de orientação de interação:

- Orientações específicas em torno dos três modelos de interação principal e dos componentes e padrões necessários para cada um.

- Documentação de orientação suplementar sobre outros benefícios que a nossa plataforma proporciona.

- Documentação de orientação geral para ajudar a selecionar o modelo de interação adequado para o seu cenário de desenvolvimento.

Demonstração básica de controlo de mãos e interações instintivas

Veja a nossa demonstração de vídeo Designing Holograms - Head Tracking and Eye Tracking abaixo e, em seguida, avance para tópicos mais específicos:

Este vídeo foi retirado da aplicação "Designing Holograms" HoloLens 2. Transfira e desfrute da experiência completa aqui.

Modelos de interação multimodal

Com base na nossa pesquisa e feedback dos clientes, descobrimos que três modelos de interação principais se adequam à maioria das experiências de realidade mista. Em muitos aspectos, o modelo de interação é o modelo mental do utilizador para saber como concluir um fluxo de trabalho. Cada um destes modelos de interação é otimizado para um conjunto de necessidades do cliente e é conveniente, poderoso e utilizável quando utilizado corretamente.

O gráfico abaixo é uma descrição geral simplificada. As informações detalhadas para utilizar cada modelo de interação estão ligadas nas páginas abaixo com imagens e exemplos de código.

| Modelação | Cenários de exemplo | Ajustar | Hardware |

| Comandos de movimento e mãos | Experiências espaciais 3D, como disposição espacial e design, manipulação de conteúdos ou simulação. | Excelente para novos utilizadores quando utilizado em combinação com voz, rastreamento ocular ou seguimento do olhar. Curva de aprendizagem reduzida. Experiência do utilizador consistente entre o rastreamento das mãos e controlos 6DoF. | HoloLens 2 Auscultadores envolventes |

| Mãos-livres | Experiências contextuais em que as mãos de um utilizador estão ocupadas, como aprendizagem prática e manutenção. | É necessária alguma aprendizagem. Se as mãos não estiverem livres, o dispositivo funcionará bem com voz e linguagem natural. | HoloLens 2 HoloLens (1.ª geração) Auscultadores envolventes |

| Olhar e confirmar | Experiências onde faz clique para avançar, por exemplo, apresentações 3D, demonstrações. | Requer formação em HMDs, mas não em dispositivos móveis. Melhor para comandos acessíveis. O melhor para o HoloLens (1.ª geração). | HoloLens 2 HoloLens (1.ª geração) Auscultadores envolventes AR móvel |

Para evitar lacunas na experiência de interação do utilizador, é melhor seguir as orientações para um único modelo do início ao fim.

As secções abaixo explicam os passos para selecionar e implementar um destes modelos de interação.

No final desta página, irá compreender a nossa documentação de orientação sobre:

- Escolher um modelo de interação para o cliente

- Implementar o modelo de interação

- Transição entre modelos de interação

- Estruturar os próximos passos

Escolher um modelo de interação para o cliente

Normalmente, os programadores e criadores têm pensado nos tipos de interações que os seus clientes podem ter. Para incentivar uma abordagem de design focada no cliente, recomendamos a seguinte documentação de orientação para selecionar o modelo de interação otimizado para o cliente.

Por que seguir esta documentação de orientação?

- Testamos os nossos modelos de interação para critérios objetivos e subjetivos, incluindo esforço físico e cognitivo, intuição e aprendizagem.

- Uma vez que as interações diferem, as acessibilidades visuais/áudio e o comportamento dos objetos podem ser diferentes entre os modelos de interação.

- Combinar partes de vários modelos de interação cria o risco de acessibilidades concorrentes, como raios de mão simultâneos e um cursor de olhar para a cabeça. Tal pode sobrecarregar e confundir os utilizadores.

Eis alguns exemplos de como as acessibilidades e os comportamentos são otimizados para cada modelo de interação. Vemos muitas vezes que os novos utilizadores têm perguntas semelhantes, como "como sei que o sistema está a funcionar","como posso saber o que posso fazer" e "como posso saber se entendeu o que acabei de fazer?"

| Modelação | Como devo proceder para sabe que está a funcionar? | Como devo proceder para sei o que posso fazer? | Como devo proceder para sabe o que acabei de fazer? |

| Comandos de movimento e mãos | Vejo uma malha de mão, uma acessibilidade de ponta dos dedos ou raios mão/controlador. | Vejo alças agarráveis ou aparece uma caixa delimitadora quando a minha mão está perto de um objeto. | Ouço tons audíveis e vejo animações em grab and release. |

| Olhar de cabeça e consolidação | Vejo um cursor no centro do meu campo de vista. | O cursor muda de estado quando está sobre determinados objetos. | Vejo/ouço confirmações visuais e audíveis quando tomo medidas. |

| Mãos livres (Olhar para a cabeça e habitar) | Vejo um cursor no centro do meu campo de vista. | Vejo um indicador de progresso quando incido num objeto interacionável. | Vejo/ouço confirmações visuais e audíveis quando tomo medidas. |

| Mãos livres (Comandos de voz) | Vejo um indicador de escuta e legendas que mostram o que o sistema ouviu. | Recebo pedidos de voz e sugestões. Quando digo: "O que posso dizer?" Vejo comentários. | Vejo/ouço confirmações visuais e audíveis quando dou um comando ou obtenho o UX de desambiguação quando necessário. |

Seguem-se as perguntas que encontrámos que ajudam as equipas a selecionar um modelo de interação:

P: Os meus utilizadores querem tocar em hologramas e realizar manipulações holográficas de precisão?

R: Em caso afirmativo, consulte o modelo de interação Mãos e controladores de movimento para obter a segmentação e manipulação de precisão.P: Os meus utilizadores precisam de manter as mãos livres para tarefas do mundo real?

R: Se for o caso, veja o modelo de interação Mãos livres, que proporciona uma excelente experiência mãos-livres através de interações baseadas em voz e olhar.P: Os meus utilizadores têm tempo para aprender interações para a minha aplicação MR ou precisam das interações com a curva de aprendizagem mais baixa possível?

R: Para a curva de aprendizagem mais baixa e as interações mais intuitivas, recomendamos o modelo Mãos e comandos de movimento, desde que os utilizadores possam utilizar as mãos para interação.P: Os meus utilizadores utilizam comandos de movimento para apontar e manipular?

R: O modelo Mãos e comandos de movimento inclui todas as orientações para uma excelente experiência com comandos de movimento.P: Os meus utilizadores utilizam um controlador de acessibilidade ou um controlador Bluetooth comum, como um clicker?

R: Recomendamos o modelo De olhar para a cabeça e consolidação para todos os controladores não controlados. Foi concebido para permitir que um utilizador percorra toda uma experiência com um mecanismo simples de "destino e consolidação".P: Os meus utilizadores progridem apenas através de uma experiência ao "clicar" (por exemplo, num ambiente semelhante a apresentação de diapositivos 3D), em vez de navegar em esquemas densos de controlos de IU?

R: Se os utilizadores não precisarem de controlar muita IU, o Head-gaze e a consolidação oferecem uma opção passível de aprendizagem em que os utilizadores não têm de se preocupar com a segmentação.P: Os meus utilizadores utilizam o HoloLens (1.ª geração) e os auscultadores HoloLens 2/Windows Mixed Reality envolventes (VR)?

R: Uma vez que o Head-gaze e a consolidação são o modelo de interação do HoloLens (1.ª geração), recomendamos que os criadores que suportam o HoloLens (1.ª geração) utilizem o Head-gaze e consolidem-se para quaisquer funcionalidades ou modos que os utilizadores irão experimentar num headset do HoloLens (1.ª geração). Veja a secção seguinte sobre Modelos de interação de transição para obter detalhes sobre como criar uma excelente experiência para várias gerações do HoloLens.P: E os utilizadores que são móveis, abrangendo um espaço grande ou movendo-se entre espaços, em comparação com os utilizadores que tendem a trabalhar num único espaço?

R: Qualquer um dos modelos de interação funcionará para estes utilizadores.

Nota

Mais orientações específicas para a conceção de aplicações brevemente.

Modelos de interação de transição

Também existem casos de utilização que podem exigir a utilização de mais do que um modelo de interação. Por exemplo, o fluxo de criação da aplicação utiliza o modelo de interação "mãos e comandos de movimento ", mas pretende utilizar um modo mãos livres para técnicos de campo. Se a sua experiência exigir vários modelos de interação, os utilizadores poderão ter dificuldade em fazer a transição de um modelo para outro, especialmente quando são novos na realidade mista.

Nota

Estamos constantemente a trabalhar em mais orientações que estarão disponíveis para programadores e designers, informando-os sobre como, quando e porquê para utilizar vários modelos de interação mr.