Примечание.

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

В этом руководстве описано, как настроить расширение Databricks для Visual Studio Code, а затем запустить Python в кластере Azure Databricks и в качестве задания Azure Databricks в удаленной рабочей области. См. раздел "Что такое расширение Databricks для Visual Studio Code?".

Требования

В этом руководстве требуется следующее:

- Вы установили расширение Databricks для Visual Studio Code. См . раздел "Установка расширения Databricks" для Visual Studio Code.

- Вы используете удаленный кластер Azure Databricks. Запишите имя кластера. Чтобы просмотреть доступные кластеры, на боковой панели рабочей области Azure Databricks щелкните " Вычисления". См. раздел " Вычисления".

Шаг 1. Создание проекта Databricks

На этом шаге вы создадите проект Databricks и настройте подключение к удаленной рабочей области Azure Databricks.

- Запустите Visual Studio Code, а затем щелкните "Открыть папку" > и откройте пустую папку на локальном компьютере разработки.

- На боковой панели щелкните значок логотипа Databricks . Откроется расширение Databricks.

- В представлении конфигурации щелкните Создать конфигурацию.

- Откроется палитра команд для настройки рабочей области Databricks. Для узла Databricksвведите или выберите URL-адрес для каждой рабочей области, например

https://adb-1234567890123456.7.azuredatabricks.net. - Выберите профиль проверки подлинности для проекта. См. настройка авторизации расширения Databricks для Visual Studio Code.

Шаг 2. Добавление сведений о кластере в расширение Databricks и запуск кластера

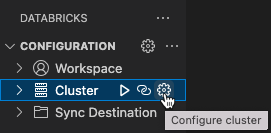

В режиме конфигурации

щелкните Выберите кластер или щелкните значок шестеренки (Настройка кластера ).

В палитре команд выберите имя кластера, который вы создали ранее.

Щелкните значок воспроизведения (запустить кластер), если он еще не запущен.

Шаг 3. Создание и запуск кода Python

Создайте локальный файл кода Python: на боковой панели щелкните значок папки (обозреватель).

В главном меню щелкните Файл > Новый файл, затем выберите файл Python. Присвойте файлу имя demo.py и сохраните его в корне проекта.

Добавьте следующий код в файл и сохраните его. Этот код создает и отображает содержимое базового кадра данных PySpark:

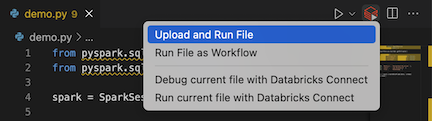

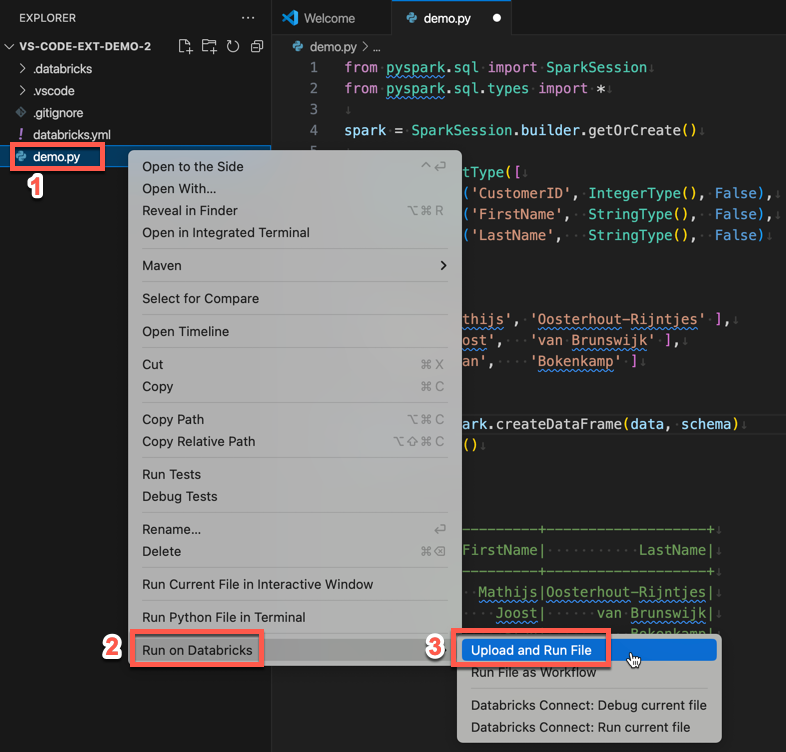

from pyspark.sql import SparkSession from pyspark.sql.types import * spark = SparkSession.builder.getOrCreate() schema = StructType([ StructField('CustomerID', IntegerType(), False), StructField('FirstName', StringType(), False), StructField('LastName', StringType(), False) ]) data = [ [ 1000, 'Mathijs', 'Oosterhout-Rijntjes' ], [ 1001, 'Joost', 'van Brunswijk' ], [ 1002, 'Stan', 'Bokenkamp' ] ] customers = spark.createDataFrame(data, schema) customers.show()# +----------+---------+-------------------+ # |CustomerID|FirstName| LastName| # +----------+---------+-------------------+ # | 1000| Mathijs|Oosterhout-Rijntjes| # | 1001| Joost| van Brunswijk| # | 1002| Stan| Bokenkamp| # +----------+---------+-------------------+Щелкните значок Запустить на Databricks рядом со списком вкладок редактора, а затем щелкните Отправить и запустить файл. Выходные данные отображаются в представлении консоли отладки.

Кроме того, в представлении обозревателя щелкните правой кнопкой мыши

demo.pyфайл и нажмите кнопку "Запустить" в Databricks>Upload and Run File.

Шаг 4. Запуск кода в качестве задания

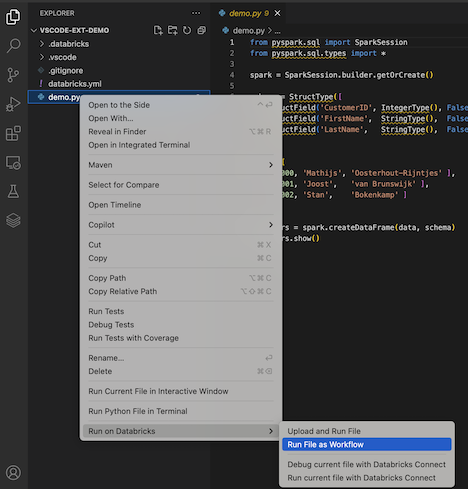

Чтобы запустить задание demo.py, щелкните значок "Запустить в Databricks" рядом со списком вкладок редактора, а затем выберите "Запустить файл как рабочий процесс". Выходные данные отображаются на отдельной вкладке редактора рядом с редактором demo.py файлов.

![]()

Кроме того, щелкните правой кнопкой мыши файл demo.py в обозревателе, а затем выберите Запустить в Databricks>Запустить файл как рабочий процесс.

Следующие шаги

Теперь, когда вы успешно использовали расширение Databricks для Visual Studio Code для отправки локального файла Python и его удаленного запуска, вы также можете:

- Изучите ресурсы и переменные databricks Asset Bundles с помощью пользовательского интерфейса расширения. См. сведения о функциях расширения наборов ресурсов Databricks.

- Запуск или отладка кода Python с помощью Databricks Connect. См . код отладки с помощью Databricks Connect для расширения Databricks для Visual Studio Code.

- Запустите файл или записную книжку в качестве задания Azure Databricks. Просмотрите файл в кластере или файле или записной книжке в качестве задания в Azure Databricks с помощью расширения Databricks для Visual Studio Code.

- Выполнение тестов с

pytestпомощью . См. статью "Запуск тестов Python с помощью расширения Databricks для Visual Studio Code".