Создание определения задания Apache Spark в Fabric

В этом руководстве описано, как создать определение задания Spark в Microsoft Fabric.

Перед началом работы вам потребуются:

- Учетная запись клиента Fabric с активной подпиской. Создайте учетную запись бесплатно .

Совет

Чтобы запустить элемент определения задания Spark, необходимо иметь основной файл определения и контекст lakehouse по умолчанию. Если у вас нет озера, вы можете создать его, выполнив действия, описанные в разделе "Создание озера".

Процесс создания определения задания Spark является быстрым и простым; Существует несколько способов приступить к работе.

Вы можете приступить к созданию двумя способами.

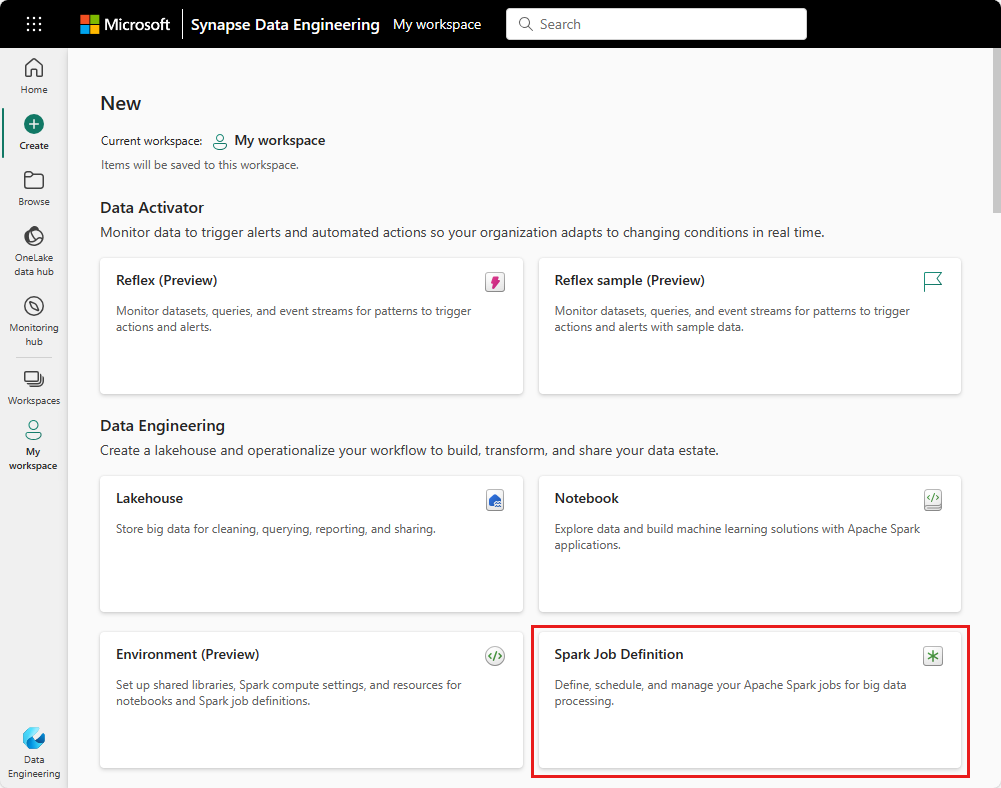

представлении рабочей области

. Вы можете легко создать определение задания Spark с помощью рабочей области Fabric, выбрав Новый элемент определение задания Spark .Домашняя страница Fabric: другая точка входа для создания определения задания Spark — это аналитика данных с помощью плитки SQL ... на домашней странице Fabric. Вы можете найти тот же параметр, выбрав плитку General.

При создании задания Spark необходимо указать имя задания Spark. Имя должно быть уникальным в текущей рабочей области. Новое определение задания Spark создается в текущей рабочей области.

Чтобы создать определение задания Spark для PySpark:

Скачайте пример файла Parquet yellow_tripdata_2022-01.parquet и отправьте его в раздел файлов lakehouse.

Создайте новое определение задания Spark.

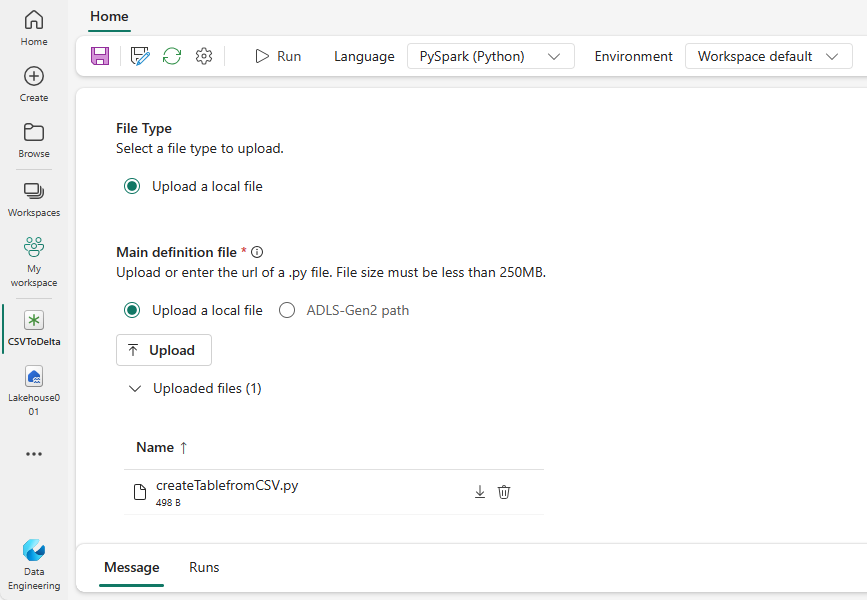

Выберите PySpark (Python) в раскрывающемся списке "Язык ".

Скачайте пример createTablefromParquet.py и отправьте его в качестве основного файла определения. Файл основного определения (задание). Main) — это файл, содержащий логику приложения и обязательный для запуска задания Spark. Для каждого определения задания Spark можно отправить только один файл основного определения.

Вы можете отправить основной файл определения с локального рабочего стола или отправить из существующего azure Data Lake Storage (ADLS) 2-го поколения, предоставив полный путь ABFSS файла. Например,

abfss://your-storage-account-name.dfs.core.windows.net/your-file-path.Отправка ссылочных файлов в виде .py файлов. Ссылочные файлы — это модули Python, импортируемые основным файлом определения. Как и файл основного определения, вы можете отправить из рабочего стола или существующего ADLS 2-го поколения. Поддерживаются несколько ссылочных файлов.

Совет

Если вы используете путь ADLS 2-го поколения, чтобы убедиться, что файл доступен, необходимо предоставить учетную запись пользователя, которая запускает задание соответствующим разрешением для учетной записи хранения. Мы рекомендуем сделать это двумя способами:

- Назначьте учетную запись пользователя роль участника для учетной записи хранения.

- Предоставьте разрешение на чтение и выполнение учетной записи пользователя для файла с помощью списка контроль доступа ADLS 2-го поколения (ACL).

Для выполнения вручную учетная запись текущего пользователя входа используется для выполнения задания.

При необходимости укажите аргументы командной строки для задания. Используйте пробел в качестве разбиения для разделения аргументов.

Добавьте ссылку lakehouse на задание. Необходимо добавить в задание по крайней мере одну ссылку lakehouse. Это lakehouse — это контекст озера по умолчанию для задания.

Поддерживаются несколько ссылок lakehouse. Найдите имя озера по умолчанию и полный URL-адрес OneLake на странице параметров Spark.

Чтобы создать определение задания Spark для Scala/Java:

Создайте новое определение задания Spark.

Выберите Spark(Scala/Java) в раскрывающемся списке "Язык ".

Отправьте файл основного определения в виде файла .jar . Основной файл определения — это файл, содержащий логику приложения этого задания и обязательный для запуска задания Spark. Для каждого определения задания Spark можно отправить только один файл основного определения. Укажите имя класса Main.

Отправка ссылочных файлов в виде .jar файлов. Ссылочные файлы — это файлы, на которые ссылается или импортируется основной файл определения.

При необходимости укажите аргументы командной строки для задания.

Добавьте ссылку lakehouse на задание. Необходимо добавить в задание по крайней мере одну ссылку lakehouse. Это lakehouse — это контекст озера по умолчанию для задания.

Создание определения задания Spark для SparkR(R):

Создайте новое определение задания Spark.

Выберите SparkR(R) в раскрывающемся списке "Язык ".

Отправьте файл основного определения в виде файла. R-файл . Основной файл определения — это файл, содержащий логику приложения этого задания и обязательный для запуска задания Spark. Для каждого определения задания Spark можно отправить только один файл основного определения.

Отправка ссылочных файлов как . R-файлы . Ссылочные файлы — это файлы, на которые ссылается или импортируется основной файл определения.

При необходимости укажите аргументы командной строки для задания.

Добавьте ссылку lakehouse на задание. Необходимо добавить в задание по крайней мере одну ссылку lakehouse. Это lakehouse — это контекст озера по умолчанию для задания.

Примечание

Определение задания Spark будет создано в текущей рабочей области.

Существует несколько вариантов для дальнейшей настройки выполнения определений заданий Spark.

- Вычислительная среда Spark. На вкладке "Вычисления Spark" можно увидеть версию среды выполнения, которая будет использоваться для выполнения задания. Вы также можете просмотреть параметры конфигурации Spark, которые будут использоваться для выполнения задания. Параметры конфигурации Spark можно настроить, нажав кнопку "Добавить ".

Оптимизация. На вкладке "Оптимизация" можно включить и настроить политику повторных попыток для задания. Если этот параметр включен, задание выполняется повторно, если он завершается ошибкой. Можно также задать максимальное количество повторных попыток и интервал между повторными попытками. Для каждой попытки повтора задание перезапускается. Убедитесь, что задание идемпотентно.