Alternativ för att hämta data till Fabric Lakehouse

Hämta dataupplevelsen omfattar alla användarscenarier för att föra in data i lakehouse, till exempel:

- Anslut till befintlig SQL Server och kopiera data till Delta-tabellen på lakehouse.

- Laddar upp filer från datorn.

- Kopiera och sammanfoga flera tabeller från andra sjöhus till en ny Delta-tabell.

- Anslut till en strömmande källa för att landa data i ett sjöhus.

- Referera till data utan att kopiera dem från andra interna sjöhus eller externa källor.

Olika sätt att läsa in data i ett sjöhus

I Microsoft Fabric finns det några sätt att hämta data till ett sjöhus:

- Filuppladdning från en lokal dator

- Köra ett kopieringsverktyg i pipelines

- Konfigurera ett dataflöde

- Apache Spark-bibliotek i notebook-kod

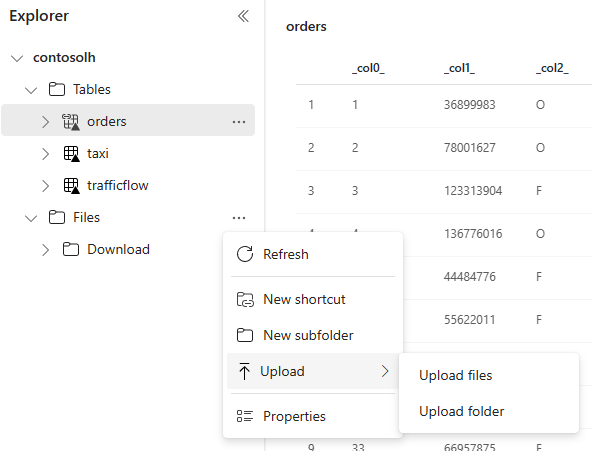

Lokal filuppladdning

Du kan också ladda upp data som lagras på den lokala datorn. Du kan göra det direkt i Lakehouse Explorer.

Kopieringsverktyget i pipelines

Verktyget Kopiera är en mycket skalbar Dataintegration lösning som gör att du kan ansluta till olika datakällor och läsa in data antingen i ursprungligt format eller konvertera dem till en Delta-tabell. Kopieringsverktyget är en del av pipelineaktiviteter som du kan ändra på flera sätt, till exempel schemaläggning eller utlösande baserat på en händelse. Mer information finns i Kopiera data med kopieringsaktivitet.

Dataflöden

För användare som är bekanta med Power BI-dataflöden är samma verktyg tillgängligt för att läsa in data i ditt lakehouse. Du kan snabbt komma åt den från alternativet Hämta data i Lakehouse Explorer och läsa in data från över 200 anslutningsappar. Mer information finns i Snabbstart: Skapa ditt första dataflöde för att hämta och transformera data.

Notebook-kod

Du kan använda tillgängliga Spark-bibliotek för att ansluta till en datakälla direkt, läsa in data till en dataram och sedan spara dem i ett sjöhus. Den här metoden är det mest öppna sättet att läsa in data i lakehouse som användarkoden hanterar fullt ut.

Kommentar

Externa Delta-tabeller som skapats med Spark-kod visas inte för en SQL-analysslutpunkt. Använd genvägar i Tabellutrymme för att göra externa Delta-tabeller synliga för en SQL-analysslutpunkt.

Överväganden när du väljer metod för att läsa in data

| Användningsfall | Rekommendation |

|---|---|

| Liten filuppladdning från den lokala datorn | Använda lokal filuppladdning |

| Små data eller specifika anslutningsappar | Använda dataflöden |

| Stor datakälla | Använda verktyget Kopiera i pipelines |

| Komplexa datatransformeringar | Använda notebook-kod |

Relaterat innehåll

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för