Använda R för Apache Spark

Microsoft Fabric har inbyggt R-stöd för Apache Spark. Detta inkluderar stöd för SparkR och sparklyr, vilket gör det möjligt för användare att interagera med Spark med hjälp av välbekanta Spark- eller R-gränssnitt. Du kan analysera data med hjälp av R via Spark-batchjobbdefinitioner eller med interaktiva Microsoft Fabric-notebook-filer.

Det här dokumentet innehåller en översikt över hur du utvecklar Spark-program i Synapse med hjälp av R-språket.

Skaffa en Microsoft Fabric-prenumeration. Eller registrera dig för en kostnadsfri utvärderingsversion av Microsoft Fabric.

Logga in på Microsoft Fabric.

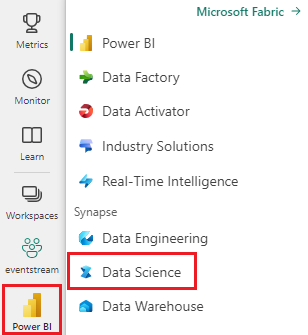

Använd upplevelseväxlaren till vänster på startsidan för att växla till Synapse Datavetenskap upplevelse.

Microsoft Fabric Notebook är ett webbgränssnitt där du kan skapa filer som innehåller livekod, visualiseringar och narrativ text. Notebook-filer är ett bra ställe att validera idéer och använda snabba experiment för att få insikter från dina data. Notebook-filer används också ofta i dataförberedelser, datavisualisering, maskininlärning och andra stordatascenarier.

Om du vill komma igång med R i Microsoft Fabric-notebook-filer ändrar du det primära språket överst i anteckningsboken genom att ange språkalternativet till SparkR (R).

Dessutom kan du använda flera språk i en anteckningsbok genom att ange kommandot language magic i början av en cell.

%%sparkr

# Enter your R code here

Mer information om notebook-filer i Microsoft Fabric Analytics finns i Använda notebook-filer.

Bibliotek ger återanvändbar kod som du kanske vill inkludera i dina program eller projekt. Om du vill göra kod från tredje part eller lokalt byggd tillgänglig för dina program kan du installera ett bibliotek på en av dina arbetsytor eller notebook-sessioner.

Mer information om hur du hanterar R-bibliotek finns i Hantering av R-bibliotek.

Microsoft Spark Utilities (MSSparkUtils) är ett inbyggt paket som hjälper dig att enkelt utföra vanliga uppgifter. Du kan använda MSSparkUtils för att arbeta med filsystem, hämta miljövariabler, länka ihop notebook-filer och arbeta med hemligheter. MSSparkUtils stöds för R-notebook-filer.

För att komma igång kan du köra följande kommandon:

library(notebookutils)

mssparkutils.fs.help()

Läs mer om mssparkUtils-kommandon som stöds i Använda Microsoft Spark Utilities.

SparkR är ett R-paket som tillhandahåller en lättviktsklientdel för användning av Apache Spark från R. SparkR tillhandahåller en distribuerad implementering av dataramar som stöder åtgärder som val, filtrering, aggregering osv. SparkR stöder även distribuerad maskininlärning med MLlib.

Du kan lära dig mer om hur du använder SparkR genom att gå till Så här använder du SparkR.

sparklyr är ett R-gränssnitt till Apache Spark. Det ger en mekanism för att interagera med Spark med hjälp av välbekanta R-gränssnitt. Du kan använda sparklyr via Spark batch-jobbdefinitioner eller med interaktiva Microsoft Fabric-notebook-filer.

Mer information om hur du använder sparklyr finns i Använda sparklyr.

Tidyverse är en samling R-paket som dataexperter ofta använder i vardagliga dataanalyser. Den innehåller paket för dataimport (readr), datavisualisering (ggplot2), datamanipulering (dplyr, tidyr), funktionell programmering (purrr) och modellskapande (tidymodels) osv. Paketen i tidyverse är utformade för att fungera sömlöst och följa en konsekvent uppsättning designprinciper. Microsoft Fabric distribuerar den senaste stabila versionen av tidyverse med varje körningsversion.

Mer information om hur du använder Tidyverse finns i Använda Tidyverse.

R-ekosystemet erbjuder flera grafbibliotek som är fullspäckade med många olika funktioner. Som standard innehåller varje Spark-instans i Microsoft Fabric en uppsättning kuraterade och populära bibliotek med öppen källkod. Du kan också lägga till eller hantera extra bibliotek eller versioner med hjälp av microsoft fabric-bibliotekshanteringsfunktionerna.

Läs mer om hur du skapar R-visualiseringar genom att besöka R-visualisering.