รวม OneLake เข้ากับ Azure Databricks

สถานการณ์นี้แสดงวิธีการเชื่อมต่อกับ OneLake ผ่าน Azure Databricks หลังจากจบบทช่วยสอนนี้แล้ว คุณจะสามารถอ่านและเขียนไปยัง Microsoft Fabric lakehouse จากพื้นที่ทํางาน Azure Databricks ของคุณได้

ก่อนที่คุณจะเชื่อมต่อ คุณต้องมี:

- พื้นที่ทํางานของ Fabric และเลคเฮ้าส์

- พื้นที่ทํางาน Azure Databricks ระดับพรีเมียม เฉพาะพื้นที่ทํางาน Azure Databricks ระดับพรีเมียมเท่านั้นที่สนับสนุนการส่งผ่านข้อมูลประจําตัวของ Microsoft Entra ซึ่งคุณต้องการสําหรับสถานการณ์นี้

เปิดพื้นที่ทํางาน Azure Databricks ของคุณ และเลือกสร้าง>คลัสเตอร์

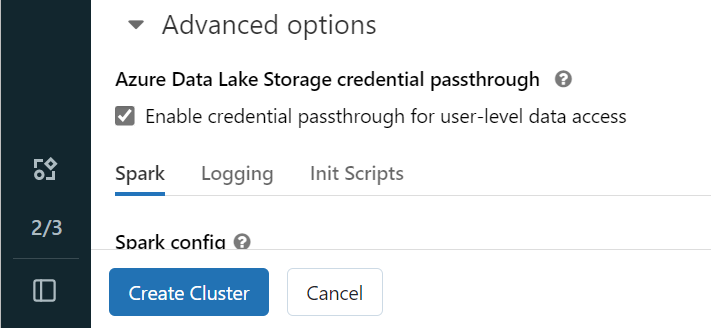

เมื่อต้องการรับรองความถูกต้อง OneLake ด้วยข้อมูลประจําตัว Microsoft Entra ของคุณ คุณต้องเปิดใช้งานการส่งผ่านข้อมูลประจําตัว Azure Data Lake Storage (ADLS) บนคลัสเตอร์ของคุณในตัวเลือกขั้นสูง

หมายเหตุ

คุณยังสามารถเชื่อมต่อ Databricks กับ OneLake โดยใช้โครงร่างสําคัญของบริการ สําหรับข้อมูลเพิ่มเติมเกี่ยวกับการรับรองความถูกต้อง Azure Databricks โดยใช้โครงร่างสําคัญของบริการ โปรดดูจัดการบริการหลัก

สร้างคลัสเตอร์ด้วยพารามิเตอร์ที่คุณต้องการ สําหรับข้อมูลเพิ่มเติมเกี่ยวกับการสร้างคลัสเตอร์ Databricks ดูกําหนดค่าคลัสเตอร์ - Azure Databricks

เปิดสมุดบันทึกและเชื่อมต่อกับคลัสเตอร์ที่สร้างขึ้นใหม่ของคุณ

นําทางไปยัง Fabric lakehouse ของคุณและคัดลอกเส้นทาง Azure Blob Filesystem (ABFS) ไปยังเลคเฮ้าส์ของคุณ คุณสามารถค้นหาได้ในบานหน้าต่างคุณสมบัติ

หมายเหตุ

Azure Databricks สนับสนุนเฉพาะโปรแกรมควบคุม Azure Blob Filesystem (ABFS) เมื่ออ่านและเขียนไปยัง ADLS Gen2 และ OneLake:

abfss://myWorkspace@onelake.dfs.fabric.microsoft.com/บันทึกเส้นทางไปยังเลคเฮาส์ของคุณในสมุดบันทึก Databricks ของคุณ เลคเฮาส์นี้คือที่ที่คุณเขียนข้อมูลที่ประมวลผลของคุณในภายหลัง:

oneLakePath = 'abfss://myWorkspace@onelake.dfs.fabric.microsoft.com/myLakehouse.lakehouse/Files/'โหลดข้อมูลจากชุดข้อมูลสาธารณะ Databricks ลงใน dataframe คุณยังสามารถอ่านไฟล์จากที่อื่นใน Fabric หรือเลือกไฟล์จากบัญชี ADLS Gen2 อื่นที่คุณเป็นเจ้าของอยู่แล้วได้

yellowTaxiDF = spark.read.format("csv").option("header", "true").option("inferSchema", "true").load("/databricks-datasets/nyctaxi/tripdata/yellow/yellow_tripdata_2019-12.csv.gz")กรอง แปลง หรือเตรียมข้อมูลของคุณ สําหรับสถานการณ์นี้ คุณสามารถตัดแต่งชุดข้อมูลของคุณสําหรับการโหลดได้เร็วขึ้น รวมกับชุดข้อมูลอื่น ๆ หรือกรองไปยังผลลัพธ์ที่เฉพาะเจาะจง

filteredTaxiDF = yellowTaxiDF.where(yellowTaxiDF.fare_amount<4).where(yellowTaxiDF.passenger_count==4) display(filteredTaxiDF)เขียน dataframe ที่กรองแล้วของคุณไปยัง Fabric lakehouse โดยใช้เส้นทาง OneLake ของคุณ

filteredTaxiDF.write.format("csv").option("header", "true").mode("overwrite").csv(oneLakePath)ทดสอบว่าข้อมูลของคุณถูกเขียนเรียบร้อยแล้วโดยการอ่านไฟล์ที่โหลดใหม่ของคุณ

lakehouseRead = spark.read.format('csv').option("header", "true").load(oneLakePath) display(lakehouseRead.limit(10))

ขอแสดงความยินดี ตอนนี้คุณสามารถอ่านและเขียนข้อมูลใน Fabric โดยใช้ Azure Databricks ได้แล้ว