Přehled příjmu dat v Azure Data Exploreru

Příjem dat zahrnuje načtení dat do tabulky v clusteru. Azure Data Explorer zajišťuje platnost dat, podle potřeby převádí formáty a provádí manipulace, jako je porovnávání schémat, organizace, indexování, kódování a komprese. Po ingestování jsou data k dispozici pro dotaz.

Azure Data Explorer nabízí jednorázový příjem dat nebo vytvoření kanálu průběžného příjmu dat pomocí streamování nebo příjmu dat ve frontě. Pokud chcete zjistit, která z nich je pro vás správná, podívejte se na jednorázový příjem dat a průběžný příjem dat.

Poznámka:

Data se uchovávají v úložišti podle nastavených zásad uchovávání informací.

Jednorázový příjem dat

Jednorázový příjem dat je užitečný pro přenos historických dat, vyplňování chybějících dat a počáteční fáze vytváření prototypů a analýzy dat. Tento přístup usnadňuje rychlou integraci dat bez nutnosti průběžného závazku kanálu.

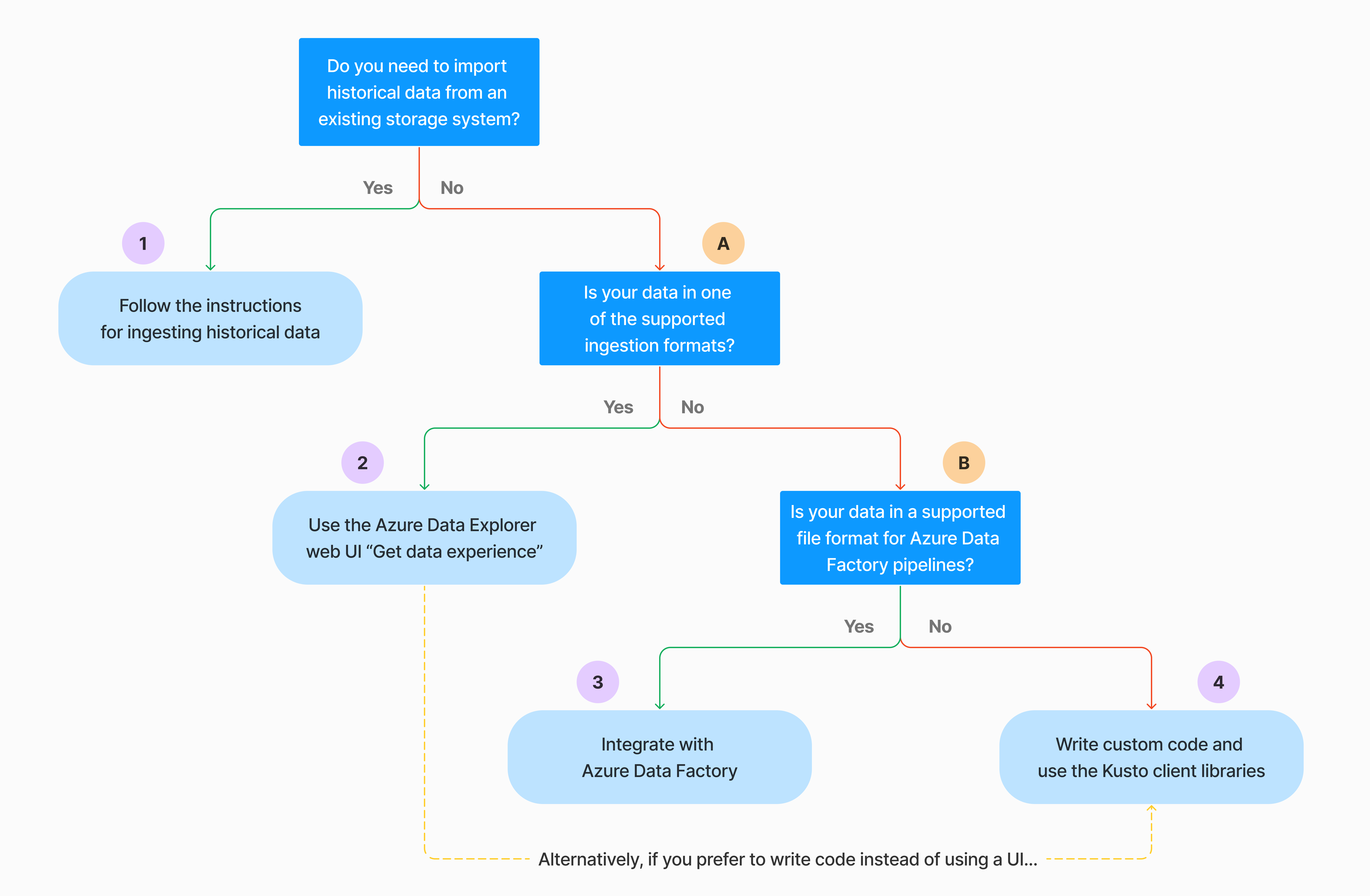

Jednorázový příjem dat je možné provést několika způsoby. Pomocí následujícího rozhodovacího stromu určete nejvhodnější možnost pro váš případ použití:

Další informace najdete v příslušné dokumentaci:

| Popisek | Relevantní dokumentace |

|---|---|

|

Podívejte se na formáty dat podporované Azure Data Explorerem pro příjem dat. |

|

Podívejte se na formáty souborů podporované pro kanály Azure Data Factory. |

|

Pokud chcete importovat data z existujícího systému úložiště, přečtěte si, jak ingestovat historická data do Azure Data Exploreru. |

|

Ve webovém uživatelském rozhraní Azure Data Exploreru můžete získat data z místního souboru, AmazonU S3 nebo Azure Storage. |

|

Informace o integraci se službou Azure Data Factory najdete v tématu Kopírování dat do Azure Data Exploreru pomocí služby Azure Data Factory. |

|

Klientské knihovny Kusto jsou dostupné pro C#, Python, Java, JavaScript, TypeScript a Go. Můžete napsat kód pro manipulaci s daty a pak pomocí knihovny Kusto Ingest ingestovat data do tabulky Azure Data Exploreru. Data musí být před příjmem dat v jednom z podporovaných formátů . |

Průběžný příjem dat

Nepřetržitý příjem dat vyniká v situacích náročných na okamžité přehledy z živých dat. Průběžný příjem dat je například užitečný pro monitorování systémů, dat protokolů a událostí a analýzy v reálném čase.

Průběžný příjem dat zahrnuje nastavení kanálu příjmu dat se streamováním nebo příjmem dat ve frontě:

Příjem dat streamování: Tato metoda zajišťuje latenci téměř v reálném čase pro malé sady dat na tabulku. Data se ingestují v mikro dávkách ze zdroje streamování, zpočátku umístěné v úložišti řádků a pak se přenesou do rozsahů úložiště sloupců. Další informace najdete v tématu Konfigurace příjmu dat streamování.

Příjem dat ve frontě: Tato metoda je optimalizovaná pro vysokou propustnost příjmu dat. Data se dávková na základě vlastností příjmu dat, s malými dávkami se pak sloučí a optimalizují pro rychlé výsledky dotazů. Ve výchozím nastavení jsou maximální hodnoty ve frontě 5 minut, 1000 položek nebo celková velikost 1 GB. Limit velikosti dat pro příkaz pro příjem dat ve frontě je 6 GB. Tato metoda používá mechanismy opakování ke zmírnění přechodných selhání a sleduje sémantiku zasílání zpráv alespoň jednou, aby se v procesu neztratily žádné zprávy. Další informace o příjmu dat ve frontě najdete v tématu Zásady dávkování příjmu dat.

Poznámka:

Ve většině scénářů doporučujeme používat příjem dat ve frontě, protože je to výkonnější možnost.

Existuje několik způsobů konfigurace průběžného příjmu dat. Pomocí následujícího rozhodovacího stromu určete nejvhodnější možnost pro váš případ použití:

Další informace najdete v příslušné dokumentaci:

| Popisek | Relevantní dokumentace |

|---|---|

|

Seznam konektorů najdete v přehledu konektorů. |

|

Vytvořte datové připojení služby Event Hubs. Integrace se službou Event Hubs poskytuje služby, jako je omezování, opakování, monitorování a upozornění. |

|

Ingestování dat z Apache Kafka, distribuované platformy streamování pro vytváření datových kanálů streamování v reálném čase |

|

Vytvořte datové připojení IoT Hubu. Integrace se službou IoT Hubs poskytuje služby, jako je omezování, opakování, monitorování a upozornění. |

|

Vytvoření datového připojení Event Gridu Integrace se službou Event Grid poskytuje služby, jako je omezování, opakování, monitorování a upozornění. |

|

Projděte si pokyny pro příslušný konektor, jako je Apache Spark, Apache Kafka, Azure Cosmos DB, Fluent Bit, Logstash, Open Telemetry, Power Automate, Splunk a další. Další informace najdete v tématu Přehled konektorů. |

|

Klientské knihovny Kusto jsou dostupné pro C#, Python, Java, JavaScript, TypeScript a Go. Můžete napsat kód pro manipulaci s daty a pak pomocí knihovny Kusto Ingest ingestovat data do tabulky Azure Data Exploreru. Data musí být před příjmem dat v jednom z podporovaných formátů . |

Poznámka:

Příjem dat streamování se nepodporuje u všech metod příjmu dat. Podrobnosti o podpoře najdete v dokumentaci pro konkrétní metodu příjmu dat.

Přímý příjem dat pomocí příkazů pro správu

Azure Data Explorer nabízí následující příkazy pro správu příjmu dat, které ingestují data přímo do vašeho clusteru místo použití služby pro správu dat. Měly by se používat pouze pro zkoumání a vytváření prototypů, a ne pro produkční nebo vysokoobsádové scénáře.

- Vložený příjem dat: Vložený příkaz .ingest obsahuje data, která jsou součástí samotného textu příkazu. Tato metoda je určena pro improvizované účely testování.

- Ingestování z dotazu: Příkazy .set, .append, .set-or-append nebo .set-or-replace nepřímo určují data, která se mají ingestovat jako výsledky dotazu nebo příkazu.

- Ingestování z úložiště: Příkaz .ingest do příkazu získá data do ingestování z externího úložiště, jako je Azure Blob Storage, přístupný vaším clusterem a odkazuje na příkaz.

Poznámka:

V případě selhání se příjem dat provádí znovu a opakuje se po dobu až 48 hodin pomocí exponenciální metody reoff pro dobu čekání mezi pokusy.

Porovnání metod příjmu dat

Následující tabulka porovnává hlavní metody příjmu dat:

| Název příjmu dat | Datový typ | Maximální velikost souboru | Streamování, ve frontě, přímé | Nejběžnější scénáře | Důležité informace |

|---|---|---|---|---|---|

| Konektor Apache Spark | Každý formát podporovaný prostředím Sparku | Bez omezení | Zařazeno do fronty | Stávající kanál, předzpracování sparku před příjmem dat, rychlý způsob, jak vytvořit bezpečný streamovací kanál (Spark) z různých zdrojů, podpora prostředí Sparku. | Zvažte náklady na cluster Spark. V případě dávkového zápisu porovnejte datové připojení Azure Data Exploreru pro Event Grid. V případě streamování Sparku porovnejte datové připojení pro centrum událostí. |

| Azure Data Factory (ADF) | Podporované formáty dat | Neomezený. Dědí omezení ADF. | Ve frontě nebo na aktivační událost ADF | Podporuje formáty, které nejsou podporované, například Excel a XML, a můžou kopírovat velké soubory z více než 90 zdrojů z perm do cloudu. | Tato metoda trvá relativně více času, než se data ingestují. ADF nahraje všechna data do paměti a pak začne ingestovat. |

| Event Grid | Podporované formáty dat | 1 GB nekomprimované | Zařazeno do fronty | Průběžný příjem dat z úložiště Azure, externí data v úložišti Azure | Příjem dat je možné aktivovat přejmenováním objektu blob nebo akcemi vytvoření objektu blob. |

| Centrum událostí | Podporované formáty dat | – | Zařazeno do fronty, streamování | Zprávy, události | |

| Získání prostředí pro data | *SV, JSON | 1 GB nekomprimované | Fronta nebo přímý příjem dat | Jednorázové vytvoření schématu tabulky, definice průběžného příjmu dat pomocí Event Gridu, hromadný příjem dat s kontejnerem (až 5 000 objektů blob; bez omezení při použití historického příjmu dat) | |

| IoT Hub | Podporované formáty dat | – | Zařazeno do fronty, streamování | Zprávy IoT, události IoT, vlastnosti IoT | |

| Konektor Kafka | Avro, ApacheAvro, JSON, CSV, Parquet a ORC | Neomezený. Dědí omezení Javy. | Zařazeno do fronty, streamování | Stávající kanál, vysoká spotřeba svazků ze zdroje | Předvolbu lze určit stávajícím použitím více výrobců nebo spotřebitelských služeb nebo požadovanou úrovní správy služeb. |

| Klientské knihovny Kusto | Podporované formáty dat | 1 GB nekomprimované | Ve frontě, streamování, přímé | Psaní vlastního kódu podle potřeb organizace | Programový příjem dat je optimalizovaný pro snížení nákladů na příjem dat tím, že minimalizuje transakce úložiště během procesu příjmu dat a sleduje je. |

| Nejsvětlejší | Podporované formáty dat | 1 GB nekomprimované | Fronta nebo přímý příjem dat | Migrace dat, historická data s upravenými časovými razítky příjmu dat, hromadným příjmem dat | Rozlišování velkých a malých a malých písmen a rozlišování mezer |

| Logic Apps | Podporované formáty dat | 1 GB nekomprimované | Zařazeno do fronty | Používá se k automatizaci kanálů. | |

| LogStash | JSON | Neomezený. Dědí omezení Javy. | Zařazeno do fronty | Existující kanál, použijte vyspělou opensourcovou povahu Logstash pro vysokou spotřebu svazků ze vstupů. | Předvolbu lze určit stávajícím použitím více výrobců nebo spotřebitelských služeb nebo požadovanou úrovní správy služeb. |

| Power Automate | Podporované formáty dat | 1 GB nekomprimované | Zařazeno do fronty | Příkazy pro příjem dat jako součást toku Používá se k automatizaci kanálů. |

Informace o dalších konektorech najdete v tématu Přehled konektorů.

Oprávnění

Následující seznam popisuje oprávnění požadovaná pro různé scénáře příjmu dat:

- Chcete-li vytvořit novou tabulku, vyžaduje alespoň oprávnění uživatele databáze.

- Pokud chcete ingestovat data do existující tabulky beze změny schématu, vyžaduje alespoň oprávnění Databázového ingestoru.

- Pokud chcete změnit schéma existující tabulky, musíte mít alespoň oprávnění správce tabulky nebo správce databáze.

Další informace najdete v tématu Řízení přístupu na základě role Kusto.

Proces příjmu dat

Následující kroky popisují obecný proces příjmu dat:

Nastavení zásad dávkování (volitelné):: Data se dávková na základě zásad dávkování příjmu dat. Pokyny najdete v tématu Optimalizace propustnosti.

Nastavení zásad uchovávání informací (volitelné):Pokud zásady uchovávání databáze nejsou vhodné pro vaše potřeby, přepište je na úrovni tabulky. Další informace najdete v tématu Zásady uchovávání.

Vytvoření tabulky: Pokud používáte prostředí Získat data, můžete vytvořit tabulku jako součást toku příjmu dat. V opačném případě vytvořte tabulku před příjmem dat ve webovém uživatelském rozhraní Azure Data Exploreru nebo příkazem .create table.

Vytvoření mapování schématu: Mapování schémat pomáhají svázat zdrojová datová pole s cílovými sloupci tabulky. Podporují se různé typy mapování, včetně formátů orientovaných na řádky, jako jsou CSV, JSON a AVRO a formáty orientované na sloupce, jako je Parquet. Ve většině metod lze mapování také předem vytvořit v tabulce.

Nastavení zásad aktualizace (volitelné):: Některé formáty dat, jako jsou Parquet, JSON a Avro, umožňují jednoduché transformace v čase ingestování. Pro složitější zpracování během příjmu dat použijte zásadu aktualizace. Tato zásada automaticky provádí extrakce a transformace přijatých dat v původní tabulce a pak ingestuje upravená data do jedné nebo více cílových tabulek.

Ingestování dat: K přenesení dat použijte preferovaný nástroj pro příjem dat, konektor nebo metodu.