Das virtuelle Rechenzentrum: Eine Netzwerkperspektive

Anwendungen, die aus einer lokalen Umgebung migriert werden, können selbst mit minimalen Anwendungsänderungen von der sicheren, kostengünstigen Infrastruktur von Azure profitieren. Unternehmen möchten ggf. ihre Architekturen anpassen, um ihre Flexibilität zu steigern und die Funktionen von Azure zu nutzen.

Microsoft Azure stellt Dienste mit Hyperskalierung und Infrastruktur mit Funktionen und Zuverlässigkeit auf Unternehmensniveau bereit. Diese Dienste und die Infrastruktur bieten zahlreiche Hybridkonnektivitätsoptionen und ermöglichen Kunden den Zugriff über das Internet oder über eine private Netzwerkverbindung. Außerdem können Microsoft-Partner erweiterte Funktionen in Form von Sicherheitsdiensten und virtuellen Geräten anbieten, die für die Verwendung in Azure optimiert sind.

Mit Azure können Kunden ihre Infrastruktur nahtlos auf die Cloud ausdehnen und Architekturen mit mehreren Ebenen erstellen.

Was ist ein virtuelles Rechenzentrum?

Die Cloud war in ihrer Anfangszeit lediglich eine Plattform für das Hosting von öffentlich Anwendungen. Unternehmen erkannten den Wert der Cloud und begannen, interne Branchenanwendungen in die Cloud zu verlagern. Diese Anwendungen waren mit zusätzlicher Sicherheit, Zuverlässigkeit und Leistung sowie mit Kostenaspekten verbunden, die eine weitere Flexibilisierung hinsichtlich der Bereitstellung von Clouddiensten nötig machten. Es wurden neue Infrastruktur- und Netzwerkdienste entwickelt, um für Flexibilität zu sorgen. Neue Features bieten elastische Skalierung, Notfallwiederherstellung und mehr.

Cloudlösungen waren anfänglich darauf ausgelegt, einzelne, relativ isolierte Anwendungen im öffentlichen Spektrum zu hosten. Das hat einige Jahre gut funktioniert. Dann wurden jedoch die Vorteile von Cloudlösungen ersichtlich, und es wurden mehrere umfangreiche Workloads in der Cloud gehostet. Die Berücksichtigung von Sicherheits-, Zuverlässigkeits-, Leistungs- und Kostenaspekten ist für die Bereitstellung und den Lebenszyklus von Clouddiensten von entscheidender Bedeutung.

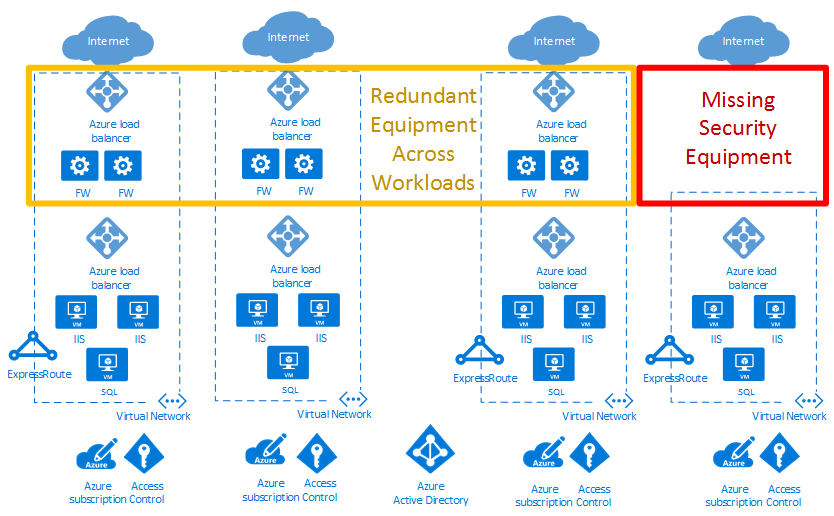

Im Beispiel eines Cloud-Bereitstellungsdiagramms unten markiert das rote Kästchen eine Sicherheitslücke. Das gelbe Kästchen hingegen stellt Möglichkeiten zum Optimieren von virtuellen Netzwerkgeräten in verschiedenen Workloads dar.

Mit virtuellen Rechenzentren kann die Skalierung für Unternehmensworkloads erzielt werden. Die Skalierung muss den Herausforderungen gerecht werden, die mit der Ausführung umfassender Anwendungen in der öffentlichen Cloud einhergehen.

Die Implementierung eines virtuellen Rechenzentrums beinhaltet mehr als nur die Anwendungsworkloads in der Cloud. Sie umfasst auch die Bereiche Netzwerk, Sicherheit, Verwaltung, DNS und Active Directory-Dienste. Im Zuge der Migration weiterer Workloads zu Azure müssen Unternehmen die Infrastruktur und die Objekte berücksichtigen, die diese Workloads unterstützen. Eine gute Ressourcenverwaltung trägt dazu bei, die Zunahme separat verwalteter „Workloadinseln“ mit unabhängigen Datenflüssen, Sicherheitsmodellen und Herausforderungen hinsichtlich der Compliance zu vermeiden.

Das Konzept des virtuellen Rechenzentrums umfasst Empfehlungen und allgemeine Designs zum Implementieren einer Sammlung separater, jedoch zusammengehörender Entitäten. Diese Entitäten weisen häufig gemeinsame unterstützende Funktionen, Features und Infrastrukturen auf. Wenn Sie Ihre Workloads als ein virtuelles Rechenzentrum betrachten, können Sie die Kosten durch Größenvorteile senken. Außerdem wird die Sicherheit durch die Zentralisierung von Komponenten und Datenflüssen optimiert und der Betrieb, die Verwaltung und die Überwachung der Compliance erleichtert.

Hinweis

Ein virtuelles Rechenzentrum ist kein spezieller Azure-Dienst. Stattdessen wurden verschiedene Azure-Features und -Funktionen miteinander kombiniert, um Ihre Anforderungen zu erfüllen. Ein virtuelles Rechenzentrum stellt ein bestimmtes Verständnis Ihrer Workloads und Azure-Nutzung dar, dessen Ziel es ist, Ihre Ressourcen und Möglichkeiten in der Cloud zu optimieren. Es handelt sich um einen modularen Ansatz zum Erstellen von IT-Diensten in Azure, bei dem die organisatorischen Rollen und Zuständigkeiten des Unternehmens respektiert werden.

Ein virtuelles Rechenzentrum kann Unternehmen dabei helfen, Workloads und Anwendungen für die folgenden Szenarien in Azure bereitzustellen:

- Hosten mehrerer verwandter Workloads

- Migrieren von Workloads aus einer lokalen Umgebung zu Azure

- Implementieren von gemeinsam genutzten oder zentralisierten Sicherheits- und Zugriffsanforderungen für verschiedene Workloads

- Ordnungsgemäßes Zusammenlegen von DevOps und der zentralen IT für große Unternehmen

Wer sollte ein virtuelles Rechenzentrum implementieren?

Alle Kunden, die sich für die Einführung von Azure entschieden haben, können von der effizienten Konfiguration eines Ressourcensatzes profitieren, der von allen Anwendungen gemeinsam genutzt wird. Je nach Größe können auch einzelne Anwendungen Vorteile aus den Mustern und den Komponenten ziehen, die zum Erstellen der Implementierung eines virtuellen Rechenzentrums verwendet werden.

In einigen Organisationen gibt es zentrale Teams oder Abteilungen für IT, Netzwerke, Sicherheit oder Compliance. Das Implementieren eines virtuellen Rechenzentrums kann dabei helfen, Aspekte von Richtlinien zu erzwingen, Zuständigkeiten voneinander abzugrenzen und die Konsistenz der zugrunde liegenden gemeinsamen Komponenten sicherzustellen. Anwendungsteams behalten die jeweils benötigte Freiheit und Kontrolle.

Organisationen mit DevOps-Ansatz können auch auf VDC-Konzepte setzen, um autorisierte Segmente von Azure-Ressourcen bereitzustellen. Mit dieser Methode wird sichergestellt, dass die DevOps-Gruppen über vollständige Kontrolle innerhalb dieser Gruppenstruktur verfügen, entweder auf der Abonnementebene oder innerhalb von Ressourcengruppen in einem gemeinsamen Abonnement haben. Gleichzeitig bleiben die Grenzen des Netzwerks und der Sicherheit konform. Die Compliance wird durch eine zentralisierte Richtlinie im Hubnetzwerk und der zentral verwalteten Ressourcengruppe definiert.

Überlegungen zur Implementierung eines virtuellen Rechenzentrums

Beim Entwerfen eines virtuellen Rechenzentrums sind diese zentralen Aspekte zu beachten:

Identitäts- und Verzeichnisdienst

Identitäts- und Verzeichnisdienste sind wichtige Aspekte jedes Rechenzentrums, ganz gleich, ob lokal oder in der Cloud gehostet. Identität bezieht sich auf alle Aspekte des Zugriffs und der Autorisierung für Dienste innerhalb der Implementierung eines virtuellen Rechenzentrums. Um sicherzustellen, dass nur autorisierte Benutzer und Prozesse auf Ihre Azure-Ressourcen zugreifen, verwendet Azure mehrere Typen von Anmeldeinformationen für die Authentifizierung. Hierzu zählen Kontokennwörter, Kryptografieschlüssel, digitale Signaturen und Zertifikate. Die Multi-Faktor-Authentifizierung von Microsoft Entra bietet eine zusätzliche Sicherheitsebene für den Zugriff auf Azure-Dienste. Eine sichere Authentifizierung mit einer Reihe von einfachen Prüfoptionen (Telefonanruf, SMS oder Benachrichtigung über eine mobile App) ermöglicht es den Kunden, die von ihnen bevorzugte Methode zu wählen.

Große Unternehmen müssen einen Identitätsverwaltungsprozess definieren, der die Verwaltung der einzelnen Identitäten, deren Authentifizierung, Autorisierung, Rollen und Berechtigungen innerhalb eines oder in mehreren virtuellen Rechenzentren beschreibt. Mit diesem Prozess werden möglicherweise Sicherheit und Produktivität gesteigert und gleichzeitig Kosten, Ausfallzeiten und sich wiederholende manuelle Aufgaben verringert.

Organisationen in Unternehmen erfordern möglicherweise eine anspruchsvolle Kombination von Diensten für verschiedene Branchen. Mitarbeiter übernehmen oft unterschiedliche Rollen, wenn sie an verschiedenen Projekten arbeiten. Das virtuelle Rechenzentrum erfordert eine gute Zusammenarbeit zwischen verschiedenen Teams mit bestimmten Rollendefinitionen, um Systeme verantwortungsbewusst mit geeigneter Governance aufzusetzen. Die Matrix der Zuständigkeiten, Zugriffsrechte und Berechtigungen kann komplex sein. Die Identitätsverwaltung im VDC wird über Microsoft Entra ID und die rollenbasierte Zugriffssteuerung von Azure (Azure RBAC) implementiert.

Ein Verzeichnisdienst ist eine freigegebene Informationsstruktur für die Suche, Verwaltung und Organisation von täglich verwendeten Elementen und Netzwerkressourcen. Diese Ressourcen können Volumes, Ordner, Dateien, Drucker, Benutzer, Gruppen, Geräte und andere Objekte enthalten. Jede Ressource im Netzwerk wird vom Verzeichnisserver als Objekt angesehen. Informationen zu einer Ressource werden als eine Auflistung von dieser Ressource oder diesem Objekt zugeordneten Attributen gespeichert.

Alle Online-Unternehmensdienste von Microsoft basieren auf Microsoft Entra ID für einmaliges Anmelden und andere Identitätsanforderungen. Microsoft Entra ID ist eine umfassende, hochverfügbare Cloudlösung für die Identitäts- und Zugriffsverwaltung, die wichtige Verzeichnisdienste, erweiterte Identitätsgovernance und Zugriffsverwaltung für Anwendungen kombiniert. Microsoft Entra ID kann mit einer lokalen Active Directory-Instanz integriert werden, um einmaliges Anmelden für alle cloudbasierten und lokal gehosteten lokalen Anwendungen zu ermöglichen. Die Benutzerattribute der lokalen Active Directory-Instanz können automatisch mit Microsoft Entra ID synchronisiert werden.

Jede einzelne Abteilung, Benutzergruppe oder jeder Dienst im Verzeichnisdienst muss über die erforderlichen Mindestberechtigungen verfügen, um die eigenen Ressourcen innerhalb einer VDC-Implementierung verwalten zu können. Das Strukturieren von Berechtigungen muss gut durchdacht sein. Zu viele Berechtigungen können die Leistungseffizienz beeinträchtigen, und zu wenige oder ungenau definierte Berechtigungen können Sicherheitsrisiken erhöhen. Die rollenbasierte Zugriffssteuerung in Azure (Azure Role-Based Access Control, Azure RBAC) löst dieses Problem, indem sie eine differenzierte Zugriffsverwaltung für die Ressourcen in einer VDC-Implementierung ermöglicht.

Sicherheitsinfrastruktur

Die Sicherheitsinfrastruktur bezieht sich auf die Trennung des Datenverkehrs im spezifischen VNET-Segment der Implementierung des virtuellen Netzwerks. Mit dieser Infrastruktur wird angegeben, wie der Ein- und Ausgang bei der Implementierung eines virtuellen Rechenzentrums gesteuert wird. Die Azure-Architektur beruht auf mehreren Mandanten, sodass nicht autorisierter oder unbeabsichtigter Datenverkehr zwischen Bereitstellungen verhindert wird. Sie nutzt die Isolation virtueller Netzwerke, Zugriffssteuerungslisten, Lastenausgleichsmodule, IP-Filter und Richtlinien für den Datenverkehrsfluss. Die Netzwerkadressenübersetzung (Network Address Translation, NAT) trennt den internen vom externen Netzwerkdatenverkehr.

Das Azure-Fabric ordnet Infrastrukturressourcen Mandantenworkloads zu und verwaltet die ein- und ausgehende Kommunikation von virtuellen Computern (Virtual Machines, VMs). Der Azure-Hypervisor erzwingt eine Speicher- und Prozesstrennung zwischen virtuellen Computern und routet den Netzwerkdatenverkehr sicher zu den Gastbetriebssystem-Mandanten.

Verbindung mit der Cloud

Ein virtuelles Rechenzentrum erfordert Konnektivität mit externen Netzwerken, um Dienste für Kunden, Partner oder interne Benutzer bereitzustellen. Es ist nicht nur Konnektivität mit dem Internet, sondern auch mit lokalen Netzwerken und Rechenzentren erforderlich.

Kunden steuern, welche Dienste auf das öffentliche Internet zugreifen können und auf welche Dienste aus dem öffentlichen Internet zugegriffen werden kann. Dieser Zugriff wird mit Azure Firewall oder anderen virtuellen Netzwerkgeräten, angepassten Routingrichtlinien mit benutzerdefinierten Routen und der Netzwerkfilterung mit Netzwerksicherheitsgruppen gesteuert. Wir empfehlen, alle Ressourcen mit Internetzugriff durch Azure DDoS Protection zu schützen.

Unternehmen müssen ihr virtuelles Rechenzentrum unter Umständen mit lokalen Rechenzentren oder anderen Ressourcen verbinden. Diese Konnektivität zwischen Azure und lokalen Netzwerken ist ein entscheidender Aspekt beim Entwerfen einer effektiven Architektur. Unternehmen haben zwei Möglichkeiten, diese Verknüpfung einzurichten: Übertragung über das Internet oder über private Direktverbindungen.

Ein Azure-Site-to-Site-VPN verbindet lokale Netzwerke mit Ihrem virtuellen Rechenzentrum in Azure. Der Link wird über sichere verschlüsselte Verbindungen (IPSec-Tunnel) hergestellt. Azure-Site-to-Site-VPN-Verbindungen sind flexibel, sie können schnell erstellt werden, und es muss in der Regel keine zusätzliche Hardware beschafft werden. Basierend auf Protokollen nach Branchenstandard können die meisten aktuellen Netzwerkgeräte VPN-Verbindungen mit Azure über das Internet oder vorhandene Konnektivitätspfade herstellen.

ExpressRoute ermöglicht private Verbindungen zwischen Ihrem virtuellen Rechenzentrum und lokalen Netzwerken. ExpressRoute-Verbindungen erfolgen nicht über das öffentliche Internet und bieten eine höhere Sicherheit, größere Zuverlässigkeit und schnellere Geschwindigkeit (bis zu 100 Gbit/s) bei konstanter Latenz. ExpressRoute bietet die Vorteile von Konformitätsregeln, die privaten Verbindungen zugeordnet sind. Mit ExpressRoute Direct können Sie eine direkte 10-Gbit/s- oder 100-Gbit/s-Verbindung mit Microsoft-Routern herstellen.

Für die Bereitstellung von ExpressRoute-Verbindungen ist in der Regel ein ExpressRoute-Dienstanbieter erforderlich (eine Ausnahme stellt ExpressRoute Direct dar). Kunden, die schnell die Arbeit aufnehmen müssen, verwenden anfangs üblicherweise Site-to-Site-VPN-Verbindungen, um die Konnektivität zwischen dem virtuellen Rechenzentrum und lokalen Ressourcen herzustellen. Sobald die physische Verbindung mit dem Dienstanbieter eingerichtet wurde, migrieren sie die Konnektivität zu einer ExpressRoute-Verbindung.

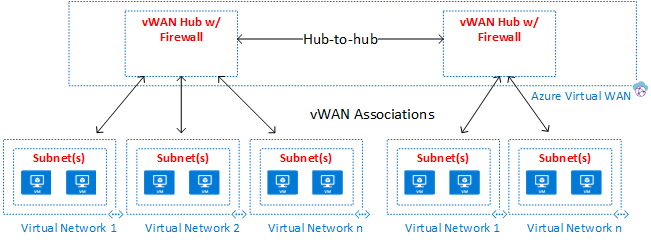

Der Netzwerkdienst Azure Virtual WAN bietet für eine große Anzahl von VPN- oder ExpressRoute-Verbindungen optimierte und automatisierte Konnektivität zwischen Branches über Azure. Per Virtual WAN können Sie Branchgeräte für die Kommunikation mit Azure verbinden und konfigurieren. Die Verbindungsherstellung und Konfiguration kann entweder manuell oder mit Geräten eines bevorzugten Anbieters über einen Virtual WAN-Partner durchgeführt werden. Die Nutzung von Geräten eines bevorzugten Anbieters ermöglicht eine einfache Verwendung, die Vereinfachung der Verbindungsherstellung und die Konfigurationsverwaltung. Über das integrierte Azure WAN-Dashboard können Sie anhand der Problembehandlung sofort Erkenntnisse gewinnen, um Zeit zu sparen, und auf einfache Weise umfangreiche Site-to-Site-Verbindungen anzeigen. Virtual WAN bietet außerdem Sicherheitsdienste mit einer optionalen Azure Firewall und Firewall Manager in Ihrem Virtual WAN-Hub.

Konnektivität in der Cloud

Virtuelle Azure-Netzwerke und Peering in virtuellen Netzwerken sind die grundlegenden Netzwerkkomponenten in einem virtuellen Rechenzentrum. Ein virtuelles Netzwerk garantiert eine Isolationsgrenze für Ressourcen virtueller Rechenzentren. Das Peering ermöglicht die Kommunikation zwischen verschiedenen virtuellen Netzwerken in derselben Azure-Regionen, zwischen verschiedenen Regionen und sogar zwischen Netzwerken in verschiedenen Abonnements. Innerhalb von und zwischen virtuellen Netzwerken können Datenverkehrsflüsse durch Sicherheitsregeln gesteuert werden, die für Netzwerksicherheitsgruppen, Firewallrichtlinien (Azure Firewall oder virtuelle Netzwerkgeräte) und benutzerdefinierten Routen angegeben sind.

Virtuelle Netzwerke sind Ankerpunkte für die Integration von PaaS-Produkten (Platform-as-a-Service) von Azure wie Azure Storage, Azure SQL und anderen integrierten öffentlichen Diensten mit öffentlichen Endpunkten. Mit Dienstendpunkten und Azure Private Link können Sie Ihre öffentlichen Dienste mit Ihrem privaten Netzwerk integrieren. Sie können sogar ihre öffentlichen Dienste für privat erklären, aber dennoch die Vorteile der von Azure verwalteten PaaS-Dienste nutzen.

Übersicht über das virtuelle Rechenzentrum

Topologien

Ein virtuelles Rechenzentrum kann mit einer dieser allgemeinen Topologien entsprechend den jeweiligen Vorgaben und Skalierungsanforderungen erstellt werden:

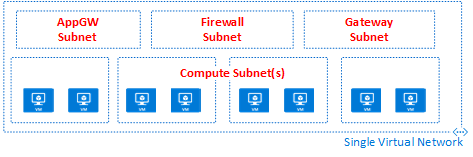

In einer flachen Topologie werden sämtliche Ressourcen in einem einzigen virtuellen Netzwerk bereitgestellt. Subnetze ermöglichen die Steuerung und Trennung von Datenflüssen.

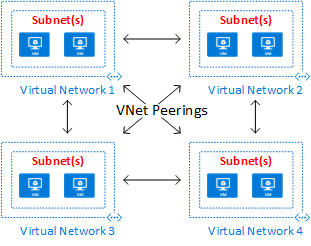

In einer Mesh-Topologie sind alle virtuellen Netzwerke über das Peering virtueller Netzwerke direkt miteinander verbunden.

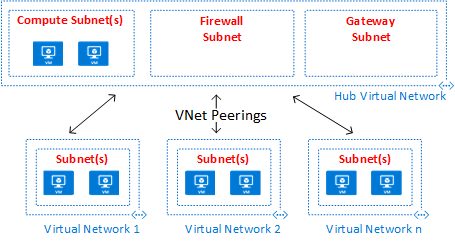

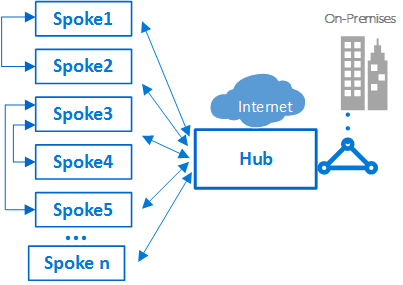

Eine Hub-and-Spoke-Peering-Topologie eignet sich für verteilte Anwendungen und Teams mit delegierten Verantwortlichkeiten.

Eine Azure Virtual WAN-Topologie kann Szenarien mit umfassenden Branches und globale WAN-Dienste unterstützen.

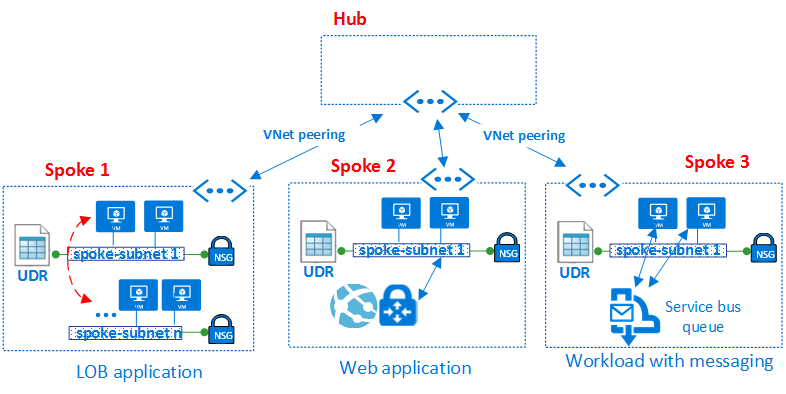

Sowohl der Hub-and-Spoke-Peering-Topologie als auch der Azure Virtual WAN-Topologie liegt ein Hub-and-Spoke-Design zugrunde, das sich optimal für Kommunikation, gemeinsame Ressourcen und zentralisierte Sicherheitsrichtlinien eignet. Hubs werden mit einem Peering-Hub für virtuelle Netzwerke (in der Abbildung als Hub Virtual Network bezeichnet) oder einem Virtual WAN-Hub (in der Abbildung als Azure Virtual WAN bezeichnet) erstellt. Azure Virtual WAN ist auf Kommunikation zwischen umfassenden Branches und die Kommunikation zwischen Branches und Azure ausgelegt. Außerdem wird die Komplexität reduziert, da in einem Peering-Hub für virtuelle Netzwerke nicht alle Komponenten einzeln erstellt werden müssen. In einigen Fällen sprechen Ihre Anforderungen möglicherweise für ein Design mit einem Peering-Hub für virtuelle Netzwerke, z. B. wenn virtuelle Netzwerkgeräte im Hub vorhanden sein müssen.

In Hub-and-Spoke-Topologien ist ein Hub die zentrale Netzwerkzone, die den gesamten Datenverkehr zwischen den verschiedenen Zonen steuert und überprüft, z. B. im Internet, lokal und in den Spokes. Mit der Hub-and-Spoke-Topologie kann die IT-Abteilung Sicherheitsrichtlinien zentral erzwingen. Außerdem verringert sie das Risiko von Fehlkonfigurationen und Offenlegungen.

Der Hub enthält oft allgemeine Dienstkomponenten, die von den Spokes genutzt werden. Im Folgenden finden Sie einige Beispiele für allgemeine zentrale Dienste:

- Die Windows Active Directory-Infrastruktur ist für die Benutzerauthentifizierung von Drittanbietern erforderlich, die über nicht vertrauenswürdige Netzwerke zugreifen, bevor sie Zugriff auf die Workloads im Spoke erhalten. Dies beinhaltet die zugehörigen Active Directory-Verbunddienste (Active Directory Federation Services, AD FS).

- Ein DNS-Dienst (Distributed Name System) wird verwendet, um die Namen der Workloads in den Spokes aufzulösen, um lokal und über das Internet auf Ressourcen zuzugreifen, wenn Azure DNS nicht verwendet wird.

- Eine Public Key-Infrastruktur (PKI) wird verwendet, um das einmalige Anmelden in Workloads zu implementieren.

- Flusssteuerung des TCP- und UDP-Datenverkehrs zwischen den Spoke-Netzwerkzonen und dem Internet

- Flusssteuerung zwischen den Spokes und dem lokalen Netzwerk

- Flusssteuerung zwischen zwei Spokes (sofern erforderlich)

Ein virtuelles Rechenzentrum reduziert die Gesamtkosten mithilfe der gemeinsamen Hubinfrastruktur, die mehrere Spokes umfasst.

Die Rolle eines jeden Spokes kann über verschiedene Arten von Workloads gehostet werden. Die Spokes können auch einen modularen Ansatz für wiederholbare Bereitstellungen der gleichen Workloads bieten. Beispiele hierfür sind Dev/Test, Benutzerakzeptanztests, Präproduktion und Produktion. Mit den Spokes können auch verschiedene Gruppen in Ihrer Organisation getrennt und aktiviert werden. DevOps-Gruppen sind ein gutes Beispiel dafür, was Spokes leisten können. Innerhalb eines Spokes ist es möglich, eine einfache Workload oder komplexe Workloads mit mehreren Ebenen mit einer Datenverkehrssteuerung zwischen den Ebenen bereitzustellen.

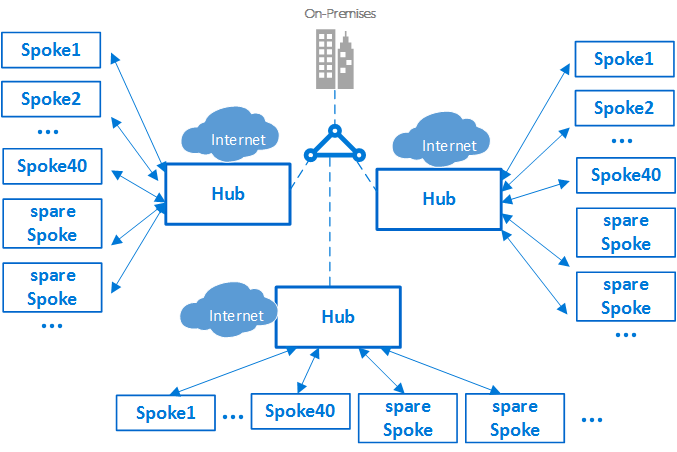

Abonnementlimit und mehrere Hubs

Wichtig

Je nach Größe Ihrer Azure-Bereitstellungen benötigen Sie möglicherweise eine Strategie mit mehreren Hubs. Stellen Sie sich beim Entwerfen Ihrer Hub-and-Spoke-Strategie die Fragen „Kann dieses Design für die Verwendung eines weiteren virtuellen Hub-Netzwerks in dieser Region skaliert werden?“ und „Kann dieses Design so skaliert werden, dass mehrere Regionen abgedeckt werden?“. Es ist weitaus besser, einen Entwurf zu planen, der eine solche Skalierung zulässt, die dann nicht erforderlich ist, als wenn keine derartige Planung erfolgt und Sie diese benötigen.

Ob auf einen sekundären Hub (oder weitere Hubs) skaliert werden muss, hängt von verschiedenen Faktoren ab. Im Allgemeinen sind die inhärenten Grenzwerte für die Skalierung zu beachten. Beim Entwerfen der Skalierung müssen Sie das Abonnement, das virtuelle Netzwerk und die Grenzen für virtuelle Computer überprüfen.

In Azure wird jede Komponente, unabhängig vom Typ, in einem Azure-Abonnement bereitgestellt. Die Isolation von Azure-Komponenten in verschiedenen Azure-Abonnements kann die Anforderungen verschiedener Branchenanwendungen erfüllen, z.B. das Einrichten unterschiedlicher Zugriffs- und Autorisierungsebenen.

Eine einzelne Implementierung des virtuellen Rechenzentrums kann auf eine große Anzahl von Spokes hochskaliert werden. Es gelten jedoch wie bei jedem IT-System gewisse Plattformbeschränkungen. Die Hub-Bereitstellung ist an ein bestimmtes Azure-Abonnement gebunden, das Beschränkungen und Beschränkungen unterliegt (z. B. eine maximale Anzahl von Peerings virtueller Netzwerke. Einzelheiten finden Sie unter Beschränkungen, Kontingente und Beschränkungen für Azure-Abonnements und -Dienste). In Fällen, in denen diese Beschränkungen ein Problem darstellen, kann die Architektur weiter hochskaliert werden, indem das Modell von einem einzelnen Hub und Spoke auf ein Cluster von Hub und Spokes erweitert wird. Mehrere Hubs in einer oder mehreren Azure-Regionen können mithilfe von Peering virtueller Netzwerke, ExpressRoute, Virtual WAN oder einem Site-to-Site-VPN miteinander verbunden werden.

Die Einführung von mehreren Hubs erhöht die Kosten und den Verwaltungsaufwand für das System. Dies lässt sich nur durch Skalierbarkeit, Systemeinschränkungen oder Redundanz und die regionale Replikation zum Erzielen von Leistung für Endbenutzer oder Notfallwiederherstellung rechtfertigen. In Szenarios, die mehrere Hubs erfordern, sollten alle Hubs die gleichen Dienste anbieten, um die Vorgänge nicht zu erschweren.

Verbindung zwischen Spokes

Innerhalb eines einzelnen Spokes oder in einem flachen Netzwerkdesign ist es möglich, komplexe Workloads mit mehreren Ebenen zu implementieren. Konfigurationen mit mehreren Ebenen können mit Subnetzen (eines für jede Ebene oder jede Anwendung) im gleichen virtuellen Netzwerk implementiert werden. Datenverkehr wird mithilfe von Netzwerksicherheitsgruppen und benutzerdefinierten Routen gesteuert und gefiltert.

Ein Architekt möchte vielleicht eine Workload mit mehreren Ebenen in mehreren virtuellen Netzwerken bereitstellen. Mittels Peering in virtuellen Netzwerken können Spokes Verbindungen mit anderen Spokes im gleichen Hub oder in anderen Hubs herstellen. Ein typisches Beispiel für dieses Szenario ist die Platzierung von Anwendungsverarbeitungsservern in einem Spoke oder virtuellen Netzwerk, während die Datenbank in einem anderen Spoke oder virtuellen Netzwerk bereitgestellt wird. In diesem Fall ist es einfach, die Spokes mittels Peering in virtuellen Netzwerken zu verbinden, wodurch das Durchlaufen des Hubs vermieden wird. Führen Sie eine sorgfältige Architektur- und Sicherheitsüberprüfung durch, um sicherzustellen, dass bei der Umgehung des Hubs keine wichtigen Sicherheits- oder Überwachungspunkte umgangen werden, die nur im Hub vorhanden sind.

Spokes können auch mit einem Spoke verbunden werden, der als Hub fungiert. Dieser Ansatz erstellt eine zweistufige Hierarchie. Der Spoke auf der höheren Ebene (Ebene 0) wird zum Knotenpunkt der niedrigeren Spokes (Ebene 1) der Hierarchie. Bei einer Implementierung mit mehreren Rechenzentren müssen die Spokes den Datenverkehr an den zentralen Hub weiterleiten. Der Datenverkehr kann entweder im lokalen Netzwerk oder im öffentlichen Internet an sein Ziel übertragen werden. Eine Architektur mit zwei Hub-Ebenen führt komplexes Routing ein, das die Vorteile einer einfachen Hub-Spoke-Beziehung aufhebt.

Obwohl Azure komplexe Topologien zulässt, ist eines der wesentlichen Prinzipien virtueller Rechenzentren die Wiederholbarkeit und Einfachheit. Um den Verwaltungsaufwand zu minimieren, empfehlen wir den einfachen Hub-Spoke-Entwurf als Referenzarchitektur für virtuelle Rechenzentren.

Komponenten

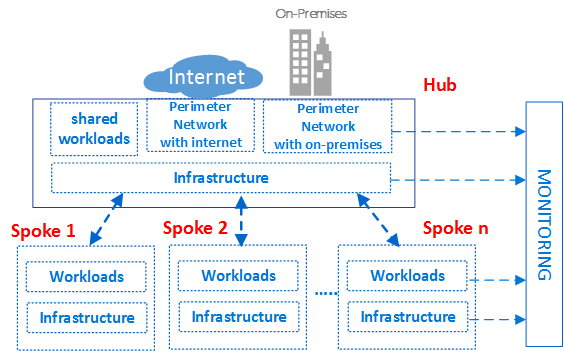

Das virtuelle Rechenzentrum besteht aus vier grundlegenden Komponententypen: Infrastruktur, Umkreisnetzwerke, Workloads und Überwachung.

Jeder Komponententyp besteht aus verschiedenen Azure-Funktionen und -Ressourcen. Ihre Implementierung des virtuellen Rechenzentrums besteht aus Instanzen verschiedener Komponententypen und mehreren Varianten des gleichen Komponententyps. Angenommen, Sie haben viele verschiedene, logisch getrennte Workloadinstanzen, die unterschiedliche Anwendungen darstellen. Aus diesen verschiedenen Komponententypen und Instanzen erstellen Sie das virtuelle Rechenzentrum.

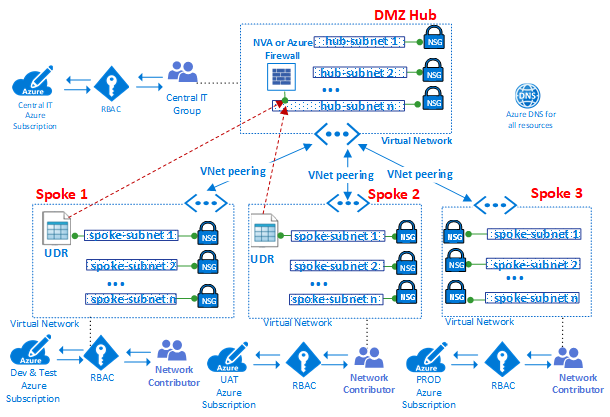

Die obige allgemeine konzeptionelle Architektur des virtuellen Rechenzentrums zeigt verschiedene Komponententypen, die in unterschiedlichen Zonen der Hub-and-Spoke-Topologie verwendet werden. Die Abbildung zeigt die Infrastrukturkomponenten in verschiedenen Teilen der Architektur.

Es ist im Allgemeinen eine bewährte Methode, gruppenbasierte Zugriffsrechte und Berechtigungen zu verwenden. Die Nutzung von Gruppen anstelle von einzelnen Benutzern vereinfacht die Wartung von Zugriffsrichtlinien, indem eine einheitliche teamübergreifende Verwaltung der Wartung erreicht, wodurch die Minimierung von Konfigurationsfehlern unterstützt wird. Das Zuweisen und Entfernen von Benutzern zu und aus den entsprechenden Gruppen erleichtert die Aktualisierung der Berechtigungen von bestimmten Benutzern.

Der Name jeder Rollengruppe kann ein eindeutiges Präfix aufweisen. Anhand dieses Präfixes kann einfach ermittelt werden, welcher Workload eine Gruppe zugeordnet ist. Einer Workload, die einen Authentifizierungsdienst hostet, könnten beispielsweise Gruppen namens AuthServiceNetOps, AuthServiceSecOps, AuthServiceDevOps und AuthServiceInfraOps zugewiesen sein. Für zentrale Rollen oder Rollen, die in keinem Zusammenhang mit einem bestimmten Dienst stehen, könnte das Präfix Corp verwendet werden. Ein Beispiel hierfür ist CorpNetOps.

Viele Organisationen verwenden in etwa die folgenden Gruppen, um Rollen bereitzustellen:

- Das zentrale IT-Team namens Corp verfügt über die Besitzrechte zum Steuern von Infrastrukturkomponenten. Beispiele hierfür sind Netzwerke und die Sicherheit. Der Gruppe muss über die Rolle „Mitwirkender“ für das Abonnement, die Kontrolle über den Hub und die Rechte eines Mitwirkenden des virtuellen Netzwerks in den Spokes verfügen. Große Unternehmen teilen diese Verwaltungsaufgaben häufig zwischen mehreren Teams auf, beispielsweise zwischen einer Gruppe für Netzwerkvorgänge CorpNetOps, die sich ausschließlich um den Netzwerkbetrieb kümmert, und einer Gruppe für Sicherheitsvorgänge CorpSecOps, die für die Firewall- und Sicherheitsrichtlinien verantwortlich ist. In diesem speziellen Fall müssen zwei unterschiedliche Gruppen für die Zuweisung dieser benutzerdefinierten Rollen erstellt werden.

- Die für die Entwicklung und Tests (Dev/Test) zuständige Gruppe namens AppDevOps ist für die Bereitstellung von App- oder Dienstworkloads verantwortlich. Diese Gruppe übernimmt die Rolle des VM-Mitwirkenden für IaaS-Bereitstellungen oder eine oder mehrere Rollen von PaaS-Mitwirkenden. Weitere Informationen finden Sie unter Integrierte Azure-Rollen. Optional benötigt das Entwicklungs- und Testteam möglicherweise Einblick in Sicherheitsrichtlinien (Netzwerksicherheitsgruppen) und Routingrichtlinien (benutzerdefinierte Routen) im Hub oder einem bestimmte Spoke. Zusätzlich zur Rolle des Mitwirkenden für Workloads benötigt diese Gruppe auch die Rolle des Netzwerklesers.

- Die Betriebs- und Wartungsgruppe namens CorpInfraOps oder AppInfraOps ist für die Verwaltung von Workloads in der Produktion zuständig. Diese Gruppe muss ein Mitwirkender des Abonnements von Workloads in jedem Produktionsabonnement sein. Manche Organisationen sollten zudem prüfen, ob sie ein Team für den Eskalationssupport mit der Rolle des Mitwirkenden des Abonnements in der Produktion und im zentralen Hubabonnement benötigen. Die andere Gruppe behebt potenzielle Konfigurationsprobleme in der Produktionsumgebung.

Das virtuelle Rechenzentrum ist so konzipiert, dass die zentralen IT-Teamgruppen, die den Hub verwalten, über entsprechende Gruppen auf der Workloadebene verfügen. Zusätzlich zur Verwaltung der Hub-Ressourcen können die zentralen IT-Teams den externen Zugriff und die Berechtigungen auf oberster Ebene für das Abonnement steuern. Workloadgruppen sind ebenfalls in der Lage, Ressourcen und Berechtigungen ihres eigenen virtuellen Netzwerks unabhängig vom zentralen IT-Team zu steuern.

Das virtuelle Rechenzentrum ist partitioniert, damit mehrere Projekte in unterschiedlichen Branchenanwendungen sicher gehostet werden können. Alle Projekte erfordern unterschiedliche isolierte Umgebungen (Dev, UAT und Produktion). Einzelne Azure-Abonnements für jede dieser Umgebungen können natürliche Isolationsstufen darstellen.

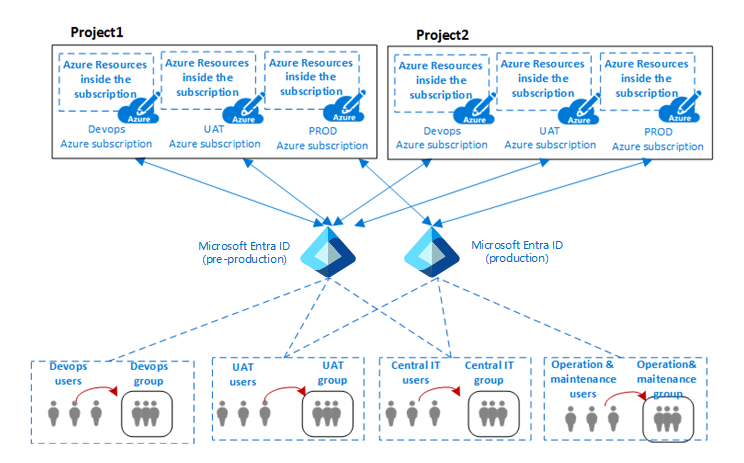

Die vorherige Abbildung veranschaulicht die Beziehung zwischen den Projekten, Benutzern und den Umgebungen einer Organisation, in denen die Azure-Komponenten bereitgestellt werden.

In der Regel ist eine Umgebung (oder Ebene) in der IT ein System, in dem mehrere Anwendungen bereitgestellt und ausgeführt werden. Große Unternehmen verwenden eine Entwicklungsumgebung (in der Änderungen vorgenommen und getestet werden) und eine Produktionsumgebung (die die Endbenutzer verwenden). Diese Umgebungen werden häufig durch mehrere Stagingumgebungen getrennt, um die Bereitstellung (Rollout), Tests und den Rollback in Phasen zu ermöglichen, falls Probleme auftreten. Bereitstellungsarchitekturen unterscheiden sich erheblich. In der Regel wird aber dem Grundmuster (Entwicklung (DEV) = Beginn, Produktion (PROD) = Ende) gefolgt.

Eine übliche Architektur für diese Arten von Umgebungen mit mehreren Ebenen umfasst eine DevOps-Umgebung für Entwicklung und Tests, eine UAT-Umgebung für das Staging und eine Produktionsumgebung. Organisationen können einzelne oder mehrere Microsoft Entra-Mandanten nutzen, um Zugriff auf und Rechte für diese Umgebungen zu definieren. Die vorherige Abbildung veranschaulicht einen Fall mit zwei verschiedenen Microsoft Entra-Mandanten: einen für DevOps und UAT und einen anderen ausschließlich für die Produktion.

Wenn mehrere Microsoft Entra-Mandanten vorhanden sind, müssen die Umgebungen getrennt werden. Dieselbe Gruppe von Benutzer*innen, z. B. das zentrale IT-Team, muss sich mithilfe eines anderen URI authentifizieren, um auf einen anderen Microsoft Entra-Mandanten zuzugreifen. Dadurch kann das Team die Rollen oder Berechtigungen entweder der DevOps- oder der Produktionsumgebung eines Projekts ändern. Die Verwendung unterschiedlicher Benutzerauthentifizierungen für den Zugriff auf verschiedene Umgebungen reduziert das Risiko möglicher Ausfälle und anderer Probleme durch menschliches Versagen.

Komponententyp: Infrastruktur

In diesem Komponententyp befindet sich der Großteil der unterstützenden Infrastruktur. Diese Komponente beansprucht auch die meiste Zeit Ihrer Teams für die zentrale IT, Sicherheit und Konformität.

Infrastrukturkomponenten stellen eine Verbindung für die unterschiedlichen Komponenten der Implementierung eines virtuellen Rechenzentrums bereit und sind sowohl auf dem Hub als auch auf den Spokes vorhanden. Die Verantwortung für die Verwaltung und Wartung der Infrastrukturkomponenten wird in der Regel dem zentralen IT-Team oder dem Sicherheitsteam übertragen.

Eine der wichtigsten Aufgaben des IT-Infrastrukturteams ist die Gewährleistung der Konsistenz von IP-Adressenschemata im gesamten Unternehmen. Der private IP-Adressraum, der einer Implementierung eines virtuellen Rechenzentrums zugewiesen ist, muss konsistent sein und darf sich nicht mit privaten IP-Adressen in Ihren lokalen Netzwerken überlappen.

Obwohl die Netzwerkadressenübersetzung (Network Address Translation, NAT) in den lokalen Edgeroutern oder in Azure-Umgebungen IP-Adressenkonflikte vermeiden kann, bedeutet sie Komplikationen für Ihre Infrastrukturkomponenten. Die Vereinfachung der Verwaltung ist eines der wichtigsten Ziele von virtuellen Rechenzentren. Die Verwendung von NAT zum Behandeln von Bedenken hinsichtlich der IP-Adressen ist zwar eine zulässige, aber keine empfohlene Lösung.

Infrastrukturkomponenten bieten die folgenden Funktionen:

- Identität und Verzeichnisdienste: Der Zugriff auf jeden Ressourcentyp in Azure wird über eine Identität gesteuert, die in einem Verzeichnisdienst gespeichert ist. Der Verzeichnisdienst speichert nicht nur die Liste der Benutzer, sondern auch die Zugriffsrechte für Ressourcen in einem bestimmten Azure-Abonnement. Diese Dienste können in der Cloud existieren oder mit lokalen Identitäten, die in Active Directory gespeichert sind, synchronisiert werden.

- Virtuelle Netzwerke: Virtuelle Netzwerke sind eine der Hauptkomponenten des virtuellen Rechenzentrums und ermöglichen es Ihnen, eine Isolationsgrenze für den Datenverkehr auf der Azure-Plattform zu erstellen. Ein virtuelles Netzwerk besteht aus einem einzelnen oder mehreren virtuellen Netzwerksegmenten, die jeweils ein bestimmtes Präfix für IP-Netzwerke (ein Subnetz, entweder IPv4 oder Dual Stack IPv4/IPv6) haben. Das virtuelle Netzwerk definiert einen internen Umkreisbereich, in dem IaaS-VMs und PaaS-Dienste eine private Kommunikation herstellen können. Virtuelle Computer (und PaaS-Dienste) in einem virtuellen Netzwerk können nicht direkt mit virtuellen Computern und PaaS-Diensten in einem anderen virtuellen Netzwerk kommunizieren. Dies gilt auch dann, wenn beide virtuellen Netzwerke von demselben Kunden im Rahmen desselben Abonnements erstellt wurden. Isolation ist eine wichtige Eigenschaft, mit der sichergestellt wird, dass VMs und die Kommunikation von Kunden innerhalb eines virtuellen Netzwerks privat bleiben. Wenn netzwerkübergreifende Verbindungen gewünscht werden, kann dies mit den im Folgenden beschriebenen Features erreicht werden.

- Peering virtueller Netzwerke: Das grundlegende Feature, das verwendet wird, um die Infrastruktur eines virtuellen Rechenzentrums zu erstellen, ist das Peering virtueller Netzwerke, das zwei virtuelle Netzwerke in derselben Region miteinander verbindet. Diese Verbindung erfolgt über das Netzwerk des Azure-Rechenzentrums oder mithilfe des weltweiten regionsübergreifenden Azure-Backbones.

- Dienstendpunkte für virtuelle Netzwerke: Dienstendpunkte erweitern Ihren privaten Adressraum des virtuellen Netzwerks um Ihren PaaS-Raum. Die Endpunkte erweitern auch die Identität Ihres virtuellen Netzwerks über eine direkte Verbindung auf die Azure-Dienste. Endpunkte ermöglichen es Ihnen, Ihre kritischen Azure-Dienstressourcen auf Ihre virtuellen Netzwerke zu beschränken und so zu schützen.

- Private Link: Mit Azure Private Link können Sie über einen privaten Endpunkt in Ihrem virtuellen Netzwerk auf Azure-PaaS-Dienste (beispielsweise Azure Storage, Azure Cosmos DB und Azure SQL-Datenbank) sowie auf in Azure gehostete Kunden-/Partnerdienste zugreifen. Der Datenverkehr zwischen Ihrem virtuellen Netzwerk und dem Dienst wird über das Microsoft-Backbone-Netzwerk übertragen und dadurch vom öffentlichen Internet isoliert. Sie können auch Ihren eigenen Private Link-Dienst in Ihrem virtuellen Netzwerk erstellen und Ihren Kunden privat zur Verfügung stellen. Die Einrichtung und Nutzung von Azure Private Link ist in Azure-PaaS-, Kunden- und gemeinsamen Partnerdiensten konsistent.

- Benutzerdefinierte Routen: Datenverkehr in einem virtuellen Netzwerk wird standardmäßig basierend auf der Systemroutingtabelle weitergeleitet. Eine benutzerdefinierte Route ist eine vom Benutzer definierte Routingtabelle, die von Netzwerkadministratoren einem oder mehreren Subnetzen zugeordnet werden kann, um das Verhalten der Systemroutingtabelle außer Kraft zu setzen und einen Kommunikationspfad innerhalb eines virtuellen Netzwerks zu definieren. Benutzerdefinierte Routen gewährleisten, dass Datenverkehr aus dem Spoke durch einen bestimmten benutzerdefinierten virtuellen Computer oder virtuelle Netzwerkgeräte und Lastenausgleichsmodule geleitet wird, die sowohl im Hub als auch in den Spokes vorhanden sind.

- Netzwerksicherheitsgruppen: Eine Netzwerksicherheitsgruppe ist eine Liste von Sicherheitsregeln, die als Datenverkehrsfilter für IP-Quellen, IP-Ziele, Protokolle, IP-Quellports und IP-Zielports fungieren (auch als Fünf-Tupel der Ebene 4 bezeichnet). Die Netzwerksicherheitsgruppe kann auf ein Subnetz, auf eine virtuelle Netzwerkkarte (NIC), die mit einer Azure-VM verknüpft ist, oder beides angewendet werden. Netzwerksicherheitsgruppen sind entscheidend für die Implementierung einer korrekten Flusssteuerung im Hub und in den Spokes. Das Maß an Sicherheit, das die Netzwerksicherheitsgruppen bieten, hängt davon ab, welche Ports Sie öffnen und zu welchem Zweck. Kunden können mit hostbasierten Firewalls wie „iptables“ oder der Windows-Firewall weitere Filter pro virtuellem Computer anwenden.

- DNS: DNS ermöglicht die Namensauflösung für Ressourcen in einem virtuellen Rechenzentrum. Azure bietet DNS-Dienste für öffentliche und private Namensauflösung. Private Zonen bieten Namensauflösung in einem virtuellen Netzwerk und zwischen virtuellen Netzwerken. Private Zonen können sich über virtuelle Netzwerke in derselben Region, über Regionen und Abonnements hinweg erstrecken. Für die öffentliche Auflösung bietet Azure DNS einen Hostingdienst für DNS-Domänen, der die Namensauflösung mithilfe von Microsoft Azure-Infrastruktur durchführt. Durch das Hosten Ihrer Domänen in Azure können Sie Ihre DNS-Einträge mithilfe der gleichen Anmeldeinformationen, APIs, Tools und Abrechnung wie für die anderen Azure-Dienste verwalten.

- Managementgruppen-, Abonnement- und Ressourcengruppen-Verwaltung. Ein Abonnement definiert eine natürliche Grenze, um mehrere Ressourcengruppen in Azure zu erstellen. Diese Abgrenzung kann sich auf Funktionen, die Trennung von Rollen oder die Abrechnung beziehen. Ressourcen in einem Abonnement werden in logischen Containern zusammengefasst, die als Ressourcengruppen bezeichnet werden. Die Ressourcengruppe stellt eine logische Gruppe dar, in der die Ressourcen eines virtuellen Rechenzentrums organisiert werden. Verfügt eine Organisation über viele Abonnements, ist häufig eine Strategie zur effizienten Verwaltung des Zugriffs, der Richtlinien und der Einhaltung dieser Abonnements erforderlich. Azure-Verwaltungsgruppen stellen einen abonnementübergreifenden Bereich dar. Sie organisieren Abonnements in Containern, die als Verwaltungsgruppen bezeichnet werden, und wenden Ihre Governancebedingungen auf die Verwaltungsgruppen an. Alle Abonnements in einer Verwaltungsgruppe erben automatisch die auf die Verwaltungsgruppe angewendeten Bedingungen. Informationen zu diesen drei Features in einer hierarchischen Ansicht finden Sie unter Organisieren Ihrer Azure-Ressourcen im Cloud Adoption Framework.

- Rollenbasierte Zugriffssteuerung in Azure (Azure RBAC): Azure RBAC kann organisatorische Rollen und Rechte für den Zugriff auf bestimmte Azure-Ressourcen zuordnen. Auf diese Weise können Sie Benutzer auf eine bestimmte Teilmenge von Aktionen beschränken. Wenn Sie Microsoft Entra ID mit einem lokalen Active Directory synchronisieren, können Sie in Azure die gleichen Active Directory-Gruppen wie lokal verwenden. Mit Azure RBAC können Sie Zugriff gewähren, indem Sie Benutzern, Gruppen und Anwendungen innerhalb des relevanten Bereichs die entsprechende Rolle zuweisen. Der Bereich einer Rollenzuweisung kann ein Azure-Abonnement, eine Ressourcengruppe oder eine einzelne Ressource sein. Azure RBAC ermöglicht die Vererbung von Berechtigungen. Mit einer Rolle, die einem übergeordneten Bereich zugewiesen ist, wird außerdem der Zugriff auf die darin enthaltenen untergeordneten Elemente gewährt. Mit Azure RBAC können Sie Aufgaben verteilen und Benutzern nur den Zugriff gewähren, den sie zur Ausführung ihrer Aufgaben benötigen. Ein Mitarbeiter kann beispielsweise virtuelle Computer in einem Abonnement verwalten, während ein anderer im gleichen Abonnement SQL Server-Datenbanken verwalten kann.

Komponententyp: Umkreisnetzwerke

Mit den Komponenten eines Umkreisnetzwerks (das gelegentlich auch als DMZ-Netzwerk bezeichnet wird) können Sie Verbindungen zwischen Ihren lokalen oder physischen Rechenzentrumsnetzwerken und darüber hinaus Konnektivität mit dem Internet herstellen. Ihre Netzwerk- und Sicherheitsteams verwenden in der Regel viel Zeit auf den Umkreis.

Eingehende Pakete können durch die Sicherheitsgeräte im Hub geleitet werden, bevor sie die Back-End-Server und -Dienste in den Spokes erreichen. Beispiele hierfür sind die Firewall, IDS und IPS. Von den Workloads an das Internet gesendete Pakete können ebenfalls über die Sicherheitsgeräte im Umkreisnetzwerk geleitet werden, bevor sie das Netzwerk verlassen. Mit diesem Fluss können Richtlinien erzwungen, überprüft und überwacht werden.

Komponenten des Umkreisnetzwerks:

- Virtuelle Netzwerke, benutzerdefinierte Routen und Netzwerksicherheitsgruppen

- Virtuelle Netzwerkgeräte

- Azure-Lastenausgleich

- Azure Application Gateway mit Web Application Firewall (WAF)

- Öffentliche IP-Adressen

- Azure Front Door mit Web Application Firewall (WAF)

- Azure Firewall und Azure Firewall Manager

- DDoS Protection Standard

In der Regel sind das zentrale IT-Team und die Sicherheitsteams für die Anforderungsdefinition und die Vorgänge in den Umkreisnetzwerken verantwortlich.

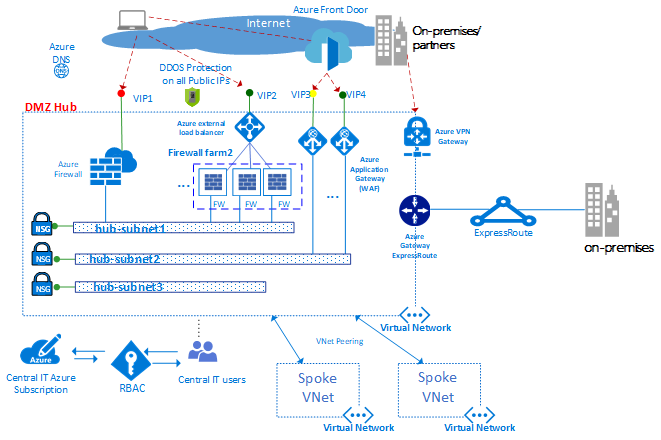

Die obige Abbildung veranschaulicht die Durchsetzung von zwei Perimetern mit Zugriff auf das Internet und einem lokalen Netzwerk, beide im DMZ-Hub. Im DMZ-Hub kann das Umkreisnetzwerk zum Internet zur Unterstützung vieler Branchenanwendungen mit mehreren Farmen von Web Application Firewalls (WAFs) oder Azure Firewalls hochskaliert werden. Der Hub ermöglicht je nach Bedarf außerdem lokale Konnektivität über VPN oder ExpressRoute.

Hinweis

In der Abbildung oben können Sie können in DMZ Hub viele der folgenden Features zusammen in einem Azure Virtual WAN-Hub gebündelt werden (z. B. virtuelle Netzwerke, benutzerdefinierte Routen, Netzwerksicherheitsgruppen, VPN-Gateways, ExpressRoute-Gateways, Azure Load Balancer-Instanzen, Azure Firewall-Instanzen, Firewall Manager und DDOS). Das Verwenden von Azure Virtual WAN-Hubs kann die Erstellung des virtuellen Hub-Netzwerks und des virtuellen Rechenzentrums sehr erleichtern, da die meisten technisch komplexen Vorgänge beim Erstellen eines Azure Virtual WAN-Hubs von Azure ausgeführt werden.

Virtuelle Netzwerke. Der Hub wird in der Regel über ein virtuelles Netzwerk mit mehreren Subnetzen erstellt, die verschiedene Arten von Diensten hosten. Diese Dienste filtern und prüfen den Datenverkehr zum oder vom Internet über Azure Firewall, NVAs, WAF und Azure Application Gateway-Instanzen.

Benutzerdefinierte Routen. Mit benutzerdefinierten Routen können Kunden Firewalls, IDS- oder IPS-Geräte und andere virtuelle Geräte bereitstellen. Sie können den Netzwerkdatenverkehr zum Erzwingen von Sicherheitsrichtlinien, zur Überwachung und zur Überprüfung über diese Sicherheitsgeräte routen. Benutzerdefinierte Routen können sowohl im Hub als auch in den Spokes erstellt werden, um sicherzustellen, dass Datenverkehr durch die spezifischen benutzerdefinierten VMs, virtuellen Netzwerkgeräte und Lastenausgleichsmodule geleitet wird, die von einer VDC-Implementierung verwendet werden. Um sicherzustellen, dass der von virtuellen Computern im Spoke generierte Datenverkehr zu den richtigen virtuellen Geräten geleitet wird, muss in den Subnetzen des Spokes eine benutzerdefinierte Route festgelegt werden. Dazu legen Sie die Front-End-IP-Adresse des internen Lastenausgleichs als nächsten Hop fest. Der interne Load Balancer verteilt den internen Datenverkehr auf die virtuellen Geräte (Back-End-Pool des Load Balancers).

Azure Firewall ist ein verwalteter Netzwerksicherheitsdienst zum Schutz Ihrer Azure Virtual Network-Ressourcen. Es handelt sich dabei um eine zustandsbehaftete verwaltete Firewall mit Hochverfügbarkeit und Cloudskalierbarkeit. Sie können Richtlinien zur Anwendungs- und Netzwerkkonnektivität übergreifend für Abonnements und virtuelle Netzwerke zentral erstellen, erzwingen und protokollieren. Azure Firewall verwendet eine statische öffentliche IP-Adresse für Ihre virtuellen Netzwerkressourcen. Dadurch können externe Firewalls Datenverkehr aus Ihrem virtuellen Netzwerk identifizieren. Der Dienst ist für Protokollierung und Analyse vollständig in Azure Monitor integriert.

Wenn Sie die Azure Virtual WAN-Topologie verwenden, verfügen Sie mit Azure Firewall Manager über einen Sicherheitsverwaltungsdienst, der eine zentrale Sicherheitsrichtlinien- und Routenverwaltung für cloudbasierte Sicherheitsperimeter bereitstellt. Der Dienst arbeitet mit Azure Virtual WAN Hub zusammen, einer von Microsoft verwalteten Ressource, mit der Sie ganz einfach Hub-and-Spoke-Architekturen erstellen können. Wenn einem Hub Sicherheits- und Routingrichtlinien zugeordnet werden, wird dieser als geschützter virtueller Hub bezeichnet.

Virtuelle Netzwerkgeräte. Im Hub wird das Umkreisnetzwerk mit Zugriff auf das Internet normalerweise über eine Azure Firewall-Instanz oder eine Farm von Firewalls oder Web Application Firewall (WAF) verwaltet.

In verschiedenen Branchen werden häufig viele Webanwendungen verwendet. Diese Anwendungen weisen häufig diverse Sicherheitsrisiken und potenzielle Exploits auf. Eine Web Application Firewall ist eine spezielle Art von Produkt, das verwendet wird, um Angriffe auf Webanwendungen und HTTP/HTTPS effektiver zu erkennen als eine allgemeine Firewall. Verglichen mit herkömmlichen Firewalls besitzen WAFs einen Satz von bestimmten Features, um den internen Webserver vor Bedrohungen zu schützen.

Azure Firewall oder eine NVA-Firewall verwenden eine gemeinsame Verwaltungsebene mit einem Satz von Sicherheitsregeln, um die in den Spokes gehosteten Workloads zu schützen und den Zugriff auf lokale Netzwerke zu steuern. Azure Firewall verfügt über integrierte Skalierbarkeit, während NVA-Firewalls hinter einem Lastenausgleich manuell skaliert werden können. Im Allgemeinen verfügt eine Firewallfarm im Vergleich zu einer Web Application Firewall über weniger spezialisierte Software. Sie hat jedoch einen umfassenderen Anwendungsbereich, sodass sie alle Arten von ein- und ausgehendem Datenverkehr filtern und überprüfen kann. Virtuelle Netzwerkgeräte für den NVA-Ansatz sind auf dem Azure Marketplace verfügbar und können von dort bereitgestellt werden.

Wir empfehlen, eine Gruppe von Azure Firewall-Instanzen oder virtuellen Netzwerkgeräten für Datenverkehr aus dem Internet zu verwenden. Verwenden Sie für Datenverkehr mit lokalem Ursprung eine andere Gruppe. Die Verwendung einer einzigen Gruppe von Firewalls für den gesamten Datenverkehr stellt ein Sicherheitsrisiko dar, da sie keinen wirksamen Sicherheitsbereich zwischen den beiden Arten von Netzwerkdatenverkehr bietet. Separate Firewallebenen vereinfachen die Überprüfung von Sicherheitsregeln, wodurch eine eindeutige Zuordnung von Regeln zu eingehenden Netzwerkanforderungen ermöglicht wird.

Azure Load Balancer stellt einen Dienst mit hoher Verfügbarkeit der Ebene 4 (TCP/UDP) bereit, mit dem eingehender Datenverkehr zwischen Dienstinstanzen verteilt werden kann, die in einer Gruppe mit Lastenausgleich definiert sind. Der Datenverkehr, der von den Front-End-Endpunkten (öffentliche IP-Endpunkte oder private IP-Endpunkte) an den Load Balancer gesendet wird, kann mit oder ohne Adressübersetzung auf einen Satz von Back-End-IP-Adresspools weiterverteilt werden (z. B. virtuelle Netzwerkgeräte oder virtuelle Computer).

Azure Load Balancer kann die Integrität von verschiedenen Serverinstanzen testen. Wenn eine Instanz nicht auf einen Test reagiert, sendet der Lastenausgleich keinen weiteren Datenverkehr an die fehlerhafte Instanz. Im virtuellen Rechenzentrum wird ein externer Load Balancer für den Hub und die Spokes bereitgestellt. Im Hub wird der Lastenausgleich verwendet, um den Datenverkehr effizient über Firewallinstanzen zu leiten. In den Spokes werden die Lastenausgleiche verwendet, um den Datenverkehr der Anwendungen zu verwalten.

Der Microsoft-Dienst Azure Front Door Service (AFDS) stellt eine hoch verfügbare und hochgradig skalierbare Plattform für die Beschleunigung von Webanwendungen mit globalem HTTP-Lastenausgleich, Anwendungsschutz und Content Delivery Network bereit. AFDS wird an mehr als 100 Standorten im Edgebereich des globalen Netzwerks von Microsoft ausgeführt und ermöglicht Ihnen das Erstellen, Ausführen und Aufskalieren Ihrer dynamischen Webanwendung und statischen Inhalte. AFDS stellt für Ihre Anwendung erstklassige Endbenutzerleistung, einheitliche Automatisierung der Regions-/Stempelwartung, BCDR-Automatisierung, einheitliche Client-/Benutzerinformationen, Zwischenspeicherung und Erkenntnisse zu Ihren Diensten bereit.

Die Plattform bietet Folgendes:

- Leistung, Zuverlässigkeit und Vereinbarungen zum Service Level (SLAs) für den Support.

- Compliancezertifizierungen.

- Überprüfbare Sicherheitspraktiken, die von Azure entwickelt, betrieben und nativ unterstützt werden.

Azure Front Door bietet außerdem eine Web Application Firewall (WAF), die Webanwendungen vor allgemeinen Sicherheitslücken und Schwachstellen (Common Vulnerabilities and Exposures, CVE) schützt.

Azure Application Gateway ist ein dediziertes virtuelle Gerät, mit dem ein verwalteter Controller zur Anwendungsbereitstellung bereitgestellt wird. Es bietet verschiedene Lastenausgleichsfunktionen der Ebene 7 für Ihre Anwendung. Sie können damit die Leistung von Webfarmen steigern, indem sie die CPU-intensive SSL-Beendigung an das Anwendungsgateway auslagern. Darüber hinaus werden noch weitere Routingfunktionen der Ebene 7 bereitgestellt. Hierzu zählen etwa die Roundrobin-Verteilung des eingehenden Datenverkehrs, cookiebasierte Sitzungsaffinität, Routing auf URL-Pfadbasis und die Möglichkeit zum Hosten mehrerer Websites hinter einer einzelnen Application Gateway-Instanz. Eine Web Application Firewall (WAF) wird auch als Teil des WAF SKU des Anwendungsgateways bereitgestellt. Dieser SKU bietet Schutz für Webanwendungen vor allgemeinen Onlinesicherheitsrisiken und Exploits. Ein Anwendungsgateway kann als Gateway mit Internetanbindung, rein internes Gateway oder als Kombination dieser beiden Optionen konfiguriert werden.

Öffentliche IP-Adressen. Einige Azure-Features ermöglichen Ihnen, einer öffentlichen IP-Adresse Dienstendpunkte zuzuordnen, sodass über das Internet auf die Ressource zugegriffen werden kann. Der Endpunkt verwendet die Netzwerkadressenübersetzung (NAT), um Datenverkehr zur internen Adresse und zum Port im virtuellen Netzwerk in Azure zu leiten. Dieser Pfad ist der primäre Weg, auf dem externer Datenverkehr in das virtuelle Netzwerk gelangt. Sie können die öffentlichen IP-Adressen konfigurieren, um festzulegen, welcher Datenverkehr zugelassen wird bzw. wie und wo eine Übersetzung in das virtuelle Netzwerk stattfindet.

Azure DDoS Protection stellt über den Diensttarif Basic hinaus weitere Risikominderungsfunktionen bereit, die speziell für Ressourcen im virtuellen Azure-Netzwerk optimiert sind. DDoS Protection kann einfach aktiviert werden und erfordert keine Anwendungsänderungen. Schutzrichtlinien werden über dedizierte Datenverkehrsüberwachung und Machine Learning-Algorithmen optimiert. Richtlinien werden auf öffentliche IP-Adressen angewendet, die in virtuellen Netzwerken bereitgestellten Ressourcen zugeordnet sind. Beispiele hierfür sind Instanzen von Azure Load Balancer, Azure Application Gateway und Azure Service Fabric. Über Azure Monitor-Ansichten stehen systemgenerierte Protokolle (in Quasi-Echtzeit) während eines Angriffs und für den Verlauf zur Verfügung. Mit der Web Application Firewall für das Azure-Anwendungsgateway können Sie Schutz auf der Anwendungsebene hinzufügen. Schutz wird für öffentliche Azure-IP-Adressen mit IPv4 und IPv6 bereitgestellt.

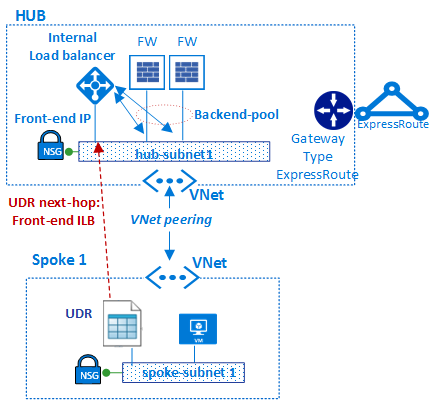

Die Hub-Spoke-Topologie nutzt zum ordnungsgemäßen Weiterleiten von Datenverkehr das Peering virtueller Netzwerke und benutzerdefinierte Routen.

Im Diagramm stellt die benutzerdefinierte Route sicher, dass der Datenverkehr von der Spoke zur Firewall fließt, bevor er über das ExpressRoute-Gateway an den lokalen Standort weitergegeben wird (sofern die Firewallrichtlinie diesen Datenfluss zulässt).

Komponententyp: Überwachung

Überwachungskomponenten bieten Sichtbarkeit und Warnungen aus allen anderen Komponententypen. Alle Teams können die Komponenten und Dienste, auf die sie Zugriff haben, überwachen. Wenn Sie über einen zentralen Helpdesk oder Betriebsteams verfügen, benötigen diese integrierten Zugriff auf die von diesen Komponenten bereitgestellten Daten.

Azure bietet verschiedene Protokollierungs- und Überwachungsdienste zum Nachverfolgen des Verhaltens von in Azure gehosteten Ressourcen. Die Governance und Steuerung von Workloads in Azure basiert nicht nur auf dem Sammeln von Protokolldaten, sondern auch auf der Möglichkeit, Aktionen auf der Grundlage von bestimmten gemeldeten Ereignissen auszulösen.

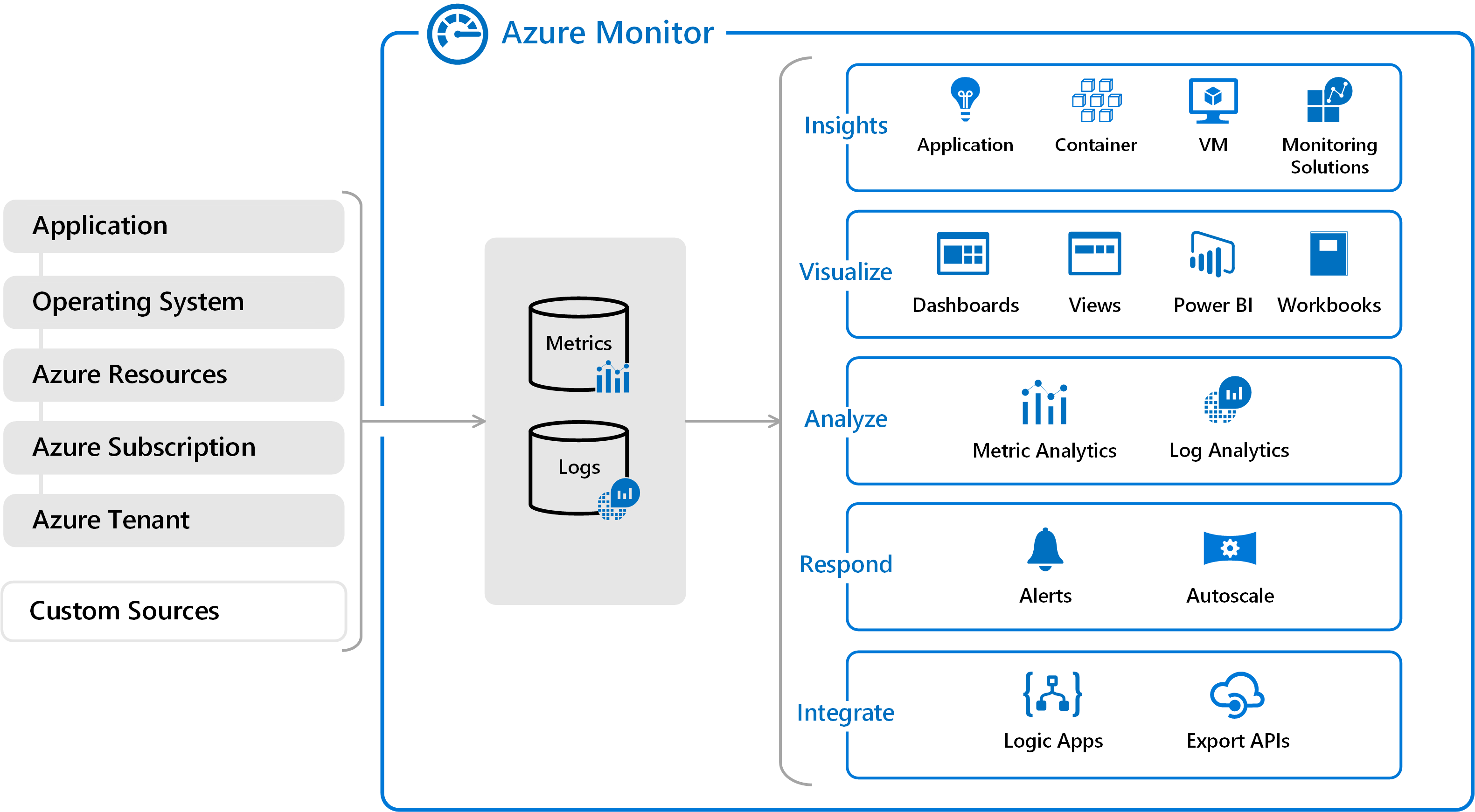

Azure Monitor: Azure umfasst mehrere Dienste, die eine bestimmte Rolle oder Aufgabe im Überwachungsbereich ausführen. Zusammen bieten diese Dienste eine umfassende Lösung für das Sammeln, Analysieren und Verarbeiten von systemgenerierten Protokollen aus Ihren Anwendungen und den zugrunde liegenden Azure-Ressourcen, die sie unterstützen. Sie können auch kritische lokale Ressourcen überwachen und so eine Hybridüberwachungsumgebung bilden. Voraussetzung der Entwicklung einer vollständigen Überwachungsstrategie für Ihre Anwendungen ist die Kenntnis der verfügbaren Tools und Daten.

In Azure Monitor gibt es zwei grundlegende Typen von Protokollen:

Metriken sind numerische Werte, die einen Aspekt eines Systems zu einem bestimmten Zeitpunkt beschreiben. Sie sind einfach strukturiert und in der Lage, Szenarien in Quasi-Echtzeit zu unterstützen. Für viele Azure-Ressourcen können die von Azure Monitor gesammelten Daten direkt auf ihrer Übersichtsseite im Azure-Portal angezeigt werden. Werfen Sie beispielsweise einen Blick auf einen beliebigen virtuellen Computer, und Sie sehen eine Reihe von Diagrammen mit Leistungsmetriken. Wählen Sie eines dieser Diagramme aus, um die Daten im Azure-Portal im Metrik-Explorer anzuzeigen. Hier können Sie die Werte mehrerer Metriken im zeitlichen Verlauf als Diagramm darstellen. Sie können die Diagramme interaktiv nutzen oder an ein Dashboard anheften, um sie mit anderen Visualisierungstools anzuzeigen.

Protokolle enthalten verschiedene Arten von Daten, die in Datensätzen mit unterschiedlichen Eigenschaften für jeden Typ organisiert sind. Ereignisse und Ablaufverfolgungen werden als Protokolle zusammen mit Leistungsdaten gespeichert; ihre Kombination zu Analysezwecken ist möglich. Die in Azure Monitor gesammelten Protokolldaten können mit Abfragen analysiert werden, die die gesammelten Daten schnell abrufen, konsolidieren und analysieren. Protokolle werden in Protokollanalysen gespeichert und abgefragt. Sie können Abfragen mit Protokollanalysen im Azure-Portal erstellen und testen und die Daten mit diesen Tools direkt analysieren oder Abfragen zur Verwendung mit Visualisierungen oder Warnungsregeln speichern.

Azure Monitor kann Daten aus vielen verschiedenen Quellen sammeln. Sie können sich das Überwachen von Daten für Ihre Anwendungen in Ebenen vorstellen, die von Ihrer Anwendung über ein Betriebssystem und die Dienste, auf denen sie aufbaut, bis zur Azure-Plattform selbst hinunterreichen. Azure Monitor sammelt Daten aus jeder der folgenden Schichten:

- Überwachungsdaten zur Anwendung: Daten zur Leistung und Funktionalität des von Ihnen geschriebenen Codes, unabhängig von seiner Plattform.

- Überwachungsdaten zum Gast-BS: Daten zum Betriebssystem, unter dem die Anwendung ausgeführt wird. Dieses Betriebssystem kann in Azure, einer anderen Cloud oder lokal ausgeführt werden.

- Überwachungsdaten zur Azure-Ressource: Daten zum Betrieb einer Azure-Ressource.

- Überwachungsdaten zum Azure-Abonnement: Daten zum Betrieb und zur Verwaltung eines Azure-Abonnements sowie zur Integrität und zum Betrieb von Azure selbst.

- Überwachungsdaten von Azure-Mandanten: Daten zum Vorgang in Azure-Diensten auf Mandantenebene, z. B. Microsoft Entra ID

- Benutzerdefinierte Quellen: Von lokalen Quellen gesendete Protokolle können ebenfalls eingeschlossen werden. Beispiele hierfür sind lokale Serverereignisse oder die Syslog-Ausgabe von Netzwerkgeräten.

Das Überwachen von Daten ist nur nützlich, wenn dadurch Ihre Einsicht in den Betrieb Ihrer Computerumgebung ausgeweitet wird. Azure Monitor enthält eine Reihe von Features und Tools, die wertvolle Einblicke in Ihre Anwendungen und weitere Ressourcen bieten, von denen sie abhängen. Überwachungslösungen und -features wie Application Insights und Azure Monitor für Container ermöglichen umfassende Einblicke in verschiedene Aspekte Ihrer Anwendung und bestimmter Azure-Dienste.

Überwachungslösungen in Azure Monitor sind Programmpakete, die Einblicke für eine bestimmte Anwendung oder einen bestimmten Dienst liefern. Dazu gehören die Logik zum Sammeln von Überwachungsdaten für die Anwendung oder den Dienst, Abfragen zur Analyse dieser Daten und Ansichten zur Visualisierung. Überwachungslösungen sind bei Microsoft und den Partnern von Microsoft verfügbar und bieten Überwachung für verschiedene Azure-Dienste und andere Anwendungen.

Bei einer derart umfangreichen Datensammlung ist es wichtig, proaktiv auf Ereignisse in Ihrer Umgebung zu reagieren, insbesondere wenn manuelle Abfragen allein nicht ausreichen. Warnungen in Azure Monitor informieren Sie proaktiv über kritische Zustände und versuchen potenziell, Korrekturmaßnahmen einzuleiten. Auf Metriken basierende Warnungsregeln bieten Warnungen in Quasi-Echtzeit basierend auf numerischen Werten. Auf Protokollen basierende Warnungsregeln ermöglichen die Nutzung einer übergreifenden komplexen Logik für Daten aus mehreren Quellen. Warnungsregeln in Azure Monitor verwenden Aktionsgruppen, die eindeutige Sätze von Empfängern und Aktionen enthalten, die gemeinsam von mehreren Regeln übergreifend verwendet werden können. Je nach Ihren Anforderungen können Aktionsgruppen Webhooks verwenden, die Warnungen auslösen, um externe Aktionen zu starten oder sich in Ihre ITSM-Tools zu integrieren.

Mit Azure Monitor können außerdem benutzerdefinierte Dashboards erstellt werden. Mit Azure Dashboards können Sie verschiedene Arten von Daten, einschließlich von Metriken und Protokollen, in einem einzelnen Bereich im Azure-Portal kombinieren. Sie können das Dashboard optional gemeinsam mit anderen Azure-Benutzern nutzen. Über die Ausgabe beliebiger Protokollabfragen oder Metrikdiagramme hinaus können Elemente im gesamten Azure Monitor einem Azure-Dashboard hinzugefügt werden. Beispielsweise können Sie ein Dashboard erstellen, das Kacheln kombiniert, die ein Diagramm der Metriken, eine Tabelle mit Aktivitätsprotokollen, ein Nutzungsdiagramm von Application Insights und die Ausgabe einer Protokollabfrage zeigen.

Schließlich stellen Azure Monitor-Daten eine native Quelle für Power BI dar. Power BI ist ein Business Analytics-Dienst, der interaktive Visualisierungen für verschiedene Datenquellen bereitstellt. Es handelt sich dabei auch um eine effektive Methode, um Daten anderen Personen innerhalb und außerhalb Ihrer Organisation zur Verfügung stellen. Sie können Power BI für den automatischen Import von Protokolldaten aus Azure Monitor konfigurieren, um diese zusätzlichen Visualisierungen zu nutzen.

Azure Network Watcher bietet Tools für die Überwachung, Diagnose und Anzeige von Metriken sowie die Aktivierung oder Deaktivierung von Protokollen für Ressourcen in einem virtuellen Netzwerk in Azure. Es ist ein breit gefächerter Dienst, der unter anderem die folgenden Funktionen bietet:

- Überwachen der Kommunikation zwischen einer VM und einem Endpunkt

- Anzeigen von Ressourcen in einem virtuellen Netzwerk mit den dazugehörigen Beziehungen

- Diagnostizieren von Problemen bei der Filterung des ein- und ausgehenden Netzwerkdatenverkehrs einer VM

- Diagnostizieren von Problemen beim Netzwerkrouting über eine VM

- Diagnostizieren ausgehender Verbindungen einer VM

- Erfassen von ein- und ausgehenden Paketen einer VM

- Diagnostizieren von Problemen mit einem Gateway eines virtuellen Netzwerks und Verbindungen

- Bestimmen von relativen Wartezeiten zwischen Azure-Regionen und Internetdienstanbietern

- Anzeigen der Sicherheitsregeln für eine Netzwerkschnittstelle

- Anzeigen von Netzwerkmetriken

- Analysieren des ein- und ausgehenden Datenverkehrs einer Netzwerksicherheitsgruppe

- Anzeigen von Diagnoseprotokollen für Netzwerkressourcen

Komponententyp: Arbeitsauslastungen

Workload-Komponenten befinden sich dort, wo auch Ihre tatsächlichen Anwendungen und Dienste sind. Dort verbringen Ihre Anwendungsentwicklungsteams die meiste Zeit.

Die Möglichkeiten für Workloads sind endlos. Im Folgenden finden Sie einige der möglichen Workload-Typen:

Interne Anwendungen: Branchenanwendungen sind für Unternehmensaktivitäten von entscheidender Bedeutung. Diese Anwendungen haben einige gemeinsame Merkmale:

- Interaktiv: Daten werden eingegeben, und Ergebnisse oder Berichte werden zurückgegeben.

- Datengesteuert: Branchenanwendungen sind datenintensiv und greifen häufig auf Datenbanken oder einen anderen Speicher zu.

- Integriert: Branchenanwendungen ermöglichen die Integration in andere Systeme innerhalb oder außerhalb der Organisation.

Websites für Kunden (im Internet oder intern): Die meisten Internetanwendungen sind Websites. Azure kann eine Website entweder über einen virtuellen IaaS-Computer oder über eine Azure-Web-Apps-Website (PaaS) ausführen. Azure-Web-Apps können in virtuelle Netzwerke integriert werden, um Web-Apps in einer Spoke-Netzwerkzone bereitzustellen. Für interne Websites muss kein öffentlicher Internetendpunkt verfügbar gemacht werden, weil auf die Ressourcen aus dem privaten virtuellen Netzwerk über Adressen zugegriffen werden kann, die nicht über das Internet geroutet werden können.

Big Data-Analyse: Wenn Daten auf größere Volumen hochskaliert werden müssen, ist die Leistung relationaler Datenbanken angesichts der extremen Auslastung oder aufgrund der unstrukturierten Daten möglicherweise schlecht. Azure HDInsight ist ein umfassender, verwalteter Open-Source-Analysedienst in der Cloud für Unternehmen. Sie können Open Source-Frameworks wie Hadoop, Apache Spark, Apache Hive, LLAP, Apache Kafka, Apache Storm, R und HDInsight verwenden. Dies unterstützt die Bereitstellung in einem standortbasierten virtuellen Netzwerk, das in einem Cluster in einem Spoke des virtuellen Rechenzentrums bereitgestellt werden kann.

Ereignisse und Messaging: Azure Event Hubs ist eine Big Data-Streamingplattform und ein Ereigniserfassungsdienst. Mit diesem Dienst können Millionen von Ereignissen pro Sekunde empfangen und verarbeitet werden. Er bietet niedrige Latenz und konfigurierbare Aufbewahrungszeiten, wodurch Sie riesige Datenmengen in Azure einspeisen und diese in verschiedenen Anwendungen lesen können. Ein einziger Datenstrom kann sowohl Echtzeit als auch batchbasierte Pipelines unterstützen.

Über Azure Service Bus können Sie einen zuverlässigen Cloudmessagingdienst zwischen Anwendungen und Diensten implementieren. Der Dienst bietet asynchrones Brokermessaging zwischen Client und Server, strukturiertes FIFO-Messaging (First In, First Out) sowie Funktionen zum Veröffentlichen und Abonnieren.

Diese Beispiele kratzen kaum an der Oberfläche der Arten von Workloads, die Sie in Azure erstellen können. Sie können alles erstellen, von einer einfachen Web- und SQL-App bis hin zu den neuesten Entwicklungen in den Bereichen IoT, Big Data, maschinelles Lernen, KI und vielen weiteren Bereichen.

Hochverfügbarkeit: mehrere virtuelle Rechenzentren

Bisher ging es in diesem Artikel in erster Linie um den Entwurf eines einzelnen virtuellen Rechenzentrums sowie die grundlegenden Komponenten und Architekturen, die zur Resilienz beitragen. Azure-Funktionen wie der Azure Load Balancer, NVAs, Verfügbarkeitszonen, Verfügbarkeitsgruppen, Skalierungsgruppen und weitere Funktionen ermöglichen es Ihnen, solide SLA-Ebenen in Ihre Produktionsdienste zu integrieren.

Da ein virtuelles Rechenzentrum normalerweise in einer einzelnen Region implementiert wird, kann es anfällig für Ausfälle sein, welche die gesamte Region betreffen. Kunden, die Hochverfügbarkeit benötigen, müssen die Dienste schützen, indem sie dasselbe Projekt in zwei (oder mehr) Implementierungen des virtuellen Rechenzentrums in unterschiedlichen Regionen bereitstellen.

Neben den Vorteilen in Bezug auf SLAs ist der Betrieb mehrerer virtueller Rechenzentren günstig in vielen gängigen Szenarien:

- Regionale oder globale Präsenz Ihrer Endbenutzer oder Partner

- Anforderungen hinsichtlich der Notfallwiederherstellung

- Mechanismus zum Umleiten von Datenverkehr zwischen Rechenzentren aus Auslastungs- oder Leistungsgründen

Regionale/globale Präsenz

Azure-Rechenzentren befinden sich in vielen Regionen auf der ganzen Welt. Bei der Auswahl mehrerer Azure-Rechenzentren sind zwei zusammenhängende Faktoren zu berücksichtigen: die geografische Entfernung und die Latenz. Bewerten Sie zum Optimieren der Benutzererfahrung die Entfernung zwischen den einzelnen virtuellen Rechenzentren und die Entfernung jedes virtuellen Rechenzentrums zu den Endbenutzern.

Eine Azure-Region, in der Ihr virtuelles Rechenzentrum gehostet wird, muss die gesetzlichen Anforderungen des Rechtsraums erfüllen, in dem Ihre Organisation tätig ist.

Notfallwiederherstellung

Der Entwurf eines Plans für die Notfallwiederherstellung richtet sich nach den Arten von Workloads und der Möglichkeit, den Zustand dieser Workloads zwischen unterschiedlichen Implementierungen des virtuellen Rechenzentrums zu synchronisieren. Die meisten Kunden wünschen sich im Idealfall einen schnellen Failovermechanismus. Hierfür ist ggf. eine Synchronisierung der Anwendungsdaten zwischen den Bereitstellungen erforderlich, die in mehreren Implementierungen des virtuellen Rechenzentrums ausgeführt werden. Beim Entwerfen von Plänen für die Notfallwiederherstellung sollte aber unbedingt berücksichtigt werden, dass die meisten Anwendungen empfindlich auf die Latenz reagieren, die durch diese Datensynchronisierung verursacht werden kann.

Für die Synchronisierung und Heartbeatüberwachung von Anwendungen in verschiedenen Implementierungen des virtuellen Rechenzentrums ist eine Kommunikation über das Netzwerk erforderlich. Mehrere Implementierungen des virtuellen Rechenzentrums in unterschiedlichen Regionen können wie folgt Weise verbunden werden:

- Hub-zu-Hub Kommunikation, die in Azure Virtual WAN-Hubs in Regionen im selben Virtual WAN integriert ist.

- Über Peering virtueller Netzwerke können Hubs regionsübergreifend verbunden werden.

- Privates ExpressRoute-Peering, wenn die Hubs jeder Implementierung des virtuellen Rechenzentrums mit derselben ExpressRoute-Leitung verbunden sind.

- Mehrere ExpressRoute-Verbindungen, die über Ihren firmeneigenen Backbone und Ihre Implementierungen der virtuellen Rechenzentren mit den ExpressRoute-Leitungen verbunden sind.

- Site-to-Site-VPN-Verbindungen zwischen der Hubzone Ihrer Implementierungen virtueller Rechenzentren in jeder Azure-Region.

Normalerweise stellen Virtual WAN-Hubs, das Peering virtueller Netzwerke oder ExpressRoute-Verbindungen aufgrund ihrer höheren Bandbreite und konsistenten Latenzebenen bei der Übertragung über den Microsoft-Backbone die bevorzugte Art von Netzwerkkonnektivität dar.

Führen Sie Netzwerkqualifizierungstests durch, um die Latenz und Bandbreite dieser Verbindungen zu überprüfen, und entscheiden Sie dann anhand des Ergebnisses, ob eine synchrone oder asynchrone Datenreplikation geeignet ist. Es ist auch wichtig, diese Ergebnisse hinsichtlich des optimalen RTO-Werts (Recovery Time Objective) zu bewerten.

Notfallwiederherstellung: Umleiten von Datenverkehr aus einer Region in eine andere

Sowohl Azure Traffic Manager als auch Azure Front Door überprüfen in regelmäßigen Abständen die Dienstintegrität von lauschenden Endpunkten in verschiedenen Implementierungen von virtuellen Rechenzentren. Wenn diese Endpunkte ausfallen, leiten Azure Traffic Manager und Azure Front Door automatisch an das nächstgelegene virtuelle Rechenzentrum weiter. Traffic Manager leitet Benutzer anhand von Echtzeit-Benutzermessungen und DNS an das nächste (oder während eines Ausfalls an das nächstgelegene) Rechenzentrum weiter. Azure Front Door ist ein Reverseproxy auf mehr als 100 Microsoft-Backbone-Edge-Sites und leitet Benutzer mit Anycast an den nächstgelegenen überwachenden Endpunkt weiter.

Zusammenfassung

Der Ansatz des virtuellen Rechenzentrums für die Migration besteht darin, eine skalierbare Architektur zu erstellen, die die Verwendung von Azure-Ressourcen optimiert, die Kosten senkt und die Steuerung des Systems vereinfacht. Das virtuelle Rechenzentrum basiert im Allgemeinen auf Hub-and-Spoke-Netzwerktopologien (wobei entweder das Peering virtueller Netzwerke oder Virtual WAN-Hubs verwendet werden). Gemeinsame Dienste werden im Hub bereitgestellt, während spezifische Anwendungen und Workloads in den Spokes bereitgestellt werden. Darüber hinaus wird im virtuellen Rechenzentrum auch die Struktur von Unternehmensrollen berücksichtigt, indem unterschiedliche Abteilungen, z. B. zentrale IT-Abteilung, DevOps sowie Betrieb und Wartung zusammenarbeiten, während sie ihre jeweiligen Rollen ausfüllen. Das virtuelle Rechenzentrum unterstützt das Migrieren vorhandener lokaler Workloads in Azure, es bietet jedoch auch viele Vorteile für cloudnative Bereitstellungen.

References

Erfahren Sie mehr über die in diesem Dokument erläuterten Azure-Funktionen.

Netzwerkfunktionen

Virtuelle Azure-Netzwerke

Netzwerksicherheitsgruppen

Dienstendpunkte

Private Link

Benutzerdefinierte Routen

Virtuelle Netzwerkgeräte:

Öffentliche IP-Adressen

Azure DNS

Identität

Microsoft Entra ID

Multi-Faktor-Authentifizierung in Microsoft Entra

Rollenbasierte Zugriffssteuerung (Azure)

Integrierte Azure-Rollen

Überwachung

Network Watcher

Azure Monitor

Log Analytics

Nächste Schritte

- Erfahren Sie mehr über das Peering virtueller Netzwerke, die Kerntechnologie von Hub-and-Spoke-Topologien.

- Implementieren Sie Microsoft Entra-ID, um die rollenbasierte Zugriffssteuerung von Azure zu verwenden.

- Entwickeln Sie ein Modell für die Abonnement- und Ressourcenverwaltung mit rollenbasierter Zugriffssteuerung in Azure, welches der Struktur, den Anforderungen und Richtlinien Ihrer Organisation gerecht wird. Die wichtigste Aktivität ist die Planung. Analysieren Sie, wie sich Umstrukturierungen, Fusionen, neue Produktlinien und andere Aspekte auf Ihre ursprünglichen Modelle auswirken, um deren Skalierbarkeit hinsichtlich künftiger Anforderung und des Wachstums sicherzustellen.