Eventos

31 mar, 23 - 2 abr, 23

Evento de aprendizaje de Fabric, Power BI y SQL más grande. 31 de marzo – 2 de abril. Use el código FABINSIDER para ahorrar $400.

Regístrate hoyEste explorador ya no se admite.

Actualice a Microsoft Edge para aprovechar las características y actualizaciones de seguridad más recientes, y disponer de soporte técnico.

SE APLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Sugerencia

Pruebe Data Factory en Microsoft Fabric, una solución de análisis todo en uno para empresas. Microsoft Fabric abarca todo, desde el movimiento de datos hasta la ciencia de datos, el análisis en tiempo real, la inteligencia empresarial y los informes. Obtenga información sobre cómo iniciar una nueva evaluación gratuita.

Microsoft Fabric Lakehouse es una plataforma de arquitectura de datos para almacenar, administrar y analizar datos estructurados y no estructurados en una sola ubicación. Para lograr un acceso sin problemas a los datos en todos los motores de proceso de Microsoft Fabric, consulte Tablas de Lakehouse y Delta para obtener más información. De forma predeterminada, los datos se escriben en la tabla Lakehouse en V-Order y puede ir a optimización de tablas de Delta Lake y V-Order para obtener más información.

En este artículo se describe cómo usar Actividad de copia para copiar datos a y desde Microsoft Fabric Lakehouse y cómo usar Data Flow para transformar datos en Microsoft Fabric Lakehouse. Para obtener más información, lea el artículo de introducción para Azure Data Factory o Azure Synapse Analytics.

Este conector de Microsoft Fabric Lakehouse es compatible con las funcionalidades siguientes:

| Funcionalidades admitidas | IR |

|---|---|

| Actividad de copia (origen/receptor) | ① ② |

| Flujo de datos de asignación (origen/receptor) | ① |

| Actividad de búsqueda | ① ② |

| Actividad GetMetadata | ① ② |

| Actividad de eliminación | ① ② |

① Azure Integration Runtime ② Entorno de ejecución de integración autohospedado

Para realizar la actividad de copia con una canalización, puede usar una de los siguientes herramientas o SDK:

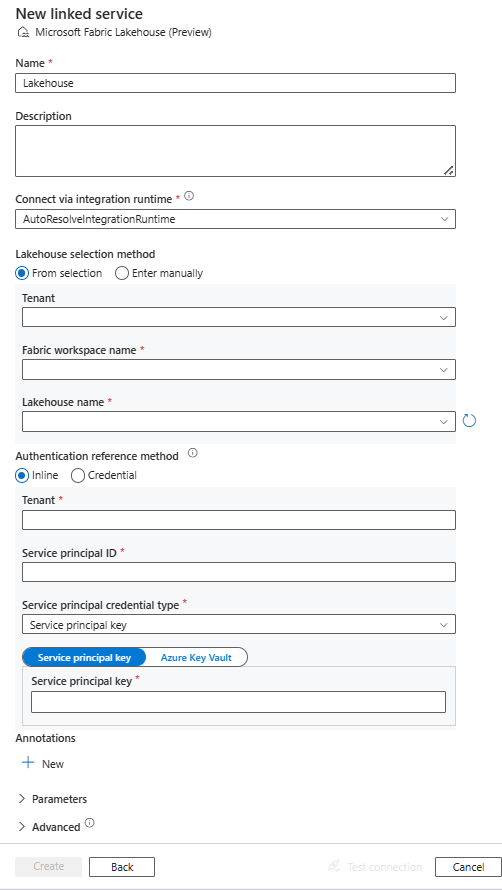

Siga estos pasos para crear un servicio vinculado de Microsoft Fabric Lakehouse en la interfaz de usuario de Azure Portal.

Vaya a la pestaña Administrar de su área de trabajo de Azure Data Factory o Synapse, y seleccione Servicios vinculados; a continuación, seleccione Nuevo:

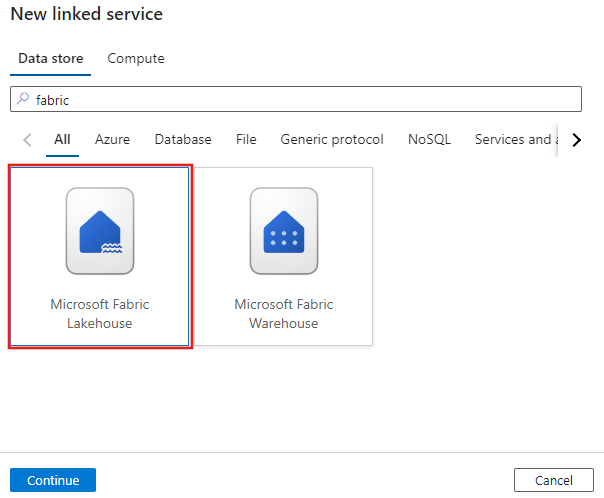

Busque Microsoft Fabric Lakehouse y seleccione el conector.

Configure los detalles del servicio, pruebe la conexión y cree el nuevo servicio vinculado.

En las secciones siguientes se proporcionan detalles sobre las propiedades que se usan para definir entidades de Data Factory específicas para Microsoft Fabric Lakehouse.

Este conector de Microsoft Fabric Lakehouse admite los siguientes tipos de autenticación. Consulte las secciones correspondientes para más información:

Antes de usar la autenticación de entidad de servicio, siga estos pasos.

Registro de una aplicación con la plataforma de identidad de Microsoft y adición de un secreto de cliente. Después, anote estos valores; los usará para definir el servicio vinculado:

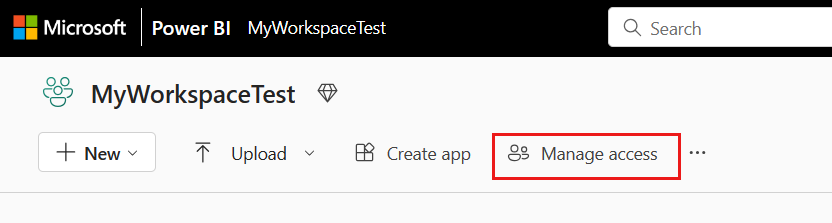

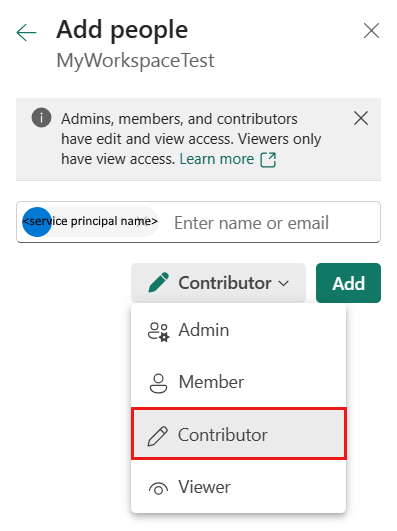

Conceda a la entidad de servicio al menos el rol de colaborador en el área de trabajo de Microsoft Fabric. Siga estos pasos:

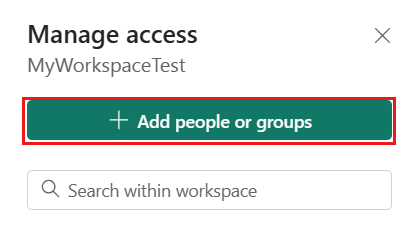

Vaya al área de trabajo de Microsoft Fabric y seleccione Administrar acceso en la barra superior. Luego seleccione Agregar personas o grupos.

En el panel Agregar personas, escriba el nombre de la entidad de servicio y seleccione la entidad de servicio en la lista desplegable.

Nota

La entidad de servicio no aparecerá en la lista Agregar contactos a menos que la configuración del inquilino de Power BI habilite el acceso a las entidades de servicio a las API de Fabric.

Especifique el rol como Colaborador o superior (Administrador, Miembro) y seleccione Agregar.

La entidad de servicio se muestra en el panel Administrar acceso.

Estas propiedades son compatibles con el servicio vinculado:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type debe establecerse en Lakehouse. | Sí |

| workspaceId | Identificador del área de trabajo de Microsoft Fabric. | Sí |

| artifactId | Identificador de objeto de Microsoft Fabric Lakehouse. | Sí |

| tenant | Especifique la información del inquilino (nombre de dominio o identificador de inquilino) en el que reside la aplicación. Para recuperarlo, mantenga el puntero del mouse en la esquina superior derecha de Azure Portal. | Sí |

| servicePrincipalId | Especifique el id. de cliente de la aplicación. | Sí |

| servicePrincipalCredentialType | Tipo de credencial que se usará para la autenticación de entidades de servicio. Los valores válidos son ServicePrincipalKey y ServicePrincipalCert. | Sí |

| servicePrincipalCredential | Credencial de entidad de servicio. Al usar ServicePrincipalKey como tipo de credenciales, especifique el valor del secreto de cliente de la aplicación. Marque este campo como SecureString para almacenarlo de forma segura, o bien haga referencia a un secreto almacenado en Azure Key Vault. Cuando use ServicePrincipalCert como credencial, haga referencia a un certificado en Azure Key Vault y asegúrese de que el tipo de contenido del certificado sea PKCS #12. |

Sí |

| connectVia | El entorno de ejecución de integración que se usará para conectarse al almacén de datos. Si el almacén de datos está en una red privada, se puede usar Azure Integration Runtime o un entorno de ejecución de integración autohospedado. Si no se especifica, se usa el valor predeterminado de Azure Integration Runtime. | No |

Ejemplo: uso de la autenticación de claves de entidad de servicio

También puede almacenar la clave de entidad de servicio en Azure Key Vault.

{

"name": "MicrosoftFabricLakehouseLinkedService",

"properties": {

"type": "Lakehouse",

"typeProperties": {

"workspaceId": "<Microsoft Fabric workspace ID>",

"artifactId": "<Microsoft Fabric Lakehouse object ID>",

"tenant": "<tenant info, e.g. microsoft.onmicrosoft.com>",

"servicePrincipalId": "<service principal id>",

"servicePrincipalCredentialType": "ServicePrincipalKey",

"servicePrincipalCredential": {

"type": "SecureString",

"value": "<service principal key>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

El conector de Microsoft Fabric Lakehouse admite dos tipos de conjuntos de datos, que son el conjunto de datos de Microsoft Fabric Lakehouse Files y el conjunto de datos de Microsoft Fabric Lakehouse Table. Consulte las secciones correspondientes para más información.

Si desea ver una lista completa de las secciones y propiedades disponibles para definir conjuntos de datos, consulte Conjuntos de datos.

El conector de Microsoft Fabric Lakehouse admite los siguientes formatos de archivo. Consulte los artículos para conocer la configuración basada en el formato.

Las propiedades siguientes se admiten en la configuración de location en el conjunto de datos de Microsoft Fabric Lakehouse Files basado en formato:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type de location del conjunto de datos se debe establecer en LakehouseLocation. |

Sí |

| folderPath | Ruta de acceso a una carpeta. Si quiere usar un carácter comodín para filtrar carpetas, omita este valor y especifíquelo en la configuración del origen de actividad. | No |

| fileName | Nombre de archivo en la propiedad folderPath indicada. Si quiere usar un carácter comodín para filtrar archivos, omita este valor y especifíquelo en la configuración del origen de actividad. | No |

Ejemplo:

{

"name": "DelimitedTextDataset",

"properties": {

"type": "DelimitedText",

"linkedServiceName": {

"referenceName": "<Microsoft Fabric Lakehouse linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"location": {

"type": "LakehouseLocation",

"fileName": "<file name>",

"folderPath": "<folder name>"

},

"columnDelimiter": ",",

"compressionCodec": "gzip",

"escapeChar": "\\",

"firstRowAsHeader": true,

"quoteChar": "\""

},

"schema": [ < physical schema, optional, auto retrieved during authoring > ]

}

}

Se admiten las siguientes propiedades para el conjunto de datos de Microsoft Fabric Lakehouse Table:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type del conjunto de datos se debe establecer en LakehouseTable. | Sí |

| esquema | Nombre del esquema. Si no se especifica, el valor predeterminado es dbo. |

No |

| table | El nombre de la tabla. El nombre de la tabla debe tener al menos un carácter, sin "/" ni "\", sin punto al final y sin espacios al principio ni al final. | Sí |

Ejemplo:

{

"name": "LakehouseTableDataset",

"properties": {

"type": "LakehouseTable",

"linkedServiceName": {

"referenceName": "<Microsoft Fabric Lakehouse linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"schema": "<schema_name>",

"table": "<table_name>"

},

"schema": [< physical schema, optional, retrievable during authoring >]

}

}

Las propiedades de la actividad de copia para el conjunto de datos de Microsoft Fabric Lakehouse Files y el conjunto de datos de Microsoft Fabric Lakehouse Table son diferentes. Consulte las secciones correspondientes para más información.

Para ver una lista completa de las secciones y propiedades disponibles para definir actividades, consulte los artículos sobre configuraciones de actividades de copia y canalizaciones y actividades.

Para usar el tipo de conjunto de datos de Microsoft Fabric Lakehouse Files como origen o receptor en Actividad de copia, vaya a las secciones siguientes para ver las configuraciones detalladas.

El conector de Microsoft Fabric Lakehouse admite los siguientes formatos de archivo. Consulte los artículos para conocer la configuración basada en el formato.

Tiene varias opciones para copiar datos desde Microsoft Fabric Lakehouse mediante el conjunto de datos de Microsoft Fabric Lakehouse Files:

wildcardFolderPath y wildcardFileName).fileListPath).Las propiedades siguientes se encuentran en la configuración de storeSettings en el origen de copia basado en formato al usar el conjunto de datos de Microsoft Fabric Lakehouse Files:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type en storeSettings debe establecerse como LakehouseReadSettings. |

Sí |

| Buscar los archivos que se van a copiar: | ||

| OPCIÓN 1: ruta de acceso estática |

Copia de la ruta de acceso de archivo o carpeta especificada en el conjunto de datos. Si quiere copiar todos los archivos de una carpeta, especifique también wildcardFileName como *. |

|

| OPCIÓN 2: carácter comodín - wildcardFolderPath |

Ruta de acceso de carpeta con caracteres comodín para filtrar las carpetas de origen. Los caracteres comodín permitidos son: * (coincide con cero o más caracteres) y ? (coincide con cero o carácter individual); use ^ para el escape si el nombre real de la carpeta tiene un carácter comodín o este carácter de escape dentro. Ver más ejemplos en Ejemplos de filtros de carpetas y archivos. |

No |

| OPCIÓN 2: carácter comodín - wildcardFileName |

Nombre de archivo con caracteres comodín en la propiedad folderPath o wildcardFolderPath indicada para filtrar los archivos de origen. Los caracteres comodín permitidos son: * (coincide con cero o más caracteres) y ? (coincide con cero o carácter individual); use ^ para el escape si el nombre real del archivo tiene un carácter comodín o este carácter de escape dentro. Ver más ejemplos en Ejemplos de filtros de carpetas y archivos. |

Sí |

| OPCIÓN 3: una lista de archivos - fileListPath |

Indica que se copie un conjunto de archivos determinado. Apunte a un archivo de texto que incluya una lista de los archivos que quiere copiar, con un archivo por línea, que sea la ruta de acceso relativa a la ruta de acceso configurada en el conjunto de datos. Al utilizar esta opción, no especifique el nombre de archivo en el conjunto de datos. Ver más ejemplos en Ejemplos de lista de archivos. |

No |

| Configuración adicional: | ||

| recursive | Indica si los datos se leen de forma recursiva de las subcarpetas o solo de la carpeta especificada. Cuando recursive se establece en true y el receptor es un almacén basado en archivos, no se crea una carpeta o una subcarpeta vacía en el receptor. Los valores permitidos son: True (valor predeterminado) y False. Esta propiedad no se aplica al configurar fileListPath. |

No |

| deleteFilesAfterCompletion | Indica si los archivos binarios se eliminarán del almacén de origen después de moverse correctamente al almacén de destino. Cada archivo se elimina individualmente, de modo que cuando se produzca un error en la actividad de copia, verá que algunos archivos ya se habrán copiado al destino y se habrán eliminado del origen, mientras que otros seguirán aún en el almacén de origen. Esta propiedad solo es válida en el escenario de copia de archivos binarios. El valor predeterminado es false. |

No |

| modifiedDatetimeStart | Filtro de archivos basado en el atributo: Última modificación. Los archivos se seleccionarán si la hora de la última modificación es mayor o igual que modifiedDatetimeStart y menor que modifiedDatetimeEnd. La hora se aplica a la zona horaria UTC en el formato "2018-12-01T05:00:00Z". Las propiedades pueden ser NULL, lo que significa que no se aplica ningún filtro de atributo de archivo al conjunto de datos. Cuando modifiedDatetimeStart tiene el valor de fecha y hora, pero modifiedDatetimeEnd es NULL, significa que se seleccionarán los archivos cuyo último atributo modificado sea mayor o igual que el valor de fecha y hora. Cuando modifiedDatetimeEnd tiene el valor de fecha y hora, pero modifiedDatetimeStart es NULL, significa que se seleccionarán los archivos cuyo último atributo modificado sea inferior al valor de fecha y hora.Esta propiedad no se aplica al configurar fileListPath. |

No |

| modifiedDatetimeEnd | Igual que el anterior. | No |

| enablePartitionDiscovery | En el caso de archivos con particiones, especifique si quiere analizar las particiones de la ruta de acceso del archivo y agregarlas como otras columnas de origen. Los valores permitidos son false (valor predeterminado) y true. |

No |

| partitionRootPath | Cuando esté habilitada la detección de particiones, especifique la ruta de acceso raíz absoluta para poder leer las carpetas con particiones como columnas de datos. Si no se especifica, de manera predeterminada, - Cuando se usa la ruta de acceso de archivo en un conjunto de datos o una lista de archivos del origen, la ruta de acceso raíz de la partición es la ruta de acceso configurada en el conjunto de datos. - Cuando se usa el filtro de carpeta con caracteres comodín, la ruta de acceso raíz de la partición es la subruta antes del primer carácter comodín. Por ejemplo, supongamos que configura la ruta de acceso en el conjunto de datos como "root/folder/year=2020/month=08/day=27": - Si especifica la ruta de acceso raíz de la partición como "root/folder/year=2020", la actividad de copia genera dos columnas más, month y day, con el valor "08" y "27", respectivamente, además de las columnas de los archivos.- Si no se especifica la ruta de acceso raíz de la partición, no se genera ninguna columna adicional. |

No |

| maxConcurrentConnections | Número máximo de conexiones simultáneas establecidas en el almacén de datos durante la ejecución de la actividad. Especifique un valor solo cuando quiera limitar las conexiones simultáneas. | No |

Ejemplo:

"activities": [

{

"name": "CopyFromLakehouseFiles",

"type": "Copy",

"inputs": [

{

"referenceName": "<Delimited text input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "DelimitedTextSource",

"storeSettings": {

"type": "LakehouseReadSettings",

"recursive": true,

"enablePartitionDiscovery": false

},

"formatSettings": {

"type": "DelimitedTextReadSettings"

}

},

"sink": {

"type": "<sink type>"

}

}

}

]

El conector de Microsoft Fabric Lakehouse admite los siguientes formatos de archivo. Consulte los artículos para conocer la configuración basada en el formato.

Las propiedades siguientes se encuentran en la configuración de storeSettings en el receptor de copia basado en formato al usar el conjunto de datos de Microsoft Fabric Lakehouse Files:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type en storeSettings se debe establecer en LakehouseWriteSettings. |

Sí |

| copyBehavior | Define el comportamiento de copia cuando el origen son archivos de un almacén de datos basados en archivos. Los valores permitidos son: - PreserveHierarchy (valor predeterminado): conserva la jerarquía de archivos en la carpeta de destino. La ruta de acceso relativa del archivo de origen a la carpeta de origen es idéntica que la ruta de acceso relativa del archivo de destino a la carpeta de destino. - FlattenHierarchy: todos los archivos de la carpeta de origen están en el primer nivel de la carpeta de destino. Los archivos de destino tienen nombres generados automáticamente. - MergeFiles: combina todos los archivos de la carpeta de origen en un archivo. Si se especifica el nombre del archivo, el nombre de archivo combinado es el nombre especificado. De lo contrario, es un nombre de archivo generado automáticamente. |

No |

| blockSizeInMB | Especifique el tamaño de bloque en MB que se usa para escribir datos en Microsoft Fabric Lakehouse. Más información sobre los blobs en bloques. El valor permitido está entre 4 y 100 MB. De forma predeterminada, ADF determina automáticamente el tamaño de bloque en función del tipo y los datos del almacén de origen. En el caso de una copia no binaria en Microsoft Fabric Lakehouse, el tamaño de bloque predeterminado es de 100 MB, con el fin de ajustarse como máximo a aproximadamente 4,75 TB de datos. Este tamaño puede no ser óptimo cuando los datos no son grandes, en especial cuando se usa el entorno de ejecución de integración autohospedado con una red deficiente, lo que produce un problema de tiempo de espera de operación o rendimiento. Puede especificar explícitamente un tamaño de bloque, al tiempo que se garantiza que blockSizeInMB*50000 es lo suficientemente grande como para almacenar los datos; de lo contrario, se producirá un error en la ejecución de la actividad de copia. |

No |

| maxConcurrentConnections | Número máximo de conexiones simultáneas establecidas en el almacén de datos durante la ejecución de la actividad. Especifique un valor solo cuando quiera limitar las conexiones simultáneas. | No |

| metadata | Establezca metadatos personalizados al realizar la copia en el receptor. Cada objeto de la matriz metadata representa una columna adicional.

name define el nombre de la clave de metadatos y value indica el valor de los datos de esa clave. Si se usa la característica para conservar atributos, los metadatos especificados se unirán a los metadatos del archivo de origen o los sobrescribirán.Los valores permitidos de los datos son: - $$LASTMODIFIED: una variable reservada indica que se debe almacenar la hora de la última modificación de los archivos de origen. Se aplica solo al origen basado en archivos con formato binario.: expresión - Valor estático |

No |

Ejemplo:

"activities": [

{

"name": "CopyToLakehouseFiles",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<Parquet output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "ParquetSink",

"storeSettings": {

"type": "LakehouseWriteSettings",

"copyBehavior": "PreserveHierarchy",

"metadata": [

{

"name": "testKey1",

"value": "value1"

},

{

"name": "testKey2",

"value": "value2"

}

]

},

"formatSettings": {

"type": "ParquetWriteSettings"

}

}

}

}

]

Esta sección describe el comportamiento resultante de la ruta de acceso de la carpeta y el nombre de archivo con los filtros de carácter comodín.

| folderPath | fileName | recursive | Resultado de estructura de carpeta de origen y filtro (se recuperan los archivos en negrita) |

|---|---|---|---|

Folder* |

(Vacío, usar el valor predeterminado) | false | FolderA File1.csv File2.json Subfolder1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Folder* |

(Vacío, usar el valor predeterminado) | true | FolderA File1.csv File2.json Subfolder1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Folder* |

*.csv |

false | FolderA File1.csv File2.json Subfolder1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Folder* |

*.csv |

true | FolderA File1.csv File2.json Subfolder1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

En esta sección se describe el comportamiento resultante de usar la ruta de acceso de la lista de archivos en el origen de la actividad de copia.

Suponga que tiene la siguiente estructura de carpetas de origen y quiere copiar los archivos en negrita:

| Estructura de origen de ejemplo | Contenido de FileListToCopy.txt | Configuración de ADF |

|---|---|---|

| fileSystem FolderA File1.csv File2.json Subfolder1 File3.csv File4.json File5.csv Metadatos FileListToCopy.txt |

File1.csv Subfolder1/File3.csv Subfolder1/File5.csv |

En el conjunto de datos: - Ruta de acceso a la carpeta: FolderAEn origen de la actividad de copia: - Ruta de acceso de la lista de archivos: Metadata/FileListToCopy.txt La ruta de acceso de la lista de archivos apunta a un archivo de texto en el mismo almacén de datos que incluye una lista de archivos que se quiere copiar, un archivo por línea con la ruta de acceso relativa a la ruta de acceso configurada en el conjunto de datos. |

En esta sección se describe el comportamiento resultante de la operación de copia para diferentes combinaciones de valores recursive y copyBehavior.

| recursive | copyBehavior | Estructura de carpetas de origen | Destino resultante |

|---|---|---|---|

| true | preserveHierarchy | Folder1 Archivo1 Archivo2 Subfolder1 File3 File4 File5 |

El destino Folder1 se crea con la misma estructura que el origen: Folder1 Archivo1 Archivo2 Subfolder1 File3 File4 File5 |

| true | flattenHierarchy | Folder1 Archivo1 Archivo2 Subfolder1 File3 File4 File5 |

La carpeta de destino Folder1 se crea con la estructura siguiente: Folder1 nombre de archivo generado automáticamente para File1 nombre de archivo generado automáticamente para File2 nombre de archivo generado automáticamente para File3 nombre de archivo generado automáticamente para File4 nombre de archivo generado automáticamente para File5 |

| true | mergeFiles | Folder1 Archivo1 Archivo2 Subfolder1 File3 File4 File5 |

La carpeta de destino Folder1 se crea con la estructura siguiente: Folder1 El contenido de File1 + File2 + File3 + File4 + File5 se combina en un archivo con un nombre de archivo generado automáticamente. |

| false | preserveHierarchy | Folder1 Archivo1 Archivo2 Subfolder1 File3 File4 File5 |

La carpeta de destino Folder1 se crea con la estructura siguiente: Folder1 Archivo1 Archivo2 No se selecciona la subcarpeta Subfolder1, con File3, File4 y File5. |

| false | flattenHierarchy | Folder1 Archivo1 Archivo2 Subfolder1 File3 File4 File5 |

La carpeta de destino Folder1 se crea con la estructura siguiente: Folder1 nombre de archivo generado automáticamente para File1 nombre de archivo generado automáticamente para File2 No se selecciona la subcarpeta Subfolder1, con File3, File4 y File5. |

| false | mergeFiles | Folder1 Archivo1 Archivo2 Subfolder1 File3 File4 File5 |

La carpeta de destino Folder1 se crea con la estructura siguiente: Folder1 El contenido de File1 + File2 se combina en un archivo con un nombre de archivo generado automáticamente. nombre de archivo generado automáticamente para File1 No se selecciona la subcarpeta Subfolder1, con File3, File4 y File5. |

Para usar el conjunto de datos de Microsoft Fabric Lakehouse Table como un conjunto de datos de origen o receptor en Actividad de copia, vaya a las secciones siguientes para ver las configuraciones detalladas.

Para copiar datos de Microsoft Fabric Lakehouse con el conjunto de datos de Microsoft Fabric Lakehouse Table, establezca la propiedad type en el origen de la actividad de copia en LakehouseTableSource. En la sección source de la actividad de copia se admiten las siguientes propiedades:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type del origen de la actividad de copia tiene que establecerse en LakehouseTableSource. | Sí |

| timestampAsOf | La marca de tiempo para consultar una instantánea más antigua. | No |

| versionAsOf | La versión para consultar una instantánea más antigua. | No |

Ejemplo:

"activities":[

{

"name": "CopyFromLakehouseTable",

"type": "Copy",

"inputs": [

{

"referenceName": "<Microsoft Fabric Lakehouse Table input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "LakehouseTableSource",

"timestampAsOf": "2023-09-23T00:00:00.000Z",

"versionAsOf": 2

},

"sink": {

"type": "<sink type>"

}

}

}

]

Para copiar datos a Microsoft Fabric Lakehouse con el conjunto de datos de Microsoft Fabric Lakehouse Table, establezca la propiedad type en el receptor de la actividad de copia en LakehouseTableSink. En la sección sink de la actividad de copia se admiten las siguientes propiedades:

| Propiedad | Descripción | Obligatorio |

|---|---|---|

| type | La propiedad type del origen de la actividad de copia tiene que establecerse en LakehouseTableSink. | Sí |

Nota

Los datos se escriben en la tabla Lakehouse en V-Order de forma predeterminada. Para obtener más información, vaya a Optimización de la tabla de Delta Lake y V-Order.

Ejemplo:

"activities":[

{

"name": "CopyToLakehouseTable",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<Microsoft Fabric Lakehouse Table output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "LakehouseTableSink",

"tableActionOption ": "Append"

}

}

}

]

Al transformar datos en el flujo de datos de asignación, puede leer y escribir en archivos o tablas en Microsoft Fabric Lakehouse. Consulte las secciones correspondientes para más información.

Para más información, vea la transformación de origen y la transformación de receptor en los flujos de datos de asignación.

Para usar el conjunto de datos de Microsoft Fabric Lakehouse Files como un conjunto de datos de origen o receptor en el flujo de datos de asignación, vaya a las secciones siguientes para ver las configuraciones detalladas.

El conector de Microsoft Fabric Lakehouse admite los siguientes formatos de archivo. Consulte los artículos para conocer la configuración basada en el formato.

Para usar el conector basado en archivos Fabric Lakehouse en el tipo de conjunto de datos insertado, debe elegir el tipo de conjunto de datos insertado adecuado para los datos. Puede usar DelimitedText, Avro, JSON, ORC o Parquet en función del formato de datos.

Para usar el conjunto de datos de Microsoft Fabric Lakehouse Table como un conjunto de datos de origen o receptor en el flujo de datos de asignación, vaya a las secciones siguientes para ver las configuraciones detalladas.

No hay propiedades configurables en opciones de origen.

Nota

La compatibilidad de CDC con el origen de la tabla de Lakehouse no está disponible actualmente.

En la sección sink de los flujos de datos de asignación se admiten las siguientes propiedades:

| Nombre | Descripción | Obligatorio | Valores permitidos | Propiedad de script de flujo de datos |

|---|---|---|---|---|

| Método de actualización | Al seleccionar solo "Permitir inserción" o al escribir en una nueva tabla delta, el destino recibe todas las filas entrantes independientemente de las directivas de fila establecidas. Si los datos contienen filas de otras directivas de fila, deben excluirse mediante una transformación de filtro anterior. Cuando se seleccionan todos los métodos Update, se realiza una combinación, donde las filas se insertan, eliminan o actualizan según las directivas de fila establecidas mediante una transformación de Alteración de fila anterior. |

sí |

true o false |

insertable deletable upsertable updateable |

| Escritura optimizada | Logre un mayor rendimiento de la operación de escritura mediante la optimización del orden aleatorio interno en los ejecutores de Spark. Como resultado, puede que observe menos particiones y archivos de un tamaño mayor. | no |

true o false |

optimizedWrite: true |

| Compactación automática | Una vez completada la operación de escritura, Spark ejecutará automáticamente el comando OPTIMIZE para volver a organizar los datos, lo que dará lugar a más particiones si es necesario, para mejorar el rendimiento de la lectura en el futuro. |

no |

true o false |

autoCompact: true |

| Combinar esquema | La opción Combinar esquema permite la evolución del esquema, es decir, cualquier columna que esté presente en el flujo entrante actual pero no en la tabla Delta de destino se agregará automáticamente a su esquema. Esta opción se admite en todos los métodos de actualización. | no |

true o false |

mergeSchema: true |

Ejemplo: receptor de Microsoft Fabric Lakehouse Table

sink(allowSchemaDrift: true,

validateSchema: false,

input(

CustomerID as string,

NameStyle as string,

Title as string,

FirstName as string,

MiddleName as string,

LastName as string,

Suffix as string,

CompanyName as string,

SalesPerson as string,

EmailAddress as string,

Phone as string,

PasswordHash as string,

PasswordSalt as string,

rowguid as string,

ModifiedDate as string

),

deletable:false,

insertable:true,

updateable:false,

upsertable:false,

optimizedWrite: true,

mergeSchema: true,

autoCompact: true,

skipDuplicateMapInputs: true,

skipDuplicateMapOutputs: true) ~> CustomerTable

En el caso del conector basado en tablas de Fabric Lakehouse en el tipo de conjunto de datos insertado, solo es necesario usar Delta como tipo de conjunto de datos. Esto le permitirá leer y escribir datos de tablas de Fabric Lakehouse.

Para obtener información detallada sobre las propiedades, consulte Actividad de búsqueda.

Para información detallada sobre las propiedades, consulte Actividad de obtención de metadatos.

Para información detallada sobre las propiedades, consulte Actividad de eliminación.

Para obtener una lista de almacenes de datos que la actividad de copia admite como orígenes y receptores, vea Almacenes de datos que se admiten.

Eventos

31 mar, 23 - 2 abr, 23

Evento de aprendizaje de Fabric, Power BI y SQL más grande. 31 de marzo – 2 de abril. Use el código FABINSIDER para ahorrar $400.

Regístrate hoyCursos

Ruta de aprendizaje

Implementación de una instancia de Lakehouse con Microsoft Fabric DP-601T00 - Training

En esta ruta de aprendizaje se presentan los componentes fundamentales de la implementación de un almacén de lago de datos con Microsoft Fabric. (DP-601T00)

Certificación

Microsoft Certified: Fabric Data Engineer Associate - Certifications

Como ingeniero de datos de tejido, debe tener experiencia en la materia con patrones de carga de datos, arquitecturas de datos y procesos de orquestación.

Documentación

Copia y transformación de datos en Microsoft Fabric Warehouse - Azure Data Factory & Azure Synapse

Aprenda a copiar y transformar datos con origen y destino de Microsoft Fabric Warehouse mediante canalizaciones de Azure Data Factory o Azure Synapse Analytics.

Cómo copiar datos mediante la actividad de copia - Microsoft Fabric

Obtenga información sobre cómo agregar una actividad de copia directamente o a través del asistente de copia.

Configuración de Lakehouse en una actividad de copia - Microsoft Fabric

Este artículo explica cómo copiar datos usando Lakehouse.