Événements

31 mars, 23 h - 2 avr., 23 h

Le plus grand événement d’apprentissage Fabric, Power BI et SQL. 31 mars au 2 avril. Utilisez le code FABINSIDER pour économiser 400 $.

Inscrivez-vous aujourd’huiCe navigateur n’est plus pris en charge.

Effectuez une mise à niveau vers Microsoft Edge pour tirer parti des dernières fonctionnalités, des mises à jour de sécurité et du support technique.

S'applique à :✅ Warehouse dans Microsoft Fabric

Warehouse dans Microsoft Fabric est constitué de formats de fichiers ouverts. Les tables utilisateur sont stockées au format de fichier parquet et les journaux Delta Lake sont publiés pour toutes les tables utilisateur.

Les journaux Delta Lake ouvrent un accès direct aux tables utilisateur de l'entrepôt pour tout moteur pouvant lire les tables Delta Lake. Cet accès est limité à la lecture seule pour s'assurer que les données de l'utilisateur maintiennent la conformité des transactions ACID. Toutes les insertions, mises à jour et suppressions des données dans les tables doivent être exécutées via l'entrepôt. Une fois qu'une transaction est validée, un processus d'arrière-plan du système est lancé pour publier le journal Delta Lake mis à jour pour les tables concernées.

Les étapes suivantes expliquent comment obtenir le chemin OneLake à partir d'une table dans un entrepôt :

Ouvrez Warehouse dans votre espace de travail Microsoft Fabric.

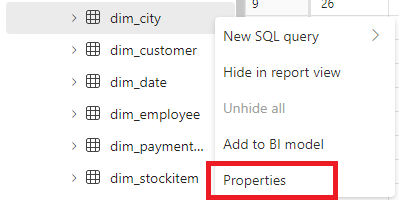

Dans l'Explorateur d'objets, vous trouvez plus d'options (...) sur une table sélectionnée dans le dossier Tables. Sélectionnez le menu Propriétés.

Lors de la sélection, le volet Propriétés affiche les informations suivantes :

Vous pouvez localiser les journaux Delta Lake via les méthodes suivantes :

Les journaux de Delta Lake peuvent être interrogés via des raccourcis créés dans une maison du lac. Vous pouvez afficher les fichiers à l'aide d'un Notebook Microsoft Fabric Spark ou de l'explorateur Lakehouse dans Ingénieurs de données Fabric dans le portail Microsoft Fabric.

Les journaux Delta Lake peuvent être trouvés via Explorateur Stockage Microsoft Azure, via des connexions Spark telles que le mode Power BI Direct Lake ou à l'aide de tout autre service capable de lire des tables delta.

Les journaux Delta Lake se trouvent dans le dossier _delta_log de chaque table via l’Explorateur OneLake dans Windows, comme illustré dans la capture d’écran suivante.

La publication des journaux Delta Lake peut être suspendue et reprise si nécessaire. Lorsque la publication est suspendue, les moteurs Microsoft Fabric qui lisent les tables en dehors de l’entrepôt voient les données telles qu’elles étaient avant la pause. Cela garantit que les rapports restent stables et cohérents, reflétant les données de toutes les tables telles qu’elles existaient avant toute modification qui leur est apportée. Une fois vos mises à jour de données terminées, vous pouvez reprendre la publication des journaux Delta Lake pour rendre toutes les modifications de données récentes visibles par d’autres moteurs analytiques. Un autre cas d’usage pour la suspension de la publication des journaux Delta Lake est quand les utilisateurs n’ont pas besoin d’interopérabilité avec d’autres moteurs de calcul dans Microsoft Fabric, car cela peut vous aider à économiser sur les coûts de calcul.

La syntaxe permettant de suspendre et de reprendre la publication des journaux Delta Lake est la suivante :

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED | AUTO

Pour suspendre la publication des journaux Delta Lake, utilisez l’extrait de code suivant :

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED

Les requêtes sur les tables d’entrepôt de l’entrepôt actuel à partir d’autres moteurs Microsoft Fabric (par exemple, les requêtes d’un lakehouse) affichent désormais une version des données telle qu’elles étaient avant la suspension de la publication des journaux Delta Lake. Les requêtes d’entrepôt continuent à afficher la dernière version des données.

Pour reprendre la publication des journaux Delta Lake, utilisez l’extrait de code suivant :

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = AUTO

Lorsque l’état est remis sur AUTO, le moteur de l’entrepôt Fabric publie les journaux de toutes les modifications récentes apportées aux tables de l’entrepôt, ce qui permet à d’autres moteurs analytiques de Microsoft Fabric de lire la dernière version des données.

Pour vérifier l’état actuel de la publication des journaux Delta Lake sur tous les entrepôts de l’espace de travail actuel, utilisez l’extrait de code suivant :

SELECT [name], [DATA_LAKE_LOG_PUBLISHING_DESC] FROM sys.databases

Événements

31 mars, 23 h - 2 avr., 23 h

Le plus grand événement d’apprentissage Fabric, Power BI et SQL. 31 mars au 2 avril. Utilisez le code FABINSIDER pour économiser 400 $.

Inscrivez-vous aujourd’huiEntrainement

Module

Utiliser des tables Delta Lake dans Microsoft Fabric - Training

Les tables d’un lakehouse Microsoft Fabric sont basées sur la technologie Delta Lake couramment utilisée dans Apache Spark. En utilisant les fonctionnalités améliorées des tables delta, vous pouvez créer des solutions d’analytique avancées.

Certification

Certifié Microsoft : Fabric Data Engineer Associate - Certifications

En tant qu’ingénieur données fabric, vous devez avoir une expertise en matière de modèles de chargement de données, d’architectures de données et de processus d’orchestration.