Archivált kibocsátási megjegyzések

Összegzés

Az Azure HDInsight a nagyvállalati ügyfelek körében a nyílt forráskódú Azure-elemzés egyik legnépszerűbb szolgáltatása. Iratkozzon fel a HDInsight kibocsátási megjegyzéseire a HDInsight és az összes HDInsight-verzió naprakész információiért.

A feliratkozáshoz kattintson a szalagcím "watch" gombjára, és figyelje meg a HDInsight-kiadásokat.

Kiadási információk

Kiadás dátuma: 2024. április 15.

Ez a kibocsátási megjegyzés a HDInsight 5.1-es verziójára vonatkozik.

A HDInsight-kiadás több napon keresztül minden régióban elérhető lesz. Ez a kibocsátási megjegyzés a 2403290825 képszámra vonatkozik. Hogyan ellenőrizhetem a képszámot?

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

Operációsrendszer-verziók

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Feljegyzés

Az Ubuntu 18.04-et az Azure Linux csapata az Azure HDInsight 2023. júliusi kiterjesztett biztonsági karbantartása (ESM) keretében támogatja, amely a kiadástól kezdve érhető el.

A számítási feladatokhoz tartozó verziókért lásd a HDInsight 5.x összetevőverzióit.

Megoldott problémák

- Az Ambari DB, a Hive Warehouse Controller (HWC), a Spark és a HDFS hibajavításai

- Hibajavítások a HDInsightSparkLogs-hez készült Log Analytics-modulhoz

- A HDInsight erőforrás-szolgáltató CVE-javításai.

Hamarosan

Hamarosan

- Alapszintű és standard A sorozatú virtuális gépek kivonása.

- 2024. augusztus 31-én kivonjuk az alapszintű és standard A sorozatú virtuális gépeket. Ezen dátum előtt migrálnia kell a számítási feladatokat Av2-sorozatú virtuális gépekre, amelyek több memóriát biztosítanak vCPU-nként, és gyorsabb tárolást a szilárd állapotú meghajtókon (SSD-ken).

- A szolgáltatáskimaradások elkerülése érdekében 2024. augusztus 31-ig migrálja a számítási feladatokat alapszintű és standard A sorozatú virtuális gépekről Av2 sorozatú virtuális gépekre.

- A HDInsight 4.0 és a HDInsight 5.0 kivonási értesítései.

Ha további kérdései vannak, forduljon az Azure ügyfélszolgálatához.

A HDInsightról bármikor kérdezhet az Azure HDInsighton – Microsoft Q&A.

Figyelünk: Itt további ötleteket és egyéb témaköröket adhat hozzá, és szavazhat rájuk – HDInsight Ideas, és kövessen minket további frissítésekért az AzureHDInsight-közösségről.

Feljegyzés

Azt javasoljuk az ügyfeleknek, hogy használják a HDInsight-rendszerképek legújabb verzióit, mivel azok a legjobb nyílt forráskód frissítéseket, Azure-frissítéseket és biztonsági javításokat kínálják. További információért lásd: Legjobb gyakorlatok.

Kiadás dátuma: 2024. február 15.

Ez a kiadás a HDInsight 4.x és 5.x verziókra vonatkozik. A HDInsight-kiadás több napon keresztül minden régióban elérhető lesz. Ez a kiadás a 2401250802 képszámra vonatkozik. Hogyan ellenőrizhetem a képszámot?

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

Operációsrendszer-verziók

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Feljegyzés

Az Ubuntu 18.04-et az Azure Linux csapata az Azure HDInsight 2023. júliusi kiterjesztett biztonsági karbantartása (ESM) keretében támogatja, amely a kiadástól kezdve érhető el.

A számítási feladatokhoz tartozó verziókért lásd:

Új funkciók

- Apache Ranger-támogatás a Spark SQL-hez a Spark 3.3.0-s (HDInsight 5.1-es verziójában) vállalati biztonsági csomaggal. További információt itt találhat.

Megoldott problémák

- Az Ambari és az Oozie összetevőinek biztonsági javításai

Hamarosan

Hamarosan

- Alapszintű és standard A sorozatú virtuális gépek kivonása.

- 2024. augusztus 31-én kivonjuk az alapszintű és standard A sorozatú virtuális gépeket. Ezen dátum előtt migrálnia kell a számítási feladatokat Av2-sorozatú virtuális gépekre, amelyek több memóriát biztosítanak vCPU-nként, és gyorsabb tárolást a szilárd állapotú meghajtókon (SSD-ken).

- A szolgáltatáskimaradások elkerülése érdekében 2024. augusztus 31-ig migrálja a számítási feladatokat alapszintű és standard A sorozatú virtuális gépekről Av2 sorozatú virtuális gépekre.

Ha további kérdései vannak, forduljon az Azure ügyfélszolgálatához.

A HDInsightról bármikor kérdezhet az Azure HDInsighton – Microsoft Q&A

Figyelünk: Itt további ötleteket és egyéb témaköröket adhat hozzá, és szavazhat rájuk – HDInsight Ideas, és kövessen minket további frissítésekért az AzureHDInsight-közösségről

Feljegyzés

Azt javasoljuk az ügyfeleknek, hogy használják a HDInsight-rendszerképek legújabb verzióit, mivel azok a legjobb nyílt forráskód frissítéseket, Azure-frissítéseket és biztonsági javításokat kínálják. További információért lásd: Legjobb gyakorlatok.

Következő lépések

- Azure HDInsight: Gyakori kérdések

- Az operációs rendszer javítási ütemtervének beállítása Linux-alapú HDInsight fürtökhöz

- Előző kibocsátási megjegyzés

Az Azure HDInsight a nagyvállalati ügyfelek körében a nyílt forráskódú Azure-elemzés egyik legnépszerűbb szolgáltatása. Ha a kibocsátási megjegyzésekre szeretne előfizetni, tekintse meg a GitHub-adattár kiadásait.

Kiadás dátuma: 2024. január 10.

Ez a gyorsjavítás-kiadás a HDInsight 4.x és 5.x verziókra vonatkozik. A HDInsight-kiadás több napon keresztül minden régióban elérhető lesz. Ez a kiadás a 2401030422 képszámra vonatkozik. Hogyan ellenőrizhetem a képszámot?

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

Operációsrendszer-verziók

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

Feljegyzés

Az Ubuntu 18.04-et az Azure Linux csapata az Azure HDInsight 2023. júliusi kiterjesztett biztonsági karbantartása (ESM) keretében támogatja, amely a kiadástól kezdve érhető el.

A számítási feladatokhoz tartozó verziókért lásd:

Megoldott problémák

- Az Ambari és az Oozie összetevőinek biztonsági javításai

Hamarosan

Hamarosan

- Alapszintű és standard A sorozatú virtuális gépek kivonása.

- 2024. augusztus 31-én kivonjuk az alapszintű és standard A sorozatú virtuális gépeket. Ezen dátum előtt migrálnia kell a számítási feladatokat Av2-sorozatú virtuális gépekre, amelyek több memóriát biztosítanak vCPU-nként, és gyorsabb tárolást a szilárd állapotú meghajtókon (SSD-ken).

- A szolgáltatáskimaradások elkerülése érdekében 2024. augusztus 31-ig migrálja a számítási feladatokat alapszintű és standard A sorozatú virtuális gépekről Av2 sorozatú virtuális gépekre.

Ha további kérdései vannak, forduljon az Azure ügyfélszolgálatához.

A HDInsightról bármikor kérdezhet az Azure HDInsighton – Microsoft Q&A

Figyelünk: Itt további ötleteket és egyéb témaköröket adhat hozzá, és szavazhat rájuk – HDInsight Ideas, és kövessen minket további frissítésekért az AzureHDInsight-közösségről

Feljegyzés

Azt javasoljuk az ügyfeleknek, hogy használják a HDInsight-rendszerképek legújabb verzióit, mivel azok a legjobb nyílt forráskód frissítéseket, Azure-frissítéseket és biztonsági javításokat kínálják. További információért lásd: Legjobb gyakorlatok.

Kiadás dátuma: 2023. október 26.

Ez a kiadás a HDInsight 4.x és 5.x HDInsight kiadásra vonatkozik, amely több napon keresztül minden régióban elérhető lesz. Ez a kiadás a 2310140056 képszámra vonatkozik. Hogyan ellenőrizhetem a képszámot?

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

Operációsrendszer-verziók

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

A számítási feladatokhoz tartozó verziókért lásd:

Újdonságok

A HDInsight 2023. november 1-től jelenti be a HDInsight 5.1 általános elérhetőségét. Ez a kiadás teljes veremfrissítést biztosít az nyílt forráskód összetevőkre és a Microsoft integrációira.

- Legújabb nyílt forráskódú verziók – A HDInsight 5.1 a legújabb stabil nyílt forráskódú verzióval rendelkezik. Az ügyfelek élvezhetik a legújabb nyílt forráskód funkciókat, a Microsoft teljesítménybeli fejlesztéseit és a hibajavításokat.

- Biztonságos – A legújabb verziókban a legújabb biztonsági javítások, a nyílt forráskódú biztonsági javítások és a Microsoft által végzett biztonsági fejlesztések is elérhetőek.

- Alacsonyabb TCO – A teljesítménybeli fejlesztések révén az ügyfelek csökkenthetik az üzemeltetési költségeket, valamint a továbbfejlesztett automatikus skálázást.

Fürtengedélyek a biztonságos tároláshoz

- Az ügyfelek megadhatja (a fürt létrehozása során), hogy a HDInsight-fürtcsomópontok számára biztonságos csatornát kell-e használni a tárfiók csatlakoztatásához.

HDInsight-fürt létrehozása egyéni virtuális hálózatokkal.

- A HDInsight-fürtök általános biztonsági helyzetének javítása érdekében az egyéni virtuális merevlemezeket használó HDInsight-fürtöknek biztosítaniuk kell, hogy a felhasználónak engedéllyel kell rendelkeznie a létrehozási műveletek végrehajtásához

Microsoft Network/virtualNetworks/subnets/join/action. Az ügyfél létrehozási hibákba ütközhet, ha ez az ellenőrzés nincs engedélyezve.

- A HDInsight-fürtök általános biztonsági helyzetének javítása érdekében az egyéni virtuális merevlemezeket használó HDInsight-fürtöknek biztosítaniuk kell, hogy a felhasználónak engedéllyel kell rendelkeznie a létrehozási műveletek végrehajtásához

Nem ESP ABFS-fürtök [A Word olvasható fürtengedélyei]

- A nem ESP ABFS-fürtök korlátozzák, hogy a nem Hadoop-csoport felhasználói Hadoop-parancsokat hajtanak végre a tárolási műveletekhez. Ez a módosítás javítja a fürt biztonsági helyzetét.

In-line kvótafrissítés.

- Most közvetlenül a Saját kvóta oldalról kérheti a kvótanövelést, és a közvetlen API-hívás sokkal gyorsabb. Ha az API-hívás meghiúsul, létrehozhat egy új támogatási kérést a kvótanöveléshez.

Hamarosan

Hamarosan

A fürt nevének maximális hossza 45-ről 59 karakterre változik a fürtök biztonsági helyzetének javítása érdekében. Ezt a módosítást minden régióban bevezetjük a közelgő kiadástól kezdve.

Alapszintű és standard A sorozatú virtuális gépek kivonása.

- 2024. augusztus 31-én kivonjuk az alapszintű és standard A sorozatú virtuális gépeket. Ezen dátum előtt migrálnia kell a számítási feladatokat Av2-sorozatú virtuális gépekre, amelyek több memóriát biztosítanak vCPU-nként, és gyorsabb tárolást a szilárd állapotú meghajtókon (SSD-ken).

- A szolgáltatáskimaradások elkerülése érdekében 2024. augusztus 31-ig migrálja a számítási feladatokat alapszintű és standard A sorozatú virtuális gépekről Av2 sorozatú virtuális gépekre.

Ha további kérdései vannak, forduljon az Azure ügyfélszolgálatához.

A HDInsightról bármikor kérdezhet az Azure HDInsighton – Microsoft Q&A

Figyelünk: Itt további ötleteket és egyéb témaköröket adhat hozzá, és szavazhat rájuk – HDInsight Ideas, és kövessen minket további frissítésekért az AzureHDInsight-közösségről

Feljegyzés

Ez a kiadás az MSRC által 2023. szeptember 12-én kiadott alábbi CVEs-eket tartalmazza. A művelet a legújabb rendszerkép-2308221128 vagy 2310140056 frissítése. Az ügyfeleknek ennek megfelelően kell tervezni.

| CVE | Súlyosság | CVE cím | Megjegyzés |

|---|---|---|---|

| CVE-2023-38156 | Fontos | Azure HDInsight Apache Ambari jogosultsági rés növelése | A 2308221128 vagy a 2310140056 oldalon található képen szerepel |

| CVE-2023-36419 | Fontos | Azure HDInsight Apache Oozie munkafolyamat-ütemező Jogosultsági rés növelése | Alkalmazza a szkript műveletet a klasztereken, vagy frissítse a 2310140056 képre |

Feljegyzés

Azt javasoljuk az ügyfeleknek, hogy használják a HDInsight-rendszerképek legújabb verzióit, mivel azok a legjobb nyílt forráskód frissítéseket, Azure-frissítéseket és biztonsági javításokat kínálják. További információért lásd: Legjobb gyakorlatok.

Kiadás dátuma: 2023. szeptember 7.

Ez a kiadás a HDInsight 4.x és 5.x HDInsight kiadásra vonatkozik, amely több napon keresztül minden régióban elérhető lesz. Ez a kiadás a 2308221128 képszámra vonatkozik. Hogyan ellenőrizhetem a képszámot?

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

Operációsrendszer-verziók

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

A számítási feladatokhoz tartozó verziókért lásd:

Fontos

Ez a kiadás az MSRC által 2023. szeptember 12-én kiadott alábbi CVEs-eket tartalmazza. A művelet a legújabb rendszerkép-2308221128 frissítése. Az ügyfeleknek ennek megfelelően kell tervezni.

| CVE | Súlyosság | CVE cím | Megjegyzés |

|---|---|---|---|

| CVE-2023-38156 | Fontos | Azure HDInsight Apache Ambari jogosultsági rés növelése | 2308221128 kép része |

| CVE-2023-36419 | Fontos | Azure HDInsight Apache Oozie munkafolyamat-ütemező Jogosultsági rés növelése | Szkriptművelet alkalmazása fürtökön |

Hamarosan

- A fürt nevének maximális hossza 45-ről 59 karakterre változik a fürtök biztonsági helyzetének javítása érdekében. Ezt a módosítást 2023. szeptember 30-ig hajtjuk végre.

- Fürtengedélyek a biztonságos tároláshoz

- Az ügyfelek megadhatja (a fürt létrehozása során), hogy a HDInsight-fürtcsomópontok számára biztonságos csatornát kell-e használni a tárfiókhoz való kapcsolódáshoz.

- In-line kvótafrissítés.

- A kéréskvóták közvetlenül a Saját kvóta oldalról növekednek, ami egy közvetlen API-hívás lesz, ami gyorsabb. Ha az APdI-hívás meghiúsul, az ügyfeleknek új támogatási kérelmet kell létrehozniuk a kvótanöveléshez.

- HDInsight-fürt létrehozása egyéni virtuális hálózatokkal.

- A HDInsight-fürtök általános biztonsági helyzetének javítása érdekében az egyéni virtuális merevlemezeket használó HDInsight-fürtöknek biztosítaniuk kell, hogy a felhasználónak engedéllyel kell rendelkeznie a létrehozási műveletek végrehajtásához

Microsoft Network/virtualNetworks/subnets/join/action. Az ügyfeleknek ennek megfelelően kell tervezniük, mivel ez a módosítás kötelező ellenőrzés lenne a fürtlétrehozás 2023. szeptember 30-a előtti hibáinak elkerülése érdekében.

- A HDInsight-fürtök általános biztonsági helyzetének javítása érdekében az egyéni virtuális merevlemezeket használó HDInsight-fürtöknek biztosítaniuk kell, hogy a felhasználónak engedéllyel kell rendelkeznie a létrehozási műveletek végrehajtásához

- Alapszintű és standard A sorozatú virtuális gépek kivonása.

- 2024. augusztus 31-én kivonjuk az alapszintű és standard A sorozatú virtuális gépeket. Ezen dátum előtt migrálnia kell a számítási feladatokat Av2-sorozatú virtuális gépekre, amelyek több memóriát biztosítanak vCPU-nként, és gyorsabb tárolást a szilárd állapotú meghajtókon (SSD-ken). A szolgáltatáskimaradások elkerülése érdekében 2024. augusztus 31-ig migrálja a számítási feladatokat alapszintű és standard A sorozatú virtuális gépekről Av2 sorozatú virtuális gépekre.

- Nem ESP ABFS-fürtök [A Word olvasható fürtengedélyei]

- Tervezze meg a nem ESP ABFS-fürtök módosítását, amely korlátozza, hogy a nem Hadoop-csoport felhasználói Hadoop-parancsokat hajtsanak végre a tárolási műveletekhez. Ez a változás a fürt biztonsági helyzetének javítása érdekében. Az ügyfeleknek 2023. szeptember 30-a előtt végre kell hajtaniuk a frissítéseket.

Ha további kérdései vannak, forduljon az Azure ügyfélszolgálatához.

A HDInsightról bármikor kérdezhet az Azure HDInsighton – Microsoft Q&A

Itt további javaslatokat, ötleteket és egyéb témákat adhat hozzá, és szavazhat rájuk – HDInsight Community (azure.com).

Feljegyzés

Azt javasoljuk az ügyfeleknek, hogy használják a HDInsight-rendszerképek legújabb verzióit, mivel azok a legjobb nyílt forráskód frissítéseket, Azure-frissítéseket és biztonsági javításokat kínálják. További információért lásd: Legjobb gyakorlatok.

Kiadás dátuma: 2023. július 25.

Ez a kiadás a HDInsight 4.x és 5.x HDInsight kiadásra vonatkozik, amely több napon keresztül minden régióban elérhető lesz. Ez a kiadás a 2307201242 képszámra vonatkozik. Hogyan ellenőrizhetem a képszámot?

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

Operációsrendszer-verziók

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.1: Ubuntu 18.04.5 LTS Linux Kernel 5.4

A számítási feladatokhoz tartozó verziókért lásd:

Mi újság

Mi újság

- A HDInsight 5.1 mostantól esp-fürttel is támogatott.

- A Ranger 2.3.0 és az Oozie 5.2.1 frissített verziója mostantól a HDInsight 5.1 része

- A Spark 3.3.1 (HDInsight 5.1) fürt a Hive Warehouse Connector (HWC) 2.1-et tartalmazza, amely együttműködik az Interaktív lekérdezési (HDInsight 5.1) fürttel.

- Az Ubuntu 18.04-et a 2023. júliusi Azure HDInsighthoz készült Azure Linux-csapat támogatja az ESM (kiterjesztett biztonsági karbantartás) keretében.

Fontos

Ez a kiadás az MSRC által 2023. augusztus 8-án kiadott alábbi CVEs-eket tartalmazza. A művelet a legújabb rendszerképre való frissítés 2307201242. Az ügyfeleknek ennek megfelelően kell tervezni.

| CVE | Súlyosság | CVE cím |

|---|---|---|

| CVE-2023-35393 | Fontos | Az Azure Apache Hive hamisítási biztonsági rése |

| CVE-2023-35394 | Fontos | Az Azure HDInsight Jupyter notebook hamisítási biztonsági rése |

| CVE-2023-36877 | Fontos | Azure Apache Oozie hamisítási biztonsági rés |

| CVE-2023-36881 | Fontos | Azure Apache Ambari hamisítási biztonsági rés |

| CVE-2023-38188 | Fontos | Az Azure Apache Hadoop hamisítási biztonsági rése |

Hamarosan

Hamarosan

- A fürt nevének maximális hossza 45-ről 59 karakterre változik a fürtök biztonsági helyzetének javítása érdekében. Az ügyfeleknek 2023. szeptember 30-a előtt kell megtervezniük a frissítéseket.

- Fürtengedélyek a biztonságos tároláshoz

- Az ügyfelek megadhatja (a fürt létrehozása során), hogy a HDInsight-fürtcsomópontok számára biztonságos csatornát kell-e használni a tárfiókhoz való kapcsolódáshoz.

- In-line kvótafrissítés.

- A kéréskvóták közvetlenül a Saját kvóta oldalról növekednek, ami egy közvetlen API-hívás lesz, ami gyorsabb. Ha az API-hívás sikertelen, az ügyfeleknek létre kell hozniuk egy új támogatási kérelmet a kvótanöveléshez.

- HDInsight-fürt létrehozása egyéni virtuális hálózatokkal.

- A HDInsight-fürtök általános biztonsági helyzetének javítása érdekében az egyéni virtuális merevlemezeket használó HDInsight-fürtöknek biztosítaniuk kell, hogy a felhasználónak engedéllyel kell rendelkeznie a létrehozási műveletek végrehajtásához

Microsoft Network/virtualNetworks/subnets/join/action. Az ügyfeleknek ennek megfelelően kell tervezniük, mivel ez a módosítás kötelező ellenőrzés lenne a fürtlétrehozás 2023. szeptember 30-a előtt bekövetkező hibáinak elkerülése érdekében.

- A HDInsight-fürtök általános biztonsági helyzetének javítása érdekében az egyéni virtuális merevlemezeket használó HDInsight-fürtöknek biztosítaniuk kell, hogy a felhasználónak engedéllyel kell rendelkeznie a létrehozási műveletek végrehajtásához

- Alapszintű és standard A sorozatú virtuális gépek kivonása.

- 2024. augusztus 31-én kivonjuk az alapszintű és standard A sorozatú virtuális gépeket. Ezen dátum előtt migrálnia kell a számítási feladatokat Av2-sorozatú virtuális gépekre, amelyek több memóriát biztosítanak vCPU-nként, és gyorsabb tárolást a szilárd állapotú meghajtókon (SSD-ken). A szolgáltatáskimaradások elkerülése érdekében 2024. augusztus 31-ig migrálja a számítási feladatokat alapszintű és standard A sorozatú virtuális gépekről Av2 sorozatú virtuális gépekre.

- Nem ESP ABFS-fürtök [A Word olvasható fürtengedélyei]

- Tervezze meg a nem ESP ABFS-fürtök módosítását, amely korlátozza, hogy a nem Hadoop-csoport felhasználói Hadoop-parancsokat hajtsanak végre a tárolási műveletekhez. Ez a változás a fürt biztonsági helyzetének javítása érdekében. Az ügyfeleknek 2023. szeptember 30-a előtt kell megtervezniük a frissítéseket.

Ha további kérdései vannak, forduljon az Azure ügyfélszolgálatához.

A HDInsightról bármikor kérdezhet az Azure HDInsighton – Microsoft Q&A

Szívesen ad további javaslatokat és ötleteket és más témákat itt, és szavazzon rájuk - HDInsight Közösség (azure.com), és kövessen minket további frissítések twitter

Feljegyzés

Azt javasoljuk az ügyfeleknek, hogy használják a HDInsight-rendszerképek legújabb verzióit, mivel azok a legjobb nyílt forráskód frissítéseket, Azure-frissítéseket és biztonsági javításokat kínálják. További információért lásd: Legjobb gyakorlatok.

Kiadás dátuma: 2023. május 08.

Ez a kiadás a HDInsight 4.x és 5.x HDInsight kiadásra vonatkozik, amely több napon keresztül minden régióban elérhető. Ez a kiadás a 2304280205 képszámra vonatkozik. Hogyan ellenőrizhetem a képszámot?

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

Operációsrendszer-verziók

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

A számítási feladatokhoz tartozó verziókért lásd:

![]()

Az Azure HDInsight 5.1 frissítése

- Apache HBase 2.4.11

- Apache Phoenix 5.1.2

- Apache Hive 3.1.2

- Apache Spark 3.3.1

- Apache Tez 0.9.1

- Apache Zeppelin 0.10.1

- Apache Livy 0.5

- Apache Kafka 3.2.0

Feljegyzés

- Minden összetevő integrálva van a Hadoop 3.3.4 > ZK 3.6.3

- A fenti frissített összetevők mostantól nyilvános előzetes verziójú, nem ESP-fürtökben is elérhetők.

![]()

Továbbfejlesztett automatikus skálázás a HDInsighthoz

Az Azure HDInsight jelentős fejlesztéseket hajtott végre az automatikus skálázás stabilitásán és késésén. Az alapvető változások közé tartozik a jobb visszajelzési ciklus a skálázási döntésekhez, a skálázási késés jelentős javulása és a leszerelt csomópontok újrakommissziójának támogatása. További információ a fejlesztésekről, a fürt egyéni konfigurálásáról és a továbbfejlesztett automatikus skálázásra való migrálásáról. A továbbfejlesztett automatikus skálázási funkció 2023. május 17-én érhető el az összes támogatott régióban.

Az Apache Kafka 2.4.1-hez készült Azure HDInsight ESP mostantól általánosan elérhető.

Az Apache Kafka 2.4.1-hez készült Azure HDInsight ESP 2022 áprilisa óta nyilvános előzetes verzióban érhető el. A CVE javításainak és stabilitásának jelentős fejlesztései után az Azure HDInsight ESP Kafka 2.4.1 általánosan elérhetővé válik, és készen áll az éles számítási feladatokra, és megismerkedhet a konfigurálás és a migrálás módjával.

A HDInsight kvótakezelése

A HDInsight jelenleg regionális szinten foglalja le a kvótát az ügyfél-előfizetésekhez. Az ügyfeleknek kiosztott magok általánosak, és nem virtuálisgép-családi szinten vannak besorolva (például,

Dv2,Ev3,Eav4stb.).A HDInsight továbbfejlesztett nézetet vezetett be, amely részletes és besorolást biztosít a családi szintű virtuális gépek kvótáihoz. Ez a funkció lehetővé teszi, hogy az ügyfelek a virtuális gép családi szintjén tekinthetik meg a régió aktuális és fennmaradó kvótáit. A továbbfejlesztett nézettel az ügyfelek gazdagabb láthatóságot, kvóták tervezését és jobb felhasználói élményt biztosítanak. Ez a funkció jelenleg az USA keleti régiójához tartozó HDInsight 4.x és 5.x rendszeren érhető el. További követendő régiók.

További információ: Fürtkapacitás-tervezés az Azure HDInsightban | Microsoft Learn

![]()

- Közép-Lengyelország

- A fürtnév maximális hossza 45-ről 59 karakterre változik a fürtök biztonsági helyzetének javítása érdekében.

- Fürtengedélyek a biztonságos tároláshoz

- Az ügyfelek megadhatja (a fürt létrehozása során), hogy a HDInsight-fürtcsomópontok számára biztonságos csatornát kell-e használni a tárfiókhoz való kapcsolódáshoz.

- In-line kvótafrissítés.

- A kéréskvóták közvetlenül a Saját kvóta oldalról növekednek, ami egy közvetlen API-hívás, amely gyorsabb. Ha az API-hívás sikertelen, az ügyfeleknek létre kell hozniuk egy új támogatási kérelmet a kvótanöveléshez.

- HDInsight-fürt létrehozása egyéni virtuális hálózatokkal.

- A HDInsight-fürtök általános biztonsági helyzetének javítása érdekében az egyéni virtuális merevlemezeket használó HDInsight-fürtöknek biztosítaniuk kell, hogy a felhasználónak engedéllyel kell rendelkeznie a létrehozási műveletek végrehajtásához

Microsoft Network/virtualNetworks/subnets/join/action. Az ügyfeleknek ennek megfelelően kell tervezni, mivel ez kötelező ellenőrzés lenne a fürtlétrehozás hibáinak elkerülése érdekében.

- A HDInsight-fürtök általános biztonsági helyzetének javítása érdekében az egyéni virtuális merevlemezeket használó HDInsight-fürtöknek biztosítaniuk kell, hogy a felhasználónak engedéllyel kell rendelkeznie a létrehozási műveletek végrehajtásához

- Alapszintű és standard A sorozatú virtuális gépek kivonása.

- 2024. augusztus 31-én kivonjuk az alapszintű és standard A sorozatú virtuális gépeket. Ezen dátum előtt migrálnia kell a számítási feladatokat Av2-sorozatú virtuális gépekre, amelyek több memóriát biztosítanak vCPU-nként, és gyorsabb tárolást a szilárd állapotú meghajtókon (SSD-ken). A szolgáltatáskimaradások elkerülése érdekében 2024. augusztus 31-ig migrálja a számítási feladatokat alapszintű és standard A sorozatú virtuális gépekről Av2 sorozatú virtuális gépekre.

- Nem ESP ABFS-fürtök [Fürtengedélyek a világ számára olvasható]

- Tervezze meg a nem ESP ABFS-fürtök módosítását, amely korlátozza, hogy a nem Hadoop-csoport felhasználói Hadoop-parancsokat hajtsanak végre a tárolási műveletekhez. Ez a változás a fürt biztonsági helyzetének javítása érdekében. Az ügyfeleknek meg kell tervezni a frissítéseket.

Kiadás dátuma: 2023. február 28.

Ez a kiadás a HDInsight 4.0-ra vonatkozik. és 5.0, 5.1. A HDInsight-kiadás több napon keresztül minden régióban elérhető. Ez a kiadás a 2302250400 képszámra vonatkozik. Hogyan ellenőrizhetem a képszámot?

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

Operációsrendszer-verziók

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

A számítási feladatokhoz tartozó verziókért lásd:

Fontos

A Microsoft kiadta a CVE-2023-23408-at, amely az aktuális kiadásban van javítva, és az ügyfeleknek javasoljuk, hogy frissítsenek fürtöiket a legújabb lemezképre.

![]()

HDInsight 5.1

Elindítottuk a HDInsight 5.1 új verzióját. Minden új nyílt forráskódú kiadás növekményes kiadásként hozzáadva a HDInsight 5.1-es verziójához.

További információ: HDInsight 5.1.0-s verzió

![]()

Kafka 3.2.0 frissítés (előzetes verzió)

- A Kafka 3.2.0 számos jelentős új funkciót/fejlesztést tartalmaz.

- Frissített Zookeeper 3.6.3-ra

- A Kafka Streams támogatása

- A Kafka-gyártó számára alapértelmezés szerint engedélyezett erősebb kézbesítési garanciák.

log4j1.x helyettreload4j.- Küldjön egy tippet a partícióvezetőnek a partíció helyreállításához.

JoinGroupRequestésLeaveGroupRequestvan egy ok csatolva.- Hozzáadva a közvetítők számának metrikái8.

- Tükrözési

Maker2fejlesztések.

HBase 2.4.11 frissítés (előzetes verzió)

- Ez a verzió olyan új funkciókkal rendelkezik, mint például a blokkgyorsítótár új gyorsítótárazási mechanizmusainak hozzáadása, a táblázat módosításának

hbase:meta tableés megtekintésének lehetősége ahbase:metaHBase WEB felhasználói felületén.

Phoenix 5.1.2 frissítés (előzetes verzió)

- A Phoenix verziója ebben a kiadásban az 5.1.2-es verzióra frissült. Ez a frissítés tartalmazza a Phoenix Query Servert is. A Phoenix Query Server a szabványos Phoenix JDBC-illesztőt proxyzja, és egy visszafelé kompatibilis vezetékes protokollt biztosít a JDBC-illesztőprogram meghívásához.

Ambari CV-k

- Több Ambari CV-t is kijavítottunk.

Feljegyzés

Ebben a kiadásban a Kafka és a HBase nem támogatja az ESP-t.

![]()

Megszűnik az Azure HDInsight-fürtök támogatása a Spark 2.4-ben 2024. február 10-én. További információ: Az Azure HDInsight által támogatott Spark-verziók

A következő lépések

- Automatikus skálázás

- Automatikus skálázás továbbfejlesztett késéssel és számos fejlesztéssel

- Fürtnévváltoztatás korlátozása

- A fürtnév maximális hossza 45-ről 59-re változik a nyilvános, az Azure China és az Azure Government esetében.

- Fürtengedélyek a biztonságos tároláshoz

- Az ügyfelek megadhatja (a fürt létrehozása során), hogy a HDInsight-fürtcsomópontok számára biztonságos csatornát kell-e használni a tárfiókhoz való kapcsolódáshoz.

- Nem ESP ABFS-fürtök [Fürtengedélyek a világ számára olvasható]

- Tervezze meg a nem ESP ABFS-fürtök módosítását, amely korlátozza, hogy a nem Hadoop-csoport felhasználói Hadoop-parancsokat hajtsanak végre a tárolási műveletekhez. Ez a változás a fürt biztonsági helyzetének javítása érdekében. Az ügyfeleknek meg kell tervezni a frissítéseket.

- Nyílt forráskódú frissítések

- Az Apache Spark 3.3.0 és a Hadoop 3.3.4 fejlesztés alatt áll a HDInsight 5.1-ben, és számos jelentős új funkciót, teljesítményt és egyéb fejlesztést tartalmaz.

Feljegyzés

Azt javasoljuk az ügyfeleknek, hogy használják a HDInsight-rendszerképek legújabb verzióit, mivel azok a legjobb nyílt forráskód frissítéseket, Azure-frissítéseket és biztonsági javításokat kínálják. További információért lásd: Legjobb gyakorlatok.

Kiadás dátuma: 2022. december 12.

Ez a kiadás a HDInsight 4.0-ra vonatkozik. és az 5.0 HDInsight kiadás több napon keresztül minden régió számára elérhetővé válik.

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

Operációsrendszer-verziók

- HDInsight 4.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

- HDInsight 5.0: Ubuntu 18.04.5 LTS Linux Kernel 5.4

A számítási feladatokhoz tartozó verziókról itt olvashat .

![]()

- Log Analytics – Az ügyfelek engedélyezhetik a klasszikus monitorozást az OMS legújabb 14.19-es verziójának beszerzéséhez. A régi verziók eltávolításához tiltsa le és engedélyezze a klasszikus monitorozást.

- Az Ambari felhasználói automatikus felhasználói felülete inaktivitás miatt kijelentkezik. További információ:

- Spark – A Spark 3.1.3 új és optimalizált verziója szerepel ebben a kiadásban. Teszteltük az Apache Spark 3.1.2(korábbi verzió) és az Apache Spark 3.1.3 (jelenlegi verzió) verzióját a TPC-DS benchmark használatával. A tesztet az Apache Spark 1 TB-os számítási feladathoz készült E8 V3 termékváltozatával végezték el. Az Apache Spark 3.1.3 (jelenlegi verzió) több mint 40%-kal felülmúlta az Apache Spark 3.1.2-t (korábbi verzió) a TPC-DS-lekérdezések teljes lekérdezési futásidejében ugyanazokkal a hardveres specifikációkkal. A Microsoft Spark csapata optimalizálásokat adott hozzá az Azure Synapse-ban az Azure HDInsighttal. További információ: Adatterhelések felgyorsítása az Apache Spark 3.1.2 teljesítményfrissítéseivel az Azure Synapse-ben

![]()

- Közép-Katar

- Észak-Németország

![]()

A HDInsight átlépett az Azul Zulu Java JDK 8-ról

Adoptium Temurin JDK 8, amely támogatja a kiváló minőségű TCK-tanúsítvánnyal rendelkező futtatókörnyezeteket és a kapcsolódó technológiákat a Java-ökoszisztémában való használathoz.A HDInsight át lett migrálva.

reload4jAlog4jmódosítások a következőre vonatkoznak:- Apache Hadoop

- Apache Zookeeper

- Apache Oozie

- Apache Ranger

- Apache Sqoop

- Apache Pig

- Apache Ambari

- Apache Kafka

- Apache Spark

- Apache Zeppelin

- Apache Livy

- Apache Rubix

- Apache Hive

- Apache Tez

- Apache HBase

- OMI

- Apache Pheonix

![]()

A TLS1.2 implementálásához szükséges HDInsight előrehaladtával a korábbi verziók frissülnek a platformon. Ha bármilyen alkalmazást futtat a HDInsighton, és a TLS 1.0 és 1.1 rendszert használják, frissítsen a TLS 1.2-re a szolgáltatások megszakadásának elkerülése érdekében.

További információ: A Transport Layer Security (TLS) engedélyezése

![]()

2022. november 30-tól megszűnik az Azure HDInsight-fürtök támogatása az Ubuntu 16.04 LTS-en. A HDInsight 2021. június 27-től megkezdi a fürtlemezképek kiadását az Ubuntu 18.04-es verziójával. Azt javasoljuk ügyfeleinknek, hogy az Ubuntu 16.04 használatával fürtöket futtató ügyfeleink 2022. november 30-ig a legújabb HDInsight-lemezképekkel építsék újra a fürtöket.

A fürt Ubuntu-verziójának ellenőrzéséről itt talál további információt

Hajtsa végre az "lsb_release -a" parancsot a terminálban.

Ha a kimenet "Description" tulajdonságának értéke "Ubuntu 16.04 LTS", akkor ez a frissítés a fürtre vonatkozik.

![]()

- A Rendelkezésre állási zónák kafka- és HBase-fürtökhöz (írási hozzáférés) való kiválasztásának támogatása.

Nyílt forráskódú hibajavítások

Hive hibajavítások

| Hibajavítások | Apache JIRA |

|---|---|

| HIVE-26127 | INSERT OVERWRITE hiba – A fájl nem található |

| HIVE-24957 | Helytelen eredmények, ha a subqueryben a COALESCE szerepel a korrelációs predikátumban |

| HIVE-24999 | A HiveSubQueryRemoveRule érvénytelen tervet hoz létre az IN-allekérdezéshez több korrelációval |

| HIVE-24322 | Közvetlen beszúrás esetén a kísérletazonosítót ellenőrizni kell, ha a jegyzékfájl olvasása meghiúsul |

| HIVE-23363 | DataNucleus-függőség frissítése 5.2-re |

| HIVE-26412 | Interfész létrehozása az elérhető pontok beolvasásához és az alapértelmezett beállítás hozzáadásához |

| HIVE-26173 | Frissítés a 10.14.2.0-s verzióra |

| HIVE-25920 | Dudor Xerce2 a 2.12.2-hez. |

| HIVE-26300 | A CVE-2020-36518 elkerülése érdekében frissítse a Jackson adatkötési verzióját a 2.12.6.1+-ra |

Kiadás dátuma: 2022. 08. 10.

Ez a kiadás a HDInsight 4.0-ra vonatkozik. A HDInsight-kiadás több napon keresztül minden régió számára elérhetővé válik.

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

![]()

Új funkció

1. Külső lemezek csatolása HDI Hadoop-/Spark-fürtökben

A HDInsight-fürt SKU-n alapuló előre definiált lemezterülettel rendelkezik. Ez a hely nagy feladatok esetén nem biztos, hogy elegendő.

Ez az új funkció lehetővé teszi további lemezek hozzáadását a fürtben, amelyek csomópontkezelő helyi könyvtárként szolgálnak. A HIVE és a Spark-fürt létrehozása során adjon hozzá lemezeket a feldolgozó csomópontokhoz, míg a kijelölt lemezek a csomópontkezelő helyi könyvtárainak részei.

Feljegyzés

A hozzáadott lemezek csak a csomópontkezelő helyi könyvtáraihoz vannak konfigurálva.

2. Szelektív naplózási elemzés

A szelektív naplózási elemzés mostantól minden régióban elérhető a nyilvános előzetes verzióhoz. A fürtöt egy log analytics-munkaterülethez csatlakoztathatja. Ha engedélyezve van, megtekintheti a naplókat és metrikákat, például a HDInsight biztonsági naplóit, a Yarn Resource Managert, a rendszermetrikákat stb. Figyelheti a számítási feladatokat, és megtekintheti, hogy ezek hogyan befolyásolják a fürt stabilitását. A szelektív naplózás lehetővé teszi az összes tábla engedélyezését/letiltását, vagy a szelektív táblák engedélyezését a Log Analytics-munkaterületen. Az egyes táblák forrástípusát módosíthatja, mivel a Genf új verziójában egy tábla több forrással rendelkezik.

- A genfi monitorozási rendszer mdsd(MDS démont) használ, amely egy monitorozási ügynök, és folyékonyan használható a naplók egységes naplózási réteg használatával történő gyűjtéséhez.

- A szelektív naplózás szkriptművelettel tiltja le/engedélyezi a táblákat és a naplótípusokat. Mivel nem nyit meg új portokat, és nem módosítja a meglévő biztonsági beállításokat, nincsenek biztonsági változások.

- A szkriptművelet párhuzamosan fut az összes megadott csomóponton, és módosítja a konfigurációs fájlokat a táblák és a naplótípusok letiltására/engedélyezésére.

![]()

Rögzített méretű lemez

Log analytics

Az OMS 13-at futtató Azure HDInsighttal integrált Log Analytics használatához az OMS 14-es verziójára kell frissíteni a legújabb biztonsági frissítéseket. Az OMS 13-at használó régebbi fürtverziót használó ügyfeleknek telepíteniük kell az OMS 14-es verzióját a biztonsági követelményeknek való megfelelés érdekében. (Az aktuális verzió ellenőrzése és a 14-es telepítés)

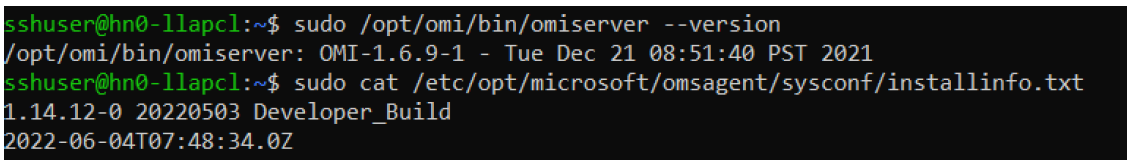

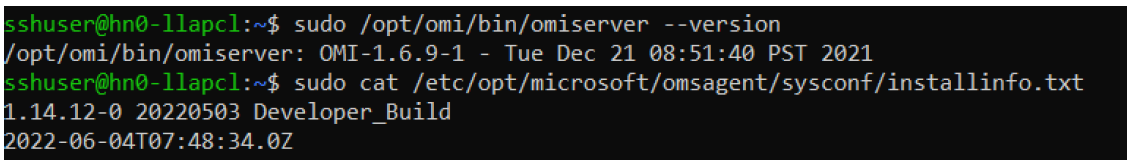

Az OMS aktuális verziójának ellenőrzése

- Jelentkezzen be a fürtbe az SSH használatával.

- Futtassa az alábbi parancsot az SSH-ügyfélben.

sudo /opt/omi/bin/ominiserver/ --version

Az OMS-verzió frissítése 13-ról 14-re

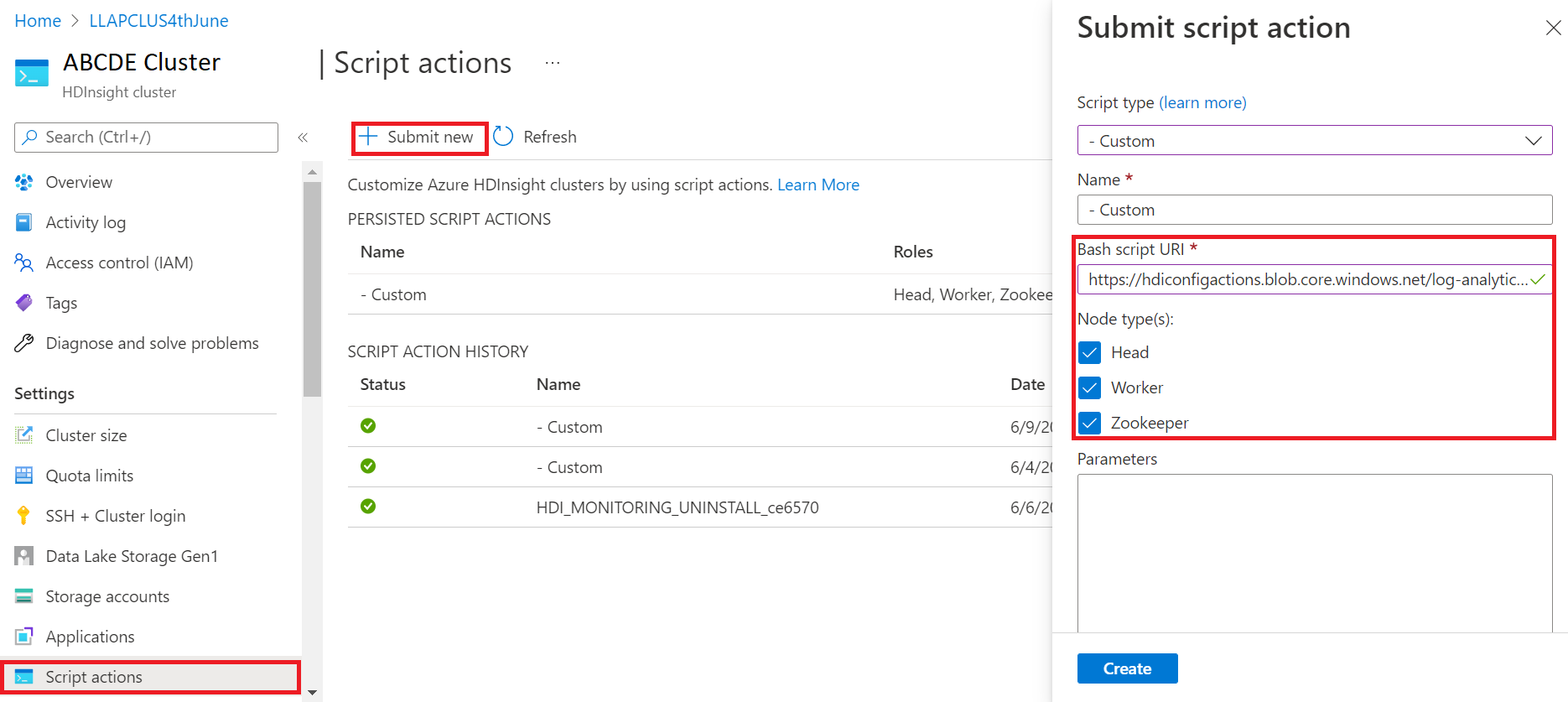

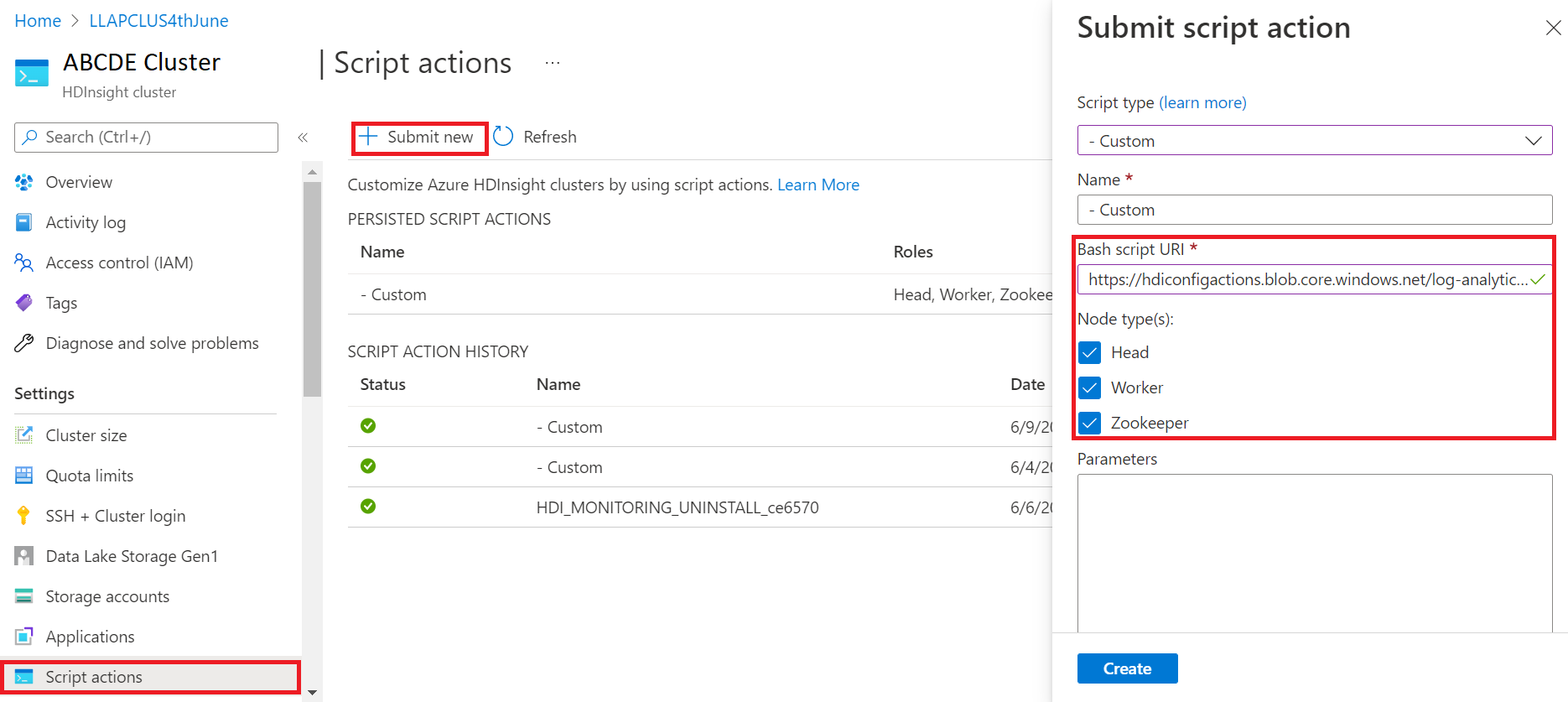

- Jelentkezzen be az Azure Portalra

- Az erőforráscsoportban válassza ki a HDInsight-fürt erőforrását

- Szkriptműveletek kiválasztása

- A szkriptművelet elküldése panelen válassza a Szkripttípus egyéniként lehetőséget

- Illessze be a következő hivatkozást a Bash-szkript URL-cím mezőjébe https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Csomóponttípus(ok) kiválasztása

- Válassza a Létrehozás elemet

Ellenőrizze a javítás sikeres telepítését az alábbi lépésekkel:

Jelentkezzen be a fürtbe az SSH használatával.

Futtassa az alábbi parancsot az SSH-ügyfélben.

sudo /opt/omi/bin/ominiserver/ --version

Egyéb hibajavítások

- A Yarn-napló parancssori felülete nem tudta lekérni a naplókat, ha valamelyik

TFilesérült vagy üres. - Az OAuth-jogkivonat az Azure Active Directoryból való lekérése során érvénytelen szolgáltatásnév-adathibát oldott fel.

- Továbbfejlesztett fürtlétrehozás megbízhatósága, ha több mint 100 működő csomópont van konfigurálva.

Nyílt forráskódú hibajavítások

TEZ hibajavítások

| Hibajavítások | Apache JIRA |

|---|---|

| Tez buildelési hibája: FileSaver.js nem található | TEZ-4411 |

Hibás FS-kivétel, ha a raktár és scratchdir a különböző FS-en van |

TEZ-4406 |

| TezUtils.createConfFromByteString on Configuration nagyobb, mint 32 MB dobja com.google.protobuf.CodedInputStream kivétel | TEZ-4142 |

| TezUtils::createByteStringFromConf kell használni snappy helyett DeflaterOutputStream | TEZ-4113 |

| Protobuf-függőség frissítése 3.x-ra | TEZ-4363 |

Hive hibajavítások

| Hibajavítások | Apache JIRA |

|---|---|

| Perf-optimalizálások az ORC felosztási generációjában | HIVE-21457 |

| Kerülje a tábla ACID-ként való olvasását, ha a tábla neve "delta" névvel kezdődik, de a tábla nem tranzakciós, és a BI felosztási stratégiát használja | HIVE-22582 |

| FS#exists hívás eltávolítása az AcidUtils#getLogicalLength szolgáltatásból | HIVE-23533 |

| Vektorizált OrcAcidRowBatchReader.computeOffset és gyűjtőoptimalizálás | HIVE-17917 |

Ismert problémák

A HDInsight kompatibilis az Apache HIVE 3.1.2-vel. A jelen kiadás hibája miatt a Hive-verzió 3.1.0-s verzióként jelenik meg a Hive-felületeken. A funkcióra azonban nincs hatással.

Kiadás dátuma: 2022. 08. 10.

Ez a kiadás a HDInsight 4.0-ra vonatkozik. A HDInsight-kiadás több napon keresztül minden régió számára elérhetővé válik.

A HDInsight biztonságos üzembehelyezési eljárásokat használ, amelyek fokozatos régiótelepítést foglalnak magukban. Akár 10 munkanapot is igénybe vehet, ha egy új kiadás vagy egy új verzió minden régióban elérhetővé válik.

![]()

Új funkció

1. Külső lemezek csatolása HDI Hadoop-/Spark-fürtökben

A HDInsight-fürt SKU-n alapuló előre definiált lemezterülettel rendelkezik. Ez a hely nagy feladatok esetén nem biztos, hogy elegendő.

Ez az új funkció lehetővé teszi további lemezek hozzáadását a fürtben, amelyek csomópontkezelő helyi könyvtárként lesznek használva. A HIVE és a Spark-fürt létrehozása során adjon hozzá lemezeket a feldolgozó csomópontokhoz, míg a kijelölt lemezek a csomópontkezelő helyi könyvtárainak részei.

Feljegyzés

A hozzáadott lemezek csak a csomópontkezelő helyi könyvtáraihoz vannak konfigurálva.

2. Szelektív naplózási elemzés

A szelektív naplózási elemzés mostantól minden régióban elérhető a nyilvános előzetes verzióhoz. A fürtöt egy log analytics-munkaterülethez csatlakoztathatja. Ha engedélyezve van, megtekintheti a naplókat és metrikákat, például a HDInsight biztonsági naplóit, a Yarn Resource Managert, a rendszermetrikákat stb. Figyelheti a számítási feladatokat, és megtekintheti, hogy ezek hogyan befolyásolják a fürt stabilitását. A szelektív naplózás lehetővé teszi az összes tábla engedélyezését/letiltását, vagy a szelektív táblák engedélyezését a Log Analytics-munkaterületen. Az egyes táblák forrástípusát módosíthatja, mivel a Genf új verziójában egy tábla több forrással rendelkezik.

- A genfi monitorozási rendszer mdsd(MDS démont) használ, amely egy monitorozási ügynök, és folyékonyan használható a naplók egységes naplózási réteg használatával történő gyűjtéséhez.

- A szelektív naplózás szkriptművelettel tiltja le/engedélyezi a táblákat és a naplótípusokat. Mivel nem nyit meg új portokat, és nem módosítja a meglévő biztonsági beállításokat, nincsenek biztonsági változások.

- A szkriptművelet párhuzamosan fut az összes megadott csomóponton, és módosítja a konfigurációs fájlokat a táblák és a naplótípusok letiltására/engedélyezésére.

![]()

Rögzített méretű lemez

Log analytics

Az OMS 13-at futtató Azure HDInsighttal integrált Log Analytics használatához az OMS 14-es verziójára kell frissíteni a legújabb biztonsági frissítéseket. Az OMS 13-at használó régebbi fürtverziót használó ügyfeleknek telepíteniük kell az OMS 14-es verzióját a biztonsági követelményeknek való megfelelés érdekében. (Az aktuális verzió ellenőrzése és a 14-es telepítés)

Az OMS aktuális verziójának ellenőrzése

- Jelentkezzen be a fürtbe az SSH használatával.

- Futtassa az alábbi parancsot az SSH-ügyfélben.

sudo /opt/omi/bin/ominiserver/ --version

Az OMS-verzió frissítése 13-ról 14-re

- Jelentkezzen be az Azure Portalra

- Az erőforráscsoportban válassza ki a HDInsight-fürt erőforrását

- Szkriptműveletek kiválasztása

- A szkriptművelet elküldése panelen válassza a Szkripttípus egyéniként lehetőséget

- Illessze be a következő hivatkozást a Bash-szkript URL-cím mezőjébe https://hdiconfigactions.blob.core.windows.net/log-analytics-patch/OMSUPGRADE14.1/omsagent-vulnerability-fix-1.14.12-0.sh

- Csomóponttípus(ok) kiválasztása

- Válassza a Létrehozás elemet

Ellenőrizze a javítás sikeres telepítését az alábbi lépésekkel:

Jelentkezzen be a fürtbe az SSH használatával.

Futtassa az alábbi parancsot az SSH-ügyfélben.

sudo /opt/omi/bin/ominiserver/ --version

Egyéb hibajavítások

- A Yarn-napló parancssori felülete nem tudta lekérni a naplókat, ha valamelyik

TFilesérült vagy üres. - Az OAuth-jogkivonat az Azure Active Directoryból való lekérése során érvénytelen szolgáltatásnév-adathibát oldott fel.

- Továbbfejlesztett fürtlétrehozás megbízhatósága, ha több mint 100 működő csomópont van konfigurálva.

Nyílt forráskódú hibajavítások

TEZ hibajavítások

| Hibajavítások | Apache JIRA |

|---|---|

| Tez buildelési hibája: FileSaver.js nem található | TEZ-4411 |

Hibás FS-kivétel, ha a raktár és scratchdir a különböző FS-en van |

TEZ-4406 |

| TezUtils.createConfFromByteString on Configuration nagyobb, mint 32 MB dobja com.google.protobuf.CodedInputStream kivétel | TEZ-4142 |

| TezUtils::createByteStringFromConf kell használni snappy helyett DeflaterOutputStream | TEZ-4113 |

| Protobuf-függőség frissítése 3.x-ra | TEZ-4363 |

Hive hibajavítások

| Hibajavítások | Apache JIRA |

|---|---|

| Perf-optimalizálások az ORC felosztási generációjában | HIVE-21457 |

| Kerülje a tábla ACID-ként való olvasását, ha a tábla neve "delta" névvel kezdődik, de a tábla nem tranzakciós, és a BI felosztási stratégiát használja | HIVE-22582 |

| FS#exists hívás eltávolítása az AcidUtils#getLogicalLength szolgáltatásból | HIVE-23533 |

| Vektorizált OrcAcidRowBatchReader.computeOffset és gyűjtőoptimalizálás | HIVE-17917 |

Ismert problémák

A HDInsight kompatibilis az Apache HIVE 3.1.2-vel. A jelen kiadás hibája miatt a Hive-verzió 3.1.0-s verzióként jelenik meg a Hive-felületeken. A funkcióra azonban nincs hatással.

Kiadás dátuma: 2022.03.06.

Ez a kiadás a HDInsight 4.0-s verziójára vonatkozik. A HDInsight-kiadás több napon keresztül minden régió számára elérhetővé válik. Az itt látható kiadási dátum az első régió kiadási dátumát jelzi. Ha nem látja a következő módosításokat, várjon, amíg a kiadás több napig a régióban él.

Kiadási kiemelések

A Hive Warehouse-összekötő (HWC) a Spark 3.1.2-ben

A Hive Warehouse Connector (HWC) lehetővé teszi, hogy kihasználja a Hive és a Spark egyedi funkcióit a nagy teljesítményű big data-alkalmazások létrehozásához. A HWC jelenleg csak a Spark 2.4-ben támogatott. Ez a funkció üzleti értéket ad hozzá azáltal, hogy engedélyezi az ACID-tranzakciókat a Hive-táblákon a Spark használatával. Ez a funkció olyan ügyfelek számára hasznos, akik a Hive-t és a Sparkot is használják az adattulajdonukban. További információ: Apache Spark > Hive – Hive Warehouse Connector – Azure HDInsight | Microsoft Docs

Ambari

- Skálázási és kiépítési fejlesztések változásai

- A HDI-hive mostantól kompatibilis az OSS 3.1.2-es verziójával

A HDI Hive 3.1-es verziója az OSS Hive 3.1.2-re frissül. Ez a verzió az nyílt forráskód Hive 3.1.2-es verziójában elérhető összes javítást és funkciót tartalmazza.

Feljegyzés

Spark

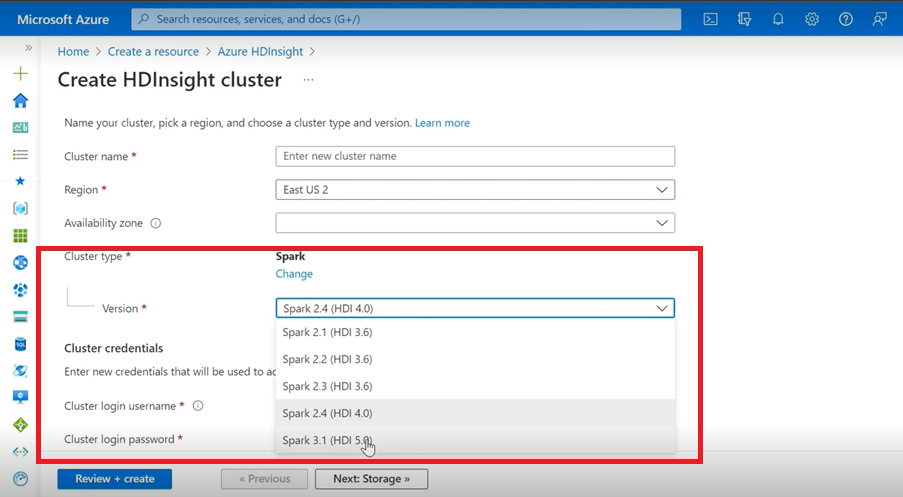

- Ha azure-beli felhasználói felületet használ a HdInsighthoz készült Spark-fürt létrehozásához, a legördülő listából egy másik Spark 3.1-es verzió jelenik meg. (HDI 5.0) és a régebbi verziók. Ez a verzió a Spark 3.1 átnevezett verziója. (HDI 4.0). Ez csak egy felhasználói felületi szintű változás, amely semmit sem érint az ARM-sablont már használó meglévő felhasználókra és felhasználókra.

Feljegyzés

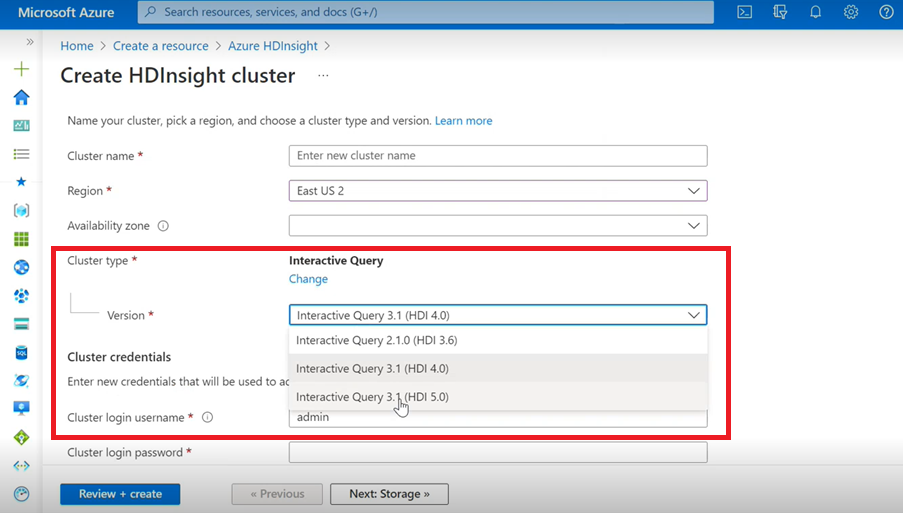

Interaktív lekérdezés

- Ha interaktív lekérdezésfürtöt hoz létre, a legördülő listában megjelenik egy másik verzió, mint Interaktív lekérdezés 3.1 (HDI 5.0).

- Ha a Spark 3.1-es verzióját és az ACID-támogatást igénylő Hive-t fogja használni, akkor ezt a verziót kell kiválasztania az Interactive Query 3.1 (HDI 5.0).

TEZ hibajavítások

| Hibajavítások | Apache JIRA |

|---|---|

| TezUtils.createConfFromByteString on Configuration nagyobb, mint 32 MB dobja com.google.protobuf.CodedInputStream kivétel | TEZ-4142 |

| A TezUtils createByteStringFromConf beépülő modult kell használnia a DeflaterOutputStream helyett | TEZ-4113 |

HBase-hibajavítások

| Hibajavítások | Apache JIRA |

|---|---|

A TableSnapshotInputFormat a ReadType.STREAM-et használja a vizsgálathoz HFiles |

HBASE-26273 |

| A scanMetrics letiltására használható beállítás hozzáadása a TableSnapshotInputFormat alkalmazásban | HBASE-26330 |

| A ArrayIndexOutOfBoundsException javítása a kiegyensúlyozó végrehajtásakor | HBASE-22739 |

Hive hibajavítások

| Hibajavítások | Apache JIRA |

|---|---|

| NPE az adatok "distribute by" záradékkal való beszúrásakor a dynpart rendezési optimalizálással | HIVE-18284 |

| Az MSCK REPAIR parancs partíciószűréssel meghiúsul a partíciók elvetése közben | HIVE-23851 |

| Hibás kivétel történt, ha kapacitás<=0 | HIVE-25446 |

| Párhuzamos terhelés támogatása HastTables esetén – Interfészek | HIVE-25583 |

| MultiDelimitSerDe alapértelmezés szerint belefoglalása a HiveServer2-be | HIVE-20619 |

| Távolítsa el a glassfish.jersey és mssql-jdbc osztályokat a jdbc-standalone jar-ból | HIVE-22134 |

| Null mutató kivétele mm-tábla tömörítésének futtatása esetén. | HIVE-21280 |

Nagy méretű knox hive-lekérdezés meghiúsult a hibás cső írása miatt |

HIVE-22231 |

| A felhasználó kötési felhasználó beállítási lehetőségének hozzáadása | HIVE-21009 |

| Az UDF implementálása a dátum/időbélyeg belső ábrázolása és a Gergely-Julián hibrid naptár használatával történő értelmezéséhez | HIVE-22241 |

| Beeline beállítás végrehajtási jelentés megjelenítésére/megjelenítésére | HIVE-22204 |

| Tez: A SplitGenerator megpróbálja megkeresni a tervfájlokat, amelyek nem léteznek a Tez számára | HIVE-22169 |

Költséges naplózás eltávolítása az LLAP-gyorsítótárból hotpath |

HIVE-22168 |

| UDF: A FunctionRegistry szinkronizálja az org.apache.hadoop.hive.ql.udf.UDFType osztályt | HIVE-22161 |

| A lekérdezés-útválasztási hozzáfűző létrehozásának megakadályozása, ha a tulajdonság értéke hamis | HIVE-22115 |

| A partíció-eval keresztlekérdezés szinkronizálásának eltávolítása | HIVE-22106 |

| A hive scratch dir beállításának kihagyása a tervezés során | HIVE-21182 |

| Ha az RPC be van kapcsolva, hagyja ki a karcnaplók létrehozását a tezhez | HIVE-21171 |

a Hive UDF-ek váltása regex motor használatára Re2J |

HIVE-19661 |

| A hive 3-on az 1. bucketing_version használatával migrált fürtözött táblák bucketing_version 2-et használnak a beszúrásokhoz | HIVE-22429 |

| Gyűjtőzés: Az 1. verzió gyűjtőbe helyezése helytelenül particionál adatokat | HIVE-21167 |

| ASF-licenc fejlécének hozzáadása az újonnan hozzáadott fájlhoz | HIVE-22498 |

| Sémaeszköz fejlesztései a mergeCatalog támogatásához | HIVE-22498 |

| A TEZ UNION ALL és az UDTF használatával végzett hive adatvesztést eredményez | HIVE-21915 |

| Szövegfájlok felosztása akkor is, ha élőfej/élőláb létezik | HIVE-21924 |

| A MultiDelimitSerDe helytelen eredményeket ad vissza az utolsó oszlopban, ha a betöltött fájl több oszlopot tartalmaz, mint a táblasémában. | HIVE-22360 |

| LLAP külső ügyfél – Csökkenteni kell a LlapBaseInputFormat#getSplits() lábnyomát | HIVE-22221 |

| A fenntartott kulcsszóval rendelkező oszlopnév nem lesz eltávolítva, ha a lekérdezés, beleértve a maszkoszlopot tartalmazó táblához való csatlakozást is (Matyus Zoltán haindrich Zoltánon keresztül) | HIVE-22208 |

LLAP-leállítás megakadályozása kapcsolódó RuntimeException esetén AMReporter |

HIVE-22113 |

| Előfordulhat, hogy az LLAP állapotszolgáltatás-illesztőprogramja hibás Yarn-alkalmazásazonosítóval elakad | HIVE-21866 |

| Az OperationManager.queryIdOperation nem törli megfelelően a több lekérdezésazonosítót | HIVE-22275 |

| A csomópontkezelő leállása blokkolja az LLAP szolgáltatás újraindítását | HIVE-22219 |

| StackOverflowError sok partíció elvetésekor | HIVE-15956 |

| A hozzáférés-ellenőrzés sikertelen, ha egy ideiglenes könyvtárat eltávolítanak | HIVE-22273 |

| Hibás eredmények kijavítása/ArrayOutOfBound kivétel a bal oldali külső térképcsatlakozásokban adott határfeltételeken | HIVE-22120 |

| Terjesztési felügyeleti címke eltávolítása a pom.xml | HIVE-19667 |

| Az elemzési idő magas lehet, ha mélyen beágyazott al lekérdezések vannak | HIVE-21980 |

Az ALTER TABLE t SET TBLPROPERTIES ('EXTERNAL'='TRUE'); TBL_TYPE nem CAPS-hez nem tükröző attribútummódosítások |

HIVE-20057 |

JDBC: A HiveConnection árnyékolja az log4j interfészeket |

HIVE-18874 |

Adattár URL-címeinek frissítése a 3.1-es ág verziójában poms |

HIVE-21786 |

DBInstall a főkiszolgálón és a branch-3.1-en megszakadt tesztek |

HIVE-21758 |

| Az adatok gyűjtőbe való betöltése figyelmen kívül hagyja a partíciók specifikációit, és betölti az adatokat az alapértelmezett partícióba | HIVE-21564 |

| Olyan lekérdezések, amelyekhez az illesztési feltétel időbélyeggel vagy időbélyeggel rendelkezik a helyi időzóna literális dobása SzemanticException használatával | HIVE-21613 |

| A HDFS-en futó átmeneti dir mögött hagyott oszlopok számítási statisztikáinak elemzése | HIVE-21342 |

| Inkompatibilis változás a Hive-gyűjtő számításában | HIVE-21376 |

| Tartalék engedélyező megadása, ha nincs használatban más engedélyező | HIVE-20420 |

| Néhány alterPartitions invocations throw "NumberFormatException: null" | HIVE-18767 |

| HiveServer2: Bizonyos esetekben a http-átvitel előhitelesített tárgya nem marad meg a HTTP-kommunikáció teljes időtartama alatt | HIVE-20555 |

Kiadás dátuma: 2022.03.10.

Ez a kiadás a HDInsight 4.0-s verziójára vonatkozik. A HDInsight-kiadás több napon keresztül minden régió számára elérhetővé válik. Az itt látható kiadási dátum az első régió kiadási dátumát jelzi. Ha nem látja a következő módosításokat, várjon, amíg a kiadás több napig a régióban él.

A kiadás operációsrendszer-verziói a következők:

- HDInsight 4.0: Ubuntu 18.04.5

Általánosan elérhető a Spark 3.1

A Spark 3.1 mostantól általánosan elérhető a HDInsight 4.0-s kiadásában. Ez a kiadás tartalmazza a

- Adaptív lekérdezés végrehajtása,

- Rendezési egyesítési illesztés átalakítása szórásos kivonatos illesztéssé,

- Spark Catalyst Optimizer,

- Dinamikus partíciómetszet,

- Az ügyfelek új Spark 3.1-fürtöket hozhatnak létre, és nem Spark 3.0-s (előzetes verziójú) fürtöket.

További információ: Az Apache Spark 3.1 mostantól általánosan elérhető a HDInsighton – Microsoft Tech Community.

A fejlesztések teljes listáját az Apache Spark 3.1 kibocsátási megjegyzéseiben találja.

A migrálással kapcsolatos további információkért tekintse meg a migrálási útmutatót .

A Kafka 2.4 már általánosan elérhető

A Kafka 2.4.1 mostantól általánosan elérhető. További információ: Kafka 2.4.1 Kibocsátási megjegyzések. További funkciók: MirrorMaker 2 rendelkezésre állás, új metrikakategória AtMinIsr témakörpartíció, továbbfejlesztett közvetítő indítási ideje lusta igény szerint mmap indexfájlok, további fogyasztói metrikák a felhasználói szavazás viselkedésének megfigyeléséhez.

A HWC adattípusának leképezése mostantól támogatott a HDInsight 4.0-ban

Ez a kiadás tartalmazza a Map Datatype támogatást a HWC 1.0-hoz (Spark 2.4) a Spark-shell alkalmazáson keresztül, és minden más spark-ügyfelet, amelyet a HWC támogat. Az alábbi fejlesztések a többi adattípushoz hasonlóan az alábbiakat tartalmazzák:

A felhasználó

- Hozzon létre egy Hive-táblát a Map adattípust tartalmazó oszlop(ok)ból, szúrjon be adatokat, és olvassa el az eredményeket.

- Hozzon létre egy Apache Spark-adatkeretet térképtípussal, és végezze el a köteg/stream olvasását és írását.

Új régiók

A HDInsight mostantól két új régióra bővítette földrajzi jelenlétét: Kína keleti régiója 3. és Kína északi régiója 3.

OSS-háttérjelentés változásai

A Hive-ben található OSS-háttérjelentések, beleértve a HWC 1.0-t (Spark 2.4), amely támogatja a Térkép adattípust.

A jelen kiadáshoz az OSS által támogatott Apache JIRA-k tartoznak:

| Érintett funkció | Apache JIRA |

|---|---|

| Az IN/(NOT IN) metaadattár közvetlen SQL-lekérdezéseit az SQL DB által megengedett maximális paraméterek alapján kell felosztani | HIVE-25659 |

Frissítés log4j 2.16.0-ra 2.17.0-ra |

HIVE-25825 |

Verzió frissítése Flatbuffer |

HIVE-22827 |

| Az adattípus natív leképezésének támogatása Nyíl formátumban | HIVE-25553 |

| LLAP külső ügyfél – Beágyazott értékek kezelése null értékű szülőstruktúra esetén | HIVE-25243 |

| A nyílverzió frissítése a 0.11.0-ra | HIVE-23987 |

Elavulással kapcsolatos közlemények

Azure-beli virtuálisgép-méretezési csoportok a HDInsighton

A HDInsight a továbbiakban nem fogja használni az Azure Virtual Machine Scale Setset a fürtök kiépítéséhez, nem várható kompatibilitástörő változás. A virtuálisgép-méretezési csoportok meglévő HDInsight-fürtjeinek nincs hatása, a legújabb rendszerképeken lévő új fürtök már nem fogják használni a virtuálisgép-méretezési csoportokat.

Az Azure HDInsight HBase számítási feladatainak skálázása mostantól csak manuális méretezéssel támogatott

2022. március 01-től a HDInsight csak a HBase manuális méretezését támogatja, nincs hatással a futó fürtökre. Az új HBase-fürtök nem fogják tudni engedélyezni az ütemezésalapú automatikus skálázást. A HBase-fürt manuális méretezéséről további információt az Azure HDInsight-fürtök manuális skálázásával kapcsolatos dokumentációnkban talál.

Kiadás dátuma: 2021. 12. 27.

Ez a kiadás a HDInsight 4.0-s verziójára vonatkozik. A HDInsight-kiadás több napon keresztül minden régió számára elérhetővé válik. Az itt látható kiadási dátum az első régió kiadási dátumát jelzi. Ha nem látja a következő módosításokat, várjon, amíg a kiadás több napig a régióban él.

A kiadás operációsrendszer-verziói a következők:

- HDInsight 4.0: Ubuntu 18.04.5 LTS

A HDInsight 4.0-s rendszerképe frissült, hogy enyhítse Log4j a biztonsági réseket a Microsoft CVE-2021-44228 Apache Log4j 2-re adott válaszában leírtak szerint.

Feljegyzés

- A 2021. december 27. 00:00 (UTC) után létrehozott HDI 4.0-fürtök a rendszerkép frissített verziójával jönnek létre, amely csökkenti a

log4jbiztonsági réseket. Ezért az ügyfeleknek nem kell kijavítani/újraindítani ezeket a fürtöket. - Az új HDInsight 4.0-fürtök esetében, amelyeket 2021. december 16., 01:15 (UTC) és 2021. december 27. 00:00 (UTC) között hoztak létre, HDInsight 3.6 vagy rögzített előfizetésekben 2021. december 16. után a rendszer automatikusan alkalmazza a javítást a fürt létrehozásának egy órájában, azonban az ügyfeleknek újra kell indítaniuk a csomópontokat a javítás befejezéséhez (kivéve a Kafka Management-csomópontokat, automatikusan újraindulnak).

Kiadás dátuma: 2021. 07. 27.

Ez a kiadás a HDInsight 3.6-os és a HDInsight 4.0-s verziójára is vonatkozik. A HDInsight-kiadás több napon keresztül minden régió számára elérhetővé válik. Az itt látható kiadási dátum az első régió kiadási dátumát jelzi. Ha nem látja a következő módosításokat, várjon, amíg a kiadás több napon belül a régióban él.

A kiadás operációsrendszer-verziói a következők:

- HDInsight 3.6: Ubuntu 16.04.7 LTS

- HDInsight 4.0: Ubuntu 18.04.5 LTS

Új funkciók

Az Azure HDInsight korlátozott nyilvános kapcsolatok támogatása 2021. október 15-én általánosan elérhető

Az Azure HDInsight mostantól minden régióban támogatja a korlátozott nyilvános kapcsolatot. Az alábbiakban bemutatjuk a képesség főbb főbb jellemzőit:

- Lehetőség az erőforrás-szolgáltató fürtkommunikációra való megfordítására, hogy az a fürtről az erőforrás-szolgáltató felé irányuló kimenő forgalomra legyen képes

- Saját Private Link-kompatibilis erőforrások (például tárolás, SQL, kulcstartó) HDInsight-fürthöz való elérésének támogatása az erőforrások csak magánhálózaton keresztüli eléréséhez

- Nincs kiépített nyilvános IP-cím

Ezzel az új funkcióval kihagyhatja a HDInsight felügyeleti IP-címeinek bejövő hálózati biztonsági csoport (NSG) szolgáltatáscímkéinek szabályait is. További információ a nyilvános kapcsolatok korlátozásáról

Az Azure HDInsight támogatása az Azure Private Linkhez 2021. október 15-én általánosan elérhető

Mostantól privát végpontokkal is csatlakozhat a HDInsight-fürtökhöz privát kapcsolaton keresztül. A privát kapcsolat olyan virtuális hálózatok közötti forgatókönyvekben használható, ahol a virtuális hálózatok közötti társviszony-létesítés nem érhető el vagy engedélyezve van.

Az Azure Private Link lehetővé teszi az Azure PaaS-szolgáltatások (például az Azure Storage és az SQL Database) és az Azure által üzemeltetett ügyfél-/partnerszolgáltatások elérését a virtuális hálózat egy privát végpontján keresztül.

A virtuális hálózat és a szolgáltatás közötti forgalom a Microsoft gerinchálózatán halad át. Ezáltal kiküszöbölhető a szolgáltatás nyilvános internetes kitettsége.

Engedélyezze a privát kapcsolat engedélyezését.

Új Azure Monitor-integrációs felület (előzetes verzió)

Az új Azure Monitor-integrációs felület az USA keleti régiójában és Nyugat-Európában jelenik meg ezzel a kiadással. Az új Azure Monitor-felületről itt talál további információt.

Elavulás

A HDInsight 3.6-os verziója 2022. október 01-én elavult.

Viselkedésbeli változások

A HDInsight Interaktív lekérdezés csak az ütemezésalapú automatikus skálázást támogatja

Ahogy az ügyfélforgatókönyvek egyre kiforrottabbak és változatosabbak lesznek, az Interaktív lekérdezés (LLAP) terhelésalapú automatikus skálázása bizonyos korlátozásokat azonosított. Ezeket a korlátozásokat az LLAP-lekérdezések dinamikájának természete, a jövőbeli terhelés-előrejelzés pontossági problémái és az LLAP-ütemező tevékenység-újraelosztásával kapcsolatos problémák okozzák. Ezen korlátozások miatt előfordulhat, hogy a felhasználók azt látják, hogy a lekérdezések lassabban futnak az LLAP-fürtökön, ha az automatikus skálázás engedélyezve van. A teljesítményre gyakorolt hatás felülmúlhatja az automatikus skálázás költségelőnyét.

2021 júliusától a HDInsight interaktív lekérdezési számítási feladatai csak az ütemezésalapú automatikus skálázást támogatják. Az új interaktív lekérdezésfürtökön már nem engedélyezheti a terhelésalapú automatikus skálázást. A meglévő futó fürtök továbbra is futtathatók a fent ismertetett ismert korlátozásokkal.

A Microsoft azt javasolja, hogy az LLAP ütemezésalapú automatikus skálázására váltson. A fürt aktuális használati mintáját a Grafana Hive irányítópulton elemezheti. További információ: Azure HDInsight-fürtök automatikus méretezése.

Közelgő változások

A következő változások a közelgő kiadásokban történnek.

Az ESP Spark-fürt beépített LLAP-összetevője el lesz távolítva

A HDInsight 4.0 ESP Spark-fürt beépített LLAP-összetevőkkel rendelkezik, és mindkét fejcsomóponton fut. Az ESP Spark-fürt LLAP-összetevői eredetileg a HDInsight 3.6 ESP Sparkhoz lettek hozzáadva, de a HDInsight 4.0 ESP Sparkhoz nincs valós felhasználói esete. A következő, 2021 szeptemberében ütemezett kiadásban a HDInsight eltávolítja a beépített LLAP-összetevőt a HDInsight 4.0 ESP Spark-fürtből. Ez a módosítás segít kiépíteni a csomópontok számítási feladatait, és elkerülheti az ESP Spark és az ESP Interaktív Hive-fürttípus közötti félreértéseket.

Új régió

- USA 3. nyugati régiója

JioNyugat-India- Ausztrália középső régiója

Összetevő verzióváltozása

Ezzel a kiadással a következő összetevőverzió módosult:

- ORC-verzió 1.5.1-től 1.5.9-es verzióig

Ebben a dokumentumban megtalálhatja a HDInsight 4.0 és a HDInsight 3.6 aktuális összetevőverzióit.

Visszahordott JIRA-k

A kiadáshoz a háttérportolt Apache JIRA-k a következők:

| Érintett funkció | Apache JIRA |

|---|---|

| Dátum/időbélyeg | HIVE-25104 |

| HIVE-24074 | |

| HIVE-22840 | |

| HIVE-22589 | |

| HIVE-22405 | |

| HIVE-21729 | |

| HIVE-21291 | |

| HIVE-21290 | |

| UDF | HIVE-25268 |

| HIVE-25093 | |

| HIVE-22099 | |

| HIVE-24113 | |

| HIVE-22170 | |

| HIVE-22331 | |

| ORK | HIVE-21991 |

| HIVE-21815 | |

| HIVE-21862 | |

| Táblaséma | HIVE-20437 |

| HIVE-22941 | |

| HIVE-21784 | |

| HIVE-21714 | |

| HIVE-18702 | |

| HIVE-21799 | |

| HIVE-21296 | |

| Számítási feladatok kezelése | HIVE-24201 |

| Tömörítés | HIVE-24882 |

| HIVE-23058 | |

| HIVE-23046 | |

| Tényleges táblán alapuló nézet | HIVE-22566 |

HDInsight Dv2 virtuális gépek árkorrekciója

2021. április 25-én kijavítottunk egy díjszabási hibát a Dv2 HDInsight virtuálisgép-sorozatában. A díjszabási hiba miatt április 25-e előtt néhány ügyfél számláinak díja csökkent, és a javítással az árak most már megegyeznek a HDInsight díjszabási oldalán és a HDInsight díjszabási kalkulátorban meghirdetett árakkalkulátorral. A díjszabási hiba a következő régiókban lévő, virtuális gépeket használó Dv2 ügyfeleket érintette:

- Közép-Kanada

- Kelet-Kanada

- Kelet-Ázsia

- Dél-Afrika északi régiója

- Délkelet-Ázsia

- Egyesült Arab Emírségek középső régiója

2021. április 25-től a virtuális gépek korrigált összege Dv2 az Ön fiókjában lesz. Az ügyfélértesítéseket a rendszer a módosítás előtt elküldte az előfizetés-tulajdonosoknak. A tarifakalkulátor, a HDInsight díjszabási lapja vagy a HDInsight-fürt létrehozása panel az Azure Portalon a régióban lévő virtuális gépek korrigált költségeinek Dv2 megtekintéséhez használható.

Nincs szükség más műveletre. Az árkorrekció csak a megadott régiókban 2021. április 25-én vagy azt követően érvényes használatra vonatkozik, az ezen időpontot megelőző használatra nem. Annak érdekében, hogy a legeredményesebb és legköltséghatékonyabb megoldással rendelkezzen, javasoljuk, hogy tekintse át a fürtök díjszabását, a VCPU-t és a RAM-ot Dv2 , és hasonlítsa össze a Dv2 specifikációkat a Ev3 virtuális gépekkel, és ellenőrizze, hogy a megoldás kihasználná-e az újabb virtuálisgép-sorozatok egyikét.

Kiadás dátuma: 2021. 02. 06.

Ez a kiadás a HDInsight 3.6-os és a HDInsight 4.0-s verziójára is vonatkozik. A HDInsight-kiadás több napon keresztül minden régió számára elérhetővé válik. Az itt látható kiadási dátum az első régió kiadási dátumát jelzi. Ha nem látja a következő módosításokat, várjon, amíg a kiadás több napon belül a régióban él.

A kiadás operációsrendszer-verziói a következők:

- HDInsight 3.6: Ubuntu 16.04.7 LTS

- HDInsight 4.0: Ubuntu 18.04.5 LTS

Új funkciók

Operációs rendszer verziófrissítése

Az Ubuntu kiadási ciklusában hivatkozott Ubuntu 16.04 kernel 2021 áprilisában éri el az End of Life (EOL) rendszert. Ezzel a kiadással elindítottuk az Ubuntu 18.04-en futó új HDInsight 4.0-fürtrendszerképet. Az újonnan létrehozott HDInsight 4.0-fürtök alapértelmezés szerint az Ubuntu 18.04-en futnak, amint elérhetők. Az Ubuntu 16.04 meglévő fürtöi ugyanúgy futnak, mint a teljes támogatással.

A HDInsight 3.6 továbbra is az Ubuntu 16.04-en fog futni. 2021. július 1-től alapszintű támogatásra vált (a Standard támogatástól kezdve). A dátumokkal és a támogatási lehetőségekkel kapcsolatos további információkért tekintse meg az Azure HDInsight verzióit. Az Ubuntu 18.04 nem támogatott a HDInsight 3.6-hoz. Ha az Ubuntu 18.04-et szeretné használni, át kell telepítenie a fürtöket a HDInsight 4.0-ra.

Ha meglévő HDInsight 4.0-fürtöket szeretne áthelyezni az Ubuntu 18.04-re, el kell helyeznie és újra létre kell hoznia a fürtöket. Tervezze meg a fürtök létrehozását vagy újbóli létrehozását az Ubuntu 18.04-támogatás elérhetővé válása után.

Az új fürt létrehozása után SSH-t adhat a fürthöz, és futtathatja sudo lsb_release -a annak ellenőrzéséhez, hogy az Ubuntu 18.04-es rendszeren fut-e. Javasoljuk, hogy az éles környezetbe való áttérés előtt tesztelje az alkalmazásokat a teszt-előfizetésekben.

A HBase gyorsított írási fürtöinek skálázási optimalizálása

A HDInsight továbbfejlesztette és optimalizálta a HBase által gyorsított írásvédett fürtök skálázását. További információ a HBase gyorsított írásáról.

Elavulás

Ebben a kiadásban nincs elavulás.

Viselkedésbeli változások

A HDInsight 4.0 főcsomópontjaként Stardard_A5 virtuális gép méretének letiltása

A HDInsight-fürtfőcsomópont felelős a fürt inicializálásáért és felügyeletéért. Standard_A5 virtuális gép mérete megbízhatósági problémákat tapasztal a HDInsight 4.0 fő csomópontjaként. Ettől a kiadástól kezdve az ügyfelek nem hozhatnak létre új fürtöket, Standard_A5 virtuálisgép-mérettel főcsomópontként. Más kétmagos virtuális gépeket is használhat, például E2_v3 vagy E2s_v3. A meglévő fürtök a jelenlegi módon fognak futni. A head node-hoz erősen ajánlott négymagos virtuális gép, amely biztosítja az éles HDInsight-fürtök magas rendelkezésre állását és megbízhatóságát.

A hálózati adapter erőforrása nem látható az Azure-beli virtuálisgép-méretezési csoportokon futó fürtök esetében

A HDInsight fokozatosan migrál az Azure-beli virtuálisgép-méretezési csoportokba. A virtuális gépek hálózati adapterei már nem láthatók az ügyfelek számára az Azure-beli virtuálisgép-méretezési csoportokat használó fürtök számára.

Közelgő változások

A következő változások a következő kiadásokban fognak történni.

A HDInsight Interaktív lekérdezés csak az ütemezésalapú automatikus skálázást támogatja

Ahogy az ügyfélforgatókönyvek egyre kiforrottabbak és változatosabbak lesznek, az Interaktív lekérdezés (LLAP) terhelésalapú automatikus skálázása bizonyos korlátozásokat azonosított. Ezeket a korlátozásokat az LLAP-lekérdezések dinamikájának természete, a jövőbeli terhelés-előrejelzés pontossági problémái és az LLAP-ütemező tevékenység-újraelosztásával kapcsolatos problémák okozzák. Ezen korlátozások miatt előfordulhat, hogy a felhasználók azt látják, hogy a lekérdezések lassabban futnak az LLAP-fürtökön, ha az automatikus skálázás engedélyezve van. A teljesítményre gyakorolt hatás felülmúlhatja az automatikus skálázás költségelőnyét.

2021 júliusától a HDInsight interaktív lekérdezési számítási feladatai csak az ütemezésalapú automatikus skálázást támogatják. Az automatikus skálázás már nem engedélyezhető az új interaktív lekérdezési fürtökön. A meglévő futó fürtök továbbra is futtathatók a fent ismertetett ismert korlátozásokkal.

A Microsoft azt javasolja, hogy az LLAP ütemezésalapú automatikus skálázására váltson. A fürt aktuális használati mintáját a Grafana Hive irányítópulton elemezheti. További információ: Azure HDInsight-fürtök automatikus méretezése.

A virtuálisgép-gazdagép elnevezése 2021. július 1-jén módosul

A HDInsight mostantól Azure-beli virtuális gépeket használ a fürt kiépítéséhez. A szolgáltatás fokozatosan migrál az Azure-beli virtuálisgép-méretezési csoportokba. Ez az áttelepítés megváltoztatja a fürt gazdagépének teljes tartományneve névformátumát, és az állomásnévben szereplő számok nem lesznek garantálva egymás után. Ha az egyes csomópontok teljes tartományneveit szeretné lekérni, tekintse meg a fürtcsomópontok gazdagépneveit.

Váltás azure-beli virtuálisgép-méretezési csoportokra

A HDInsight mostantól Azure-beli virtuális gépeket használ a fürt kiépítéséhez. A szolgáltatás fokozatosan migrál az Azure-beli virtuálisgép-méretezési csoportokba. A teljes folyamat hónapokig is eltarthat. A régiók és előfizetések migrálása után az újonnan létrehozott HDInsight-fürtök ügyfélműveletek nélkül fognak futni a virtuálisgép-méretezési csoportokon. Nem várható kompatibilitástörő változás.

Kiadás dátuma: 2021. 03. 24.

Új funkciók

Spark 3.0 előzetes verzió

A HDInsight a Spark 3.0.0 támogatását hozzáadta a HDInsight 4.0-hoz előzetes verziójú funkcióként.

Kafka 2.4 előzetes verzió

A HDInsight hozzáadta a Kafka 2.4.1-támogatást a HDInsight 4.0-hoz előzetes verziójú funkcióként.

Eav4-sorozat támogatása

Ebben a kiadásban a HDInsight -series támogatást adott hozzá Eav4.

Váltás Azure-beli virtuálisgép-méretezési csoportokra

A HDInsight mostantól Azure-beli virtuális gépeket használ a fürt kiépítéséhez. A szolgáltatás fokozatosan migrál az Azure-beli virtuálisgép-méretezési csoportokba. A teljes folyamat hónapokig is eltarthat. A régiók és előfizetések migrálása után az újonnan létrehozott HDInsight-fürtök ügyfélműveletek nélkül fognak futni a virtuálisgép-méretezési csoportokon. Nem várható kompatibilitástörő változás.

Elavulás

Ebben a kiadásban nincs elavulás.

Viselkedésbeli változások

A fürt alapértelmezett verziója 4.0-ra módosul

A HDInsight-fürt alapértelmezett verziója 3.6-ról 4.0-ra módosul. Az elérhető verziókkal kapcsolatos további információkért tekintse meg az elérhető verziókat. További információ a HDInsight 4.0 újdonságairól.

Az alapértelmezett fürt virtuálisgép-méretei -series értékre változnak Ev3

A fürt alapértelmezett virtuálisgép-méretei D sorozatról -sorozatra változnak Ev3. Ez a módosítás a fő csomópontokra és a feldolgozó csomópontokra vonatkozik. Annak érdekében, hogy ez a módosítás ne befolyásolja a tesztelt munkafolyamatokat, adja meg az ARM-sablonban használni kívánt virtuálisgép-méreteket.

A hálózati adapter erőforrása nem látható az Azure-beli virtuálisgép-méretezési csoportokon futó fürtök esetében

A HDInsight fokozatosan migrál az Azure-beli virtuálisgép-méretezési csoportokba. A virtuális gépek hálózati adapterei már nem láthatók az ügyfelek számára az Azure-beli virtuálisgép-méretezési csoportokat használó fürtök számára.

Közelgő változások

A következő változások a következő kiadásokban fognak történni.

A HDInsight Interaktív lekérdezés csak az ütemezésalapú automatikus skálázást támogatja

Ahogy az ügyfélforgatókönyvek egyre kiforrottabbak és változatosabbak lesznek, az Interaktív lekérdezés (LLAP) terhelésalapú automatikus skálázása bizonyos korlátozásokat azonosított. Ezeket a korlátozásokat az LLAP-lekérdezések dinamikájának természete, a jövőbeli terhelés-előrejelzés pontossági problémái és az LLAP-ütemező tevékenység-újraelosztásával kapcsolatos problémák okozzák. Ezen korlátozások miatt előfordulhat, hogy a felhasználók azt látják, hogy a lekérdezések lassabban futnak az LLAP-fürtökön, ha az automatikus skálázás engedélyezve van. A teljesítményre gyakorolt hatás meghaladja az automatikus skálázás költségelőnyét.

2021 júliusától a HDInsight interaktív lekérdezési számítási feladatai csak az ütemezésalapú automatikus skálázást támogatják. Az automatikus skálázás már nem engedélyezhető az új interaktív lekérdezési fürtökön. A meglévő futó fürtök továbbra is futtathatók a fent ismertetett ismert korlátozásokkal.

A Microsoft azt javasolja, hogy az LLAP ütemezésalapú automatikus skálázására váltson. A fürt aktuális használati mintáját a Grafana Hive irányítópulton elemezheti. További információ: Azure HDInsight-fürtök automatikus méretezése.

Operációs rendszer verziófrissítése

A HDInsight-fürtök jelenleg az Ubuntu 16.04 LTS-en futnak. Az Ubuntu kiadási ciklusában hivatkozott Ubuntu 16.04 kernel 2021 áprilisában éri el az End of Life (EOL) rendszert. Az Ubuntu 18.04-en futó új HDInsight 4.0-s fürtrendszerképet 2021 májusában fogjuk elindítani. Az újonnan létrehozott HDInsight 4.0-fürtök alapértelmezés szerint az Ubuntu 18.04-en futnak, amint elérhetők. Az Ubuntu 16.04 meglévő fürtöi ugyanúgy futnak, mint a teljes támogatással.

A HDInsight 3.6 továbbra is az Ubuntu 16.04-en fog futni. 2021. június 30-ig megszűnik a standard támogatás, és 2021. július 1-től alapszintű támogatásra változik. A dátumokkal és a támogatási lehetőségekkel kapcsolatos további információkért tekintse meg az Azure HDInsight verzióit. Az Ubuntu 18.04 nem támogatott a HDInsight 3.6-hoz. Ha az Ubuntu 18.04-et szeretné használni, át kell telepítenie a fürtöket a HDInsight 4.0-ra.

Ha meglévő fürtöket szeretne áthelyezni az Ubuntu 18.04-re, el kell helyeznie és újra létre kell hoznia a fürtöket. Tervezze meg a fürt létrehozását vagy újbóli létrehozását az Ubuntu 18.04-támogatás elérhetővé válása után. Egy újabb értesítést küldünk, miután az új rendszerkép minden régióban elérhetővé válik.

Erősen ajánlott, hogy előre tesztelje a szkriptműveleteket és a peremcsomópontokon üzembe helyezett egyéni alkalmazásokat egy Ubuntu 18.04 virtuális gépen (VM). Létrehozhat Ubuntu Linux rendszerű virtuális gépet a 18.04-LTS-en, majd létrehozhat és használhat egy biztonságos rendszerhéj-(SSH-) kulcspárt a virtuális gépen a szkriptműveletek és a peremcsomópontokon üzembe helyezett egyéni alkalmazások futtatásához és teszteléséhez.

A HDInsight 4.0 főcsomópontjaként Stardard_A5 virtuális gép méretének letiltása

A HDInsight-fürtfőcsomópont felelős a fürt inicializálásáért és felügyeletéért. Standard_A5 virtuális gép mérete megbízhatósági problémákat tapasztal a HDInsight 4.0 fő csomópontjaként. A következő, 2021. májusi kiadástól kezdve az ügyfelek nem hozhatnak létre új fürtöket, Standard_A5 virtuálisgép-méretet főcsomópontként. Más kétmagos virtuális gépeket is használhat, például E2_v3 vagy E2s_v3. A meglévő fürtök a jelenlegi módon fognak futni. Az éles HDInsight-fürtök magas rendelkezésre állása és megbízhatósága érdekében a head node-hoz erősen ajánlott egy négymagos virtuális gép.

Hibajavítások

A HDInsight továbbra is fejleszti a fürt megbízhatóságát és teljesítményét.

Összetevő verzióváltozása

A Spark 3.0.0 és a Kafka 2.4.1 előzetes verziója is támogatott. Ebben a dokumentumban megtalálhatja a HDInsight 4.0 és a HDInsight 3.6 aktuális összetevőverzióit.

Kiadás dátuma: 2021.05.02.

Ez a kiadás a HDInsight 3.6-os és a HDInsight 4.0-s verziójára is vonatkozik. A HDInsight-kiadás több napon keresztül minden régió számára elérhetővé válik. Az itt látható kiadási dátum az első régió kiadási dátumát jelzi. Ha nem látja a következő módosításokat, várjon, amíg a kiadás több napon belül a régióban él.

Új funkciók

Dav4-sorozat támogatása

A HDInsight ebben a kiadásban dav4-sorozatú támogatást adott hozzá. További információ a Dav4-sorozatról itt.

Kafka REST Proxy GA