Megjegyzés

Az oldalhoz való hozzáféréshez engedély szükséges. Megpróbálhat bejelentkezni vagy módosítani a címtárat.

Az oldalhoz való hozzáféréshez engedély szükséges. Megpróbálhatja módosítani a címtárat.

A Microsoft Fabric Runtime egy Apache Sparkon alapuló Azure-beli integrált platform, amely lehetővé teszi az adatfeldolgozási és adatelemzési élmények végrehajtását és kezelését. A belső és a nyílt forráskódú forrásból származó kulcsfontosságú összetevőket egyesíti, és átfogó megoldást kínál az ügyfelek számára. Az egyszerűség kedvéért az Apache Spark által üzemeltetett Microsoft Fabric Futtatókörnyezetet tekintjük át Fabric Runtime-ként.

A Fabric Runtime főbb összetevői:

Apache Spark – egy hatékony, nyílt forráskódú elosztott számítástechnikai kódtár, amely nagy léptékű adatfeldolgozási és elemzési feladatokat tesz lehetővé. Az Apache Spark sokoldalú és nagy teljesítményű platformot biztosít az adatmérnöki feladatokhoz és az adatelemzéshez.

Delta Lake – egy nyílt forráskódú tárolási réteg, amely ACID-tranzakciókat és más adatmegbízható funkciókat biztosít az Apache Spark számára. A Fabric Runtime-ban integrálva a Delta Lake javítja az adatfeldolgozási képességeket, és több egyidejű művelet adatkonzisztenciáját biztosítja.

A natív végrehajtási motor – az Apache Spark számítási feladatainak átalakító fejlesztése, amely jelentős teljesítménynövekedést kínál a Spark-lekérdezések lakehouse-infrastruktúrán történő közvetlen végrehajtásával. Zökkenőmentesen integrálható, nem igényel kódmódosítást, és elkerüli a gyártói kötöttséget. Támogatja mind a Parquet, mind a Delta formátumokat az Apache Spark API-kon a Runtime 1.3-ban (Spark 3.5). Ez a motor a lekérdezési sebességet akár négyszer gyorsabban is felgyorsítja, mint a hagyományos OSS Spark, amint azt az TPC-DS 1 TB-os teljesítményteszt mutatja, csökkentve a működési költségeket, és javítja a hatékonyságot a különböző adatfeladatok között– beleértve az adatbetöltést, az ETL-t, az elemzést és az interaktív lekérdezéseket. A natív végrehajtási motor két fő OSS-összetevőn alapul: a Velox, a Meta által bevezetett C++ adatbázis-gyorsítási kódtár és az Apache Gluten (inkubálás) egy középső réteg, amely a JVM-alapú SQL-motorok végrehajtásának az Intel által bevezetett natív motorokra való kiszervezéséért felelős.

Alapértelmezett szintű csomagok Java-/ Scala-, Python- és R-csomagokhoz, amelyek különböző programozási nyelveket és környezeteket támogatnak. Ezek a csomagok automatikusan települnek és konfigurálódnak, így a fejlesztők az adatfeldolgozási feladatokhoz az előnyben részesített programozási nyelveket alkalmazhatják.

A Microsoft Fabric Runtime egy robusztus, nyílt forráskódú operációs rendszerre épül, amely biztosítja a különböző hardverkonfigurációkkal és rendszerkövetelményekkel való kompatibilitást.

Az alábbiakban átfogó összehasonlítást talál az Apache Spark-verziók, a támogatott operációs rendszerek, a Java, a Scala, a Python, a Delta Lake és az R fő összetevőiről a Microsoft Fabric platformon belüli Apache Spark-alapú futtatókörnyezetekhez.

Jótanács

Mindig a legújabb, általánosan elérhető (GA) futtatókörnyezeti verziót használja az éles számítási feladathoz, amely jelenleg a Runtime 1.3.

| Összetevő | Futtatókörnyezet 1.2 | Futtatókörnyezet 1.3 | Futtatókörnyezet 2.0 |

|---|---|---|---|

| kiadási fázis | EOSA | GA | Kísérleti (előzetes verzió) |

| Apache Spark-verzió | 3.4.1 | 3.5.5 | 4.0.0 |

| Operációs rendszer | Mariner 2.0 | Mariner 2.0 | Mariner 3.0 |

| Java-verzió | 11 | 11 | 21 |

| Scala-verzió | 2.12.17 | 2.12.17 | 2.13.16 |

| Python-verzió | 3.10 | 3.11 | 3.12.11 |

| Delta Lake verzió | 2.4.0 | 3.2 | 4.0.0 |

Látogasson el a Runtime 1.2, a Runtime 1.3 vagy a Runtime 2.0 webhelyre az adott futtatókörnyezeti verzió részleteinek, új funkcióinak, fejlesztéseinek és migrálási forgatókönyveinek megismeréséhez.

Szövet optimalizálások

A Microsoft Fabricben a Spark motor és a Delta Lake implementációi platformspecifikus optimalizálásokat és funkciókat tartalmaznak. Ezeket a funkciókat natív integrációk használatára tervezték a platformon belül. Fontos megjegyezni, hogy ezek a funkciók le is tilthatók a Spark és a Delta Lake standard funkcióinak eléréséhez. Az Apache Sparkhoz készült Fabric Runtimes a következőket foglalja magában:

- Az Apache Spark teljes nyílt forráskódú verziója.

- Közel 100 beépített, különálló lekérdezési teljesítményjavító gyűjteménye. Ezek a fejlesztések olyan funkciókat tartalmaznak, mint a partíció gyorsítótárazás (amely lehetővé teszi a FileSystem partíciógyorsítótárának használatát a metaadattár-hívások számának csökkentésére), valamint a Cross Join és skaláris allekérdezés kivetítése.

- Beépített intelligens gyorsítótár.

Az Apache Sparkhoz és a Delta Lake-hez készült Fabric Runtime-on belül vannak natív írói képességek, amelyek két fő célt szolgálnak:

- Differenciált teljesítményt nyújtanak a számítási feladatok írásához, és optimalizálják az írási folyamatot.

- Alapértelmezetten a Delta Parquet-fájlok V-Order szerinti optimalizálást használják. A Delta Lake V-Order optimalizálása kulcsfontosságú az összes Fabric motor kiváló olvasási teljesítményének biztosításához. Ha részletesebben szeretné megismerni a működését és kezelésének módját, tekintse meg a Delta Lake-táblaoptimalizálásról és a V-Orderről szóló külön cikket.

Több futtatókörnyezet támogatása

A Fabric több futtatókörnyezetet is támogat, így a felhasználók rugalmasan válthatnak közöttük, így minimalizálva az inkompatibilitás vagy a megszakítások kockázatát.

Alapértelmezés szerint minden új munkaterület a ga futtatókörnyezet legújabb verzióját használja, amely jelenleg a Runtime 1.3.

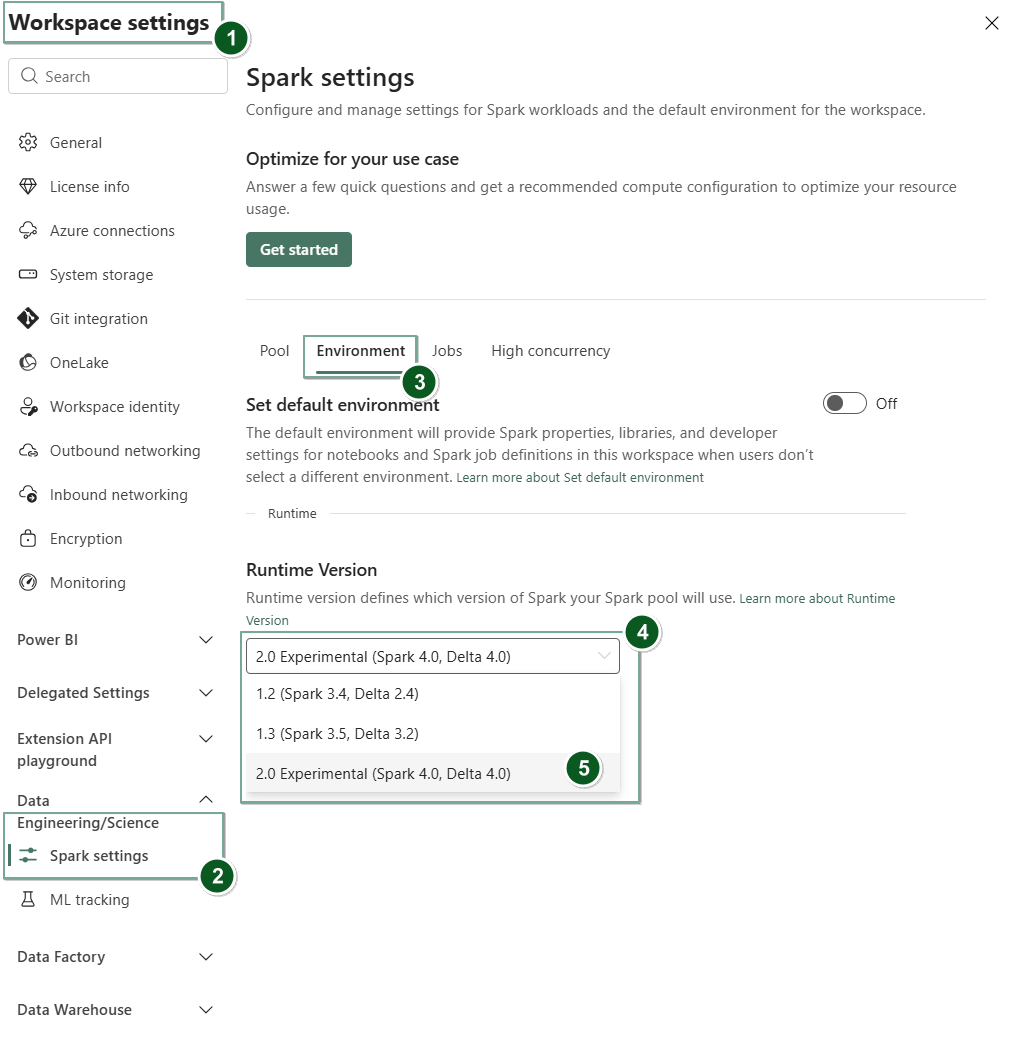

A futtatókörnyezet verziójának munkaterületszinten történő módosításához lépjen Munkaterület beállításai>Adatmérnöki/tudományos>Spark-beállítások. A Környezet lapon válassza ki a kívánt futtatókörnyezeti verziót az elérhető lehetőségek közül. Válassza a Mentés gombot a választásának megerősítéséhez.

A módosítást követően a munkaterület összes rendszer által létrehozott eleme, beleértve a Lakehouse-t, az SJD-ket és a jegyzetfüzeteket is, az újonnan kiválasztott munkaterületszintű futtatókörnyezeti verzióval fog működni a következő Spark-munkamenettől kezdve. Ha jelenleg egy meglévő munkamenettel rendelkező jegyzetfüzetet használ egy feladathoz vagy bármilyen tóházhoz kapcsolódó tevékenységhez, akkor a Spark munkamenet változatlanul folytatódik. A következő munkamenettől vagy feladattól kezdve azonban a kiválasztott futtatókörnyezeti verzió lesz alkalmazva.

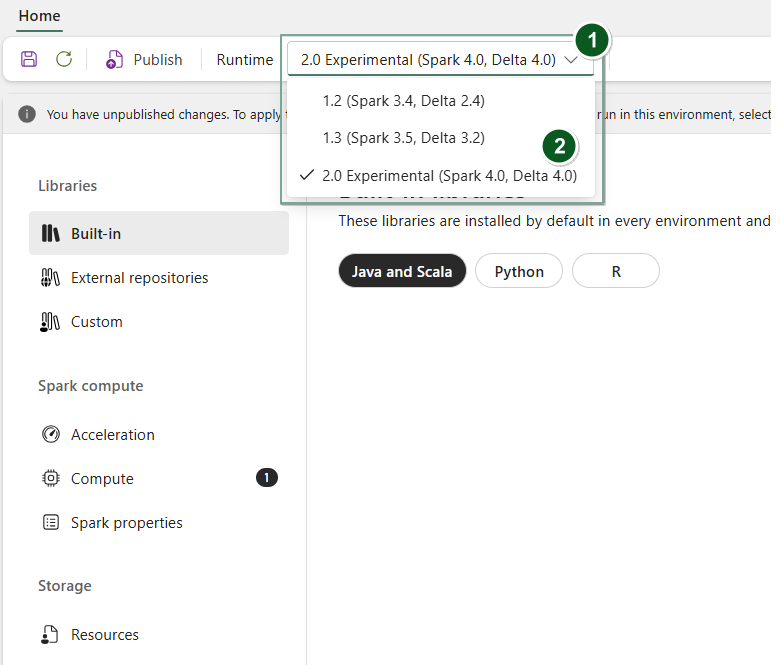

A futtatókörnyezet elemszinten Environment történő módosításához hozzon létre egy új Environment elemet, vagy nyisson meg egy meglévőt. A Futtatókörnyezet legördülő menüben válassza ki a kívánt futtatókörnyezeti verziót az elérhető lehetőségek közül, majd válassza ki Save és Publish a módosításokat. Ezután használhatja ezt az Environment elemet a Notebook vagy a Spark Job Definition.

A futtatókörnyezet változásainak következményei a Spark-beállításokban

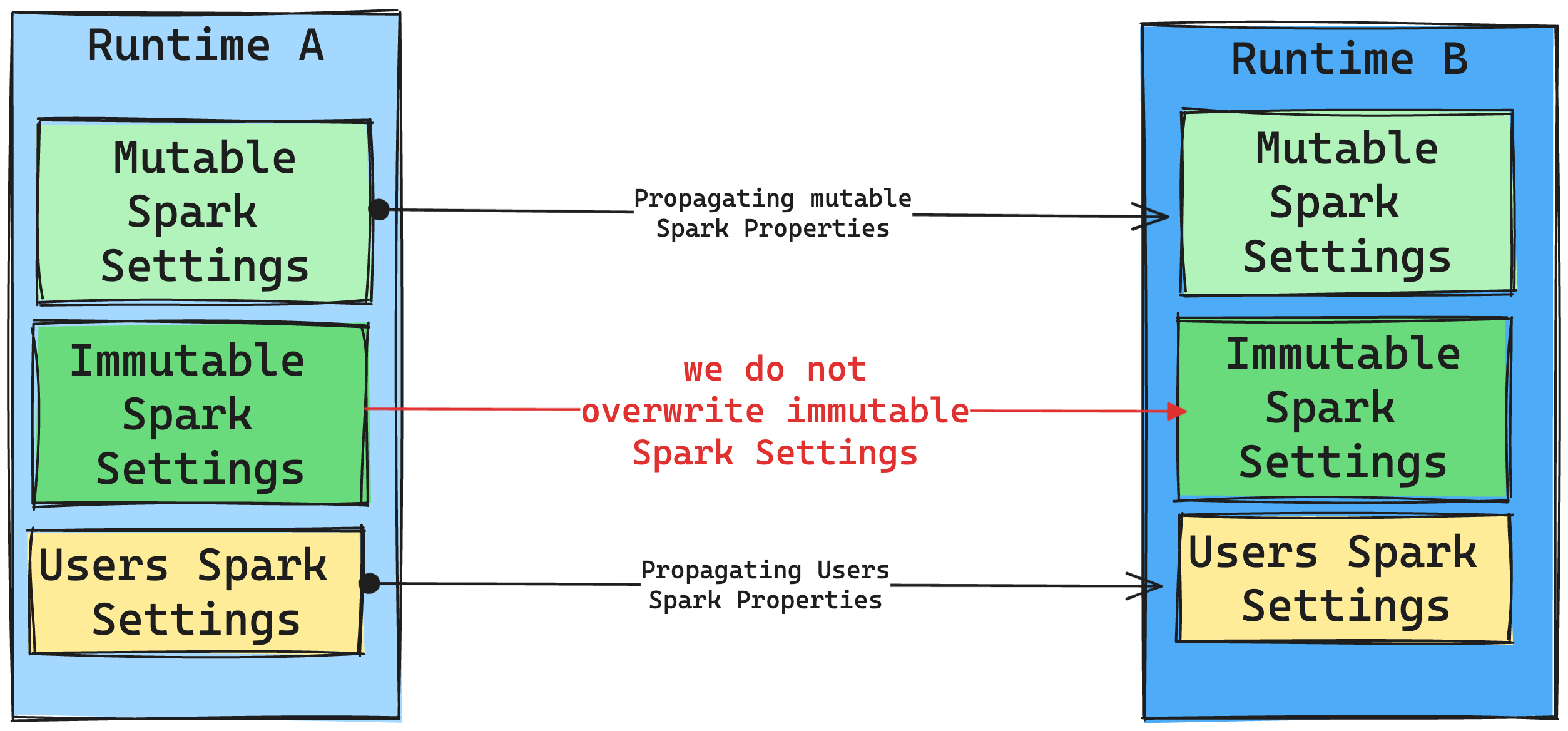

Általában az összes Spark-beállítás áttelepítésére törekszünk. Ha azonban azt állapítjuk meg, hogy a Spark-beállítás nem kompatibilis a Runtime B-vel, figyelmeztető üzenetet küldünk, és tartózkodunk a beállítás implementálásától.

A futtatókörnyezet változásainak következményei a könyvtárkezelésben

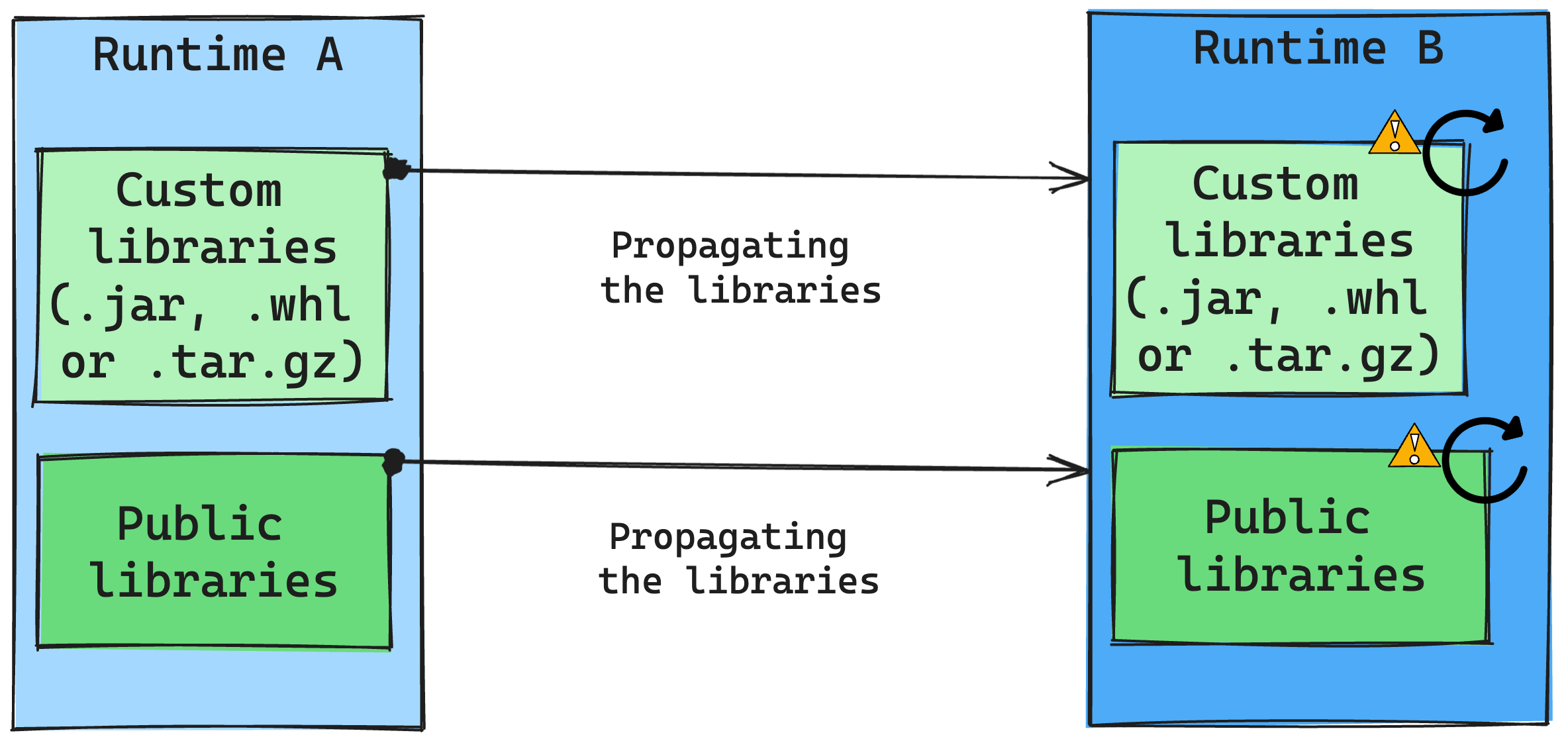

Általában az a megközelítésünk, hogy az összes kódtárat az A futtatókörnyezetből a B futtatókörnyezetbe migráljuk, beleértve a nyilvános és az egyéni futtatókörnyezeteket is. Ha a Python- és R-verziók változatlanok maradnak, a kódtáraknak megfelelően kell működnie. A Jars esetében azonban nagy a valószínűsége annak, hogy a függőségek változásai, valamint más tényezők, például a Scala, a Java, a Spark és az operációs rendszer változásai miatt nem működnek.

A felhasználó felelős minden olyan kódtár frissítéséért vagy cseréjéért, amely nem működik a Runtime B-vel. Ha ütközés történik, ami azt jelenti, hogy a Runtime B tartalmaz egy eredetileg a Runtime A-ban definiált tárat, a kódtár-felügyeleti rendszer megpróbálja létrehozni a B futtatókörnyezethez szükséges függőséget a felhasználó beállításai alapján. Ütközés esetén azonban az építési folyamat meghiúsul. A hibanaplóban a felhasználók láthatják, hogy mely kódtárak okoznak ütközéseket, és módosíthatják a verziójukat vagy specifikációikat.

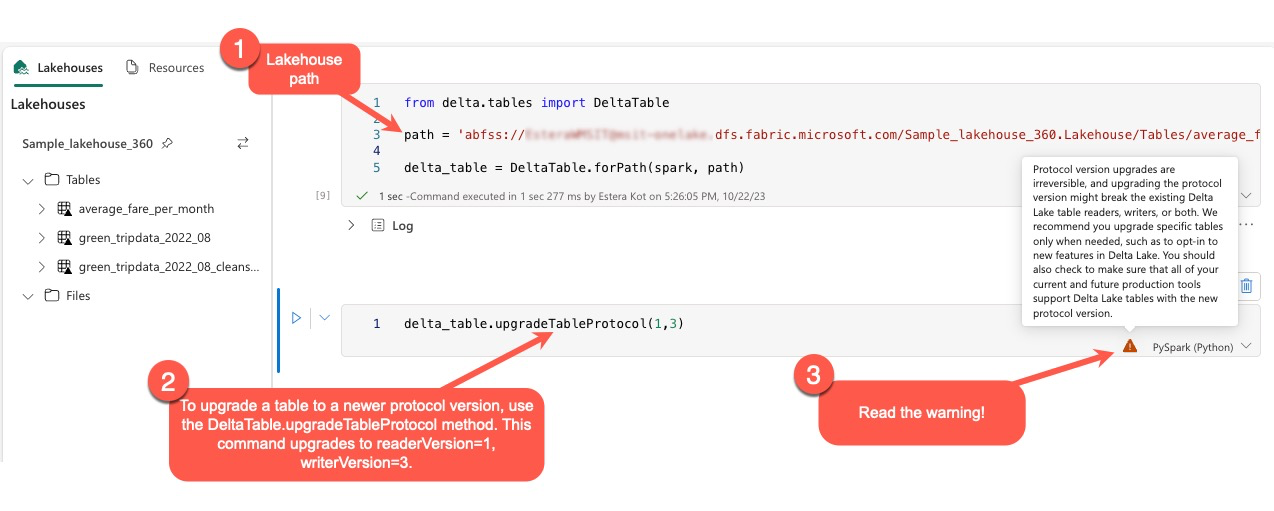

A Delta Lake protokoll frissítése

A Delta Lake funkciói mindig visszamenőlegesen kompatibilisek, így az alacsonyabb Delta Lake-verzióban létrehozott táblák zökkenőmentesen használhatják a magasabb verziókat. Ha azonban bizonyos funkciók engedélyezve vannak (például módszer használatával delta.upgradeTableProtocol(minReaderVersion, minWriterVersion) , az alacsonyabb Delta Lake-verziókkal való kompatibilitás sérülhet. Ilyen esetekben elengedhetetlen, hogy a frissített táblákra hivatkozó számítási feladatokat úgy módosítsa, hogy azok igazodjanak a kompatibilitást fenntartó Delta Lake-verzióhoz.

Minden Delta-tábla egy protokollspecifikációhoz van társítva, amely meghatározza az általa támogatott funkciókat. A táblázatot olvasásra vagy írásra használó alkalmazások erre a protokollspecifikációra támaszkodva állapítják meg, hogy kompatibilisek-e a tábla funkciókészletével. Ha egy alkalmazás nem képes kezelni a tábla protokolljában támogatottként felsorolt funkciókat, nem tud olvasni vagy írni a táblából.

A protokoll specifikációja két különböző összetevőre oszlik: az "olvasási" protokollra és az "írási" protokollra. További információ: "Hogyan kezeli a Delta Lake a funkciók kompatibilitását?".

A felhasználók végrehajthatják a parancsot delta.upgradeTableProtocol(minReaderVersion, minWriterVersion) a PySpark-környezetben, valamint a Spark SQL-ben és a Scalában. Ez a parancs lehetővé teszi számukra, hogy frissítést kezdeményezhessenek a Delta táblán.

Fontos megjegyezni, hogy a frissítés végrehajtásakor a felhasználók figyelmeztetést kapnak, amely azt jelzi, hogy a Delta protokoll verziójának frissítése nem visszafordítható folyamat. Ez azt jelenti, hogy a frissítés végrehajtása után nem vonható vissza.

A protokollverzió-frissítések hatással lehetnek a meglévő Delta Lake-táblaolvasók, írók vagy mindkettő kompatibilitására. Ezért célszerű körültekintően haladni, és csak akkor frissíteni a protokollverziót, ha szükséges, például új funkciók bevezetésekor a Delta Lake-ben.

Fontos

Ha többet szeretne megtudni arról, hogy mely protokollverziók és szolgáltatások kompatibilisek az összes Microsoft Fabric-szolgáltatással, olvassa el a Delta Lake táblaformátum együttműködési lehetőségeit.

Emellett a felhasználóknak ellenőrizniük kell, hogy az összes jelenlegi és jövőbeli éles számítási feladat és folyamat kompatibilis-e a Delta Lake-táblákkal az új protokollverzióval, hogy zökkenőmentes átmenetet biztosítson, és megelőzze az esetleges fennakadásokat.