Adatelemzési végpontok közötti forgatókönyv: bevezetés és architektúra

Ez az oktatóanyag-készlet bemutatja a Fabric adatelemzési felületének végpontok közötti példaforgatókönyvét. Az adatbetöltéstől, a tisztítástól és az előkészítéstől kezdve a gépi tanulási modellek betanításán és az elemzések létrehozásán át az elemzésekig minden lépést implementálhat, majd ezeket az elemzéseket a Power BI-hoz hasonló vizualizációs eszközökkel használhatja fel.

Ha még nem ismerkedik a Microsoft Fabric szolgáltatásban, olvassa el a Mi a Microsoft Fabric? című témakört.

Bevezetés

Az adatelemzési projektek életciklusa általában a következő lépéseket foglalja magában (gyakran iteratív módon):

- Üzleti megállapítás

- Adatgyűjtés

- Adatfeltárás, tisztítás, előkészítés és vizualizáció

- Modellbetanítás és kísérletkövetés

- Modell pontozása és elemzések létrehozása.

Az egyes szakaszok céljai és sikerességi kritériumai az együttműködéstől, az adatmegosztástól és a dokumentációtól függenek. A Fabric adatelemzési felülete több natív beépített funkcióból áll, amelyek zökkenőmentesen teszik lehetővé az együttműködést, az adatgyűjtést, a megosztást és a felhasználást.

Ezekben az oktatóanyagokban egy adatelemző szerepét veszi át, aki egy bank 10 000 ügyfelet tartalmazó adathalmaz feltárására, tisztítására és átalakítására kapott feladatot. Ezután létrehoz egy gépi tanulási modellt, amely előrejelzi, hogy mely banki ügyfelek fognak távozni.

A következő tevékenységek elvégzését fogja elsajátítani:

- Használja a Fabric-jegyzetfüzeteket adatelemzési forgatókönyvekhez.

- Adatok betöltése Fabric lakehouse-ba az Apache Spark használatával.

- Meglévő adatok betöltése a lakehouse-beli deltatáblákból.

- Adatok tisztítása és átalakítása Apache Spark- és Python-alapú eszközökkel.

- Kísérletek és futtatások létrehozása különböző gépi tanulási modellek betanítása érdekében.

- Betanított modellek regisztrálása és nyomon követése az MLflow és a Fabric felhasználói felületén.

- A pontozást nagy méretekben futtathatja, és előrejelzéseket és következtetési eredményeket menthet a lakehouse-ba.

- Előrejelzések megjelenítése a Power BI-ban a DirectLake használatával.

Architektúra

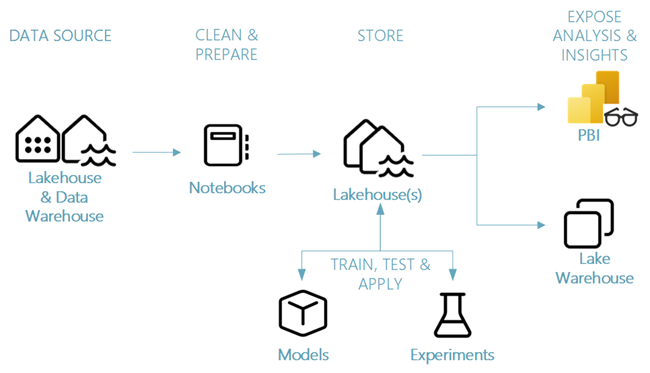

Ebben az oktatóanyag-sorozatban egy egyszerűsített, végpontok közötti adatelemzési forgatókönyvet mutatunk be, amely a következőket foglalja magában:

- Adatok betöltése külső adatforrásból.

- Adatok feltárása és tisztítása.

- Gépi tanulási modellek betanítása és regisztrálása.

- Kötegelt pontozás és előrejelzések mentése.

- Előrejelzési eredmények megjelenítése a Power BI-ban.

Az adatelemzési forgatókönyv különböző összetevői

Adatforrások – A Fabric segítségével egyszerűen és gyorsan csatlakozhat az Azure Data Serviceshez, más felhőplatformokhoz és helyszíni adatforrásokhoz az adatok betöltéséhez. A Fabric Notebookok használatával adatokat lehet beemészteni a beépített Lakehouse-ból, az Adattárházból, a szemantikai modellekből, valamint a különböző Apache Spark- és Python-támogatott egyéni adatforrásokból. Ez az oktatóanyag-sorozat az adatok tóházból való betöltésére és betöltésére összpontosít.

Felfedezés, tisztítás és előkészítés – A Fabric adatelemzési felülete támogatja az adattisztítást, az átalakítást, a feltárást és a featurizálást a Spark beépített felhasználói felületei, valamint a Python-alapú eszközök, például a Data Wrangler és a SemPy Library használatával. Ez az oktatóanyag a Python-kódtár seaborn használatával végzett adatfeltárást, valamint az Apache Spark használatával végzett adattisztítást és -előkészítést mutatja be.

Modellek és kísérletek – A Fabric lehetővé teszi a gépi tanulási modellek betanítása, kiértékelése és pontszáma a beépített kísérletekkel és modellelemekkel, zökkenőmentes integrációval az MLflow-jal a kísérletkövetéshez és a modellregisztrációhoz/üzembe helyezéshez. A Fabric emellett nagy léptékű modell-előrejelzési (PREDICT) képességeket is kínál az üzleti elemzések megszerzéséhez és megosztásához.

Tárolás – A Fabric a Delta Lake-en szabványosít, ami azt jelenti, hogy a Fabric minden motorja képes ugyanazzal az adatkészlettel kommunikálni, amelyet egy tóházban tárolnak. Ez a tárolási réteg lehetővé teszi strukturált és strukturálatlan adatok tárolását, amelyek támogatják a fájlalapú tárolást és a táblázatos formátumot is. A tárolt adatkészletek és fájlok könnyen elérhetők az összes Fabric-felületi elemen, például jegyzetfüzeteken és folyamatokon keresztül.

Elemzések és elemzések felfedése – A lakehouse-ból származó adatokat a Power BI, az iparág vezető üzletiintelligencia-eszköze használhatja fel jelentéskészítéshez és vizualizációhoz. A lakehouse-ban tárolt adatok spark- vagy Python-natív vizualizációs kódtárak, például matplotlib, seabornplotlystb. használatával is megjeleníthetők jegyzetfüzetekben. Az adatok a SemPy-kódtár használatával is megjeleníthetők, amely támogatja a szemantikai adatmodell beépített, feladatspecifikus vizualizációit, a függőségeket és azok megsértését, valamint a besorolási és regressziós használati eseteket.

Következő lépés

Visszajelzés

Hamarosan elérhető: 2024-ben fokozatosan kivezetjük a GitHub-problémákat a tartalom visszajelzési mechanizmusaként, és lecseréljük egy új visszajelzési rendszerre. További információ: https://aka.ms/ContentUserFeedback.

Visszajelzés küldése és megtekintése a következőhöz: