Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Penting

Dukungan untuk Studio Azure Machine Learning (klasik) akan berakhir pada 31 Agustus 2024. Sebaiknya Anda transisi ke Azure Machine Learning sebelum tanggal tersebut.

Mulai 1 Desember 2021, Anda tidak akan dapat membuat sumber daya Studio Azure Machine Learning (klasik) baru. Hingga 31 Agustus 2024, Anda dapat terus menggunakan sumber daya Pembelajaran Mesin Studio (klasik) yang ada.

- Lihat informasi tentang memindahkan proyek pembelajaran mesin dari ML Studio (klasik) ke Azure Machine Learning.

- Pelajari selengkapnya tentang Azure Machine Learning.

ML Dokumentasi Studio (klasik) sedang berhenti dan mungkin tidak diperbarui di masa mendatang.

Memuat data dari sumber eksternal di web; dari berbagai bentuk penyimpanan berbasis cloud di Azure seperti tabel, blob, dan database SQL; dan dari database SQL Server lokal

Kategori: Input dan Output Data

Catatan

Berlaku untuk: Pembelajaran Mesin Studio (klasik) saja

Modul seret dan letakkan serupa tersedia di perancang Azure Machine Learning.

Ringkasan Modul

Artikel ini menjelaskan cara menggunakan modul Impor Data di Pembelajaran Mesin Studio (klasik), untuk memuat data ke dalam eksperimen pembelajaran mesin dari layanan data cloud yang ada.

Modul sekarang menampilkan wizard untuk membantu Anda memilih opsi penyimpanan dan memilih dari antara langganan dan akun yang ada untuk mengonfigurasi semua opsi dengan cepat. Perlu mengedit koneksi data yang sudah ada? Tidak masalah; wizard memuat semua detail konfigurasi sebelumnya sehingga Anda tidak perlu memulai lagi dari awal.

Setelah Anda menentukan data yang Anda inginkan dan menyambungkan ke sumbernya, Impor Data menyimpulkan jenis data setiap kolom berdasarkan nilai yang dikandungnya, dan memuat data ke ruang kerja Pembelajaran Mesin Studio (klasik). Output Impor Data adalah himpunan data yang dapat digunakan dengan eksperimen apa pun.

Penting

Saat ini, ada batasan pada jenis akun penyimpanan yang didukung. Untuk informasi selengkapnya, lihat Catatan Teknis.

Jika data sumber Anda berubah, Anda dapat merefresh himpunan data dan menambahkan data baru dengan menjalankan kembali Impor Data. Namun, jika Anda tidak ingin membaca ulang dari sumber setiap kali Anda menjalankan eksperimen, pilih opsi Gunakan hasil yang di-cache ke TRUE. Ketika opsi ini dipilih, modul memeriksa apakah eksperimen telah berjalan sebelumnya menggunakan sumber yang sama dan opsi input yang sama. Jika eksekusi sebelumnya ditemukan, data dalam cache digunakan, alih-alih memuat ulang data dari sumbernya.

Catatan

Modul ini sebelumnya bernama Pembaca. Jika sebelumnya Anda menggunakan modul Pembaca dalam eksperimen, modul tersebut diganti namanya menjadi Impor Data saat Anda me-refresh eksperimen.

Sumber data

Modul Impor Data mendukung sumber data berikut. Klik tautan untuk instruksi terperinci dan contoh penggunaan setiap sumber data.

Jika Anda tidak yakin bagaimana atau di mana Anda harus menyimpan data Anda, lihat panduan ini untuk skenario data umum dalam proses ilmu data: Skenario untuk analitik tingkat lanjut di Pembelajaran Mesin.

| Sumber data | Gunakan dengan |

|---|---|

| URL Web melalui HTTP | Mendapatkan data yang dihosting di URL web yang menggunakan HTTP dan yang telah disediakan dalam format CSV, TSV, ARFF, atau SvmLight |

| Kueri Apache Hive | Dapatkan data dari penyimpanan terdistribusi di Hadoop. Anda menentukan data yang Anda inginkan dengan menggunakan bahasa HiveQL |

| Azure SQL Database | Mendapatkan data dari Azure SQL Database atau dari Azure SQL Data Warehouse |

| Azure Table | Mendapatkan data yang disimpan dalam layanan tabel Azure |

| Impor dari Azure Blob Storage | Mendapatkan data yang disimpan di layanan blob Azure |

| Penyedia Umpan Data | Mendapatkan data yang diekspos sebagai umpan dalam format OData |

| Mengimpor dari Database SQL Server Lokal | Mendapatkan data dari database SQL Server lokal menggunakan Microsoft Data Management Gateway |

| Azure Cosmos DB | Dapatkan data yang disimpan dalam format JSON di Azure Cosmos DB. |

Tip

Perlu mengimpor data dalam format JSON? Baik R dan Python mendukung REST API, jadi gunakan modul Jalankan Skrip Python atau Jalankan Skrip R untuk mengurai data Anda dan menyimpannya sebagai himpunan data Azure ML.

Atau, gunakan API SQL DB untuk CosmosDB, yang mendukung beberapa penyimpanan JSON, termasuk MongoDB, untuk membaca data Anda menggunakan opsi Impor dari Azure Cosmos DB. Untuk informasi selengkapnya, lihat Mengimpor dari Azure Cosmos DB.

Cara menggunakan Impor Data

Tambahkan modul Impor Data ke eksperimen Anda. Anda dapat menemukan modul ini di kategori Input dan Output Data di Studio (klasik).

Klik Luncurkan Wizard Impor Data untuk mengonfigurasi sumber data menggunakan wizard.

Wizard mendapatkan nama akun dan kredensial, dan membantu Anda mengonfigurasi opsi lain. Jika Anda mengedit konfigurasi yang ada, konfigurasi akan memuat nilai saat ini terlebih dahulu.

Jika Anda tidak ingin menggunakan wizard, klik Sumber data, dan pilih jenis penyimpanan berbasis cloud yang Anda baca.

Pengaturan tambahan bergantung pada jenis penyimpanan yang Anda pilih, dan apakah penyimpanan diamankan atau tidak. Anda mungkin perlu memberikan nama akun, jenis file, atau kredensial. Beberapa sumber tidak memerlukan autentikasi; untuk orang lain, Anda mungkin perlu mengetahui nama akun, kunci, atau nama kontainer.

Untuk detailnya, lihat daftar Sumber data.

Pilih opsi Gunakan hasil yang di-cache jika Anda ingin menyimpan himpunan data untuk digunakan kembali pada eksekusi berturut-turut.

Dengan asumsi belum ada perubahan lain pada parameter modul, eksperimen memuat data hanya saat pertama kali modul dijalankan, dan setelah itu menggunakan versi himpunan data yang di-cache.

Batalkan pilihan opsi ini jika Anda perlu memuat ulang data setiap kali Anda menjalankan eksperimen.

Jalankan eksperimen.

Saat Mengimpor Data memuat data ke Studio (klasik), Data tersebut menyimpulkan jenis data setiap kolom berdasarkan nilai yang dikandungnya, baik numerik maupun kategoris.

Jika ada, header digunakan untuk menamai kolom dari himpunan data output.

Jika tidak ada header kolom yang ada dalam data, nama kolom baru dibuat menggunakan format col1, col2,… ,coln.

Hasil

Saat impor selesai, klik himpunan data output dan pilih Visualisasikan untuk melihat apakah data berhasil diimpor.

Jika Anda ingin menyimpan data untuk digunakan kembali, daripada mengimpor kumpulan data baru setiap kali eksperimen dijalankan, klik kanan output dan pilih Simpan sebagai Himpunan Data. Pilih nama untuk himpunan data. Himpunan data yang disimpan mempertahankan data pada saat penyimpanan, dan data tidak diperbarui saat eksperimen dijalankan kembali, bahkan jika himpunan data dalam eksperimen berubah. Ini bisa berguna untuk mengambil rekam jepret data.

Setelah mengimpor data, mungkin perlu beberapa persiapan tambahan untuk pemodelan dan analisis:

Hasilkan ringkasan statistik data, menggunakan Ringkasan Data atau Statistik Dasar Komputasi.

Gunakan Edit Metadata untuk mengubah nama kolom, untuk menangani kolom sebagai tipe data yang berbeda, atau untuk menunjukkan bahwa beberapa kolom adalah label atau fitur.

Gunakan Pilih Kolom dalam Himpunan Data untuk memilih subkumpulan kolom yang akan diubah atau digunakan dalam pemodelan. Kolom yang diubah atau dihapus dapat dengan mudah bergabung kembali ke himpunan data asli dengan menggunakan modul Tambahkan Kolom atau modul Gabung Data .

Gunakan Partisi dan Sampel untuk membagi himpunan data, melakukan pengambilan sampel, atau mendapatkan n baris teratas.

Gunakan Terapkan Transformasi SQL untuk mengagregasi data, memfilter, atau mengubah menggunakan pernyataan SQL.

Gunakan modul ini untuk membersihkan kolom teks dan menghasilkan fitur teks baru:

- Teks Praproses

- Ekstrak Fitur N-Gram dari Teks

- Pengenalan Entitas Bernama

- Jalankan Skrip Python, untuk mengimplementasikan NLP kustom berdasarkan nltk.

Catatan teknis

Bagian ini menyediakan daftar masalah yang diketahui dengan modul Impor Data , serta beberapa informasi pemecahan masalah umum yang tidak spesifik untuk jenis sumber.

Jenis akun yang didukung

Sering azure merilis layanan baru atau jenis penyimpanan baru; namun, biasanya ada penundaan sementara dukungan untuk jenis akun baru diterapkan di Pembelajaran Mesin Studio (klasik).

Saat ini, Pembelajaran Mesin mendukung semua akun penyimpanan tujuan umum, kecuali yang menggunakan penyimpanan zona redundan (ZRS).

Opsi penyimpanan redundan lokal (LRS) dan penyimpanan geo-redundan didukung.

Blob blok didukung tetapi blob Penambahan tidak.

Pertanyaan dan masalah umum

Bagian ini menjelaskan beberapa masalah yang diketahui, pertanyaan umum, dan solusinya.

Header harus berupa baris tunggal

Jika Anda mengimpor dari file CSV, ketahuilah bahwa Pembelajaran Mesin mengizinkan satu baris header. Anda tidak dapat menyisipkan header multibaris.

Pemisah kustom didukung pada impor tetapi tidak diekspor

Modul Impor Data mendukung impor data yang menggunakan pemisah kolom alternatif, seperti titik koma (;), yang sering digunakan di Eropa. Saat Anda mengimpor data dari file CSV di penyimpanan eksternal, pilih opsi CSV dengan pengodean , dan pilih pengodean yang didukung.

Namun, Anda tidak dapat menghasilkan pemisah alternatif saat menyiapkan data untuk diekspor menggunakan modul Konversi ke CSV .

Pemisahan kolom yang buruk pada data string yang berisi koma

Hampir setiap karakter yang dapat ditentukan sebagai pemisah kolom (tab, spasi, koma, dll.) juga dapat ditemukan secara acak di bidang teks. Mengimpor teks dari CSV selalu memerlukan perhatian untuk menghindari pemisahan teks di seluruh kolom baru yang tidak perlu. Ini adalah masalah umum dalam pemrosesan teks yang mungkin telah Anda temui dan tangani dengan cara yang berbeda.

Masalah juga dapat terjadi ketika Anda mencoba mengekspor kolom data string yang berisi koma. Pembelajaran Mesin tidak mendukung penanganan khusus atau terjemahan khusus dari data tersebut, seperti menyertakan string dalam tanda kutip. Selain itu, Anda tidak dapat menggunakan karakter escape sebelum koma untuk memastikan bahwa koma ditangani sebagai karakter harfiah. Akibatnya, bidang baru dibuat dalam file output untuk setiap koma yang ditemui di bidang string.

Untuk menghindari masalah pada ekspor, gunakan modul Teks Praproscess untuk menghapus karakter tanda baca dari bidang string.

Anda juga dapat menggunakan skrip R kustom atau skrip Python untuk memproses teks kompleks dan memastikan bahwa data dapat diimpor atau diekspor dengan benar.

Pengodean UTF-8 diperlukan

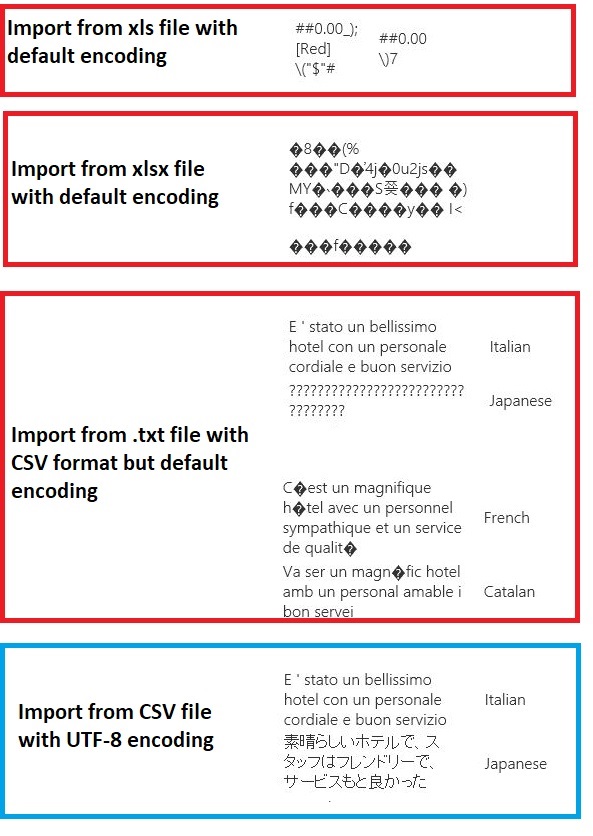

Pembelajaran Mesin memerlukan pengodean UTF-8. Jika data yang Anda impor menggunakan pengodean yang berbeda, atau diekspor dari sumber data yang menggunakan pengodean default yang berbeda, berbagai masalah mungkin muncul dalam teks.

Misalnya, gambar berikut berisi himpunan data multilanguage yang sama yang diekspor dari Excel lalu diimpor ke Pembelajaran Mesin di bawah empat kombinasi jenis file dan pengodean yang berbeda.

Contoh ketiga mewakili data yang hilang selama penyimpanan dari Excel dalam format CSV, karena pengodean yang benar tidak ditentukan pada saat itu. Oleh karena itu, jika Anda mengalami masalah, pastikan untuk memeriksa bukan hanya file yang Anda impor, tetapi apakah file diekspor dengan benar dari sumbernya.

Himpunan data tidak memiliki nama kolom

Jika himpunan data yang Anda impor tidak memiliki nama kolom, pastikan untuk menentukan salah satu opsi "tanpa header". Saat Anda melakukannya, Impor Data menambahkan nama kolom default menggunakan format Col1, Col2, dll. Nantinya, gunakan Edit Metadata untuk memperbaiki nama kolom.

Jika Anda mengekspor himpunan data ke file CSV, gunakan Edit Metadata untuk menambahkan nama kolom sebelum mengonversi atau mengekspornya.

Solusi untuk sumber data yang tidak didukung

Jika Anda perlu mendapatkan data dari sumber yang tidak ada dalam daftar, ada berbagai solusi yang dapat Anda coba:

Untuk mengunggah data dari file di komputer Anda, klik Baru di Studio (klasik), pilih Himpunan Data, lalu pilih Dari File Lokal. Temukan file dan tentukan format (TSV, CSV, dll.). Untuk informasi selengkapnya, lihat Mengimpor data pelatihan ke Studio (klasik).

Gunakan R atau Python. Anda dapat menggunakan modul Jalankan Skrip R dengan paket R yang sesuai untuk mendapatkan data dari database cloud lainnya.

Modul Execute Python Script juga memungkinkan Anda membaca dan mengonversi data dari berbagai sumber. Lihat contoh-contoh ini dari ilmuwan data Microsoft di Galeri Kecerdasan Cortana:

Mendapatkan data dari kluster AWS. Anda dapat menjalankan kueri terhadap kluster Apache Hive generik dengan titik akhir WebHCat atau HCatalog diaktifkan. Atau terbitkan sebagai halaman dan baca dari URL Web.

Mendapatkan data dari MongoDB. Utilitas migrasi data untuk Azure Cosmos DB mendukung berbagai sumber dan format. Untuk informasi dan contoh selengkapnya, lihat Azure Cosmos DB: Alat migrasi data

Untuk ide dan solusi lainnya, lihat forum Pembelajaran Mesin atau Galeri Azure AI.

Parameter modul

Setiap sumber data harus dikonfigurasi menggunakan opsi yang berbeda. Tabel ini hanya mencantumkan opsi yang umum untuk semua sumber data.

| Nama | Rentang | Jenis | Default | Deskripsi |

|---|---|---|---|---|

| Sumber data | Daftar | Sumber data atau sink | Layanan blob di Azure Storage | Sumber data dapat berupa HTTP, HTTPS anonim, file di layanan Blob atau layanan Tabel, database SQL di Azure, Gudang Data Azure SQL, tabel Apache Hive, atau titik akhir OData. |

| Menggunakan hasil yang di-cache | BENAR/SALAH | Boolean | SALAH | Jika TRUE, modul akan memeriksa apakah eksperimen telah berjalan sebelumnya menggunakan sumber yang sama dan opsi input yang sama, dan jika eksekusi sebelumnya ditemukan, data dalam cache digunakan. Jika FALSE, atau jika perubahan ditemukan, data akan dimuat ulang dari sumbernya. |

Output

| Nama | Jenis | Deskripsi |

|---|---|---|

| Himpunan data hasil | Tabel Data | Himpunan data dengan data yang diunduh |

Pengecualian

| Pengecualian | Deskripsi |

|---|---|

| Kesalahan 0027 | Pengecualian terjadi ketika dua objek harus berukuran sama, tetapi tidak. |

| Kesalahan 0003 | Pengecualian terjadi jika satu atau beberapa input null atau kosong. |

| Kesalahan 0029 | Pengecualian terjadi ketika URI yang tidak valid diteruskan. |

| Kesalahan 0030 | pengecualian terjadi ketika tidak dimungkinkan untuk mengunduh file. |

| Kesalahan 0002 | Pengecualian terjadi jika satu atau beberapa parameter tidak dapat diurai atau dikonversi dari jenis yang ditentukan ke jenis yang diperlukan oleh metode target. |

| Kesalahan 0009 | Pengecualian terjadi jika nama akun penyimpanan Azure atau nama kontainer ditentukan dengan tidak benar. |

| Kesalahan 0048 | Pengecualian terjadi ketika tidak dimungkinkan untuk membuka file. |

| Kesalahan 0015 | Pengecualian terjadi jika koneksi database gagal. |

| Kesalahan 0046 | Pengecualian terjadi ketika tidak dimungkinkan untuk membuat direktori pada jalur yang ditentukan. |

| Kesalahan 0049 | Pengecualian terjadi ketika tidak dimungkinkan untuk mengurai file. |

Untuk daftar kesalahan khusus untuk modul Studio (klasik), lihat kode Kesalahan Pembelajaran Mesin.

Untuk daftar pengecualian API, lihat Pembelajaran Mesin Kode Kesalahan REST API.

Lihat juga

Input dan Output Data

Konversi Format Data

Mengekspor data

Daftar Modul A-Z