Skenario end-to-end Lakehouse: gambaran umum dan arsitektur

Microsoft Fabric adalah solusi analitik all-in-one untuk perusahaan yang mencakup segala sesuatu mulai dari pergerakan data hingga ilmu data, analitik real time, dan kecerdasan bisnis. Ini menawarkan serangkaian layanan yang komprehensif, termasuk data lake, rekayasa data, dan integrasi data, semuanya di satu tempat. Untuk informasi selengkapnya, lihat Apa itu Microsoft Fabric?

Tutorial ini memancang Anda melalui skenario end-to-end dari akuisisi data ke konsumsi data. Ini membantu Anda membangun pemahaman dasar tentang Fabric, termasuk pengalaman yang berbeda dan bagaimana mereka berintegrasi, serta pengalaman pengembang profesional dan warga negara yang datang dengan bekerja di platform ini. Tutorial ini tidak dimaksudkan untuk menjadi arsitektur referensi, daftar lengkap fitur dan fungsionalitas, atau rekomendasi praktik terbaik tertentu.

Skenario end-to-end Lakehouse

Secara tradisional, organisasi telah membangun gudang data modern untuk kebutuhan analitik data transaksi dan terstruktur mereka. Dan data lakehouses untuk kebutuhan analitik data big data (semi/tidak terstruktur). Kedua sistem ini berjalan secara paralel, membuat silo, duplikasi data, dan peningkatan total biaya kepemilikan.

Fabric dengan penyatuan penyimpanan data dan standardisasinya pada format Delta Lake memungkinkan Anda menghilangkan silo, menghapus duplikasi data, dan secara drastis mengurangi total biaya kepemilikan.

Dengan fleksibilitas yang ditawarkan oleh Fabric, Anda dapat menerapkan arsitektur gudang data atau lakehouse atau menggabungkannya bersama-sama untuk mendapatkan yang terbaik dari keduanya dengan implementasi sederhana. Dalam tutorial ini, Anda akan mengambil contoh organisasi ritel dan membangun lakehouse-nya dari awal hingga akhir. Ini menggunakan arsitektur medali di mana lapisan perunggu memiliki data mentah, lapisan perak memiliki data yang divalidasi dan dideduplikasi, dan lapisan emas memiliki data yang sangat halus. Anda dapat mengambil pendekatan yang sama untuk menerapkan lakehouse untuk organisasi apa pun dari industri apa pun.

Tutorial ini menjelaskan bagaimana pengembang di perusahaan Wide World Importers fiktif dari domain ritel menyelesaikan langkah-langkah berikut:

Masuk ke akun Power BI Anda dan daftar untuk uji coba Microsoft Fabric gratis. Jika Anda tidak memiliki lisensi Power BI, daftar untuk lisensi gratis Power BI lalu Anda dapat memulai uji coba Fabric.

Bangun dan terapkan lakehouse end-to-end untuk organisasi Anda:

- Buat ruang kerja Fabric.

- Buat lakehouse.

- Serap data, ubah data, dan muat ke lakehouse. Anda juga dapat menjelajahi OneLake, satu salinan data Anda di seluruh mode lakehouse dan mode titik akhir analitik SQL.

- Sambungkan ke lakehouse Anda menggunakan titik akhir analitik SQL dan Buat laporan Power BI menggunakan DirectLake untuk menganalisis data penjualan di berbagai dimensi.

- Secara opsional, Anda dapat mengatur dan menjadwalkan penyerapan data dan aliran transformasi dengan alur.

Bersihkan sumber daya dengan menghapus ruang kerja dan item lainnya.

Sistem

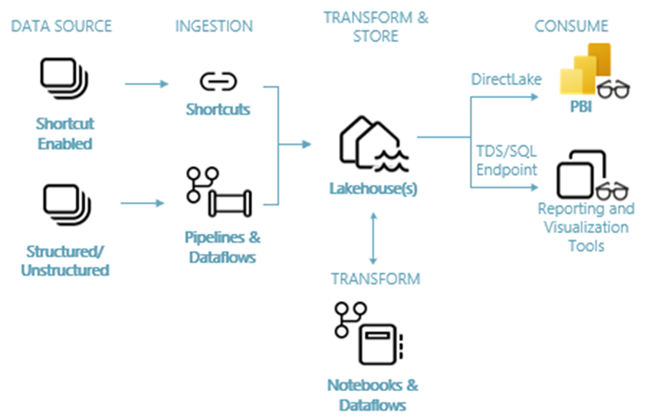

Gambar berikut menunjukkan arsitektur end-to-end lakehouse. Komponen yang terlibat dijelaskan dalam daftar berikut.

Sumber data: Fabric membuatnya cepat dan mudah untuk terhubung ke Azure Data Services, serta platform berbasis cloud dan sumber data lokal lainnya, untuk penyerapan data yang disederhanakan.

Penyerapan: Anda dapat dengan cepat membangun wawasan untuk organisasi Anda menggunakan lebih dari 200 konektor asli. Konektor ini diintegrasikan ke dalam alur Fabric dan menggunakan transformasi data seret dan letakkan yang mudah digunakan dengan aliran data. Selain itu, dengan fitur Pintasan di Fabric Anda dapat terhubung ke data yang ada, tanpa harus menyalin atau memindahkannya.

Transformasi dan simpan: Fabric menstandarkan pada format Delta Lake. Yang berarti semua mesin Fabric dapat mengakses dan memanipulasi himpunan data yang sama yang disimpan di OneLake tanpa menduplikasi data. Sistem penyimpanan ini memberikan fleksibilitas untuk membangun lakehouse menggunakan arsitektur medali atau jala data, tergantung pada persyaratan organisasi Anda. Anda dapat memilih antara pengalaman kode rendah atau tanpa kode untuk transformasi data, menggunakan alur/aliran data atau notebook/Spark untuk pengalaman pertama kode.

Konsumsi: Power BI dapat menggunakan data dari Lakehouse untuk pelaporan dan visualisasi. Setiap Lakehouse memiliki titik akhir TDS bawaan yang disebut titik akhir analitik SQL untuk konektivitas dan kueri data yang mudah dalam tabel Lakehouse dari alat pelaporan lainnya. Titik akhir analitik SQL memberi pengguna fungsionalitas koneksi SQL.

Sampel himpunan data

Tutorial ini menggunakan database sampel Wide World Importers (WWI). Untuk skenario end-to-end lakehouse, kami telah menghasilkan data yang memadai untuk menjelajahi skala dan kemampuan performa platform Fabric.

Wide World Importers (WWI) adalah importir dan distributor barang baru grosir yang beroperasi dari area Teluk San Francisco. Sebagai grosir, pelanggan WWI sebagian besar termasuk perusahaan yang menjual kembali ke individu. WWI menjual kepada pelanggan ritel di seluruh Amerika Serikat termasuk toko khusus, supermarket, toko komputasi, toko objek wisata, dan beberapa individu. WWI juga menjual kepada grosir lain melalui jaringan agen yang mempromosikan produk atas nama WWI. Untuk mempelajari selengkapnya tentang profil dan operasi perusahaan mereka, lihat Database sampel Wide World Importers untuk Microsoft SQL.

Secara umum, data dibawa dari sistem transaksi atau aplikasi lini bisnis ke dalam lakehouse. Namun, demi kesederhanaan dalam tutorial ini, kami menggunakan model dimensi yang disediakan oleh WWI sebagai sumber data awal kami. Kami menggunakannya sebagai sumber untuk menyerap data ke dalam lakehouse dan mengubahnya melalui berbagai tahap (Perunggu, Perak, dan Emas) dari arsitektur medali.

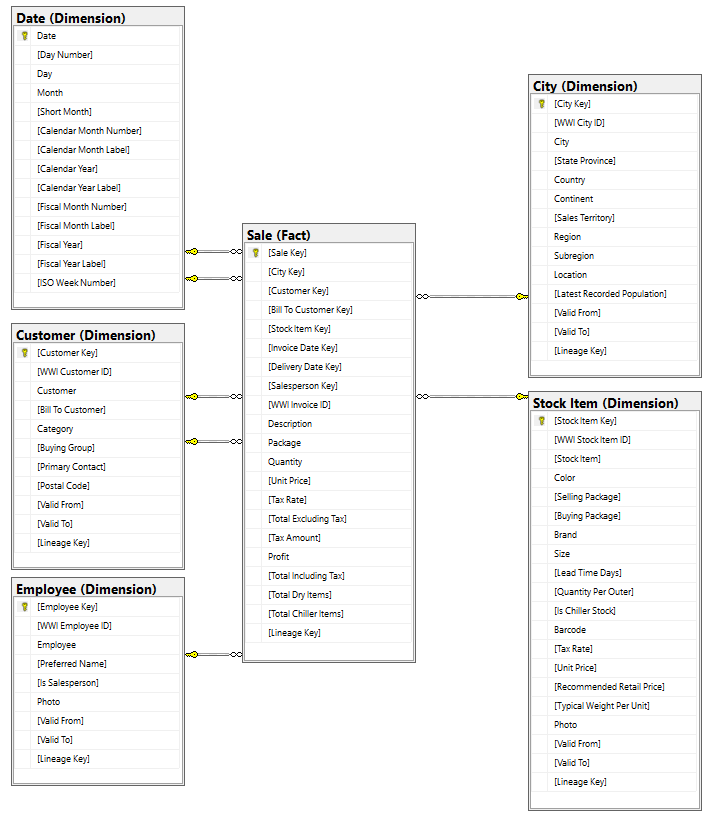

Model data

Sementara model dimensi WWI berisi banyak tabel fakta, untuk tutorial ini, kami menggunakan tabel Fakta penjualan dan dimensi yang berkorelasi. Contoh berikut mengilustrasikan model data WWI:

Aliran data dan transformasi

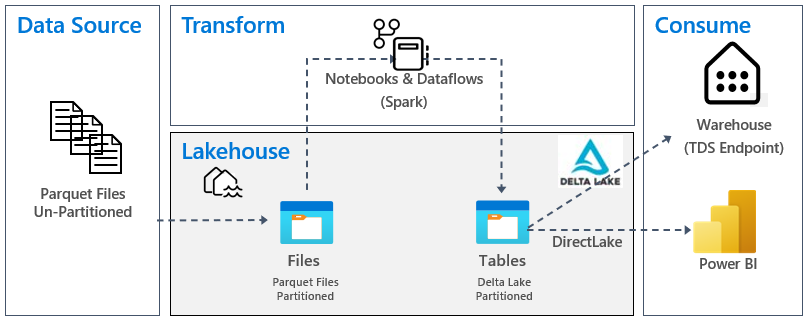

Seperti yang dijelaskan sebelumnya, kami menggunakan data sampel dari data sampel Wide World Importers (WWI) untuk membangun lakehouse end-to-end ini. Dalam implementasi ini, data sampel disimpan dalam akun penyimpanan Azure Data dalam format file Parquet untuk semua tabel. Namun, dalam skenario dunia nyata, data biasanya berasal dari berbagai sumber dan dalam format yang beragam.

Gambar berikut menunjukkan transformasi sumber, tujuan, dan data:

Sumber Data: Data sumber dalam format file Parquet dan dalam struktur yang tidak dipartisi. Ini disimpan dalam folder untuk setiap tabel. Dalam tutorial ini, kami menyiapkan alur untuk menyerap data historis lengkap atau satu kali ke lakehouse.

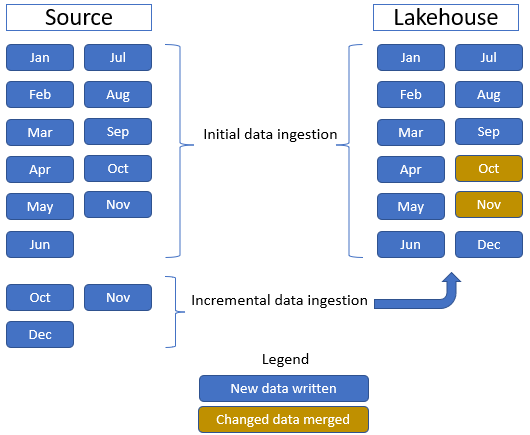

Dalam tutorial ini, kami menggunakan tabel Fakta penjualan , yang memiliki satu folder induk dengan data historis selama 11 bulan (dengan satu subfolder untuk setiap bulan) dan folder lain yang berisi data bertahap selama tiga bulan (satu subfolder untuk setiap bulan). Selama penyerapan data awal, 11 bulan data diserap ke dalam tabel lakehouse. Namun, ketika data bertahap tiba, data tersebut mencakup data yang diperbarui untuk Okt dan Nov, dan data baru untuk data Dec. Okt dan Nov digabungkan dengan data yang ada dan data Des baru ditulis ke dalam tabel lakehouse seperti yang ditunjukkan pada gambar berikut:

Lakehouse: Dalam tutorial ini, Anda membuat lakehouse, menyerap data ke bagian file lakehouse, lalu membuat tabel delta lake di bagian Tabel lakehouse.

Transformasi: Untuk persiapan dan transformasi data, Anda melihat dua pendekatan yang berbeda. Kami menunjukkan penggunaan Notebooks/Spark untuk pengguna yang lebih menyukai pengalaman code-first dan menggunakan alur/aliran data untuk pengguna yang lebih menyukai pengalaman kode rendah atau tanpa kode.

Konsumsi: Untuk menunjukkan konsumsi data, Anda akan melihat bagaimana Anda dapat menggunakan fitur DirectLake Power BI untuk membuat laporan, dasbor, dan langsung mengkueri data dari lakehouse. Selain itu, kami menunjukkan bagaimana Anda dapat membuat data Anda tersedia untuk alat pelaporan pihak ketiga dengan menggunakan titik akhir analitik TDS/SQL. Titik akhir ini memungkinkan Anda terhubung ke gudang dan menjalankan kueri SQL untuk analitik.

Langkah selanjutnya

Saran dan Komentar

Segera hadir: Sepanjang tahun 2024 kami akan menghentikan penggunaan GitHub Issues sebagai mekanisme umpan balik untuk konten dan menggantinya dengan sistem umpan balik baru. Untuk mengetahui informasi selengkapnya, lihat: https://aka.ms/ContentUserFeedback.

Kirim dan lihat umpan balik untuk