Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Tutorial ini membantu Anda mempercepat proses evaluasi untuk Data Factory di Microsoft Fabric dengan menyediakan langkah-langkah untuk skenario integrasi data lengkap dalam waktu satu jam. Pada akhir tutorial ini, Anda memahami nilai dan kemampuan utama Data Factory dan mengetahui cara menyelesaikan skenario integrasi data end-to-end yang umum.

Skenario dibagi menjadi pengenalan dan tiga modul:

- Pengantar tutorial dan mengapa Anda harus menggunakan Data Factory di Microsoft Fabric.

- Modul 1: Buat alur dengan Data Factory untuk menyerap data mentah dari penyimpanan Blob ke tabel lapisan data perunggu di data Lakehouse.

- Modul 2: Mengubah data dengan aliran data di Data Factory untuk memproses data mentah dari tabel perunggu Anda dan memindahkannya ke tabel lapisan data emas di data Lakehouse.

- Modul 3: Selesaikan perjalanan integrasi data pertama Anda dan kirim email untuk memberi tahu Anda setelah semua pekerjaan selesai, dan terakhir, siapkan seluruh alur untuk berjalan sesuai jadwal.

Mengapa Data Factory di Microsoft Fabric?

Microsoft Fabric menyediakan satu platform untuk semua kebutuhan analitik perusahaan. Ini mencakup spektrum analitik termasuk pergerakan data, data lake, rekayasa data, integrasi data, ilmu data, analitik real time, dan kecerdasan bisnis. Dengan Fabric, Anda tidak perlu menyatukan berbagai layanan dari beberapa vendor. Sebagai gantinya, pengguna Anda menikmati produk komprehensif yang mudah dipahami, dibuat, disetorkan, dan dioperasikan.

Data Factory in Fabric menggabungkan kemudahan penggunaan Power Query dengan skala dan kekuatan Azure Data Factory. Ini membawa yang terbaik dari kedua produk bersama-sama ke dalam satu pengalaman. Tujuannya adalah agar pengembang data warga negara dan profesional memiliki alat integrasi data yang tepat. Data Factory menyediakan pengalaman persiapan dan transformasi data berkode rendah dengan dukungan AI, transformasi skala petabyte, dan ratusan konektor dengan konektivitas hibrid dan multicloud.

Tiga fitur utama Data Factory

- Penyerapan data: Aktivitas Salin dalam alur (atau pekerjaan Salin terpisah) memungkinkan Anda memindahkan data skala petabyte dari ratusan sumber data ke Lakehouse data Anda untuk pemrosesan lebih lanjut.

- Transformasi dan persiapan data: Dataflow Gen2 menyediakan antarmuka kode rendah untuk mengubah data Anda menggunakan 300+ transformasi data, dengan kemampuan untuk memuat hasil yang diubah menjadi beberapa tujuan seperti database Azure SQL, Lakehouse, dan banyak lagi.

- Otomatisasi end-to-end: Alur menyediakan orkestrasi aktivitas yang mencakup aktivitas Salin, Aliran Data, dan Notebook, dan banyak lagi. Aktivitas dalam alur dapat ditautkan bersama untuk beroperasi secara berurutan, atau dapat beroperasi secara independen secara paralel. Seluruh alur integrasi data Anda berjalan secara otomatis, dan dapat dipantau di satu tempat.

Tutorial Arsitektur

Dalam 50 menit ke depan, Anda akan mempelajari ketiga fitur utama Data Factory saat Menyelesaikan skenario integrasi data end-to-end.

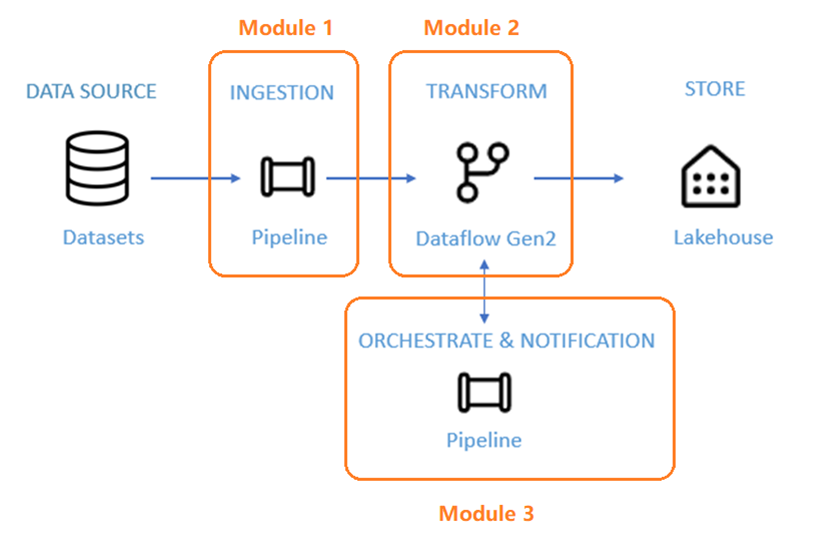

Skenario dibagi menjadi tiga modul:

- Modul 1: Buat alur dengan Data Factory untuk menyerap data mentah dari penyimpanan Blob ke tabel lapisan data perunggu di data Lakehouse.

- Modul 2: Mengubah data dengan aliran data di Data Factory untuk memproses data mentah dari tabel perunggu Anda dan memindahkannya ke tabel lapisan data emas di data Lakehouse.

- Modul 3: Selesaikan perjalanan integrasi data pertama Anda dan kirim email untuk memberi tahu Anda setelah semua pekerjaan selesai, dan terakhir, siapkan seluruh alur untuk berjalan sesuai jadwal.

Anda menggunakan himpunan data sampel NYC-Taxi sebagai sumber data untuk tutorial. Setelah selesai, Anda akan dapat memperoleh wawasan tentang diskon harian tentang tarif taksi untuk jangka waktu tertentu menggunakan Data Factory di Microsoft Fabric.

Langkah selanjutnya

Lanjutkan ke bagian berikutnya untuk membuat alur data Anda.